第11卷第6期 智能系统学报 Vol.11 No.6 2016年12月 CAAI Transactions on Intelligent Systems Dec.2016 D0I:10.11992/is.201607026 网络出版地址:http://www.cnki.net/kcms/detail,/23.1538.TP.20170111.1705.006.html 视觉SLAM综述 权美香1,朴松昊12,李国 (1.哈尔滨工业大学多智能体机器人实验室,黑龙江哈尔滨150000:2.哈尔滨工业大学多智能体机器人实验室,黑 龙江哈尔滨150000) 摘要:视觉SLAM指的是相机作为唯一的外部传感器,在进行自身定位的同时创建环境地图。SLAM创建的地图 的好坏对之后自主的定位、路径规划以及壁障的性能起到一个决定性的作用。本文对基于特征的视觉SLAM方法和 直接的SLAM方法,视觉SLAM的主要标志性成果,SLAM的主要研究实验室进行了介绍,并介绍了SFT,SURF,ORB 特征的检测与匹配,关键帧选择方法,并对消除累积误差的闭环检测及地图优化的方法进行了总结。最后,对视觉 SLAM的主要发展趋势及研究热点进行了讨论,并对单目视觉SLAM,双目视觉SLAM,RGB D SLAM进行了优缺点 分析。 关键词:视觉同步定位与创建地图;单日视觉:RGB_D SLAM:特征检测与匹配:闭环检测 中图分类号:TP391文献标志码:A文章编号:1673-4785(2016)06-0768-09 中文引用格式:权美香,朴松昊,李国.视觉SL4M综述[J].智能系统学报,2016,11(6):768-776 英文引用格式:QUAN Meixiang,PIAO Songhao,LI Guo..An overview of visual SLAM[J].CAAI transactions on intelligent sys- tems,2016,11(6):768-776. An overview of visual SLAM QUAN Meixiang',PIAO Songhao'2,LI Guo' (1.Multi-agent Robot Research Center,Harbin Institute of Technology,Harbin 150000,China;2.Multi-agent Robot Research Cen- ter,Harbin Institute of Technology,Harbin 150000,China) Abstract:Visual SLAM refers to simultaneously localizing itself and reconstructing the environment map using cam- eras as the only external sensor.The quality of the map created by SLAM plays a decisive role in the performance of the subsequent automatic localization,path planning,and obstacle avoidance.This paper introduced the feature- based visual SLAM and direct visual SLAM methods;the major symbolic achievement of visual SLAM;the main re- search laboratory of SLAM;and the method of SIFT,SURF,and ORB feature detection and matching,key frame selection.In addition,this paper summarized the loop closure detection and map optimization that removed the ac- cumulated error.In the end,the development tendency and research highlights of SLAM were discussed and the ad- vantages and disadvantages of monocular SLAM,binocular SLAM,and RGB_D SLAM were analyzed. Keywords:visual simultaneous localization and mapping;monocular vision;RGB_D;feature detection and matc- hing;loop closure detection 移动机器人的一个基本任务是在给定环境地图 一开始就有的,当移动机器人进入未知的环境时,需 的条件下确定其所在的位置,然而环境地图并不是 要通过自身的传感器构建3-D环境地图,并且同时 确定自身在地图中的位置,这就是SLAM(simultane- 收稿日期:2016-07-25.网络出版日期: ous localization and mapping)问题,它是运动恢复结 基金项目:国家自然科学基金面上项目(61375081): 通信作者:朴松吴.E-mail:piaosh@hit.cdu.cn. 构(structure from motion,SM)的实时版本

第 11 卷第 6 期 智 能 系 统 学 报 Vol.11 №.6 2016 年 12 月 CAAI Transactions on Intelligent Systems Dec. 2016 DOI:10.11992 / tis.201607026 网络出版地址:http: / / www.cnki.net / kcms/ detail / 23.1538.TP.20170111.1705.006.html 视觉 SLAM 综述 权美香1 ,朴松昊1,2 ,李国1 (1.哈尔滨工业大学 多智能体机器人实验室,黑龙江 哈尔滨 150000;2. 哈尔滨工业大学 多智能体机器人实验室,黑 龙江 哈尔滨 150000) 摘 要:视觉 SLAM 指的是相机作为唯一的外部传感器,在进行自身定位的同时创建环境地图。 SLAM 创建的地图 的好坏对之后自主的定位、路径规划以及壁障的性能起到一个决定性的作用。 本文对基于特征的视觉 SLAM 方法和 直接的 SLAM 方法,视觉 SLAM 的主要标志性成果,SLAM 的主要研究实验室进行了介绍,并介绍了 SIFT,SURF,ORB 特征的检测与匹配,关键帧选择方法,并对消除累积误差的闭环检测及地图优化的方法进行了总结。 最后,对视觉 SLAM 的主要发展趋势及研究热点进行了讨论,并对单目视觉 SLAM,双目视觉 SLAM,RGB_D SLAM 进行了优缺点 分析。 关键词:视觉同步定位与创建地图;单目视觉;RGB_D SLAM;特征检测与匹配;闭环检测 中图分类号: TP391 文献标志码:A 文章编号:1673-4785(2016)06-0768-09 中文引用格式:权美香,朴松昊,李国. 视觉 SLAM 综述[J]. 智能系统学报, 2016, 11(6): 768-776. 英文引用格式:QUAN Meixiang, PIAO Songhao, LI Guo. An overview of visual SLAM[ J]. CAAI transactions on intelligent sys⁃ tems, 2016, 11(6): 768-776. An overview of visual SLAM QUAN Meixiang 1 , PIAO Songhao 1,2 , LI Guo 1 (1. Multi⁃agent Robot Research Center, Harbin Institute of Technology, Harbin 150000, China; 2. Multi⁃agent Robot Research Cen⁃ ter, Harbin Institute of Technology, Harbin 150000, China) Abstract:Visual SLAM refers to simultaneously localizing itself and reconstructing the environment map using cam⁃ eras as the only external sensor. The quality of the map created by SLAM plays a decisive role in the performance of the subsequent automatic localization, path planning, and obstacle avoidance. This paper introduced the feature- based visual SLAM and direct visual SLAM methods; the major symbolic achievement of visual SLAM; the main re⁃ search laboratory of SLAM; and the method of SIFT, SURF, and ORB feature detection and matching, key frame selection. In addition, this paper summarized the loop closure detection and map optimization that removed the ac⁃ cumulated error. In the end, the development tendency and research highlights of SLAM were discussed and the ad⁃ vantages and disadvantages of monocular SLAM, binocular SLAM, and RGB_D SLAM were analyzed. Keywords: visual simultaneous localization and mapping; monocular vision; RGB_D; feature detection and matc⁃ hing; loop closure detection 收稿日期:2016-07-25. 网络出版日期:. 基金项目::国家自然科学基金面上项目(61375081). 通信作者:朴松昊. E⁃mail: piaosh@ hit.edu.cn. 移动机器人的一个基本任务是在给定环境地图 的条件下确定其所在的位置,然而环境地图并不是 一开始就有的,当移动机器人进入未知的环境时,需 要通过自身的传感器构建 3⁃D 环境地图,并且同时 确定自身在地图中的位置,这就是 SLAM(simultane⁃ ous localization and mapping)问题,它是运动恢复结 构(structure from motion,SfM)的实时版本

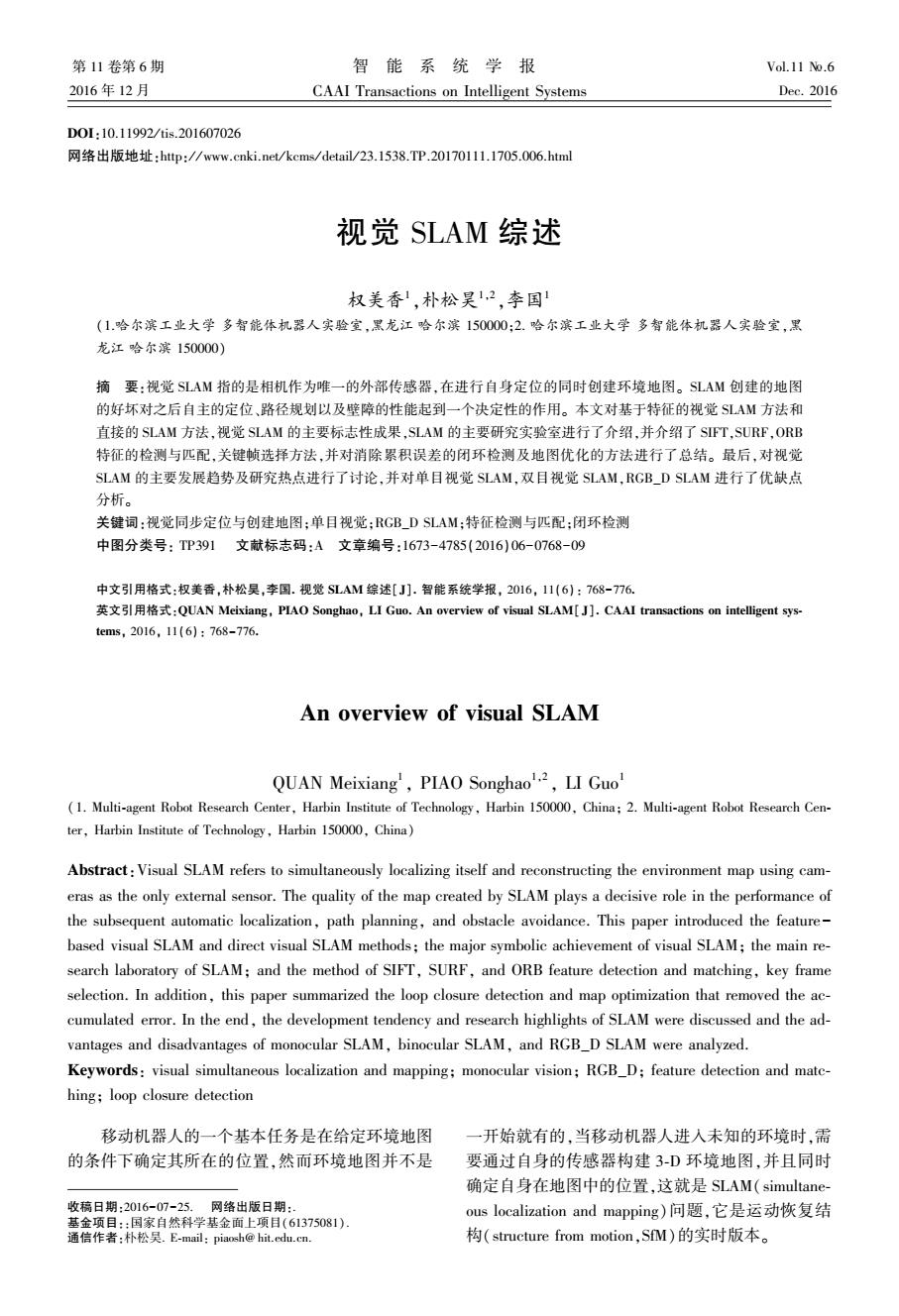

第6期 权美香,等:视觉SLAM综述 .769. 相机作为唯一外部传感器的SLAM被称为视觉 在关键帧的基础上提出的一个单目视觉SLAM系 SLAM。由于相机具有成本低,轻,很容易放到商品 统,将整个SLAM过程分为定位、创建地图、闭环3 硬件上的优点,且图像含有丰富的信息,视觉SLAM 个线程,且对这3个任务使用相同的ORB特征,且 得到了巨大的发展。根据采用的视觉传感器不同, 引进本质图的概念来加速闭环校正过程。 可以将视觉SLAM主要分为三类:仅用一个相机作 微软公司推出的Kinect相机,能够同时获得图 为唯一外部传感器的单目视觉SLAM:使用多个相 像信息及深度信息,从而简化了三维重建的过程,且 机作为传感器的立体视觉SLAM,其中双目立体视 由于价格便宜,基于RGB_D数据的SLAM得到了 觉的应用最多:基于单目相机与红外传感器结合构 迅速的发展42)。文献[18]是最早提出的使用 成的传感器的RGB-D SLAM。 RGBD相机对室内环境进行三维重建的方法,在彩 色图像中提取SFT特征并在深度图像上查找相应 1视觉SLAM方法介绍 的深度信息。然后使用RANSAC方法对3-D特征 视觉SLAM算法可根据利用图像信息的不同分 点进行匹配并计算出相应的刚体运动变换,再以此 为基于特征的SLAM方法和direct SLAM方法。下 作为ICP(iterative closest point)的初始值来求出更 面就这两种方法对单目视觉SLAM与RGB_D SLAM 精确的位姿。RGBD SLAM通常使用ICP算法来进 进行简要的介绍,并介绍视觉SLAM的标志性成果 行位姿估计,图1给出了ICP算法的基本流程。文 以及国内外主要的研究单位。 献[20]与文献[18]类似,不同点在于对彩色图像进 1.1基于特征的SLAM方法 行的是SURF特征提取,并用ICP对运动变换进行 基于特征的视觉SLAM方法指的是对输入的图 优化后,最后使用Hogman位姿图优化方法求出全 像进行特征点检测及提取,并基于2-D或3-D的特 局最优位姿。 征匹配计算相机位姿及对环境进行建图。如果对整 开始 幅图像进行处理,则计算复杂度太高,由于特征在保 存图像重要信息的同时有效减少了计算量,从而被 读入点集PP 广泛使用。 对点集p上的点,在曲 早期的单目视觉SLAM的实现是借助于滤波器 面S上搜索最近的点 而实现的l-4)。利用扩展卡尔曼滤波器(extended Kalman filter,EKF)来实现同时定位与地图创建,其 计算两个点集的重心坐标, 并生成两个新的点集 主要思想是使用状态向量来存储相机位姿及地图点 的三维坐标,利用概率密度函数来表示不确定性,从 由新点集计算旋转矩阵R 观测模型和递归的计算,最终获得更新的状态向量 和平移矩阵 的均值和方差。但是由于EKF的引进,SLAM算法 由R和ri计算点集p和变换 会有计算复杂度及由于线性化而带来的不确定性问 后的p 题。为了弥补EKF的线性化对结果带来的影响,在 文献[5-7]里将无迹卡尔曼滤波器(Unscented Kal- 是否连续两次 距离平方和之 man filter,.UKF)或改进的UKF引入到单目视觉 差小于绝对值A SLAM中。该方法虽然对不确定性有所改善,但同 Y 时也增加了计算复杂度。此外,文献[8-9]利用 结束○ Rao-Blackwellized粒子滤波(Particle filter)实现了单 图1ICP算法流程图 目视觉SLAM。该方法避免了线性化,且对相机的 Fig.1 Flow diagram of ICP algorithm 快速运动有一定的弹力,但是为了保证定位精度,则 需要使用较多的粒子,从而大大提高了计算复杂度。 1.2直接的SLAM方法 之后基于关键帧的单目视觉SLAM0B]逐渐发 直接的SLAM方法指的是直接对像素点的强度 展起来,其中最具代表性的是parallel tracking and 进行操作,避免了特征点的提取,该方法能够使用图 mapping(PTAM)[uo,该论文提出了一个简单、有效 像的所有信息。此外,提供更多的环境几何信息,有 的提取关键帧的方法,且将定位和创建地图分为两 助于对地图的后续使用。且对特征较少的环境有更 个独立的任务,并在两个线程上进行。文献[13]是 高的准确性和鲁棒性。 近几年,基于直接法的单目视觉里程计算法才

相机作为唯一外部传感器的 SLAM 被称为视觉 SLAM。 由于相机具有成本低,轻 ,很容易放到商品 硬件上的优点,且图像含有丰富的信息,视觉 SLAM 得到了巨大的发展。 根据采用的视觉传感器不同, 可以将视觉 SLAM 主要分为三类:仅用一个相机作 为唯一外部传感器的单目视觉 SLAM;使用多个相 机作为传感器的立体视觉 SLAM,其中双目立体视 觉的应用最多;基于单目相机与红外传感器结合构 成的传感器的 RGB-D SLAM。 1 视觉 SLAM 方法介绍 视觉 SLAM 算法可根据利用图像信息的不同分 为基于特征的 SLAM 方法和 direct SLAM 方法。 下 面就这两种方法对单目视觉 SLAM 与 RGB_D SLAM 进行简要的介绍,并介绍视觉 SLAM 的标志性成果 以及国内外主要的研究单位。 1.1 基于特征的 SLAM 方法 基于特征的视觉 SLAM 方法指的是对输入的图 像进行特征点检测及提取,并基于 2⁃D 或 3⁃D 的特 征匹配计算相机位姿及对环境进行建图。 如果对整 幅图像进行处理,则计算复杂度太高,由于特征在保 存图像重要信息的同时有效减少了计算量,从而被 广泛使用。 早期的单目视觉 SLAM 的实现是借助于滤波器 而实现的[1-4] 。 利用扩展卡尔曼滤波器( extended Kalman filter,EKF)来实现同时定位与地图创建,其 主要思想是使用状态向量来存储相机位姿及地图点 的三维坐标,利用概率密度函数来表示不确定性,从 观测模型和递归的计算,最终获得更新的状态向量 的均值和方差。 但是由于 EKF 的引进,SLAM 算法 会有计算复杂度及由于线性化而带来的不确定性问 题。 为了弥补 EKF 的线性化对结果带来的影响,在 文献[5-7]里将无迹卡尔曼滤波器( Unscented Kal⁃ man filter,UKF) 或改进的 UKF 引入到单目视觉 SLAM 中。 该方法虽然对不确定性有所改善,但同 时也增加了计算复杂度。 此外,文献[ 8 - 9] 利用 Rao⁃Blackwellized 粒子滤波(Particle filter)实现了单 目视觉 SLAM。 该方法避免了线性化,且对相机的 快速运动有一定的弹力,但是为了保证定位精度,则 需要使用较多的粒子,从而大大提高了计算复杂度。 之后基于关键帧的单目视觉 SLAM [10-13]逐渐发 展起来,其中最具代表性的是 parallel tracking and mapping(PTAM) [10] ,该论文提出了一个简单、有效 的提取关键帧的方法,且将定位和创建地图分为两 个独立的任务,并在两个线程上进行。 文献[13]是 在关键帧的基础上提出的一个单目视觉 SLAM 系 统,将整个 SLAM 过程分为定位、创建地图、闭环 3 个线程,且对这 3 个任务使用相同的 ORB 特征,且 引进本质图的概念来加速闭环校正过程。 微软公司推出的 Kinect 相机,能够同时获得图 像信息及深度信息,从而简化了三维重建的过程,且 由于价格便宜,基于 RGB_D 数据的 SLAM 得到了 迅速的发展[14-21] 。 文献[ 18] 是最早提出的使用 RGBD 相机对室内环境进行三维重建的方法,在彩 色图像中提取 SIFT 特征并在深度图像上查找相应 的深度信息。 然后使用 RANSAC 方法对 3⁃D 特征 点进行匹配并计算出相应的刚体运动变换,再以此 作为 ICP( iterative closest point)的初始值来求出更 精确的位姿。 RGBD SLAM 通常使用 ICP 算法来进 行位姿估计,图 1 给出了 ICP 算法的基本流程。 文 献[20]与文献[18]类似,不同点在于对彩色图像进 行的是 SURF 特征提取,并用 ICP 对运动变换进行 优化后,最后使用 Hogman 位姿图优化方法求出全 局最优位姿。 图 1 ICP 算法流程图 Fig.1 Flow diagram of ICP algorithm 1.2 直接的 SLAM 方法 直接的 SLAM 方法指的是直接对像素点的强度 进行操作,避免了特征点的提取,该方法能够使用图 像的所有信息。 此外,提供更多的环境几何信息,有 助于对地图的后续使用。 且对特征较少的环境有更 高的准确性和鲁棒性。 近几年,基于直接法的单目视觉里程计算法才 第 6 期 权美香,等:视觉 SLAM 综述 ·769·

·770 智能系统学报 第11卷 被提出[2-25]。文献[22]的相机定位方法依赖图像 SLAM26]是直接的单目SLAM方法,即直接对图像 的每个像素点,即用稠密的图像对准来进行自身定 的像素点进行处理,相比于之前的基于直接法的单 位,并构建出稠密的3-D地图。文献[23]对当前图 目视觉里程计,不仅能计算出自身的位姿,还能构建 像构建半稠密inverse深度地图,并使用稠密图像配 出全局的半稠密且精确的环境地图。其中的追踪方 准(dense image alignment)法计算相机位姿。构建 法,直接在sim3上进行操作,从而能够准确地检测 半稠密地图即估计图像中梯度较大的所有像素的深 尺度漂移,可在CPU上实时运行。ORB_SLAM] 度值,该深度值被表示为高斯分布,且当新的图像到 是2015年出的比较完整的基于关键帧的单目 来时,该深度值被更新。文献[24]对每个像素点进 SLAM算法,将整个系统分为追踪、地图创建、闭环 行概率的深度测量,有效降低了位姿估计的不确定 控制3个线程进行处理,且特征的提取与匹配、稀疏 性。文献[25]提出了一种半直接的单目视觉里程 地图的创建、位置识别都是基于ORB特征,其定位 计方法,该方法相比于直接法不是对整幅图像进行 精确度很高,且可以实时运行。 直接匹配从而获得相机位姿,而是通过在整幅图像 1.4SLAM的主要研究实验室 中提取的图像块来进行位姿的获取,这样能够增强 SLAM的主要研究实验室有: 算法的鲁棒性。为了构建稠密的三维环境地图,E- 1)苏黎世联邦理工学院的Autonomous System gel等26提出了LSD-SLAM算法(large-scale direct Lab,该实验室在tango项目上与谷歌合作,负责视觉一 SLAM),相比之前的直接的视觉里程计方法,该方 惯导的里程计,基于视觉的定位和深度重建算法。 法在估计高准确性的相机位姿的同时能够创建大规 2)明尼苏达大学的Multiple Autonomous Robotic 模的三维环境地图。 Systems Laboratory,主要研究四轴飞行器导航,合作 文献[27提出了Kinect融合的方法,该方法通 建图,基于地图的定位,半稠密地图创建等。 过Kinect获取的深度图像对每帧图像中的每个像 3)慕尼黑理工大学的The Computer Vision 素进行最小化距离测量而获得相机位姿,且融合所 Group,主要研究基于图像的3-D重建,机器人视觉, 有深度图像,从而获得全局地图信息。文献[28]使 视觉SLAM等。 用图像像素点的光度信息和几何信息来构造误差函 2视觉SLAM关键性问题 数,通过最小化误差函数而获得相机位姿,且地图问 题被处理为位姿图表示。文献[29]是较好的直接 2.1特征检测与匹配 RGB_D SLAM方法,该方法结合像素点的强度误差 目前,点特征的使用最多,最常用的点特征有 与深度误差作为误差函数,通过最小化代价函数,从 SlFT(scale invariant feature transform)[3o]特征,SURT 而求出最优相机位姿,该过程由g2o实现,并提出了 (speeded up robust features)[3)特征和ORB(oriented 基于熵的关键帧提取及闭环检方法,从而大大降低 fast and rotated BRIEF)[3]特征。SIFT特征已发展l0 了路径的误差。 多年,且获得了巨大的成功。SFT特征具有可辨别 1.3视觉SLAM主要标志性成果 性,由于其描述符用高维向量(128维)表示,且具有 视觉SLAM的标志性成果有Andrew Davison提 旋转不变性、尺度不变性、放射变换不变性,对噪声和 出的MonoSLAM3],是第1个基于EKF方法的单目 光照变化也有鲁棒性。[-]在视觉SLAM里使用了 SLAM,能够达到实时但是不能确定漂移多少,能够 SFT特征,但是由于SFT特征的向量维数太高,导致 在概率框架下在线创建稀疏地图。DTAM2]是 时间复杂度高。SURF特征具有尺度不变性、旋转不 2011年提出的基于直接法的单目SLAM算法,该方 变性,且相对于ST特征的算法速度提高了3到7 法通过帧率的整幅图像对准来获得相对于稠密地图 倍。在文献[37-39]SURF被作为视觉SLAM的特征 的相机的6个自由度位姿,能够在GPU上达到实时 提取方法,与SFT特征相比,时间复杂度有所降低。 的效果。PTAMI0是由Georg Klein提出的第1个 对两幅图像的SFT和SURF特征进行匹配时通常是 用多线程处理SLAM的算法,将跟踪和建图分为两 计算两个特征向量之间的欧氏距离,并以此作为特征 个单独的任务并在两个平行的线程进行处理。K- 点的相似性判断度量。ORB特征是FASTt4]特征检 nectFusion是第1个基于Kinect的能在GPU上实 测算子与BREF4描述符的结合,并在其基础上做 时构建稠密三维地图的算法,该方法仅使用Kinect 了一些改进。ORB特征最大的优点是计算速度快, 相机获取的深度信息去计算传感器的位姿以及构建 是SFT特征的1O0倍,SURF特征的10倍,其原因是 精确的环境3-D地图模型。2014年提出的LSD- FAST特征检测速度就很快,再加上BRIEF描述符是

被提出[22-25] 。 文献[22]的相机定位方法依赖图像 的每个像素点,即用稠密的图像对准来进行自身定 位,并构建出稠密的 3⁃D 地图。 文献[23]对当前图 像构建半稠密 inverse 深度地图,并使用稠密图像配 准(dense image alignment) 法计算相机位姿。 构建 半稠密地图即估计图像中梯度较大的所有像素的深 度值,该深度值被表示为高斯分布,且当新的图像到 来时,该深度值被更新。 文献[24]对每个像素点进 行概率的深度测量,有效降低了位姿估计的不确定 性。 文献[25]提出了一种半直接的单目视觉里程 计方法,该方法相比于直接法不是对整幅图像进行 直接匹配从而获得相机位姿,而是通过在整幅图像 中提取的图像块来进行位姿的获取,这样能够增强 算法的鲁棒性。 为了构建稠密的三维环境地图,En⁃ gel 等[26] 提出了 LSD⁃SLAM 算法( large⁃scale direct SLAM),相比之前的直接的视觉里程计方法,该方 法在估计高准确性的相机位姿的同时能够创建大规 模的三维环境地图。 文献[27]提出了 Kinect 融合的方法,该方法通 过 Kinect 获取的深度图像对每帧图像中的每个像 素进行最小化距离测量而获得相机位姿,且融合所 有深度图像,从而获得全局地图信息。 文献[28]使 用图像像素点的光度信息和几何信息来构造误差函 数,通过最小化误差函数而获得相机位姿,且地图问 题被处理为位姿图表示。 文献[29] 是较好的直接 RGB_D SLAM 方法,该方法结合像素点的强度误差 与深度误差作为误差函数,通过最小化代价函数,从 而求出最优相机位姿,该过程由 g2o 实现,并提出了 基于熵的关键帧提取及闭环检方法,从而大大降低 了路径的误差。 1.3 视觉 SLAM 主要标志性成果 视觉 SLAM 的标志性成果有 Andrew Davison 提 出的 MonoSLAM [3] ,是第 1 个基于 EKF 方法的单目 SLAM,能够达到实时但是不能确定漂移多少,能够 在概率框架下在 线 创 建 稀 疏 地 图。 DTAM [24] 是 2011 年提出的基于直接法的单目 SLAM 算法,该方 法通过帧率的整幅图像对准来获得相对于稠密地图 的相机的 6 个自由度位姿,能够在 GPU 上达到实时 的效果。 PTAM [10]是由 Georg Klein 提出的第 1 个 用多线程处理 SLAM 的算法,将跟踪和建图分为两 个单独的任务并在两个平行的线程进行处理。 Ki⁃ nectFusion [27]是第 1 个基于 Kinect 的能在 GPU 上实 时构建稠密三维地图的算法,该方法仅使用 Kinect 相机获取的深度信息去计算传感器的位姿以及构建 精确的环境 3⁃D 地图模型。 2014 年提出的 LSD- SLAM [26]是直接的单目 SLAM 方法,即直接对图像 的像素点进行处理,相比于之前的基于直接法的单 目视觉里程计,不仅能计算出自身的位姿,还能构建 出全局的半稠密且精确的环境地图。 其中的追踪方 法,直接在 sim3 上进行操作,从而能够准确地检测 尺度漂移,可在 CPU 上实时运行。 ORB_SLAM [13] 是 2015 年 出 的 比 较 完 整 的 基 于 关 键 帧 的 单 目 SLAM 算法,将整个系统分为追踪、地图创建、闭环 控制 3 个线程进行处理,且特征的提取与匹配、稀疏 地图的创建、位置识别都是基于 ORB 特征,其定位 精确度很高,且可以实时运行。 1.4 SLAM 的主要研究实验室 SLAM 的主要研究实验室有: 1) 苏黎世联邦理工学院的 Autonomous System Lab,该实验室在 tango 项目上与谷歌合作,负责视觉— 惯导的里程计,基于视觉的定位和深度重建算法。 2)明尼苏达大学的 Multiple Autonomous Robotic Systems Laboratory,主要研究四轴飞行器导航,合作 建图,基于地图的定位,半稠密地图创建等。 3) 慕 尼 黑 理 工 大 学 的 The Computer Vision Group,主要研究基于图像的 3⁃D 重建,机器人视觉, 视觉 SLAM 等。 2 视觉 SLAM 关键性问题 2.1 特征检测与匹配 目前,点特征的使用最多,最常用的点特征有 SIFT(scale invariant feature transform) [30] 特征,SURT (speeded up robust features) [31] 特征和 ORB(oriented fast and rotated BRIEF) [32]特征。 SIFT 特征已发展 10 多年,且获得了巨大的成功。 SIFT 特征具有可辨别 性,由于其描述符用高维向量(128 维)表示,且具有 旋转不变性、尺度不变性、放射变换不变性,对噪声和 光照变化也有鲁棒性。 [33-36] 在视觉 SLAM 里使用了 SIFT 特征,但是由于 SIFT 特征的向量维数太高,导致 时间复杂度高。 SURF 特征具有尺度不变性、旋转不 变性,且相对于 SIFT 特征的算法速度提高了 3 到 7 倍。 在文献[37-39]SURF 被作为视觉 SLAM 的特征 提取方法,与 SIFT 特征相比,时间复杂度有所降低。 对两幅图像的 SIFT 和 SURF 特征进行匹配时通常是 计算两个特征向量之间的欧氏距离,并以此作为特征 点的相似性判断度量。 ORB 特征是 FAST [40] 特征检 测算子与 BRIEF [41] 描述符的结合,并在其基础上做 了一些改进。 ORB 特征最大的优点是计算速度快, 是 SIFT 特征的 100 倍,SURF 特征的 10 倍,其原因是 FAST 特征检测速度就很快,再加上 BRIEF 描述符是 ·770· 智 能 系 统 学 报 第 11 卷

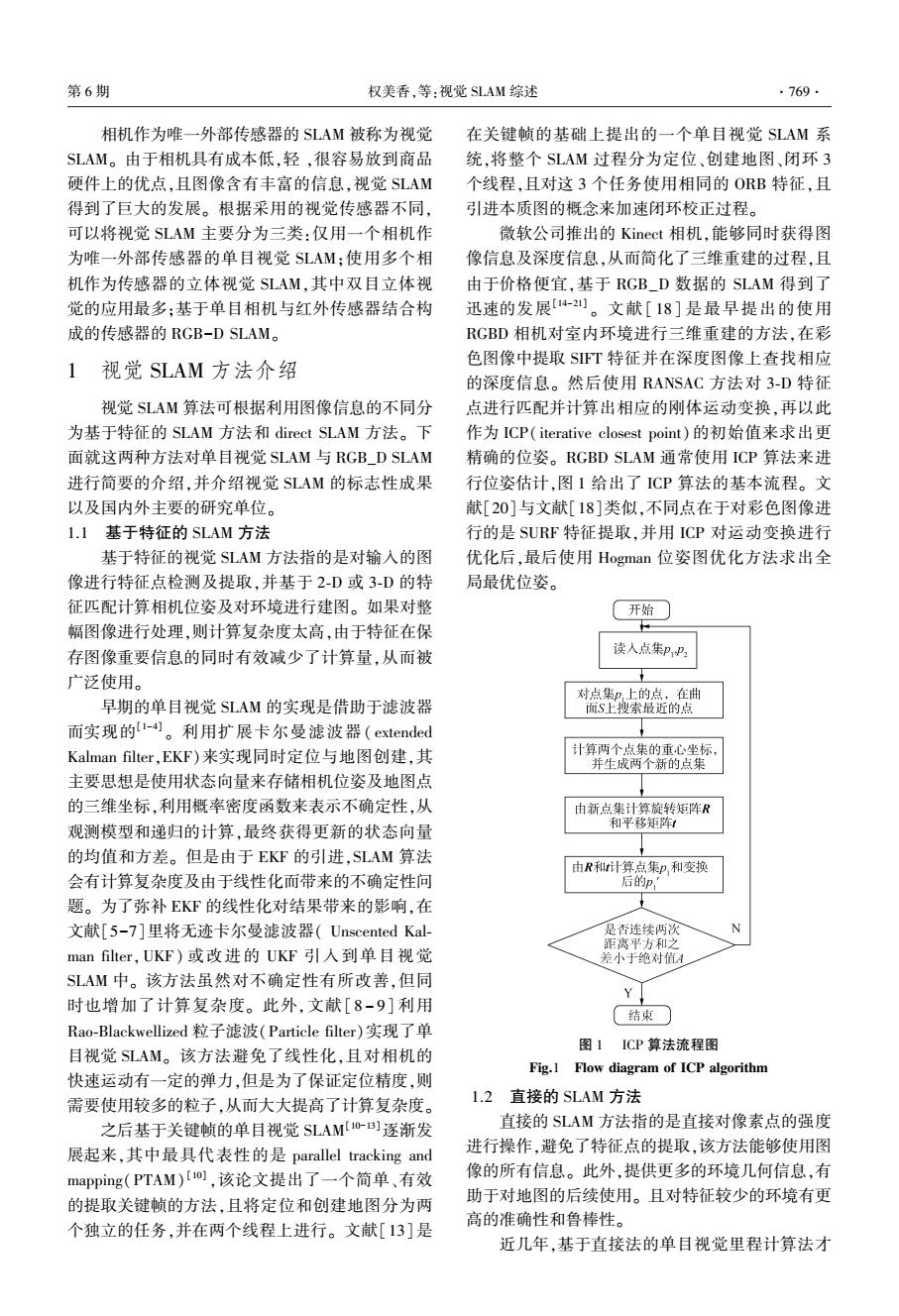

第6期 权美香,等:视觉SLAM综述 .771. 二进制串,大大缩减了匹配速度,而且具有旋转不变 方法,它们使用基于16维的SFT特征的词典方法 性,但不具备尺度不变性。文献[12-13,42-44]的 不断地搜索已访问过的位置。文献[61-62]使用基 SLAM算法中采用了ORB特征,大大加快了算法速 于SURF描述符的词典方法去进行闭环检测SURF 度。ORB特征匹配是以BRIEF二进制描述符的汉明 特征,SURF特征提取需要花费4O0ms去进行。文 距离为相似性度量的。 献[63]使用SFT特征执行全局定位,且用KD树来 在大量包含直线和曲线的环境下,使用点特征 排列地图点。文献[59]提出了一种使用基于FAST 时,环境中很多信息都将被遗弃,为了弥补这个缺 特征检测与BRIEF二进制描述符词典,且添加了直 陷,从而也提出了基于边特征的视觉SLAM45-6]和 接索引(direct index),直接索引的引入使得能够有 基于区域特征的视觉SLAM]方法。 效地获得图像之间的匹配点,从而加快闭环检测的 2.2关键帧的选择 几何验证。文献[12]用基于ORB特征的词典方法 帧对帧的对准方法会造成大的累积漂浮,由于 进行位置识别,由于ORB特征具有旋转不变性且能 位姿估计过程中总会产生误差。为了减少帧对帧的 处理尺度变化,该方法能识别位置从不同的视角。 对准方法带来的误差,基于关键帧的 文献[13]的位置识别方法建于文献[12]的主要思 SLAM10-13,19,29]方法被提出。 想上,即使用基于ORB特征的词典方法选出候选闭 目前有几种选择关键帧的方法。文献[10,13] 环,再通过相似性计算进行闭环的几何验证。 里当满足以下全部条件时该帧作为关键帧插入到地 图里:从上一个关键帧经过了n个帧:当前帧至少能 看到n个地图点,位姿估计准确性较高。文献[19] 是当两幅图像看到的共同特征点数低于一定阈值 时,创建一个新的关键帧。文献[29]提出了一种基 于熵的相似性的选择关键帧的方法,由于简单的阈 值不适用于不同的场景,对每一帧计算一个熵的相 似性比,如果该值小于一个预先定义的阈值,则前一 帧被选为新的关键帧,并插入地图里,该方法大大减 少了位姿漂浮。 2.3闭环检测(1 loop closing)方法 闭环检测及位置识别,判断当前位置是否是以 前已访问过的环境区域。三维重建过程中必然会产 图2K中心点聚类方法 生误差累积,实现闭环是消除的一种手段。在位置 Fig.2 Method of k medians clustering 识别算法中,视觉是主要的传感器3,4s-0]。文献 2.4地图优化 [51]对闭环检测方法进行了比较,且得出图像对图 对于一个在复杂且动态的环境下工作的机器 像[s2-s)的匹配性能优于地图对地图[s,图像对地 人,3-D地图的快速生成是非常重要的,且创建的环 图约的匹配方法。 境地图对之后的定位、路径规划及壁障的性能起到 图像对图像的匹配方法中,词袋(bag of 一个关键性的作用,从而精确的地图创建也是非常 words)[s6]方法由于其有效性得到了广泛的应 重要的。 用[2-3,7-9]。词袋指的是使用视觉词典树(visual 闭环检测成功后,往地图里添加闭环约束,执行 vocabulary tree)将一幅图像的内容转换为数字向量 闭环校正。闭环问题可以描述为大规模的光束平差 的技术。对训练图像集进行特征提取,并将其特征 法(bundle adjustment)[64-]问题,即对相机位姿及 描述符空间通过K中心点聚类(k medians cluste- 所有的地图点3-D坐标进行优化,但是该优化计算 ing)方法离散化为个簇,由此,词典树的第一节点 复杂度太高,从而很难实现实时。 层被创建。下面的层通过对每个簇重复执行这个操 一种可执行方法为通过位姿图优化(pose graph 作而获得,直到共获得层。最终获得W个叶子节 optimization)方法来对闭环进行优化,顶点为相机位 点,即视觉词汇。每层到每层的K中心聚类过程如 图2所示[6]」 姿,边表示位姿之间相对变换的图称为位姿图,位姿 图优化即将闭环误差沿着图进行分配,即均匀分配 文献「60对重定位和闭环检测提出了统一的 到图上的所有位姿上。图优化通常由图优化框架

二进制串,大大缩减了匹配速度,而且具有旋转不变 性,但不具备尺度不变性。 文献[12-13,42-44]的 SLAM 算法中采用了 ORB 特征,大大加快了算法速 度。 ORB 特征匹配是以 BRIEF 二进制描述符的汉明 距离为相似性度量的。 在大量包含直线和曲线的环境下,使用点特征 时,环境中很多信息都将被遗弃,为了弥补这个缺 陷,从而也提出了基于边特征的视觉 SLAM [45-46] 和 基于区域特征的视觉 SLAM [47]方法。 2.2 关键帧的选择 帧对帧的对准方法会造成大的累积漂浮,由于 位姿估计过程中总会产生误差。 为了减少帧对帧的 对 准 方 法 带 来 的 误 差, 基 于 关 键 帧 的 SLAM [10-13,19,29]方法被提出。 目前有几种选择关键帧的方法。 文献[10,13] 里当满足以下全部条件时该帧作为关键帧插入到地 图里:从上一个关键帧经过了 n 个帧;当前帧至少能 看到 n 个地图点,位姿估计准确性较高。 文献[19] 是当两幅图像看到的共同特征点数低于一定阈值 时,创建一个新的关键帧。 文献[29]提出了一种基 于熵的相似性的选择关键帧的方法,由于简单的阈 值不适用于不同的场景,对每一帧计算一个熵的相 似性比,如果该值小于一个预先定义的阈值,则前一 帧被选为新的关键帧,并插入地图里,该方法大大减 少了位姿漂浮。 2.3 闭环检测(loop closing)方法 闭环检测及位置识别,判断当前位置是否是以 前已访问过的环境区域。 三维重建过程中必然会产 生误差累积,实现闭环是消除的一种手段。 在位置 识别算法中, 视觉是主要的传感器[3,48-50] 。 文献 [51]对闭环检测方法进行了比较,且得出图像对图 像[52-53]的匹配性能优于地图对地图[54] ,图像对地 图[55]的匹配方法。 图像 对 图 像 的 匹 配 方 法 中, 词 袋 ( bag of words) [56] 方 法 由 于 其 有 效 性 得 到 了 广 泛 的 应 用[12-13,57-59] 。 词袋指的是使用视觉词典树( visual vocabulary tree)将一幅图像的内容转换为数字向量 的技术。 对训练图像集进行特征提取,并将其特征 描述符空间通过 K 中心点聚类( k medians cluste⁃ ring)方法离散化为个簇,由此,词典树的第一节点 层被创建。 下面的层通过对每个簇重复执行这个操 作而获得,直到共获得层。 最终获得 W 个叶子节 点,即视觉词汇。 每层到每层的 K 中心聚类过程如 图 2 所示[56] 。 文献[60]对重定位和闭环检测提出了统一的 方法,它们使用基于 16 维的 SIFT 特征的词典方法 不断地搜索已访问过的位置。 文献[61-62]使用基 于 SURF 描述符的词典方法去进行闭环检测 SURF 特征,SURF 特征提取需要花费 400 ms 去进行。 文 献[63]使用 SIFT 特征执行全局定位,且用 KD 树来 排列地图点。 文献[59]提出了一种使用基于 FAST 特征检测与 BRIEF 二进制描述符词典,且添加了直 接索引(direct index),直接索引的引入使得能够有 效地获得图像之间的匹配点,从而加快闭环检测的 几何验证。 文献[12]用基于 ORB 特征的词典方法 进行位置识别,由于 ORB 特征具有旋转不变性且能 处理尺度变化,该方法能识别位置从不同的视角。 文献[13]的位置识别方法建于文献[12]的主要思 想上,即使用基于 ORB 特征的词典方法选出候选闭 环,再通过相似性计算进行闭环的几何验证。 图 2 K 中心点聚类方法 Fig.2 Method of k medians clustering 2.4 地图优化 对于一个在复杂且动态的环境下工作的机器 人,3⁃D 地图的快速生成是非常重要的,且创建的环 境地图对之后的定位、路径规划及壁障的性能起到 一个关键性的作用,从而精确的地图创建也是非常 重要的。 闭环检测成功后,往地图里添加闭环约束,执行 闭环校正。 闭环问题可以描述为大规模的光束平差 法(bundle adjustment) [64-65] 问题,即对相机位姿及 所有的地图点 3⁃D 坐标进行优化,但是该优化计算 复杂度太高,从而很难实现实时。 一种可执行方法为通过位姿图优化(pose graph optimization)方法来对闭环进行优化,顶点为相机位 姿,边表示位姿之间相对变换的图称为位姿图,位姿 图优化即将闭环误差沿着图进行分配,即均匀分配 到图上的所有位姿上。 图优化通常由图优化框架 第 6 期 权美香,等:视觉 SLAM 综述 ·771·

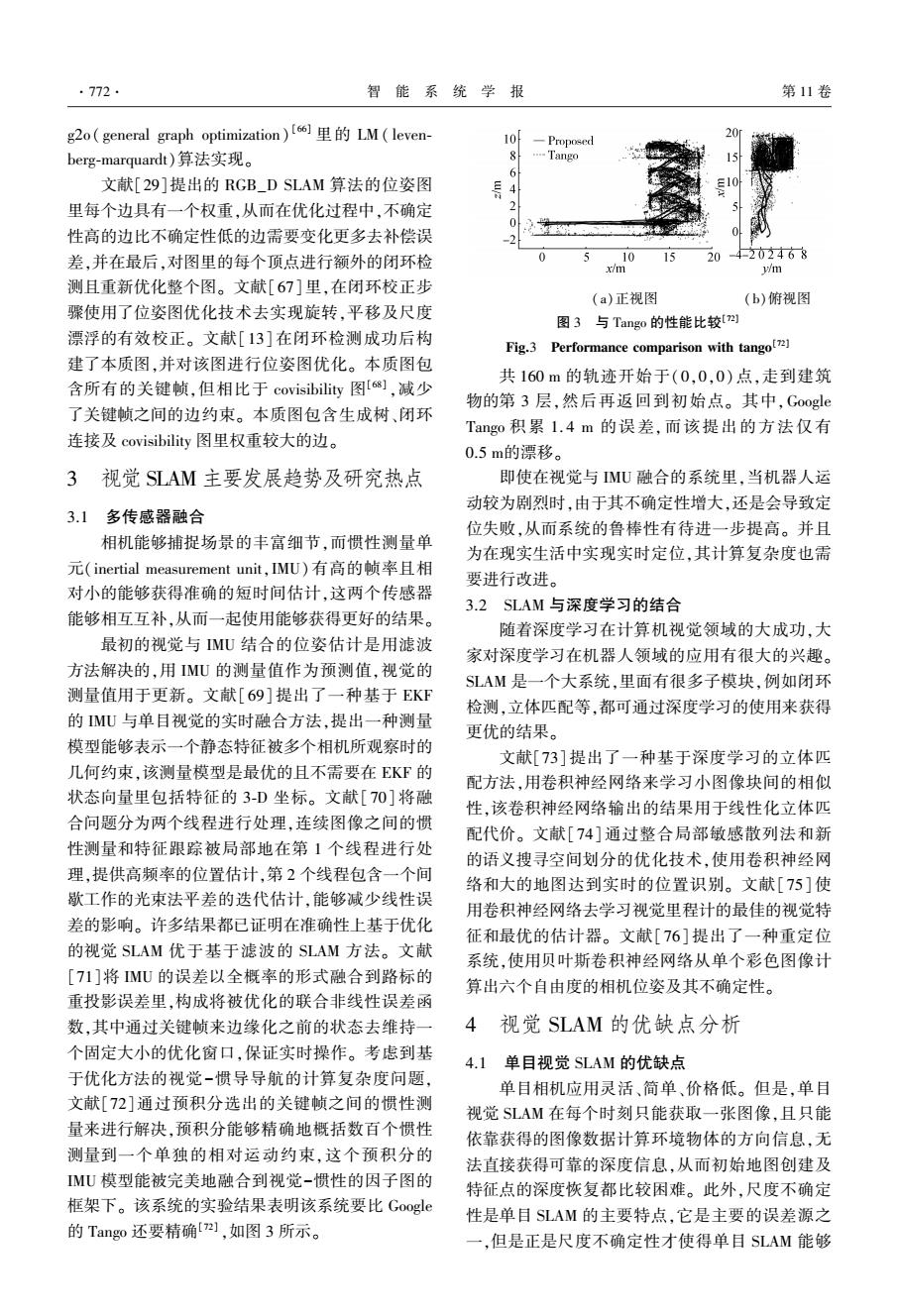

·772· 智能系统学报 第11卷 g2o(general graph optimization)(]LM(leven- 10 -Proposed berg-marquardt)算法实现。 8 -Tango 6 文献[29]提出的RGB_D SLAM算法的位姿图 4 里每个边具有一个权重,从而在优化过程中,不确定 2 0 性高的边比不确定性低的边需要变化更多去补偿误 2 差,并在最后,对图里的每个顶点进行额外的闭环检 0 5 10 15 20-4-202468 x/m m 测且重新优化整个图。文献[67]里,在闭环校正步 (a)正视图 (b)俯视图 骤使用了位姿图优化技术去实现旋转,平移及尺度 图3与Tango的性能比较[ 漂浮的有效校正。文献[13]在闭环检测成功后构 Fig.3 Performance comparison with tango(7) 建了本质图,并对该图进行位姿图优化。本质图包 共160m的轨迹开始于(0,0,0)点,走到建筑 含所有的关键帧,但相比于covisibility图[],减少 物的第3层,然后再返回到初始点。其中,Google 了关键帧之间的边约束。本质图包含生成树、闭环 Tango积累1.4m的误差,而该提出的方法仅有 连接及covisibility图里权重较大的边。 0.5m的漂移。 3视觉SLAM主要发展趋势及研究热点 即使在视觉与MU融合的系统里,当机器人运 动较为剧烈时,由于其不确定性增大,还是会导致定 3.1多传感器融合 位失败,从而系统的鲁棒性有待进一步提高。并且 相机能够捕捉场景的丰富细节,而惯性测量单 为在现实生活中实现实时定位,其计算复杂度也需 元(inertial measurement unit,IMU)有高的帧率且相 要进行改进。 对小的能够获得准确的短时间估计,这两个传感器 3.2SLAM与深度学习的结合 能够相互互补,从而一起使用能够获得更好的结果。 随着深度学习在计算机视觉领域的大成功,大 最初的视觉与MU结合的位姿估计是用滤波 家对深度学习在机器人领域的应用有很大的兴趣。 方法解决的,用IMU的测量值作为预测值,视觉的 SLAM是一个大系统,里面有很多子模块,例如闭环 测量值用于更新。文献[69]提出了一种基于EKF 检测,立体匹配等,都可通过深度学习的使用来获得 的MU与单目视觉的实时融合方法,提出一种测量 更优的结果。 模型能够表示一个静态特征被多个相机所观察时的 文献[73]提出了一种基于深度学习的立体匹 几何约束,该测量模型是最优的且不需要在EKF的 配方法,用卷积神经网络来学习小图像块间的相似 状态向量里包括特征的3-D坐标。文献[70]将融 性,该卷积神经网络输出的结果用于线性化立体匹 合问题分为两个线程进行处理,连续图像之间的惯 配代价。文献[74]通过整合局部敏感散列法和新 性测量和特征跟踪被局部地在第1个线程进行处 的语义搜寻空间划分的优化技术,使用卷积神经网 理,提供高频率的位置估计,第2个线程包含一个间 络和大的地图达到实时的位置识别。文献[75]使 歇工作的光束法平差的迭代估计,能够减少线性误 用卷积神经网络去学习视觉里程计的最佳的视觉特 差的影响。许多结果都已证明在准确性上基于优化 征和最优的估计器。文献[76]提出了一种重定位 的视觉SLAM优于基于滤波的SLAM方法。文献 系统,使用贝叶斯卷积神经网络从单个彩色图像计 [71]将MU的误差以全概率的形式融合到路标的 算出六个自由度的相机位姿及其不确定性。 重投影误差里,构成将被优化的联合非线性误差函 数,其中通过关键帧来边缘化之前的状态去维持一 4视觉SLAM的优缺点分析 个固定大小的优化窗口,保证实时操作。考虑到基 4.1单目视觉SLAM的优缺点 于优化方法的视觉-惯导导航的计算复杂度问题, 单目相机应用灵活、简单、价格低。但是,单目 文献[72]通过预积分选出的关键帧之间的惯性测 视觉SLAM在每个时刻只能获取一张图像,且只能 量来进行解决,预积分能够精确地概括数百个惯性 依靠获得的图像数据计算环境物体的方向信息,无 测量到一个单独的相对运动约束,这个预积分的 法直接获得可靠的深度信息,从而初始地图创建及 MU模型能被完美地融合到视觉-惯性的因子图的 特征点的深度恢复都比较困难。此外,尺度不确定 框架下。该系统的实验结果表明该系统要比Google 性是单目SLAM的主要特点,它是主要的误差源之 的Tango还要精确2,如图3所示。 一,但是正是尺度不确定性才使得单目SLAM能够

g2o( general graph optimization) [66] 里的 LM ( leven⁃ berg⁃marquardt)算法实现。 文献[29]提出的 RGB_D SLAM 算法的位姿图 里每个边具有一个权重,从而在优化过程中,不确定 性高的边比不确定性低的边需要变化更多去补偿误 差,并在最后,对图里的每个顶点进行额外的闭环检 测且重新优化整个图。 文献[67]里,在闭环校正步 骤使用了位姿图优化技术去实现旋转,平移及尺度 漂浮的有效校正。 文献[13] 在闭环检测成功后构 建了本质图,并对该图进行位姿图优化。 本质图包 含所有的关键帧,但相比于 covisibility 图[68] ,减少 了关键帧之间的边约束。 本质图包含生成树、闭环 连接及 covisibility 图里权重较大的边。 3 视觉 SLAM 主要发展趋势及研究热点 3.1 多传感器融合 相机能够捕捉场景的丰富细节,而惯性测量单 元(inertial measurement unit,IMU)有高的帧率且相 对小的能够获得准确的短时间估计,这两个传感器 能够相互互补,从而一起使用能够获得更好的结果。 最初的视觉与 IMU 结合的位姿估计是用滤波 方法解决的,用 IMU 的测量值作为预测值,视觉的 测量值用于更新。 文献[69]提出了一种基于 EKF 的 IMU 与单目视觉的实时融合方法,提出一种测量 模型能够表示一个静态特征被多个相机所观察时的 几何约束,该测量模型是最优的且不需要在 EKF 的 状态向量里包括特征的 3⁃D 坐标。 文献[70] 将融 合问题分为两个线程进行处理,连续图像之间的惯 性测量和特征跟踪被局部地在第 1 个线程进行处 理,提供高频率的位置估计,第 2 个线程包含一个间 歇工作的光束法平差的迭代估计,能够减少线性误 差的影响。 许多结果都已证明在准确性上基于优化 的视觉 SLAM 优于基于滤波的 SLAM 方法。 文献 [71]将 IMU 的误差以全概率的形式融合到路标的 重投影误差里,构成将被优化的联合非线性误差函 数,其中通过关键帧来边缘化之前的状态去维持一 个固定大小的优化窗口,保证实时操作。 考虑到基 于优化方法的视觉-惯导导航的计算复杂度问题, 文献[72]通过预积分选出的关键帧之间的惯性测 量来进行解决,预积分能够精确地概括数百个惯性 测量到一个单独的相对运动约束,这个预积分的 IMU 模型能被完美地融合到视觉-惯性的因子图的 框架下。 该系统的实验结果表明该系统要比 Google 的 Tango 还要精确[72] ,如图 3 所示。 (a)正视图 (b)俯视图 图 3 与 Tango 的性能比较[72] Fig.3 Performance comparison with tango [72] 共 160 m 的轨迹开始于(0,0,0) 点,走到建筑 物的第 3 层,然后再返回到初始点。 其中,Google Tango 积累 1. 4 m 的误差,而该提出的方法仅有 0.5 m的漂移。 即使在视觉与 IMU 融合的系统里,当机器人运 动较为剧烈时,由于其不确定性增大,还是会导致定 位失败,从而系统的鲁棒性有待进一步提高。 并且 为在现实生活中实现实时定位,其计算复杂度也需 要进行改进。 3.2 SLAM 与深度学习的结合 随着深度学习在计算机视觉领域的大成功,大 家对深度学习在机器人领域的应用有很大的兴趣。 SLAM 是一个大系统,里面有很多子模块,例如闭环 检测,立体匹配等,都可通过深度学习的使用来获得 更优的结果。 文献[73]提出了一种基于深度学习的立体匹 配方法,用卷积神经网络来学习小图像块间的相似 性,该卷积神经网络输出的结果用于线性化立体匹 配代价。 文献[74]通过整合局部敏感散列法和新 的语义搜寻空间划分的优化技术,使用卷积神经网 络和大的地图达到实时的位置识别。 文献[75] 使 用卷积神经网络去学习视觉里程计的最佳的视觉特 征和最优的估计器。 文献[76] 提出了一种重定位 系统,使用贝叶斯卷积神经网络从单个彩色图像计 算出六个自由度的相机位姿及其不确定性。 4 视觉 SLAM 的优缺点分析 4.1 单目视觉 SLAM 的优缺点 单目相机应用灵活、简单、价格低。 但是,单目 视觉 SLAM 在每个时刻只能获取一张图像,且只能 依靠获得的图像数据计算环境物体的方向信息,无 法直接获得可靠的深度信息,从而初始地图创建及 特征点的深度恢复都比较困难。 此外,尺度不确定 性是单目 SLAM 的主要特点,它是主要的误差源之 一,但是正是尺度不确定性才使得单目 SLAM 能够 ·772· 智 能 系 统 学 报 第 11 卷

第6期 权美香,等:视觉SLAM综述 ·773· 在大尺度和小尺度环境之间进行自由转换。 SLAM for large-scale outdoor environments[C]//Proceed- 4.2双目视觉SLAM的优缺点 ings of 2005 IEEE/RSJ International Conference on Intelli- 双目视觉SLAM利用外极线几何约束的原理去 gent Robots and Systems.Edmonton,Alberta,Canada, 匹配左右两个相机的特征,从而能够在当前帧速率 2005:3427-3432 [6]CHEKHLOV D,PUPILLI M,MAYOL-CUEVAS W,et al. 的条件下直接提取完整的特征数据,因而应用比较 广泛,它直接解决了系统地图特征的初始化问题。 Real-time and robust monocular SLAM using predictive multi-resolution descriptors[C]Proceedings of the Sec- 但是系统设计比较复杂,系统成本比较高,且它的视 ond International Conference on Advances in Visual Compu- 角范围受到一定限制,不能够获取远处的场景,从而 ti.Lake Tahoe,USA,2006:276-285. 只能在一定的尺度范围内进行可靠的测量,从而缺 [7]HOLMES S,KLEIN G,MURRAY D W.A square root un- 乏灵活性。 scented kalman filter for visual monoSLAM[C]//Proceed- 4.3 RGBD SLAM的优缺点 ings of 2008 International Conference on Robotics and Auto- 深度相机在获得彩色图像的同时获得深度图 mation,ICRA.Pasadena,California,USA,2008:3710- 像,从而方便获得深度信息,且能够获得稠密的地 3716. 图,但是成本高,体积大,有效探测距离太短,从而可 [8]SIM R,ELINAS P,GRIFFIN M,et al.Vision-based SLAM 应用环境很有限。 using the Rao-Blackwellised particle filter[J].IJCAI work- shop on reasoning with uncertainty in robotics,2005,9 5结束语 (4):500-509. [9]LI Maohai,HONG Bingrong,CAI Zesu,et al.Novel Rao- 十几年来,视觉SLAM虽然取得了惊人的发展, Blackwellized particle filter for mobile robot SLAM using 但是仅用摄像机作为唯一外部传感器进行同时定位 monocular vision [J].International journal of intelligent 与三维地图重建还是一个很具挑战性的研究方向, technolog,2006,1(1):63-69. 想要实时进行自身定位且构建类似人眼看到的环境 [10]KLEIN G,MURRAY D.Parallel Tracking and Mapping 地图还有很长的科研路要走。为了弥补视觉信息的 for Small AR Workspaces[Cl//IEEE and ACM Interna- 不足,视觉传感器可以与惯性传感器(MU)、激光等 tional Symposium on Mixed and Augmented Reality.Nara, 传感器融合,通过传感器之间的互补获得更加理想 Japan,2007:225-234. [11]KLEIN G,MURRAY D.Improving the agility of keyframe- 的结果。此外,为了能在实际环境中进行应用, based SLAM[C]//European Conference on Computer Vi- SLAM的鲁棒性需要很高,从而足够在各种复杂环 sion.Marseille,France,2008:802-815. 境下进行准确的处理,SLAM的计算复杂度也不能 [12]MUR-ARTAL R,TARDOS J D.Fast relocalisation and 太高,从而达到实时效果。 loop closing in keyframe-based SLAM[C]//IEEE Inter- 参考文献: national Conference on Robotics and Automation.New Or- leans,LA,2014:846-853. [1]DAVISON A J.SLAM with a single camera[C]//Proceed- [13]MUR-ARTAL R,MONTIEL J M M,TARDOS J D.ORB- ings of Workshop on Concurrent Mapping an Localization for SLAM:A Versatile and Accurate Monocular SLAM System Autonomous Mobile Robots in Conjunction with ICRA. []IEEE transactions on robotics,2015,31(5):1147- Washington,DC,USA,2002:18-27. 1163. [2]DAVISON A J.Real-time simultaneous localisation and [14]KHOSHELHAM K,ELBERINK S O.Accuracy and resolu- mapping with a single camera [C]//Proceedings of the tion of Kinect depth data for indoor mapping applications Ninth IEEE International Conference on Computer Vision. [J].Sensors,2012,12(2):1437-1454. Washington,DC,USA,2003:1403-1410. [15]HOGMAN V.Building a 3-D Map from RGB-D sensors [3]DAVISON A J,REID I D,MOLTON N D,et al.Mono- [D].Stockholm,Sweden:Royal Institute of Technology, SLAM:real-time single camera SLAM[J].IEEE transac- 2012. tions on pattern analysis and machine intelligence,2007,29 [16]HENRY P,KRAININ M,HERBST E,et al.RGB-D map- (6):1052-1067. ping:Using depth cameras for dense 3-D modeling of in- [4]CIVERA J,DAVISON A J,MONTIEL J MM.Inverse door environments C]//12th International Symposium on depth parametrization for monocular SLAM[.IEEE trans- Experimental Robotics.Berlin,Germany,2014:477-491. actions on robotics,2008,24(5):932-945. [17]DRYANOVSKI I,VALENTI R G,XIAO J Z.Fast visual [5]MARTINEZ-CANTIN R,CASTELLANOS J A.Unscented odometry and mapping from RGB-D data[C]//IEEE In-

在大尺度和小尺度环境之间进行自由转换。 4.2 双目视觉 SLAM 的优缺点 双目视觉 SLAM 利用外极线几何约束的原理去 匹配左右两个相机的特征,从而能够在当前帧速率 的条件下直接提取完整的特征数据,因而应用比较 广泛,它直接解决了系统地图特征的初始化问题。 但是系统设计比较复杂,系统成本比较高,且它的视 角范围受到一定限制,不能够获取远处的场景,从而 只能在一定的尺度范围内进行可靠的测量,从而缺 乏灵活性。 4.3 RGBD SLAM 的优缺点 深度相机在获得彩色图像的同时获得深度图 像,从而方便获得深度信息,且能够获得稠密的地 图,但是成本高,体积大,有效探测距离太短,从而可 应用环境很有限。 5 结束语 十几年来,视觉 SLAM 虽然取得了惊人的发展, 但是仅用摄像机作为唯一外部传感器进行同时定位 与三维地图重建还是一个很具挑战性的研究方向, 想要实时进行自身定位且构建类似人眼看到的环境 地图还有很长的科研路要走。 为了弥补视觉信息的 不足,视觉传感器可以与惯性传感器(IMU)、激光等 传感器融合,通过传感器之间的互补获得更加理想 的结果。 此外, 为了能在实际环境中进行应用, SLAM 的鲁棒性需要很高,从而足够在各种复杂环 境下进行准确的处理,SLAM 的计算复杂度也不能 太高,从而达到实时效果。 参考文献: [1]DAVISON A J. SLAM with a single camera[C] / / Proceed⁃ ings of Workshop on Concurrent Mapping an Localization for Autonomous Mobile Robots in Conjunction with ICRA. Washington, DC, USA, 2002: 18-27. [2] DAVISON A J. Real⁃time simultaneous localisation and mapping with a single camera [ C] / / Proceedings of the Ninth IEEE International Conference on Computer Vision. Washington, DC, USA, 2003: 1403-1410. [3]DAVISON A J, REID I D, MOLTON N D, et al. Mono⁃ SLAM: real⁃time single camera SLAM[ J]. IEEE transac⁃ tions on pattern analysis and machine intelligence, 2007, 29 (6): 1052-1067. [4] CIVERA J, DAVISON A J, MONTIEL J M M. Inverse depth parametrization for monocular SLAM[J]. IEEE trans⁃ actions on robotics, 2008, 24(5): 932-945. [5] MARTINEZ⁃CANTIN R, CASTELLANOS J A. Unscented SLAM for large⁃scale outdoor environments[C] / / Proceed⁃ ings of 2005 IEEE/ RSJ International Conference on Intelli⁃ gent Robots and Systems. Edmonton, Alberta, Canada, 2005: 3427-3432 [6]CHEKHLOV D, PUPILLI M, MAYOL⁃CUEVAS W, et al. Real⁃time and robust monocular SLAM using predictive multi⁃resolution descriptors [ C] / / Proceedings of the Sec⁃ ond International Conference on Advances in Visual Compu⁃ ti. Lake Tahoe, USA, 2006: 276-285. [7]HOLMES S, KLEIN G, MURRAY D W. A square root un⁃ scented kalman filter for visual monoSLAM[C] / / Proceed⁃ ings of 2008 International Conference on Robotics and Auto⁃ mation, ICRA. Pasadena, California, USA, 2008: 3710 - 3716. [8]SIM R, ELINAS P, GRIFFIN M, et al. Vision⁃based SLAM using the Rao⁃Blackwellised particle filter[ J]. IJCAI work⁃ shop on reasoning with uncertainty in robotics, 2005, 9 (4): 500-509. [9]LI Maohai, HONG Bingrong, CAI Zesu, et al. Novel Rao⁃ Blackwellized particle filter for mobile robot SLAM using monocular vision [ J ]. International journal of intelligent technology, 2006, 1(1): 63-69. [10] KLEIN G, MURRAY D. Parallel Tracking and Mapping for Small AR Workspaces[C] / / IEEE and ACM Interna⁃ tional Symposium on Mixed and Augmented Reality. Nara, Japan, 2007: 225-234. [11]KLEIN G, MURRAY D. Improving the agility of keyframe⁃ based SLAM[C] / / European Conference on Computer Vi⁃ sion. Marseille, France, 2008: 802-815. [12] MUR⁃ARTAL R, TARDÓS J D. Fast relocalisation and loop closing in keyframe⁃based SLAM[C] / / IEEE Inter⁃ national Conference on Robotics and Automation. New Or⁃ leans, LA, 2014: 846-853. [13]MUR⁃ARTAL R, MONTIEL J M M, TARDOS J D. ORB⁃ SLAM: A Versatile and Accurate Monocular SLAM System [J]. IEEE transactions on robotics, 2015, 31(5): 1147- 1163. [ 14]KHOSHELHAM K, ELBERINK S O. Accuracy and resolu⁃ tion of Kinect depth data for indoor mapping applications [J]. Sensors, 2012, 12(2): 1437-1454. [15] HOGMAN V. Building a 3⁃D Map from RGB⁃D sensors [D]. Stockholm, Sweden: Royal Institute of Technology, 2012. [ 16]HENRY P, KRAININ M, HERBST E, et al. RGB⁃D map⁃ ping: Using depth cameras for dense 3⁃D modeling of in⁃ door environments[ C] / / 12th International Symposium on Experimental Robotics. Berlin, Germany, 2014: 477-491. [17]DRYANOVSKI I, VALENTI R G, XIAO J Z. Fast visual odometry and mapping from RGB⁃D data[C] / / IEEE In⁃ 第 6 期 权美香,等:视觉 SLAM 综述 ·773·

.774. 智能系统学报 第11卷 ternational Conference on Robotics and Automation.Piscat- Applications.Lisbon,Portugal,2014:1103-1114 away,USA,2013:2305-2310. [29]KERL C.STURM J.CREMERS D.Dense visual SLAM 18]HENRY P,KRAININ M,HERBST E,et al.RGB-D map- for RGB-D cameras[C]//Proceedings of IEEE/RSJ Inter- ping:using depth cameras for dense 3-D modeling of in- national Conference on Intelligent Robots and Systems.To- door environments[M]//KHATIB O,KUMAR V,PAP. kyo,Japan,2013:2100-2106. PAS G J.Experimental Robotics.Berlin Heidelberg: [30]Lowe D G.Distinctive image features from scale-invariant Springer,2014:647-663. keypoints[J].International journal of computer vision, [19]HENRY P,KRAININ M,HERBST E,et al.RGB-D 2004,60(2):91-110. Mapping:Using Depth Cameras for Dense 3-D Modeling [31]BAY H,TUYTELAARS T,VAN GOOL L.SURF:spee- of Indoor Environments[C]//12th International Symposi- ded up robust features M]//LEONARDIS A,BISCHOF um on Experimental Robotics.Berlin Germany,2014:477 H,PINZ A.Computer Vision-ECCV 2006.Berlin Heidel- -491. berg:Springer,2006. [20]HENRY P,KRAININ M,HERBST E,et al.RGB-D map- [32]RUBLEE E.RABAUD V,KONOLIGE K,et al.ORB: ping:Using Kinect-style depth cameras for dense 3-D An efficient alternative to SIFT or SURF[C]//Interna- modeling of indoor environments[J].International journal tional Conference on Computer Vision.Barcelona,Spain, of robotics research,2012,31(5):647-663. 2011:2564-2571. [21]ENGELHARD N,ENDRES F,HESS J.Real-time 3-D [33]ALI A M,JAN NORDIN M.SIFT based monocular SLAM visual SLAM with a hand-held RGB-D camera[C]//Pro- with multi-clouds features for indoor navigation[C]//2010 ceeedings of the RGB-D workshop on 3-D Perception in IEEE Region 10 Conference TENCON.Fukuoka,2010: Robotics at the European Robotics Forum.Vasteras,Swe- 2326-2331. den,2011. [34]WU E Y,ZHAO L K,GUO Y P,et al.Monocular vision [22]STUHMER J,GUMHOLD S,CREMERS D.Real-time SLAM based on key feature points selection[C]//2010 dense geometry from a handheld camera[C//GOESELE IEEE International Conference on Information and Automa- M,ROTH S,KUIJPER A,et al.Pattern Recognition. tion (ICIA).Harbin,China,2010:1741-1745. Berlin Heidelberg:Springer,2010:11-20. [35]CHEN C H,CHAN Y P.SIFT-based monocluar SLAM [23]ENGEL J,STURM J,CREMERS D.Semi-Dense Visual with inverse depth parameterization for robot localization Odometry for a Monocular Camera C]//International [C]//IEEE Workshop on Advanced Robotics and Its So- Conference on Computer Vision.Sydney,NSW,2013: cial Impacts,2007.Hsinchu,China,2007:1-6. 1449-1456. [36]Zhu D X.Binocular Vision-SLAM Using Improved SIFT [24]NEWCOMBE R A.LOVEGROVE S J.DAVISON A J. Algorithm[C]//2010 2nd International Workshop on In- DTAM:Dense tracking and mapping in real-time [C]// telligent Systems and Applications (ISA).Wuhan,China, International Conference on Computer Vision.Barcelona, 2010:1-4. Spain,2011:2320-2327. [37]ZHANG Z Y,HUANG Y L,LI C,et al.Monocular vision [25]FORSTER C.PIZZOLI M.SCARAMUZZA D.SVO:Fast simultaneous localization and mapping using SURF[C]/ semi-direct monocular visual odometry [C]//2014 IEEE WCICA 2008.7th World Congress on Intelligent Control International Conference onRobotics and Automation.Hong and Automation.Chongqing,China,2008:1651-1656. Kong,China,2014:15-22. [38]YE Y.The research of SLAM monocular vision based on [26]ENGEL J,SCHOPS T,CREMERS D.LSD-SLAM:Large- the improved surf feather[C]//International Conference Scale Direct Monocular SLAM[M1//FLEET D,PAJDLA on Computational Intelligence and Communication Net- T,SCHIELE B,et al,eds.Computer Vision-ECCV 2014. works.Hongkong,China,2014:344-348. Switzerland:Springer International Publishing,2014:834 [39]WANG Y T,FENG Y C.Data association and map man- -849. agement for robot SLAM using local invariant features [27]NEWCOMBE R A,IZADI S,HILLIGES O,et al.Kinect- [C]//2013 IEEE International Conference on Mechatron- Fusion:Real-time dense surface mapping and tracking ics and Automation.Takamatsu,2013. [C]//IEEE International Symposium on Mixed and Aug- [40]ROSTEN E,DRUMMOND T.Machine Learning for High- mented Reality.Basel,Switzerland,2011:127-136. Speed Corer Detection[M]//LEONARDIS A,BISCHOF [28]GOKHOOL T,MEILLAND M,RIVES P,et al.A dense H,PINZ A,et al.European Conference on Computer Vi- map building approach from spherical RGBD images[C]/ sion.Berlin Heidelberg:Springer,2006:430-443. International Conference on Computer Vision Theory and [41]CALONDER M,LEPETIT V,STRECHA C,et al

ternational Conference on Robotics and Automation. Piscat⁃ away, USA, 2013: 2305-2310. [ 18]HENRY P, KRAININ M, HERBST E, et al. RGB⁃D map⁃ ping: using depth cameras for dense 3⁃D modeling of in⁃ door environments[M] / / KHATIB O, KUMAR V, PAP⁃ PAS G J. Experimental Robotics. Berlin Heidelberg: Springer, 2014: 647-663. [19] HENRY P, KRAININ M, HERBST E, et al. RGB⁃D Mapping: Using Depth Cameras for Dense 3⁃D Modeling of Indoor Environments[C] / / 12th International Symposi⁃ um on Experimental Robotics. Berlin Germany, 2014: 477 -491. [ 20]HENRY P, KRAININ M, HERBST E, et al. RGB⁃D map⁃ ping: Using Kinect⁃style depth cameras for dense 3⁃D modeling of indoor environments[ J]. International journal of robotics research, 2012, 31(5): 647-663. [21] ENGELHARD N, ENDRES F, HESS J. Real⁃time 3⁃D visual SLAM with a hand⁃held RGB⁃D camera[C] / / Pro⁃ ceeedings of the RGB⁃D workshop on 3⁃D Perception in Robotics at the European Robotics Forum. Våsterås, Swe⁃ den, 2011. [22] STÜHMER J, GUMHOLD S, CREMERS D. Real⁃time dense geometry from a handheld camera[C] / / GOESELE M, ROTH S, KUIJPER A, et al. Pattern Recognition. Berlin Heidelberg: Springer, 2010: 11-20. [23]ENGEL J, STURM J, CREMERS D. Semi⁃Dense Visual Odometry for a Monocular Camera [ C] / / International Conference on Computer Vision. Sydney, NSW, 2013: 1449-1456. [24] NEWCOMBE R A, LOVEGROVE S J, DAVISON A J. DTAM: Dense tracking and mapping in real⁃time [ C] / / International Conference on Computer Vision. Barcelona, Spain, 2011: 2320-2327. [25]FORSTER C, PIZZOLI M, SCARAMUZZA D. SVO: Fast semi⁃direct monocular visual odometry [ C] / / 2014 IEEE International Conference onRobotics and Automation. Hong Kong, China, 2014: 15-22. [26]ENGEL J, SCHÖPS T, CREMERS D. LSD⁃SLAM: Large⁃ Scale Direct Monocular SLAM[M] / / FLEET D, PAJDLA T, SCHIELE B, et al, eds. Computer Vision⁃ECCV 2014. Switzerland: Springer International Publishing, 2014: 834 -849. [27]NEWCOMBE R A, IZADI S, HILLIGES O, et al. Kinect⁃ Fusion: Real⁃time dense surface mapping and tracking [C] / / IEEE International Symposium on Mixed and Aug⁃ mented Reality. Basel, Switzerland, 2011: 127-136. [28]GOKHOOL T, MEILLAND M, RIVES P, et al. A dense map building approach from spherical RGBD images[C] / / International Conference on Computer Vision Theory and Applications. Lisbon, Portugal, 2014: 1103-1114. [29]KERL C, STURM J, CREMERS D. Dense visual SLAM for RGB⁃D cameras[C] / / Proceedings of IEEE/ RSJ Inter⁃ national Conference on Intelligent Robots and Systems. To⁃ kyo, Japan, 2013: 2100-2106. [30]Lowe D G. Distinctive image features from scale⁃invariant keypoints [ J ]. International journal of computer vision, 2004, 60(2): 91-110. [31]BAY H, TUYTELAARS T, VAN GOOL L. SURF: spee⁃ ded up robust features[M] / / LEONARDIS A, BISCHOF H, PINZ A. Computer Vision⁃ECCV 2006. Berlin Heidel⁃ berg: Springer, 2006. [32] RUBLEE E, RABAUD V, KONOLIGE K, et al. ORB: An efficient alternative to SIFT or SURF[ C] / / Interna⁃ tional Conference on Computer Vision. Barcelona, Spain, 2011: 2564-2571. [33]ALI A M, JAN NORDIN M. SIFT based monocular SLAM with multi⁃clouds features for indoor navigation[C] / / 2010 IEEE Region 10 Conference TENCON. Fukuoka, 2010: 2326-2331. [34]WU E Y, ZHAO L K, GUO Y P, et al. Monocular vision SLAM based on key feature points selection [ C] / / 2010 IEEE International Conference on Information and Automa⁃ tion (ICIA). Harbin, China, 2010: 1741-1745. [35] CHEN C H, CHAN Y P. SIFT⁃based monocluar SLAM with inverse depth parameterization for robot localization [C] / / IEEE Workshop on Advanced Robotics and Its So⁃ cial Impacts, 2007. Hsinchu, China, 2007: 1-6. [36] Zhu D X. Binocular Vision⁃SLAM Using Improved SIFT Algorithm[C] / / 2010 2nd International Workshop on In⁃ telligent Systems and Applications (ISA). Wuhan, China, 2010: 1-4. [37]ZHANG Z Y, HUANG Y L, LI C, et al. Monocular vision simultaneous localization and mapping using SURF[C] / / WCICA 2008. 7th World Congress on Intelligent Control and Automation. Chongqing, China, 2008: 1651-1656. [38]YE Y. The research of SLAM monocular vision based on the improved surf feather [ C] / / International Conference on Computational Intelligence and Communication Net⁃ works. Hongkong, China, 2014: 344-348. [39]WANG Y T, FENG Y C. Data association and map man⁃ agement for robot SLAM using local invariant features [C] / / 2013 IEEE International Conference on Mechatron⁃ ics and Automation. Takamatsu, 2013. [40]ROSTEN E, DRUMMOND T. Machine Learning for High⁃ Speed Corner Detection[M] / / LEONARDIS A, BISCHOF H, PINZ A, et al. European Conference on Computer Vi⁃ sion. Berlin Heidelberg: Springer, 2006: 430-443. [ 41 ] CALONDER M, LEPETIT V, STRECHA C, et al. ·774· 智 能 系 统 学 报 第 11 卷

第6期 权美香,等:视觉SLAM综述 .775· BRIEF:Binary Robust Independent Elementary Features ping Large Loops with a Single Hand-Held Camera.[C]/ [C]//European Conference on Computer Vision.Crete, Robotics:Science and Systems.Atlanta,GA,USA,2007 Greece,2010:778-792. [55]CUMMINS M,NEWMAN P.FAB-MAP:Probabilistic Lo- [42]FEN X,ZHEN W.An embedded visual SLAM algorithm calization and Mapping in the Space of Appearance[J].In- based on Kinect and ORB features[C]//2015 34th Chi- ternational Journal of Robotics Research,2008,27(6): nese Control Conference.Hangzhou,China,2015:6026- 647-665. 6031. [56]NISTER D,STEWENIUS H.Scalable Recognition with a [43]XIN G X,ZHANG X T,WANG X,et al.A RGBD SLAM Vocabulary Tree[C]//2006 IEEE Computer Society Con- algorithm combining ORB with PROSAC for indoor mobile ference on Computer Vision and Pattern Recognition robot[Cl//2015 4th International Conference on Comput- (CVPR06).New York.NY.USA,2006:2161-2168. er Science and Network Technology ICCSNT).Harbin, [57]ANGELI A,FILLIAT D,DONCIEUX S,et al.A fast and China,2015:71-74. incremental method for loop-closure detection using bags of [44]LI J,PAN T S,TSENG KK,et al.Design of a monocular visual words[J].IEEE transactions on robotics,2008,24 simultaneous localisation and mapping system with ORB (5):1027-1037. feature[C]//International Conference on Multimedia and [58]CUMMINS M,NEWMAN P.Highly scalable appearance- Expo (ICME),San Jose,California,USA,2013:1-4. only SLAM-FAB-MAP 2.0[C]//Robotics:Science and [45]EADE E,DRUMMOND T.Edge landmarks in monocular Systems V,University of Washington.Seattle,USA,2009. SLAM[J].Image and vision computing,2009.27(5): [59]GALVEZ-LOPEZ D,TARDOS J D.Bags of binary words 588-596. for fast place recognition in image sequences J].IEEE [46]KLEIN G,MURRAY D.Improving the agility of keyframe- Transactions on robotics,2012,28(5):1188-1197. based SLAM[C]//European Conference on Computer Vi- [60]EADE E D,DRUMMOND T W.Unified loop closing and sion.Marseille,France,2008:802-815. recovery for real time monocular SLAM [C]//British Ma [47]CONCHA A,CIVERA J.Using superpixels in monocular chine Vision Conference.Leeds,UK,2008:1-10. SLAM[C]//IEEE International Conference on Robotics [61]GALVEZ-LOPEZ D,TARDOS J D.Real-time loop detec- and Automation.New Orleans,LA,2014:365-372. tion with bags of binary words[C]//IEEE/RSJ Interna- 48]SCHINDLER G,BROWN M,SZELISKI R.City-Scale Lo- tional Conference on Intelligent Robots and Systems.San cation Recognition[C]//IEEE Conference on Computer Vi- Francisco,California,USA,2011:51-58. sion and Pattern Recognition.Ezhou,China,2007:1-7. [62 CUMMINS M,NEWMAN P.Appearance-only SLAM at [49]ULRICH I,NOURBAKHSH I.Appearance-based place large scale with FAB-MAP 2.0[J].International journal of recognition for topological localization[C]/IEEE Inter- robotics research,2011,30(9):1100-1123. national Conference on Robotics and Automation.Anchor- [63]LOWE D G.Distinctive Image features from scale-invariant age,Alaska,2010:1023-1029. keypoints[J.International journal of computer vision, [50]NEIRA J,RIBEIRO M I,TARDOS J D.Mobile robot lo- 2004,60(2):91-110. calization and map building using monocular vision[C]/ [64]TRIGGS B,MCLAUCHLAN P F,HARTLEY R I,et al. Proceedings of the 5th International Symposium on Intelli- Bundle Adjustment-A Modern Synthesis[M]//TRIGGS gent Robotic Systems.Pisa,Italy,1997:275-284. B,ZISSERMAN A,SZELISKI R.Vision Algorithms:The- [51]WILLIAMS B,CUMMINS M,NEIRA J,et al.A compari- ory and Practice.Berlin Heidelberg:Springer,2000:298 son of loop closing techniques in monocular SLAM[J].Ro- -372. botics and autonomous systems,2009,57(12):1188- [65]HARTLEY R,ZISSERMAN A.Multiple view geometry in 1197 computer vision[M].2nd ed.Cambridge U K:Cambridge [52]MUR-ARTAL R,TARDOS J D.ORB-SLAM:Tracking University Press,2003. and mapping recognizable features[C]//IEEE Interna- [66]KUMMERLE R,GRISETTI G,STRASDAT H.G2o:A tional Conference on Robotics and Automation (ICRA). general framework for graph optimization[C]/IEEE In- Berkeley,CA,USA,2014. ternational Conference on Robotics and Automation.Shang- [53]CUMMINS M,NEWMAN P.Accelerated appearance-only hai,China,2011:3607-3613. SLAM[C]//IEEE International Conference on Robotics [67]STRASDAT H,MONTIEL J MM,DAVISON A J.Scale and Automation.Pasadena,California,USA,2008:1828 drift-aware large scale monocular SLAM [C]//Proceed- -1833. ings of Robotics:Science and Systems.Zaragoza,Spain, [54]CLEMENTE L A,DAVISON A J,REID I D,et al.Map- 2010

BRIEF: Binary Robust Independent Elementary Features [C] / / European Conference on Computer Vision. Crete, Greece, 2010: 778-792. [42] FEN X, ZHEN W. An embedded visual SLAM algorithm based on Kinect and ORB features[C] / / 2015 34th Chi⁃ nese Control Conference. Hangzhou, China, 2015: 6026- 6031. [43]XIN G X, ZHANG X T, WANG X, et al. A RGBD SLAM algorithm combining ORB with PROSAC for indoor mobile robot[C] / / 2015 4th International Conference on Comput⁃ er Science and Network Technology ( ICCSNT). Harbin, China, 2015: 71-74. [44]LI J, PAN T S, TSENG K K, et al. Design of a monocular simultaneous localisation and mapping system with ORB feature[C] / / International Conference on Multimedia and Expo (ICME), San Jose, California, USA, 2013: 1-4. [45] EADE E, DRUMMOND T. Edge landmarks in monocular SLAM[ J]. Image and vision computing, 2009, 27( 5): 588-596. [46]KLEIN G, MURRAY D. Improving the agility of keyframe⁃ based SLAM[C] / / European Conference on Computer Vi⁃ sion. Marseille, France, 2008: 802-815. [47]CONCHA A, CIVERA J. Using superpixels in monocular SLAM[ C] / / IEEE International Conference on Robotics and Automation. New Orleans, LA, 2014: 365-372. [48]SCHINDLER G, BROWN M, SZELISKI R. City⁃Scale Lo⁃ cation Recognition[C] / / IEEE Conference on Computer Vi⁃ sion and Pattern Recognition. Ezhou, China, 2007: 1-7. [49] ULRICH I, NOURBAKHSH I. Appearance⁃based place recognition for topological localization[C] / / IEEE Inter⁃ national Conference on Robotics and Automation. Anchor⁃ age, Alaska, 2010: 1023-1029. [50]NEIRA J, RIBEIRO M I, TARDOS J D. Mobile robot lo⁃ calization and map building using monocular vision[C] / / Proceedings of the 5th International Symposium on Intelli⁃ gent Robotic Systems. Pisa, Italy, 1997: 275-284. [51]WILLIAMS B, CUMMINS M, NEIRA J, et al. A compari⁃ son of loop closing techniques in monocular SLAM[J]. Ro⁃ botics and autonomous systems, 2009, 57 ( 12): 1188 - 1197. [52] MUR⁃ARTAL R, TARDOS J D. ORB⁃SLAM: Tracking and mapping recognizable features [ C] / / IEEE Interna⁃ tional Conference on Robotics and Automation ( ICRA). Berkeley, CA, USA, 2014. [53]CUMMINS M, NEWMAN P. Accelerated appearance⁃only SLAM[ C] / / IEEE International Conference on Robotics and Automation. Pasadena, California, USA, 2008: 1828 -1833. [54]CLEMENTE L A, DAVISON A J, REID I D, et al. Map⁃ ping Large Loops with a Single Hand⁃Held Camera. [C] / / Robotics: Science and Systems. Atlanta, GA, USA, 2007. [55]CUMMINS M, NEWMAN P. FAB⁃MAP: Probabilistic Lo⁃ calization and Mapping in the Space of Appearance[J]. In⁃ ternational Journal of Robotics Research, 2008, 27 ( 6): 647-665. [56]NISTER D, STEWENIUS H. Scalable Recognition with a Vocabulary Tree[C] / / 2006 IEEE Computer Society Con⁃ ference on Computer Vision and Pattern Recognition (CVPR'06). New York, NY, USA, 2006: 2161-2168. [57]ANGELI A, FILLIAT D, DONCIEUX S, et al. A fast and incremental method for loop⁃closure detection using bags of visual words[J]. IEEE transactions on robotics, 2008, 24 (5): 1027-1037. [58]CUMMINS M, NEWMAN P. Highly scalable appearance⁃ only SLAM⁃FAB⁃MAP 2. 0 [ C] / / Robotics: Science and Systems V, University of Washington. Seattle, USA, 2009. [59]GALVEZ⁃LÓPEZ D, TARDOS J D. Bags of binary words for fast place recognition in image sequences [ J]. IEEE Transactions on robotics, 2012, 28(5): 1188-1197. [60]EADE E D, DRUMMOND T W. Unified loop closing and recovery for real time monocular SLAM [C] / / British Ma⁃ chine Vision Conference. Leeds, UK, 2008: 1-10. [61]GÁLVEZ⁃LÓPEZ D, TARDOS J D. Real⁃time loop detec⁃ tion with bags of binary words[C] / / IEEE/ RSJ Interna⁃ tional Conference on Intelligent Robots and Systems. San Francisco, California, USA, 2011: 51-58. [62] CUMMINS M, NEWMAN P. Appearance⁃only SLAM at large scale with FAB⁃MAP 2.0[J]. International journal of robotics research, 2011, 30(9): 1100-1123. [63]LOWE D G. Distinctive Image features from scale⁃invariant keypoints [ J ]. International journal of computer vision, 2004, 60(2): 91-110. [64]TRIGGS B, MCLAUCHLAN P F, HARTLEY R I, et al. Bundle Adjustment⁃A Modern Synthesis [ M] / / TRIGGS B, ZISSERMAN A, SZELISKI R. Vision Algorithms: The⁃ ory and Practice. Berlin Heidelberg: Springer , 2000: 298 -372. [65]HARTLEY R, ZISSERMAN A. Multiple view geometry in computer vision[M]. 2nd ed. Cambridge U K: Cambridge University Press, 2003. [66] KÜMMERLE R, GRISETTI G, STRASDAT H. G2o: A general framework for graph optimization[C] / / IEEE In⁃ ternational Conference on Robotics and Automation. Shang⁃ hai, China, 2011: 3607-3613. [67] STRASDAT H, MONTIEL J M M, DAVISON A J. Scale drift⁃aware large scale monocular SLAM [ C] / / Proceed⁃ ings of Robotics: Science and Systems. Zaragoza, Spain, 2010. 第 6 期 权美香,等:视觉 SLAM 综述 ·775·

·776 智能系统学报 第11卷 [68]STRASDAT H,DAVISON A J,MONTIEL J MM,et al. [75]COSTANTE G,MANCINI M,VALIGI P,et al.Exploring Double window optimisation for constant time visual SLAM representation learning with CNNs for frame-to-frame ego- [C]//International Conference on Computer Vision.Bar- motion estimation[J].IEEE robotics and automation let- celona.Spain,2011:2352-2359. ters,2016,1(1):18-25. [69]MOURIKIS A I,ROUMELIOTIS S I.A multi-state con- [76]KENDALL A,CIPOLLA R.Modelling uncertainty in deep straint Kalman filter for vision-aided inertial navigation learning for camera relocalization[C]//2016 IEEE Inter- [C]//Proceedings of the 2007 IEEE International Confer- national Conference on Robotics and Automation.Stock- ence on Robotics and Automation (ICRA).Roma,Italy, holm.Sweden,2016:4762-4769 2007. 作者简介: [70]MOURIKIS A I,ROUMELIOTIS S I.A dual-layer estima 权美香,女,1992年生,博士,主要 tor architecture for long-term localization C]//Proceed- 研究方向为单目视觉SLAM,VIN,移动 ings of the 2008 Workshop on Visual Localization for Mo- 机器人视觉导航。 bile Platforms at CVPR.Anchorage,Alaska,2008. [71]LEUTENEGGER S,FURGALE P,RABAUD V,et al. Keyframe-based visual-inertial slam using nonlinear opti- mization [C]//Proceedings of 2013 Robotics:Science 朴松吴,男,1972年生,教授,博士 and Systems RSS).Berlin,Germany,2013. 生导师,中国人工智能学会常务理事, [72]Google.Project tango.URL https://www.google.com/a- 机器人文化艺术专业委员会主任,主要 tap/projecttango/. 研究方向为机器人环境感知与导航、机 [73 ZBONTAR J,LE CUN Y.Stereo matching by training a 器人运动规划、多智能体机器人协作。 convolutional neural network to compare image patches 主背或参加了国家自然科学基金、国家“863”计划重点及面 [J].The journal of machine learning research,2015,17 上项目、机器人技术与系统国家重点实验室基金、教育部 (1):2287-2318. “985”项目、三星国际合作项目等多个项目。发表学术论文 [74]SUNDERHAUF N,SHIRAZI S,DAYOUB F.On the per- 60余篇,其中被SCI,EI,STP检索60多篇,出版专著一部。 formance of ConvNet features for place recognition C]// 2015 IEEE/RSJ International Conference on Intelligent Ro- 李国,男,1989年生,博士,主要研 bots and Systems IROS).Hamburg,Germany,2015: 究方向为SLAM、机器学习。 4297-4304

[68]STRASDAT H, DAVISON A J, MONTIEL J M M, et al. Double window optimisation for constant time visual SLAM [C] / / International Conference on Computer Vision. Bar⁃ celona, Spain, 2011: 2352-2359. [69] MOURIKIS A I, ROUMELIOTIS S I. A multi⁃state con⁃ straint Kalman filter for vision⁃aided inertial navigation [C] / / Proceedings of the 2007 IEEE International Confer⁃ ence on Robotics and Automation ( ICRA). Roma, Italy, 2007. [70]MOURIKIS A I, ROUMELIOTIS S I. A dual⁃layer estima⁃ tor architecture for long⁃term localization [ C] / / Proceed⁃ ings of the 2008 Workshop on Visual Localization for Mo⁃ bile Platforms at CVPR. Anchorage, Alaska, 2008. [71] LEUTENEGGER S, FURGALE P, RABAUD V, et al. Keyframe⁃based visual⁃inertial slam using nonlinear opti⁃ mization [ C] / / Proceedings of 2013 Robotics: Science and Systems (RSS). Berlin, Germany, 2013. [72] Google. Project tango. URL https: / / www. google. com/ a⁃ tap / projecttango / . [73] ŽBONTAR J, LE CUN Y. Stereo matching by training a convolutional neural network to compare image patches [J]. The journal of machine learning research, 2015, 17 (1): 2287-2318. [74]SÜNDERHAUF N, SHIRAZI S, DAYOUB F. On the per⁃ formance of ConvNet features for place recognition[ C] / / 2015 IEEE/ RSJ International Conference on Intelligent Ro⁃ bots and Systems ( IROS ). Hamburg, Germany, 2015: 4297-4304. [75]COSTANTE G, MANCINI M, VALIGI P, et al. Exploring representation learning with CNNs for frame⁃to⁃frame ego⁃ motion estimation [ J]. IEEE robotics and automation let⁃ ters, 2016, 1(1): 18-25. [76]KENDALL A, CIPOLLA R. Modelling uncertainty in deep learning for camera relocalization[C] / / 2016 IEEE Inter⁃ national Conference on Robotics and Automation. Stock⁃ holm, Sweden, 2016: 4762-4769. 作者简介: 权美香,女,1992 年生,博士,主要 研究方向为单目视觉 SLAM,VIN,移动 机器人视觉导航。 朴松昊,男,1972 年生,教授,博士 生导师,中国人工智能学会常务理事, 机器人文化艺术专业委员会主任,主要 研究方向为机器人环境感知与导航、机 器人运动规划、多智能体机器人协作。 主持或参加了国家自然科学基金、国家“863”计划重点及面 上项目、机器人技术与系统国家重点实验室基金、教育部 “985”项目、三星国际合作项目等多个项目。 发表学术论文 60 余篇,其中被 SCI、EI、ISTP 检索 60 多篇,出版专著一部。 李国,男,1989 年生,博士,主要研 究方向为 SLAM、机器学习。 ·776· 智 能 系 统 学 报 第 11 卷