第11卷第5期 智能系统学报 Vol.11 No.5 2016年10月 CAAI Transactions on Intelligent Systems 0ct.2016 D0I:10.11992/is.201603050 网络出版地址:htp:/www.cnki.net/kcms/detail/23.1538.TP.20160824.0929.016.html 一种鲁棒的Multi-Egocentric视频中的 多目标检测及匹配算法 李龙,尹辉2,许宏丽,欧伟奇 (1.北京交通大学计算机与信息技术学院,北京100044:2.北京交通大学交通数据分析与挖据北京市重点实验室, 北京100044) 摘要:针对视频中的背景变化剧烈、目标尺度差异明显和视角时变性强的特点,提出一种鲁棒的针对muli-egocen- ic视频的多目标检测及匹配算法。首先,构建基于boosting方法的多目标检测模型对各视频序列中的显著目标进 行粗检测,并提出一种基于局部相似度的区域优化算法对粗检测显著目标的轮廓进行优化,提高Egocentric视频中 显著目标轮廓检测和定位的准确性。在显著目标检测基础上,对不同视角中的显著目标构建基于HOG特征的SVM 分类器,实现多视角的多目标匹配。在Party Scene数据集上的实验验证了本文算法的有效性。 关键词:Muli-Egocentric视频:多目标检测:多目标匹配 中图分类号:TP391.4文献标志码:A文章编号:1673-4785(2016)05-0619-08 中文引用格式:李龙,尹辉,许宏丽,等.一种鲁棒的Multi-Egocentric视频中的多目标检测及匹配算法[J].智能系统学报,2016,11 (5):619-626. 英文引用格式:LI Long,YIN Hui,XU Hongli,etal.A robust multi-object detection and matching algorithm for multi-egocentric videos[J].CAAI transactions on intelligent systems,2016,11(5):619-626. A robust multi-object detection and matching algorithm for multi-egocentric videos LI Long',Yin Hui.2,XU Hongli',OU Weiqi (1.Department of Computer Science and Technology,Beijing Jiaotong University,Beijing 100044,China;2.Beijing Key Lab of Transportation Data Analysis and Mining,Beijing Jiaotong University,Beijing 100044,China) Abstract:In this paper,a robust multi-object detection and matching algorithm for a multi-egocentric video is pro- posed by considering the characteristics of multi-egocentric videos,for example,sudden changes in background, and variable target scales and viewpoints.First,a multi-target detection model based on a boosting method is con- structed,to roughly detect any salient objects in the video frames.Then an optimization algorithm based on local similarity is proposed for optimizing the salient-object area and improving the accuracy of salient-object detection and localization.Finally,a SVM classifier based on HOG features is trained to realize multi-target matching in multi-egocentric videos.Experiments using Scene Party datasets show the effectiveness of the proposed method. Keywords:multi-egocentric video;multi-object detection;multi-object matching Egocentric视频是通过固定在拍摄者头、肩、手特点,同时存在拍摄视频不平顺、运动模糊、噪声大 等部位或由拍摄者手持的穿戴式摄像机,在拍摄者 等问题,为基于此的计算机视觉任务带来极大的挑 自由运动过程中所拍摄的。Egocentric视频具有背 战。Multi-Egocentric视频是由处于同一场景中的多 景变化剧烈、目标尺度差异明显和视角时变性强的 个个体所拍摄的不同视角、不同运动轨迹的视频,研 究基于multi-egocentric视频的目标检测和匹配对于 收稿日期:2016-03-20.网络出版日期:2016-08-24. 后续的场景理解等高级视觉任务具有重要的意义。 基金项目:国家自然科学基金项目(61472029,61473031). 由于场景的复杂性和运动的多样性,基于视频 通信作者:李龙.E-mail:hyin@djpu.cdu.cn

第 11 卷第 5 期 智 能 系 统 学 报 Vol.11 №.5 2016 年 10 月 CAAI Transactions on Intelligent Systems Oct. 2016 DOI:10.11992 / tis.201603050 网络出版地址:http: / / www.cnki.net / kcms/ detail / 23.1538.TP.20160824.0929.016.html 一种鲁棒的 Multi⁃Egocentric 视频中的 多目标检测及匹配算法 李龙1 ,尹辉1,2 ,许宏丽1 ,欧伟奇1 (1.北京交通大学 计算机与信息技术学院,北京 100044; 2. 北京交通大学 交通数据分析与挖掘北京市重点实验室, 北京 100044) 摘 要:针对视频中的背景变化剧烈、目标尺度差异明显和视角时变性强的特点,提出一种鲁棒的针对 multi⁃egocen⁃ tric 视频的多目标检测及匹配算法。 首先,构建基于 boosting 方法的多目标检测模型对各视频序列中的显著目标进 行粗检测,并提出一种基于局部相似度的区域优化算法对粗检测显著目标的轮廓进行优化,提高 Egocentric 视频中 显著目标轮廓检测和定位的准确性。 在显著目标检测基础上,对不同视角中的显著目标构建基于 HOG 特征的 SVM 分类器,实现多视角的多目标匹配。 在 Party Scene 数据集上的实验验证了本文算法的有效性。 关键词:Multi⁃Egocentric 视频;多目标检测;多目标匹配 中图分类号:TP391.4 文献标志码:A 文章编号:1673⁃4785(2016)05⁃0619⁃08 中文引用格式:李龙,尹辉,许宏丽,等.一种鲁棒的 Multi⁃Egocentric 视频中的多目标检测及匹配算法[J]. 智能系统学报, 2016, 11 (5):619⁃626. 英文引用格式:LI Long, YIN Hui, XU Hongli,et al. A robust multi⁃object detection and matching algorithm for multi⁃egocentric videos[J]. CAAI transactions on intelligent systems, 2016,11(5):619⁃626. A robust multi⁃object detection and matching algorithm for multi⁃egocentric videos LI Long 1 , Yin Hui 1,2 , XU Hongli 1 , OU Weiqi 1 (1. Department of Computer Science and Technology, Beijing Jiaotong University, Beijing 100044, China; 2. Beijing Key Lab of Transportation Data Analysis and Mining, Beijing Jiaotong University, Beijing 100044, China) Abstract:In this paper, a robust multi⁃object detection and matching algorithm for a multi⁃egocentric video is pro⁃ posed by considering the characteristics of multi⁃egocentric videos, for example, sudden changes in background, and variable target scales and viewpoints. First, a multi⁃target detection model based on a boosting method is con⁃ structed, to roughly detect any salient objects in the video frames. Then an optimization algorithm based on local similarity is proposed for optimizing the salient⁃object area and improving the accuracy of salient⁃object detection and localization. Finally, a SVM classifier based on HOG features is trained to realize multi⁃target matching in multi⁃egocentric videos. Experiments using Scene Party datasets show the effectiveness of the proposed method. Keywords:multi⁃egocentric video; multi⁃object detection; multi⁃object matching 收稿日期:2016⁃03⁃20. 网络出版日期:2016⁃08⁃24. 基金项目:国家自然科学基金项目(61472029,61473031). 通信作者:李龙. E⁃mail:hyin@ djpu.edu.cn. Egocentric 视频是通过固定在拍摄者头、肩、手 等部位或由拍摄者手持的穿戴式摄像机,在拍摄者 自由运动过程中所拍摄的。 Egocentric 视频具有背 景变化剧烈、目标尺度差异明显和视角时变性强的 特点,同时存在拍摄视频不平顺、运动模糊、噪声大 等问题,为基于此的计算机视觉任务带来极大的挑 战。 Multi⁃Egocentric 视频是由处于同一场景中的多 个个体所拍摄的不同视角、不同运动轨迹的视频,研 究基于 multi⁃egocentric 视频的目标检测和匹配对于 后续的场景理解等高级视觉任务具有重要的意义。 由于场景的复杂性和运动的多样性,基于视频

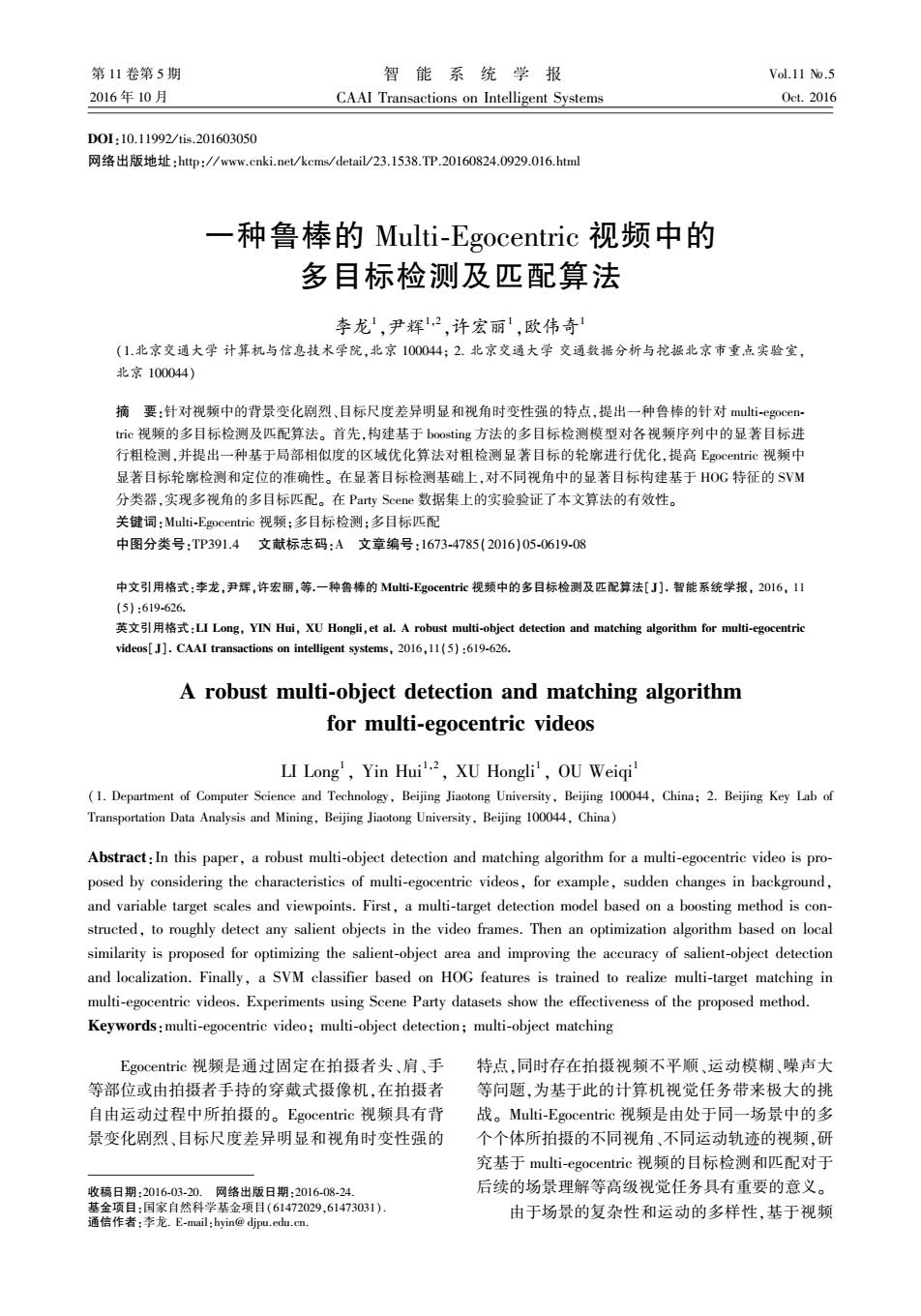

·620 智能系统学报 第11卷 的显著目标检测一直都是计算机视觉研究领域的难 分类器预测显著区域,但此类方法无法获得显著区 点问题之一。基于单视角视频的目标检测主要有基 域中成员的精确位置:Lin等[6在多个视频中利用 于单帧图像通过特征提取训练目标检测器的方法, 不同运动模式对成员做匹配,然后利用条件随机场 如Pedro Felzenszwalb等I)提出的可变性组件模型 寻找时空一致性最高的成员,即为当前最显著成员, (deformable part model,.DPM),基于目标成员的可变 但此类方法需要每个成员同一时刻的动作具有差异 形部位,结合边界敏感的方法挖掘负样本,训练隐性 性:通过多个视频寻找匹配点利用透视图原理计算 支持向量机(latent,SVM)分类器检测目标,但对于 出多个成员的位置和姿态,如Hyun Soo Park等)通 视频中距离镜头较远的目标有漏检的情况;Lubomir 过SM)方法,恢复三维场景及成员位置和姿态,实 Bourdev等2提出Poselet模型用带标注的三维人体 现场景理解:利用多个视频间的相互运动关系进行 动作关节点数据集训练SVM分类器,以检测人的 成员检测,如Ryo Yonetani等[)利用一对成员互相 头、躯干、背部等部位,该算法在清晰图像上取得较 拍摄的视频,根据超像素分割单位区域的局部相对 好的效果,但对于低质图像漏检率较高:利用时空特 运动和全局运动信息搜索其中一个成员,但此方法 征和表面特征相结合的训练方法,如Philippe 一次只能检测一个拍摄视频的成员面部。上述传统 Weinzaepfel)提出运动边模型(motion boundary, 的基于视频的显著目标检测方法大多基于固定视角 MB)将图像局部区域的颜色、光流以包的形式训练 或视角微变的视频,而multi-egocentric视频中场景 随机森林模型,得到的支持向量机(SVM)分类器可 变化剧烈,目标运动稳定性低,如DPM)在视角变 检测精确的目标边缘,但当目标无明显运动时,边缘 换剧烈时的检测效果下降;Poselets[2算法在图像有 检测结果不佳:基于多视角视频的目标检测利用多 轻微运动模糊时的性能受到较大影响;Motion 个不同视角的监控视频跟踪目标,检测目标行为,如 Boundariest)算法在目标尺寸较小时出现漏检。基 KSusheel Kumar等提出的实时多视角视频跟踪算 于此,本文提出了一种两步层进目标检测算法,将目 法,应用在安全系统中。 标检测分为粗检测阶段和细检测两阶段,从而提高 Egocentric视频的分析和处理是近年来的研究 了基于Egocentric视频的目标检测的鲁棒性,并提 热点之一,目前的研究主要集中于估计拍摄者所关 出了multi-.egocentric视频中的目标匹配算法,实现 注的显著区域,例如Hyun Soo Park[)提出利用群体 了多视角多目标的匹配。算法流程图如图1。 模式的几何关系得到成员交互关系,经训练后得到 输入视频 基于Boosting模型的目标粗检测 粗检测 检测及匹配结果 输入 相机1 匹配 两 基于空间位置关系的区域融合算法 基于方 进 梯度 相机2 标 方图 细检测 测 基于局部相似度的目标区域优化算法(显著目标) 算 法 征的支 相机3 向量机模 (非显著目标) (显著目标) 训练 训练集 输入 相机 B.BB 图1 本文算法流程(n为相机个数,即视角数,B,i=1,2,…,11为目标编号) Fig.1 The framework of our method (n represents the number of camera,B,i=1,2,..,11 is target number)

的显著目标检测一直都是计算机视觉研究领域的难 点问题之一。 基于单视角视频的目标检测主要有基 于单帧图像通过特征提取训练目标检测器的方法, 如 Pedro Felzenszwalb 等[1] 提出的可变性组件模型 (deformable part model,DPM),基于目标成员的可变 形部位,结合边界敏感的方法挖掘负样本,训练隐性 支持向量机( latent,SVM)分类器检测目标,但对于 视频中距离镜头较远的目标有漏检的情况;Lubomir Bourdev 等[2]提出 Poselet 模型用带标注的三维人体 动作关节点数据集训练 SVM 分类器,以检测人的 头、躯干、背部等部位,该算法在清晰图像上取得较 好的效果,但对于低质图像漏检率较高;利用时空特 征和 表 面 特 征 相 结 合 的 训 练 方 法, 如 Philippe Weinzaepfel [3] 提 出 运 动 边 模 型 ( motion boundary, MB)将图像局部区域的颜色、光流以包的形式训练 随机森林模型,得到的支持向量机(SVM)分类器可 检测精确的目标边缘,但当目标无明显运动时,边缘 检测结果不佳;基于多视角视频的目标检测利用多 个不同视角的监控视频跟踪目标,检测目标行为,如 KSusheel Kumar 等[4]提出的实时多视角视频跟踪算 法,应用在安全系统中。 Egocentric 视频的分析和处理是近年来的研究 热点之一,目前的研究主要集中于估计拍摄者所关 注的显著区域,例如 Hyun Soo Park [5]提出利用群体 模式的几何关系得到成员交互关系,经训练后得到 分类器预测显著区域,但此类方法无法获得显著区 域中成员的精确位置;Lin 等[6] 在多个视频中利用 不同运动模式对成员做匹配,然后利用条件随机场 寻找时空一致性最高的成员,即为当前最显著成员, 但此类方法需要每个成员同一时刻的动作具有差异 性;通过多个视频寻找匹配点利用透视图原理计算 出多个成员的位置和姿态,如 Hyun Soo Park 等[5]通 过 SfM [7]方法,恢复三维场景及成员位置和姿态,实 现场景理解;利用多个视频间的相互运动关系进行 成员检测,如 Ryo Yonetani 等[8] 利用一对成员互相 拍摄的视频,根据超像素分割单位区域的局部相对 运动和全局运动信息搜索其中一个成员,但此方法 一次只能检测一个拍摄视频的成员面部。 上述传统 的基于视频的显著目标检测方法大多基于固定视角 或视角微变的视频,而 multi⁃egocentric 视频中场景 变化剧烈,目标运动稳定性低,如 DPM [1] 在视角变 换剧烈时的检测效果下降;Poselets [2] 算法在图像有 轻微 运 动 模 糊 时 的 性 能 受 到 较 大 影 响; Motion Boundaries [3]算法在目标尺寸较小时出现漏检。 基 于此,本文提出了一种两步层进目标检测算法,将目 标检测分为粗检测阶段和细检测两阶段,从而提高 了基于 Egocentric 视频的目标检测的鲁棒性,并提 出了 multi⁃egocentric 视频中的目标匹配算法,实现 了多视角多目标的匹配。 算法流程图如图 1。 图 1 本文算法流程(n 为相机个数,即视角数,βi,i= 1,2,…,11 为目标编号) Fig.1 The framework of our method (n represents the number of camera, βi,i= 1,2,…,11 is target number) ·620· 智 能 系 统 学 报 第 11 卷

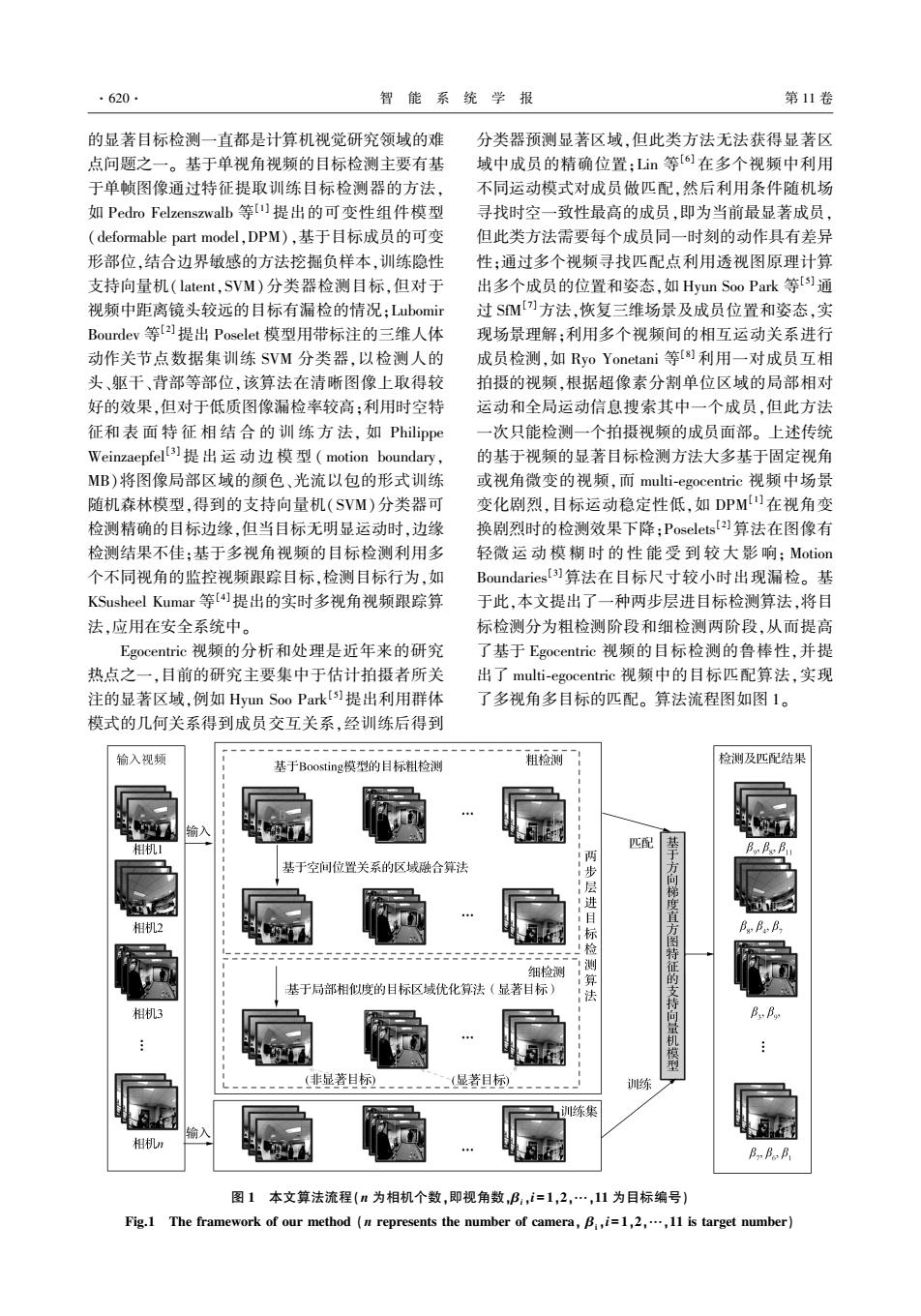

第5期 李龙,等:一种鲁棒的Muli-Egocentrie视频中的多目标检测及匹配算法 ·621. 1两步层进目标检测算法 m为检测器个数,K:表示第i个检测器,则第i个检 测器针对图像f的检测结果用集合来表示,且 两步层进目标检测算法的主要思想是首先粗略 B={bIk=1,2,…,},其中为检测器K在图像 定位目标位置,其次优化目标区域。算法分为两步: f上检测出的目标个数,=[],、 第1步是基于Boosting)模型的目标粗定位方法, 、分别表示的左上角x坐标、左上角y坐 融合多个检测器结果,最大限度覆盖目标区域,此种 标、右下角x坐标、右下角y坐标、表示为显著 方法在一定程度上克服了Egocentric视频背景变化 目标的概率,且∈(0,1),则所有检测器对图像f 剧烈、目标尺度差异明显和视角时变性强等特点导 致的检测结果不完整、漏检、错检等问题,提高了算 的检测结果为B以=UB。本文取m=4,分别为Mo i=1 法的鲁棒性:第2步采用基于局部相似度的区域优化 tion Boundaries](MB)算法、DPM)算法、Pose- 方法对目标轮廓进行优化,得到更精确的目标区域。 lets[2算法和空间金字塔池化(sptial pyramid poo- 1.1基于Boosting模型的目标粗检测算法 ling,SPP Net)[o算法。算法流程如图2所示,图 设输入的Egocentric视频集合为山={c,Il=1, 中Color表示仅用颜色特征:ColorFlow采用颜色和 2,…,n},其中n为视频个数,c表示第l个相机拍 光流特征;Color Flow Warping采用颜色、光流以及 摄的视频,则第l个视频的第j帧图像表示为f。假 形变特征,而Color Flow Warping Backward增加了反 设有一系列目标检测器={K:i=1,2,…,m,其中 向特征。 Color ColorFlow ColorFlowWarping ColorFlowWarpingBackwardo 输入图像 目标检测结果 基于空间位置关 系的区域融合 目标候选区域 图2基于boosting模型的目标粗检测算法流程 Fig.2 Object detection based on boosting model 在以上的检测算法中设置较低的检测阈值,可 的显著目标候选区域集合B以,b=[xyxys],b∈B 获得较多的目标候选区域,当然其中包含大量的冗 作为算法输入。 余结果。根据目标候选区的空间位置关系进行区域 2)计算每个显著目标候选区域b:的面积S:= 融合得到目标粗检测结果。具体算法如下: Iy:-y:1×1x,-x:I,保留中满足S:>01的显著目标 算法1基于空间位置关系的区域融合算法 候选区域,其中日,为阈值。 1)由基于boosting模型的目标粗检测算法得到 3)搜索B中有重叠的任意2个显著目标候选

1 两步层进目标检测算法 两步层进目标检测算法的主要思想是首先粗略 定位目标位置,其次优化目标区域。 算法分为两步: 第 1 步是基于 Boosting [9] 模型的目标粗定位方法, 融合多个检测器结果,最大限度覆盖目标区域,此种 方法在一定程度上克服了 Egocentric 视频背景变化 剧烈、目标尺度差异明显和视角时变性强等特点导 致的检测结果不完整、漏检、错检等问题,提高了算 法的鲁棒性;第 2 步采用基于局部相似度的区域优化 方法对目标轮廓进行优化,得到更精确的目标区域。 1.1 基于 Boosting 模型的目标粗检测算法 设输入的 Egocentric 视频集合为 ψ = { cl | l = 1, 2,…,n} ,其中 n 为视频个数,cl 表示第 l 个相机拍 摄的视频,则第 l 个视频的第 j 帧图像表示为 f j l。 假 设有一系列目标检测器 ξ = {κi | i = 1,2,…,m},其中 m 为检测器个数,κi 表示第 i 个检测器,则第 i 个检 测器针对图像 f j l的检测结果用集合 B j li 来表示,且 B j li = {b jk li | k = 1,2,…,z j li},其中 z j li为检测器 κi 在图像 f j l上检测出的目标个数,b jk li = [x jk li y jk li x ~ jk li y ~ jk li s jk li ], x jk li 、 y jk li 、x ~ jk li 、y ~ jk li分别表示 b jk li 的左上角 x 坐标、左上角 y 坐 标、右下角 x 坐标、右下角 y 坐标、s jk li 表示 b jk li 为显著 目标的概率,且 s jk li∈(0,1),则所有检测器对图像f j l 的检测结果为 B j l =∪ m i = 1 B j li。 本文取 m = 4,分别为 Mo⁃ tion Boundaries [3] ( MB ) 算 法、 DPM [1] 算 法、 Pose⁃ lets [2]算法和空间金字塔池化( sptial pyramid poo⁃ ling,SPP Net ) [10] 算法。 算法流程如图 2 所示,图 中 Color 表示仅用颜色特征:ColorFlow 采用颜色和 光流特征;Color Flow Warping 采用颜色、光流以及 形变特征,而 Color Flow Warping Backward 增加了反 向特征。 图 2 基于 boosting 模型的目标粗检测算法流程 Fig.2 Object detection based on boosting model 在以上的检测算法中设置较低的检测阈值,可 获得较多的目标候选区域,当然其中包含大量的冗 余结果。 根据目标候选区的空间位置关系进行区域 融合得到目标粗检测结果。 具体算法如下: 算法 1 基于空间位置关系的区域融合算法 1)由基于 boosting 模型的目标粗检测算法得到 的显著目标候选区域集合 B j l,b = [ x y x ~ y ~ s],b∈B j l 作为算法输入。 2)计算每个显著目标候选区域 bi 的面积 Si = | yi -y ~ i | × | xi -x ~ i | ,保留 B j l 中满足 Si >θ1 的显著目标 候选区域,其中 θ1 为阈值。 3)搜索 B i l 中有重叠的任意 2 个显著目标候选 第 5 期 李龙,等:一种鲁棒的 Multi⁃Egocentric 视频中的多目标检测及匹配算法 ·621·

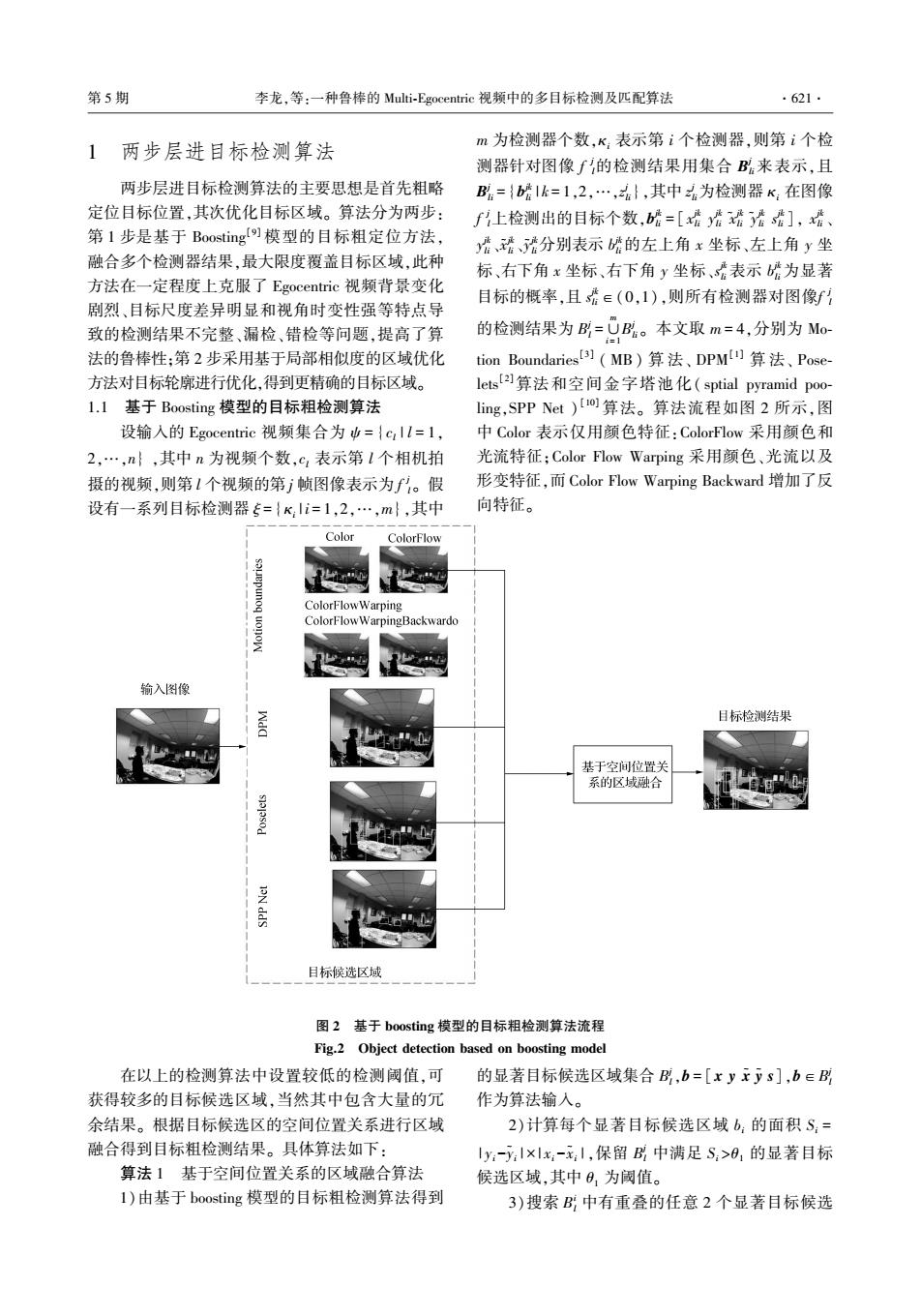

·622 智能系统学报 第11卷 区域b:,;计算其重叠面积Sn。如果Sn>82,其 H(p:)=1,P:∈边界超像素 (2) 中0,为阈值,则根据式(1)更新显著目标区域并删 H(P:)=0,P:∈非边界超像素 除队中面积较小的那个显著目标候选区域 对任意超像素p:,计算其属于显著目标可能性为 fb:=[min(x:,x)min(yy)max(元:,)max(:,)s+ D(p:)= (ω中.(P:P)+w.(p:,P))·H(P) s],S:>S i=1*i (3) b=[min(x:,x)min(y:y)max(元:,x)max(y:,y)s:+ 式中:山(P:P)表示超像素P:和p的颜色相似度, si],S;>S: 由颜色直方图特征向量的k2距离确定,中(P:,P)表 (1) 示超像素P:和P,之间的运动相似度,由光流模直方 4)重复执行3),直至无重叠的显著目标候选区 图特征向量的K2距离确定,ω。和ω。为权值。 域,算法结束。 计算所有超像素的显著目标可能性后,保留 1.2基于局部相似度的目标区域优化算法 超像素集合P中D(P:)≥0,(0,为阈值)的超像 由基于空间位置关系的区域融合算法得到融合 素P:,从而得到优化后的显著目标区域,基于局 后的显著目标区域中包含了较多的非目标区域,为 部相似度的D计算式(3)的区域优化算法示意 了更精确地检测目标区域,本文提出基于局部相似 如图3。 度的区域优化算法对目标区域进行进一步的优化。 由于,经过两步层进目标检测后,得到了各个视 首先对显著目标区域b∈B进行超像素分割,得超 角的Egocentric视频每帧中的显著目标检测结果, 像素集合P={p,|i=1,2,…,n},由超像素空间位置 下面将对各个视角中的显著目标进行匹配。 设置超像素的边界属性: D(p) D(p.) D(p,) 区域优化 (Dp)≥0) 粗检测结果 D(p) 局部相似度计算 显著目标区域b 超像素分割区域 优化后的目标区域 图3基于局部相似度的区域优化算法 Fig.3 Bounding box area optimization based on local similarity 2基于HOG特征的目标匹配算法 (HOG),并将不同level的直方图特征连接起来组 成特征向量,: 为了实现muli-egocentric中的多目标匹配,首 4)最后将',和B,输入SVM分类器中进行 先对数据集中关键帧的显著目标进行人工标注得到 训练 显著目标区域h,以及对应目标编号B,构建训练集 5)重复执行3)、4)直到所有显著目标区域训练 H={(hnBn)1m=1,2,…,Q:Bn∈{0,1,…,Q},其 完毕,输出SVM目标匹配模型。 基于HOG特征的目标匹配分类器训练流程如 中Q为标注的目标个数,Q为目标分类数。基于 图4所示。 HOG特征的目标匹配算法如下: 由两步层进法检测得到多视角的显著目标后, 算法2基于H0G特征的目标匹配算法 基于HOG特征的目标匹配分类器实现多视角中多 1)输入H={(hn,Bn)17=1,2,…,Q,B,∈{0, 目标的匹配流程如图5所示。 1,…,Q}作为输入: 3实验结果 2)初始化sVM分类器参数,bins以及level;: 3)将h,按不同level划分为固定大小的矩形 为了验证本文算法的有效性,采用Hyun Soo 块:在每一个矩形块上统计梯度向量直方图 Park[)的Party Scene数据集进行目标检测和目标

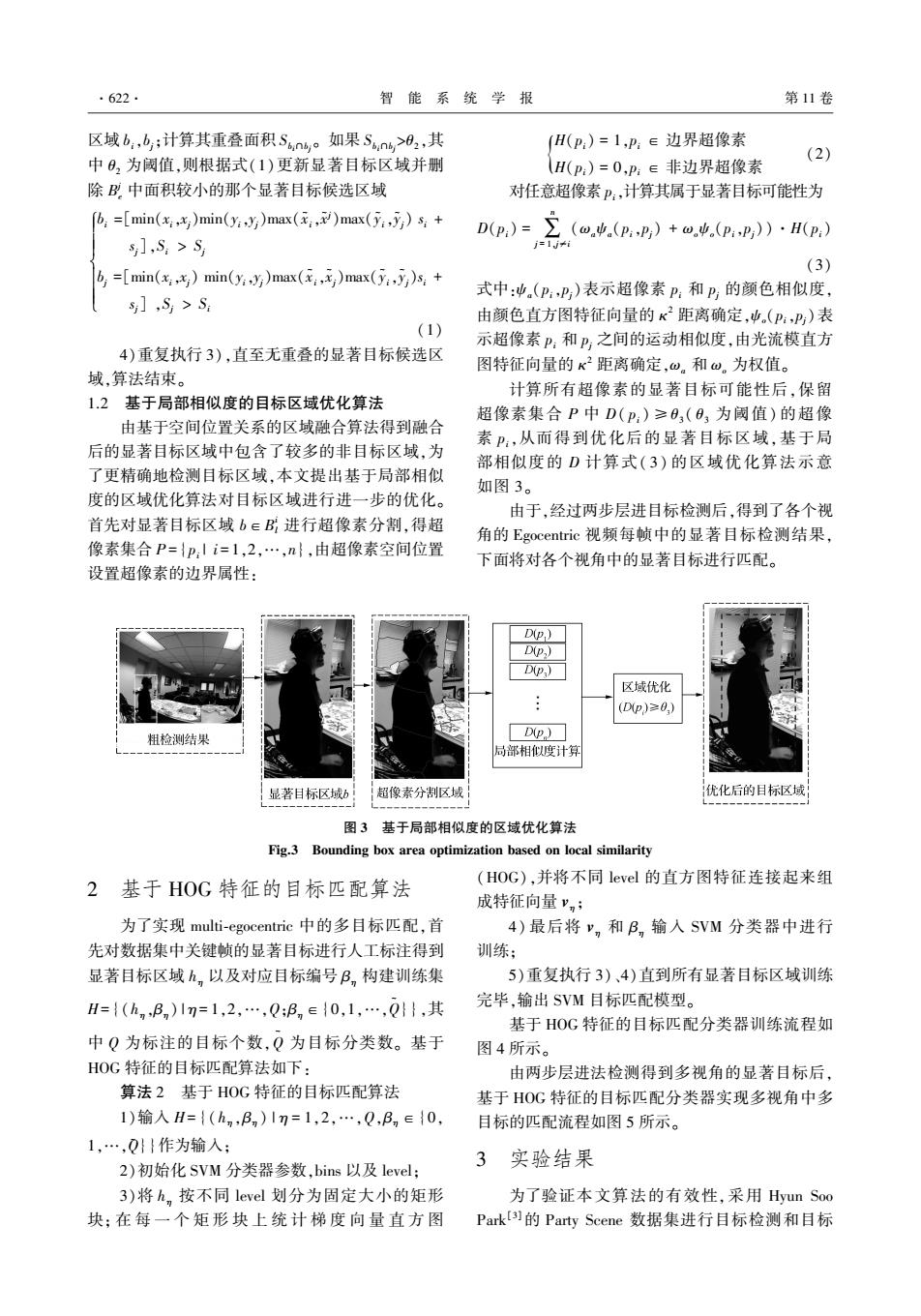

区域 bi,bj;计算其重叠面积 Sbi∩bj 。 如果 Sbi∩bj >θ2 ,其 中 θ2 为阈值,则根据式(1)更新显著目标区域并删 除 B j e 中面积较小的那个显著目标候选区域 bi =[min(xi,xj)min(yi,yj)max(x ~ i,x ~ j)max(y ~ i,y ~ j) si + sj],Si > Sj bj =[min(xi,xj) min(yi,yj)max(x ~ i,x ~ j)max(y ~ i,y ~ j)si + sj] ,Sj > Si ì î í ï ï ï ï ïï (1) 4)重复执行 3),直至无重叠的显著目标候选区 域,算法结束。 1.2 基于局部相似度的目标区域优化算法 由基于空间位置关系的区域融合算法得到融合 后的显著目标区域中包含了较多的非目标区域,为 了更精确地检测目标区域,本文提出基于局部相似 度的区域优化算法对目标区域进行进一步的优化。 首先对显著目标区域 b∈B i l 进行超像素分割,得超 像素集合 P = {pi | i = 1,2,…,n},由超像素空间位置 设置超像素的边界属性: H(pi) = 1,pi ∈ 边界超像素 H(pi) = 0,p { i ∈ 非边界超像素 (2) 对任意超像素 pi,计算其属于显著目标可能性为 D(pi) = ∑ n j = 1,j≠i (ωaψa(pi,pj) + ωoψo(pi,pj))·H(pi) (3) 式中:ψa(pi,pj)表示超像素 pi 和 pj 的颜色相似度, 由颜色直方图特征向量的 κ 2 距离确定,ψo(pi,pj)表 示超像素 pi 和 pj 之间的运动相似度,由光流模直方 图特征向量的 κ 2 距离确定,ωa 和 ωo 为权值。 计算所有超像素的显著目标可能性后,保留 超像素集合 P 中 D( pi ) ≥θ3 ( θ3 为阈值) 的超像 素 pi,从而得到优化后的显著目标区域,基于局 部相似度的 D 计算式( 3) 的区域优化算法示意 如图 3。 由于,经过两步层进目标检测后,得到了各个视 角的 Egocentric 视频每帧中的显著目标检测结果, 下面将对各个视角中的显著目标进行匹配。 图 3 基于局部相似度的区域优化算法 Fig.3 Bounding box area optimization based on local similarity 2 基于 HOG 特征的目标匹配算法 为了实现 multi⁃egocentric 中的多目标匹配,首 先对数据集中关键帧的显著目标进行人工标注得到 显著目标区域 hη 以及对应目标编号 βη 构建训练集 H= {(hη ,βη ) | η = 1,2,…,Q;βη∈{0,1,…,Q ~ }},其 中 Q 为标注的目标个数,Q ~ 为目标分类数。 基于 HOG 特征的目标匹配算法如下: 算法 2 基于 HOG 特征的目标匹配算法 1)输入 H= {( hη ,βη ) | η = 1,2,…,Q,βη∈{0, 1,…,Q ~ }}作为输入; 2)初始化 SVM 分类器参数,bins 以及 level; 3)将 hη 按不同 level 划分为固定大小的矩形 块; 在 每 一 个 矩 形 块 上 统 计 梯 度 向 量 直 方 图 (HOG),并将不同 level 的直方图特征连接起来组 成特征向量 vη ; 4) 最后将 vη 和 βη 输入 SVM 分类器中进行 训练; 5)重复执行 3)、4)直到所有显著目标区域训练 完毕,输出 SVM 目标匹配模型。 基于 HOG 特征的目标匹配分类器训练流程如 图 4 所示。 由两步层进法检测得到多视角的显著目标后, 基于 HOG 特征的目标匹配分类器实现多视角中多 目标的匹配流程如图 5 所示。 3 实验结果 为了验证本文算法的有效性,采用 Hyun Soo Park [3]的 Party Scene 数据集进行目标检测和目标 ·622· 智 能 系 统 学 报 第 11 卷

第5期 李龙,等:一种鲁棒的Muli-Egocentrie视频中的多目标检测及匹配算法 ·623· 匹配实验。该multi-egocentric数据集进行目标检测 到或只能部分检测到目标,如图6中第1行、第3 和目标匹配实验。该数据集包括来自11个相机的 列,检测结果中漏检了目标的手部:而Poselets算法 第一视角视频数据,并且是同时拍摄同一场景得到 首先检测目标部位,再根据目标种类的不同合并符 的。每个视频共8640帧,经同步后每个视频共 合模式的部位检测结果,因此检测结果中会产生 8566帧,本文取前914帧中的目标样本做手工标 些孤立的部位检测结果,降低了检测结果的精度,如 注,作为训练集:另选取50帧作为测试集,其包含没 图6中Poselets列所示;由Egocentric视频视角时变 有任何目标个体的帧。本文的目标检测算法与 性导致的像第3行这样的拍摄角度不正的图像非常 MB、DPM、SPP Net、Poselets算法结果对比如图6所 常见,而SPPNet、DPM算法对此种图像会有显著目 示。SPP Net、DPM算法在随机窗口中搜索窗口包 标漏检的情况。本文算法在粗检测过程中综合了以 含目标概率最高的框,因此搜索结果可能不会完全 上算法优势,并基于空间位置进行了区域融合,从而 覆盖目标区域,但相对准确,这也使得检测的显著目 有效地避免了egocentric视频中目标尺度、运动差异 标轮廓不完整,如图6中第1行、第2行所示;MB算 较大而引起的漏检问题,而基于局部相似度的区域 法主要通过目标的运动信息检测目标边缘,但Eg0 优化能很好地排除复杂背景的影响,因而具有较强 centric视频中的运动相对复杂,尤其是当目标运动 的鲁棒性。本文算法的显著目标检测结果如图6中 不显著或目标只有局部运动时,MB算法无法检测 第1列所示。 标注 相机1 标注 SVM分类器 相机2 HOG特征提取 训练 BB 标注 目标匹配 模型 相机n 数据标注 区域剪栽 图4基于H0G特征的目标匹配分类器训练流程(B,i=1,2,“,)表示目标编号) Fig.4 Object classification model training based on HOG feature(B,i=1,2,represents match number of target region) HOG特征提取 目标匹配模型 两步层进目标 检测结果 区域剪裁 目标匹配结果 图5多视角多目标匹配算法流程(B,i=1,2,…,)表示显著目标区域匹配编号) Fig.5 Multi-view and multi-object matching algorithm (B,,i=1,2,...,n represents match number of match target region)

匹配实验。 该 multi⁃egocentric 数据集进行目标检测 和目标匹配实验。 该数据集包括来自 11 个相机的 第一视角视频数据,并且是同时拍摄同一场景得到 的。 每个视 频 共 8 640 帧, 经 同 步 后 每 个 视 频 共 8 566帧,本文取前 914 帧中的目标样本做手工标 注,作为训练集;另选取 50 帧作为测试集,其包含没 有任何目标个体的帧。 本文的目标检测算法与 MB、DPM、SPP Net、Poselets 算法结果对比如图 6 所 示。 SPP Net、DPM 算法在随机窗口中搜索窗口包 含目标概率最高的框,因此搜索结果可能不会完全 覆盖目标区域,但相对准确,这也使得检测的显著目 标轮廓不完整,如图 6 中第 1 行、第 2 行所示;MB 算 法主要通过目标的运动信息检测目标边缘,但 Ego⁃ centric 视频中的运动相对复杂,尤其是当目标运动 不显著或目标只有局部运动时,MB 算法无法检测 到或只能部分检测到目标,如图 6 中第 1 行、第 3 列,检测结果中漏检了目标的手部;而 Poselets 算法 首先检测目标部位,再根据目标种类的不同合并符 合模式的部位检测结果,因此检测结果中会产生一 些孤立的部位检测结果,降低了检测结果的精度,如 图 6 中 Poselets 列所示;由 Egocentric 视频视角时变 性导致的像第 3 行这样的拍摄角度不正的图像非常 常见,而 SPPNet、DPM 算法对此种图像会有显著目 标漏检的情况。 本文算法在粗检测过程中综合了以 上算法优势,并基于空间位置进行了区域融合,从而 有效地避免了 egocentric 视频中目标尺度、运动差异 较大而引起的漏检问题,而基于局部相似度的区域 优化能很好地排除复杂背景的影响,因而具有较强 的鲁棒性。 本文算法的显著目标检测结果如图 6 中 第 1 列所示。 图 4 基于 HOG 特征的目标匹配分类器训练流程(βi,i= 1,2,…,η 表示目标编号) Fig.4 Object classification model training based on HOG feature(βi,i=1,2,…,ηrepresents match number of target region) 图 5 多视角多目标匹配算法流程(βi,i= 1,2,…,η 表示显著目标区域匹配编号) Fig.5 Multi⁃view and multi⁃object matching algorithm (βi,i= 1,2,…,η represents match number of match target region) 第 5 期 李龙,等:一种鲁棒的 Multi⁃Egocentric 视频中的多目标检测及匹配算法 ·623·

·624. 智能系统学报 第11卷 Ours GT MB SPP Net DPM Poselets 图6本文方法与DPM,SPP Net,.Poselets算法结果对比图(Ours列为本文方法的检测结果,图中椭圆框中为算法漏检或错检的区域) Fig.6 Comparison of our method with DPM,SPP Net and Poselets(missing or wrong detection areas are in ellipse boxes) 本文提出的基于HOG特征的多目标匹配算法 P=SnG 实验结果如图7所示,可以看出,在大多数情况下, S 本文提出的算法能够有效地匹配多视角中的多个目 R=∑0 (4) 标。但是当视频视角变化较大时,目标姿态不正,从 G 而导致目标匹配失败,究其原因,因为训练是通过人 式中:S为目标检测算法检测的目标区域像素数,G 工标注的包含目标的矩形框来完成的,从而导致训 为人工标注的目标区域像素数,n为目标数。 练样例包含更多的非目标区域给匹配结果的正确性 则F-measure为 带来影响,造成匹配结果不准确,如图7中第3列的 2PR F二P+R (5) 目标1和第4列的目标7;另外,由于提取特征时是 目标匹配正确率的计算为 通过将显著目标区域分成固定尺寸的bins(子块), 匹配正确的目标数 因此当显著目标区域较小时,所划分的bins(子块) A= (6) 目标总数 也就很少,提取的特征也就不显著,因此会出现结果 本文提出的鲁棒的muli-egocentric视频中的目 错误,如图7中第1列的目标2、5、3。 标检测和目标匹配算法在整个数据集上的检测结果 最后,本文采用F-measure方法评价目标检测 如表1所示。 算法。查准率和查全率的计算为

图6 本文方法与 DPM、SPP Net、Poselets 算法结果对比图(Ours 列为本文方法的检测结果,图中椭圆框中为算法漏检或错检的区域) Fig.6 Comparison of our method with DPM、SPP Net and Poselets(missing or wrong detection areas are in ellipse boxes) 本文提出的基于 HOG 特征的多目标匹配算法 实验结果如图 7 所示,可以看出,在大多数情况下, 本文提出的算法能够有效地匹配多视角中的多个目 标。 但是当视频视角变化较大时,目标姿态不正,从 而导致目标匹配失败,究其原因,因为训练是通过人 工标注的包含目标的矩形框来完成的,从而导致训 练样例包含更多的非目标区域给匹配结果的正确性 带来影响,造成匹配结果不准确,如图 7 中第 3 列的 目标 1 和第 4 列的目标 7;另外,由于提取特征时是 通过将显著目标区域分成固定尺寸的 bins(子块), 因此当显著目标区域较小时,所划分的 bins(子块) 也就很少,提取的特征也就不显著,因此会出现结果 错误,如图 7 中第 1 列的目标 2、5、3。 最后,本文采用 F⁃measure 方法评价目标检测 算法。 查准率和查全率的计算为 P = ∑ n i = 1 Si ∩ Gi Si R = ∑ n i = 1 Si ∩ Gi Gi (4) 式中:Si 为目标检测算法检测的目标区域像素数,Gi 为人工标注的目标区域像素数,n 为目标数。 则 F⁃measure 为 F = 2PR P + R (5) 目标匹配正确率的计算为 A = 匹配正确的目标数 目标总数 (6) 本文提出的鲁棒的 multi⁃egocentric 视频中的目 标检测和目标匹配算法在整个数据集上的检测结果 如表 1 所示。 ·624· 智 能 系 统 学 报 第 11 卷

第5期 李龙,等:一种鲁棒的Muli-Egocentric视频中的多目标检测及匹配算法 ·625· C1F914 C9F5577 C6F5044 C11F4772 C5F188 图7本文基于HOG特征的显著目标匹配算法结果和Ground-Truth对比图 Fig.7 Comparison of Ground-Truth and object matching results of our method 表I在Party Scene数据集上的实验结果对比 discriminatively trained,multiscale,deformable part model Table 1 Comparison of experimental results on Scene Par- [C]//Proceedings of IEEE Conference on Computer Vision ty data sets and Pattern Recognition.Anchorage,AK:IEEE,2008:1-8. 目标 R [2]BOURDEV L,MALIK J.Poselets:body part detectors trained using 3d human pose annotations[C]//Proceedings 显著目标 0.77 0.61 0.68 0.61 of the 2009 IEEE 12th International Conference on Comput- 所有目标 0.28 0.39 0.33 0.21 er Vision.Kyoto:IEEE,2009:1365-1372. [3]WEINZAEPFEL P,REVAUD J,HARCHAOUI Z,et al. 4结束语 Learning to detect motion boundaries C]//Proceedings of 本文对multi-egocentric视频中的多目标检测和 2015 IEEE Conference on Computer Vision and Pattern Recognition.Boston,MA:IEEE,2015:2578-2586 匹配进行了研究,提出了基于boosting和局部相似 [4]KUMAR K S,PRASAD S,SAROJ P K,et al.Multiple 度的两步层进目标检测算法,综合多种检测模型的 cameras using real time object tracking for surveillance and 优势以克服Egocentric视频中目标尺度差异明显和 security system[C]//Proceedings of the 2010 3rd Interna- 视角时变性强给检测带来的干扰。在显著目标检测 tional Conference on Emerging Trends in Engineering and 基础上,对不同视角中的显著目标构建基于HOG特 Technology.Goa:IEEE,2010:213-218. 征的SVM分类器,实现多视角的多目标匹配,为后 [5]SOO PARK H,SHI Jianbo.Social saliency prediction 期的群体分析、场景理解等高级视觉任务提供了前 [C]//Proceedings of the IEEE Conference on Computer 期基础。muli-egocentric视频的处理和分析是一个 Vision and Pattern Recognition.Boston,MA:IEEE, 极具挑战的研究课题,在后续的研究工作中,将进一 2015:4777-4785. 步考虑融合局部相似度和全局相似度的显著目标区 [6]LIN Yuewei,ABDELFATAH K,ZHOU Youjie,et al.Co- 域检测方法,同时多视角之间的运动关联和目标自 interest person detection from multiple wearable camera vid- 运动轨迹也是多视角视频分析中的重要线索。 eos[C]//Proceedings of the IEEE International Conference 参考文献: on Computer Vision.Santiago:IEEE,2015:4426-4434. [7]SNAVELY N,SEITZ S M,SZELISKI R.Photo tourism: [1]FELZENSZWALB P,MCALLESTER D,RAMANAN D.A exploring photo collections in 3D[J].ACM transactions on

图 7 本文基于 HOG 特征的显著目标匹配算法结果和 Ground⁃Truth 对比图 Fig.7 Comparison of Ground⁃Truth and object matching results of our method 表 1 在 Party Scene 数据集上的实验结果对比 Table 1 Comparison of experimental results on Scene Par⁃ ty data sets 目标 P R F A 显著目标 0.77 0.61 0.68 0.61 所有目标 0.28 0.39 0.33 0.21 4 结束语 本文对 multi⁃egocentric 视频中的多目标检测和 匹配进行了研究,提出了基于 boosting 和局部相似 度的两步层进目标检测算法,综合多种检测模型的 优势以克服 Egocentric 视频中目标尺度差异明显和 视角时变性强给检测带来的干扰。 在显著目标检测 基础上,对不同视角中的显著目标构建基于 HOG 特 征的 SVM 分类器,实现多视角的多目标匹配,为后 期的群体分析、场景理解等高级视觉任务提供了前 期基础。 multi⁃egocentric 视频的处理和分析是一个 极具挑战的研究课题,在后续的研究工作中,将进一 步考虑融合局部相似度和全局相似度的显著目标区 域检测方法,同时多视角之间的运动关联和目标自 运动轨迹也是多视角视频分析中的重要线索。 参考文献: [1]FELZENSZWALB P, MCALLESTER D, RAMANAN D. A discriminatively trained, multiscale, deformable part model [C] / / Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Anchorage, AK: IEEE, 2008: 1⁃8. [2 ] BOURDEV L, MALIK J. Poselets: body part detectors trained using 3d human pose annotations[C] / / Proceedings of the 2009 IEEE 12th International Conference on Comput⁃ er Vision. Kyoto: IEEE, 2009: 1365⁃1372. [3] WEINZAEPFEL P, REVAUD J, HARCHAOUI Z, et al. Learning to detect motion boundaries[C] / / Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA: IEEE, 2015: 2578⁃2586. [4] KUMAR K S, PRASAD S, SAROJ P K, et al. Multiple cameras using real time object tracking for surveillance and security system[C] / / Proceedings of the 2010 3rd Interna⁃ tional Conference on Emerging Trends in Engineering and Technology. Goa: IEEE, 2010: 213⁃218. [5 ] SOO PARK H, SHI Jianbo. Social saliency prediction [C] / / Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA: IEEE, 2015: 4777⁃4785. [6]LIN Yuewei, ABDELFATAH K, ZHOU Youjie, et al. Co⁃ interest person detection from multiple wearable camera vid⁃ eos[C] / / Proceedings of the IEEE International Conference on Computer Vision. Santiago: IEEE, 2015: 4426⁃4434. [7] SNAVELY N, SEITZ S M, SZELISKI R. Photo tourism: exploring photo collections in 3D[ J]. ACM transactions on 第 5 期 李龙,等:一种鲁棒的 Multi⁃Egocentric 视频中的多目标检测及匹配算法 ·625·

·626. 智能系统学报 第11卷 graphics(T0G),2006,25(3):835-846. [14]ZHU Wangjiang,LIANG Shuang,WEI Yichen,et al.Sa- [8]YONETANI R,KITANI K M,SATO Y.Ego-surfing first liency optimization from robust background detection[C]// person videos[C]//Proceedings of 2015 IEEE Conference Proceedings of 2014 IEEE Conference on Computer Vision on Computer Vision and Pattern Recognition.Boston,MA: and Pattern Recognition.Columbus,OH:IEEE,2014: EEE,2015:5445-5454. 2814-2821. [9]FREUND Y,SCHAPIRE R.A short introduction to boosting 作者简介: [J].Journal of Japanese society for artificial intelligence, 李龙,男,1982年生,硕士研究生, 1999,14(5):771-780. 主要研究方向为图像处理与计算机 [10]HE Kaiming,ZHANG Xiangyu,REN Shaoqing,et al. 视觉。 Spatial pyramid pooling in deep convolutional networks for visual recognition M ]//FLEET D,PAJDLA T. SCHIELE B,et al.Computer Vision-ECCV 2014.Switzer- land:Springer International Publishing,2014:346-361. [11]LAZEBNIK S,SCHMID C.PONCE J.Beyond bags of fea- 尹辉,女,1972年生,副教授,博士 tures:spatial pyramid matching for recognizing natural 生导师,主要研究方向为计算机视觉、 scene categories[C]//Proceedings of 2006 IEEE Comput- 模式识别以及神经计算。 er Society Conference on Computer Vision and Pattern Recognition.New York,NY,USA:IEEE,2006,2: 2169-2178. [12]BURGES C J C.A tutorial on support vector machines for pattern recognition[].Data mining and knowledge discov- 许宏丽.女,1963年生,教授,主要 ey,1998,2(2):121-167. 研究方向为计算机技术、机器学习以及 [13]DALAL N,TRIGGS B.Histograms of oriented gradients for 认知计算。 human detection[C]//Proceedings of IEEE Computer So- ciety Conference on Computer Vision and Pattern Recogni- tion.San Diego,CA,USA:IEEE,2005,1:886-893

graphics (TOG), 2006, 25(3): 835⁃846. [8] YONETANI R, KITANI K M, SATO Y. Ego⁃surfing first person videos[C] / / Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA: IEEE, 2015: 5445⁃5454. [9]FREUND Y, SCHAPIRE R. A short introduction to boosting [J]. Journal of Japanese society for artificial intelligence, 1999, 14(5): 771⁃780. [10] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition [ M ] / / FLEET D, PAJDLA T, SCHIELE B, et al. Computer Vision⁃ECCV 2014. Switzer⁃ land: Springer International Publishing, 2014: 346⁃361. [11]LAZEBNIK S, SCHMID C, PONCE J. Beyond bags of fea⁃ tures: spatial pyramid matching for recognizing natural scene categories[C] / / Proceedings of 2006 IEEE Comput⁃ er Society Conference on Computer Vision and Pattern Recognition. New York, NY, USA: IEEE, 2006, 2: 2169⁃2178. [12]BURGES C J C. A tutorial on support vector machines for pattern recognition[J]. Data mining and knowledge discov⁃ ery, 1998, 2(2): 121⁃167. [13]DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[C] / / Proceedings of IEEE Computer So⁃ ciety Conference on Computer Vision and Pattern Recogni⁃ tion. San Diego, CA, USA: IEEE, 2005, 1: 886⁃893. [14]ZHU Wangjiang, LIANG Shuang, WEI Yichen, et al. Sa⁃ liency optimization from robust background detection[C] / / Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH: IEEE, 2014: 2814⁃2821. 作者简介: 李龙,男,1982 年生,硕士研究生, 主要研究方向为图像处理与计算机 视觉。 尹辉,女,1972 年生,副教授,博士 生导师,主要研究方向为计算机视觉、 模式识别以及神经计算。 许宏丽,女,1963 年生, 教授,主要 研究方向为计算机技术、机器学习以及 认知计算。 ·626· 智 能 系 统 学 报 第 11 卷