第12卷第2期 智能系统学报 Vol.12 No.2 2017年4月 CAAI Transactions on Intelligent Systems Apr.2017 D0I:10.11992/is.201605031 网络出版地址:http://www.cnki.net/kcms/detail/23.1538.tp.20170112.1020.004.html 动态数据约简的神经网络分类器训练方法研究 刘威,刘尚,白润才2,周璇,周定宁 (1.辽宁工程技术大学理学院,辽宁阜新123000;2.辽宁工程技术大学矿业学院,辽宁阜新123000) 摘要:针对神经网络分类器训练时间长、泛化能力差的问题,提出了一种基于动态数据约简的神经网络分类器训 练方法(DDR)。该训练方法在训练过程中赋给每个训练样本一个权重值作为样本的重要性度量,依据每次网络迭 代训练样本的分类错误率动态更新每个训练样本的权重值,之后依据样本的权重值来约简训练样本,从而增加易错 分类的边界样本比重,减少冗余核样本的作用。数值实验表明,基于权重的动态数据约简神经网络训练方法不仅大 幅缩短了网络的训练时间,而且还能够显著提升网络的分类泛化能力。 关键词:神经网铬:数据约简:分类边界:样本权重:边界样本:核样本 中图分类号:TP301.6文献标志码:A文章编号:1673-4785(2017)02-02258-08 中文引用格式:刘威,刘尚,白润才,等.动态数据约简的神经网络分类器训练方法研究[J].智能系统学报,2017,12(2):258-265. 英文引用格式:LIU Wei,LIU Shang,BAI Runcai,etal.Reducing training times in neural network classifiers by using dynamic da- ta reduction[J].CAAI transactions on intelligent systems,2017,12(2):258-265. Reducing training times in neural network classifiers by using dynamic data reduction LIU Wei',LIU Shang',BAI Runcai2,ZHOU Xuan',ZHOU Dingning' (1.College of Science,Liaoning Technical University,Fuxin 123000,China;2.Mining Institute,Liaoning Technical University, Fuxin 123000,China) Abstract:In this paper,we present a neural network classifier training method based on dynamic data reduction (DDR)to address long training times and the poor generalization ability of neural network classifiers.In our ap- proach,we assigned each sample a weight value,which was then dynamically updated based on the classification error rate at each iteration of the training sample.Subsequently,the training sample was reduced based on the weight of the sample so as to increase the proportion of boundary samples in error-prone classification environments and to reduce the role of redundant kernel samples.Our numerical experiments show that our neural network train- ing method not only substantially shortens the training time of the given networks,but also significantly enhances the classification and generalization abilities of the network. Keywords:neural network;data reduction;classification boundary;sample weight;boundary sample;kernel sample 单隐藏层前馈神经网络由于其学习能力强、能权值后,输入信号通过网络正向传递,得到模拟输出 够逼近复杂非线性函数、优异的信息分布式存储和 信号,之后依据输出信号和数据标签之间的误差反 并行协同处理能力以及鲁棒性好的特点,使得神经 向传播的方式调整网络权值,使均方误差最小,从而 网络在很多领域得到了广泛的应用。由于神经网络 使网络映射输出更好地“拟合逼近”数据标签,以达 监督学习的本质,在神经网络训练过程中,随机初始 到学习的目的。 在神经网络的分类应用中,神经网络分类器训 收稿日期:2016-05-28.网络出版日期:2017-02-20. 基金项目:国家自然科学基金项目(51304114,71371091). 练过程是一个调整分类超曲面的过程,在训练初始 通信作者:刘尚.E-mail:whiteinblue@l26.com. 阶段通过随机产生一个超曲面,然后依据误差来调

第 12 卷第 2 期 智 能 系 统 学 报 Vol.12 №.2 2017 年 4 月 CAAI Transactions on Intelligent Systems Apr. 2017 DOI:10.11992 / tis.201605031 网络出版地址:http: / / www.cnki.net / kcms/ detail / 23.1538.tp.20170112.1020.004.html 动态数据约简的神经网络分类器训练方法研究 刘威1 ,刘尚1 ,白润才2 ,周璇1 ,周定宁1 (1.辽宁工程技术大学 理学院,辽宁 阜新 123000; 2.辽宁工程技术大学 矿业学院,辽宁 阜新 123000) 摘 要:针对神经网络分类器训练时间长、泛化能力差的问题,提出了一种基于动态数据约简的神经网络分类器训 练方法(DDR)。 该训练方法在训练过程中赋给每个训练样本一个权重值作为样本的重要性度量,依据每次网络迭 代训练样本的分类错误率动态更新每个训练样本的权重值,之后依据样本的权重值来约简训练样本,从而增加易错 分类的边界样本比重,减少冗余核样本的作用。 数值实验表明,基于权重的动态数据约简神经网络训练方法不仅大 幅缩短了网络的训练时间,而且还能够显著提升网络的分类泛化能力。 关键词:神经网络;数据约简;分类边界;样本权重;边界样本;核样本 中图分类号: TP301.6 文献标志码:A 文章编号:1673-4785(2017)02-02258-08 中文引用格式:刘威,刘尚,白润才,等. 动态数据约简的神经网络分类器训练方法研究[J]. 智能系统学报, 2017, 12(2): 258-265. 英文引用格式:LIU Wei, LIU Shang, BAI Runcai, et al. Reducing training times in neural network classifiers by using dynamic da⁃ ta reduction[J]. CAAI transactions on intelligent systems, 2017, 12(2): 258-265. Reducing training times in neural network classifiers by using dynamic data reduction LIU Wei 1 , LIU Shang 1 , BAI Runcai 2 , ZHOU Xuan 1 , ZHOU Dingning 1 (1. College of Science, Liaoning Technical University, Fuxin 123000, China; 2. Mining Institute, Liaoning Technical University, Fuxin 123000, China) Abstract:In this paper, we present a neural network classifier training method based on dynamic data reduction (DDR) to address long training times and the poor generalization ability of neural network classifiers. In our ap⁃ proach, we assigned each sample a weight value, which was then dynamically updated based on the classification error rate at each iteration of the training sample. Subsequently, the training sample was reduced based on the weight of the sample so as to increase the proportion of boundary samples in error⁃prone classification environments and to reduce the role of redundant kernel samples. Our numerical experiments show that our neural network train⁃ ing method not only substantially shortens the training time of the given networks, but also significantly enhances the classification and generalization abilities of the network. Keywords: neural network; data reduction; classification boundary; sample weight; boundary sample; kernel sample 收稿日期:2016-05-28. 网络出版日期:2017-02-20. 基金项目:国家自然科学基金项目 (51304114, 71371091). 通信作者:刘尚. E⁃mail:whiteinblue@ 126.com. 单隐藏层前馈神经网络由于其学习能力强、能 够逼近复杂非线性函数、优异的信息分布式存储和 并行协同处理能力以及鲁棒性好的特点,使得神经 网络在很多领域得到了广泛的应用。 由于神经网络 监督学习的本质,在神经网络训练过程中,随机初始 权值后,输入信号通过网络正向传递,得到模拟输出 信号,之后依据输出信号和数据标签之间的误差反 向传播的方式调整网络权值,使均方误差最小,从而 使网络映射输出更好地“拟合逼近”数据标签,以达 到学习的目的。 在神经网络的分类应用中,神经网络分类器训 练过程是一个调整分类超曲面的过程,在训练初始 阶段通过随机产生一个超曲面,然后依据误差来调

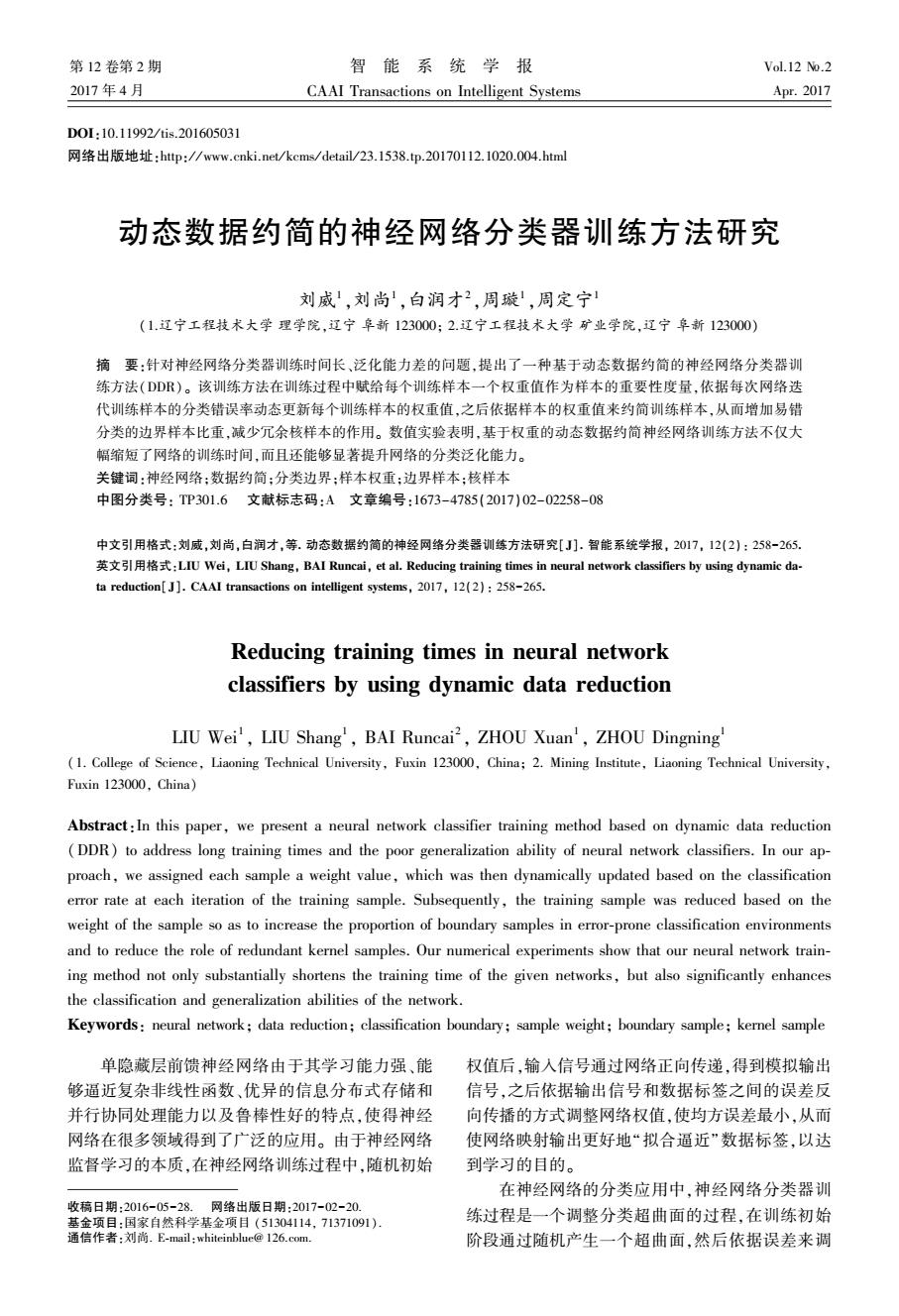

第2期 刘威,等:动态数据约简的神经网络分类器训练方法研究 .259. 整超曲面的位置,直到数据集中属于不同类的点正 只是更改样本分布权重,达到了重点关注错分类样 好位于超曲面的不同侧面。这种处理机制决定了神 本的目的。 经网络进行数据分类最终获得的分类超曲面有可能 当数据量大和数据过于集中时,神经网络分类器 相当靠近训练集中的点),不仅导致网络训练时间 训练时间长,泛化能力差:结合数据约简和样本权值 长,而且使网络分类边界过于靠近样本集中点,导致 的思想,本文提出了一种基于动态数据约简(dynamic 较差的分类泛化能力,所以数据样本对于网络训练 data reduction,DDR)的神经网络训练方法。该方法 时间、网络性能有重要的影响。 依据神经网络迭代训练过程中的训练样本的分类错 一个数据集可以用数据特征、数据量、数据分布 误率,动态更新训练样本的权重,然后依据权重对训 来描述。数据约简的目的主要是减少信息量,将一 练数据进行动态约简,从而达到缩短网络训练时间、 些无关紧要的信息去掉后,不影响系统原有的功能 增强网络泛化能力的目的。该方法将数据约简和分 表达。目前,针对数据约简的研究主要集中在两个 类器训练融合为一个阶段,比文献[5-7]的方法具有 方面:基于特征选择约简和基于实例选择约简。 快速的特点,比文献[8]具有简单的优势。 基于特征选择的数据约简是指在所有特征中选 择某些重要的、有代表性的特征,去除对处理结果影 1DDR训练方法 响小甚至无影响的特征,以达到提取主要特征的目 1.1BP神经网络 的。常见的特征选择方法主要有粗糙集法[)、主成 BP(back propagation)神经网络是一种单向传 分分析法[)、基于流行学习的Autoencoder等。 播的多层前馈网络,采用误差反向传播权值学习算 基于实例选择的数据约简是从原始数据集中选 法(BP算法),是目前应用较多的一种模型。BP神 择具有代表性的实例,去除冗余的和相似性较大的 经网络的基本单元是神经元,按照神经元的功能不 数据,得到相对较小的约简数据集,以达到减少数据 同将其分成若干层,通常最左侧的为输入层,最右侧 量和改变数据分布的目的。目前针对实例选择的数 的为输出层,而中间的为隐层,只有相邻层神经元之 据约简方法主要有基于聚类、基于样本距离、基于分 间存在权值连接,每层内部神经元无连接,其结构如 类边界的数据约简方法。聚类约简方法首先通过模 图1所示。 糊聚类)、K邻近聚类6)等聚类方法对训练数据进 行聚类分析,选择目标样本,别除冗余样本,以达到 h() 数据约简的目的,然后用约简后的数据作为新的训 h(x) 练数据进行分类器训练。整个分类系统分为数据约 简和分类训练两个阶段,第1阶段的数据筛选结果 对于最终分类器的性能起着关键性的作用,此外每 个阶段需要调整相应的模型参数,整个分类系统过 于复杂。基于样本距离的约简方法),通过构建样 本间距离度量(通常为欧氏距离),保留边界样本, 图1BP神经网络结构 Fig.1 BP neural network structure 剔除非边界样本。该方法同聚类的概念类似,仍属 于两阶段的分类系统。基于分类边界数据约简方法 B即神经网络的信息传递过程主要分为两个阶 主要为支持向量机算法(SVM)[),SVM算法基于最 段:信息前馈传递阶段和误差反馈阶段。信息前馈 优分类边界的概念,从训练集中选择支持向量,使得 阶段,每层的输入信息,首先通过连接权值进行融合 对支持向量的划分等价于对整个数据集的划分。 计算,再通过相应类型的激活函数进行激活变换得 此外,文献[9]利用HMM模型,通过模型的预 到输出信号,然后将输出信号作为输入传入下一层 测概率将训练样本分为好样本、差样本和边界样本, 进行相似的信息变换,最终传递到输出层得到网络 然后分析了选择不同的训练样本对于分类器的影 最终输出。误差反馈阶段,由于神经网络是一种监 响。文献[I0]的Adaboosting算法依据分类错误率, 督学习算法,将信号的前馈输出和真实标签之间的 通过增加错分类样本权重,减小正确分类样本权重 误差,通过连接权值从输出层反向传播至输入层,并 的方法,改变样本的权重分布,以达到重点关注错分 依据梯度值来更新连接权值,从而达到学习的目的。 类样本的目的,然后通过多个弱分类器加权综合获 1.2DDR训练方法设计思想 从分类的角度来说,分类的任务在于寻找分类 得强分类器,Adaboosting方法没有约简训练数据, 面,将分类空间划分为不同的类区域,训练的作用在

整超曲面的位置,直到数据集中属于不同类的点正 好位于超曲面的不同侧面。 这种处理机制决定了神 经网络进行数据分类最终获得的分类超曲面有可能 相当靠近训练集中的点[1] ,不仅导致网络训练时间 长,而且使网络分类边界过于靠近样本集中点,导致 较差的分类泛化能力,所以数据样本对于网络训练 时间、网络性能有重要的影响。 一个数据集可以用数据特征、数据量、数据分布 来描述。 数据约简的目的主要是减少信息量,将一 些无关紧要的信息去掉后,不影响系统原有的功能 表达。 目前,针对数据约简的研究主要集中在两个 方面:基于特征选择约简和基于实例选择约简。 基于特征选择的数据约简是指在所有特征中选 择某些重要的、有代表性的特征,去除对处理结果影 响小甚至无影响的特征,以达到提取主要特征的目 的。 常见的特征选择方法主要有粗糙集法[2] 、主成 分分析法[3] 、基于流行学习的 Autoencoder [4]等。 基于实例选择的数据约简是从原始数据集中选 择具有代表性的实例,去除冗余的和相似性较大的 数据,得到相对较小的约简数据集,以达到减少数据 量和改变数据分布的目的。 目前针对实例选择的数 据约简方法主要有基于聚类、基于样本距离、基于分 类边界的数据约简方法。 聚类约简方法首先通过模 糊聚类[5] 、K 邻近聚类[6] 等聚类方法对训练数据进 行聚类分析,选择目标样本,剔除冗余样本,以达到 数据约简的目的,然后用约简后的数据作为新的训 练数据进行分类器训练。 整个分类系统分为数据约 简和分类训练两个阶段,第 1 阶段的数据筛选结果 对于最终分类器的性能起着关键性的作用,此外每 个阶段需要调整相应的模型参数,整个分类系统过 于复杂。 基于样本距离的约简方法[7] ,通过构建样 本间距离度量(通常为欧氏距离),保留边界样本, 剔除非边界样本。 该方法同聚类的概念类似,仍属 于两阶段的分类系统。 基于分类边界数据约简方法 主要为支持向量机算法(SVM) [8] ,SVM 算法基于最 优分类边界的概念,从训练集中选择支持向量,使得 对支持向量的划分等价于对整个数据集的划分。 此外,文献[9]利用 HMM 模型,通过模型的预 测概率将训练样本分为好样本、差样本和边界样本, 然后分析了选择不同的训练样本对于分类器的影 响。 文献[10]的 Adaboosting 算法依据分类错误率, 通过增加错分类样本权重,减小正确分类样本权重 的方法,改变样本的权重分布,以达到重点关注错分 类样本的目的,然后通过多个弱分类器加权综合获 得强分类器,Adaboosting 方法没有约简训练数据, 只是更改样本分布权重,达到了重点关注错分类样 本的目的。 当数据量大和数据过于集中时,神经网络分类器 训练时间长,泛化能力差;结合数据约简和样本权值 的思想,本文提出了一种基于动态数据约简(dynamic data reduction,DDR)的神经网络训练方法。 该方法 依据神经网络迭代训练过程中的训练样本的分类错 误率,动态更新训练样本的权重,然后依据权重对训 练数据进行动态约简,从而达到缩短网络训练时间、 增强网络泛化能力的目的。 该方法将数据约简和分 类器训练融合为一个阶段,比文献[5-7]的方法具有 快速的特点,比文献[8]具有简单的优势。 1 DDR 训练方法 1.1 BP 神经网络 BP (back propagation)神经网络是一种单向传 播的多层前馈网络,采用误差反向传播权值学习算 法(BP 算法),是目前应用较多的一种模型。 BP 神 经网络的基本单元是神经元,按照神经元的功能不 同将其分成若干层,通常最左侧的为输入层,最右侧 的为输出层,而中间的为隐层,只有相邻层神经元之 间存在权值连接,每层内部神经元无连接,其结构如 图 1 所示。 图 1 BP 神经网络结构 Fig.1 BP neural network structure BP 神经网络的信息传递过程主要分为两个阶 段:信息前馈传递阶段和误差反馈阶段。 信息前馈 阶段,每层的输入信息,首先通过连接权值进行融合 计算,再通过相应类型的激活函数进行激活变换得 到输出信号,然后将输出信号作为输入传入下一层 进行相似的信息变换,最终传递到输出层得到网络 最终输出。 误差反馈阶段,由于神经网络是一种监 督学习算法,将信号的前馈输出和真实标签之间的 误差,通过连接权值从输出层反向传播至输入层,并 依据梯度值来更新连接权值,从而达到学习的目的。 1.2 DDR 训练方法设计思想 从分类的角度来说,分类的任务在于寻找分类 面,将分类空间划分为不同的类区域,训练的作用在 第 2 期 刘威,等:动态数据约简的神经网络分类器训练方法研究 ·259·

.260 智能系统学报 第12卷 于分类超曲面的生成,从这个方面来说,边界样本就 的边界样本,弱化易正确分类的核样本的目的:最后 是位于理想分类超曲面附近的样本。神经网络在训 依据数据约简规则对训练样本进行挑选。数据约简 练过程中可以理解为依据训练数据调整分类超曲面 选择规则为:对于正确分类的训练样本,在[0,1]随 的过程,训练样本中,如果某种类别的数据量越多, 机选择一个数值rand,若rand小于样本的权重值, 它在训练出的模型中所起的作用就越大,分类超曲 则选择该样本为新的训练样本;否则剔除该样本。 面越靠近该分类。所以训练样本的分布主要影响分 这样在迭代过程中一直迭代分类正确的核样本,由 类超曲面的位置,训练样本的个数则主要影响网络 于其权值持续降低,被选择的概率较小:而边界样本 的训练时间。 由于其分类准确性随着分类超曲面的移动而波动, 依据文献[5,7,9]通过聚类或样本距离,依据 所以其权重值较大,被选择的概率较大;对于错误分 数据样本位置分布将数据分为核样本和边界样本, 类的样本则全部选择。然后将全部错分类样本和随 核样本数据一般位于数据类别聚类中心或远离类别 机选择的部分正确分类样本作为新的训练样本集, 边界的位置,边界样本位于相邻类别的临近或重叠 进行下一次迭代训练。由于神经网络训练过程中迭 位置。从聚类分析的观点来看,位于类中心的核样 代收敛较慢,训练过程往往需要较长的迭代次数,这 本更具代表性,所表达信息量更大,核样本可以使得 样会使核样本的权重值持续降低,一些错误分类边 训练出的模式类区域更加紧凑,不同模式类区域间 界样本的权重值则持续增加,导致训练样本的权值 隔更大,但核样本数目太多,不仅增加网络训练时 差异较大,不利于正确分类样本的选择。为了避免 间,还容易使得分类超曲面过于靠近核样本,使得分 上述问题,在权重值更新后通过权重值上下限约束, 类区域过小,从而使得边界样本被划分到超曲面以 对权重值进行规范化处理,权重下限值为xwb,xwb 外,使得网络分类错误率增加,泛化能力降低。文献 >0,权重上限值为xwt,xwt≤1,即权重xw:∈ [11]指出,基于神经网络的模式识别中,训练样本 [xwb,xwt],i=1,2,…,m,通过权值的规范化约束, 的总数目对于神经网络训练的影响不是十分重要, 使得迭代过程中选择边界样本的同时,也选择部分 重要的是其中边界样本的数目:有了足够多的边界 核样本进行协同训练,以避免由于样本过少而引起 样本,就可以训练出好的分类超曲面。但由于网络 的过拟合现象。 中边界样本个数相对较少,较少的训练数据很容易 1.3DDR训练方法算法描述 导致网络发生过拟合现象,同样会导致网络泛化能 设训练集为X={(x1少1),…,(xy:),…,(xm, 力下降。所以在神经网络分类器训练过程中,在利 yn)},x;∈R,训练样本批量为s,样本总均值误差 为E,批量均值误差为e,连接权值为0,学习率为 用全部边界样本的基础上,为了防止由于数据较少 α,迭代次数为k,样本权重集为XW,正确分类样本 引起的过拟合问题,实验还应选择相应数量的核样 本来协同训练。 权重集为XW,权重增量为xwd,权重标识集为XS, 错分类样本集为Xs,正确分类样本集为X,从 由于神经网络训练定过程可以理解为分类超曲面 Xh中选择的样本集Xe,约简后训练样本集为 移动的过程,训练样本中,核样本个数多,且分布在 Xin,则动态数据约简的神经网络分类器训练方 边界样本内部,所以在网络迭代训练过程中,核样本 法算法如下: 一般位于分类超曲面内部,其分类错误率较低,而边 算法1动态数据约简的神经网络分类器训练 界样本随着分类超曲面的移动,其分类错误率也随 输入X,xwd,xb,xwt=1,XW1.)=0.5, 之波动。所以在网络训练过程中应该减少核样本的 i=1,2,…,m 作用,增加边界样本的比重。 输出神经网络分类器f(x)。 基于上述思想,本文提出了一种基于训练分类 1)初始化网络结构,随机初始化网络权值: 错误率的动态数据约简方法(DDR):在网络训练过 2)训练样本规则化预处理: 程中,首先赋给每个训练样本一个权重值xw:(i= 3)对当前训练样本X.m进行随机乱序操作, 1,2,…,m,m为原始训练样本总数)作为样本的重 重新排列样本的顺序: 要性度量,则样本构成权重向量XW={xw,…, 4)按照训练样本排列序号,依次提取批量s个 x,·,xwm};然后再依据每次迭代所有原始训练 样本,样本分成n个批次,n=round(m/s)。 样本的分类错误率动态更新每个训练样本的权重 5)计算网络各批量的均值误差 值,更新规则为:降低正确分类样本的权重值,增加 错误分类样本的权重值,以达到重点关注易错分类 (fx)-y)2,i=1,2,…,n

于分类超曲面的生成,从这个方面来说,边界样本就 是位于理想分类超曲面附近的样本。 神经网络在训 练过程中可以理解为依据训练数据调整分类超曲面 的过程,训练样本中,如果某种类别的数据量越多, 它在训练出的模型中所起的作用就越大,分类超曲 面越靠近该分类。 所以训练样本的分布主要影响分 类超曲面的位置,训练样本的个数则主要影响网络 的训练时间。 依据文献[5,7,9] 通过聚类或样本距离,依据 数据样本位置分布将数据分为核样本和边界样本, 核样本数据一般位于数据类别聚类中心或远离类别 边界的位置,边界样本位于相邻类别的临近或重叠 位置。 从聚类分析的观点来看,位于类中心的核样 本更具代表性,所表达信息量更大,核样本可以使得 训练出的模式类区域更加紧凑,不同模式类区域间 隔更大,但核样本数目太多,不仅增加网络训练时 间,还容易使得分类超曲面过于靠近核样本,使得分 类区域过小,从而使得边界样本被划分到超曲面以 外,使得网络分类错误率增加,泛化能力降低。 文献 [11]指出,基于神经网络的模式识别中,训练样本 的总数目对于神经网络训练的影响不是十分重要, 重要的是其中边界样本的数目;有了足够多的边界 样本,就可以训练出好的分类超曲面。 但由于网络 中边界样本个数相对较少,较少的训练数据很容易 导致网络发生过拟合现象,同样会导致网络泛化能 力下降。 所以在神经网络分类器训练过程中,在利 用全部边界样本的基础上,为了防止由于数据较少 引起的过拟合问题,实验还应选择相应数量的核样 本来协同训练。 由于神经网络训练过程可以理解为分类超曲面 移动的过程,训练样本中,核样本个数多,且分布在 边界样本内部,所以在网络迭代训练过程中,核样本 一般位于分类超曲面内部,其分类错误率较低,而边 界样本随着分类超曲面的移动,其分类错误率也随 之波动。 所以在网络训练过程中应该减少核样本的 作用,增加边界样本的比重。 基于上述思想,本文提出了一种基于训练分类 错误率的动态数据约简方法(DDR):在网络训练过 程中,首先赋给每个训练样本一个权重值 xwi ( i = 1,2,…,m , m 为原始训练样本总数)作为样本的重 要性度量,则样本构成权重向量 XW = {xw1 ,…, xwi,…,xwm } ;然后再依据每次迭代所有原始训练 样本的分类错误率动态更新每个训练样本的权重 值,更新规则为:降低正确分类样本的权重值,增加 错误分类样本的权重值,以达到重点关注易错分类 的边界样本,弱化易正确分类的核样本的目的;最后 依据数据约简规则对训练样本进行挑选。 数据约简 选择规则为:对于正确分类的训练样本,在[0,1]随 机选择一个数值 rand,若 rand 小于样本的权重值, 则选择该样本为新的训练样本;否则剔除该样本。 这样在迭代过程中一直迭代分类正确的核样本,由 于其权值持续降低,被选择的概率较小;而边界样本 由于其分类准确性随着分类超曲面的移动而波动, 所以其权重值较大,被选择的概率较大;对于错误分 类的样本则全部选择。 然后将全部错分类样本和随 机选择的部分正确分类样本作为新的训练样本集, 进行下一次迭代训练。 由于神经网络训练过程中迭 代收敛较慢,训练过程往往需要较长的迭代次数,这 样会使核样本的权重值持续降低,一些错误分类边 界样本的权重值则持续增加,导致训练样本的权值 差异较大,不利于正确分类样本的选择。 为了避免 上述问题,在权重值更新后通过权重值上下限约束, 对权重值进行规范化处理,权重下限值为 xwb,xwb > 0, 权重上限值为 xwt, xwt ≤ 1, 即 权 重 xwi ∈ [xwb,xwt],i =1,2,…,m ,通过权值的规范化约束, 使得迭代过程中选择边界样本的同时,也选择部分 核样本进行协同训练,以避免由于样本过少而引起 的过拟合现象。 1.3 DDR 训练方法算法描述 设训练集为 X = {(x1 ,y1 ),…,(xi,yi),…,(xm, ym)} ,xi ∈ R r ,训练样本批量为 s ,样本总均值误差 为 E ,批量均值误差为 e ,连接权值为 w ,学习率为 α ,迭代次数为 k ,样本权重集为 XW,正确分类样本 权重集为 XWright,权重增量为 xwd,权重标识集为 XS, 错分类样本集为 Xwrong,正确分类样本集为 Xright ,从 Xright 中选择的样本集 Xselect ,约简后训练样本集为 Xreduction ,则动态数据约简的神经网络分类器训练方 法算法如下: 算法 1 动态数据约简的神经网络分类器训练 输入 X , xwd, xwb, xwt = 1, XW(1,i) = 0.5, i =1,2,…,m; 输出 神经网络分类器 f(x)。 1)初始化网络结构,随机初始化网络权值; 2)训练样本规则化预处理; 3)对当前训练样本 Xreduction 进行随机乱序操作, 重新排列样本的顺序; 4)按照训练样本排列序号,依次提取批量 s 个 样本,样本分成 n 个批次, n = round(m / s) 。 5)计算网络各批量的均值误差 ei = 1 s ∑ s j = 1 (f(xj) - yj) 2 ,i = 1,2,…,n ·260· 智 能 系 统 学 报 第 12 卷

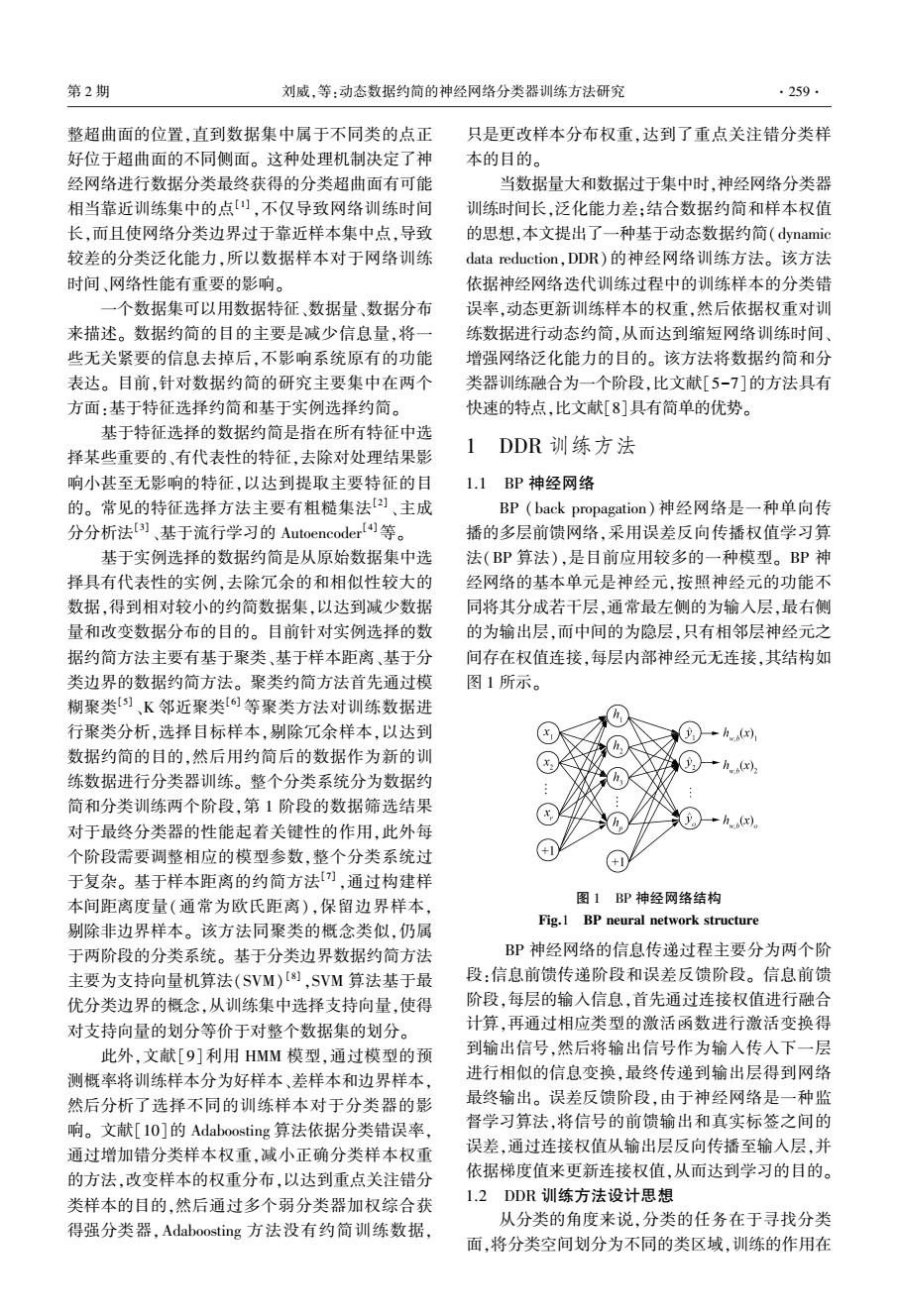

第2期 刘威,等:动态数据约简的神经网络分类器训练方法研究 .261. 6)子批量内均值修正网络的权值: 2 实验分析 de 0(k+1)=o(k)+a 00 2.1 实验参数设置 7)计算所有样本的均值误差: 实验网络神经元激励函数均采用单级S型 E=6,i=1,2…,n (Sigmoid)激励函数,训练中采用动量项梯度下降算 法作为网络训练算法,为了加速网络收敛,选用子批 8)依据分类错误率更新样本权重值: 量网络权值更新规则,同时为了避免过拟合现象,实 X.nng= 验输人数据经过预处理后再输入到网络中,并且在 {(x11),…,(x:y:),…,(xpyn)fx)~=y 训练过程中加入权值惩罚项。 Xright= 为了使算法稳定收敛到最小,采用学习率缩减的 {(x1,y1),…,(x,y:),…,(xgyg){f八x)==y 方式来调节学习率,设学习率改变次数比例参数为 (-1 f八x:)==y scaleIndex,学习率改变程度参数为scaleLr,学习率改 x5:+1, fx:)~=y: 变总次数为Change Times,.学习率调整策略见算法2。 算法2学习率调整算法 XWk+l,=XWk.)+XS:·xwd,i=1,2,…,m 输入T,scaleIndex,scaleLr,ChangeTimes; 9)样本权重约束 输出学习率curLr。 XW(1.)max(XW(+1 ,xwb) =min(wt)12.m Changelndex =T*scalelndex FOR =1:K 10)样本约简选择 IF >Changelndex&&curTimes<ChangeTimes Xcdea=(x,)XWish(i)rand(0,1),i= Changelndex =k+scalelndex *(K-k) 1,2,,9,Xmduction =Xhad UXscect curLr =curLr scaleLr 11)根据迭代次数进行判断是否达到收敛要求,若 curTimes curTimes+1 达到要求则网络完成训练,否则循环3)~11)。 为了全面公平地对比标准神经网络训练方法 算法补充说明:round()函数表示对小数进行 (STD)和本文提出的数据约简神经网络训练方法 舍入取整操作:神经网络更新规则当s=m时,即为 (DDR),将两种神经网络在相同的网络结构、初始 全批量权值更新规则:当s=1时,即为增量权值更 权值和学习参数配置下进行训练。 新规则:当1<s<m时,即为子批量权值更新规则。 2.2人工数据可视化分析 动态数据约简的神经网络训练方法如图2。 为了可视化验证动态数据约简神经网络训练方 开始 法在训练过程中数据约简过程,实验采用正态分布生 成3分类的2维点数据集,各类点的坐标均值分别为 归一化预处理数据 人 (38,38),(50,70),(75,45),每个维度的方差为55, 训练样本随机排序 每个类别400个样本,总计1200个样本。生成的数 据集如图5所示,星号为类别A,五角星为类别B,圆 将训练样本按照批量S进行分组 依据权重和错误率 进行数据选择 圈为类别C,数据集中每个类的中心点数据密集,边 界点相对稀疏,且边界别点之间存在重叠。 在当前批量内进行权值更新 基于错误率更新 样本权重 实验参数设置:训练样本个数为600,测试样本 个数为600,网络结构为2-3-3,迭代次数为500,学 全部批量 计算训练样本分类 于算完成 错误率 习率为0.2,动量项为0.9,权值惩罚系数为105,学 习改变参数scaleIndex和scaleLr均为2/3,ChangeT- <是否达到收敛 imes为8,初始训练样本权重为0.5,权重增量系数 为0.005,权值上限为1,权值下限为0.1。 结束○ 依据实验参数设置可知,训练样本权重xw:∈ [0.1,1],i=1,2,…,m。为了可视化实验过程的训 图2动态数据约简神经网络训练方法流程图 Fig.2 Flow chart of neural network training method 练样本权重分布,实验将权重取值范围分成[0.1, for dynamie data reduction 0.32]、[0.32,0.55]、[0.55,0.77]、[0.77,1]4个区

6)子批量内均值修正网络的权值: w(k + 1) = w(k) + α ∂e ∂w 7)计算所有样本的均值误差: E = ∑ n i = 1 ei,i = 1,2,…,n 8)依据分类错误率更新样本权重值: Xwrong = {(x1,y1),…,(xi,yi),…,(xp,yp)}f(xi) ~ = yi Xright = {(x1 ,y1 ),…,(xi,yi),…,(xq,yq)}f(xi) == yi XSi = - 1, f(xi) == yi + 1, f(xi) ~ = yi { XW(k+1,i) = XW(k,i) + XSi·xwd,i = 1,2,…,m 9)样本权重约束 XW(k+1,i) = max(XW(k+1,i) ,xwb) XW(k+1,i) = min(XW(k+1,i) ,xwt) ,i = 1,2,…,m 10)样本约简选择 Xselect = {(xi,yi)}XWright(i) > rand(0,1),i = 1,2,…,q,Xreduction = Xbad ∪ Xselect 11)根据迭代次数进行判断是否达到收敛要求,若 达到要求则网络完成训练,否则循环 3) ~11)。 算法补充说明: round( ) 函数表示对小数进行 舍入取整操作;神经网络更新规则当 s = m 时,即为 全批量权值更新规则;当 s = 1 时,即为增量权值更 新规则;当 1 < s < m 时,即为子批量权值更新规则。 动态数据约简的神经网络训练方法如图 2。 图 2 动态数据约简神经网络训练方法流程图 Fig.2 Flow chart of neural network training method for dynamic data reduction 2 实验分析 2.1 实验参数设置 实验网络神经元激励函数均采用单级 S 型 (Sigmoid)激励函数,训练中采用动量项梯度下降算 法作为网络训练算法,为了加速网络收敛,选用子批 量网络权值更新规则,同时为了避免过拟合现象,实 验输入数据经过预处理后再输入到网络中,并且在 训练过程中加入权值惩罚项。 为了使算法稳定收敛到最小,采用学习率缩减的 方式来调节学习率,设学习率改变次数比例参数为 scaleIndex,学习率改变程度参数为 scaleLr,学习率改 变总次数为 ChangeTimes,学习率调整策略见算法 2。 算法 2 学习率调整算法 输入 T,scaleIndex,scaleLr,ChangeTimes; 输出 学习率 curLr。 ChangeIndex = T∗scaleIndex FOR k = 1:K IF k>ChangeIndex&&curTimes<ChangeTimes ChangeIndex = k+scaleIndex∗(K-k) curLr = curLr∗scaleLr curTimes = curTimes+1 为了全面公平地对比标准神经网络训练方法 (STD)和本文提出的数据约简神经网络训练方法 (DDR),将两种神经网络在相同的网络结构、初始 权值和学习参数配置下进行训练。 2.2 人工数据可视化分析 为了可视化验证动态数据约简神经网络训练方 法在训练过程中数据约简过程,实验采用正态分布生 成 3 分类的 2 维点数据集,各类点的坐标均值分别为 (38,38),(50,70),(75,45),每个维度的方差为 55, 每个类别 400 个样本,总计 1 200 个样本。 生成的数 据集如图 5 所示,星号为类别 A ,五角星为类别 B ,圆 圈为类别 C ,数据集中每个类的中心点数据密集,边 界点相对稀疏,且边界别点之间存在重叠。 实验参数设置:训练样本个数为 600,测试样本 个数为 600,网络结构为 2-3-3,迭代次数为 500,学 习率为 0.2,动量项为 0.9,权值惩罚系数为 10 -5 ,学 习改变参数 scaleIndex 和 scaleLr 均为 2 / 3,ChangeT⁃ imes 为 8,初始训练样本权重为 0.5,权重增量系数 为 0.005,权值上限为 1,权值下限为 0.1。 依据实验参数设置可知,训练样本权重 xwi ∈ [0.1,1],i = 1,2,…,m 。 为了可视化实验过程的训 练样本权重分布,实验将权重取值范围分成[0.1, 0.32]、[0.32,0.55]、[0.55,0.77]、[0.77,1] 4 个区 第 2 期 刘威,等:动态数据约简的神经网络分类器训练方法研究 ·261·

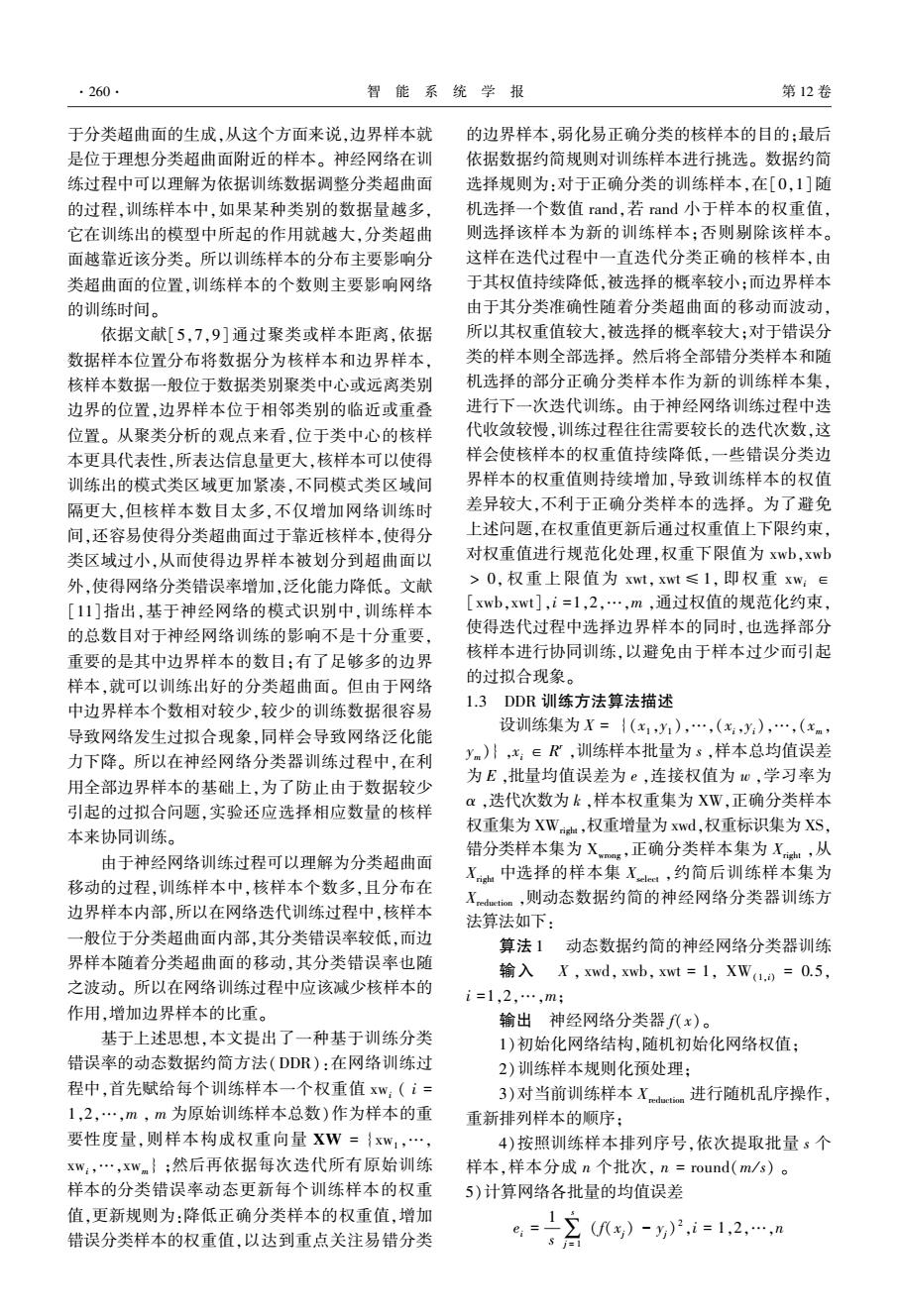

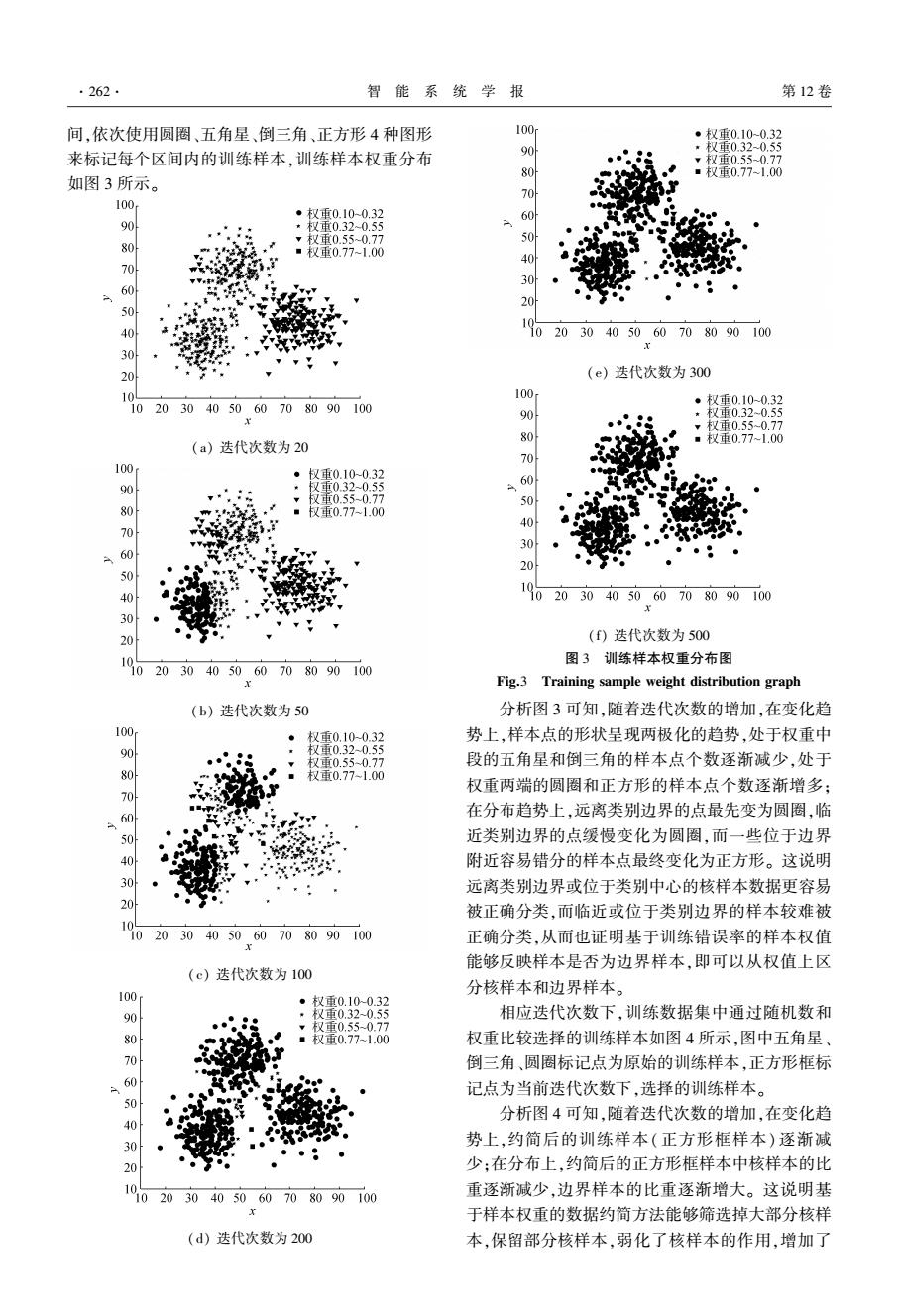

262 智能系 统学报 第12卷 间,依次使用圆圈、五角星、倒三角、正方形4种图形 100 ·权重0.10-0.32 9 权重0.32-0.55 来标记每个区间内的训练样本,训练样本权重分布 权重0.55-0.77 如图3所示。 ■权重0.77-1.00 100 权重0.10-0.32 90 权重0.320.55 80 70 40 60 20 40 20 30 405060 708090100 30 20 (e)迭代次数为300 00 10 20 。权重0.10-0.32 30 40 50 60 708090100 *权重0.320.55 (a)迭代次数为20 0300 权重0.550.77 ■电07.00 100 ·权重0.10-0.32 权重032-0.55 000 权重0.550.77 权重0.77-1.00 60 9 ● 1 0 10 20 30 405060 708090100 30 20 (f)迭代次数为500 图3训练样本权重分布图 20 30 40 60708090100 Fig.3 Training sample weight distribution graph (b)迭代次数为50 分析图3可知,随着迭代次数的增加,在变化趋 V面010-03 势上,样本点的形状呈现两极化的趋势,处于权重中 000 权重0.32-0.55 权重0.55-0.77 段的五角星和倒三角的样本点个数逐渐减少,处于 权重0.77-1.00 权重两端的圆圈和正方形的样本点个数逐渐增多; 60 在分布趋势上,远离类别边界的点最先变为圆圈,临 近类别边界的点缓慢变化为圆圈,而一些位于边界 40 附近容易错分的样本点最终变化为正方形。这说明 30 远离类别边界或位于类别中心的核样本数据更容易 20 被正确分类,而临近或位于类别边界的样本较难被 1 0 20 30 40 50 60 7080 90100 正确分类,从而也证明基于训练错误率的样本权值 能够反映样本是否为边界样本,即可以从权值上区 (c)迭代次数为100 分核样本和边界样本。 100 权重0.100.32 权重0.32-0.55 相应迭代次数下,训练数据集中通过随机数和 00刀 权重0.55-0.77 权重0.77-1.00 权重比较选择的训练样本如图4所示,图中五角星 倒三角、圆圈标记点为原始的训练样本,正方形框标 记点为当前迭代次数下,选择的训练样本。 分析图4可知,随着迭代次数的增加,在变化趋 40 势上,约简后的训练样本(正方形框样本)逐渐减 ● 少:在分布上,约简后的正方形框样本中核样本的比 10 重逐渐减少,边界样本的比重逐渐增大。这说明基 0 30 405060708090 100 于样本权重的数据约简方法能够筛选掉大部分核样 (d)迭代次数为200 本,保留部分核样本,弱化了核样本的作用,增加了

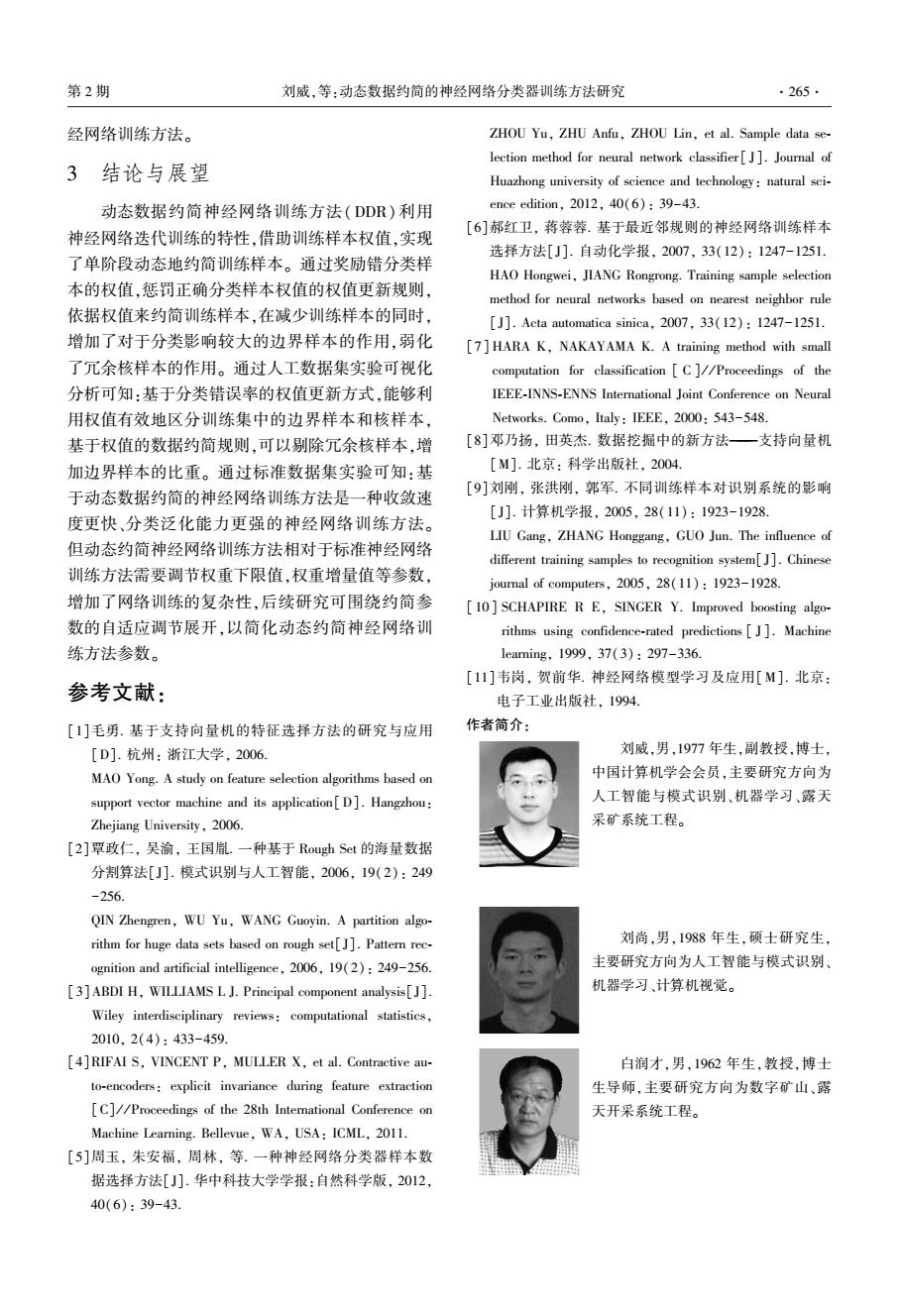

间,依次使用圆圈、五角星、倒三角、正方形 4 种图形 来标记每个区间内的训练样本,训练样本权重分布 如图 3 所示。 (a) 迭代次数为 20 (b) 迭代次数为 50 (c) 迭代次数为 100 (d) 迭代次数为 200 (e) 迭代次数为 300 (f) 迭代次数为 500 图 3 训练样本权重分布图 Fig.3 Training sample weight distribution graph 分析图 3 可知,随着迭代次数的增加,在变化趋 势上,样本点的形状呈现两极化的趋势,处于权重中 段的五角星和倒三角的样本点个数逐渐减少,处于 权重两端的圆圈和正方形的样本点个数逐渐增多; 在分布趋势上,远离类别边界的点最先变为圆圈,临 近类别边界的点缓慢变化为圆圈,而一些位于边界 附近容易错分的样本点最终变化为正方形。 这说明 远离类别边界或位于类别中心的核样本数据更容易 被正确分类,而临近或位于类别边界的样本较难被 正确分类,从而也证明基于训练错误率的样本权值 能够反映样本是否为边界样本,即可以从权值上区 分核样本和边界样本。 相应迭代次数下,训练数据集中通过随机数和 权重比较选择的训练样本如图 4 所示,图中五角星、 倒三角、圆圈标记点为原始的训练样本,正方形框标 记点为当前迭代次数下,选择的训练样本。 分析图 4 可知,随着迭代次数的增加,在变化趋 势上,约简后的训练样本(正方形框样本) 逐渐减 少;在分布上,约简后的正方形框样本中核样本的比 重逐渐减少,边界样本的比重逐渐增大。 这说明基 于样本权重的数据约简方法能够筛选掉大部分核样 本,保留部分核样本,弱化了核样本的作用,增加了 ·262· 智 能 系 统 学 报 第 12 卷

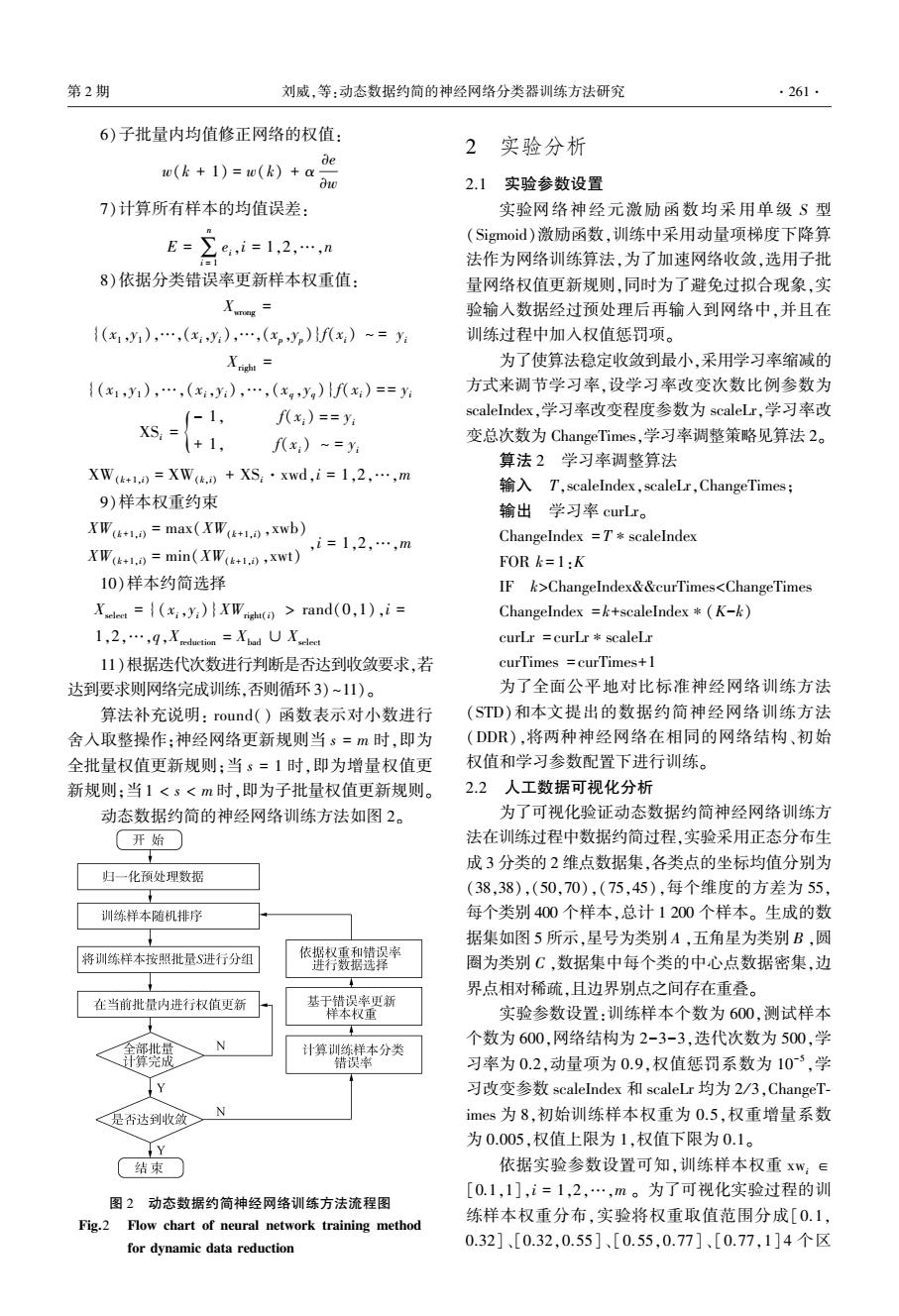

第2期 刘威,等:动态数据约简的神经网络分类器训练方法研究 .263. 边界样本的比重,约简数据的同时,通过保留部分核 100 5 选择样本 样本进行协同训练,避免了仅选择少数边界样本会 类别- 造成的过拟合问题。 类别-C 100 60 90 80 40 60 50 0 1 40 102030405060708090100 30 20 (e)迭代次数为300 10 0 100 20 30405060708090100 选择样本 (a)迭代次数为20 60 1 102030405060708090100 020 (f)迭代次数为500 图4选择的训练样本分布图 10 20 30 4050.60 708090100 Fig.4 Selected training sample distribution map (b)迭代次数为50 标准训练方法STD和动态数据约简方法DDR 训练的神经网络分类器,最终形成的分类边界如图 0000 洗择样本 5所示。图中白色、灰色和深灰色区域为STD方法 每个类别对应的区域,区域边界即为标准训练方法 训练的神经网络对应的分类边界。黑色实线为 DDR方法训练的神经网络的分类边界。 100 4 90 020 80 10 20 30405060708090100 60 (c)迭代次数为100 0 选择样本 30 R 类别 1062030 4050,60708090100 60 图5神经网络分类器边界图 5 Fig.5 Neural network classifier boundary map 0 对比图5中两个神经网络分类器边界可知, 20 DDR方法训练的神经网络分类器边界在一个更加 20 30405060708090100 恰当的分类位置区分各个类别,比STD方法具有更 少的错分类样本,这也说明通过增加边界样本的比 (d)迭代次数为200 重,削弱核样本作用训练的神经网络分类器具有更

边界样本的比重,约简数据的同时,通过保留部分核 样本进行协同训练,避免了仅选择少数边界样本会 造成的过拟合问题。 (a)迭代次数为 20 (b)迭代次数为 50 (c)迭代次数为 100 (d) 迭代次数为 200 (e)迭代次数为 300 (f) 迭代次数为 500 图 4 选择的训练样本分布图 Fig.4 Selected training sample distribution map 标准训练方法 STD 和动态数据约简方法 DDR 训练的神经网络分类器,最终形成的分类边界如图 5 所示。 图中白色、灰色和深灰色区域为 STD 方法 每个类别对应的区域,区域边界即为标准训练方法 训练的神经网络对应的分类边界。 黑色实线为 DDR 方法训练的神经网络的分类边界。 图 5 神经网络分类器边界图 Fig.5 Neural network classifier boundary map 对比图 5 中两个神经网络分类器边界可知, DDR 方法训练的神经网络分类器边界在一个更加 恰当的分类位置区分各个类别,比 STD 方法具有更 少的错分类样本,这也说明通过增加边界样本的比 重,削弱核样本作用训练的神经网络分类器具有更 第 2 期 刘威,等:动态数据约简的神经网络分类器训练方法研究 ·263·

.264 智能系统学报 第12卷 强的分类泛化能力。 误差下取得了较小的训练和测试分类错误率,说明 基于以上分析可知,基于样本权重的动态数据 DDR训练方法更加注重边界样本的作用,具有防止 约简方法能够区分并挑选边界样本和核样本,并随 过拟合的能力,能够训练分类泛化能力更好的神经 着网络的迭代训练,逐渐增加边界样本比重,弱化核 网络。 样本作用,从而训练出泛化能力更好的神经网络分 对比网络训练时间,DDR训练方法具有更短的 类器。 训练时间。由于每个数据集的训练样本个数,迭代 2.3标准数据集实验分析 次数、批量值、权重下限值等训练参数不同,所以相 为了验证基于动态数据约简的神经网络训练方 对STD训练方法,DDR训练方法时间缩短程度有所 法在标准分类数据集上的效果,选取10组标准数据 不同,总体上选择的权重下限值和学习批量越小, 集进行数值实验,其中Forest等9组来自UCI分类 DDR训练方法所需的训练时间越短,但过小的权重 数据集,Mnist标准数据集来自官方网站。各组数据 下限值和学习批量,容易引起网络波动,使得网络的 集属性以及训练集,测试集样本个数信息见表1。 分类泛化能力较差。 I0组数据集中Forest、IS、SL、Mnist具有固定的分类 表2不同神经网络训练方法的分类错误率比较 训练集个数和测试集个数,剩余的非固定数据集,训 Table 2 Comparison of classification error rate of different 练集和测试集个数比例基本保持1:1。 neural network training methods 表1UCI分类数据集的属性信息 数据集 Method loss train-Avg test-Avg time Table 1 Attribute information of UCI classification data set 名称 名称 样本个数训练样本属性个数 类别数 STD 0.0075 0.07 15.66 5.34 Forest Forest 523 198 27 4 DDR 0.0116 0.00 15.79 2.11 Glass 214 100 9 6 STD 0.0366 4.47 35.37 7.70 P 180 90 34 2 Glass DDR 0.0504 1.63 33.48 3.29 Iris 150 75 4 3 STD 0.0044 0.30 30.04 1.24 IS 2310 210 19 7 P DDR 0.0108 0.00 29.96 0.41 LIR 20000 10000 10 Seeds 210 105 > 3 STD 0.0258 3.07 4.22 0.67 Iris SL 6435 4000 36 DDR 0.0585 6 1.87 3.69 0.36 Wine 178 90 13 3 STD 0.0274 3.51 10.14 2.52 Mnist 60000 10000 784 10 IS DDR 0.0326 1.14 8.72 1.53 在相同的实验条件下,标准训练算法(STD)和 STD 0.1141 12.92 14.41 122.33 动态数据约简训练方法(DDR)训练的神经网络分 LIR DDR 0.1446 8.05 11.01 77.80 类器,最终训练集均方误差1oss,训练集分类错误率 train-Avg,测试集分类错误率test-Avg和训练时间 STD 0.0582 7.06 9.62 78.14 time,30次实验的平均结果如表2所示。对比STD DDR 0.0652 5.80 9.78 34.15 和DDR两种训练方法的最终均方误差,除Seeds数 STD 0.0340 3.40 6.44 1.42 据集外,STD训练方法的均方误差均大于DDR训练 Seeds DDR 0.0132 0.13 4.98 3.73 方法的均方误差,说明DDR训练方法在整个训练上 更加关注边界样本,弱化了对于训练样本整体的 STD 0.0010 0.04 2.65 0.71 Wine “逼近拟合”。 DDR 0.0017 0.00 2.50 0.49 对比分类错误率,DDR训练方法比STD训练方 STD 0.0045 0.10 1.51 2104.83 法在较高的均方误差下具有更低的训练分类错误 Mnist DDR 0.0047 0.03 1.61 1129.18 率,除Forest、SL和Mnist3个数据集外取得相近的 预测分类错误率外,DDR训练方法在其余数据集上 基于以上对比分析可知,相对标准的神经网络 均具有更低的测试分类错误率。综合对比均方误差 训练方法STD,动态数据约简的神经网络训练方法 和错分类错误率可知,DDR训练方法在较大的均方 DDR是一种收敛速度更快、分类泛化能力更好的神

强的分类泛化能力。 基于以上分析可知,基于样本权重的动态数据 约简方法能够区分并挑选边界样本和核样本,并随 着网络的迭代训练,逐渐增加边界样本比重,弱化核 样本作用,从而训练出泛化能力更好的神经网络分 类器。 2.3 标准数据集实验分析 为了验证基于动态数据约简的神经网络训练方 法在标准分类数据集上的效果,选取 10 组标准数据 集进行数值实验,其中 Forest 等 9 组来自 UCI 分类 数据集,Mnist 标准数据集来自官方网站。 各组数据 集属性以及训练集,测试集样本个数信息见表 1。 10 组数据集中 Forest、IS、SL、Mnist 具有固定的分类 训练集个数和测试集个数,剩余的非固定数据集,训 练集和测试集个数比例基本保持 1:1。 表 1 UCI 分类数据集的属性信息 Table 1 Attribute information of UCI classification data set 名称 样本个数 训练样本 属性个数 类别数 Forest 523 198 27 4 Glass 214 100 9 6 IP 180 90 34 2 Iris 150 75 4 3 IS 2 310 210 19 7 LIR 20 000 10 000 61 10 Seeds 210 105 7 3 SL 6 435 4 000 36 6 Wine 178 90 13 3 Mnist 60 000 10 000 784 10 在相同的实验条件下,标准训练算法( STD)和 动态数据约简训练方法(DDR) 训练的神经网络分 类器,最终训练集均方误差 loss,训练集分类错误率 train⁃Avg,测试集分类错误率 test⁃Avg 和训练时间 time,30 次实验的平均结果如表 2 所示。 对比 STD 和 DDR 两种训练方法的最终均方误差,除 Seeds 数 据集外,STD 训练方法的均方误差均大于 DDR 训练 方法的均方误差,说明 DDR 训练方法在整个训练上 更加关注边界样本,弱化了对于训练样本整体的 “逼近拟合”。 对比分类错误率,DDR 训练方法比 STD 训练方 法在较高的均方误差下具有更低的训练分类错误 率,除 Forest、SL 和 Mnist 3 个数据集外取得相近的 预测分类错误率外,DDR 训练方法在其余数据集上 均具有更低的测试分类错误率。 综合对比均方误差 和错分类错误率可知,DDR 训练方法在较大的均方 误差下取得了较小的训练和测试分类错误率,说明 DDR 训练方法更加注重边界样本的作用,具有防止 过拟合的能力,能够训练分类泛化能力更好的神经 网络。 对比网络训练时间,DDR 训练方法具有更短的 训练时间。 由于每个数据集的训练样本个数,迭代 次数、批量值、权重下限值等训练参数不同,所以相 对 STD 训练方法,DDR 训练方法时间缩短程度有所 不同,总体上选择的权重下限值和学习批量越小, DDR 训练方法所需的训练时间越短,但过小的权重 下限值和学习批量,容易引起网络波动,使得网络的 分类泛化能力较差。 表 2 不同神经网络训练方法的分类错误率比较 Table 2 Comparison of classification error rate of different neural network training methods 数据集 名称 Method loss train⁃Avg test⁃Avg time Forest STD 0.007 5 0.07 15.66 5.34 DDR 0.011 6 0.00 15.79 2.11 Glass STD 0.036 6 4.47 35.37 7.70 DDR 0.050 4 1.63 33.48 3.29 IP STD 0.004 4 0.30 30.04 1.24 DDR 0.010 8 0.00 29.96 0.41 Iris STD 0.025 8 3.07 4.22 0.67 DDR 0.058 5 1.87 3.69 0.36 IS STD 0.027 4 3.51 10.14 2.52 DDR 0.032 6 1.14 8.72 1.53 LIR STD 0.114 1 12.92 14.41 122.33 DDR 0.144 6 8.05 11.01 77.80 SL STD 0.058 2 7.06 9.62 78.14 DDR 0.065 2 5.80 9.78 34.15 Seeds STD 0.034 0 3.40 6.44 1.42 DDR 0.013 2 0.13 4.98 3.73 Wine STD 0.001 0 0.04 2.65 0.71 DDR 0.001 7 0.00 2.50 0.49 Mnist STD 0.004 5 0.10 1.51 2 104.83 DDR 0.004 7 0.03 1.61 1 129.18 基于以上对比分析可知,相对标准的神经网络 训练方法 STD,动态数据约简的神经网络训练方法 DDR 是一种收敛速度更快、分类泛化能力更好的神 ·264· 智 能 系 统 学 报 第 12 卷

第2期 刘威,等:动态数据约简的神经网络分类器训练方法研究 .265. 经网络训练方法。 ZHOU Yu,ZHU Anfu,ZHOU Lin,et al.Sample data se- lection method for neural network classifier[J].Journal of 3结论与展望 Huazhong university of science and technology:natural sci- 动态数据约简神经网络训练方法(DDR)利用 ence edition,2012,40(6):39-43. [6]郝红卫,蒋蓉蓉.基于最近邻规则的神经网络训练样本 神经网络迭代训练的特性,借助训练样本权值,实现 选择方法[J].自动化学报,2007,33(12):1247-1251. 了单阶段动态地约简训练样本。通过奖励错分类样 HAO Hongwei,JIANG Rongrong.Training sample selection 本的权值,惩罚正确分类样本权值的权值更新规则, method for neural networks based on nearest neighbor rule 依据权值来约简训练样本,在减少训练样本的同时, [J].Acta automatica sinica,2007,33(12)1247-1251. 增加了对于分类影响较大的边界样本的作用,弱化 [7]HARA K,NAKAYAMA K.A training method with small 了冗余核样本的作用。通过人工数据集实验可视化 computation for classification [C]//Proceedings of the 分析可知:基于分类错误率的权值更新方式,能够利 IEEE-INNS-ENNS International Joint Conference on Neural 用权值有效地区分训练集中的边界样本和核样本, Networks.Como,Italy:IEEE,2000:543-548. 基于权值的数据约简规则,可以别除冗余核样本,增 [8]邓乃扬,田英杰.数据挖掘中的新方法一支持向量机 加边界样本的比重。通过标准数据集实验可知:基 [M].北京:科学出版社,2004 于动态数据约简的神经网络训练方法是一种收敛速 [9]刘刚,张洪刚,郭军.不同训练样本对识别系统的影响 [J].计算机学报,2005,28(11):1923-1928, 度更快、分类泛化能力更强的神经网络训练方法。 LIU Gang,ZHANG Honggang,GUO Jun.The influence of 但动态约简神经网络训练方法相对于标准神经网络 different training samples to recognition system[J].Chinese 训练方法需要调节权重下限值,权重增量值等参数, journal of computers,2005,28(11):1923-1928. 增加了网络训练的复杂性,后续研究可围绕约简参 [10 SCHAPIRE R E,SINGER Y.Improved boosting algo- 数的自适应调节展开,以简化动态约简神经网络训 rithms using confidence-rated predictions[J].Machine 练方法参数。 learning,1999,37(3):297-336. [11]韦岗,贺前华.神经网络模型学习及应用[M].北京: 参考文献: 电子工业出版社,1994. [1]毛勇.基于支持向量机的特征选择方法的研究与应用 作者简介: [D].杭州:浙江大学,2006. 刘威,男,1977年生,副教授,博士 MAO Yong.A study on feature selection algorithms based on 中国计算机学会会员,主要研究方向为 support vector machine and its application[D].Hangzhou: 人工智能与模式识别、机器学习、露天 Zhejiang University,2006. 采矿系统工程。 [2]罩政仁,吴渝,王国胤.一种基于Rough Set的海量数据 分割算法[J].模式识别与人工智能,2006,19(2):249 -256. QIN Zhengren,WU Yu,WANG Guoyin.A partition algo- rithm for huge data sets based on rough set[J.Pattern rec- 刘尚,男,1988年生,硕士研究生. ognition and artificial intelligence,2006,19(2):249-256. 主要研究方向为人工智能与模式识别、 [3]ABDI H,WILLIAMS L J.Principal component analysis[J]. 机器学习、计算机视觉。 Wiley interdisciplinary reviews:computational statistics, 2010,2(4):433-459. [4]RIFAI S,VINCENT P,MULLER X,et al.Contractive au- 白润才,男,1962年生,教授,博士 to-encoders:explicit invariance during feature extraction 生导师,主要研究方向为数字矿山、露 [C]//Proceedings of the 28th International Conference on 天开采系统工程。 Machine Learning.Bellevue,WA,USA:ICML,2011. 「5]周玉,朱安福,周林,等.一种神经网络分类器样本数 据选择方法[J].华中科技大学学报:自然科学版,2012, 40(6):39-43

经网络训练方法。 3 结论与展望 动态数据约简神经网络训练方法(DDR) 利用 神经网络迭代训练的特性,借助训练样本权值,实现 了单阶段动态地约简训练样本。 通过奖励错分类样 本的权值,惩罚正确分类样本权值的权值更新规则, 依据权值来约简训练样本,在减少训练样本的同时, 增加了对于分类影响较大的边界样本的作用,弱化 了冗余核样本的作用。 通过人工数据集实验可视化 分析可知:基于分类错误率的权值更新方式,能够利 用权值有效地区分训练集中的边界样本和核样本, 基于权值的数据约简规则,可以剔除冗余核样本,增 加边界样本的比重。 通过标准数据集实验可知:基 于动态数据约简的神经网络训练方法是一种收敛速 度更快、分类泛化能力更强的神经网络训练方法。 但动态约简神经网络训练方法相对于标准神经网络 训练方法需要调节权重下限值,权重增量值等参数, 增加了网络训练的复杂性,后续研究可围绕约简参 数的自适应调节展开,以简化动态约简神经网络训 练方法参数。 参考文献: [1]毛勇. 基于支持向量机的特征选择方法的研究与应用 [D]. 杭州: 浙江大学, 2006. MAO Yong. A study on feature selection algorithms based on support vector machine and its application[D]. Hangzhou: Zhejiang University, 2006. [2]覃政仁, 吴渝, 王国胤. 一种基于 Rough Set 的海量数据 分割算法[J]. 模式识别与人工智能, 2006, 19(2): 249 -256. QIN Zhengren, WU Yu, WANG Guoyin. A partition algo⁃ rithm for huge data sets based on rough set[J]. Pattern rec⁃ ognition and artificial intelligence, 2006, 19(2): 249-256. [3]ABDI H, WILLIAMS L J. Principal component analysis[J]. Wiley interdisciplinary reviews: computational statistics, 2010, 2(4): 433-459. [4]RIFAI S, VINCENT P, MULLER X, et al. Contractive au⁃ to⁃encoders: explicit invariance during feature extraction [C] / / Proceedings of the 28th International Conference on Machine Learning. Bellevue, WA, USA: ICML, 2011. [5]周玉, 朱安福, 周林, 等. 一种神经网络分类器样本数 据选择方法[J]. 华中科技大学学报:自然科学版, 2012, 40(6): 39-43. ZHOU Yu, ZHU Anfu, ZHOU Lin, et al. Sample data se⁃ lection method for neural network classifier[ J]. Journal of Huazhong university of science and technology: natural sci⁃ ence edition, 2012, 40(6): 39-43. [6]郝红卫, 蒋蓉蓉. 基于最近邻规则的神经网络训练样本 选择方法[J]. 自动化学报, 2007, 33(12): 1247-1251. HAO Hongwei, JIANG Rongrong. Training sample selection method for neural networks based on nearest neighbor rule [J]. Acta automatica sinica, 2007, 33(12): 1247-1251. [7] HARA K, NAKAYAMA K. A training method with small computation for classification [ C ] / / Proceedings of the IEEE⁃INNS⁃ENNS International Joint Conference on Neural Networks. Como, Italy: IEEE, 2000: 543-548. [8]邓乃扬, 田英杰. 数据挖掘中的新方法———支持向量机 [M]. 北京: 科学出版社, 2004. [9]刘刚, 张洪刚, 郭军. 不同训练样本对识别系统的影响 [J]. 计算机学报, 2005, 28(11): 1923-1928. LIU Gang, ZHANG Honggang, GUO Jun. The influence of different training samples to recognition system[J]. Chinese journal of computers, 2005, 28(11): 1923-1928. [ 10] SCHAPIRE R E, SINGER Y. Improved boosting algo⁃ rithms using confidence⁃rated predictions [ J ]. Machine learning, 1999, 37(3): 297-336. [11]韦岗, 贺前华. 神经网络模型学习及应用[M]. 北京: 电子工业出版社, 1994. 作者简介: 刘威,男,1977 年生,副教授,博士, 中国计算机学会会员,主要研究方向为 人工智能与模式识别、机器学习、露天 采矿系统工程。 刘尚,男,1988 年生,硕士研究生, 主要研究方向为人工智能与模式识别、 机器学习、计算机视觉。 白润才,男,1962 年生,教授,博士 生导师,主要研究方向为数字矿山、露 天开采系统工程。 第 2 期 刘威,等:动态数据约简的神经网络分类器训练方法研究 ·265·