第2章信息的度量 7/21/20101:03PM 信息理论与编码 1

7/21/2010 1:03 PM 信息理论与编码 1 第2章 信息的度量

主要内容 1、信源的数学模型及 7、离散有记忆信源的熵 分类 8、马尔可夫信源的信息 2、信息量及其性质 熵 3、离散信源的熵及性质 9、离散信源的信息(速 4、联合熵和条件熵 率和信息含 5、平均互信息量及其性 量效率 质 10、连续随机变量下的 6、扩展信源 熵和平均互信息量 第2章信息的度量 信息理论与编码 2

第2章 信息的度量 信息理论与编码 2 主要内容 1 、信源的数学模型及 分类 2、信息量及其性质 3、离散信源的熵及性质 4、联合熵和条件熵 5、平均互信息量及其性 质 6、扩展信源 7、离散有记忆信源的熵 8、马尔可夫信源的信息 熵 9、离散信源的信息(速) 率和信息含 量效率 10、连续随机变量下的 熵和平均互信息量

1、信源的数学模型及分类 根据参数集和值域是离散集合还是连续 区间,可将信源分为四类: (1)时间离散空间离散信源 (2)时间离散空间连续信源 (3)时间连续空间离散信源 (4)时间连续空间连续信源 简单的表示: 空间离散信源→离散信源 空间连续信源→连续信源 第2章信息的度量 信息理论与编码 3

第2章 信息的度量 信息理论与编码 3 1 、信源的数学模型及分类 根据参数集和值域是离散集合还是连续 区间,可将信源分为四类: (1) 时间离散空间离散信源 (2) 时间离散空间连续信源 (3) 时间连续空间离散信源 (4) 时间连续空间连续信源 简单的表示: 空间离散信源→离散信源 空间连续信源→连续信源

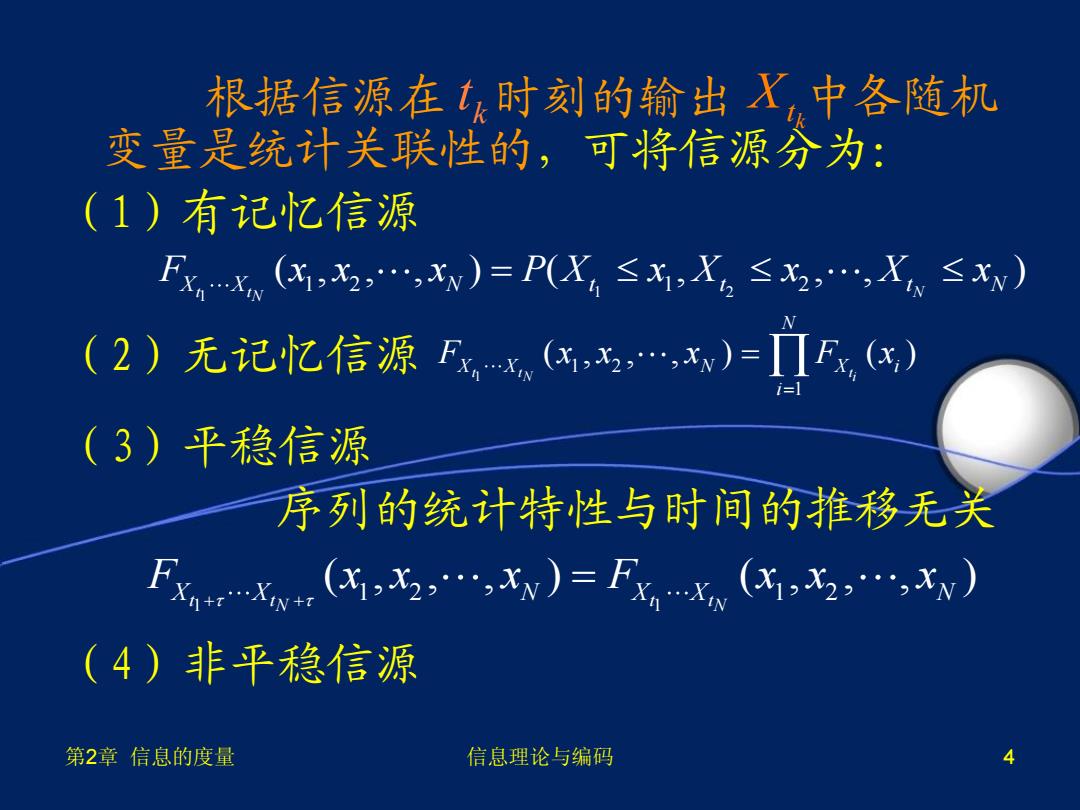

根据信源在1时刻的输出X,中各随机 变量是统计关联性的,可将信源分为: (1)有记忆信源 FX,x(K,x2,,x)=PX4≤x,X2≤x,,X≤Xv) (2)无记忆信源FX.(,x,,xv)=ΠF,(任) (3)平稳信源 序列的统计特性与时间的推移无关 Xw(X,x2,,xw)=FXXm(x,x2,…,xv) (4)非平稳信源 第2章信息的度量 信息理论与编码 4

第2章 信息的度量 信息理论与编码 4 根据信源在 时刻的输出 中各随机 变量是统计关联性的,可将信源分为: (1)有记忆信源 (2)无记忆信源 (3)平稳信源 序列的统计特性与时间的推移无关 (4)非平稳信源 k t k Xt 1 2 1 1 2 1 2 ( , , , ) ( , , , ) t t N N F x x x P X x X x X x X X N t t t N 1 1 2 1 ( , , , ) ( ) t t t N i N X X N X i i F x x x F x 1 1 1 2 1 2 ( , , , ) ( , , , ) t t t t N N F x x x F x x x X X N X X N

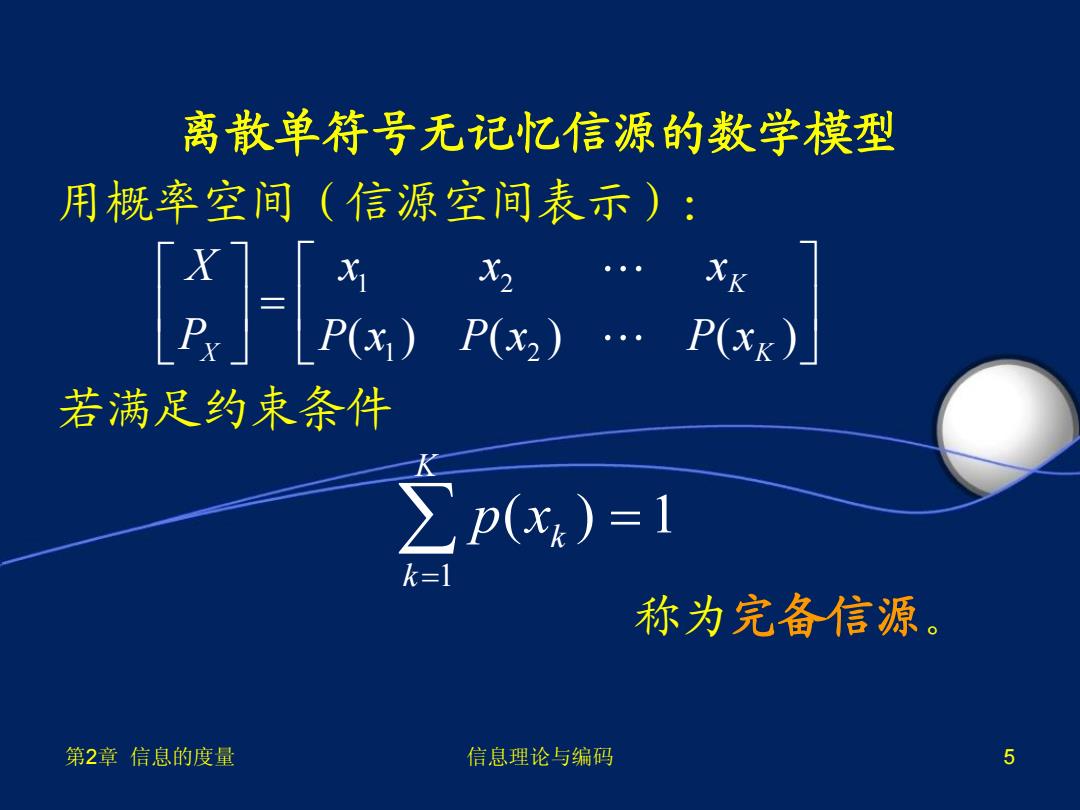

离散单符号无记忆信源的数学模型 用概率空间(信源空间表示): E),/ X2 XK 若满足约束条件 >p(x)=1 k=1 称为完备信源。 第2章信息的度量 信息理论与编码 5

第2章 信息的度量 信息理论与编码 5 离散单符号无记忆信源的数学模型 用概率空间(信源空间表示): 若满足约束条件 称为完备信源。 1 2 1 2 ( ) ( ) ( ) K X K X x x x P P x P x P x 1 ( ) 1 K k k p x

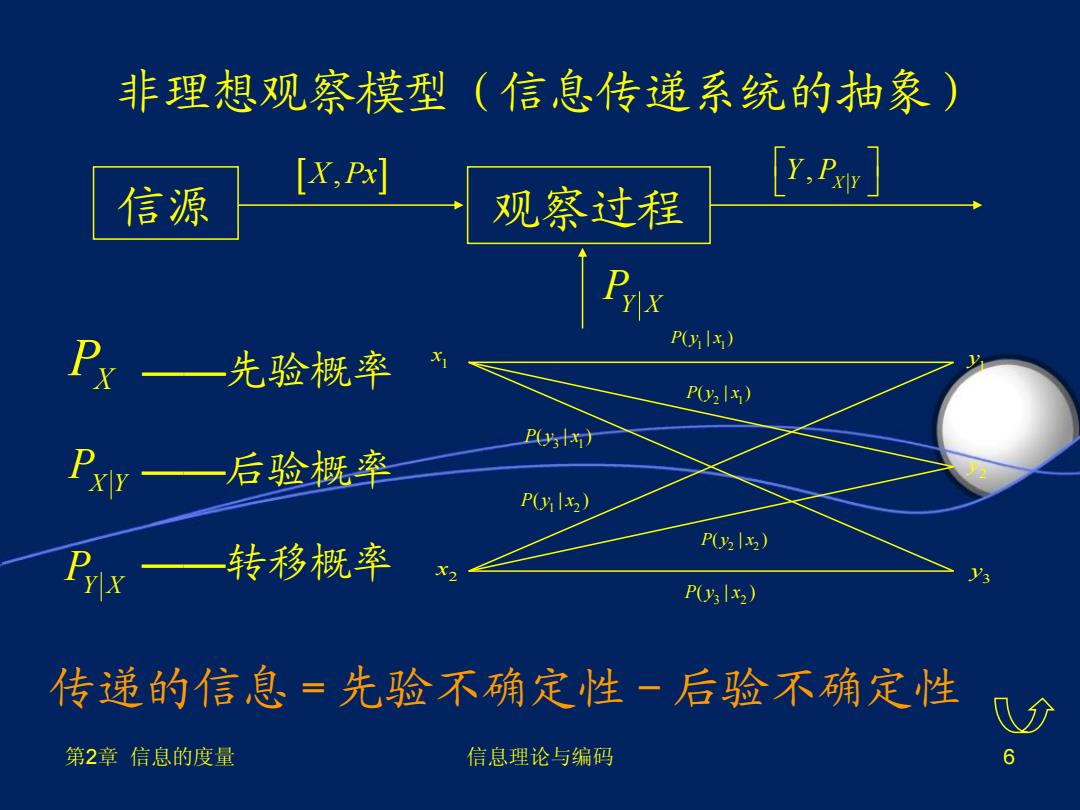

非理想观察模型(信息传递系统的抽象) [X,P] [y.A] 信源 观察过程 P) 卫x一先验概率 P2x) P(x) 阝xr一后验概率 2 P) 转移概率 P(x) P(x) 传递的信息=先验不确定性一后验不确定性 第2章信息的度量 信息理论与编码 6

第2章 信息的度量 信息理论与编码 6 非理想观察模型(信息传递系统的抽象) ——先验概率 ——后验概率 ——转移概率 传递的信息=先验不确定性-后验不确定性 1 1 P y x ( | ) 1 x 2 x 3 y 2 y 1 y 2 2 P y x ( | ) 2 1 P y x ( | ) 1 2 P y x ( | ) 3 1 P y x ( | ) 3 2 P y x ( | ) PX PX Y PY X 信源 观察过程 X Px , , X Y Y P PY X

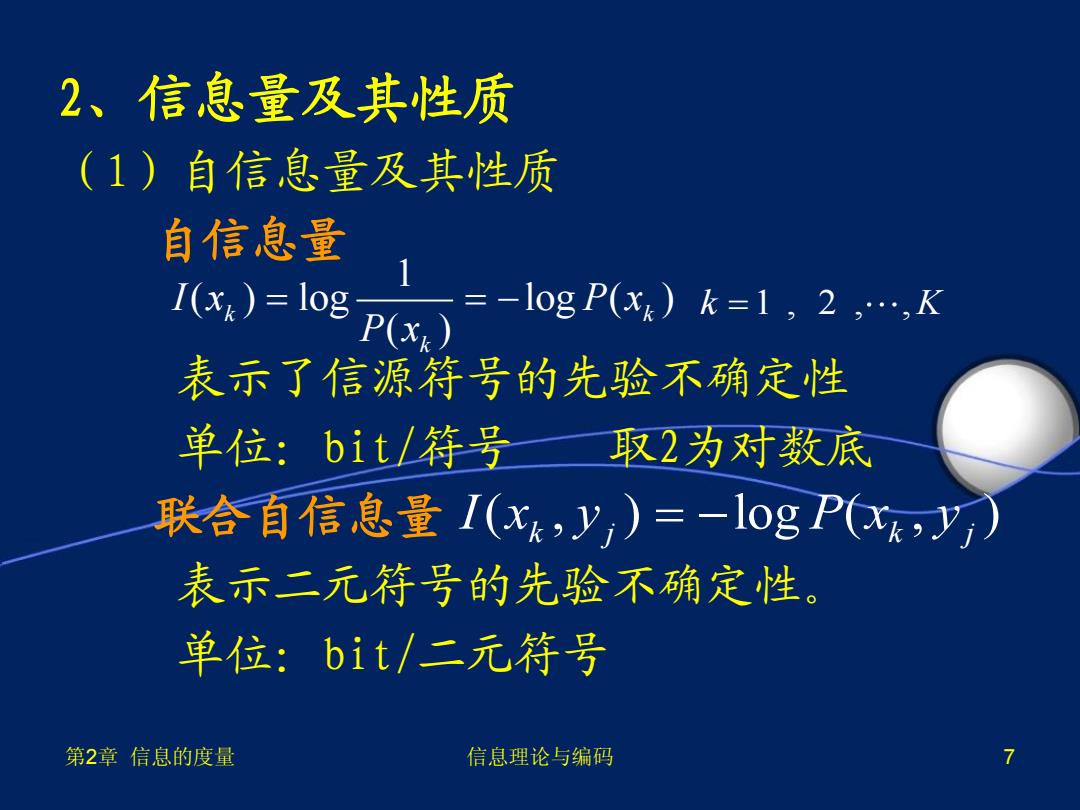

2、信息量及其性质 (1)自信息量及其性质 自信息量 1()=lo=-log()12 表示了信源符号的先验不确定性 单位:bit/符号 取2为对数底 联合自信息量I(xk,y,)=-logP(x,y) 表示二元符号的先验不确定性。 单位:bit/二元符号 第2章信息的度量 信息理论与编码 7

第2章 信息的度量 信息理论与编码 7 2、信息量及其性质 (1)自信息量及其性质 自信息量 表示了信源符号的先验不确定性 单位:bit/符号 取2为对数底 联合自信息量 表示二元符号的先验不确定性。 单位:bit/二元符号 1 ( ) log log ( ) ( ) k k k I x P x P x k K 1 , 2 , , ( , ) log ( , ) k j k j I x y P x y

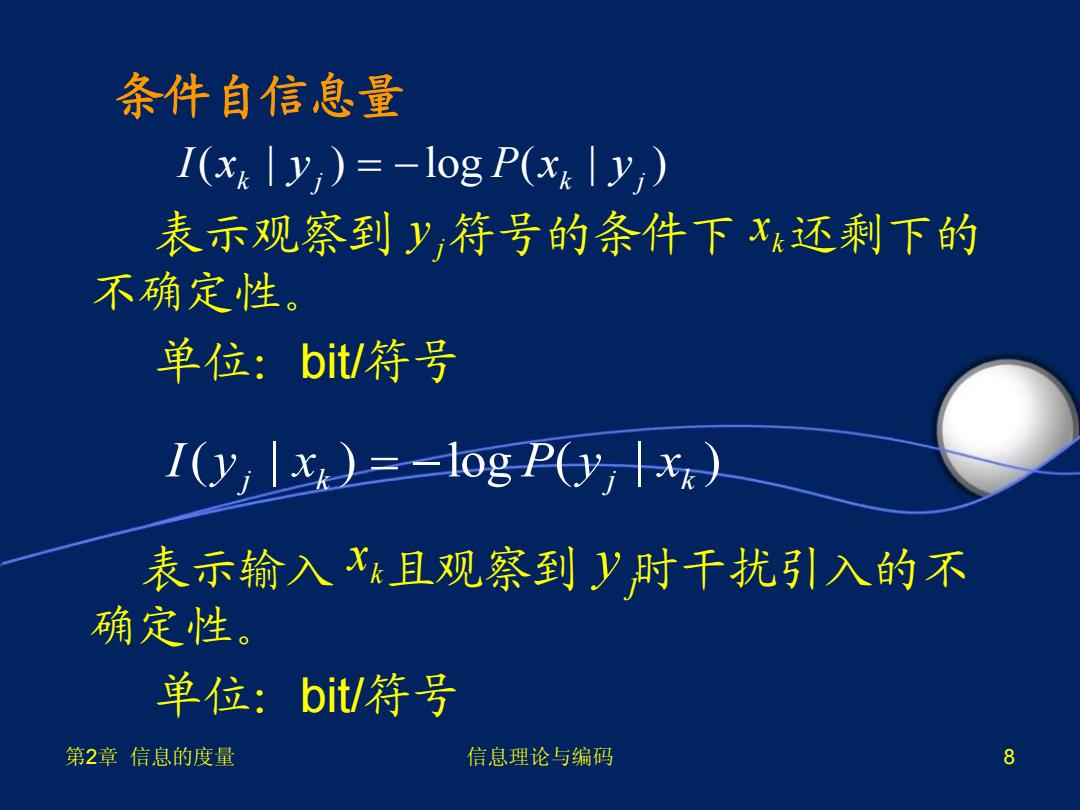

条件自信息量 I(xy)=-log P(xy) 表示观察到y,符号的条件下x还剩下的 不确定性。 单位:bit/符号 I(y)=-log P(Y) 表示输入x且观察到y时干扰引入的不 确定性。 单位:bit/符号 第2章信息的度量 信息理论与编码 8

第2章 信息的度量 信息理论与编码 8 条件自信息量 表示观察到 符号的条件下 还剩下的 不确定性。 单位:bit/符号 表示输入 且观察到 时干扰引入的不 确定性。 单位:bit/符号 ( | ) log ( | ) k j k j I x y P x y ( | ) log ( | ) j k j k I y x P y x k x k x j y j y

例甲在一8×8的方格棋盘上随意放入一 个棋子,在乙看来棋子落入的位置是不确 定的。 (1)在乙看来,棋子落入某方格的不 确定性为多少? (2)若甲告知乙棋子落入方格的行号, 这时,在乙看来棋子落入某方格的 不确定性为多少? 第2章信息的度量 信息理论与编码 9

第2章 信息的度量 信息理论与编码 9 例 甲在一8×8的方格棋盘上随意放入一 个棋子,在乙看来棋子落入的位置是不确 定的。 (1)在乙看来,棋子落入某方格的不 确定性为多少? (2)若甲告知乙棋子落入方格的行号, 这时,在乙看来棋子落入某方格的 不确定性为多少?

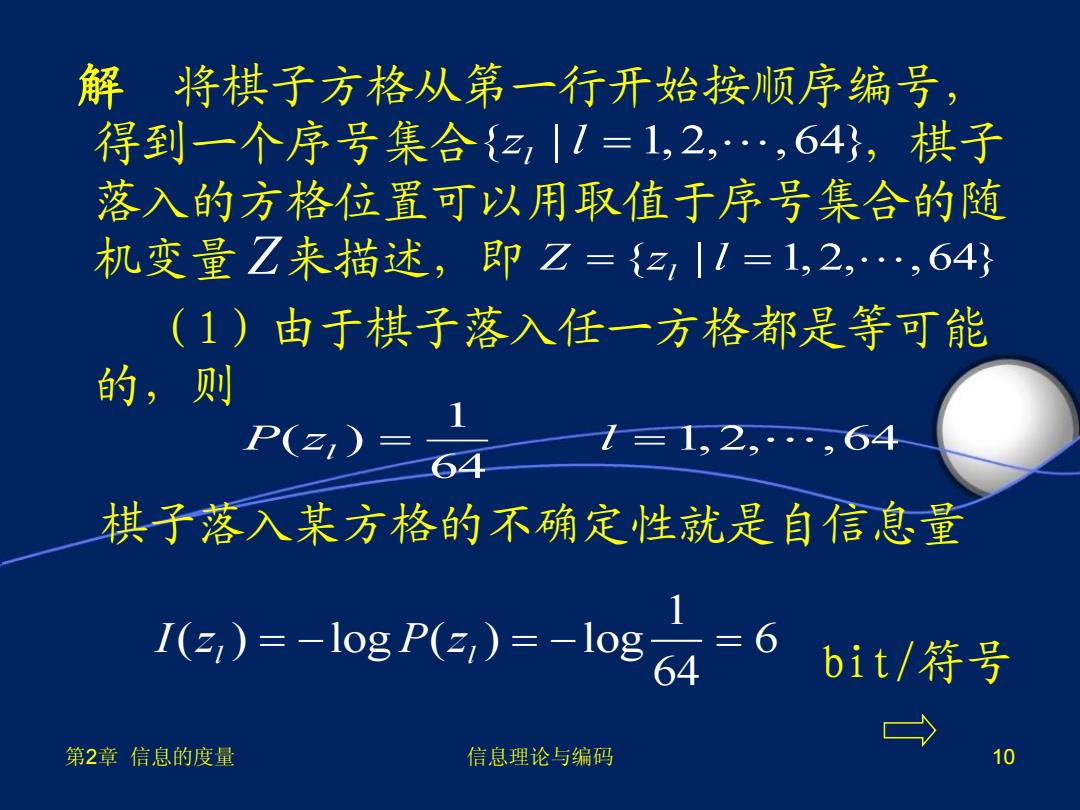

解将棋子方格从第一行开始按顺序编号 得到一个序号集合{z,|1=1,2,…,64),棋子 落入的方格位置可以用取值于序号集合的随 机变量Z来描述,即乙={z,|1=1,2,…,64} (1)由于棋子落入任一方格都是等可能 的,则 P(z,) =1.2 ··,64 棋子落入某方格的不确定性就是自信息量 E)-1gre)=-le4 6 bit/符号 第2章信息的度量 信息理论与编码 10

第2章 信息的度量 信息理论与编码 10 解 将棋子方格从第一行开始按顺序编号, 得到一个序号集合 ,棋子 落入的方格位置可以用取值于序号集合的随 机变量 来描述,即 (1)由于棋子落入任一方格都是等可能 的,则 棋子落入某方格的不确定性就是自信息量 bit/符号 { | 1, 2, ,64} l z l Z Z z l { | 1, 2, ,64} l 1 ( ) 1,2, ,64 64 P z l l 1 ( ) log ( ) log 6 64 l l I z P z