第12卷第1期 智能系统学报 Vol.12 No.1 2017年2月 CAAI Transactions on Intelligent Systems Feb.2017 D0I:10.11992/is.201611007 网络出版地址:http://kns.cmki.net/kcms/detail/23.1538.TP.20170227.2211.022.html 最近最远得分的聚类性能评价指标 冯柳伟2,常冬霞12,邓勇3,赵耀2 (1.北京交通大学信息科学研究所,北京100044:2.北京交通大学计算机与信息科学学院,北京100044;3.中国科 学院软件研究所,北京100190) 摘要:聚类算法是数据分析中广泛使用的方法之一,而类别数往往是决定聚类算法性能的关键。目前,大部分聚 类算法需要预先给定类别数,在很多情况下,很难根据数据集的先验知识获得有效的类别数。因此,为了获得数据 集的类别数,本文基于最近邻一致性和最远邻相异性的准则,提出了一种最近最远得分评价指标,并在此基础上提 出了一种自动确定类别数的聚类算法。实验结果证明了所提评价指标在确定类别数时的有效性和可行性。 关键词:最近邻一致性;最远邻相异性:K-means聚类算法;评分机制;评价指标:层次聚类 中图分类号:TP391文献标志码:A文章编号:1673-4785(2017)01-0067-08 中文引用格式:冯柳伟,常冬霞,邓勇,等.最近最远得分的聚类性能评价指标[J].智能系统学报,2017,12(1):67-74. 英文引用格式:FENGLiuwei,CHANG Dongxia,DENG Yong,etal.A clustering evaluation index based on the nearest and furthest score [J].CAAI Transactions on Intelligent Systems,2017,12(1):67-74. A clustering evaluation index based on the nearest and furthest score FENG Liuwei 23,CHANG Dongxia3,DENG Yong',ZHAO Yao23 (1.Institute of Information Science,Beijing Jiaotong University Beijing 100044,China;2.School of Computer and Information Technology,Beijing Jiaotong University,Beijing 100044,China;3.Institute of Software,Chinese Academy of Sciences,Beijing 100190,China) Abstract:The clustering algorithm is one of the widely-used methods in data analysis.However,the number of clusters is essential to determine the performance of the clustering algorithm.At present,the number of clusters usually need to be specified in advance.In most cases,it is difficult to obtain the valid cluster number according to a priori knowledge of the dataset.To obtain the number of clusters automatically,a Nearest and Furthest Score (NFS)index was proposed based on the principles of the nearest neighbor consistency and the furthest neighbor difference.Moreover,an Automatic Clustering NFS (ACNFS)algorithm was also proposed,which can determine the number of clusters automatically.The experimental results prove the index is reasonable and practicable to determine the cluster number. Keywords:the nearest neighbor consistency;the furthest neighbor difference;K-means clustering algorithm; scoring mechanism;evaluation index:hierarchical clustering 聚类算法作为数据分析中广泛使用的主要方数据间的相似度尽可能大,而不同类别数据间的相 法之一,已经广泛应用于模式识别、机器学习、图像 似度则尽可能小。目前,常用聚类算法可以分为划 处理和数据挖掘等方面1。简单来说,聚类就是 分法、层次法、基于密度的方法、基于网格的方法和 根据数据的特征将数据划分为几类,使得同一类别 基于模型的方法。事实上,很多聚类算法往往需要 预先知道聚类问题的类别数。然而,在很多实际情 收稿日期:2016-11-07.网络出版日期:2017-02-27. 况下,很难根据数据特征获得有效的类别数。因 基金项目:国家自然科学基金“重点”项目(61532005). 通信作者:常冬霞.E-mail:dxchange@bjtu.cdu.cn. 此,为了获得有效的类别数,很多学者基于聚类的

第 12 卷第 1 期 智 能 系 统 学 报 Vol.12 №.1 2017 年 2 月 CAAI Transactions on Intelligent Systems Feb. 2017 DOI:10.11992 / tis.201611007 网络出版地址:http: / / kns.cnki.net / kcms/ detail / 23.1538.TP.20170227.2211.022.html 最近最远得分的聚类性能评价指标 冯柳伟1,2 ,常冬霞1,2 ,邓勇3 ,赵耀1,2 (1. 北京交通大学 信息科学研究所,北京 100044;2. 北京交通大学 计算机与信息科学学院,北京 100044; 3.中国科 学院 软件研究所,北京 100190) 摘 要:聚类算法是数据分析中广泛使用的方法之一,而类别数往往是决定聚类算法性能的关键。 目前,大部分聚 类算法需要预先给定类别数,在很多情况下,很难根据数据集的先验知识获得有效的类别数。 因此,为了获得数据 集的类别数,本文基于最近邻一致性和最远邻相异性的准则,提出了一种最近最远得分评价指标,并在此基础上提 出了一种自动确定类别数的聚类算法。 实验结果证明了所提评价指标在确定类别数时的有效性和可行性。 关键词:最近邻一致性;最远邻相异性;K⁃means 聚类算法;评分机制;评价指标;层次聚类 中图分类号: TP391 文献标志码:A 文章编号:1673-4785(2017)01-0067-08 中文引用格式:冯柳伟,常冬霞,邓勇,等.最近最远得分的聚类性能评价指标[J]. 智能系统学报, 2017, 12(1): 67-74. 英文引用格式:FENG Liuwei, CHANG Dongxia, DENG Yong,et al. A clustering evaluation index based on the nearest and furthest score [J]. CAAI Transactions on Intelligent Systems, 2017, 12(1): 67-74. A clustering evaluation index based on the nearest and furthest score FENG Liuwei 1,2,3 ,CHANG Dongxia 1,2,3 , DENG Yong 4 , ZHAO Yao 1,2,3 (1. Institute of Information Science, Beijing Jiaotong University Beijing 100044, China; 2. School of Computer and Information Technology, Beijing Jiaotong University, Beijing 100044, China; 3. Institute of Software, Chinese Academy of Sciences, Beijing 100190, China) Abstract:The clustering algorithm is one of the widely⁃used methods in data analysis. However, the number of clusters is essential to determine the performance of the clustering algorithm. At present, the number of clusters usually need to be specified in advance. In most cases, it is difficult to obtain the valid cluster number according to a priori knowledge of the dataset. To obtain the number of clusters automatically, a Nearest and Furthest Score (NFS) index was proposed based on the principles of the nearest neighbor consistency and the furthest neighbor difference. Moreover, an Automatic Clustering NFS (ACNFS) algorithm was also proposed, which can determine the number of clusters automatically. The experimental results prove the index is reasonable and practicable to determine the cluster number. Keywords: the nearest neighbor consistency; the furthest neighbor difference; K⁃means clustering algorithm; scoring mechanism; evaluation index; hierarchical clustering 收稿日期:2016-11-07. 网络出版日期:2017-02-27. 基金项目:国家自然科学基金“重点”项目(61532005). 通信作者:常冬霞. E⁃mail:dxchang@ bjtu.edu.cn. 聚类算法作为数据分析中广泛使用的主要方 法之一,已经广泛应用于模式识别、机器学习、图像 处理和数据挖掘等方面[1-4] 。 简单来说,聚类就是 根据数据的特征将数据划分为几类,使得同一类别 数据间的相似度尽可能大,而不同类别数据间的相 似度则尽可能小。 目前,常用聚类算法可以分为划 分法、层次法、基于密度的方法、基于网格的方法和 基于模型的方法。 事实上,很多聚类算法往往需要 预先知道聚类问题的类别数。 然而,在很多实际情 况下,很难根据数据特征获得有效的类别数。 因 此,为了获得有效的类别数,很多学者基于聚类的

·68 智能系统学报 第12卷 不同性质分别提出了一系列评价聚类结果的评价 BWP指标和IGP指标等。 指标。对给定范围的类别数依次对数据集进行聚 l.1 Calinski-Harabasz(CH)指标 类,并采用评价指标对每次的聚类结果进行评价, CH指标是Calinski和Harabasz提出的确定最 然后选择一个使评价指标最优的类别数。目前,常 佳聚类数的评价指标。该指标是一种基于样本 用有效性评价指标大致可以分为3种类型,分别是 的类内距离和类间离差矩阵的测度,其判断函数为 基于数据集模糊划分的指标、基于数据集样本几何 CH(k)= BGSS WGSS (1) 结构的指标和基于数据集统计信息的指标。其中, -1'n-K 1991年,Xie等利用模糊聚类的目标函数,同时考 式中:n为数据集样本数,K为类别数。且 虑数据集本身的结构和模糊隶属度的性质,提出了 Xie-Beni指标。之后,很多学者基于数据集模糊划 WGSs=2[(m,-1)d+…+(mk-1)d] 分提出了一系列改善的评价指标[6],但这些指标 不适合对硬聚类算法的聚类结果进行评价。另外 BGS5-[(-1)+(n-K)A] -类是基于数据集样本几何结构的评价指标[1c6 式中:d是第j类中样本间的平均距离,j=1,2,…, 1974年,Calinski和Harabasz提出了基于全部样本 的类内离差矩阵和类间离差矩阵测度的Calinski- k:?是所有样本间的平均距离。且Ax为 Harabasz(CH)指标2.1979年,Davies和Bouldin Ak=1Σ(n,-1)(2-) 提出了基于样本的类内散度与各聚类中心间距离 n-K台 测度的Davies-Bouldin(DB)指标[1],以及随后提出 CH指标值越大表示聚类结果的类内距离越小 的基于最大化类内相似度和最小化类间相似度目 而类间距离越大,聚类结果性能越好。但是随着类 标的Weighted inter--intra(Wint)指标a)、基于样本 别数搜索范围的变化,CH指标得到的最佳聚类数 类内离差矩阵的Krzanowski-Lai(KL)指标1]、周世 会发生变化,并且随着搜索范围增大,CH指标得到 兵等提出的基于样本间的最小类间距离与类内距 的最佳聚类数有逐渐增大的趋势[)。 离的Between-Within Proportion(BWP)指标Ii6)。但 1.2BWP指标 是这些评价指标均具有一定的局限性,对数据结构 BWP指标是周世兵等人提出的一种基于样本 无法完全分离的数据集进行评价得到的结果并不 的几何结构设计的确定聚类类别数的评价指标[6]」 理想。2007年,Kapp等基于数据集统计的思想,使 该指标利用聚类结果的类内紧密性和类间分离性 用类内数据点的in-goup比例来评价聚类结果,提 来衡量聚类结果。指标的最大值对应的类数作为 出了n-Group Proportion(IGP)评价指标]。该评 聚类数。该指标的判断函数为 价指标使用样本与其最近邻样本划分到同一类的 BWP(K) 比例来衡量聚类结果的质量。但是由于IGP只关 n bwp(i,j) (2) 注最近邻一致性,使得IG指标值会随着聚类数的 式中:K是类别数,bwp(i,j)为 增加而减少,导致在很多实际情况下,利用IG指 b(i,j)-w(i,j) bwp(i,j) 标得到的类别数往往比实际的类别数小。针对这 b(i,j)+w(i,j) 种情况,本文基于最近邻一致性和最远邻相异性的 式中:b(i,)是第j类中的第i个样本到其他每类中 原则,提出了一种最近最远得分指标(NFS),并基于 样本平均距离的最小值,称为最小类间距;w(i,)是 此指标,提出了一种基于NFS指标自动确定类别数 第j类中的第i个样本的类内距离。且 的聚类算法。实验结果验证了本文所提的评价指 b(i,j)=, min x-x 标的有效性和可行性。 k,m产八几mp=1 1 已有评价指标 w(i,j)=- ‖xg9-9I2 众所周知,很多聚类算法需要用户根据先验知 BWP指标值越大则表示聚类结果的类内越紧 识给出算法所需要的类别数。但是,在很多实际应 密而类间越远离,聚类结果性能越好。但是该评价 用中很难获得有效的先验知识,因此,确定聚类问 指标不适合非完全分离的数据集。 题的类别数成为了聚类分析的一个研究的热点。 1.3IGP指标 目前传统的确定类别数的方法是根据评价指标来 IGP指标是Kapp提出的评价指标[)。此指标 确定类别数。至今提出的评价指标包括CH指标、 的设计思想是:当对新的样本进行分类时,新样本

不同性质分别提出了一系列评价聚类结果的评价 指标。 对给定范围的类别数依次对数据集进行聚 类,并采用评价指标对每次的聚类结果进行评价, 然后选择一个使评价指标最优的类别数。 目前,常 用有效性评价指标大致可以分为 3 种类型,分别是 基于数据集模糊划分的指标、基于数据集样本几何 结构的指标和基于数据集统计信息的指标。 其中, 1991 年,Xie 等[5]利用模糊聚类的目标函数,同时考 虑数据集本身的结构和模糊隶属度的性质,提出了 Xie⁃Beni 指标。 之后,很多学者基于数据集模糊划 分提出了一系列改善的评价指标[6⁃9] ,但这些指标 不适合对硬聚类算法的聚类结果进行评价。 另外 一类是基于数据集样本几何结构的评价指标[10⁃16] 。 1974 年,Caliński 和 Harabasz 提出了基于全部样本 的类内离差矩阵和类间离差矩阵测度的 Caliński⁃ Harabasz(CH) 指标[12] 。 1979 年,Davies 和 Bouldin 提出了基于样本的类内散度与各聚类中心间距离 测度的 Davies⁃Bouldin(DB)指标[13] ,以及随后提出 的基于最大化类内相似度和最小化类间相似度目 标的 Weighted inter⁃intra( Wint) 指标[14] 、基于样本 类内离差矩阵的 Krzanowski⁃Lai(KL)指标[15] 、周世 兵等提出的基于样本间的最小类间距离与类内距 离的 Between⁃Within Proportion(BWP) 指标[16] 。 但 是这些评价指标均具有一定的局限性,对数据结构 无法完全分离的数据集进行评价得到的结果并不 理想。 2007 年,Kapp 等基于数据集统计的思想,使 用类内数据点的 in⁃group 比例来评价聚类结果,提 出了 In⁃Group Proportion( IGP) 评价指标[17] 。 该评 价指标使用样本与其最近邻样本划分到同一类的 比例来衡量聚类结果的质量。 但是由于 IGP 只关 注最近邻一致性,使得 IGP 指标值会随着聚类数的 增加而减少,导致在很多实际情况下,利用 IGP 指 标得到的类别数往往比实际的类别数小。 针对这 种情况,本文基于最近邻一致性和最远邻相异性的 原则,提出了一种最近最远得分指标(NFS),并基于 此指标,提出了一种基于 NFS 指标自动确定类别数 的聚类算法。 实验结果验证了本文所提的评价指 标的有效性和可行性。 1 已有评价指标 众所周知,很多聚类算法需要用户根据先验知 识给出算法所需要的类别数。 但是,在很多实际应 用中很难获得有效的先验知识,因此,确定聚类问 题的类别数成为了聚类分析的一个研究的热点。 目前传统的确定类别数的方法是根据评价指标来 确定类别数。 至今提出的评价指标包括 CH 指标、 BWP 指标和 IGP 指标等。 1.1 Calinski⁃Harabasz(CH)指标 CH 指标是 Caliński 和 Harabasz 提出的确定最 佳聚类数的评价指标[12] 。 该指标是一种基于样本 的类内距离和类间离差矩阵的测度,其判断函数为 CH(k) = BGSS K - 1 / WGSS n - K (1) 式中:n 为数据集样本数,K 为类别数。 且 WGSS = 1 2 [(n1 - 1) d - 2 1 + … + (nK - 1) d - 2 K ] BGSS = 1 2 [(K - 1) d - 2 + (n - K)AK ] 式中:d -2 j 是第 j 类中样本间的平均距离,j = 1,2,…, k;d -2 是所有样本间的平均距离。 且 AK 为 AK = 1 n - K∑ K i = 1 (ni - 1)( d - 2 - d - 2 i ) CH 指标值越大表示聚类结果的类内距离越小 而类间距离越大,聚类结果性能越好。 但是随着类 别数搜索范围的变化,CH 指标得到的最佳聚类数 会发生变化,并且随着搜索范围增大,CH 指标得到 的最佳聚类数有逐渐增大的趋势[18] 。 1.2 BWP 指标 BWP 指标是周世兵等人提出的一种基于样本 的几何结构设计的确定聚类类别数的评价指标[16] , 该指标利用聚类结果的类内紧密性和类间分离性 来衡量聚类结果。 指标的最大值对应的类数作为 聚类数。 该指标的判断函数为 BWP(K) = 1 n ∑ K j = 1 ∑ nj i = 1 bwp(i,j) (2) 式中:K 是类别数,bwp(i,j)为 bwp(i,j) = b(i,j) - w(i,j) b(i,j) + w(i,j) 式中:b(i,j)是第 j 类中的第 i 个样本到其他每类中 样本平均距离的最小值,称为最小类间距;w(i,j)是 第 j 类中的第 i 个样本的类内距离。 且 b(i,j) = min 1≤m≤k,m≠j 1 nm ∑ nm p = 1 ‖ x (m) p - x (j) i ‖ æ è ç ö ø ÷ w(i,j) = 1 nj - 1 ∑ nj q = 1,q≠i ‖ x (j) q - x (j) i ‖2 BWP 指标值越大则表示聚类结果的类内越紧 密而类间越远离,聚类结果性能越好。 但是该评价 指标不适合非完全分离的数据集。 1.3 IGP 指标 IGP 指标是 Kapp 提出的评价指标[17] 。 此指标 的设计思想是:当对新的样本进行分类时,新样本 ·68· 智 能 系 统 学 报 第 12 卷

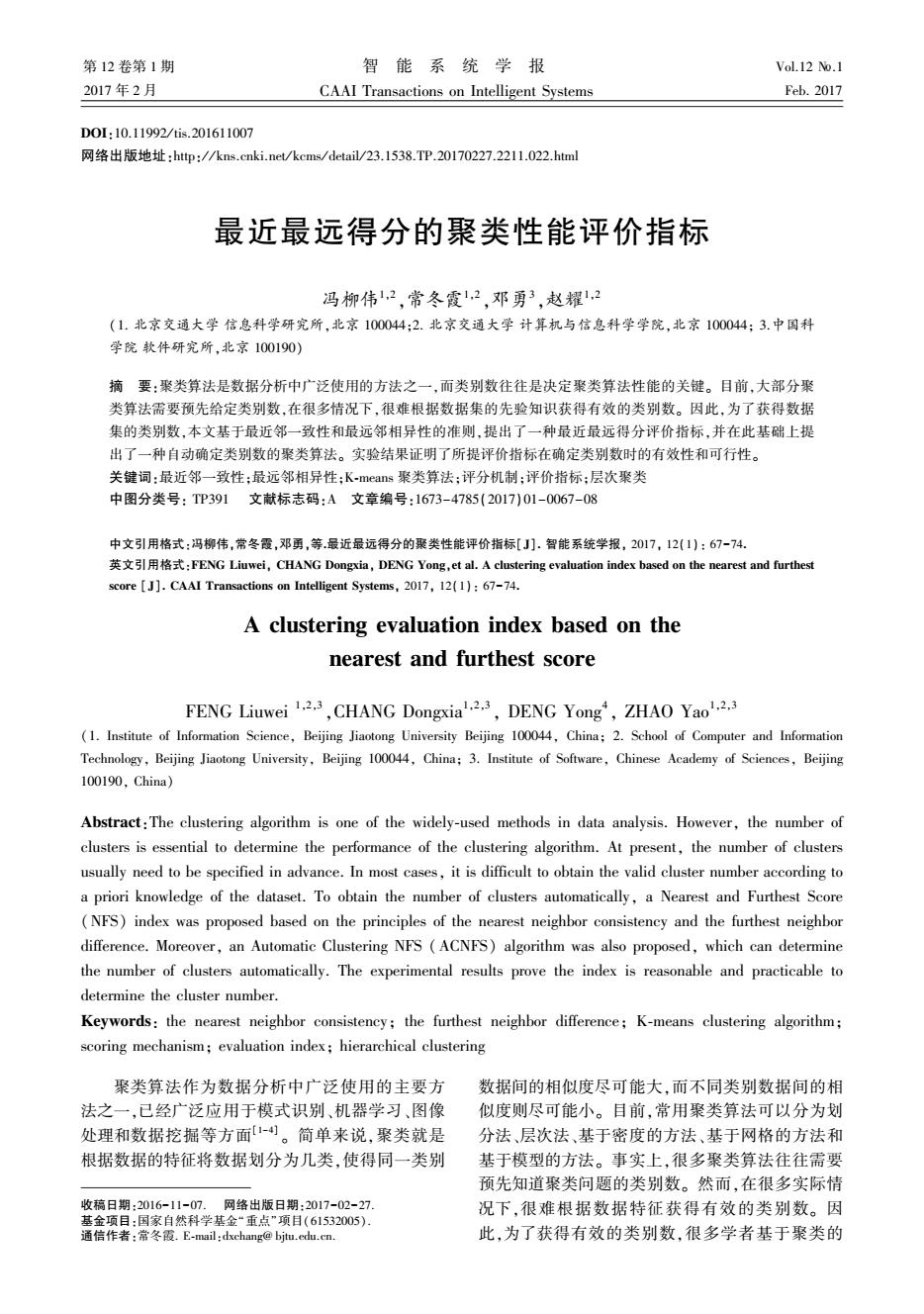

第1期 冯柳伟,等:最近最远得分的聚类性能评价指标 ·69· 应该被划分到与其最相似的样本所在类别。因此 定义4每类的得分。定义cs(G)为第j类的得 该指标使用样本与其最近邻样本划分到同一类的 分,其定义为属于第j类的所有样本的得分的平均 比例来衡量聚类结果的质量。该指标的评价函数为 值,即 IGP(K)= 1 ∑ig鄂(u,X) (3) K 0 式中:K是类别数;g即(u,X)表示数据集X中的第u cs(i)=- (7) 类的指标值, 式中n:为第j类中的样本总数。 ig鄂(u,X)= (jl Classx(j)=Classx(j)=u) 定义5NFS。定义nfs(K)为在类别数为K下 (jl Classx(j)=u) 聚类结果的最近最远得分,定义为所有类得分的平 式中:是距离样本j最近的样本,Classx)表示数 均值,即 据集X中的第j个样本所属的类别。 nfs(K) cs(j) (8) IGP指标的值越大表示样本和其最近邻划分到 同一类的概率越高,聚类结果越好。但是IG指标 式中K是类别数。 只关注了最近邻一致性,使得IG指标值不适合判 2.2NFS指标的分析 断非完全分离的数据集。 NFS指标的设计原则是每个样本应该和距离其 2最近最远得分评价指标 最近的样本划分到同一类别中,而与距离其最远的 样本划分到不同类别中。因此,每个样本拥有两个 为了能准确地得到聚类问题的类别数,本文在 影响评分的因子,分别是最近得分因子和最远得分 基于最近邻一致性和最远邻相异性的原则上,提出 因子。对于最近得分因子,如果某个样本与距离其 了最近最远得分(nearest and furthest score,NFS)评 最近的样本划分到同一类中,则得1分,表示对此聚 价指标。 类结果的支持,而如果划分到不同类中,则得-1分, 2.1相关概念定义 表示对此聚类结果的反对。最远得分因子的规定 X={x1,x2,…,xn}是一个n维矢量空间的有 也是如此。 限子集,K是类别数,C={c1,c2,…,cx}是聚类算法 随着类别数的增加,样本和其最近邻样本被划 所得类别中心集合。 分到不同类别中的概率将会增加,从而导致了最近 定义1最近得分。定义ns(i)是第i个样本的 得分累积和的减少:然而随着类别数的增加,样本 最近得分,第个样本是距离其最近的样本,若样本 和其最远邻样本被划分到同一类的概率将会减少, i与样本j属于同一类别,则第i个样本的最近得分 从而导致了最远得分累积和的增加。因此,在评价 值为1:否则其最近得分值为-1,即 聚类结果时仅采用最近得分或最远得分将很难得 ns(i)= ∫1,sc(i)=sc() 到正确的类别数,需要综合利用这两个得分才能获 1-1,sc(i)≠sc(Gj) (4) 得好的聚类结果。为了说明这个问题,我们将利用 式中:sc(i)代表第i个样本所属的类别,sc()代表 图1所示的数据集在不同类别数下的聚类结果来说 距离样本i最近的样本j所属的类别。 明同时考虑最近得分和最远得分的必要性。观察 定义2最远得分。定义s(i)是第i个样本的 图1所示数据集,可知此数据集的最佳类别数为4。 最远得分,第1个样本是距离其最远的样本,若样本 如果只考虑最近邻得分时,如图1(a)所示,当K=2 i与样本1属于不同类别,则第i个样本的最远得分 时,所有样本和其最近邻样本都在同一类中,而如 值为1,否则其最远得分值-1,即 图1(b)和图1(c)所示,当K=3或K=4时,样本和 fs(i)=(-1,se(i)=se(1) 其最近邻划分到不同类的比率就会增大,聚类结果 \1,sc(i)≠sc(l) (5) 的最近得分值会下降,因此K=2时,使最近得分值 式中:sC(i)代表第i个样本所属的类别;sc(l)代表 达到最大,故采用最近得分准则所得到的最佳类别 距离样本i最远的样本1所属的类别。 数为2。而如果只考虑最远得分时,如图1(a)所 定义3样本得分。定义s(i)是第i个样本的 示,当K=2时,样本和其最远邻样本被划分到同一 得分值,则第i个样本的最近得分和最远得分的平 类的比率很大,而如图1(b)和图1(c)所示,当K=3 均值为第i个样本的得分,即 或K=4时,样本与其最远邻样本划分到同一类的比 s(i)=ns(i)+fs(i) 率下降,而且当K=3时,样本和其最远邻样本分别 (6) 划分到不同类中,此时聚类结果的最远得分值达到

应该被划分到与其最相似的样本所在类别。 因此 该指标使用样本与其最近邻样本划分到同一类的 比例来衡量聚类结果的质量。 该指标的评价函数为 IGP(K) = 1 K∑ K u = 1 igp(u,X) (3) 式中:K 是类别数;igp(u,X)表示数据集 X 中的第 u 类的指标值,且 igp(u,X) = j | ClassX(j) = ClassX(j N { ) = u} j | Class { X(j) = u} 式中:j N 是距离样本 j 最近的样本,ClassX (j) 表示数 据集 X 中的第 j 个样本所属的类别。 IGP 指标的值越大表示样本和其最近邻划分到 同一类的概率越高,聚类结果越好。 但是 IGP 指标 只关注了最近邻一致性,使得 IGP 指标值不适合判 断非完全分离的数据集。 2 最近最远得分评价指标 为了能准确地得到聚类问题的类别数,本文在 基于最近邻一致性和最远邻相异性的原则上,提出 了最近最远得分(nearest and furthest score,NFS)评 价指标。 2.1 相关概念定义 X = x1 ,x2 ,…,xn { } 是一个 n 维矢量空间的有 限子集,K 是类别数,C = c1 ,c2 ,…,cK { } 是聚类算法 所得类别中心集合。 定义 1 最近得分。 定义 ns(i)是第 i 个样本的 最近得分,第 j 个样本是距离其最近的样本,若样本 i 与样本 j 属于同一类别,则第 i 个样本的最近得分 值为 1;否则其最近得分值为-1,即 ns(i) = 1, sc(i) = sc(j) - 1, sc(i) ≠ sc(j) { (4) 式中:sc(i)代表第 i 个样本所属的类别,sc( j)代表 距离样本 i 最近的样本 j 所属的类别。 定义 2 最远得分。 定义 fs(i)是第 i 个样本的 最远得分,第 l 个样本是距离其最远的样本,若样本 i 与样本 l 属于不同类别,则第 i 个样本的最远得分 值为 1,否则其最远得分值-1,即 fs(i) = - 1, sc(i) = sc(l) 1, sc(i) ≠ sc(l) { (5) 式中:sc(i)代表第 i 个样本所属的类别;sc( l)代表 距离样本 i 最远的样本 l 所属的类别。 定义 3 样本得分。 定义 s(i)是第 i 个样本的 得分值,则第 i 个样本的最近得分和最远得分的平 均值为第 i 个样本的得分,即 s(i) = ns(i) + fs(i) 2 (6) 定义 4 每类的得分。 定义 cs(j)为第 j 类的得 分,其定义为属于第 j 类的所有样本的得分的平均 值,即 cs(j) = ∑ nj i = 1 s(i) nj (7) 式中 nj 为第 j 类中的样本总数。 定义 5 NFS。 定义 nfs(K)为在类别数为 K 下 聚类结果的最近最远得分,定义为所有类得分的平 均值,即 nfs(K) = 1 K∑ K j = 1 cs(j) (8) 式中 K 是类别数。 2.2 NFS 指标的分析 NFS 指标的设计原则是每个样本应该和距离其 最近的样本划分到同一类别中,而与距离其最远的 样本划分到不同类别中。 因此,每个样本拥有两个 影响评分的因子,分别是最近得分因子和最远得分 因子。 对于最近得分因子,如果某个样本与距离其 最近的样本划分到同一类中,则得 1 分,表示对此聚 类结果的支持,而如果划分到不同类中,则得-1 分, 表示对此聚类结果的反对。 最远得分因子的规定 也是如此。 随着类别数的增加,样本和其最近邻样本被划 分到不同类别中的概率将会增加,从而导致了最近 得分累积和的减少;然而随着类别数的增加,样本 和其最远邻样本被划分到同一类的概率将会减少, 从而导致了最远得分累积和的增加。 因此,在评价 聚类结果时仅采用最近得分或最远得分将很难得 到正确的类别数,需要综合利用这两个得分才能获 得好的聚类结果。 为了说明这个问题,我们将利用 图 1 所示的数据集在不同类别数下的聚类结果来说 明同时考虑最近得分和最远得分的必要性。 观察 图 1 所示数据集,可知此数据集的最佳类别数为 4。 如果只考虑最近邻得分时,如图 1( a)所示,当 K = 2 时,所有样本和其最近邻样本都在同一类中,而如 图 1(b)和图 1(c)所示,当 K = 3 或 K = 4 时,样本和 其最近邻划分到不同类的比率就会增大,聚类结果 的最近得分值会下降,因此 K = 2 时,使最近得分值 达到最大,故采用最近得分准则所得到的最佳类别 数为 2。 而如果只考虑最远得分时,如图 1 ( a) 所 示,当 K = 2 时,样本和其最远邻样本被划分到同一 类的比率很大,而如图 1(b)和图 1(c)所示,当 K = 3 或K = 4 时,样本与其最远邻样本划分到同一类的比 率下降,而且当 K = 3 时,样本和其最远邻样本分别 划分到不同类中,此时聚类结果的最远得分值达到 第 1 期 冯柳伟,等:最近最远得分的聚类性能评价指标 ·69·

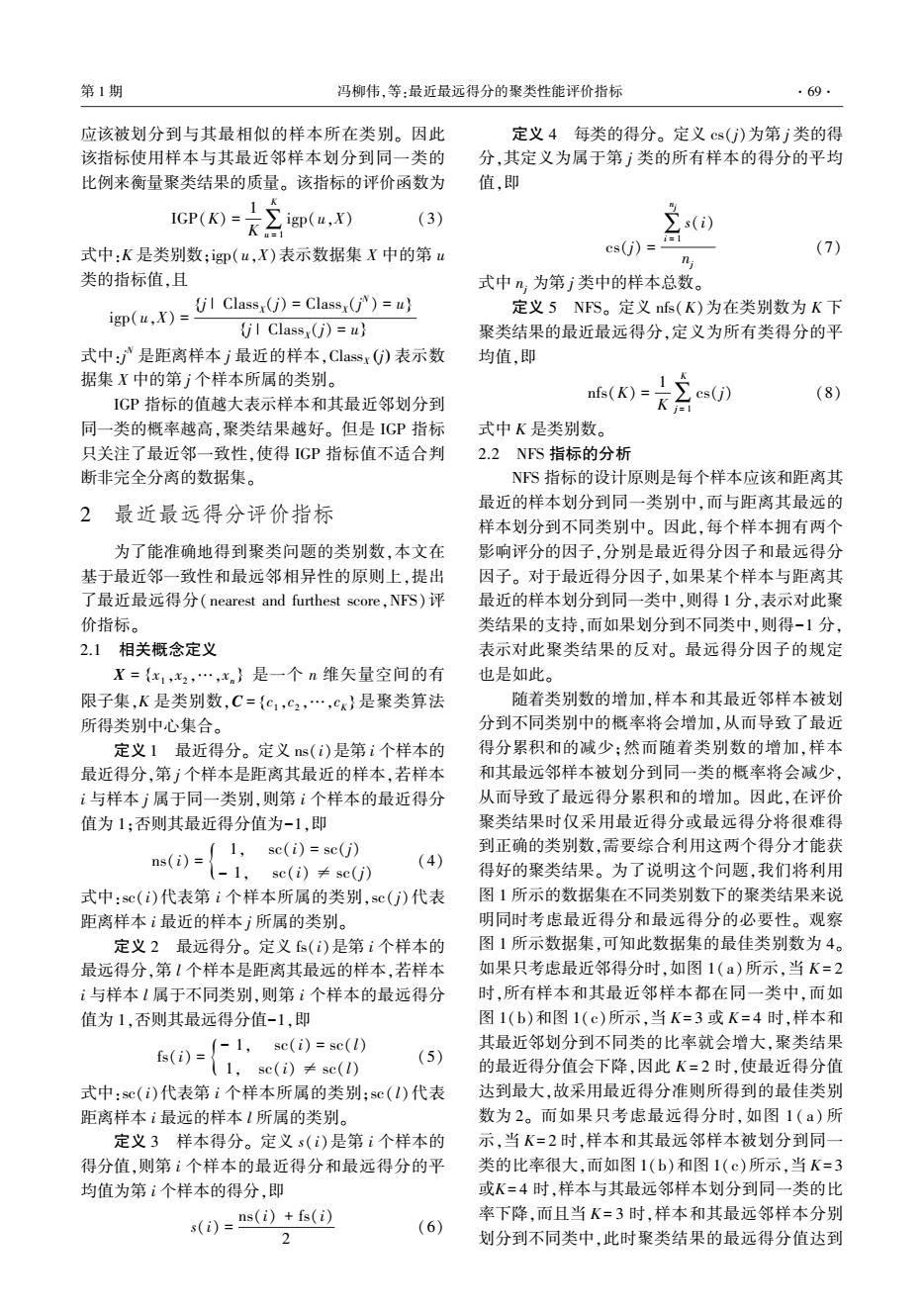

·70 智能系统学报 第12卷 最大,因此,采用最远得分准则所得到的最佳类别 算在不同类别数下的NS评价指标值,第3步是根 数为3。为了选择出正确的类别数,评价指标应该 据评价指标得到使聚类结果达到最好的类别数。 综合考虑最近得分和最远得分这两个因素。基于 该算法具体步骤如下。 以上的理论,在NS评价指标中每个样本的得分设 1)使用基于最短距离的分层聚类算法[]并设 计为最近得分和最远得分的均值。 定合适的截止阈值得到类别数,把该类别数作为搜 索上限K,设置搜索下限K.=2,得到聚类数的搜 索范围[Ka,K]。 2)对于搜索范围[K,K]中不同的聚类数K 分别运行以下步骤: ①利用K-means【2o]算法对数据集进行聚类; ②根据式(4)~(8)计算聚类结果的NFS指 标值; ③根据式(9)得到最佳聚类数Kp。 0 2 ACNFS算法流程如图2所示。 (a)K=2 开始 输出数据 2 得到类别数搜索范围[KnKJ 设置:Kmn2 K-means算法聚类 计算NFS评价指标nfs(K) 0 2 N (b)K=3 Y Kmp-Kianp1 K-maxinfs(》 结束○ 图2 ACNFS算法流程图 Fig.2 The flow chart of ACNFS algorithm 3.2 ACNFS时间复杂度分析 假定数据集有n个样本,则ACNFS算法的时间 (c)K=4 复杂度分析如下。 图1不同聚类数下的聚类 1)ACNFS算法首先采用基于最短距离的分层聚 Fig.1 Clustering under different cluster number 类算法,该算法每次把距离最近的两类合并成一类,其 NS指标值衡量的是样本对聚类结果的满意 时间复杂度为O(tn2),其中t为迭代次数且tn。 度,NS指标值越大聚类结果就越好。因此,依据 2)算法第二步中使用K-means算法进行聚类, NFS选取最佳类别数的公式为 其时间复杂度为O(n),其中l为迭代次数,K为 Ko max (nfs(K)) (9) 2∠K6Km 类别数,且ln,Kgn。 3)采用K-menas聚类之后需要采用NFS评价 3 基于NFS的自动聚类算法 指标对聚类结果进行评估。我们需要计算样本间 3.1 ACNFS算法 的距离从而计算每个样本的最近得分与最远得分, 基于NFS的自动聚类算法(automatic clustering 因此计算NS指标值的时间复杂度为O(n2)。 algorithm based on the NFS,ACNFS)主要包括3个主 为了获得类别数,需要重复K-means和计算NS指 要步骤。第1步确定类别数的搜索范围,第2步计 标值K-K+1次,因此2)和3)的总的时间复杂度为

最大,因此,采用最远得分准则所得到的最佳类别 数为 3。 为了选择出正确的类别数,评价指标应该 综合考虑最近得分和最远得分这两个因素。 基于 以上的理论,在 NFS 评价指标中每个样本的得分设 计为最近得分和最远得分的均值。 (a)K= 2 (b)K= 3 (c)K= 4 图 1 不同聚类数下的聚类 Fig.1 Clustering under different cluster number NFS 指标值衡量的是样本对聚类结果的满意 度,NFS 指标值越大聚类结果就越好。 因此,依据 NFS 选取最佳类别数的公式为 Kopt = max 2≤K≤Kmax {nfs(K)} (9) 3 基于 NFS 的自动聚类算法 3.1 ACNFS 算法 基于 NFS 的自动聚类算法( automatic clustering algorithm based on the NFS,ACNFS)主要包括 3 个主 要步骤。 第 1 步确定类别数的搜索范围,第 2 步计 算在不同类别数下的 NFS 评价指标值,第 3 步是根 据评价指标得到使聚类结果达到最好的类别数。 该算法具体步骤如下。 1)使用基于最短距离的分层聚类算法[19] 并设 定合适的截止阈值得到类别数,把该类别数作为搜 索上限 Kmax,设置搜索下限 Kmin = 2,得到聚类数的搜 索范围 Kmin ,Kmax [ ] 。 2)对于搜索范围 Kmin ,Kmax [ ] 中不同的聚类数 K 分别运行以下步骤: ① 利用 K⁃means [20]算法对数据集进行聚类; ②根据式( 4) ~ ( 8) 计算聚类结果的 NFS 指 标值; ③根据式(9)得到最佳聚类数 Kopt。 ACNFS 算法流程如图 2 所示。 图 2 ACNFS 算法流程图 Fig.2 The flow chart of ACNFS algorithm 3.2 ACNFS 时间复杂度分析 假定数据集有 n 个样本,则 ACNFS 算法的时间 复杂度分析如下。 1)ACNFS 算法首先采用基于最短距离的分层聚 类算法,该算法每次把距离最近的两类合并成一类,其 时间复杂度为 O tn 2 ( ) ,其中 t 为迭代次数且t≪n。 2)算法第二步中使用 K⁃means 算法进行聚类, 其时间复杂度为 O( nKl),其中 l 为迭代次数,K 为 类别数,且 l≪n,K≪n。 3)采用 K⁃menas 聚类之后需要采用 NFS 评价 指标对聚类结果进行评估。 我们需要计算样本间 的距离从而计算每个样本的最近得分与最远得分, 因此计算 NFS 指标值的时间复杂度为 O n 2 ( ) 。 为了获得类别数,需要重复 K⁃means 和计算 NFS 指 标值 Kmax -Kmin +1 次,因此 2)和 3)的总的时间复杂度为 ·70· 智 能 系 统 学 报 第 12 卷

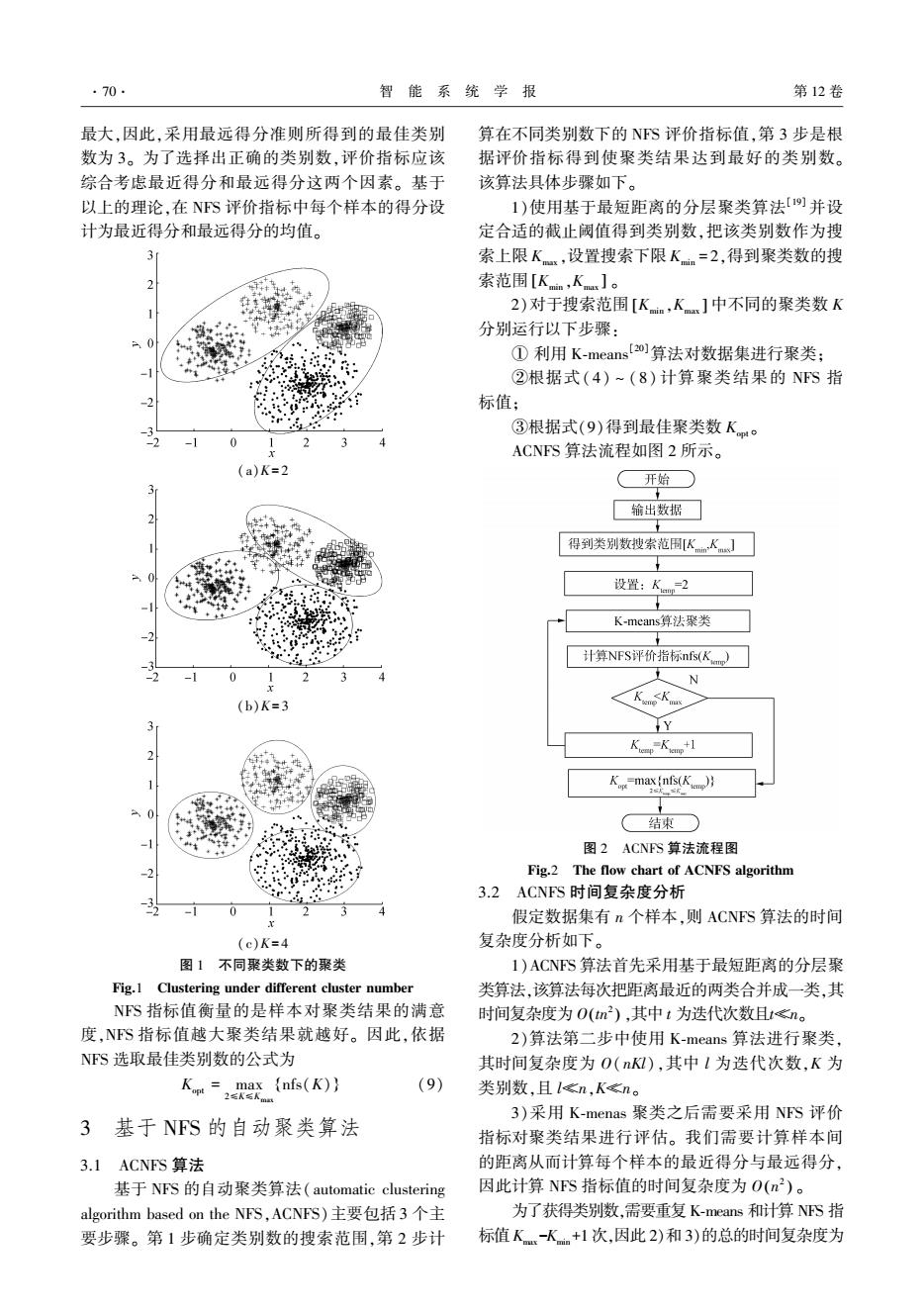

第1期 冯柳伟,等:最近最远得分的聚类性能评价指标 ·71 O(n2+nll)×(K-Kn+1),且(K-K+1)n。 因此,ACNFS算法总的时间复杂度即 为0(tm2+(n2+nkl)×(Kx-Kia))。 4 实验 为了验证本文所提NFS指标和ACNFS算法的 有效性,我们进行了仿真实验。在实验中我们将采 用6个人工数据集和4个UCI真实数据,对CH指 标、BWP指标,IGP指标和NFS指标确定类别数的 2 0 性能进行比较。实验证明,基于NS指标所提出的 (d)Dataset 4 ACNFS算法可以有效地确定数据集的类别数,实现 2.0 1.5 类别中心和类别数的自动估计。 1.0 在仿真实验中,我们所采用的人工数据集如图 0.5 3所示,而真实数据集则为UCI数据库中的IRIS 0 Balance Scale,Wine以及Soybean-small数据集。为 -0.5 了方便,我们将上述所有数据集的特征总结到表1 -1.0 -1.5 中,其中n表示数据集中样本点的个数,K表示数据 -2.0 集中样本点的类别数,d表示数据集中样本点的特 -2.5 征维数,最后一列表示各类别中样本点的个数。 -2.0-1.5-1.0-0.500.51.01.52.02.5 10 (e)Dataset 5 8 6 4 0 0 6 8 10 (a)Dataset 1 2.5r -2.0-1.5-1.0-0.500.51.01.52.02.5 2.0 。h (f)Dataset 6 图3人工数据集 +料 1.0 有 Fig.3 Artificial dataset 0.5 表1 实验中所使用的10组数据集特征 0 Table 1 The characters of the ten data sets used in -0.5 our experiments -10 数据集 n K d 每类中样本点的个数 -1.0 -0.5 0 0.5 1.0 1.5 2.0 Dataset 1 800 2 2 400.400 (b)Dataset 2 Dataset 2 800 3 2 400.200.200 Dataset 3 800 3 2 400.200.200 15 Dataset 4 1 100 4 200,400,200 Dataset 5 1 000 5 2 400.200.200.300 Dataset 6 900 6 200.200,200.200,200 Iris 150 3 4 150.150.150.150.150.150 Balance Scale 630 3 4 50,50,50 -10 1015 Wine 178 3 13 54.288.288 -10 -5 0 5 Sovbean-small 47 435 59,71,48 (c)Dataset 3

O((n 2+nkl)×(Kmax -Kmin +1)),且(Kmax -Kmin +1)≪n。 因 此, ACNFS 算 法 总 的 时 间 复 杂 度 即 为O tn 2+(n 2+nkl)×(Kmax ( -Kmin ) ) 。 4 实验 为了验证本文所提 NFS 指标和 ACNFS 算法的 有效性,我们进行了仿真实验。 在实验中我们将采 用 6 个人工数据集和 4 个 UCI 真实数据,对 CH 指 标、BWP 指标、IGP 指标和 NFS 指标确定类别数的 性能进行比较。 实验证明,基于 NFS 指标所提出的 ACNFS 算法可以有效地确定数据集的类别数,实现 类别中心和类别数的自动估计。 在仿真实验中,我们所采用的人工数据集如图 3 所示,而真实数据集则为 UCI 数据库中的 IRIS, Balance Scale,Wine 以及 Soybean⁃small 数据集。 为 了方便,我们将上述所有数据集的特征总结到表 1 中,其中 n 表示数据集中样本点的个数,K 表示数据 集中样本点的类别数,d 表示数据集中样本点的特 征维数,最后一列表示各类别中样本点的个数。 (a)Dataset 1 (b)Dataset 2 (c)Dataset 3 (d)Dataset 4 (e)Dataset 5 (f)Dataset 6 图 3 人工数据集 Fig.3 Artificial dataset 表 1 实验中所使用的 10 组数据集特征 Table 1 The characters of the ten data sets used in our experiments 数据集 n K d 每类中样本点的个数 Dataset 1 800 2 2 400,400 Dataset 2 800 3 2 400,200,200 Dataset 3 800 3 2 400,200,200 Dataset 4 1 100 4 2 200,400,200 Dataset 5 1 000 5 2 400,200,200,300 Dataset 6 900 6 2 200,200,200,200,200 Iris 150 3 4 150,150,150,150,150,150 Balance Scale 630 3 4 50,50,50 Wine 178 3 13 54,288,288 Soybean⁃small 47 4 35 59,71,48 第 1 期 冯柳伟,等:最近最远得分的聚类性能评价指标 ·71·

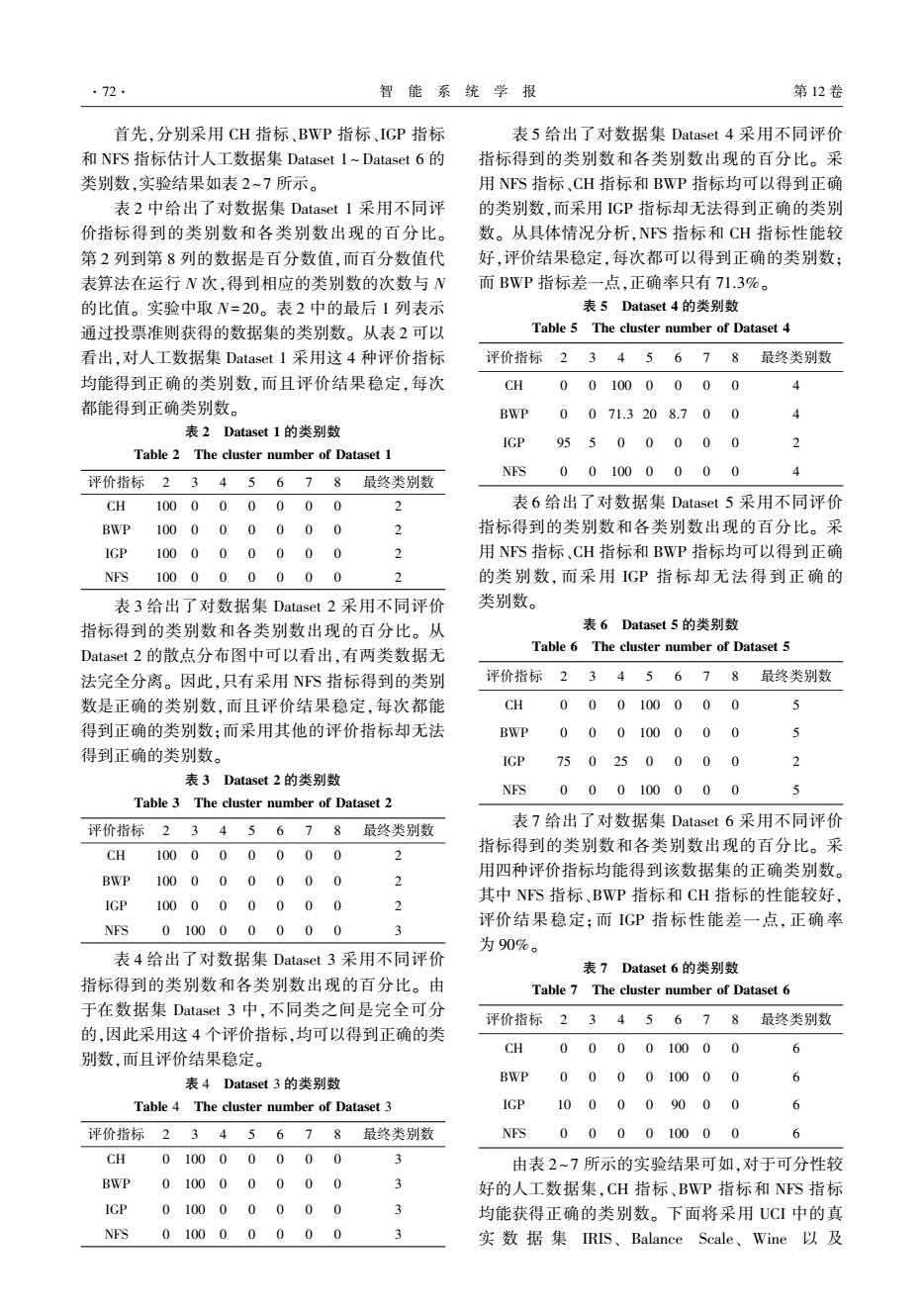

·72 智能系统学报 第12卷 首先,分别采用CH指标、BWP指标,IGP指标 表5给出了对数据集Dataset4采用不同评价 和NFS指标估计人工数据集Dataset 1~Dataset6的 指标得到的类别数和各类别数出现的百分比。采 类别数,实验结果如表2~7所示。 用NFS指标、CH指标和BWP指标均可以得到正确 表2中给出了对数据集Dataset1采用不同评 的类别数,而采用IGP指标却无法得到正确的类别 价指标得到的类别数和各类别数出现的百分比。 数。从具体情况分析,NFS指标和CH指标性能较 第2列到第8列的数据是百分数值,而百分数值代 好,评价结果稳定,每次都可以得到正确的类别数: 表算法在运行N次,得到相应的类别数的次数与N 而BWP指标差一点,正确率只有71.3%。 的比值。实验中取N=20。表2中的最后1列表示 表5 Dataset4的类别数 通过投票准则获得的数据集的类别数。从表2可以 Table 5 The cluster number of Dataset 4 看出,对人工数据集Dataset1采用这4种评价指标 评价指标23456.78 最终类别数 均能得到正确的类别数,而且评价结果稳定,每次 CH 001000000 4 都能得到正确类别数。 BWP 0071.3208.700 4 表2 Dataset1的类别数 IGP 95500000 2 Table 2 The cluster number of Dataset 1 NFS 001000000 评价指标2345678 最终类别数 CH100000000 表6给出了对数据集Dataset5采用不同评价 BWP10000000 0 2 指标得到的类别数和各类别数出现的百分比。采 1GP100000000 用NFS指标、CH指标和BWP指标均可以得到正确 NFS100000000 2 的类别数,而采用IGP指标却无法得到正确的 表3给出了对数据集Dataset2采用不同评价 类别数。 指标得到的类别数和各类别数出现的百分比。从 表6 Dataset5的类别数 Dataset2的散点分布图中可以看出,有两类数据无 Table 6 The cluster number of Dataset 5 法完全分离。因此,只有采用NFS指标得到的类别 评价指标2345678 最终类别数 数是正确的类别数,而且评价结果稳定,每次都能 CH 00.0100000 5 得到正确的类别数;而采用其他的评价指标却无法 BWP 00 01000 0 0 5 得到正确的类别数。 IGP 750250000 2 表3 Dataset2的类别数 NFS000100000 Table 3 The cluster number of Dataset 2 评价指标23 45678 最终类别数 表7给出了对数据集Dataset6采用不同评价 CH100000000 指标得到的类别数和各类别数出现的百分比。采 用四种评价指标均能得到该数据集的正确类别数。 BWP100000000 IGP100000000 其中NFS指标、BWP指标和CH指标的性能较好, 评价结果稳定;而IGP指标性能差一点,正确率 NFS010000000 3 为90%。 表4给出了对数据集Dataset3采用不同评价 表7 Dataset6的类别数 指标得到的类别数和各类别数出现的百分比。由 Table 7 The cluster number of Dataset 6 于在数据集Dataset3中,不同类之间是完全可分 评价指标2345678最终类别数 的,因此采用这4个评价指标,均可以得到正确的类 CH 000010000 别数,而且评价结果稳定。 6 表4 Dataset3的类别数 BWP 00 001000 0 6 Table 4 The cluster number of Dataset 3 IGP 100009000 6 评价指标2345678最终类别数 NFS 000010000 6 CH 01000000 0 3 由表2~7所示的实验结果可如,对于可分性较 BWP 010000000 3 好的人工数据集,CH指标、BWP指标和NFS指标 IGP 010000000 3 均能获得正确的类别数。下面将采用UCI中的真 NFS010000000 3 实数据集IRIS、Balance Scale、Wine以及

首先,分别采用 CH 指标、BWP 指标、IGP 指标 和 NFS 指标估计人工数据集 Dataset 1 ~ Dataset 6 的 类别数,实验结果如表 2~7 所示。 表 2 中给出了对数据集 Dataset 1 采用不同评 价指标得到的类别数和各类别数出现的百分比。 第 2 列到第 8 列的数据是百分数值,而百分数值代 表算法在运行 N 次,得到相应的类别数的次数与 N 的比值。 实验中取 N= 20。 表 2 中的最后 1 列表示 通过投票准则获得的数据集的类别数。 从表 2 可以 看出,对人工数据集 Dataset 1 采用这 4 种评价指标 均能得到正确的类别数,而且评价结果稳定,每次 都能得到正确类别数。 表 2 Dataset 1 的类别数 Table 2 The cluster number of Dataset 1 评价指标 2 3 4 5 6 7 8 最终类别数 CH 100 0 0 0 0 0 0 2 BWP 100 0 0 0 0 0 0 2 IGP 100 0 0 0 0 0 0 2 NFS 100 0 0 0 0 0 0 2 表 3 给出了对数据集 Dataset 2 采用不同评价 指标得到的类别数和各类别数出现的百分比。 从 Dataset 2 的散点分布图中可以看出,有两类数据无 法完全分离。 因此,只有采用 NFS 指标得到的类别 数是正确的类别数,而且评价结果稳定,每次都能 得到正确的类别数;而采用其他的评价指标却无法 得到正确的类别数。 表 3 Dataset 2 的类别数 Table 3 The cluster number of Dataset 2 评价指标 2 3 4 5 6 7 8 最终类别数 CH 100 0 0 0 0 0 0 2 BWP 100 0 0 0 0 0 0 2 IGP 100 0 0 0 0 0 0 2 NFS 0 100 0 0 0 0 0 3 表 4 给出了对数据集 Dataset 3 采用不同评价 指标得到的类别数和各类别数出现的百分比。 由 于在数据集 Dataset 3 中,不同类之间是完全可分 的,因此采用这 4 个评价指标,均可以得到正确的类 别数,而且评价结果稳定。 表 4 Dataset 3 的类别数 Table 4 The cluster number of Dataset 3 评价指标 2 3 4 5 6 7 8 最终类别数 CH 0 100 0 0 0 0 0 3 BWP 0 100 0 0 0 0 0 3 IGP 0 100 0 0 0 0 0 3 NFS 0 100 0 0 0 0 0 3 表 5 给出了对数据集 Dataset 4 采用不同评价 指标得到的类别数和各类别数出现的百分比。 采 用 NFS 指标、CH 指标和 BWP 指标均可以得到正确 的类别数,而采用 IGP 指标却无法得到正确的类别 数。 从具体情况分析,NFS 指标和 CH 指标性能较 好,评价结果稳定,每次都可以得到正确的类别数; 而 BWP 指标差一点,正确率只有 71.3%。 表 5 Dataset 4 的类别数 Table 5 The cluster number of Dataset 4 评价指标 2 3 4 5 6 7 8 最终类别数 CH 0 0 100 0 0 0 0 4 BWP 0 0 71.3 20 8.7 0 0 4 IGP 95 5 0 0 0 0 0 2 NFS 0 0 100 0 0 0 0 4 表 6 给出了对数据集 Dataset 5 采用不同评价 指标得到的类别数和各类别数出现的百分比。 采 用 NFS 指标、CH 指标和 BWP 指标均可以得到正确 的类别数, 而采用 IGP 指标却无法得 到 正 确 的 类别数。 表 6 Dataset 5 的类别数 Table 6 The cluster number of Dataset 5 评价指标 2 3 4 5 6 7 8 最终类别数 CH 0 0 0 100 0 0 0 5 BWP 0 0 0 100 0 0 0 5 IGP 75 0 25 0 0 0 0 2 NFS 0 0 0 100 0 0 0 5 表 7 给出了对数据集 Dataset 6 采用不同评价 指标得到的类别数和各类别数出现的百分比。 采 用四种评价指标均能得到该数据集的正确类别数。 其中 NFS 指标、BWP 指标和 CH 指标的性能较好, 评价结果稳定;而 IGP 指标性能差一点,正确率 为 90%。 表 7 Dataset 6 的类别数 Table 7 The cluster number of Dataset 6 评价指标 2 3 4 5 6 7 8 最终类别数 CH 0 0 0 0 100 0 0 6 BWP 0 0 0 0 100 0 0 6 IGP 10 0 0 0 90 0 0 6 NFS 0 0 0 0 100 0 0 6 由表 2 ~ 7 所示的实验结果可如,对于可分性较 好的人工数据集,CH 指标、BWP 指标和 NFS 指标 均能获得正确的类别数。 下面将采用 UCI 中的真 实 数 据 集 IRIS、 Balance Scale、 Wine 以 及 ·72· 智 能 系 统 学 报 第 12 卷

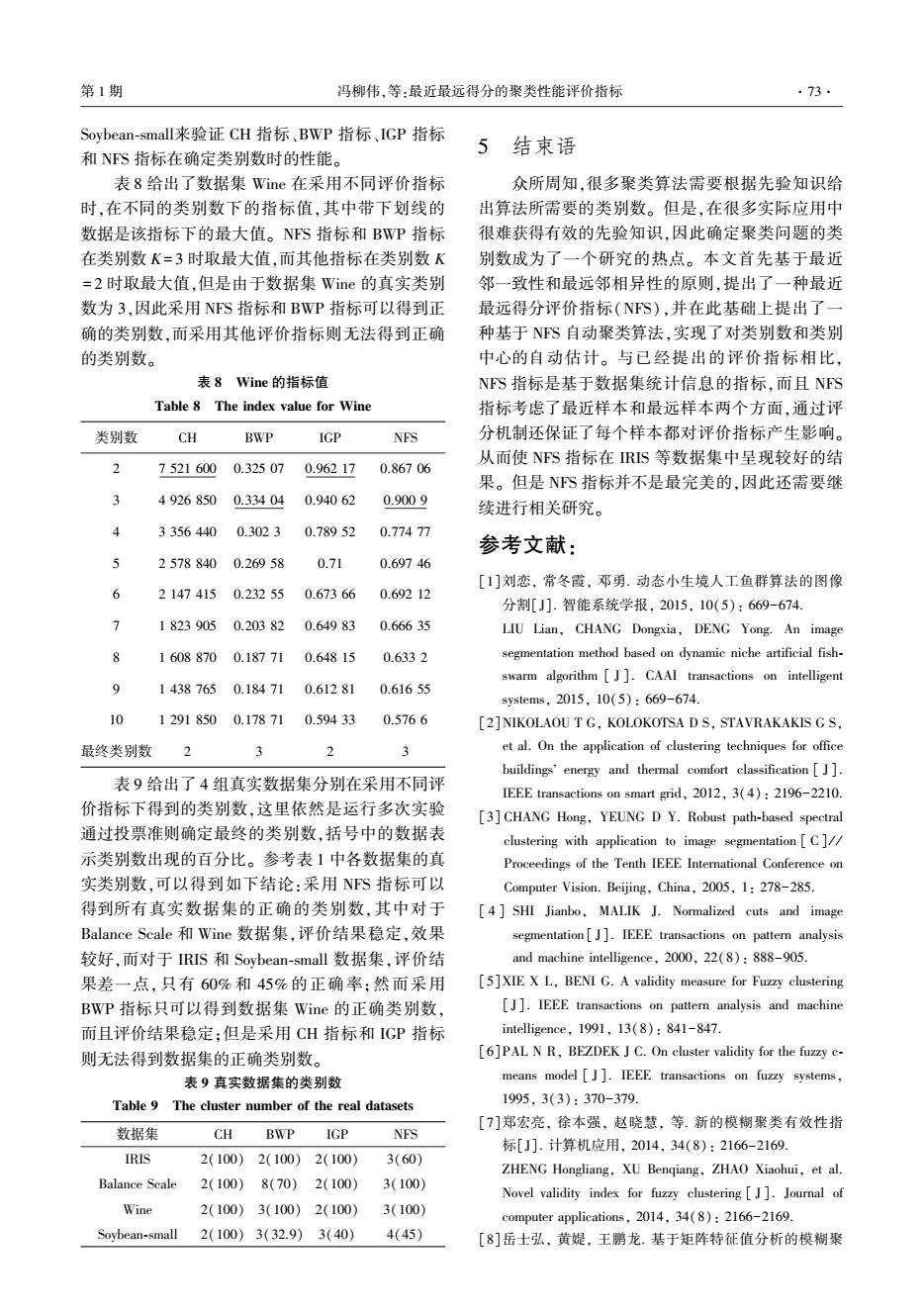

第1期 冯柳伟,等:最近最远得分的聚类性能评价指标 ·73· Soybean-small来验证CH指标、BWP指标、IGP指标 5 结束语 和NFS指标在确定类别数时的性能。 表8给出了数据集Wine在采用不同评价指标 众所周知,很多聚类算法需要根据先验知识给 时,在不同的类别数下的指标值,其中带下划线的 出算法所需要的类别数。但是,在很多实际应用中 数据是该指标下的最大值。NFS指标和BWP指标 很难获得有效的先验知识,因此确定聚类问题的类 在类别数K=3时取最大值,而其他指标在类别数K 别数成为了一个研究的热点。本文首先基于最近 =2时取最大值,但是由于数据集Wime的真实类别 邻一致性和最远邻相异性的原则,提出了一种最近 数为3,因此采用NFS指标和BWP指标可以得到正 最远得分评价指标(NFS),并在此基础上提出了一 确的类别数,而采用其他评价指标则无法得到正确 种基于NS自动聚类算法,实现了对类别数和类别 的类别数。 中心的自动估计。与已经提出的评价指标相比, 表81 Wine的指标值 NFS指标是基于数据集统计信息的指标,而且NFS Table 8 The index value for Wine 指标考虑了最近样本和最远样本两个方面,通过评 类别数 CH BWP IGP NFS 分机制还保证了每个样本都对评价指标产生影响。 从而使NFS指标在RIS等数据集中呈现较好的结 2 7521600 0.32507 0.96217 0.86706 果。但是NFS指标并不是最完美的,因此还需要继 49268500.33404 0.94062 0.9009 续进行相关研究。 33564400.3023 0.78952 0.77477 参考文献: 25788400.26958 0.71 0.69746 [1]刘恋,常冬霞,邓勇.动态小生境人工鱼群算法的图像 6 21474150.23255 0.67366 0.69212 分割[J].智能系统学报,2015,10(5):669-674. > 18239050.20382 0.64983 0.66635 LIU Lian,CHANG Dongxia,DENG Yong.An image 16088700.18771 0.64815 0.6332 segmentation method based on dynamic niche artificial fish- swarm algorithm J].CAAI transactions on intelligent 14387650.18471 0.61281 0.61655 systems,2015,10(5):669-674. 12918500.178710.59433 0.5766 [2]NIKOLAOU T G.KOLOKOTSA DS,STAVRAKAKIS G S. 最终类别数 2 et al.On the application of clustering techniques for office buildings'energy and thermal comfort classification [J]. 表9给出了4组真实数据集分别在采用不同评 IEEE transactions on smart grid,2012,3(4):2196-2210. 价指标下得到的类别数,这里依然是运行多次实验 [3]CHANG Hong,YEUNG D Y.Robust path-based spectral 通过投票准则确定最终的类别数,括号中的数据表 clustering with application to image segmentation [C]/ 示类别数出现的百分比。参考表1中各数据集的真 Proceedings of the Tenth IEEE International Conference on 实类别数,可以得到如下结论:采用NS指标可以 Computer Vision.Beijing,China,2005,1:278-285. 得到所有真实数据集的正确的类别数,其中对于 [4]SHI Jianbo,MALIK J.Normalized cuts and image Balance Scale和Wine数据集,评价结果稳定,效果 segmentation[J].IEEE transactions on pattern analysis 较好,而对于IRIS和Soybean-small数据集,评价结 and machine intelligence,2000,22(8):888-905. 果差一点,只有60%和45%的正确率:然而采用 [5]XIE X L,BENI G.A validity measure for Fuzzy clustering BWP指标只可以得到数据集Wine的正确类别数, [J].IEEE transactions on pattern analysis and machine 而且评价结果稳定:但是采用CH指标和IGP指标 intelligence,1991,13(8):841-847 则无法得到数据集的正确类别数。 [6]PAL N R.BEZDEK J C.On cluster validity for the fuzzy c- 表9真实数据集的类别数 means model J].IEEE transactions on fuzzy systems, Table 9 The cluster number of the real datasets 1995,3(3):370-379. [7]郑宏亮,徐本强,赵晓慧,等.新的模糊聚类有效性指 数据集 CH BWP IGP NFS 标[J].计算机应用,2014.34(8):2166-2169 IRIS 2(100)2(100) 2(100) 3(60) ZHENG Hongliang,XU Benqiang,ZHAO Xiaohui,et al. Balance Scale 2(100)8(70)2(100) 3(100) Novel validity index for fuzzy clustering J].Journal of Wine 2(100)3(100)2(100) 3(100) computer applications,2014,34(8):2166-2169. Soybean-small 2(100)3(32.9)3(40) 4(45) [8]岳士弘,黄妮,王鹏龙.基于矩阵特征值分析的模糊聚

Soybean⁃small来验证 CH 指标、BWP 指标、IGP 指标 和 NFS 指标在确定类别数时的性能。 表 8 给出了数据集 Wine 在采用不同评价指标 时,在不同的类别数下的指标值,其中带下划线的 数据是该指标下的最大值。 NFS 指标和 BWP 指标 在类别数 K = 3 时取最大值,而其他指标在类别数 K = 2 时取最大值,但是由于数据集 Wine 的真实类别 数为 3,因此采用 NFS 指标和 BWP 指标可以得到正 确的类别数,而采用其他评价指标则无法得到正确 的类别数。 表 8 Wine 的指标值 Table 8 The index value for Wine 类别数 CH BWP IGP NFS 2 7 521 600 0.325 07 0.962 17 0.867 06 3 4 926 850 0.334 04 0.940 62 0.900 9 4 3 356 440 0.302 3 0.789 52 0.774 77 5 2 578 840 0.269 58 0.71 0.697 46 6 2 147 415 0.232 55 0.673 66 0.692 12 7 1 823 905 0.203 82 0.649 83 0.666 35 8 1 608 870 0.187 71 0.648 15 0.633 2 9 1 438 765 0.184 71 0.612 81 0.616 55 10 1 291 850 0.178 71 0.594 33 0.576 6 最终类别数 2 3 2 3 表 9 给出了 4 组真实数据集分别在采用不同评 价指标下得到的类别数,这里依然是运行多次实验 通过投票准则确定最终的类别数,括号中的数据表 示类别数出现的百分比。 参考表 1 中各数据集的真 实类别数,可以得到如下结论:采用 NFS 指标可以 得到所有真实数据集的正确的类别数,其中对于 Balance Scale 和 Wine 数据集,评价结果稳定,效果 较好,而对于 IRIS 和 Soybean⁃small 数据集,评价结 果差一点,只有 60% 和 45% 的正确率;然而采用 BWP 指标只可以得到数据集 Wine 的正确类别数, 而且评价结果稳定;但是采用 CH 指标和 IGP 指标 则无法得到数据集的正确类别数。 表 9 真实数据集的类别数 Table 9 The cluster number of the real datasets 数据集 CH BWP IGP NFS IRIS 2(100) 2(100) 2(100) 3(60) Balance Scale 2(100) 8(70) 2(100) 3(100) Wine 2(100) 3(100) 2(100) 3(100) Soybean⁃small 2(100) 3(32.9) 3(40) 4(45) 5 结束语 众所周知,很多聚类算法需要根据先验知识给 出算法所需要的类别数。 但是,在很多实际应用中 很难获得有效的先验知识,因此确定聚类问题的类 别数成为了一个研究的热点。 本文首先基于最近 邻一致性和最远邻相异性的原则,提出了一种最近 最远得分评价指标(NFS),并在此基础上提出了一 种基于 NFS 自动聚类算法,实现了对类别数和类别 中心的自动估计。 与已经提出的评价指标相比, NFS 指标是基于数据集统计信息的指标,而且 NFS 指标考虑了最近样本和最远样本两个方面,通过评 分机制还保证了每个样本都对评价指标产生影响。 从而使 NFS 指标在 IRIS 等数据集中呈现较好的结 果。 但是 NFS 指标并不是最完美的,因此还需要继 续进行相关研究。 参考文献: [1]刘恋, 常冬霞, 邓勇. 动态小生境人工鱼群算法的图像 分割[J]. 智能系统学报, 2015, 10(5): 669-674. LIU Lian, CHANG Dongxia, DENG Yong. An image segmentation method based on dynamic niche artificial fish⁃ swarm algorithm [ J ]. CAAI transactions on intelligent systems, 2015, 10(5): 669-674. [2]NIKOLAOU T G, KOLOKOTSA D S, STAVRAKAKIS G S, et al. On the application of clustering techniques for office buildings energy and thermal comfort classification [ J ]. IEEE transactions on smart grid, 2012, 3(4): 2196-2210. [3] CHANG Hong, YEUNG D Y. Robust path⁃based spectral clustering with application to image segmentation [ C] / / Proceedings of the Tenth IEEE International Conference on Computer Vision. Beijing, China, 2005, 1: 278-285. [ 4 ] SHI Jianbo, MALIK J. Normalized cuts and image segmentation [ J]. IEEE transactions on pattern analysis and machine intelligence, 2000, 22(8): 888-905. [5]XIE X L, BENI G. A validity measure for Fuzzy clustering [ J]. IEEE transactions on pattern analysis and machine intelligence, 1991, 13(8): 841-847. [6]PAL N R, BEZDEK J C. On cluster validity for the fuzzy c⁃ means model [ J ]. IEEE transactions on fuzzy systems, 1995, 3(3): 370-379. [7]郑宏亮, 徐本强, 赵晓慧, 等. 新的模糊聚类有效性指 标[J]. 计算机应用, 2014, 34(8): 2166-2169. ZHENG Hongliang, XU Benqiang, ZHAO Xiaohui, et al. Novel validity index for fuzzy clustering [ J ]. Journal of computer applications, 2014, 34(8): 2166-2169. [8]岳士弘, 黄媞, 王鹏龙. 基于矩阵特征值分析的模糊聚 第 1 期 冯柳伟,等:最近最远得分的聚类性能评价指标 ·73·

·74 智能系统学报 第12卷 类有效性指标[J].天津大学学报:自然科学与工程技 ZHOU Shibing,XU Zhenyuan,TANG Xuqing.Method for 术版,2014,47(8):689-696. determining optimal number of clusters in K-means YUE Shihong,HUANG Ti,WANG Penglong.Matrix clustering algorithm[J].Journal of computer applications, eigenvalue analysis-based clustering validity index[J]. 2010,30(8):1995-1998. Journal of Tianjin university:science and technology,2014, [17]KAPP A V,TIBSHIRANI R.Are clusters found in one 47(8):689-696. dataset present in another dataset[].Biostatistics,2007, [9]卿铭,孙晓梅.一种新的聚类有效性函数:模糊划分的 8(1):9-31 模糊嫡[J].智能系统学报,2015,10(1):75-80. [18]周世兵.聚类分析中的最佳聚类数确定方法研究及应 QING Mei,SUN Xiaomei.A new clustering effectiveness 用[D].无锡:江南大学,2011. function:fuzzy entropy of fuzzy partition [J].CAAI ZHOU Shibing.Research and application on determining transactions on intelligent systems,2015,10(1):75-80. optimal number of cluster in cluster analysis[D].Wuxi: [10]王开军,李健,张军英,等.聚类分析中类数估计方法 Jiangnan University,2011. 的实验比较[J].计算机工程,2008,34(9):198- [19]Gower J C,Ross G J S.Minimum spanning trees and 199.202. single linkage cluster analysis [J].Journal of the royal WANG Kaijun,LI Jian,ZHANG Junying,et al. statistical society,1969.18(1):54-64. Experimental comparison of clusters number estimation for [20 MACQUEEN J.Some methods for classification and cluster analysis[J].Computer engineering,2008,34(9): analysis of multivariate observations[C]//Proceedings of 198-199,202. the 5th Berkeley Symposium on Mathematical Statistics [ll]王勇,唐靖,饶勤菲,等.高效率的K-means最佳聚类 and Probability.Berkeley,USA,1967:281-297 数确定算法[J].计算机应用,2014,34(5): 作者简介: 1331-1335 冯柳伟,女,1992年生,硕士研究 WANG Yong,TANG Jing,RAO Qinfei,et al.High 生,研究方向为聚类算法。 efficient K-means algorithm for determining optimal number of clusters[J].Journal of computer applications,2014,34 (5):1331-1335 [12]CALINSKI T,HARABASZ J.A dendrite method for cluster analysis [J].Communications in statistics,1974,3 (1):1-27 常冬霞,女,1977年生.副教授,硕 [13]DAVIES D L.BOULDIN D W.A cluster separation 士生导师,主要研究方向为进化计算、 measure[J].IEEE transactions on pattern analysis and 非监督分类算法、图像分割以及图像分 machine intelligence,1979,PAMI-1(2):224-227. 类。发表学术论文10余篇,其中SC检 [14]DIMITRIADOU E,DOLNICAR S,WEINGESSEL A.An 索5篇,El检索2篇。 examination of indexes for determining the number of clusters in binary data sets[J].Psychometrika,2002,67 (1):137-159. 邓勇,男,1974年生,副研究员,博 [15]KRZANOWSKI W J,LAI Y T.A criterion for determining 士,主要研究方向为智能信息处理、数 the number of groups in a data set using sum-of-squares 据库系统技术及应用等。主持和参与 clustering[J].Biometrics,1988,44(1):23-34. 国家“863”计划1项,北京市自然科学 [16]周世兵,徐振源,唐旭清.K-means算法最佳聚类数确 基金项目1项。发表学术论文20余 定方法[J】.计算机应用,2010,30(8):1995-1998 篇,其中收录10余篇

类有效性指标[ J]. 天津大学学报: 自然科学与工程技 术版, 2014, 47(8): 689-696. YUE Shihong, HUANG Ti, WANG Penglong. Matrix eigenvalue analysis - based clustering validity index [ J ]. Journal of Tianjin university: science and technology, 2014, 47(8): 689-696. [9]卿铭, 孙晓梅. 一种新的聚类有效性函数: 模糊划分的 模糊熵[J]. 智能系统学报, 2015, 10(1): 75-80. QING Mei, SUN Xiaomei. A new clustering effectiveness function: fuzzy entropy of fuzzy partition [ J ]. CAAI transactions on intelligent systems, 2015, 10(1): 75-80. [10]王开军, 李健, 张军英, 等. 聚类分析中类数估计方法 的实验比较[ J]. 计算机工程, 2008, 34 ( 9): 198 - 199, 202. WANG Kaijun, LI Jian, ZHANG Junying, et al. Experimental comparison of clusters number estimation for cluster analysis[J]. Computer engineering, 2008, 34(9): 198-199, 202. [11]王勇, 唐靖, 饶勤菲, 等. 高效率的 K-means 最佳聚类 数确 定 算 法 [ J ]. 计 算 机 应 用, 2014, 34 ( 5 ): 1331-1335. WANG Yong, TANG Jing, RAO Qinfei, et al. High efficient K⁃means algorithm for determining optimal number of clusters[J]. Journal of computer applications, 2014, 34 (5): 1331-1335. [12]CALIN ' SKI T, HARABASZ J. A dendrite method for cluster analysis [ J ]. Communications in statistics, 1974, 3 (1): 1-27. [ 13 ] DAVIES D L, BOULDIN D W. A cluster separation measure[ J]. IEEE transactions on pattern analysis and machine intelligence, 1979, PAMI-1(2): 224-227. [14]DIMITRIADOU E, DOLNIC ˇ AR S, WEINGESSEL A. An examination of indexes for determining the number of clusters in binary data sets[ J]. Psychometrika, 2002, 67 (1): 137-159. [15]KRZANOWSKI W J, LAI Y T. A criterion for determining the number of groups in a data set using sum⁃of⁃squares clustering[J]. Biometrics, 1988, 44(1): 23-34. [16]周世兵, 徐振源, 唐旭清. K⁃means 算法最佳聚类数确 定方法[J]. 计算机应用, 2010, 30(8): 1995-1998. ZHOU Shibing, XU Zhenyuan, TANG Xuqing. Method for determining optimal number of clusters in K⁃means clustering algorithm[ J]. Journal of computer applications, 2010, 30(8): 1995-1998. [17] KAPP A V, TIBSHIRANI R. Are clusters found in one dataset present in another dataset[J]. Biostatistics, 2007, 8(1): 9-31. [18]周世兵. 聚类分析中的最佳聚类数确定方法研究及应 用[D]. 无锡: 江南大学, 2011. ZHOU Shibing. Research and application on determining optimal number of cluster in cluster analysis[D]. Wuxi: Jiangnan University, 2011. [19] Gower J C, Ross G J S. Minimum spanning trees and single linkage cluster analysis [ J]. Journal of the royal statistical society, 1969, 18(1):54-64. [ 20 ] MACQUEEN J. Some methods for classification and analysis of multivariate observations[C] / / Proceedings of the 5th Berkeley Symposium on Mathematical Statistics and Probability. Berkeley, USA, 1967: 281-297. 作者简介: 冯柳伟,女,1992 年生,硕士研究 生,研究方向为聚类算法。 常冬霞,女,1977 年生,副教授,硕 士生导师,主要研究方向为进化计算、 非监督分类算法、图像分割以及图像分 类。 发表学术论文 10 余篇,其中 SCI 检 索 5 篇,EI 检索 2 篇。 邓勇,男,1974 年生,副研究员,博 士,主要研究方向为智能信息处理、数 据库系统技术及应用等。 主持和参与 国家“863”计划 1 项,北京市自然科学 基金项目 1 项。 发表学术论文 20 余 篇,其中收录 10 余篇。 ·74· 智 能 系 统 学 报 第 12 卷