第12卷第3期 智能系统学报 Vol.12 No.3 2017年6月 CAAI Transactions on Intelligent Systems Jun.2017 D0I:10.11992/tis.201704032 网络出版地址:http:/kns.cmki.net/kcms/detail/23.1538.TP.20170703.1854.016.html 连续型数据的辨识矩阵属性约简方法 冯丹1,2,黄洋2,石云鹏2,王长忠2 (1.国网葫芦岛供电公司信息道信分公司,辽宁葫芦岛125000:2.渤海大学数理学院,辽宁锦州121000) 摘要:属性约简是粗糙集理论在数据处理方面的重要应用,已有的针对连续型数据的属性约简算法主要集中在基 于正域的贪心算法,该方法只考虑了一致样本和其他样本的可辨识性,而忽略了边界样本点间可区分性。为了克服 基于正域算法的缺点,提出了连续型数据的辨识矩阵属性约简模型,该模型不但考虑了正域样本的一致性,同时考 虑了边界样本的可分性。基于该模型,分析了属性约简结构,定义了辨识矩阵来刻画特征子集的分类能力,构造了 实值型数据的属性约简启发式算法,并利用UCI标准数据集进行了验证。理论分析和实验结果表明,提出的算法能 够有效地处理连续型数据,提高了数据的分类精度。 关键词:邻域关系;粗糙集;属性约简:辨识矩阵:启发式算法 中图分类号:TP391:TP274文献标志码:A文章编号:1673-4785(2017)03-0371-06 中文引用格式:冯丹,黄洋,石云鹏,等.连续型数据的辨识矩阵属性约简方法[J].智能系统学报,2017,12(3):371-376. 英文引用格式:FENG Dan,HUANG Yang,SHI Yunpeng,etal.A discernibility matri-based attribute reduction for continuous data[J].CAAI transactions on intelligent systems,2017,12(3):371-376. A discernibility matrix-based attribute reduction for continuous data FENG Dan'2,HUANG Yang',SHI Yunpeng',Wang Changzhong? (1.Information and Communication Branch,State Grid Power Supply Company of Huludao,Huludao 125000,China;2.College of Mathematics and Physics,Bohai University,Jinzhou 121000,China) Abstract:In data processing,attribute reduction is an important application of rough set theory.The existing methods for continuous data mainly concentrate on the greedy algorithms based on the positive region.These methods take account of only the identifiability between consistent samples and other samples while ignoring distinguishability among the boundary samples.To overcome the disadvantage based on the positive domain algorithm,this paper proposed a new method for attribute reduction using a discernibility matrix.The model considers not only the consistency of samples in the positive region but also the reparability of boundary samples.On this basis,this paper analyzes the structure of attribute reduction and defines a discernibility matrix to characterize the discernibility ability of a subset of attributes.Next,an attribute reduction algorithm was designed based on the discernibility matrix.The validity of the proposed algorithm was verified using UCI standard data sets and theoretical analysis. Keywords:neighborhood relation;rough set;attribute reduction;discernibility matrix;heuristic algorithm 粗糙集理论是由波兰数学家Z.Pawlak于 础。其主要思想是在确保信息表的分类能力不变 1982年提出的,它是一种处理不确定性知识的数据 的情况下,删除掉不必要属性,保留必要属性,从而 分析理论。目前粗糙集理论已被广泛应用于人工 导出问题的分类规则。属性约简无疑是在获取规 智能、过程控制、数据挖掘、决策支持以及知识发现 则的过程中最重要的核心问题,历来受到大家的 等领域。属性约简是粗糙集理论的研究内容之一, 关注。 它是利用粗糙集进行数据挖掘、规则抽取的理论基 传统的粗糙集理论[1)是基于等价关系来描述 的,由等价关系粒化样本空间形成信息粒子,构造 收稿日期:2017-04-23.网络出版日期:2017-07-03. 论域上的上、下近似算子,进而研究知识约简与知 基金项目:国家自然科学基金项目(61572082,61673396,61473111 61363056):辽宁省教育厅项目(LZ2016003):辽宁省自然科 识获取问题。但是经典粗糙集只适用于离散型的 学基金项目(2014020142):辽宁省高校创新团队计划项目 数据,对于连续型数据,必须通过离散化才能处理。 (LT2014024). 通信作者:王长忠.E-mail:changzhongwang@126.com. 然而,数据的离散化会导致大量信息丢失,从而使

第 12 卷第 3 期 智 能 系 统 学 报 Vol.12 №.3 2017 年 6 月 CAAI Transactions on Intelligent Systems Jun. 2017 DOI:10.11992 / tis.201704032 网络出版地址:http: / / kns.cnki.net / kcms/ detail / 23.1538.TP.20170703.1854.016.html 连续型数据的辨识矩阵属性约简方法 冯丹1, 2 ,黄洋2 ,石云鹏2 ,王长忠2 (1. 国网葫芦岛供电公司 信息通信分公司,辽宁 葫芦岛 125000; 2. 渤海大学 数理学院,辽宁 锦州 121000) 摘 要:属性约简是粗糙集理论在数据处理方面的重要应用,已有的针对连续型数据的属性约简算法主要集中在基 于正域的贪心算法, 该方法只考虑了一致样本和其他样本的可辨识性,而忽略了边界样本点间可区分性。 为了克服 基于正域算法的缺点,提出了连续型数据的辨识矩阵属性约简模型,该模型不但考虑了正域样本的一致性,同时考 虑了边界样本的可分性。 基于该模型,分析了属性约简结构,定义了辨识矩阵来刻画特征子集的分类能力,构造了 实值型数据的属性约简启发式算法,并利用 UCI 标准数据集进行了验证。 理论分析和实验结果表明,提出的算法能 够有效地处理连续型数据,提高了数据的分类精度。 关键词:邻域关系;粗糙集;属性约简;辨识矩阵;启发式算法 中图分类号:TP391;TP274 文献标志码:A 文章编号:1673-4785(2017)03-0371-06 中文引用格式:冯丹,黄洋,石云鹏,等.连续型数据的辨识矩阵属性约简方法[J]. 智能系统学报, 2017, 12(3): 371-376. 英文引用格式:FENG Dan, HUANG Yang, SHI Yunpeng, et al. A discernibility matrix⁃based attribute reduction for continuous data[J]. CAAI transactions on intelligent systems, 2017, 12(3): 371-376. A discernibility matrix⁃based attribute reduction for continuous data FENG Dan 1,2 , HUANG Yang 2 , SHI Yunpeng 2 , Wang Changzhong 2 (1. Information and Communication Branch, State Grid Power Supply Company of Huludao, Huludao 125000, China; 2. College of Mathematics and Physics, Bohai University, Jinzhou 121000, China) Abstract:In data processing, attribute reduction is an important application of rough set theory. The existing methods for continuous data mainly concentrate on the greedy algorithms based on the positive region. These methods take account of only the identifiability between consistent samples and other samples while ignoring distinguishability among the boundary samples. To overcome the disadvantage based on the positive domain algorithm, this paper proposed a new method for attribute reduction using a discernibility matrix. The model considers not only the consistency of samples in the positive region but also the reparability of boundary samples. On this basis, this paper analyzes the structure of attribute reduction and defines a discernibility matrix to characterize the discernibility ability of a subset of attributes. Next, an attribute reduction algorithm was designed based on the discernibility matrix. The validity of the proposed algorithm was verified using UCI standard data sets and theoretical analysis. Keywords: neighborhood relation; rough set; attribute reduction; discernibility matrix; heuristic algorithm 收稿日期:2017-04-23. 网络出版日期:2017-07-03. 基金项目:国家自然科学基金项目( 61572082, 61673396, 61473111, 61363056);辽宁省教育厅项目(LZ2016003);辽宁省自然科 学基金项目( 2014020142);辽宁省高校创新团队计划项目 (LT2014024). 通信作者:王长忠.E⁃mail:changzhongwang@ 126.com. 粗糙集理论是由波兰数学家 Z. Pawlak [1] 于 1982 年提出的,它是一种处理不确定性知识的数据 分析理论。 目前粗糙集理论已被广泛应用于人工 智能、过程控制、数据挖掘、决策支持以及知识发现 等领域。 属性约简是粗糙集理论的研究内容之一, 它是利用粗糙集进行数据挖掘、规则抽取的理论基 础。 其主要思想是在确保信息表的分类能力不变 的情况下,删除掉不必要属性,保留必要属性,从而 导出问题的分类规则。 属性约简无疑是在获取规 则的过程中最重要的核心问题,历来受到大家的 关注。 传统的粗糙集理论[1-3] 是基于等价关系来描述 的, 由等价关系粒化样本空间形成信息粒子, 构造 论域上的上、下近似算子, 进而研究知识约简与知 识获取问题。 但是经典粗糙集只适用于离散型的 数据,对于连续型数据,必须通过离散化才能处理。 然而,数据的离散化会导致大量信息丢失,从而使

·372 智能系统学报 第12卷 计算的结果不能准确地反映分类信息。为此,经典 [x:]D=x;EUld(x;)=d(x) 粗糙集理论被进行了多角度的推广,其中包括邻域 则称M。为U上的决策等价关系,[x:]。为x:的关 粗糙集模型4-川、优势粗糙集模型-)、覆盖粗糙 于M。的决策等价类。称(U,A,F,D)为基于邻域关 集模型[14-6]、模糊粗糙集模型[7-2]等。邻域粗糙 系的决策信息表,简称邻域决策表。若MCM。,则 集模型是重要的推广模型之一,基于此模型,许多 称(U,A,F,D)是协调的,否则,称它是不协调的。 学者研究了不同的依赖度函数,并设计了相应的属 U上的所有决策等价类构成了U的一个划分,记 性约简算法[4-山)。例如,Hus)利用邻域的概念定义 为U/D={[x:]ox:∈U。 了样本空间的决策正域,构造了邻域依赖度函数来 同理,决策等价关系M。可以用关系矩阵N。来 刻画属性的分类能力,用于处理混合数据的属性约 表示。即对于任意x:,x∈U,如果x∈[x:]。,那么 简:Zhao)根据数据精度设计了一个自适应性的邻 记N,(i,j)=1,否则记N(i,)=0。 域粗糙集模型,并给出了基于该模型的代价敏感属 设(U,A,F,D)为决策表,U/D={X,X2,…, 性约简算法:Chen[】利用邻域粗糙集模型和信息测 X,}为决策划分,BCA,对于任意X:∈U/D,定义X 度为肿瘤分类进行特征选择:Zu)对邻域粗糙集 的下近似为B(X)={x:∈U:6g(x:)≤X},D关于 模型的边界进行分布优化,从而为粒度的选取和组 B的正域定义为POSg(D)=U=1B(X)。显然, 合提供了新方法。然而,邻域粗糙集模型中的决策 POSg(D)SPOS,(D)。 正域只考虑了一致性样本与其他样本的可辨识性, 设a:∈BCA,如果POSg(D)=POSg-a(D),则 忽略了边界样本的可分性。因此,基于正域的依赖 称a:相对于D是B中不必要的属性;否则,称a:是 度函数不能正确地刻画一个属性子集的分类能力。 B中必要的属性。如果POS(D)=POS,(D)且B中 为了克服基于正域算法的缺点,本文提出了基于辨 每一个属性相对于D都是B中必要的,则称B是A 识矩阵的属性约简算法。该算法克服了依赖度算 的一个属性约简。 法的局限性。 定理1设(U,A,F,D={d})为决策表,BCA, 1 邻域关系决策表的属性约简 则POSe(D)=POS,(D)的充要条件是:对于任意 x,∈0,如果满足以下条件之一,即 设(U,A,F)为信息表,其中,U={x1,x2,…,xn} 1)x:∈POS,(D),x年POS(D)Ad(x)≠d(x); 为样本集合,A={a1,a2,…,am}是属性集合,F={f: 2)x:,xeP0S(D)Λ[x:]∩[x]o=☑: j≤m}为U和A的关系集,f:U→V,j≤m,V,为属性 则有x,生8(x:)=xδ(x:)。 a的值域。 证明充分性证明。设Hx:,x∈U,如果x:∈ 定义1 设U={x1,x2,…,xn}为样本集, POS4(D)和x生POS4(D)且d(x:)≠d(x),则3 BCA,令 X。∈U/D使得x,∈A(X。)以及xX,于是8,(x:)C M={(x:x)∈U×U:lf(x)-f(x)≤e,Ha∈B} X。,从而x8(x:)。由于POS(D)=POS4(D),所 则称M。为U上的邻域关系,称(U,A,F)为基于邻 以对于任意X∈U/D,都有B(X,)=A(X:),当然也 域关系的信息系统,简称邻域信息表,ε表示相似度 有A(X。)=B(X)。由x:∈A(X),可得x:∈B(X),于 阈值。对于任意x,∈U,令 是6(x)CX。,因此x8(x:)o δ(x:)={x∈U:(x:,x)∈Mg} 如果x,E POS(D)且[x:]n∩[x]n=☑,则 则称δ(x:)为x:关于Ms的邻域。 存在X。和X,∈U/D使得X。≠X1且满足x:∈A(X。) 邻域关系可以用一个关系矩阵来表示。设属 以及x生X。由x:∈A(X,)可得6,(x:)二X。,从而 性a1∈A,对于任意x:,x∈U,如果x∈8,(x:),那么 xδ:(x:)。类似地,由于POSB(D)=POS,(D),所 记N,(i,)=1,否则记N,(i,j)=0。因此,一个属性 以A(X)=B(X)。由x:∈A(X。),可得x:∈ a,唯一地对应一个关系矩阵N,。而属性集合A的 B(X。)。从而8s(x)CX。,因此x生8B(x:)。 关系矩阵可以由公式N,=∩4,计算。 必要性证明。设x:∈POS,(D),所以存在X。∈ 定义2设(U,A,F,D={d})为决策表,其中 U/D使得8,(x:)CX。对于满足x年POS.(D)且 (U,A,F)为信息表,A={a1,a2,…am},D为决策属 d(x:)≠d(x)的任意x∈U,有x年X。,因此x 性。对于任意x∈U,令 6,(x)。由于x年84(x)→x8(x:),所以8(x:) M。={(x:,x)∈U×Ud(x:)=d(x) X,从而x:∈POSB(D)。于是POS,(D)CPOS(D)

计算的结果不能准确地反映分类信息。 为此,经典 粗糙集理论被进行了多角度的推广,其中包括邻域 粗糙集模型[4-11] 、优势粗糙集模型[12-13] 、覆盖粗糙 集模型[14-16] 、模糊粗糙集模型[17-22] 等。 邻域粗糙 集模型是重要的推广模型之一,基于此模型,许多 学者研究了不同的依赖度函数,并设计了相应的属 性约简算法[4-11] 。 例如,Hu [5]利用邻域的概念定义 了样本空间的决策正域,构造了邻域依赖度函数来 刻画属性的分类能力,用于处理混合数据的属性约 简;Zhao [7] 根据数据精度设计了一个自适应性的邻 域粗糙集模型,并给出了基于该模型的代价敏感属 性约简算法;Chen [8]利用邻域粗糙集模型和信息测 度为肿瘤分类进行特征选择;Zhu [9] 对邻域粗糙集 模型的边界进行分布优化,从而为粒度的选取和组 合提供了新方法。 然而,邻域粗糙集模型中的决策 正域只考虑了一致性样本与其他样本的可辨识性, 忽略了边界样本的可分性。 因此,基于正域的依赖 度函数不能正确地刻画一个属性子集的分类能力。 为了克服基于正域算法的缺点,本文提出了基于辨 识矩阵的属性约简算法。 该算法克服了依赖度算 法的局限性。 1 邻域关系决策表的属性约简 设(U,A,F)为信息表,其中,U = {x1 ,x2 ,…,xn } 为样本集合,A = {a1 ,a2 ,…,am }是属性集合,F = {f j: j≤m}为 U 和 A 的关系集,f j:U→Vj,j≤m,Vj 为属性 aj 的值域。 定义 1 设 U = { x1 , x2 , …, xn } 为 样 本 集, B⊆A,令 MB = {(xi,xj) ∈U × U: f a(xi) - f a(xj) ≤ε,∀a ∈B} 则称 MB 为 U 上的邻域关系,称(U,A,F)为基于邻 域关系的信息系统,简称邻域信息表,ε 表示相似度 阈值。 对于任意 xi∈U,令 δB(xi) = {xj ∈ U:(xi,xj) ∈ MB } 则称 δB(xi)为 xi 关于 MB 的邻域。 邻域关系可以用一个关系矩阵来表示。 设属 性 al∈A,对于任意 xi,xj∈U,如果 xj∈δal (xi),那么 记 Nl(i,j)= 1,否则记 Nl(i,j)= 0。 因此,一个属性 al 唯一地对应一个关系矩阵 Nl。 而属性集合 A 的 关系矩阵可以由公式 NA =∩al∈ANl 计算。 定义 2 设(U,A,F,D = { d})为决策表,其中 (U,A,F)为信息表,A = {a1 ,a2 ,…am },D 为决策属 性。 对于任意 x∈U,令 MD = (xi,xj) ∈ U × U d(xi) = d(x { j)} [xi] D = {xj ∈ U d(xi) = d(xj)} 则称 MD 为 U 上的决策等价关系, xi [ ] D 为 xi 的关 于 MD 的决策等价类。 称(U,A,F,D)为基于邻域关 系的决策信息表,简称邻域决策表。 若 MA⊆MD,则 称(U,A,F,D) 是协调的,否则,称它是不协调的。 U 上的所有决策等价类构成了 U 的一个划分,记 为U/ D= xi [ ] D x { i∈U} 。 同理,决策等价关系 MD 可以用关系矩阵 ND 来 表示。 即对于任意 xi,xj∈U,如果 xj∈[xi] D,那么 记 ND(i,j)= 1,否则记 ND(i,j)= 0。 设(U,A,F,D) 为决策表,U/ D = { X1 ,X2 ,…, Xr}为决策划分,B⊆A,对于任意 Xk∈U/ D,定义 Xk 的下近似为 B(Xk ) = { xi ∈U:δB ( xi ) ⊆X},D 关于 B 的正域定义为 POSB ( D) = ∪r k = 1 B ( Xk )。 显然, POSB(D)⊆POSA(D)。 设 ai∈B⊆A,如果 POSB(D)= POSB-{ai } (D),则 称 ai 相对于 D 是 B 中不必要的属性;否则,称 ai 是 B 中必要的属性。 如果 POSB(D)= POSA(D)且 B 中 每一个属性相对于 D 都是 B 中必要的,则称 B 是 A 的一个属性约简。 定理 1 设(U,A,F,D= {d})为决策表,B⊆A, 则 POSB(D) = POSA (D) 的充要条件是: 对于任意 xi,xj∈U,如果满足以下条件之一,即 1)xi∈POSA(D),xj∉POSA(D)∧d(xi)≠d(xj); 2)xi,xj∈POSA(D)∧[xi] D∩[xj] D =∅; 则有 xj∉δA(xi)⇒xj∉δB(xi)。 证明 充分性证明。 设∀xi,xj∈U,如果 xi ∈ POSA(D) 和xj∉POSA (D) 且 d ( xi ) ≠d ( xj ),则∃ X0∈U/ D使得 xi∈A(X0 )以及 xj∉X0 ,于是 δA(xi)⊆ X0 ,从而 xj∉δA(xi)。 由于 POSB(D)= POSA(D),所 以对于任意Xk∈U/ D,都有 B(Xk)= A(Xk),当然也 有 A(X0 )= B(X0)。 由 xi∈A(X0),可得 xi∈B(X0 ),于 是 δB(xi)⊆X0,因此 xj∉δB(xi)。 如果 xi,xj∈POSA (D) 且[xi] D∩[xj] D = ∅,则 存在 X0 和 X1∈U/ D 使得 X0≠X1 且满足 xi∈A(X0 ) 以及 xj∉X0 。 由 xi∈A(X0 )可得 δA( xi ) ⊆X0 ,从而 xj∉δA(xi)。 类似地,由于 POSB(D) = POSA(D),所 以 A ( X0 ) = B ( X0 )。 由 xi ∈ A ( X0 ), 可 得 xi ∈ B(X0 )。 从而 δB(xi)⊆X0 ,因此 xj∉δB(xi)。 必要性证明。 设 xi∈POSA(D),所以存在 X0∈ U/ D 使得 δA( xi ) ⊆X0 。 对于满足 xj ∉POSA (D) 且 d(xi)≠d( xj ) 的任意 xj ∈U,有 xj ∉X0 ,因此 xj ∉ δA(xi)。 由于 xj∉δA(xi)⇒xj∉δB(xi),所以 δB(xi)⊆ X0,从而 xi∈POSB(D)。 于是 POSA(D)⊆POSB(D), ·372· 智 能 系 统 学 报 第 12 卷

第3期 冯丹,等:连续型数据的辨识矩阵属性约简方法 ·373· 而POSg(D)CPOS,(D)显然成立,因此POSB(D)= 表1病例决策信息表 P0S,(D)。 Table 1 Decision information for cases 另设x,x∈POS4(D)且[x:]。∩[x]。=☑,则 序号 a 存在X,X,∈U/D(X。≠X)使得8(x:)≤X。=[x:]D 0.66 0.45 0.20 0.82 和8(x)CX1=[x]0。由于x4(x:)→x X2 0.47 0.30 0.06 0.65 1 6(x:),所以6(x:)CX。,从而x:∈POSg(D)。于是 X3 0.05 0.80 0.40 0.10 2 POS(D)CPOS(D),而POSB(D)CPOS,(D)是显 0.35 0.51 0.00 0.52 2 然成立的,因此POS(D)=POS4(D)。综上所述,结 0.31 0.20 0.15 0.70 论成立。 根据定理1可以定义如下的辨识矩阵。 0.00 1.00 0.20 0.00 2 定义3设(U,A,F,D={d})为决策表,U= 取£=0.25,根据定义1和定义2,计算关系矩阵 {x1,x2,…,xn},A={a1,a2,am},令 N,(i≤4)、N,以及决策关系矩阵N。分别为 DIS =(x,)x;EPOS,(D),;POS,(D)A 110000 110110 111111 d(x:)≠d(x)}U{(x,x)lx,x∈ 110110 110110 110111 P0S,(D)A[x:]。∩[x]。= 001001 001001 101011 N,= ,N3= 则称DIS为决策表(U,A,F,D)的可辨识域。对于 010110 ,N2= 110100 110111 任意的样本对(x:,x)eDIS,记 010110 110010 111111 {a∈A:年δn(x:)},(x:,x)∈DIS 001001 001001] 111111 DM(i,j)= 110010 110000 110010 (A,(x,x)生DIS 110110 110110 110010 则称DM(i,j)为x,x的辩识集合,称DM为基于 001001 001001 001101 邻域关系的辨识矩阵。 N .NA= ,N= 010110 010100 001101 定理2设DM为决策表(U,A,F,D={d})的 110110 010010 110010 辨识矩阵,B二A,则B是决策表的一个约简的充要 001001 001001 001101」 条件是:B满足B∩DM(i,j)≠☑,Hx:,x∈U的最 说明N4¢N。由以上计算知,POS(D)={x1,x, 小子集。 x5,x6}。根据定义3,得到辨识矩阵如表2所示。 定理2说明通过辨识矩阵可以等价地刻画决策 表2病例决策信息表的辨识矩阵 表的属性约简。下面给出决策表的属性约简的辨 Table 2 Discernibility matrix of case decisions 识公式。通过析取和合取运算可以获得决策表的 序号 X2 全部约简。 a1,a2,a4a1,a4 1,a2,a4 定义4设DM为决策表(U,A,F,D)的辨识 矩阵,U={x1,x2,…,xn},辨识函数定义为 A y A f(U,A,F,D)=A (V DM(i,j)) x3 a1,a2,d4 A A a1,2,a4 A i.i=1 定理3设f(U,A,F,D)为决策表(U,A,F,D) A A A 的辨识函数,如果通过析取和合取运算,有 A A a1,a2,a4 a1,a2,a4 f(U,A,F,D)=V (A B) x6a1,a2,a4a1,a2,a4 A A a,a,aa A k=1 式中:B,CA,且B中每个属性只能出现一次。则称 所以,可得决策表的辨识函数为 {B:k≤}是A的所有约简组成的集类。 f=(a Va)A(a VaVa)Aa2= A的所有约简组成的集类记为RED,(A)={B: (a1∧a2)V(a2Aa4) k≤}。 因此{a1,a2}和{a2,a4}是病例决策表的两个 下面通过一个具体的实例来说明应用辨识矩 约简。 阵方法如何求解邻域决策表的属性约简。 2属性约简算法 例1表1是具有4种症状a1、a2、a3、a4的某 些病例信息,具体描述如表1所示。 经典粗糙集算法是以等价关系作为聚类标准

而 POSB(D)⊆POSA(D)显然成立,因此 POSB(D)= POSA(D)。 另设 xi,xj∈POSA (D) 且[xi] D∩[xj] D = ∅,则 存在 X0 ,X1∈U/ D X0≠X1 ( ) 使得 δA(xi)⊆X0 = [xi] D 和 δA ( xj ) ⊆ X1 = [xj] D。 由于 xj ∉ δA ( xi ) ⇒ xj ∉ δB(xi),所以 δB(xi)⊆X0 ,从而 xi∈POSB(D)。 于是 POSA(D) ⊆POSB(D),而 POSB(D)⊆POSA(D)是显 然成立的,因此 POSB(D)= POSA(D)。 综上所述,结 论成立。 根据定理 1 可以定义如下的辨识矩阵。 定义 3 设(U,A,F,D = { d}) 为决策表,U = {x1 ,x2 ,…,xn },A = {a1 ,a2 ,…am },令 DIS = {(xi,xj) xi ∈POSA(D),xj ∉ POSA(D) ∧ d(xi) ≠ d(xj)} ∪ {(xi,xj) xi,xj ∈ POSA(D) ∧ [xi] D ∩ [xj] D = ∅} 则称 DIS 为决策表(U,A,F,D) 的可辨识域。 对于 任意的样本对(xi,xj)∈DIS,记 DM(i, j) = {al ∈ A:xj ∉ δal (xi)}, (xi,xj) ∈ DIS A, (xi,xj) ∉ DIS { 则称 DM(i, j)为 xi,xj 的辩识集合,称 DM 为基于 邻域关系的辨识矩阵。 定理 2 设 DM 为决策表(U,A,F,D = {d})的 辨识矩阵,B⊆A,则 B 是决策表的一个约简的充要 条件是:B 满足 B∩DM(i,j)≠∅,∀xi,xj∈U 的最 小子集。 定理 2 说明通过辨识矩阵可以等价地刻画决策 表的属性约简。 下面给出决策表的属性约简的辨 识公式。 通过析取和合取运算可以获得决策表的 全部约简。 定义 4 设 DM 为决策表(U,A,F,D) 的辨识 矩阵,U= {x1 ,x2 ,…,xn },辨识函数定义为 f(U,A,F,D) = ∧ n i,j = 1 (∨ DM(i,j)) 定理 3 设 f(U,A,F,D)为决策表(U,A,F,D) 的辨识函数,如果通过析取和合取运算,有 f(U,A,F,D) =∨ l k = 1 (∧ Bk) 式中:Bk⊆A,且 Bk 中每个属性只能出现一次。 则称 {Bk:k≤l}是 A 的所有约简组成的集类。 A 的所有约简组成的集类记为REDD(A)= {Bk: k≤l}。 下面通过一个具体的实例来说明应用辨识矩 阵方法如何求解邻域决策表的属性约简。 例 1 表 1 是具有 4 种症状 a1 、a2 、a3 、a4 的某 些病例信息,具体描述如表 1 所示。 表 1 病例决策信息表 Table 1 Decision information for cases 序号 a1 a2 a3 a4 D x1 0.66 0.45 0.20 0.82 1 x2 0.47 0.30 0.06 0.65 1 x3 0.05 0.80 0.40 0.10 2 x4 0.35 0.51 0.00 0.52 2 x5 0.31 0.20 0.15 0.70 1 x6 0.00 1.00 0.20 0.00 2 取 ε = 0.25,根据定义 1 和定义 2,计算关系矩阵 Nl(i≤4)、NA 以及决策关系矩阵 ND 分别为 N1 = 110000 110110 001001 010110 010110 001001 é ë ê ê ê ê ê ê ê ê ù û ú ú ú ú ú ú ú ú ,N2 = 110110 110110 001001 110100 110010 001001 é ë ê ê ê ê ê ê ê ê ù û ú ú ú ú ú ú ú ú ,N3 = 111111 110111 101011 110111 111111 111111 é ë ê ê ê ê ê ê ê ê ù û ú ú ú ú ú ú ú ú N4 = 110010 110110 001001 010110 110110 001001 é ë ê ê ê ê ê ê ê ê ù û ú ú ú ú ú ú ú ú ,NA = 110000 110110 001001 010100 010010 001001 é ë ê ê ê ê ê ê ê ê ù û ú ú ú ú ú ú ú ú ,ND = 110010 110010 001101 001101 110010 001101 é ë ê ê ê ê ê ê ê ê ù û ú ú ú ú ú ú ú ú 说明 NA⊄ND。 由以上计算知,POSA(D)= {x1 ,x3 , x5 ,x6 }。 根据定义 3,得到辨识矩阵如表 2 所示。 表 2 病例决策信息表的辨识矩阵 Table 2 Discernibility matrix of case decisions 序号 x1 x2 x3 x4 x5 x6 x1 A A a1,a2,a4 a1,a4 A a1,a2,a4 x2 A A A A A A x3 a1,a2,a4 A A A a1,a2,a4 A x4 A A A A A A x5 A A a1,a2,a4 A A a1,a2,a4 x6 a1,a2,a4 a1,a2,a4 A A a1,a2,a4 A 所以,可得决策表的辨识函数为 f = (a1 ∨ a4 ) ∧ (a1 ∨ a2 ∨ a4 ) ∧ a2 = (a1 ∧ a2 ) ∨ (a2 ∧ a4 ) 因此{ a1 ,a2 } 和{ a2 ,a4 } 是病例决策表的两个 约简。 2 属性约简算法 经典粗糙集算法是以等价关系作为聚类标准 第 3 期 冯丹,等:连续型数据的辨识矩阵属性约简方法 ·373·

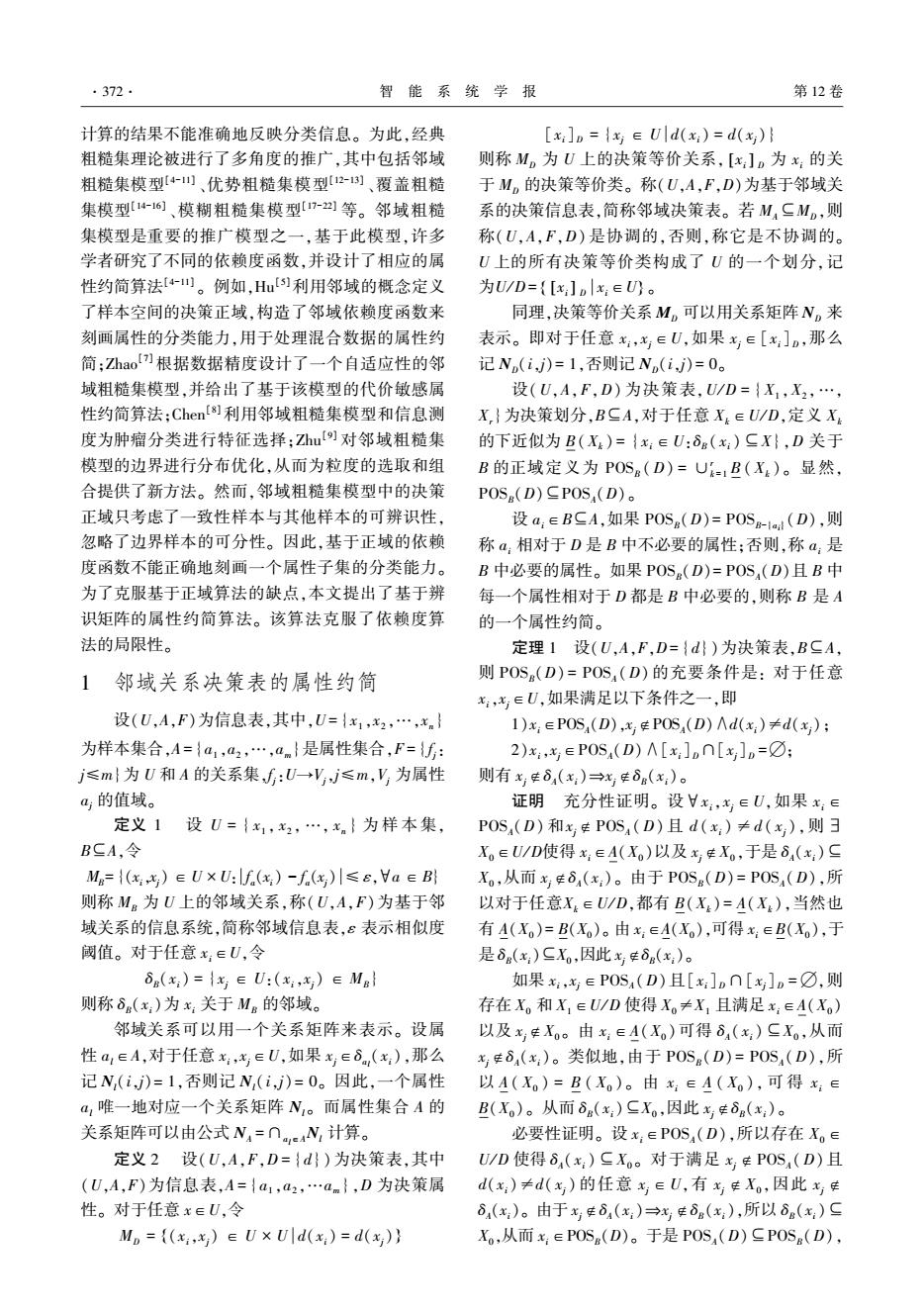

·374· 智能系统学报 第12卷 的。对于数值型数据集,首先进行离散化并构造等 计算正域POS,(D) 价关系。若两个样本在所有属性上取值一样,那么 这两个样本就为一类,否则不是一类。而在离散化 Va,eA,计算可辨识矩阵y 过程中,避免不了信息流失,而这恰恰是当今研究 计算可辨识矩阵W 的热点。本算法通过定义一个距离参数,考虑某两 个样本在属性上的相似程度。如果两个样本之间 赋初值REDA 距离小于阈值,则这两个样本就可以聚为一类,这 a,eRED,计算N:Ro和sUm(N,En】 比经典粗糙集的理论显然更多地考虑了样本之间 选择最优的a,并且RED-{A-a} 的联系,避免大量信息的流失,从而提高了属性约 简的精度。由于利用定理3去搜索决策表的全部约 e,令N,(i)=1,否则令N,(i,j)= 为了说明该算法的有效性和可行性,首先对各个数 0:当N(i,j)=1,令N,(i,j)=0。 据集进行了属性约简,选取约简数据的最高分类精 4)计算N4=UN,RED-A。 度所对应的属性数目进行比较,具体结果如表4所 5)a,∈A,计算N1ta和sum(N1i-a),其中 示,其中ε列表示对应数据约简后所取得的最高分 sum(N)表示对矩阵V的行列求和。 类精度的相似度阈值的取值。表5和表6分别给出 6)选择满足sum(Niod-a4l)=max(sum 了各个数据集属性约简前后的分类精度。 (Nid)的ak,令RED4-{A-ak}。 表3数据描述 7)如果(sum(N4)-sum(N))/|U<8,输出约 Table 3 Data information 简RED。否则,转到5)。 序号 Data sets Samples Numerical Classes 了更好地理解所提出的算法,下面给出该算法 1 Glass 214 10 6 的流程图,如图1。 2 Colon 62 1224 2 3实验分析 Wine 178 13 3 为了验证算法的有效性,从一些文献中选出4 Wdbe 569 30 2 个相关的属性约简方法与本文所提的算法作比较。 这4个算法分别是经典粗糙集算法(FCMRS)[)、邻 Prostate 102 12625 2 域粗糙集算法(NBRS)[、邻域粗糙信息测度算法 从表4中可以看出,这5种属性约简方法都能 (NBIM)[]以及自适应邻域粗糙集模型 够有效地对数据集进行属性约简。FCMRS算法选 (APTNB))。本实验主要从算法选择的属性数目 取的属性数目最少,DISRS算法次之。表5和表6 和相应的分类精度两个方面进行比较。计算机运 表明,DISRS算法的分类精度最高,FCMRS算法的 行的环境参数为:奔腾双核,CPUE52001.90GHz, 分类精度最低。同时,DISRS算法所对应的分类精 RAM4.0GB,软件为MATLAB2007。 度明显好于其他方法。10次分类任务,DISRS算法

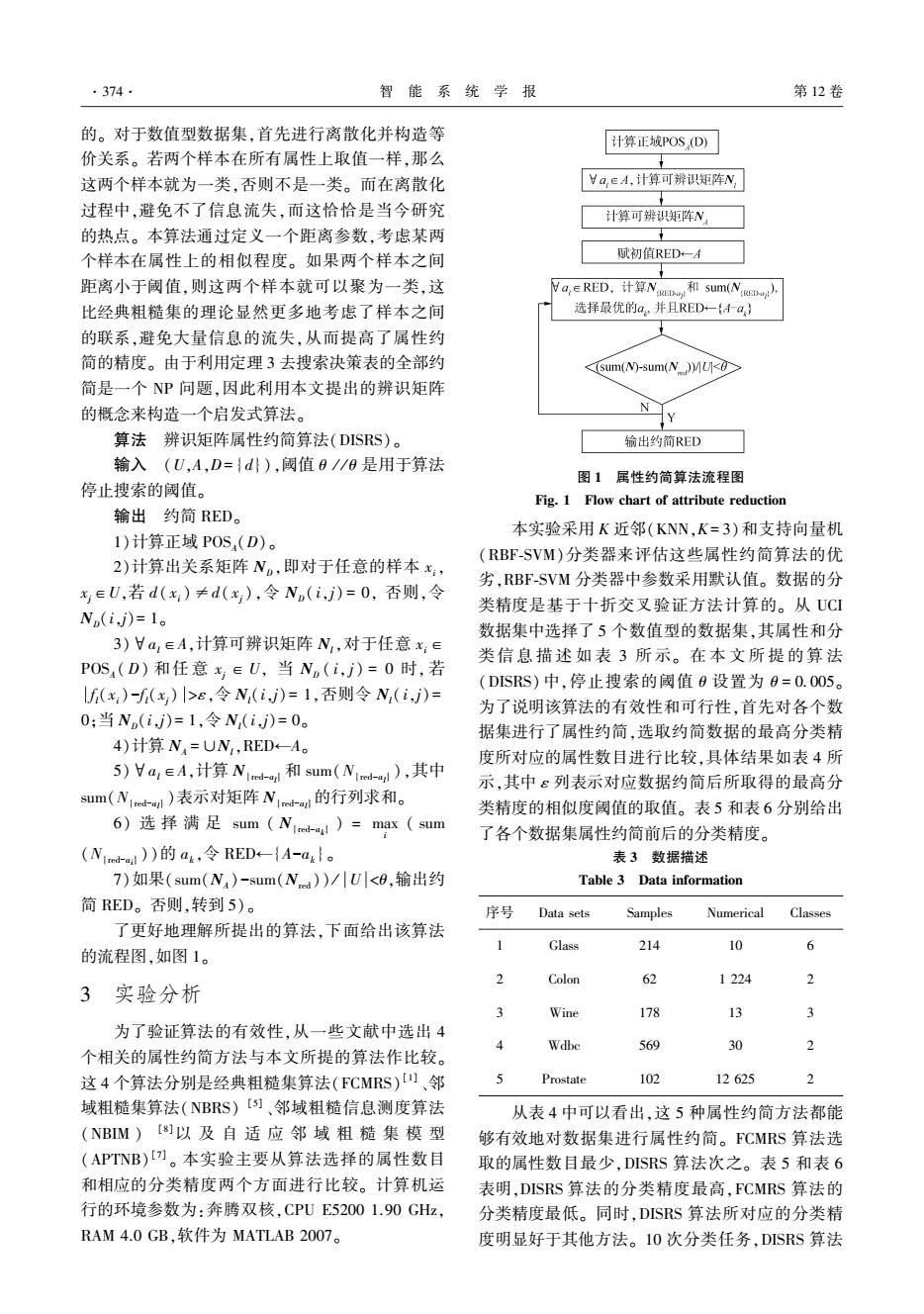

的。 对于数值型数据集,首先进行离散化并构造等 价关系。 若两个样本在所有属性上取值一样,那么 这两个样本就为一类,否则不是一类。 而在离散化 过程中,避免不了信息流失,而这恰恰是当今研究 的热点。 本算法通过定义一个距离参数,考虑某两 个样本在属性上的相似程度。 如果两个样本之间 距离小于阈值,则这两个样本就可以聚为一类,这 比经典粗糙集的理论显然更多地考虑了样本之间 的联系,避免大量信息的流失,从而提高了属性约 简的精度。 由于利用定理 3 去搜索决策表的全部约 简是一个 NP 问题,因此利用本文提出的辨识矩阵 的概念来构造一个启发式算法。 算法 辨识矩阵属性约简算法(DISRS)。 输入 (U,A,D= {d}),阈值 θ / / θ 是用于算法 停止搜索的阈值。 输出 约简 RED。 1)计算正域 POSA(D)。 2)计算出关系矩阵 ND,即对于任意的样本 xi, xj∈U,若 d( xi ) ≠d( xj ),令 ND( i,j) = 0, 否则,令 ND(i,j)= 1。 3)∀al∈A,计算可辨识矩阵 Nl,对于任意 xi∈ POSA ( D) 和任意 xj ∈ U, 当 ND ( i, j) = 0 时, 若 f l(xi)-f l(xj) >ε,令 Nl(i,j) = 1,否则令 Nl( i,j) = 0;当 ND(i,j)= 1,令 Nl(i,j)= 0。 4)计算 NA =∪Nl,RED←A。 5)∀al∈A,计算 N{red-al } 和 sum(N{red-al } ),其中 sum(N{red-al } )表示对矩阵 N{red-al }的行列求和。 6) 选 择 满 足 sum ( N{red-ak } ) = max i ( sum (N{red-ai } ))的 ak,令 RED←{A-ak}。 7)如果(sum(NA )-sum(Nred )) / U <θ,输出约 简 RED。 否则,转到 5)。 了更好地理解所提出的算法,下面给出该算法 的流程图,如图 1。 3 实验分析 为了验证算法的有效性,从一些文献中选出 4 个相关的属性约简方法与本文所提的算法作比较。 这 4 个算法分别是经典粗糙集算法(FCMRS) [1] 、邻 域粗糙集算法(NBRS) [5] 、邻域粗糙信息测度算法 (NBIM ) [8]以 及 自 适 应 邻 域 粗 糙 集 模 型 (APTNB) [7] 。 本实验主要从算法选择的属性数目 和相应的分类精度两个方面进行比较。 计算机运 行的环境参数为:奔腾双核,CPU E5200 1.90 GHz, RAM 4.0 GB,软件为 MATLAB 2007。 图 1 属性约简算法流程图 Fig. 1 Flow chart of attribute reduction 本实验采用 K 近邻(KNN,K = 3)和支持向量机 (RBF⁃SVM)分类器来评估这些属性约简算法的优 劣,RBF⁃SVM 分类器中参数采用默认值。 数据的分 类精度是基于十折交叉验证方法计算的。 从 UCI 数据集中选择了 5 个数值型的数据集,其属性和分 类信 息 描 述 如 表 3 所 示。 在 本 文 所 提 的 算 法 (DISRS) 中,停止搜索的阈值 θ 设置为 θ = 0. 005。 为了说明该算法的有效性和可行性,首先对各个数 据集进行了属性约简,选取约简数据的最高分类精 度所对应的属性数目进行比较,具体结果如表 4 所 示,其中 ε 列表示对应数据约简后所取得的最高分 类精度的相似度阈值的取值。 表 5 和表 6 分别给出 了各个数据集属性约简前后的分类精度。 表 3 数据描述 Table 3 Data information 序号 Data sets Samples Numerical Classes 1 Glass 214 10 6 2 Colon 62 1 224 2 3 Wine 178 13 3 4 Wdbc 569 30 2 5 Prostate 102 12 625 2 从表 4 中可以看出,这 5 种属性约简方法都能 够有效地对数据集进行属性约简。 FCMRS 算法选 取的属性数目最少,DISRS 算法次之。 表 5 和表 6 表明,DISRS 算法的分类精度最高,FCMRS 算法的 分类精度最低。 同时,DISRS 算法所对应的分类精 度明显好于其他方法。 10 次分类任务,DISRS 算法 ·374· 智 能 系 统 学 报 第 12 卷

第3期 冯丹,等:连续型数据的辨识矩阵属性约简方法 ·375· 获得了8次最高分类精度,APTNB获得了2次, 数用于分类,因此属性约简后的数据分类精度明显 NBIM获得了1次,而FCMRS和NBRS算法没有获 高于FCMRS算法。然而,NBRS、NBIM和APTNB 得最高分类精度。但是NBRS算法的性能要比 算法只考虑一致样本和其他样本的可辨识性,忽略 FCMRS方法好很多。这说明邻域粗糙集模型在处 了边界样本点间可区分性,因此这3种算法的分类 理连续型数据时比经典粗糙集方法具有更大的优 精度低于DISRS算法精度。而DISRS算法克服了 势。造成FCMRS算法选择的属性数目少、分类精 NBRS、NBM和APTNB算法的缺点,因此,在数据 度低的原因,可能是由于FCMRS算法固有的离散 实验分析中取得了较好的性能,即DISRS算法的分 化步骤破坏了原有数据的分类信息。而NBRS、 类精度不仅高于其他算法,而且有效地删减了属 NBM和APTNB算法避免了离散化步骤,直接利用 性。根据数据实验分析表明,本文提出的算法是行 相似关系粒化数据空间,构造分类目标的依赖度函 之有效的,达到了理论预期的效果。 表4属性约简的结果 Table 4 Result of attribute reduction Data sets Raw data FCMRS NBRS NBIM APTNB DISRS Glass 10 J 8 6 0.225 Colon 1224 4 10 13 8 8 0.275 Wine 13 6 9 10 6 > 0.425 Wdbe 30 > 16 8 19 12 0.325 Prostate 12625 2 4 3 4 3 0.25 平均值 2780.4 48 9.4 10.4 8.8 7.2 表5约简数据的SVM后的分类精度 Table5 Classification accuracy of reduced data with SVM % Data sets Raw data FCMRS NBRS NBIM APTNB DISRS Glass 91.58±11.02 89.33±3.06 92.32±6.86 92.56±6.12 93.07±5.33 94.43±4.36 Colon 76.17±17.23 81.07±14.28 82.67±11.78 83.11±12.32 83.46±10.69 84.86±10.11 Wine 95.56±3.33 92.11±3.56 96.18±2.72 95.27±3.64 96.78±2.22 96.78±3.89 Wdbe 94.03±4.83 93.06±8.47 96.81±4.80 97.20±3.59 97.00±2.94 97.17±3.12 Prostate 81.23±15.83 81.86±13.47 85.86±10.81 86.55±12.35 88.39±11.88 88.86±9.98 平均值 87.71±10.45 86.09±7.14 90.77±8.04 90.94±7.60 91.74±6.61 92.42±6.29 表6约简数据的3NN分类精度 Table 6 Classification accuracy of reduced data with 3NN 号 Data sets Raw data FCMRS NBRS NBIM APTNB DISRS Glass 89.73±6.72 89.10±5.00 91.43±5.49 91.37±4.87 91.44±3.98 93.34±3.00 Colon 76.15±16.55 78.33±13.06 81.88±12.08 82.85±11.77 82.76±10.98 83.71±10.23 Wine 94.52±5.63 92.45±6.82 96.78±1.67 97.19±1.08 96.43±3.56 97.22±1.98 Wdbe 94.62±2.57 92.26±7.33 97.00±1.82 97.00±3.16 97.00±3.05 97.17±2.18 Prostate 89.73±6.72 89.10±5.00 91.43±5.49 92.37±4.87 93.44±3.98 93.34±3.00 平均值 87.18±9.50 86.80±9.31 90.29±6.86 90.87±6.71 91.02±6.62 91.75±5.57 致样本有关,也与边界样本有关。而辨识矩阵的 4 结束语 概念正好反映了一组特征的区分能力。本文研究 邻域粗糙集中基于正域的贪心算法只考虑了 了基于邻域辨识矩阵的属性约简方法,设计了启发 区分一致性样本和异类样本,忽略了边界样本间的 式属性约简的算法,并通过UCI数据集验证了该算 区分性。事实上,一个属性子集的分类能力不仅与 法的有效性。未来的工作将讨论该方法在分类决

获得了 8 次最高分类精度,APTNB 获得了 2 次, NBIM 获得了 1 次,而 FCMRS 和 NBRS 算法没有获 得最高分类精度。 但是 NBRS 算法的性能要比 FCMRS 方法好很多。 这说明邻域粗糙集模型在处 理连续型数据时比经典粗糙集方法具有更大的优 势。 造成 FCMRS 算法选择的属性数目少、分类精 度低的原因,可能是由于 FCMRS 算法固有的离散 化步骤破坏了原有数据的分类信息。 而 NBRS、 NBIM 和 APTNB 算法避免了离散化步骤,直接利用 相似关系粒化数据空间,构造分类目标的依赖度函 数用于分类,因此属性约简后的数据分类精度明显 高于 FCMRS 算法。 然而,NBRS、NBIM 和 APTNB 算法只考虑一致样本和其他样本的可辨识性,忽略 了边界样本点间可区分性,因此这 3 种算法的分类 精度低于 DISRS 算法精度。 而 DISRS 算法克服了 NBRS、NBIM 和 APTNB 算法的缺点,因此,在数据 实验分析中取得了较好的性能,即 DISRS 算法的分 类精度不仅高于其他算法,而且有效地删减了属 性。 根据数据实验分析表明,本文提出的算法是行 之有效的,达到了理论预期的效果。 表 4 属性约简的结果 Table 4 Result of attribute reduction Data sets Raw data FCMRS NBRS NBIM APTNB DISRS ε Glass 10 5 8 8 7 6 0.225 Colon 1 224 4 10 13 8 8 0.275 Wine 13 6 9 10 6 7 0.425 Wdbc 30 7 16 18 19 12 0.325 Prostate 12 625 2 4 3 4 3 0. 25 平均值 2 780.4 4.8 9.4 10.4 8.8 7.2 表 5 约简数据的 SVM 后的分类精度 Table5 Classification accuracy of reduced data with SVM % Data sets Raw data FCMRS NBRS NBIM APTNB DISRS Glass 91.58 ± 11. 02 89.33 ± 3. 06 92.32 ± 6. 86 92.56 ± 6.12 93.07 ± 5.33 94.43 ± 4.36 Colon 76.17 ± 17.23 81.07 ± 14.28 82.67 ± 11.78 83.11 ± 12.32 83.46 ± 10.69 84.86 ± 10.11 Wine 95.56 ± 3. 33 92.11 ± 3. 56 96.18 ± 2. 72 95.27 ± 3.64 96.78 ± 2. 22 96.78 ± 3.89 Wdbc 94.03 ± 4. 83 93.06 ± 8. 47 96.81 ± 4. 80 97.20 ± 3.59 97.00 ± 2.94 97.17 ± 3. 12 Prostate 81.23 ± 15. 83 81.86 ± 13. 47 85.86 ± 10. 81 86.55 ± 12.35 88.39 ± 11.88 88.86 ± 9.98 平均值 87.71 ± 10.45 86.09 ± 7.14 90.77 ± 8.04 90.94 ± 7.60 91.74 ± 6.61 92.42 ± 6.29 表 6 约简数据的 3NN 分类精度 Table 6 Classification accuracy of reduced data with 3NN % Data sets Raw data FCMRS NBRS NBIM APTNB DISRS Glass 89.73 ± 6. 72 89.10 ± 5. 00 91.43 ± 5. 49 91.37 ± 4. 87 91.44 ± 3.98 93.34 ± 3. 00 Colon 76.15 ± 16.55 78.33 ± 13.06 81.88 ± 12.08 82.85 ± 11.77 82.76 ± 10.98 83.71 ± 10.23 Wine 94.52 ± 5. 63 92.45 ± 6. 82 96.78 ± 1. 67 97.19 ± 1. 08 96.43 ± 3. 56 97.22 ± 1. 98 Wdbc 94.62 ± 2. 57 92.26 ± 7. 33 97.00 ± 1. 82 97.00 ± 3. 16 97.00 ± 3. 05 97.17 ± 2. 18 Prostate 89.73 ± 6. 72 89.10 ± 5. 00 91.43 ± 5. 49 92.37 ± 4. 87 93.44 ± 3.98 93.34 ± 3. 00 平均值 87.18 ± 9.50 86.80 ± 9.31 90.29 ± 6.86 90.87 ± 6.71 91.02 ± 6.62 91.75 ± 5.57 4 结束语 邻域粗糙集中基于正域的贪心算法只考虑了 区分一致性样本和异类样本,忽略了边界样本间的 区分性。 事实上,一个属性子集的分类能力不仅与 一致样本有关,也与边界样本有关。 而辨识矩阵的 概念正好反映了一组特征的区分能力。 本文研究 了基于邻域辨识矩阵的属性约简方法,设计了启发 式属性约简的算法,并通过 UCI 数据集验证了该算 法的有效性。 未来的工作将讨论该方法在分类决 第 3 期 冯丹,等:连续型数据的辨识矩阵属性约简方法 ·375·

·376· 智能系统学报 第12卷 策中的应用。 [14]WANG C,HE Q,CHEN D G,et al.A novel method for attribute reduction of covering decision tables[]]. 参考文献: Information sciences,2014,254:181-196. [15]WANG C.SHAO M,SUN B,et al.An improved attribute [1]PAWLAK Z.Rough sets [J].International journal of reduction scheme with covering based rough sets[J]. computer and information sciences,1982,11 (5): Applied soft computing,2015,26(1):235-243. 341-356. [16]ZHU W,WANG F Y.Reduction and maximization of [2]SKOWRON A,RAUSZER C.The discernibility matrices and covering generalized rough sets[].Information sciences, functions in information systems [C]//Slowinski R. 2003,152:217-230. (Ed.),Intelligent Decision Support.Dordrecht,Kluwer [17]DUBOIS D,PRADE H.Rough fuzzy sets and fuzzy rough Academic Publishers,1992:331-362. sets[]International journal of general systems,1990, [3]MI J S,WU W Z,ZHANG W X.Approaches to knowledge 17:191-208. reduction based on variable precision rough sets model [] [18]WANG C.QI Y,HU Q,et al.A fitting model for feature Information sciences,2004,159(3/4):255-272 selection with fuzzy rough sets[J.IEEE transaction on [4]WU W Z,ZHANG W X.Neighborhood operator systems fuzzy systems,2016,99:1-1. and approximations[J].Information sciences,2002,144 [19]WANG C.SHAO M,QIAN Y.Feature subset selection (1/4):201-217. based on fuzzy neighborhood rough sets[J].Knowledge- [5]HU Q H,YU D,LIU J F,et al.Neighborhood-rough-set based systems,2016,111(1):173-179. based heterogeneous feature subset selection [J]. [20]CHEN D G,ZHANG L,ZHAO S Y,et al.A novel algorithm Information sciences,2008,178(18):3577-3594. for finding reducts with fuzzy rough sets[.IEEE transaction [6]KIM D.Data classification based on tolerant rough set [J]. on fuzzy systems,2013,20(2):385-389. Pattern recognition,2001,34(8):1613-1624. [21]WANG X Z,ZHAI J H,LU S X.Induction of multiple [7]ZHAO H,WANG P,HU Q H.Cost-sensitive feature fuzzy decision trees based on rough set technique[J]. selection based on adaptive neighborhood granularity with Information sciences,2008,178(16):3188-3202. multi-level confidence [J].Information sciences,2016, [22]ZHAO S Y,TSANG CC,CHEN D.Building a rule-based 366:134-149. classifier by using fuzzy rough set technique[J].IEEE [8]CHEN Y,ZHANG Z,ZHENG J,et al.Gene selection for transaction on knowledge and data engineering,2010.22 tumor classification using neighborhood rough sets and (5):624-638. entropy measures [J].Journal of biomedical informatics, 作者简介: 2017.67:59-68 冯丹,女,1977年生,高级工程师, [9]ZHU P,HU Q H.Adaptive neighborhood granularity 主要研究方向为计算机信息管理、数据 selection and combination based on margin distribution 挖掘。已发表学术论文10余篇。 optimation [J].Information sciences,2013,249:1-12. [10]鲍丽娜,丁世飞,许新征,等.基于邻域粗糙集的极速 学习机算法[J].济南大学学报,2015,29(5): 367-371. BAO Lina,DING Shifei,XU Xinzheng,et al.Extreme learning machine algorithm based on neighborhood rough sets 黄洋,女,1994年生,硕士研究生 []Journal of jinan university,2015,29(5):367-371. 主要研究方向为粒计算与数据挖掘。 [11]谢娟英,李楠,乔子芮.基于邻域粗糙集的不完整决策 系统特征选择算法[J].南京大学学报,2016,47: 384-390. XIE Juanying,LI Nan,QIAO Zirui.A feature selection algorithm based on neighborhood rough sets for incomplete information systems[J].Journal of Nanjing university, 2016,47:384-390. 石云鹏,男,1994年生,硕士研究 [12]徐伟华.序信息系统与粗糙集[M].北京:科学出版 生,主要研究方向为粒计算与数据 社,2013. 挖掘。 [13]GRECO S,MATARAZZO B,SLOWINSKI R.Rough sets methodology for sorting problems in presence of multiple attributes and criteria[].European journal of operational research,2002,38:247-259

策中的应用。 参考文献: [1] PAWLAK Z. Rough sets [ J ]. International journal of computer and information sciences, 1982, 11 ( 5 ): 341-356. [2]SKOWRON A,RAUSZER C. The discernibility matrices and functions in information systems [ C ] / / Slowinski R. (Ed.), Intelligent Decision Support. Dordrecht, Kluwer Academic Publishers, 1992: 331-362. [3]MI J S, WU W Z, ZHANG W X. Approaches to knowledge reduction based on variable precision rough sets model [J]. Information sciences, 2004, 159(3 / 4): 255-272. [4] WU W Z, ZHANG W X. Neighborhood operator systems and approximations [ J]. Information sciences, 2002, 144 (1 / 4): 201-217. [5]HU Q H, YU D, LIU J F, et al. Neighborhood⁃rough⁃set based heterogeneous feature subset selection [ J ]. Information sciences, 2008, 178(18): 3577-3594. [6]KIM D. Data classification based on tolerant rough set [ J]. Pattern recognition, 2001, 34(8): 1613-1624. [7 ] ZHAO H, WANG P, HU Q H. Cost⁃sensitive feature selection based on adaptive neighborhood granularity with multi⁃level confidence [ J]. Information sciences, 2016, 366: 134-149. [8]CHEN Y, ZHANG Z, ZHENG J, et al. Gene selection for tumor classification using neighborhood rough sets and entropy measures [ J]. Journal of biomedical informatics, 2017, 67:59-68 [9 ] ZHU P, HU Q H. Adaptive neighborhood granularity selection and combination based on margin distribution optimation [J]. Information sciences, 2013, 249:1-12. [10]鲍丽娜,丁世飞, 许新征, 等. 基于邻域粗糙集的极速 学习 机 算 法 [ J ]. 济 南 大 学 学 报, 2015, 29 ( 5 ): 367-371. BAO Lina, DING Shifei, XU Xinzheng, et al. Extreme learning machine algorithm based on neighborhood rough sets [J]. Journal of jinan university, 2015, 29(5): 367-371. [11]谢娟英, 李楠, 乔子芮. 基于邻域粗糙集的不完整决策 系统特征选择 算 法 [ J]. 南 京 大 学 学 报, 2016, 47: 384-390. XIE Juanying, LI Nan, QIAO Zirui. A feature selection algorithm based on neighborhood rough sets for incomplete information systems [ J ]. Journal of Nanjing university, 2016, 47:384-390. [12]徐伟华. 序信息系统与粗糙集[ M]. 北京: 科学出版 社, 2013. [13]GRECO S, MATARAZZO B, SLOWINSKI R. Rough sets methodology for sorting problems in presence of multiple attributes and criteria[J]. European journal of operational research, 2002, 38:247-259. [14]WANG C, HE Q, CHEN D G, et al. A novel method for attribute reduction of covering decision tables[J]. Information sciences, 2014, 254: 181-196. [15]WANG C, SHAO M, SUN B, et al. An improved attribute reduction scheme with covering based rough sets[J]. Applied soft computing, 2015, 26(1): 235-243. [16] ZHU W, WANG F Y. Reduction and maximization of covering generalized rough sets[J]. Information sciences, 2003, 152: 217-230. [17]DUBOIS D, PRADE H. Rough fuzzy sets and fuzzy rough sets[J]. International journal of general systems, 1990, 17: 191-208. [18]WANG C, QI Y, HU Q, et al. A fitting model for feature selection with fuzzy rough sets[J]. IEEE transaction on fuzzy systems, 2016,99: 1-1. [19] WANG C, SHAO M, QIAN Y. Feature subset selection based on fuzzy neighborhood rough sets[J]. Knowledge⁃ based systems, 2016, 111(1): 173-179. [20]CHEN D G, ZHANG L, ZHAO S Y, et al. A novel algorithm for finding reducts with fuzzy rough sets[J]. IEEE transaction on fuzzy systems, 2013, 20(2): 385-389. [21] WANG X Z, ZHAI J H, LU S X. Induction of multiple fuzzy decision trees based on rough set technique[J]. Information sciences, 2008, 178(16): 3188-3202. [22]ZHAO S Y, TSANG C C, CHEN D. Building a rule-based classifier by using fuzzy rough set technique[J]. IEEE transaction on knowledge and data engineering, 2010, 22 (5): 624-638. 作者简介: 冯丹,女,1977 年生,高级工程师, 主要研究方向为计算机信息管理、数据 挖掘。 已发表学术论文 10 余篇。 黄洋,女,1994 年生,硕士研究生, 主要研究方向为粒计算与数据挖掘。 石云鹏,男,1994 年生,硕士研究 生, 主 要 研 究 方 向 为 粒 计 算 与 数 据 挖掘。 ·376· 智 能 系 统 学 报 第 12 卷