简介 1.1 多重线性回归模型 1 1.2 多元线性回归模型 9 1.2.1最小二乘估计的性质.. 16 1.2.2 最小二乘估计的几何解释 22 1.2.3 有线性约束的线性模型.。···。。·· 23 1.2.4 预测... 26 Previous Next First Last Back Forward 1

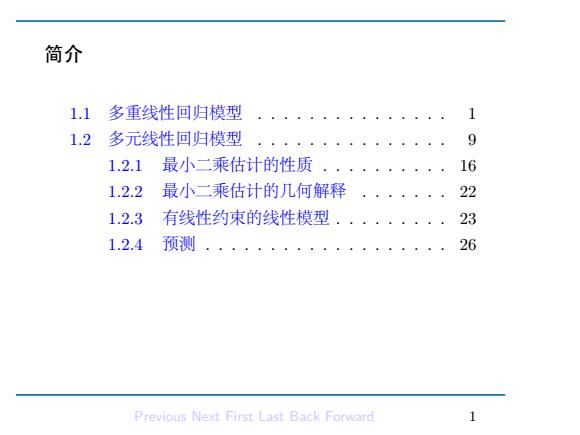

简介 1.1 多重线性回归模型 . . . . . . . . . . . . . . . 1 1.2 多元线性回归模型 . . . . . . . . . . . . . . . 9 1.2.1 最小二乘估计的性质 . . . . . . . . . . 16 1.2.2 最小二乘估计的几何解释 . . . . . . . 22 1.2.3 有线性约束的线性模型 . . . . . . . . . 23 1.2.4 预测 . . . . . . . . . . . . . . . . . . . 26 Previous Next First Last Back Forward 1

1.1 多重线性回归模型 ·回归分析是一类基于预测变量(predictor variables)(a.k.a解 释变量,自变量(independent variables),回归量(regressors) 来预测一个或多个响应变量(response variable)(a.k.a因变量 (dependent variable),被解释变量(explained variable),回归 应变量(regressand))的统计方法 ·回归分析也可以用来评价解释变量对响应变量的作用,常为解 释变量的线性函数对响应变量的作用 ·解释变量可以为连续的或者离散的,或者两者混合的 ·首先我们回顾一下用于一元响应变量的多重回归方法,然后推 广到响应变量是多维的」 Previous Next First Last Back Forward

1.1 多重线性回归模型 • 回归分析是一类基于预测变量 (predictor variables)(a.k.a 解 释变量, 自变量 (independent variables), 回归量 (regressors)) 来预测一个或多个响应变量 (response variable)(a.k.a 因变量 (dependent variable), 被解释变量 (explained variable), 回归 应变量 (regressand) ) 的统计方法 • 回归分析也可以用来评价解释变量对响应变量的作用, 常为解 释变量的线性函数对响应变量的作用 • 解释变量可以为连续的或者离散的, 或者两者混合的 • 首先我们回顾一下用于一元响应变量的多重回归方法, 然后推 广到响应变量是多维的. Previous Next First Last Back Forward 1

Multiple Regression Analysis 。假设解释变量为x1,x2,Ep-1,这些变量认为是和响应变量 y有关联 ·多重线性总体回归模型假设 y=Bo+B11+B2T2++Bp-1cp-1+e -B=(o,31,.,3p-1)'为(固定的)未知的参数向量 一x1,,xp-1称为解释变量,其可以为固定的(设计的),或 者随机的 -e称为随机误差项,一般假设e~(0,a2),且E(ex)= 0,i=1,,p-1. ·当我们对总体进行随机抽样时候,假设有n个个体,每个个体 有模型 =B0+B1x1+B2x2+·+Bp-1t(p-1)+e Previous Next First Last Back Forward 2

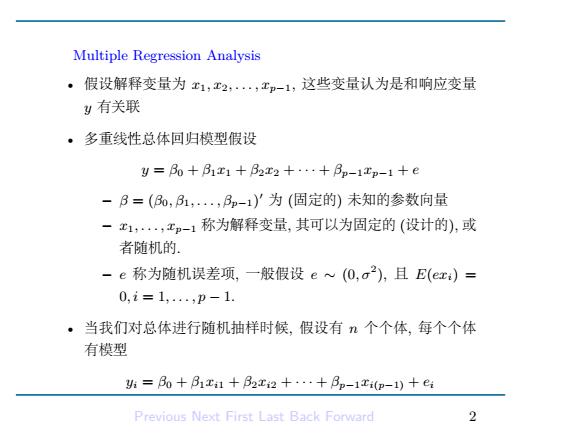

Multiple Regression Analysis • 假设解释变量为 x1, x2, . . . , xp−1, 这些变量认为是和响应变量 y 有关联 • 多重线性总体回归模型假设 y = β0 + β1x1 + β2x2 + · · · + βp−1xp−1 + e – β = (β0, β1, . . . , βp−1) ′ 为 (固定的) 未知的参数向量 – x1, . . . , xp−1 称为解释变量, 其可以为固定的 (设计的), 或 者随机的. – e 称为随机误差项, 一般假设 e ∼ (0, σ2 ), 且 E(exi) = 0, i = 1, . . . , p − 1. • 当我们对总体进行随机抽样时候, 假设有 n 个个体, 每个个体 有模型 yi = β0 + β1xi1 + β2xi2 + · · · + βp−1xi(p−1) + ei Previous Next First Last Back Forward 2

表示成矩阵形式后有 11 E1(p-1) 21 2(p-1) e 8+ n1··n(p-1) ←→Ynx1=XnxpB+e 其中,x1,,-)表示对总体变量,x1,,工p-1的独 立重复观测.按照总体模型假设和抽样方式,一般假设误差有 下述性质: Eei=0 - Var(e)=o2(常数) -Cou(e,e)=0,i≠j Previous Next First Last Back Forward 2

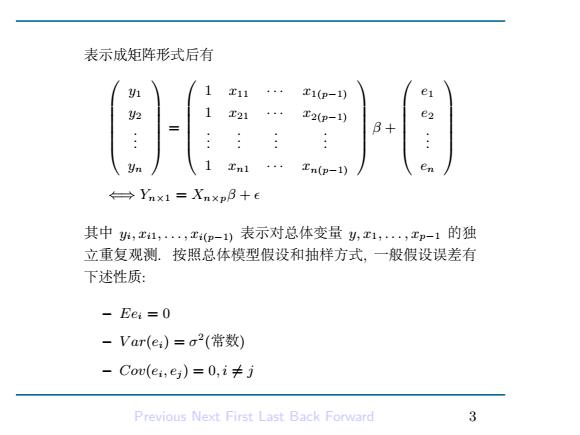

表示成矩阵形式后有 y1 y2 . . . yn = 1 x11 · · · x1(p−1) 1 x21 · · · x2(p−1) . . . . . . . . . . . . 1 xn1 · · · xn(p−1) β + e1 e2 . . . en ⇐⇒ Yn×1 = Xn×pβ + ϵ 其中 yi, xi1, . . . , xi(p−1) 表示对总体变量 y, x1, . . . , xp−1 的独 立重复观测. 按照总体模型假设和抽样方式, 一般假设误差有 下述性质: – Eei = 0 – V ar(ei) = σ 2 (常数) – Cov(ei, ej ) = 0, i ̸= j Previous Next First Last Back Forward 3

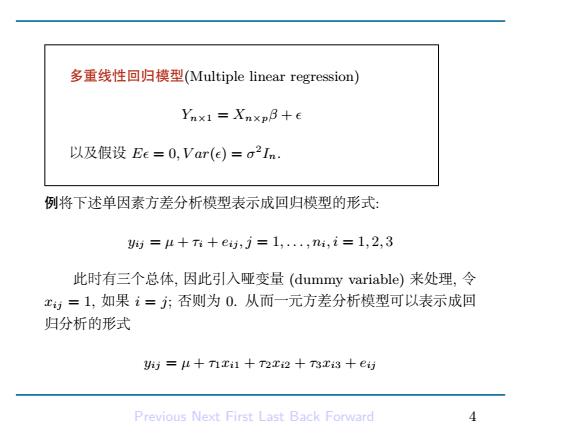

多重线性回归模型(Multiple linear regression) Ynx1 Xnxp8+e 以及假设Ee=0,Var(e)=o2In. 例将下述单因素方差分析模型表示成回归模型的形式: y时=μ+T+e,j=1,..,ni,i=1,2,3 此时有三个总体,因此引入哑变量(dummy variable)来处理,令 ,=1,如果i=方;否则为0.从而一元方差分析模型可以表示成回 归分析的形式 )=μ+nri1十T2r2+T3r3+e访 Previous Next First Last Back Forward 4

多重线性回归模型(Multiple linear regression) Yn×1 = Xn×pβ + ϵ 以及假设 Eϵ = 0, V ar(ϵ) = σ 2 In. 例将下述单因素方差分析模型表示成回归模型的形式: yij = µ + τi + eij , j = 1, . . . , ni, i = 1, 2, 3 此时有三个总体, 因此引入哑变量 (dummy variable) 来处理, 令 xij = 1, 如果 i = j; 否则为 0. 从而一元方差分析模型可以表示成回 归分析的形式 yij = µ + τ1xi1 + τ2xi2 + τ3xi3 + eij Previous Next First Last Back Forward 4

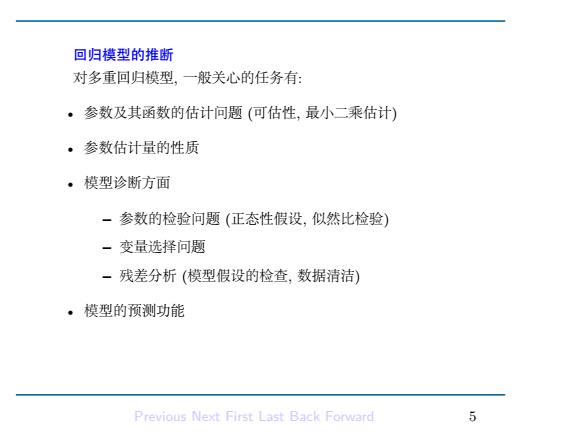

回归模型的推断 对多重回归模型,一般关心的任务有: ·参数及其函数的估计问题(可估性,最小二乘估计) ·参数估计量的性质 ·模型诊断方面 一参数的检验问题(正态性假设,似然比检验) -变量选择问题 一残差分析(模型假设的检查,数据清洁) ·模型的预测功能 Previous Next First Last Back Forward S

回归模型的推断 对多重回归模型, 一般关心的任务有: • 参数及其函数的估计问题 (可估性, 最小二乘估计) • 参数估计量的性质 • 模型诊断方面 – 参数的检验问题 (正态性假设, 似然比检验) – 变量选择问题 – 残差分析 (模型假设的检查, 数据清洁) • 模型的预测功能 Previous Next First Last Back Forward 5

最小二乘估计 ·对B的估计方法之一是选择使得残差平方和达到最小 =ag盟V-x=as∑(k-∑Aa) 其中x0三1. ·当X为满秩时候(p<n),上述最小化残差平方和的B可以得 出 B=(X'x)XY -此时称B为B的最小二乘估计. -此时响应变量的拟合值为Y=XB=X(X'X)-1XY= HY,H称为帽子(Hat)矩阵. -残差为=Y-Y=(I-H)Y Previous Next First Last Back Forward 6

最小二乘估计 • 对 β 的估计方法之一是选择使得残差平方和达到最小: βˆ = arg min β∈Rp ∥Y − Xβ∥ 2 = arg min β∈Rp ∑n i=1 ( yi − ∑p−1 k=0 βkxik)2 其中 xi0 ≡ 1. • 当 X 为满秩时候 (p < n), 上述最小化残差平方和的 β 可以得 出 βˆ = (X ′X) −1X ′ Y – 此时称 βˆ 为 β 的最小二乘估计. – 此时响应变量的拟合值为 Yˆ = Xβˆ = X(X′X) −1X′Y = HY , H 称为帽子 (Hat) 矩阵. – 残差为 ϵˆ = Y − Yˆ = (I − H)Y Previous Next First Last Back Forward 6

-残差满足X=0,空=0. 平方和分解 由于Y=0,因此总的响应变量平方和Y'Y可以分解为 Y'Y=(P+Y-)'(Y+Y-)=Y空+ 由于X的第一列为1,因此Xe=0表明1'e=0=→1Y=1'Y. 从而两边同时减去1'Y和1'夕得到 y'y-1'y=Y空-1'Y+e 一-驴=,-那+∑ SST SSreg SSe 总平方和=回归平方和+残差平方和 总波动性=回归能解释的波动性+误差的波动性 Previous Next First Last Back Forward

– 残差满足 ϵˆ ′X = 0, ϵˆ ′Yˆ = 0. 平方和分解 由于 ϵˆ ′Yˆ = 0, 因此总的响应变量平方和 Y ′Y 可以分解为 Y ′ Y = (Yˆ + Y − Yˆ ) ′ (Yˆ + Y − Yˆ ) = Yˆ ′ Yˆ + ˆϵ ′ ϵˆ 由于 X 的第一列为 1, 因此 X′ ϵˆ = 0 表明 1 ′ ϵˆ = 0 =⇒ 1 ′Y = 1 ′Yˆ . 从而两边同时减去 1 ′Y 和 1 ′Yˆ 得到 Y ′ Y − 1 ′ Y = Yˆ ′ Yˆ − 1 ′ Yˆ + ˆϵ ′ ϵˆ ⇐⇒ ∑n i=1 (yi − y¯) 2 = ∑n i=1 (ˆyj − y¯) 2 + ∑n i=1 ϵˆ 2 i SST = SSreg + SSe 总平方和 = 回归平方和 + 残差平方和 总波动性 = 回归能解释的波动性 + 误差的波动性 Previous Next First Last Back Forward 7

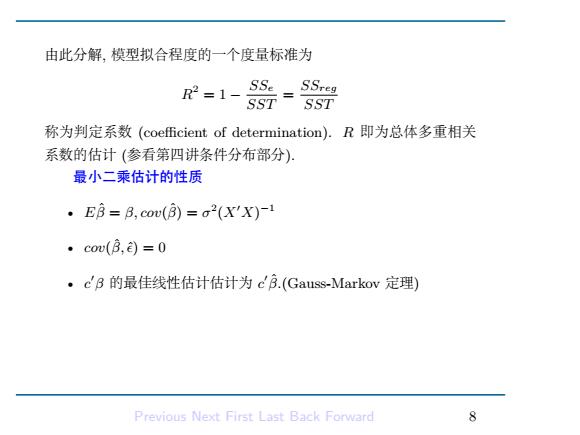

由此分解,模型拟合程度的一个度量标准为 2=1- SSe SSreg SST SST 称为判定系数(coef伍cient of determination).R即为总体多重相关 系数的估计(参看第四讲条件分布部分) 最小二乘估计的性质 ·E8=B,cov(8)=a2(X'X)-1 ·cow(B,)=0 。c'B的最佳线性估计估计为cB.(Gauss-Markov定理) Previous Next First Last Back Forward 8

由此分解, 模型拟合程度的一个度量标准为 R 2 = 1 − SSe SST = SSreg SST 称为判定系数 (coefficient of determination). R 即为总体多重相关 系数的估计 (参看第四讲条件分布部分). 最小二乘估计的性质 • Eβˆ = β, cov(βˆ) = σ 2 (X′X) −1 • cov(β, ˆ ϵˆ) = 0 • c ′β 的最佳线性估计估计为 c ′βˆ.(Gauss-Markov 定理) Previous Next First Last Back Forward 8

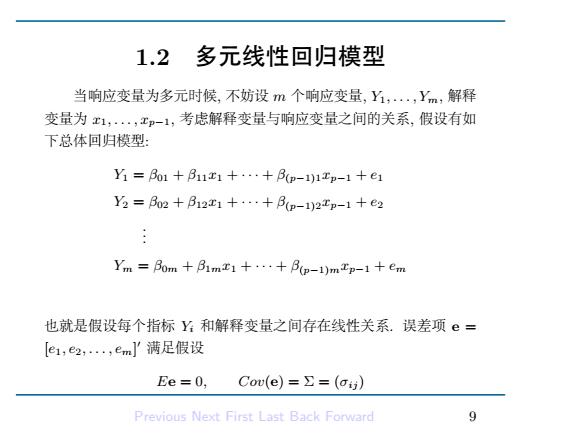

1.2 多元线性回归模型 当响应变量为多元时候,不妨设m个响应变量,Y,.,Ym,解释 变量为x1,,xp-1,考虑解释变量与响应变量之间的关系,假设有如 下总体回归模型: Y=Bo1+B11r1+··+B(p-1)1xp-1+e1 Y2=B02+B12x1+…+Bp-1)2xp-1+e2 Ym=Bom十Bm1+…+Bp-1)mtp-1+em 也就是假设每个指标和解释变量之间存在线性关系.误差项e= [e1,e2,·,emJ'满足假设 Ee=0, Cow(e)=∑=(oi) Previous Next First Last Back Forward

1.2 多元线性回归模型 当响应变量为多元时候, 不妨设 m 个响应变量, Y1, . . . , Ym, 解释 变量为 x1, . . . , xp−1, 考虑解释变量与响应变量之间的关系, 假设有如 下总体回归模型: Y1 = β01 + β11x1 + · · · + β(p−1)1xp−1 + e1 Y2 = β02 + β12x1 + · · · + β(p−1)2xp−1 + e2 . . . Ym = β0m + β1mx1 + · · · + β(p−1)mxp−1 + em 也就是假设每个指标 Yi 和解释变量之间存在线性关系. 误差项 e = [e1, e2, . . . , em] ′ 满足假设 Ee = 0, Cov(e) = Σ = (σij ) Previous Next First Last Back Forward 9