第1章绪论 1.1引言 傍晚小街路面上沁出微雨后的湿润,和煦的细风吹来,抬头看看天边的晚 霞,嗯,明天又是一个好天气。走到水果摊旁,挑了个根蒂蜷缩、敲起来声音浊 响的青绿西瓜,一边满心期待着皮薄肉厚瓢甜的爽落感,一边愉快地想着,这学 期狠下了工夫,基础概念弄得清清楚楚,算法作业也是信手拈来,这门课成绩一 定差不了! 希望各位在学期结束时有这样的感觉.作为开场,我们先大致了解一下什 么是“机器学习”(machine learning)). 回头看第一段话,我们会发现这里涉及很多基于经验做出的预判.例如,为 什么看到微湿路面、感到和风、看到晚霞,就认为明天是好天呢?这是因为在 我们的生活经验中已经遇见过很多类似情况,头一天观察到上述特征后,第二 天天气通常会很好.为什么色泽青绿、根蒂蜷缩、敲声浊响,就能判断出是正 熟的好瓜?因为我们吃过、看过很多西瓜,所以基于色泽、根蒂、敲声这几个 特征我们就可以做出相当好的判断.类似的,我们从以往的学习经验知道,下足 了工夫、弄清了概念、做好了作业,自然会取得好成绩.可以看出,我们能做出 有效的预判,是因为我们已经积累了许多经验,而通过对经验的利用,就能对新 情况做出有效的决策 上面对经验的利用是靠我们人类自身完成的.计算机能帮忙吗? 机器学习正是这样一门学科,它致力于研究如何通过计算的手段,利用经 【Mitchell,1o97给出T 验来改善系统自身的性能.在计算机系统中,“经验”通常以“数据”形式存 设 在任务类T上的性能 在,因此,机器学习所研究的主要内容,是关于在计算机上从数据中产生“模 若一个程序通过利用经验 型”(model)的算法,即“学习算法”(learning algorithm).有了学习算法,我 E在T中任务上获得了性 们把经验数据提供给它,它就能基于这些数据产生模型;在面对新的情况时(例 能改善,则我们就说关于 T和P.该程序对E进行 如看到一个没剖开的西瓜,模型会给我们提供相应的判断(例如好瓜).如果说 了学习 计算机科学是研究关于“算法”的学问,那么类似的,可以说机器学习是研究 关于“学习算法”的学问 本书用“模型”泛指从数据中学得的结果.有文献用“模型”指全局性结 倒如Hand etal..2001 果(例如一棵决策树),而用“模式”指局部性结果(例如一条规则)

第1章绪论 1.2基本术语 要进行机器学习,先要有数据.假定我们收集了一批关于西瓜的数据,例 如(色泽=青绿;根蒂=蜷缩;敲声=浊响),(色泽=乌黑;根蒂=稍蜷;敲声=沉 闷),(色泽=浅白;根蒂=硬挺;敲声=清脆),,每对括号内是一条记录 “=”意思是“取值为”: 这组记录的集合称为一个“数据集”(data set),其中每条记录是关于 个事件或对象(这里是一个西瓜)的描述,称为一个“示例”(instance)或“样 因为 本”(sample),反映事件或对象在某方面的表现或性质的事项,例如“色泽” 作对样本空间的一个采样 “根蒂”“敲声”,称为“属性”(attribute)或“特征”(feature);属性上的取 通过上下文可判断出“样 本”是指单个示例还是数 值,例如“青绿”“乌黑”,称为“属性值”(attribute value).属性张成的空 据」 间称为“属性空间”(attribute space)、“样本空间”(sample space)或“输入 空间”,例如我们把“色泽”“根蒂”“敲声”作为三个坐标轴,则它们张成 一个用于描述西瓜的三维空间,每个西瓜都可在这个空间中找到自己的坐标位 置。由于空间中的每个点对应一个坐标向量,因此我们也把一个示例称为一个 “特征向量”(feature vector). 一般地,令D={c1,2,,xm}表示包含m个示例的数据集,每个 示例由d个属性描述(例如上面的西瓜数据使用了3个属性),则每个示例 x=(x;c2;xd)是d维样本空间X中的一个向量,x1∈X,其中x是 x:在第)个属性上的取值(例如上述第3个西瓜在第2个属性上的值是“硬 挺”),d称为样本xi的“维数”(dimensionality). 从数据中学得模型的过程称为“学习”(learning)或“训练”(training) 这个过程通过执行某个学习算法来完成.训练过程中使用的数据称为“训练 数据”(training data),其中每个样本称为一个“训练样本”(training sample), 训练样本组成的集合称为“训练集”((training set).学得模型对应了关于数据 的某种潜在的规律,因此亦称“假设”(hypothesis):这种潜在规律自身,则称 为“真相”或“真实”(ground-truth),学习过程就是为了找出或逼近真相.本 书有时将模型称为“学习器”(learner),可看作学习算法在给定数据和参数空 和(或)训练数据,将产生 间上的实例化. 不同的结果 如果希望学得一个能帮助我们判断没剖开的是不是“好瓜”的模型,仅 有前面的示例数据显然是不够的.要建立这样的关于“预测”(prediction)的 模型,我们需获得训练样本的“结果”信息,例如“((色泽=青绿;根蒂=蜷缩; 敲声=浊响),好瓜)”.这里关于示例结果的信息,例如“好瓜”,称为“标 用作名词、也可用作动词 记”(label);拥有了标记信息的示例,则称为“样例”(example).一般地,用

1.2基本术语 3 若将标记看作对象本身 (红,)表示第i个样例,其中h∈y是示例x:的标记,y是所有标记的集合, 的一郸分,则“样例”有 时也称为“样本” 亦称“标记空间”(label space)或“输出空间” 若我们欲预测的是离散值,例如“好瓜”“坏瓜”,此类学习任务称为 “分类”(classification:若欲预测的是连续值,例如西瓜成熟度0.95、0.37, 此类学习任务称为“回归”(regression)。对只涉及两个类别的“二分 类”(binary classification)任务,通常称其中一个类为“正类”(positive class), 亦称“负类” 另一个类为“反类”(negative class);涉及多个类别时,则称为“多分 类”(multi--class classification)任务.一般地,预测任务是希望通过对训练 集{e,h,(c2,2,,(m,m}进行学习,建立一个从输入空间X到输出 空间y的映射∫:X→y.对二分类任务,通常令y={-1,+1}或{0,1;对 多分类任务,门川>2;对回归任务,y=R,R为实数集 学得模型后,使用其进行预测的过程称为“测试”(testing),被预测的样本 使的芯力测雅本感即知在学得厂后对试例工可得到共预一 测标记y=f(x). 我们还可以对西瓜做“聚类”(clustering),即将训练集中的西瓜分成若干 组,每组称为一个“簇”(cluster);这些自动形成的簇可能对应一些潜在的概念 划分,例如“浅色瓜”“深色瓜”,甚至“本地瓜”“外地瓜”,这样的学习过 程有助于我们了解数据内在的规律,能为更深入地分析数据建立基础.需说明 的是,在聚类学习中,“浅色瓜”“本地瓜”这样的概念我们事先是不知道的, 况,见136节 而且学习过程中使用的训练样本通常不拥有标记信息 根据训练数据是否拥有标记信息,学习任务可大致划分为两大类:“监督 壳林师华习 学习”(supervised learning)和“无监督学习”(unsupervised learning),分类 和回归是前者的代表,而聚类则是后者的代表。 更确切地说,是“未见 示°(unseen instance). 需注意的是,机器学习的目标是使学得的模型能很好地适用于“新样本” 而不是仅仅在训练样本上工作得很好:即便对聚类这样的无监督学习任务,我 们也希望学得的簇划分能适用于没在训练集中出现的样本.学得模型适用于 新样本的能力,称为“泛化”(generalization)能力.具有强泛化能力的模型能 现实任务中样本空间的 很好地适用于整个样本空间.于是,尽管训练集通常只是样本空间的一个很小 规通常很 例如20 属性,每个属性有10个可 的采样,我们仍希望它能很好地反映出样本空间的特性,否则就很难期望在训 能取值,则样本空间的规 练集上学得的模型能在整个样本空间上都工作得很好.通常假设样本空间中全 模已达1020). 体样本服从一个未知“分布”(distribution)D,我们获得的每个样本都是独立 地从这个分布上采样获得的,即“独立同分布”(independent and identically distributed,简称ii.d).一般而言,训练样本越多,我们得到的关于D的信息

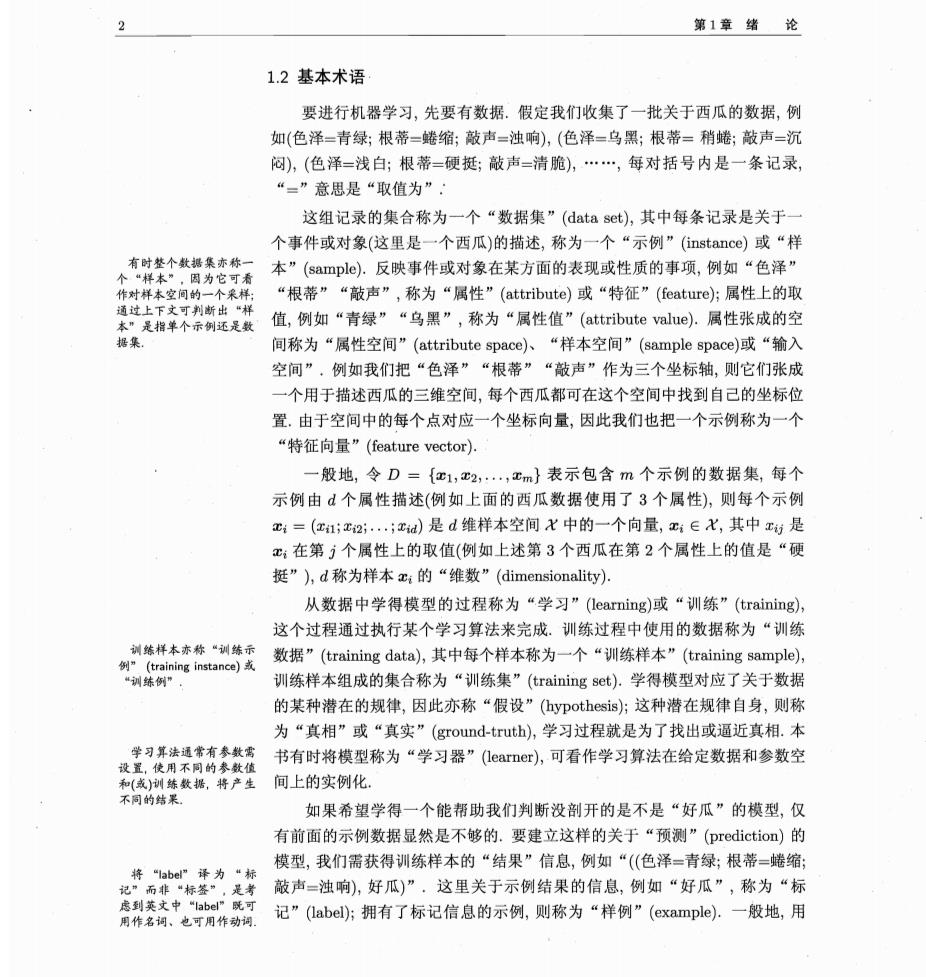

4 第1章绪论 越多,这样就越有可能通过学习获得具有强泛化能力的模型 1.3假设空间 归纳(induction)与演绎(deduction)是科学推理的两大基本手段.前者是从 特殊到一般的“泛化”(generalization)过程,即从具体的事实归结出一般性规 律:后者则是从一般到特殊的“特化”(specialization)过程,即从基础原理推演 出具体状况.例如,在数学公理系统中,基于一组公理和推理规则推导出与之 相洽的定理,这是演绎:而“从样例中学习”显然是一个归纳的过程,因此亦称 “归纳学习”(inductive learning). 归纳学习有狭义与广义之分,广义的归纳学习大体相当于从样例中学习 而狭义的归纳学习则要求从训练数据中学得概念(concept),因此亦称为“概念 学习”或“概念形成”,概念学习技术目前研究、应用都比较少,因为要学得 泛化性能好且语义明确的概念实在太困难了,现实常用的技术大多是产生“黑 箱”模型。然而,对概念学习有所了解,有助于理解机器学习的一些基础思想. 概念学习中最基本的是布尔概念学习,即对“是”“不是”这样的可表示 为0/1布尔值的目标概念的学习.举一个简单的例子,假定我们获得了这样 个训练数据集 表1.1西瓜数据集 编号色泽根蒂敲声好瓜 1 吉绿缘馆神响 是 乌黑缩 浊响 青绿 插辉 清脆 4 黑稍沉闷 这里要学习的目标是“好瓜”,暂且假设“好瓜”可由“色泽”“根蒂” “敲声”这三个因素完全确定,换言之,只要某个瓜的这三个属性取值明确了 我们就能判断出它是不是好瓜.于是,我们学得的将是“好瓜是某种色泽、某 种根蒂、某种敲声的瓜”这样的概念,用布尔表达式写出来则是“好瓜(色 垂一的 知(AAB)V(CAD)的析 泽=)A(根蒂=)Λ(敲声=?)”,这里“?”表示尚未确定的取值,而我们的任 合范或 务就是通过对表1.1的训练集进行学习,把“?”确定下来 读者可能马上发现,表1.1第一行:“(色泽=青绿)Λ(根蒂=蟾缩)Λ(敲 声=浊响)”不就是好瓜吗?是的,但这是一个已见过的瓜,别忘了我们学习的 目的是“泛化”,即通过对训练集中瓜的学习以获得对没见过的瓜进行判断的

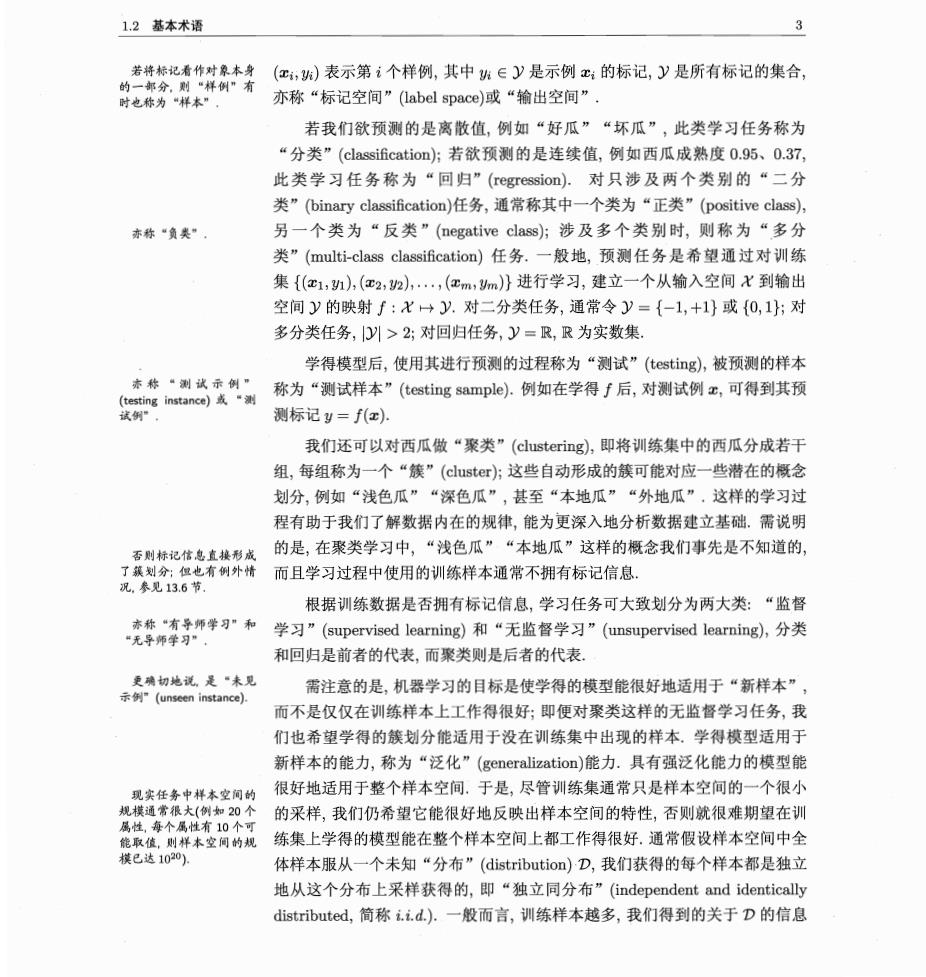

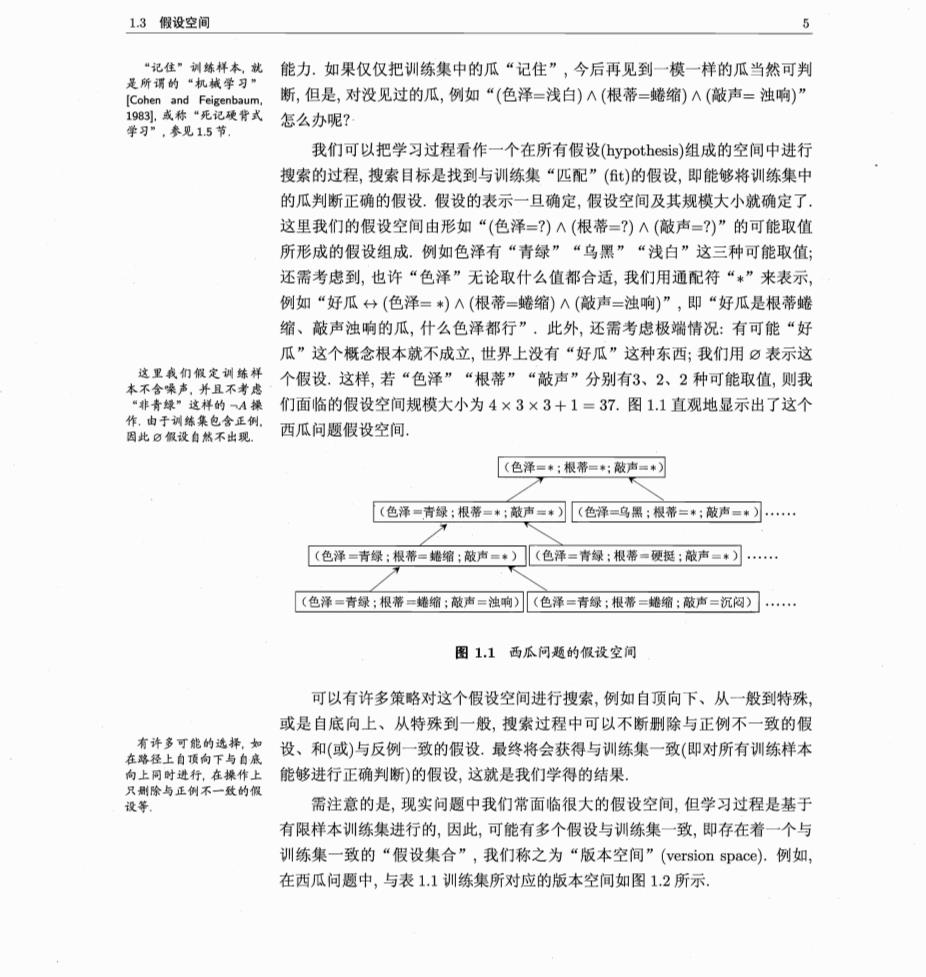

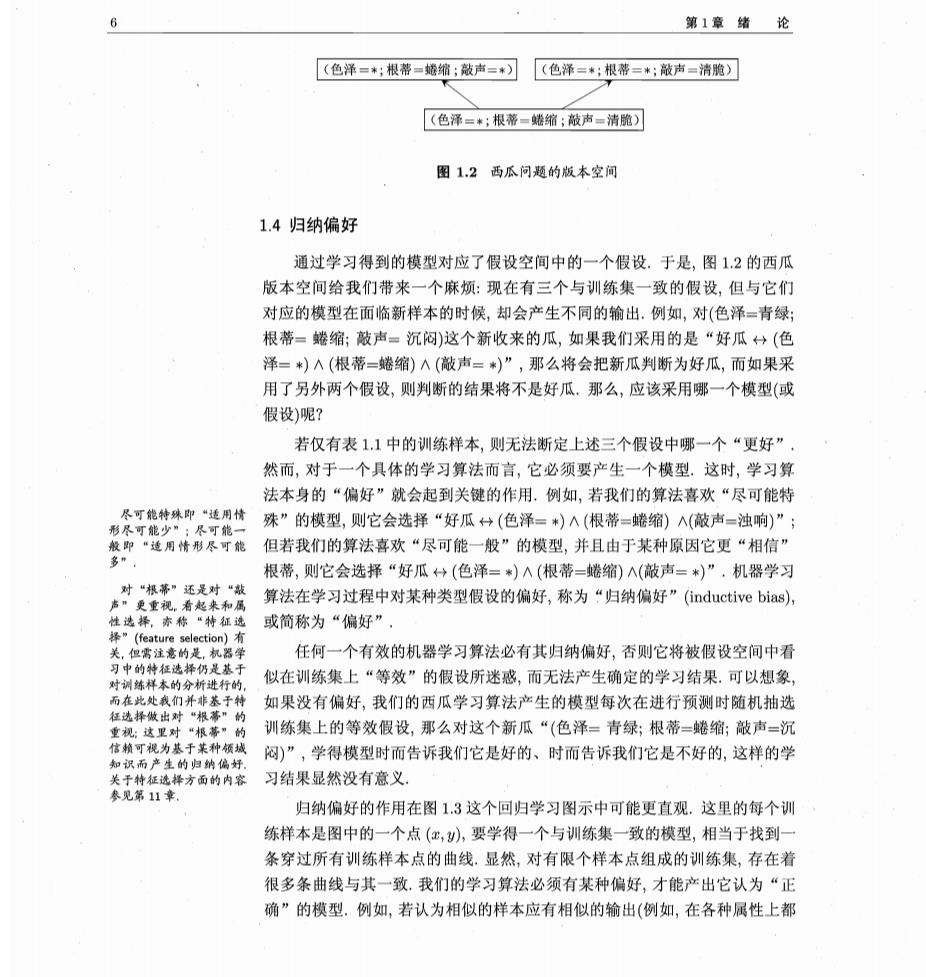

1.3假设空间 、6 能力。如果仅仅把训练集中的瓜“记住”,今后再见到一模一样的瓜当然可判 是所谓的 断,但是,对没见过的瓜,例如“(色泽=浅白)入(根蒂=蜷缩)A(敲声=浊响)” ,泰见15节 怎么办呢? 我们可以把学习过程看作一个在所有假设(ypothesis)组成的空间中进行 搜索的过程,搜索目标是找到与训练集“匹配”()的假设,即能够将训练集中 的瓜判断正确的假设。假设的表示一旦确定,假设空间及其规模大小就确定了 这里我们的假设空间由形如“(色泽=?)A(根蒂=?)A(敲声=?)”的可能取值 所形成的假设组成。例如色泽有“青绿”“乌黑”“浅白”这三种可能取值 还需考虑到,也许“色泽”无论取什么值都合适,我们用通配符“*”来表示 例如“好瓜什(色泽=)Λ(根蒂=蜷缩)A(敲声=浊响)”,即“好瓜是根蒂蟋 缩、敲声浊响的瓜,什么色泽都行”,此外,还需考虑极端情况:有可能“好 瓜”这个概念根本就不成立,世界上没有“好瓜”这种东西;我们用©表示这 个假设.这样,若“色泽”“根蒂”“敲声”分别有3、2、2种可能取值,则我 “非青绿”这样的A操 们面临的假设空间规模大小为4×3×3+1=37.图11直观地显示出了这个 作,由于训练集包含正例 因此白假设自然不出现. 西瓜问题假设空间。 [(色泽=:根彩=:敲舟=可 (色泽一青绿:根蒂=*:敲声■)[《色泽=乌黑:根蒂=:敲声=*)…。 (色泽一青绿:根蒂=婚缩:破尚=·)](色泽=青绿:根蒂一硬挺:敲声一*)… [(色泽=青绿:根蒂=蟋缩:敲声=浊响)(色泽=青绿:根蒂=地缩:敲声=沉闷)】 图1.1西瓜问题的假设空间 可以有许多策略对这个假设空间进行搜索,例如自顶向下、从一般到特殊 或是自底向上、从特殊到一般,搜索过程中可以不断别除与正例不一致的假 设、和(或)与反例一致的假设.最终将会获得与训练集一致(即对所有训练样本 向上同时进行,在操作上 能够进行正确判断)的假设,这就是我们学得的结果 只删除与正例不一致的假 设等 需注意的是,现实问题中我们常面临很大的假设空间,但学习过程是基于 有限样本训练集进行的,因此,可能有多个假设与训练集一致,即存在着一个与 训练集一致的“假设集合”,我们称之为“版本空间”(version space).例如, 在西瓜问题中,与表1.1训练集所对应的版本空间如图12所示

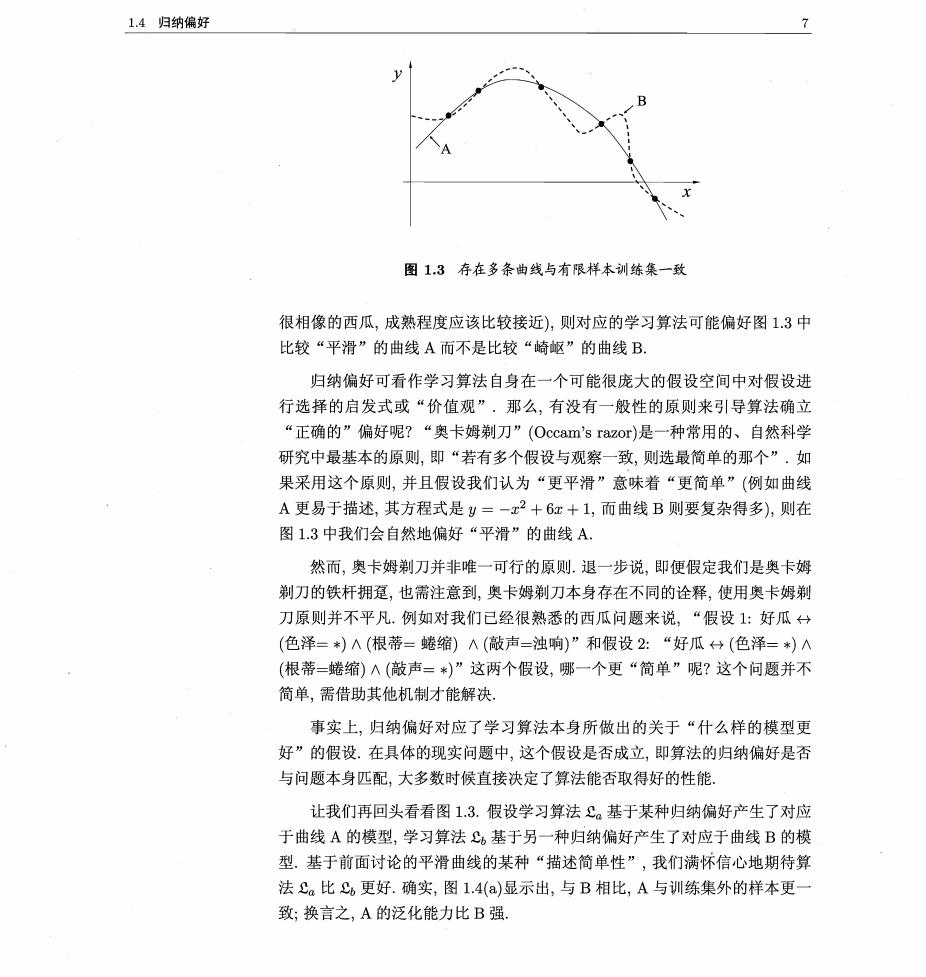

第1章绪论 (色泽=*;根蒂=蟾缩;敲声=*)(色泽=*;根蒂=*;敲声=清脆) (色泽=:根蒂一蜷缩;敲声=清脆) 图12西瓜问题的版本空间 1.4归纳偏好 通过学习得到的模型对应了假设空间中的一个假设.于是,图1.2的西瓜 版本空间给我们带来一个麻烦:现在有三个与训练集一致的假设,但与它们 对应的模型在面临新样本的时候,却会产生不同的输出.例如,对(色泽=青绿 根蒂=蜷缩;敲声=沉闷)这个新收来的瓜,如果我们采用的是“好瓜口(色 泽=*)人(根蒂=蜷缩)Λ(敲声=*)”,那么将会把新瓜判断为好瓜,而如果采 用了另外两个假设,则判断的结果将不是好瓜.那么,应该采用哪一个模型(或 假设)呢? 若仅有表1.1中的训练样本,则无法断定上述三个假设中哪一个“更好” 然而,对于一个具体的学习算法而言,它必须要产生一个模型.。这时,学习算 法本身的“偏好”就会起到关键的作用.例如,若我们的算法喜欢“尽可能特 殊”的模型,则它会选择“好瓜分(色泽=*)Λ(根蒂=蜷缩)A(敲声=浊响)”: 即·用情尽能但若我们的算法喜欢“尽可能一般”的模型,并且由于某种原因它更“相信” 根蒂,则它会选择“好瓜+(色泽=*)Λ(根蒂=蜷缩)A(敲声=*)”,机器学习 算法在学习过程中对某种类型假设的偏好,称为“归纳偏好”(inductive bias) 或简称为“偏好” 关,但需注意的是,机器学 任何一个有效的机器学习算法必有其归纳偏好,否则它将被假设空间中看 习中的特征选择仍是基于 对训练样本的分析进行的, 似在训练集上“等效”的假设所迷惑,而无法产生确定的学习结果.可以想象 而在此处我们并非基于特 如果没有偏好,我们的西瓜学习算法产生的模型每次在进行预测时随机抽选 征选择做出对“根蒂】 重视:这里对 “根薄 的的, 训练集上的等效假设,那么对这个新瓜“(色泽=青绿;根蒂=蜷缩;敲声=沉 的 闷)”,学得模型时而告诉我们它是好的、时而告诉我们它是不好的,这样的学 习结果显然没有意义 参见第11章. 归纳偏好的作用在图1.3这个回归学习图示中可能更直观.这里的每个训 练样本是图中的一个点(,),要学得一个与训练集一致的模型,相当于找到 条穿过所有训练样本点的曲线.显然,对有限个样本点组成的训练集,存在着 很多条曲线与其一致,我们的学习算法必须有某种偏好,才能产出它认为“正 确”的模型.例如,若认为相似的样本应有相似的输出(例如,在各种属性上都

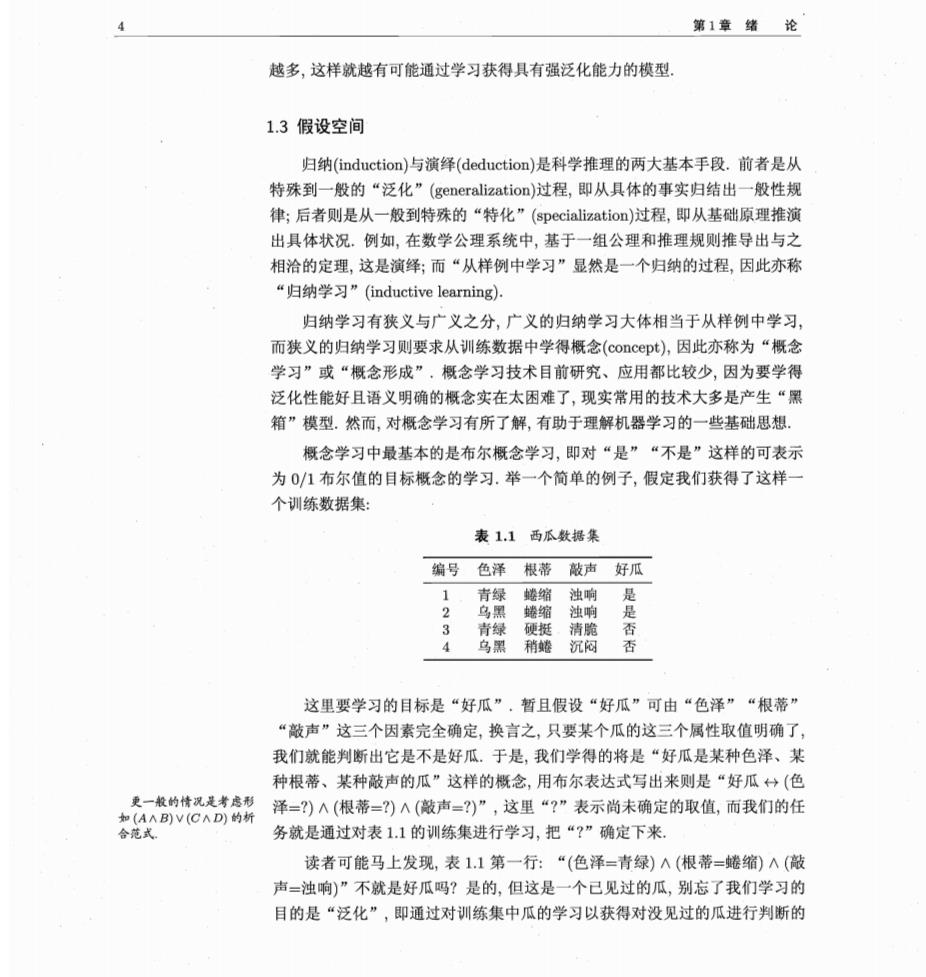

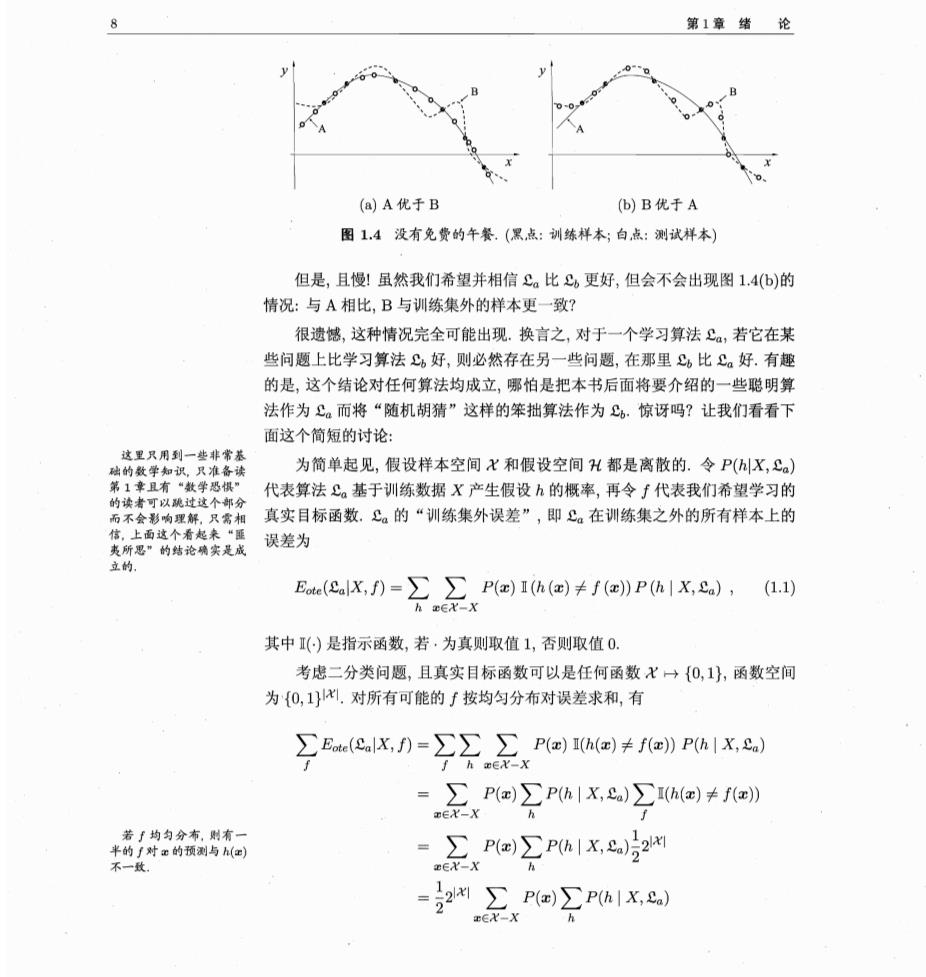

1.4归纳偏好 图13存在多条曲线与有限样本训练集一致 很相像的西瓜,成熟程度应该比较接近),则对应的学习算法可能偏好图1.3中 比较“平滑”的曲线A而不是比较“崎岖”的曲线B 归纳偏好可看作学习算法自身在一个可能很庞大的假设空间中对假设进 行选择的启发式或“价值观”.那么,有没有一般性的原则来引导算法确立 “正确的”偏好呢?“奥卡姆剃刀”(Occam's razor)是一种常用的、自然科学 研究中最基本的原则,即“若有多个假设与观察一致,则选最简单的那个”.如 果采用这个原则,并且假设我们认为“更平滑”意味着“更简单”(例如曲线 A更易于描述,其方程式是y=-x2+6x+1,而曲线B则要复杂得多),则在 图13中我们会自然地偏好“平滑”的曲线A. 然而,奥卡姆剃刀并非唯一可行的原则.退一步说,即便假定我们是奥卡姆 剃刀的铁杆拥趸,也需注意到,奥卡姆剃刀本身存在不同的诠释,使用奥卡姆剃 刀原则并不平凡.例如对我们已经很熟悉的西瓜问题来说,“假设1:好瓜分 (色泽=*)Λ(根蒂=蜷缩)A(敲声=浊响)”和假设2:“好瓜:(色泽=*)Λ (根蒂=蜷缩)Λ(敲声=*)”这两个假设,哪一个更“简单”呢?这个问题并不 简单,需借助其他机制才能解决 事实上,归纳偏好对应了学习算法本身所做出的关于“什么样的模型更 好”的假设.在具体的现实问题中,这个假设是否成立,即算法的归纳偏好是否 与问题本身匹配,大多数时候直接决定了算法能否取得好的性能。 让我们再回头看看图1.3.假设学习算法£。基于某种归纳偏好产生了对应 于曲线A的模型,学习算法基于另一种归纳偏好产生了对应于曲线B的模 型.基于前面讨论的平滑曲线的某种“描述简单性”,我们满怀信心地期待算 法£。比更好.确实,图1.4()显示出,与B相比,A与训练集外的样本更 致;换言之,A的泛化能力比B强

第1章绪论 (a)A优于B (b)B优于A 图1,4没有免费的午餐.(黑点:训练样本;白点:测试样本) 但是,且慢!虽然我们希望并相信£。比C更好,但会不会出现图1,4(b)的 情况:与A相比,B与训练集外的样本更一致? 很遗憾,这种情况完全可能出现.换言之,对于一个学习算法£,若它在某 些问题上比学习算法,好,则必然存在另一些问题,在那里比。好.有趣 的是,这个结论对任何算法均成立,哪怕是把本书后面将要介绍的一些聪明算 法作为£。而将“随机胡猜”这样的笨拙算法作为.惊讶吗?让我们看看下 面这个简短的讨论: 这里只用到一些非常蒸 础的数学知识,只准备读 为简单起见,假设样本空间X和假设空间H都是离散的.令P(X,) 代表算法。基于训练数据X产生假设h的概率,再令∫代表我们希望学习的 ,只需相 真实目标函数.£。的“训练集外误差”,即。在训练集之外的所有样本上的 信,上面这个看起来 夷所思”的结论确实是成 误差为 立的。 Eae(alXf)=∑∑P(e)Ih(e)≠f(o》Ph|X,a),(1.1) h IEX-X 其中1(是指示函数,若·为真则取值1,否则取值0. 考虑二分类问题,且真实目标函数可以是任何函数X→{0,1,函数空间 为{0,1}心.对所有可能的∫按均匀分布对误差求和,有 Ea(calX,f)=∑∑∑P()h()≠fe)Ph|X,&a) 了hxX-X =∑P(m)∑Ph|X,)∑h(a)≠fz》 EX-X h 若均匀分右时有 半的/对的预测与h(】 =∑P(e)∑Ph|X,&)52W 不一 sEX-X h =2州∑P∑Pa1X,) EEX-X h

14归纳偏好 9 =2x-1P(x)1 (1.2) wEY-x 式(12)显示出,总误差竟然与学习算法无关!对于任意两个学习算法£。和 ,我们都有 ∑Eae(calX,f)=∑Ete(clX,f), (1.3) 也就是说,无论学习算法。多聪明、学习算法C多笨拙,它们的期望性能竟 严格的NL定理证明比 然相同!这就是“没有免费的午餐”定理(No Free Lunch Theorem,简称NFL 这里的简化论述繁难得多。 )[Wolpert,1996;Wolpert and Macready,1995]. 这下子,读者对机器学习的热情可能被一盆冷水浇透了:既然所有学习算 法的期望性能都跟随机胡猜差不多,那还有什么好学的? 我们需注意到,NFL定理有一个重要前提:所有“问题”出现的机会相 同、或所有问题同等重要.但实际情形并不是这样.很多时候,我们只关注自 己正在试图解决的问题(例如某个具体应用任务),希望为它找到一个解决方案 至于这个解决方案在别的问题、甚至在相似的问题上是否为好方案,我们并不 关心.例如,为了快速从A地到达B地,如果我们正在考虑的A地是南京鼓 楼、B地是南京新街口,那么“骑自行车”是很好的解决方案;这个方案对A 地是南京鼓楼、B地是北京新街口的情形显然很糟糕,但我们对此并不关心。 事实上,上面NFL定理的简短论述过程中假设了∫的均匀分布,而实际情 形并非如此.例如,回到我们熟悉的西瓜问题,考虑假设1:好瓜分(色泽=*) Λ(根蒂=蜷缩)A(敲声=浊响)}和{假设2:好瓜艹(色泽=*)A(根蒂=硬挺) A(敲声=清脆).从NFL定理可知,这两个假设同样好.我们立即会想到符 合条件的例子,对好瓜(色泽=青绿;根蒂=蜷缩;敲声=浊响)是假设1更好,而 对好瓜(色泽=乌黑;根蒂=硬挺;敲声=清脆)则是假设2更好.看上去的确是 这样.然而需注意到,“(根蒂=蜷缩;敲声=浊响)”的好瓜很常见,而“(根 蒂=硬挺;敲声=清脆)”的好瓜罕见,甚至不存在. 所以,N℉L定理最重要的寓意,是让我们清楚地认识到,脱离具体问题,空 泛地谈论“什么学习算法更好”毫无意义,因为若考虑所有潜在的问题,则所 有学习算法都一样好.要谈论算法的相对优劣,必须要针对具体的学习问题;在 某些问题上表现好的学习算法,在另一些问题上却可能不尽如人意,学习算法 自身的归纳偏好与问题是否相配,往往会起到决定性的作用

10 第1章绪论 1.5发展历程 机器学习是人工智能(artificial intelligence)研究发展到一定阶段的必然产 物.二十世纪五十年代到七十年代初,人工智能研究处于“推理期”,那时人们 以为只要能赋予机器逻辑推理能力,机器就能具有智能.这一阶段的代表性工 作主要有A.Newell和H.Simon的“逻辑理论家”(Logic Theorist)程序以及 此后的“通用问题求解”(General Problem Solving)程序等,这些工作在当时 取得了令人振奋的结果.例如,“逻辑理论家”程序在1952年证明了著名数学 家罗素和怀特海的名著《数学原理》中的38条定理,在1963年证明了全部52 条定理,特别值得一提的是,定理2.85甚至比罗素和怀特海证明得更巧妙.A Newell和H.Simon因为这方面的工作获得了1975年图灵奖.然而,随着研究 向前发展,人们逐渐认识到,仅具有逻辑推理能力是远远实现不了人工智能的. E.A.Feigenbaum等人认为,要使机器具有智能,就必须设法使机器拥有知识, 所谓“知识就是力量” 在他们的倡导下,从二十世纪七十年代中期开始,人工智能研究进入了“知识 1965年.Feigenbaum主 持研制了世界上第一个专 期”,在这一时期,大量专家系统问世,在很多应用领域取得了大量成果.E.A 家系统DENDRAL Feigenbaum作为“知识工程”之父在1994年获得图灵奖.但是,人们逐渐认 识到,专家系统面临“知识工程瓶颈”,简单地说,就是由人来把知识总结出来 再教给计算机是相当困难的.于是,一些学者想到,如果机器自己能够学习知识 该多好! 事实上,图灵在1950年关于图灵测试的文章中,就曾提到了机器学习的可 能:二十世纪五十年代初已有机器学习的相关研究,例如A.Samuel著名的跳 泰见p,22 棋程序.五十年代中后期,基于神经网络的“连接主义”(connectionism)学习 开始出现,代表性工作有F.Rosenblatt的感知机(Perceptron)、B.Widrow的 Adaline等.在六七十年代,基于逻辑表示的“符号主义”(symbolism)学习技 术蓬勃发展,代表性工作有P.Winston的“结构学习系统”、R.S.Michalski 等人的“基于逻辑的归纳学习系统”、E.B.Hut等人的“概念学习系统” 等;以决策理论为基础的学习技术以及强化学习技术等也得到发展,代表性工 作有N.J.Nlso加的“学习机器”等;二十多年后红极一时的统计学习理论的 些奠基性结果也是在这个时期取得的. 1980年夏,在美国卡耐基梅隆大学举行了第一届机器学习研讨会(IWML) 同年,《策略分析与信息系统》连出三期机器学习专辑;1983年,Tioga出版社 出版了R.S.Michalski、J.G.Carbonell和T.Mitchell主编的《机器学习:一 种人工智能途径》Michalski et al,.1983],对当时的机器学习研究工作进行了 总结;1986年,第一本机器学习专业期刊Machine Learning创f刊;1989年,人