第7卷第4期 智能系统学报 Vol.7 No.4 2012年8月 CAAI Transactions on Intelligent Systems Aug.2012 D0I:10.3969/j.issn.16734785.201203003 网络出版地址:htp:/nw.cnki.net/kcma/detail/23.1538.TP.20120712.1041.005.html 视觉关注转移的事件检测算法 张丽坤,孙建德,李静2 (1.山东大学信息科学与工程学院,山东济南250100;2.山东省工会管理千部学院信息工程学院,山东济南250100) 摘要:智能监控系统已广泛应用于银行、超市、公交车等公共场合,监控视频的事件检测已经成为智能监控中的关 键技术.提出了一种基于视觉关注转移的事件检测方法,该方法首先分别通过对视频帧进行动态和静态受关注模型 的提取得到视觉关注显著图,然后根据视觉关注显著图的时域特性形成视觉关注节奏曲线,根据视觉关注节奏的变 化强度选取关键顿,以关键顿形式表示受关注事件的发生.实验结果表明,算法提取的关键帧可以准确地标示监控 视频中特征事件的发生,并且可以做到实时地检测事件. 关键词:智能监控:事件检测:事件发生;视觉关注模型:视觉关注节奏;关键帧提取 中图分类号:TP18;TN911.73文献标志码:A文章编号:16734785(2012)04033306 Event detection based on visual attention shift ZHANG Likun',SUN Jiande',LI Jing? (1.School of Information Science and Engineering,Shandong University,Ji'nan 250100,China;2.School of Information Engineer- ing,Shandong Institute of Trade Unions'Administration Cadres,Ji'nan 250100,China) Abstract:Intelligent surveillance systems have been widely used in banks,supermarkets,buses,and other public places.Event detection in a surveillance video is a key technology for this field.In this paper,a visual attention shift-based event detection algorithm was proposed for intelligent surveillance in which the dynamic and static visual attention regions were detected to obtain the visual saliency map.After that,the visual attention rhythm was derived from the visual saliency map temporally.According to the visual attention rhythm,the key frames were selected to label the occurrence of the events.Experimental results demonstrate that the proposed algorithm can label the oc- currence of the events with the extracted key frames correctly,and that the event detection is performed in real- time. Keywords:intelligent surveillance;event detection;occurrence of event;visual attention model;visual attention rhythm:key frame extraction 随着社会对公共安全要求的不断提升,监控系 的智能化还未达到一定程度的情况下,大多数监控 统在银行、商场、高速公路、公交车、地铁站等各种公 视频中的事件检测,主要是靠保安人员不间断地观 共场所的应用越来越普遍.监控系统的智能化将有 看来实现.特别是在大型监控平台的环境中,通常配 助于遏制一些恶性事件或是危险情况的进一步发 备专职监控人员对监控视颜进行实时监控,监控人 展.对突发事件做出及时的处理,对整个社会的公共 员需要同时监视一定数量的监控屏幕,这使得监控 安全有着非常重要的意义.但是,在现阶段监控系统 人员很难长时间保持较高的注意力,并且达到多个 屏幕无遗漏的人工监控.在这样的情况下,如何能够 收稿日期:20120302.网络出版日期:201207-12. 使监控系统对所有监控场景中发生的受关注事件不 基金项目:国家自然科学基金资助项目(61001180) 通信作者:孙建德.E-mail:jd_sun@sdu.edn,cm. 遗漏地、实时地发出警报,以提示监控人员进行特别

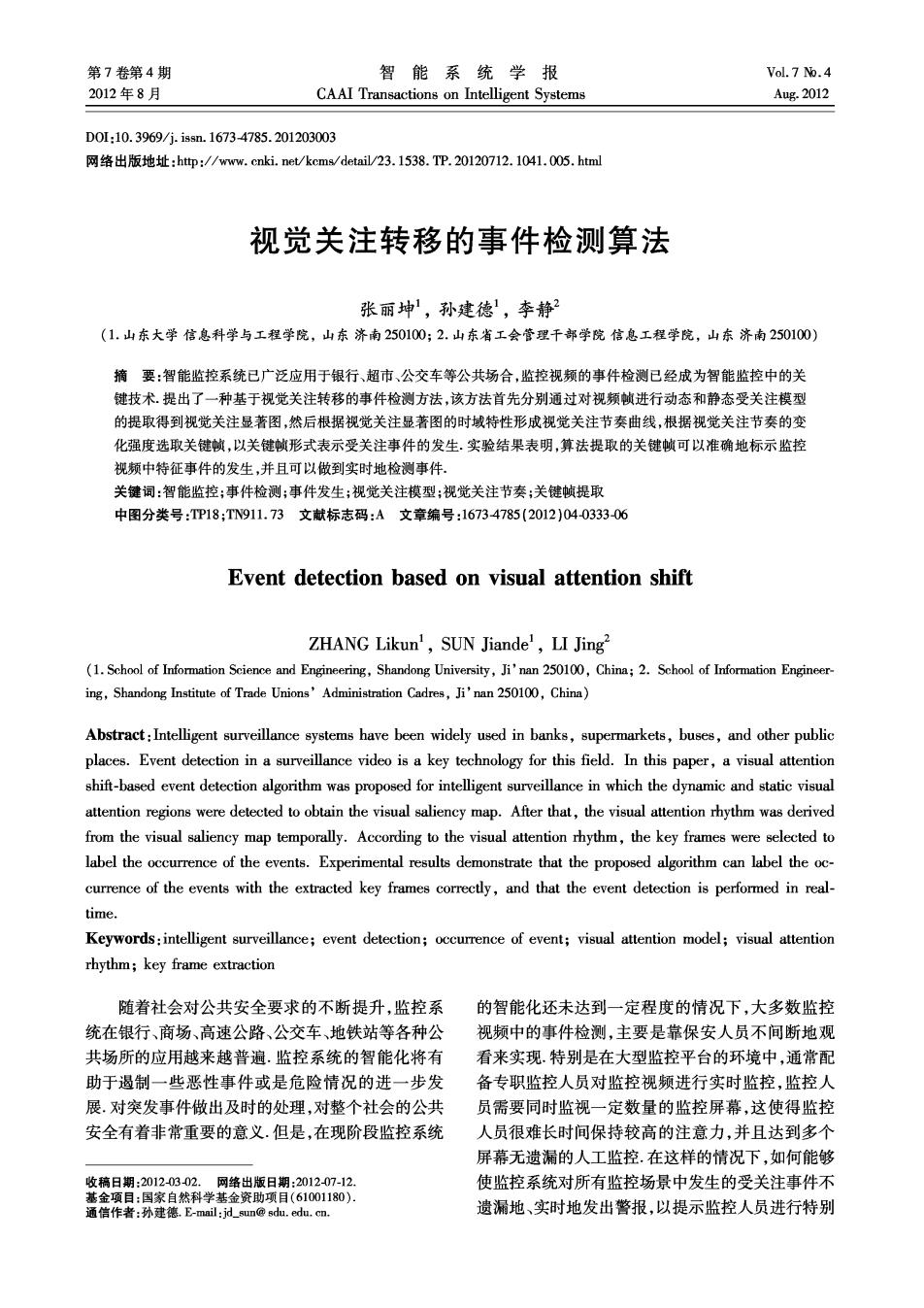

·334 智能系统学报 第7卷 关注,成为了智能监控中非常具有实际应用价值的 频中事件的发生.图1是提出的监控视频事件检测 研究问题. 算法框图 近年来,随着智能视频监控越来越多地受到重 运动受关 视,监控视频中的事件检测技术研究已经取得很大进 区域检测 输入 觉 关键 展.Jiang等采取了对目标的检测和追踪的方法,将单 视频 关锭顿 节 选取 懒序 一物体的运动轨迹定义为视频的一个事件,通过轨迹 序列 形成 降态受关 线聚类来区分正常事件和非正常事件.但是这种定义 这域检测 忽略了视频的一些时间和空间信息[.Liu等提出了 受关 报警 一种基于运动方向统计的异常事件检测方法,他们通 事件 提示 过对视频中的连续帧进行分析,采用颜色、纹理、运动 图1监控视频事件检测算法 等低级特征对视频中的事件进行描述,进而从监控视 Fig.1 The framework of the proposed event detec- 频中辨别出异常事件.但是,仅仅靠低级特征表征视 tion algorithm of surveillance video 频中的事件是远远不够的,需要采用基于人类视觉系 2 统的高级语义特征才能对视频内容进行最准确的描 算法分析 述2].因此,研究者们开始从视觉关注的角度来弥补 2.1 视觉关注模型 视频的高级语义特征和低级语义特征之间的鸿沟。 视觉关注是视觉信息处理过程中一个非常重要 Jiang等提出由视觉关注值表征人眼对视频内容的关 的方面.当视网膜拥有整个场景时,注意力只集中在 注程度的方法,他们采用K均值聚类,选出视觉关注 一个或为数很少的几个区域,这几个区域就是图像 值最高的帧作为关键帧,以关键帧来描述视频中事件 的受关注区域,它们代表了人眼的视觉关注点,而受 的内容).Lai等则通过运动、颜色、纹理等特征,形成 关注区域的提取是建立在视觉关注模型基础之上 静止和运动相结合的显著图,从而形成视觉关注曲 的.视觉关注模型是根据人的视觉注意机制而建立 的模型,它利用视觉注意机制得到图像中最容易引 线;然后利用时间限制的聚类方法来提取关键帧从而 起注意的显著区域,并通过将这些显著区域的显著 表征视频中的事件[4.这些方法在视频中的事件检测 性用灰度值表示来构成显著图 和事件描述方面都取得了较好的结果,但是这些方法 研究表明,人类的视觉感知系统对于静止图像 大多需要对整段视频进行分析,因此很难达到事件的 中差异明显的区域更为关注,对于图像序列中运动 实时检测 的部分也更加关注.因此,将视频的动态关注模型和 针对上述问题,文章从人的视觉关注特性出发, 静态关注模型结合形成最终的视觉关注模型,通过 将视觉关注的转移作为事件检测的依据,针对现有的 视觉关注模型来提取视频帧中的受关注区域。 大多数算法在突发事件检测实时性方面的局限性,提 2.1.1动态关注模型 出了一种关键帧触发的、能够对视频内容的变化准确 由于人眼往往对运动的目标更加关注,同时运 描述的事件检测方法.该方法将视觉上动态和静态的 动目标能够体现视频在时域上的信息,所以动态关 视觉关注模型进行融合,通过视觉关注模型来提取视 注模型的提取过程实际上就是对视频序列中运动目 频帧中的受关注区域,根据连续帧中的最受关注区域 标的检测过程.在运动目标的检测过程中,使用文献 的变化来确定人眼视觉关注点的转移,形成视频关注 [3]中所提到的基于块的LK光流算法计算视频各 节奏,根据关注节奏的变化强度来选取关键帧,通过 帧的光流,同时为了弥补运动目标检测中出现的阴 关键帧表明事件发生的时刻,从而触发对受关注事件 影问题,在LKtm光流算法的基础上,应用混合高 的提示.实验结果表明,根据文章提出的算法提取的 斯背景建模技术,得到每帧的运动前景G 关键帧能够准确地表示监控视频中特征事件的开始 将LK光流算法得到的运动区域跟混合高斯背景 时刻,并且关键帧的提取是实时的 建模技术获得的运动前景进行膨胀和腐蚀运算,然后 进行归一化形成最终的动态关注模型T。: 1事件检测算法 T=dilatation(LKmi,G), (1) Tm=erosion(T). (2) 关键帧是指从原始视频中提取的能够代表视频 式中:T是二值图像,运动区域的像素值为1,静止 内容的图像集合,它常被用于视频检索及视频摘要 区域的像素值为0. 领域5),而文中提取的关键帧则是用来表征监控视

第4期 张丽坤,等:视觉关注转移的事件检测算法 ·335· 2.1.2静态关注模型 这里用图像块平均灰度值代表这个图像块的受关注 静态关注模型的加入主要是从视频的空间信息 程度,均值越大,这个块的受关注程度越高. 考虑的.监控视频中各帧的静态关注模型S的提取 3)以均值最大的块为中心,通过区域扩展形成 方法为:首先对视频帧进行多尺度变换,在不同尺度 一个最优的矩形区域作为视觉关注区域。这个矩形 上提取颜色、亮度、纹理等低级特征的局部对照特 区域要满足矩形面积最小且局部平均像素值最大的 征,然后根据局部对照特征形成特征图,并将形成的 要求.这样就可以获得第1个视觉受关注区域, 特征图进行全局归一化,最后将归一化后的特征图 在选择最优矩形区域R,时,采用文献[8]中的 进行线性结合,得到最终的显著图[ 方法: 2.1.3运动优先融合 动态关注模型和静态关注模型需要结合在一起, 如果a≥T,扩展R,直到os,视频序列中的 值的变化来表征视觉关注的转移 动态关注优于静态关注,这时动态关注在视频帧的 当aw1(i)>aw2(i)&a2(i+1)>aw1(i+1)或 视觉关注中占主导地位;当mean(Tm)∈(0.768,1] 者aw2(i)>am1(i)&aw1(i+1)>am2(i+1)时,表示 时,0r<0s,静态关注优于动态关注,这时视频帧的 在第i帧时刻发生了视觉转移,此时将第i+1帧选 视觉关注由静态关注主导, 出作为关键帧的候选帧,这里aw,(i)和aw2(i)表示 这样就可以得到符合人眼视觉关注的视频帧的 第帧选出的2个受关注区域的均值. 最终视觉显著图Saliency: 5)获得视觉关注节奏曲线,定义视觉转移量来 Saliency wr x Tm ws x S.m 表示视觉转移程度的大小,视觉转移量是指视觉转 显著图Saliency的像素值归一化到0~1内.其中 移之前,视觉关注保持在某一关注区域的时间,它可 1表示受关注度最高,0表示受关注度最低 以用视频中没有视觉转移发生的这段时间内视频的 2.2视觉关注转移 帧数来表示: 根据人眼的转移机制,人眼关注点的转移意味 着有特征事件的出现。因此,首先要找到视觉显著图 8.()=d,T∈N 中局部最受关注的区域,然后再根据连续帧中的最 式中:T是没有视觉转移发生的一段时间内出现的 受关注区域的变化来确定人眼视觉关注点的转移, 视频帧数,N是正整数或零,6,()为第i帧出现时刻 从而选定关键帧的候选帧,具体步骤如下: 的视觉转移量. 1)将视频帧的最终视觉显著图分成无重叠的、 视频当前帧选出的2个关注区域的均值与前一 大小为8×8的块, 帧选出的2个关注区域的均值相比没有发生变化 2)计算每块的均值,并找到均值最大的块.在 时,视觉转移量为零;若发生变化,视觉转移量累加

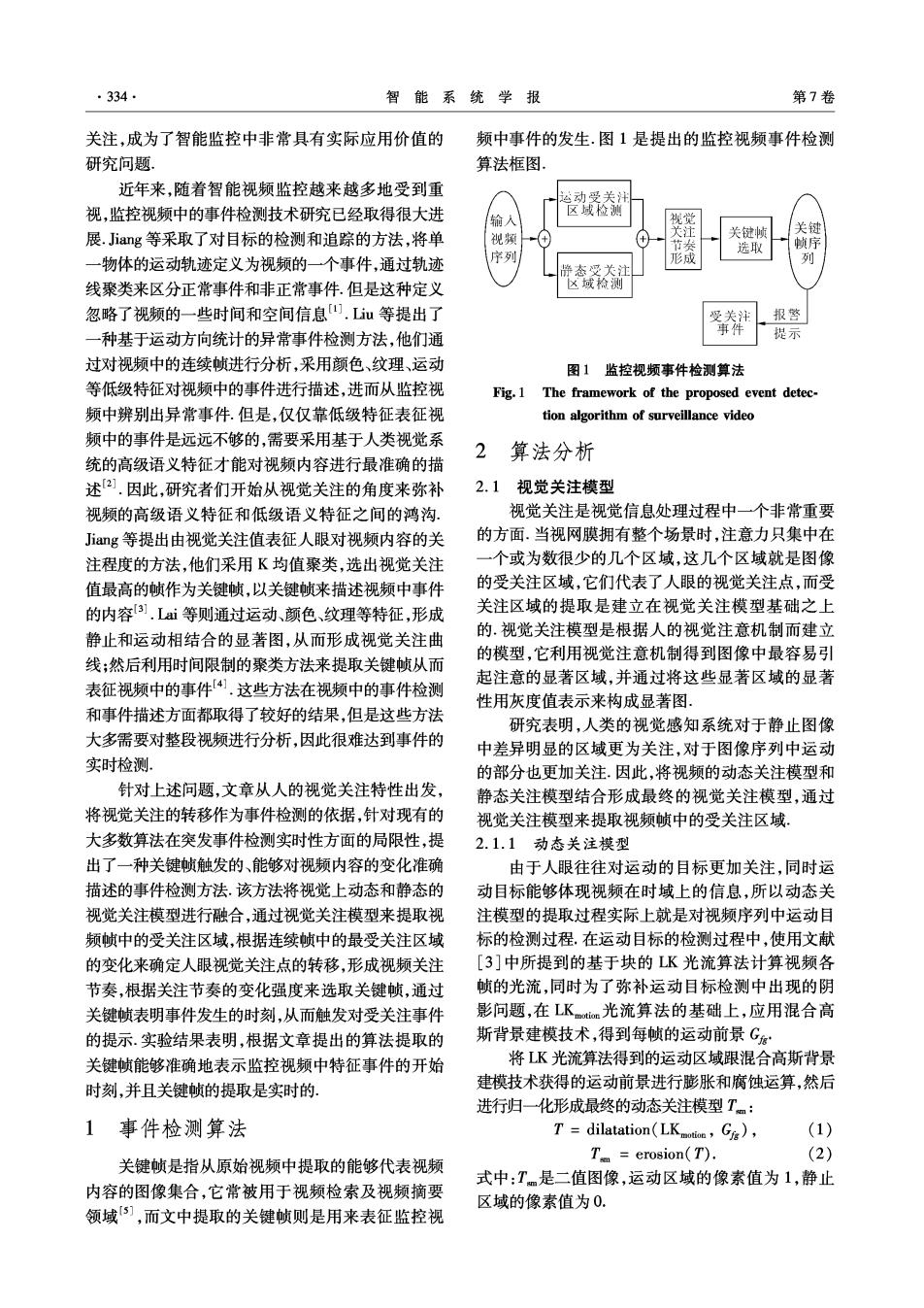

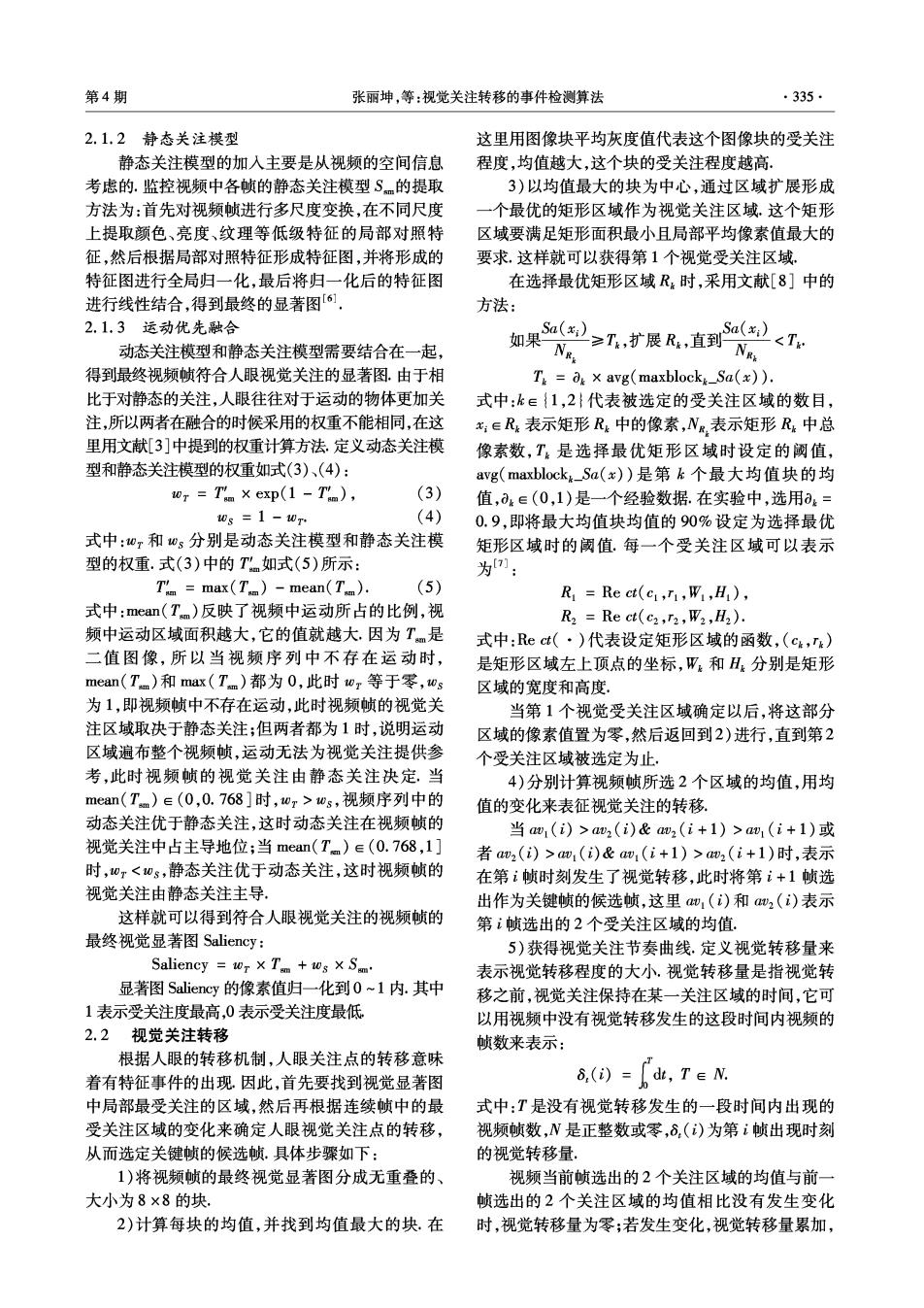

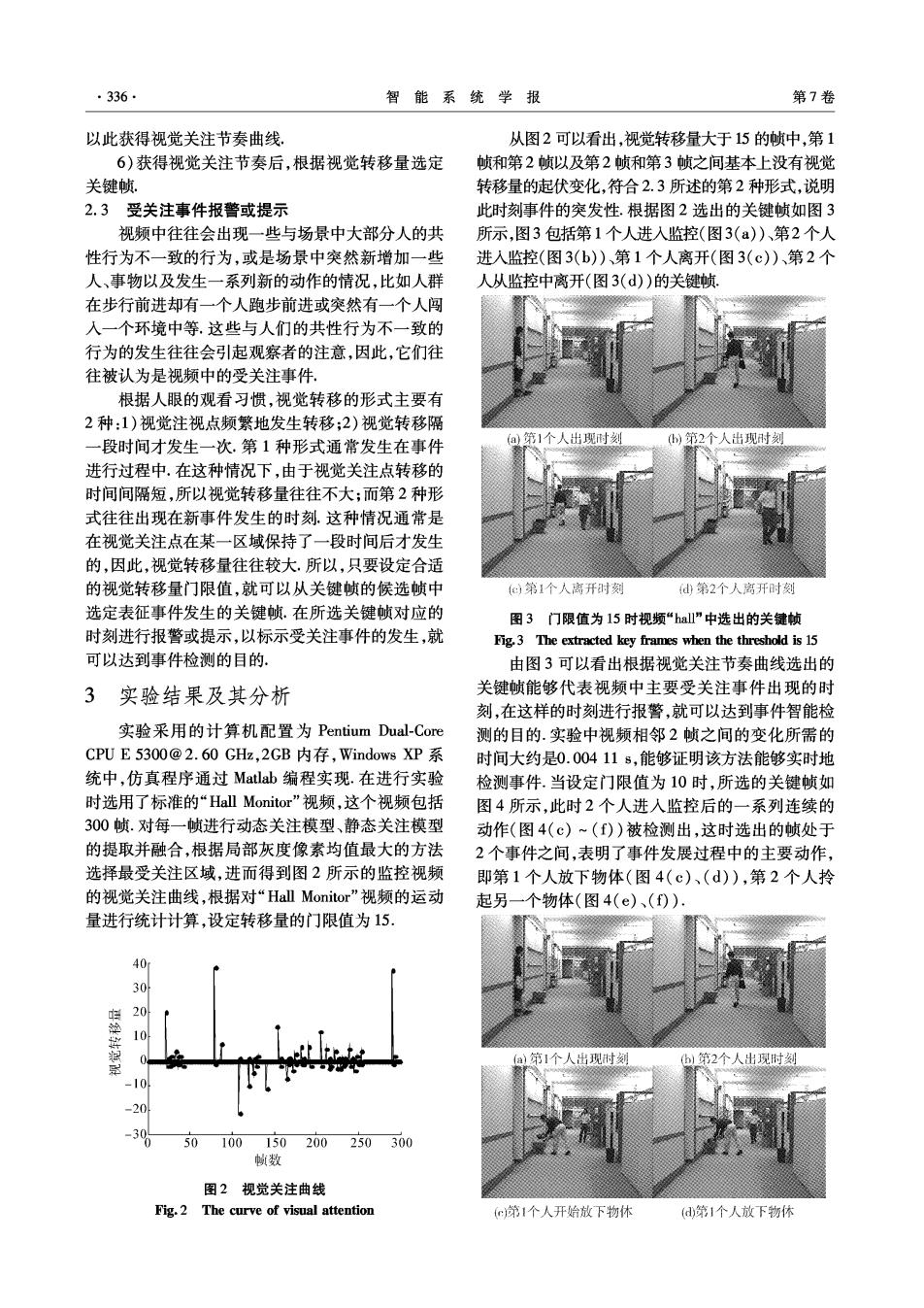

·336 智能系统学报 第7卷 以此获得视觉关注节奏曲线。 从图2可以看出,视觉转移量大于15的帧中,第1 6)获得视觉关注节奏后,根据视觉转移量选定 帧和第2帧以及第2帧和第3帧之间基本上没有视觉 关键帧. 转移量的起伏变化,符合2.3所述的第2种形式,说明 2.3受关注事件报警或提示 此时刻事件的突发性.根据图2选出的关键帧如图3 视频中往往会出现一些与场景中大部分人的共 所示,图3包括第1个人进入监控(图3(a))、第2个人 性行为不一致的行为,或是场景中突然新增加一些 进人监控(图3(b)、第1个人离开(图3(c)、第2个 人、事物以及发生一系列新的动作的情况,比如人群 人从监控中离开(图3(d))的关键帧 在步行前进却有一个人跑步前进或突然有一个人闯 入一个环境中等.这些与人们的共性行为不一致的 行为的发生往往会引起观察者的注意,因此,它们往 往被认为是视频中的受关注事件 根据人眼的观看习惯,视觉转移的形式主要有 2种:1)视觉注视点频繁地发生转移;2)视觉转移隔 段时间才发生一次.第1种形式通常发生在事件 a第1个人出现时刻 )第2个人出现时刻 进行过程中.在这种情况下,由于视觉关注点转移的 时间间隔短,所以视觉转移量往往不大;而第2种形 式往往出现在新事件发生的时刻,这种情况通常是 在视觉关注点在某一区域保持了一段时间后才发生 的,因此,视觉转移量往往较大.所以,只要设定合适 的视觉转移量门限值,就可以从关键帧的候选帧中 (e)第1个人离开时刻 d第2个人离开时刻 选定表征事件发生的关键帧.在所选关键帧对应的 图3门限值为l5时视频“hall”中选出的关键顿 时刻进行报警或提示,以标示受关注事件的发生,就 Fig.3 The extracted key frames when the threshold is 15 可以达到事件检测的目的, 由图3可以看出根据视觉关注节奏曲线选出的 3实验结果及其分析 关键帧能够代表视频中主要受关注事件出现的时 刻,在这样的时刻进行报警,就可以达到事件智能检 实验采用的计算机配置为Pentium Dual-.Core 测的目的.实验中视频相邻2帧之间的变化所需的 CPUE5300@2.60GHz,2GB内存,Windows XP系 时间大约是0.00411s,能够证明该方法能够实时地 统中,仿真程序通过Matlab编程实现.在进行实验 检测事件.当设定门限值为10时,所选的关键帧如 时选用了标准的“Hall Monitor”视频,这个视频包括 图4所示,此时2个人进人监控后的一系列连续的 300帧.对每一帧进行动态关注模型、静态关注模型 动作(图4(c)~(f))被检测出,这时选出的帧处于 的提取并融合,根据局部灰度像素均值最大的方法 2个事件之间,表明了事件发展过程中的主要动作, 选择最受关注区域,进而得到图2所示的监控视频 即第1个人放下物体(图4(c)、(d)),第2个人拎 的视觉关注曲线,根据对“Hall Monitor'”视频的运动 起另一个物体(图4(e)、(f)) 量进行统计计算,设定转移量的门限值为15, 40 30 10 (a)第1个人出现时刻! )第2个人出现时刻 30 100150200250300 帧数 图2视觉关注曲线 Fig.2 The curve of visual attention c第1个人开始放下物休 (第1个人放下物体

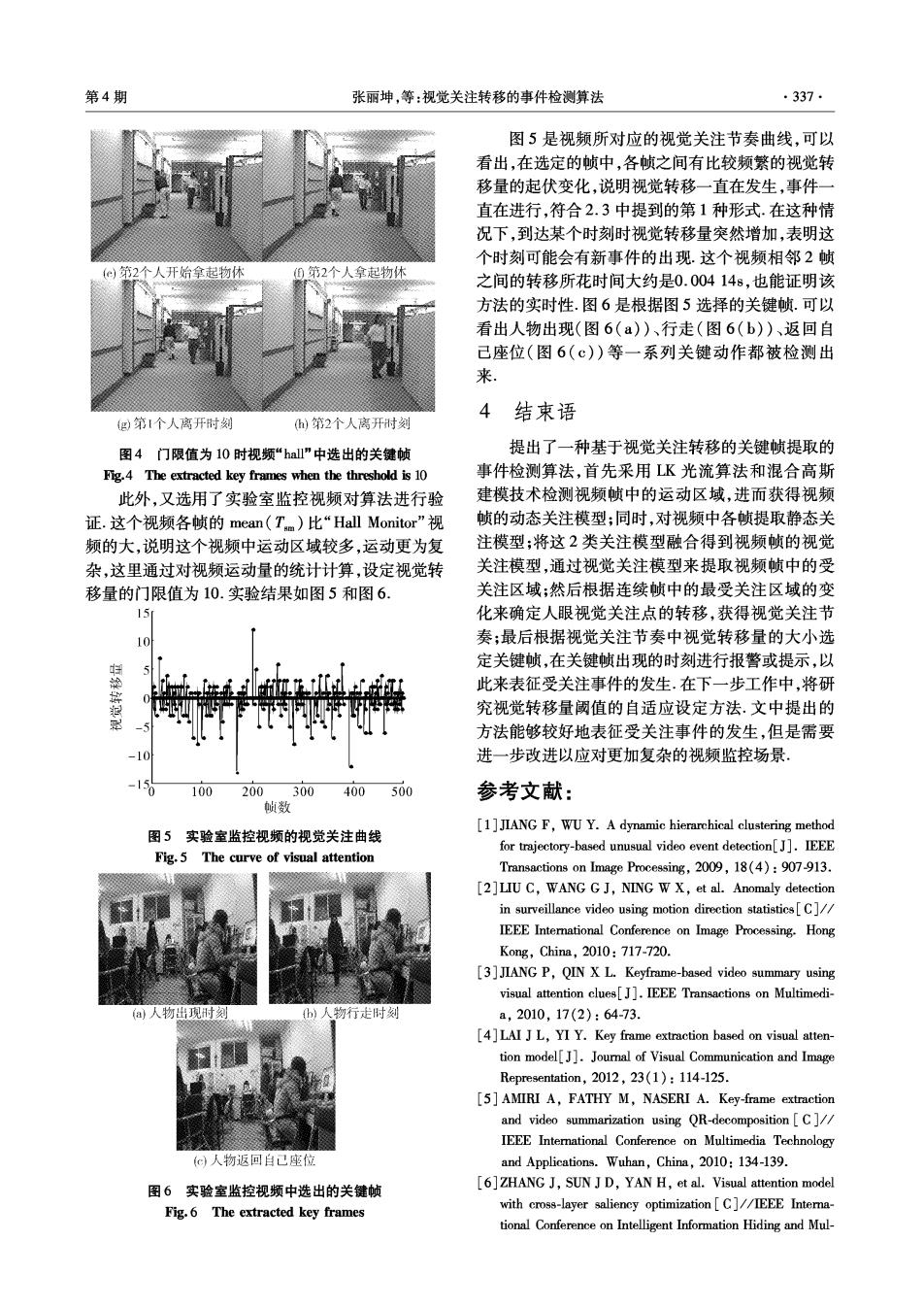

第4期 张丽坤,等:视觉关注转移的事件检测算法 ·337· 图5是视频所对应的视觉关注节奏曲线,可以 看出,在选定的帧中,各帧之间有比较频繁的视觉转 移量的起伏变化,说明视觉转移一直在发生,事件一 直在进行,符合2.3中提到的第1种形式.在这种情 况下,到达某个时刻时视觉转移量突然增加,表明这 个时刻可能会有新事件的出现.这个视频相邻2帧 ()第2个人开始拿起物休 ⑨第2个人拿起物休 之间的转移所花时间大约是0.00414s,也能证明该 方法的实时性.图6是根据图5选择的关键帧.可以 看出人物出现(图6(a)、行走(图6(b))、返回自 己座位(图6(c))等一系列关键动作都被检测出 来 4 g)第1个人离开时刻 )第2个人离开时刻 结束语 图4门限值为10时枧频“hall"中选出的关键帧 提出了一种基于视觉关注转移的关键帧提取的 Fig.4 The extracted key frames when the threshold is 10 事件检测算法,首先采用LK光流算法和混合高斯 此外,又选用了实验室监控视频对算法进行验 建模技术检测视频帧中的运动区域,进而获得视频 证.这个视频各帧的mean(Tm)比“Hall Monitor'”视 帧的动态关注模型;同时,对视频中各帧提取静态关 频的大,说明这个视频中运动区域较多,运动更为复 注模型;将这2类关注模型融合得到视频帧的视觉 杂,这里通过对视频运动量的统计计算,设定视觉转 关注模型,通过视觉关注模型来提取视频帧中的受 移量的门限值为10.实验结果如图5和图6. 关注区域;然后根据连续帧中的最受关注区域的变 15 化来确定人眼视觉关注点的转移,获得视觉关注节 奏;最后根据视觉关注节奏中视觉转移量的大小选 定关键帧,在关键帧出现的时刻进行报警或提示,以 此来表征受关注事件的发生.在下一步工作中,将研 究视觉转移量阈值的自适应设定方法.文中提出的 方法能够较好地表征受关注事件的发生,但是需要 进一步改进以应对更加复杂的视频监控场景。 100 200300400500 参考文献: 帧数 [1]JIANG F,WU Y.A dynamic hierarchical clustering method 图5实验室监控视频的视觉关注曲线 for trajectory-based unusual video event detection[J].IEEE Fig.5 The curve of visual attention Transactions on Image Processing,2009,18(4):907-913. [2]LIU C,WANG G J,NING W X,et al.Anomaly detection in surveillance video using motion direction statistics[C] IEEE International Conference on Image Processing.Hong Kong,China,2010:717-720. [3]JIANG P,QIN X L.Keyframe-based video summary using visual attention clues[J].IEEE Transactions on Multimedi- a人物出现刑烫 )人物行走时刻 a,2010,17(2):64-73. [4]LAI J L,YI Y.Key frame extraction based on visual atten- tion model[J].Joural of Visual Communication and Image Representation,2012,23(1):114-125. [5]AMIRI A,FATHY M,NASERI A.Key-frame extraction and video summarization using QR-decomposition [C]// IEEE International Conference on Multimedia Technology G)人物返回自己座位 and Applications.Wuhan,China,2010:134-139. 图6实验室监控视频中选出的关键帧 [6]ZHANG J,SUN J D,YAN H,et al.Visual attention model Fig.6 The extracted key frames with cross-layer saliency optimization [C]//IEEE Intera- tional Conference on Intelligent Information Hiding and Mul-

·338· 智能系统学报 第7卷 timedia Signal Processing.Dalian,China,2011:240-243. 孙建德,男,1978年生,副教授.主 [7]ITTI L,KOCH C,NIEBUR E.A model of saliency based 要研究方向为基于内容的多媒体分析、 visual attention for rapid scene analysis[J].IEEE Transac- 基于视觉关注模型的图像/视频分析、 tions on Pattern Analysis and Machine Intelligence,1998, 图像/视频复制检测、多媒体信息内容 20(11):1254-1259. 安全和数字水印等.承担及完成科研项 [8]RUBINSTEIN M,SHAMIR A,AVIDAN S.Multi-operator 目10余项,授权发明专利8项,发表学 media retargeting[J].ACM Transactions on Graphics, 术论文40余篇. 2009,23(3):1-8. 作者简介: 李静,女,1979年生,主要研究方向 张丽坤,女,1986年生,硕士研究 为多媒体通信。 生,主要研究方向为多媒体信号处理. 第9届国际机器学习和数据挖掘会议 9th International Conference on Machine Learning and Data Mining (MLDM)2013 The aim of the conference is to bring together researchers from all over the world who deal with machine learning and data mining in order to discuss the recent status of the research and to direct further developments.Basic re- search papers as well as application papers are welcome. All kinds of applications are welcome but special preference will be given to multimedia related applications,bio- medical applications,and webmining.MLDM'2013 is the 9th event in a series of MLDM events that have been o- riginally started out as a workshop. Web site:http://www.mldm.de/