第12卷第5期 智能系统学报 Vol.12 No.5 2017年10月 CAAI Transactions on Intelligent Systems 0ct.2017 D0I:10.11992/tis.201706012 网络出版地址:htp:/kns.cmki.net/kcms/detail/23.1538.TP.20170831.1051.002.html 融合语义信息的矩阵分解词向量学习模型 陈培,景丽萍 (北京交通大学交通数据分析与挖掘北京市重点实验室,北京100044) 摘要:词向量在自然语言处理中起着重要的作用,近年来受到越来越多研究者的关注。然而,传统词向量学习方 法往往依赖于大量未经标注的文本语料库,却忽略了单词的语义信息如单词间的语义关系。为了充分利用已有领 域知识库(包含丰富的词语义信息),文中提出一种融合语义信息的词向量学习方法(KbEMF),该方法在矩阵分解学 习词向量的模型上加入领域知识约束项,使得拥有强语义关系的词对获得的词向量相对近似。在实际数据上进行 的单词类比推理任务和单词相似度量任务结果表明,KbEMF比已有模型具有明显的性能提升。 关键词:自然语言处理:词向量:矩阵分解:语义信息:知识库 中图分类号:TP391文献标志码:A文章编号:1673-4785(2017)05-0661-07 中文引用格式:陈培,景丽萍.融合语义信息的矩阵分解词向量学习模型[J].智能系统学报,2017,12(5):661-667. 英文引用格式:CHEN Pei,JING Liping..Word representation learning model using matrix factorization to incorporate semantic information [J].CAAI transactions on intelligent systems,2017,12(5):661-667. Word representation learning model using matrix factorization to incorporate semantic information CHEN Pei,JING Liping (Beijing Key Lab of Traffic Data Analysis and Mining,Beijing Jiaotong University,Beijing 100044,China) Abstract:Word representation plays an important role in natural language processing and has attracted a great deal of attention from many researchers due to its simplicity and effectiveness.However,traditional methods for learning word representations generally rely on a large amount of unlabeled training data,while neglecting the semantic information of words,such as the semantic relationship between words.To sufficiently utilize knowledge bases that contain rich semantic word information in existing fields,in this paper,we propose a word representation learning method that incorporates semantic information(KbEMF).In this method,we use matrix factorization to incorporate field knowledge constraint items into a learning word representation model,which identifies words with strong semantic relationships as being relatively approximate to the obtained word representations.The results of word analogy reasoning tasks and word similarity measurement tasks obtained using actual data show the performance of KbEMF to be superior to that of existing models. Keywords:natural language processing;word representation;matrix factorization;semantic information; knowledge base 词向量是单词在实数空间所表示的一个低维 分析、机器翻译等。在处理上述任务的过程中通常 连续向量,它能够同时捕获单词的语义信息和语法 需要用到更大单位级别(如短语、句子、段落、篇章) 信息。近年来,词向量已被广泛地应用于各种各样 的向量表示,这些向量则可以由词向量组合获得。 的自然语言处理任务中-)],如命名实体识别、情感 因此学习优质的词向量非常重要。 现有的词向量学习方法是利用单词的上下文 收稿日期:2017-06-06.网络出版日期:2017-08-31. 基金项目:国家自然科学基金项目(61370129,61375062,61632004). 信息预测该单词含义,并且使上下文信息相似的单 通信作者:景丽葬.E-mial:pjing(@bjtu.cdu.cn. 词含义也相似,因此对应的词向量在空间距离上更

第 12 卷第 5 期 智 能 系 统 学 报 Vol.12 №.5 2017 年 10 月 CAAI Transactions on Intelligent Systems Oct. 2017 DOI:10.11992 / tis.201706012 网络出版地址:http: / / kns.cnki.net / kcms/ detail / 23.1538.TP.20170831.1051.002.html 融合语义信息的矩阵分解词向量学习模型 陈培,景丽萍 (北京交通大学 交通数据分析与挖掘北京市重点实验室,北京 100044) 摘 要:词向量在自然语言处理中起着重要的作用,近年来受到越来越多研究者的关注。 然而,传统词向量学习方 法往往依赖于大量未经标注的文本语料库,却忽略了单词的语义信息如单词间的语义关系。 为了充分利用已有领 域知识库(包含丰富的词语义信息),文中提出一种融合语义信息的词向量学习方法(KbEMF),该方法在矩阵分解学 习词向量的模型上加入领域知识约束项,使得拥有强语义关系的词对获得的词向量相对近似。 在实际数据上进行 的单词类比推理任务和单词相似度量任务结果表明,KbEMF 比已有模型具有明显的性能提升。 关键词:自然语言处理;词向量;矩阵分解;语义信息;知识库 中图分类号:TP391 文献标志码:A 文章编号:1673-4785(2017)05-0661-07 中文引用格式:陈培,景丽萍.融合语义信息的矩阵分解词向量学习模型[J]. 智能系统学报, 2017, 12(5): 661-667. 英文引用格式:CHEN Pei, JING Liping. Word representation learning model using matrix factorization to incorporate semantic information [J]. CAAI transactions on intelligent systems, 2017, 12(5): 661-667. Word representation learning model using matrix factorization to incorporate semantic information CHEN Pei, JING Liping (Beijing Key Lab of Traffic Data Analysis and Mining, Beijing Jiaotong University, Beijing 100044, China) Abstract:Word representation plays an important role in natural language processing and has attracted a great deal of attention from many researchers due to its simplicity and effectiveness. However, traditional methods for learning word representations generally rely on a large amount of unlabeled training data, while neglecting the semantic information of words, such as the semantic relationship between words. To sufficiently utilize knowledge bases that contain rich semantic word information in existing fields, in this paper, we propose a word representation learning method that incorporates semantic information (KbEMF). In this method, we use matrix factorization to incorporate field knowledge constraint items into a learning word representation model, which identifies words with strong semantic relationships as being relatively approximate to the obtained word representations. The results of word analogy reasoning tasks and word similarity measurement tasks obtained using actual data show the performance of KbEMF to be superior to that of existing models. Keywords: natural language processing; word representation; matrix factorization; semantic information; knowledge base 收稿日期:2017-06-06. 网络出版日期:2 基金项目:国家自然科学基金项目(61370 词向量是单词在实数空间所表示的一个低维 连续向量,它能够同时捕获单词的语义信息和语法 信息。 近年来,词向量 12 0 9 17 ,6 - 1 0 3 8 7 - 5 3 0 1 通信作者:景丽萍.E⁃mial: lpjing@ bjtu.edu.cn. 已被广泛地应用于各种各样 的自然语言处理任务中[1-5] ,如命名实体识别、情感 分析、机器翻译等。 在处理上述任务的过程中通常 需要用到更大单位级别(如短语、句子、段落、篇章) 的向量表示,这些向量则可以由词向量组合获得。 因此学习优质的词向量非常重要。 有的词向量学习方法是利用单词的上下文 6 . 2,61632004) 信息 现 预测该单词含义,并且使上下文信息相似的单 词含义也相似,因此对应的词向量在空间距离上更 .

.662. 智能系统学报 第12卷 靠近。现有的词向量学习方法大致可以分为基于 学习过程中,提出了高质量的词向量联合学习模型 神经网络学习词向量和基于矩阵分解学习词向量。 RCM。Liu等[1通过在训练skip-gram模型过程中 基于神经网络学习词向量是根据上下文与目标单 加入单词相似性排序信息约束词向量学习,提出了 词之间的关系建立语言模型,通过训练语言模型获 SWE模型,该模型通过单词间的3种语义关系,即 得词向量[6-1]。但有效词向量的获取是建立在训练 近反义关系、上下位关系及类别关系获取单词相似 大规模文本语料库的基础上,这无疑使计算成本很 性排序信息。Faruqui等[0)采用后处理的方式调整 高。近年来提出的CBOW和skip-gram模型去除 已经预先训练好的词向量,提出了Retro模型,该模 了神经网络结构中非线性隐层,使算法复杂度大大 型可以利用任意知识库信息调整由任意词向量模 降低,并且也获得了高效的词向量。CBOW根据上 型训练好的词向量,而无需重新训练词向量。 下文预测目标单词,skip-gam根据目标单词预测上 以上研究都是通过拓展神经网络词向量学习 下文单词。基于矩阵分解的词向量学习模型3-) 模型构建的。与之不同,本文提出的KbEMF模型 是通过分解从文本语料库中提取的矩阵(如共现矩 是基于矩阵分解学习词向量。该模型以ⅱ等)提 阵或由共现矩阵生成的PMI矩阵)得到低维连续的 出的EMF模型为框架加人领域知识约束项,使具有 词向量,并且文献[13]和文献[14]证明了矩阵分解 较强语义关系的词对学习到的词向量在实数空间 的词向量学习模型与skip-gram完全等价。 中的距离更近,也就是更加近似。与Faruqui等采 上述模型学习的词向量已被有效地应用于自 用后处理方式调整训练好的词向量方式不同, 然语言处理任务中,然而这些模型在学习词向量的 KbEMF是一个同时利用语料库和知识库学习词向 过程中仅使用了文本语料库信息,却忽略了单词间 量的联合模型,并且在单词类比推理和单词相似度 的语义信息。一旦遇到下列情形很难保证所得词 量两个实验任务中展示了它的优越性。 向量的质量:1)含义不同甚至完全相反的单词 (good/bad)往往出现在相似的上下文中,那么它们 1 矩阵分解词向量学习模型相关背景 的词向量必然十分相似,这明显与现实世界相悖; KbEMF模型是通过扩展矩阵分解词向量学习 2)对于两个含义相似的单词,其中一个出现在语料 模型构建的,本节介绍有关矩阵分解学习词向量涉 库中的次数极少,另外一个却频繁出现,或者它们 及的背景知识。 出现在不同的上下文中,那么最终它们学得的词向 矩阵分解给定一个矩阵X,矩阵分解的目标 量会有很大差别:3)大量上下文噪音的存在使学得 在于找到两个低秩的矩阵Y和Z,使得X≈YZ,因 的词向量不能准确反映出单词间的真实关系,甚至 此矩阵分解的目标函数可以用min叱(X,YZ)公式来 会误导整个词向量的训练过程。 表示,其中(表示将矩阵X近似分解为Z与Y的乘 为解决上述问题,本文考虑从领域知识库提取 积造成的损失。不同的损失函数得到不同的矩阵 语义信息并融入到词向量学习的过程中。这会给 分解模型,例如,非负矩阵分解21、概率矩阵分 词向量的学习带来下列优势。 解2]、最大边界矩阵分解] 首先,知识库明确定义了单词的语义关系 共现矩阵对于一个特定的训练语料库T,V (knife/fork都属于餐具,animal/dog具有范畴包含 是从该语料库中提取的全部单词生成的词汇表,当 关系等),引入这些语义关系约束词向量的学习,使 上下文窗口设定为L时,对任意的w:∈V,它的上下 学到的词向量具有更准确的关系。另外,相似单词 文单词为0-L,…,01,0#1,…,w+L,则共现矩阵X 出现在不同的上下文中或者出现频次存在较大差 的每个元素值#(0,c)表示0和c的共现次数,即上 异带来的词向量偏差问题,都可以通过知识库丰富 下文单词c出现在目标单词0上下文中的次数, 的语义信息予以修正。再者,知识库是各领域的权 威专家构建的,具有更高的可靠性。因此,引入语 #(o)=∑#(0,c)表示出现在0上下文中全部c 义信息约束词向量的学习是很有必要的。 的次数。同样地,#(c)=∑(0,c)表示c作为 目前融合语义信息学习词向量已有一些研究 上下文出现在语料库中的次数。 成果。Bian等[16)利用单词结构信息、语法信息及语 EMF模型skip-gram模型学得的词向量在多 义信息学习词向量,并取得了良好的效果。Xu 项自然语言处理任务中都取得了良好的表现,却没 等[)分别给取自于知识库的两类知识信息(R-NET 有清晰的理论原理解释。由此,EMF从表示学习的 和C-NET)建立正则约束函数,并将它们与skp 角度出发,重新定义了skip-am模型的目标函数, ram模型联合学习词向量,提出了RC-NET模型。 将其精确地解释为矩阵分解模型,把词向量解释为 Yu等[8]将单词间的语义相似信息融入到CBOW的 softmax损失下显示词向量d,关于表示字典C的一

靠近。 现有的词向量学习方法大致可以分为基于 神经网络学习词向量和基于矩阵分解学习词向量。 基于神经网络学习词向量是根据上下文与目标单 词之间的关系建立语言模型,通过训练语言模型获 得词向量[6-12] 。 但有效词向量的获取是建立在训练 大规模文本语料库的基础上,这无疑使计算成本很 高。 近年来提出的 CBOW 和 skip⁃gram 模型[11]去除 了神经网络结构中非线性隐层,使算法复杂度大大 降低,并且也获得了高效的词向量。 CBOW 根据上 下文预测目标单词,skip⁃gram 根据目标单词预测上 下文单词。 基于矩阵分解的词向量学习模型[13-15] 是通过分解从文本语料库中提取的矩阵(如共现矩 阵或由共现矩阵生成的 PMI 矩阵)得到低维连续的 词向量,并且文献[13]和文献[14]证明了矩阵分解 的词向量学习模型与 skip⁃gram 完全等价。 上述模型学习的词向量已被有效地应用于自 然语言处理任务中,然而这些模型在学习词向量的 过程中仅使用了文本语料库信息,却忽略了单词间 的语义信息。 一旦遇到下列情形很难保证所得词 向量的质量: 1) 含义不同甚至完全相反的单词 (good / bad)往往出现在相似的上下文中,那么它们 的词向量必然十分相似,这明显与现实世界相悖; 2)对于两个含义相似的单词,其中一个出现在语料 库中的次数极少,另外一个却频繁出现,或者它们 出现在不同的上下文中,那么最终它们学得的词向 量会有很大差别;3)大量上下文噪音的存在使学得 的词向量不能准确反映出单词间的真实关系,甚至 会误导整个词向量的训练过程。 为解决上述问题,本文考虑从领域知识库提取 语义信息并融入到词向量学习的过程中。 这会给 词向量的学习带来下列优势。 首先, 知 识 库 明 确 定 义 了 单 词 的 语 义 关 系 (knife / fork 都属于餐具,animal / dog 具有范畴包含 关系等),引入这些语义关系约束词向量的学习,使 学到的词向量具有更准确的关系。 另外,相似单词 出现在不同的上下文中或者出现频次存在较大差 异带来的词向量偏差问题,都可以通过知识库丰富 的语义信息予以修正。 再者,知识库是各领域的权 威专家构建的,具有更高的可靠性。 因此,引入语 义信息约束词向量的学习是很有必要的。 目前融合语义信息学习词向量已有一些研究 成果。 Bian 等[16]利用单词结构信息、语法信息及语 义信息学习 词 向 量, 并 取 得 了 良 好 的 效 果。 Xu 等[17]分别给取自于知识库的两类知识信息(R⁃NET 和 C⁃NET) 建立正则约束函数,并将它们与 skip⁃ gram 模型联合学习词向量,提出了 RC⁃NET 模型。 Yu 等[18]将单词间的语义相似信息融入到 CBOW 的 学习过程中,提出了高质量的词向量联合学习模型 RCM。 Liu 等[19]通过在训练 skip⁃gram 模型过程中 加入单词相似性排序信息约束词向量学习,提出了 SWE 模型,该模型通过单词间的 3 种语义关系,即 近反义关系、上下位关系及类别关系获取单词相似 性排序信息。 Faruqui 等[20]采用后处理的方式调整 已经预先训练好的词向量,提出了 Retro 模型,该模 型可以利用任意知识库信息调整由任意词向量模 型训练好的词向量,而无需重新训练词向量。 以上研究都是通过拓展神经网络词向量学习 模型构建的。 与之不同,本文提出的 KbEMF 模型 是基于矩阵分解学习词向量。 该模型以 Li 等[13] 提 出的 EMF 模型为框架加入领域知识约束项,使具有 较强语义关系的词对学习到的词向量在实数空间 中的距离更近,也就是更加近似。 与 Faruqui 等采 用后处 理 方 式 调 整 训 练 好 的 词 向 量 方 式 不 同, KbEMF 是一个同时利用语料库和知识库学习词向 量的联合模型,并且在单词类比推理和单词相似度 量两个实验任务中展示了它的优越性。 1 矩阵分解词向量学习模型相关背景 KbEMF 模型是通过扩展矩阵分解词向量学习 模型构建的,本节介绍有关矩阵分解学习词向量涉 及的背景知识。 矩阵分解 给定一个矩阵 X,矩阵分解的目标 在于找到两个低秩的矩阵 Y 和 Z,使得 X≈YZ,因 此矩阵分解的目标函数可以用 min Y,Z ζ(X,YZ) 公式来 表示,其中 ζ 表示将矩阵 X 近似分解为 Z 与 Y 的乘 积造成的损失。 不同的损失函数得到不同的矩阵 分解模型, 例如, 非负矩阵分解[21] 、 概率矩阵分 解[22] 、最大边界矩阵分解[23] 。 共现矩阵 对于一个特定的训练语料库 T,V 是从该语料库中提取的全部单词生成的词汇表,当 上下文窗口设定为 L 时,对任意的 wi∈V,它的上下 文单词为wi-L ,…,wi-1 ,wi+1 ,…,wi+L ,则共现矩阵 X 的每个元素值#(w,c)表示 w 和 c 的共现次数,即上 下文单词 c 出现在目标单词 w 上下文中的次数, #(w) =∑c∈V #(w,c) 表示出现在 w 上下文中全部 c 的次数。 同样地, #(c) =∑w∈V #(w,c) 表示 c 作为 上下文出现在语料库中的次数。 EMF 模型 skip⁃gram 模型学得的词向量在多 项自然语言处理任务中都取得了良好的表现,却没 有清晰的理论原理解释。 由此,EMF 从表示学习的 角度出发,重新定义了 skip⁃gram 模型的目标函数, 将其精确地解释为矩阵分解模型,把词向量解释为 softmax 损失下显示词向量 dw 关于表示字典 C 的一 ·662· 智 能 系 统 学 报 第 12 卷

第5期 陈培,等:融合语义信息的矩阵分解词向量学习模型 ·663· 个隐表示,并直接显式地证明了skip-gram就是分解 tr(w S.w)tr(W S.W)-2tr(W'SW)= 词共现矩阵学习词向量的模型。这一证明为进一 tr(w'(S.+S-25)W) 步推广及拓展skip-gram提供了坚实理论基础。 最终所得语义约束模型为 EMF目标函数用(1)式表示: R=tr(W(S.+S-2s)W) (2) minw,wC)=-t(NCwW+∑.e(∑e) 式中:r(·)表示矩阵的迹;S,表示语义矩阵S第i 行全部元素值的加和,即S的第i行和:S,表示语义 (1) 矩阵S第j列全部元素值的加和,即S的第j列和; 式中:X为共现矩阵;W为单词矩阵:C为上下文矩 Sm表示以S:为对角元素值的对角矩阵,S表示以 阵,V中单词、上下文单词c对应的词向量构成W S,为对角元素值的对角矩阵。 和C的列向量,d.为单词w所在X列的列向量。 2.3模型融合 Sn=S.,1×S.2X…×S×…XS,m,表示S的笛卡尔 将语义约束模型R与EMF相结合,得到融合语 乘积,Sc={0,1,…,k #(w)#(c)k是一个 义信息的矩阵分解词向量学习模型KEMF: ∑.cev#(0,c) 参数。 0=-tr(x"c"w)+∑n(∑erc)+ wEV X'ES。 2融合语义信息的矩阵分解词向量学 ytr(W'(S +S-2S)W) (3) 式中y是语义组合权重,表示语义约束模型在联合 习模型 模型中所占的比重大小。y在词向量学习过程中扮 2.1提取语义信息并构建语义矩阵 演相当重要的角色,该参数设置值过小时会弱化先 本文选择WordNet做先验知识库。WordNet是 验知识对词向量学习的影响,若过大则会破坏词向 一个覆盖范围较广的英语词汇语义网,它把含义相 量学习的通用性,无论哪种情况都不利于词向量的 同的单词组织在同义词集合中,每个同义词集合都 学习。该模型目标在于最小化目标函数0,采用变 代表一个基本的语义概念,并且这些集合之间也由 量交替迭代策略求取最优解。当Y=0时表示没有 各种关系(例如整体部分关系、上下文关系)连接。 融合语义信息,即为EMF模型。 本文基于同义词集合及集合间的关系词构建 2.4模型求解 一个语义关系矩阵S∈Rx",它的每一个元素S,= 目标函数,即式(3)不是关于C和W的联合凸 S(:,w)表示词汇表V中第i个单词w:与第j个单 函数,但却是关于C或W的凸函数,因此本文采用 词心,之间的语义相关性。如果S,=0表示单词:与 被广泛应用于矩阵分解的变量交替迭代优化策略 w没有语义相关性,反之S,≠0则表示单词w:与0 求取模型的最优解。分别对C、W求偏导数,得到 具有相关性。简单起见,本文将语义关系矩阵S构 =(ExIc-)W 30 (4) 建成0-1矩阵,如果单词w:与w:具有上述语义关系 则令Sa=1,否则S:=0。 aW=C(ExIcmX-x)+(L+L)W (5) a 2.2构建语义约束模型 本文构建语义约束模型的前提是具有语义相 式中:L=S+S-2S;Ex1cwX位于w行c列的值是 关性的词对心:、心,学到的词向量更相似,在实数空 EncIwX(w,c)=Q(w,c)o(cTw),Q位于w行c列的 间中有更近的距离,本文采用向量的欧氏距离作为 值是Q(0,c)=k0)#(C+#(,0),0)= #(0,c) 度量词对相似程度的标尺,即d(w:,w)= 1+。。本文的优化更新策略为 1 w:一w,?。因此,语义约束模型可以表示为 R=∑Sg‖小w:-w,2= W-W+n[C(ExcTwX -X)+y(L+L)W] 是5w+听g-2) (6) C←C+n[(Ex1cmwX-X)W] (7) 在一次循环中先对W迭代更新,直到目标函数 O对W收敛为止,然后对C迭代更新,再次使目标 Sw0:+若s"w-22S和%= 函数O对C收敛,至此一次循环结束,依此循环下 I= 去直到最终目标函数关于C和W都收敛为止

个隐表示,并直接显式地证明了skip⁃gram就是分解 词共现矩阵学习词向量的模型。 这一证明为进一 步推广及拓展 skip⁃gram 提供了坚实理论基础。 EMF 目标函数用(1)式表示: minW,C ζ(X,WC)= -tr X T C T ( W) +∑w∈V ln ∑X′w∈Sw e X′ T wC T w ( ) (1) 式中:X 为共现矩阵;W 为单词矩阵;C 为上下文矩 阵,V 中单词 w、上下文单词 c 对应的词向量构成 W 和 C 的列向量,dw 为单词 w 所在 X 列的列向量。 Sw = Sw,1 ×Sw,2 ×…×Sw,c ×…×Sw,| V| ,表示 Sw,c的笛卡尔 乘积, Sw,c = { 0, 1, …, k #(w)#(c) ∑w,c∈V #(w,c) } k 是一个 参数。 2 融合语义信息的矩阵分解词向量学 习模型 2.1 提取语义信息并构建语义矩阵 本文选择 WordNet 做先验知识库。 WordNet 是 一个覆盖范围较广的英语词汇语义网,它把含义相 同的单词组织在同义词集合中,每个同义词集合都 代表一个基本的语义概念,并且这些集合之间也由 各种关系(例如整体部分关系、上下文关系)连接。 本文基于同义词集合及集合间的关系词构建 一个语义关系矩阵 S ∈ R V×V ,它的每一个元素Sij = S(wi,wj) 表示词汇表 V 中第 i 个单词wi 与第 j 个单 词 wj 之间的语义相关性。 如果 Sij = 0 表示单词wi 与 wj 没有语义相关性,反之 Sij ≠ 0 则表示单词 wi 与wj 具有相关性。 简单起见,本文将语义关系矩阵 S 构 建成 0-1 矩阵,如果单词 wi 与wj 具有上述语义关系 则令 Sij = 1,否则 Sij = 0。 2.2 构建语义约束模型 本文构建语义约束模型的前提是具有语义相 关性的词对 wi、wj 学到的词向量更相似,在实数空 间中有更近的距离,本文采用向量的欧氏距离作为 度 量 词 对 相 似 程 度 的 标 尺, 即 d wi,wj ( ) = wi - wj 2 。 因此,语义约束模型可以表示为 R = ∑wi ,wj∈V Sij wi - wj 2 = ∑ V i,j = 1 Sij(w T i wi + w T j wj - 2 w T i wj) = ∑ V i =1 (∑ V j =1 Sij) w T i wi +∑ V j =1 (∑ V i =1 Sij) w T j wj - 2∑ V i, j =1 Sij w T i wj = ∑ V i = 1 Siw T i wi + ∑ V j = 1 Sjw T j wj - 2∑ V i,j = 1 Sij w T i wj = tr(W T SrowW) + tr(W T ScolW) - 2tr(W T SW) = tr(W T (Srow + Scol - 2S)W) 最终所得语义约束模型为 R = tr(W T (Srow + Scol - 2S)W) (2) 式中:tr(·)表示矩阵的迹; Si 表示语义矩阵 S 第 i 行全部元素值的加和,即 S 的第 i 行和; Sj 表示语义 矩阵 S 第 j 列全部元素值的加和,即 S 的第 j 列和; Srow表示以 Si 为对角元素值的对角矩阵,Scol表示以 Sj 为对角元素值的对角矩阵。 2.3 模型融合 将语义约束模型 R 与 EMF 相结合,得到融合语 义信息的矩阵分解词向量学习模型 KbEMF: O =- tr X T C T ( W) + ∑w∈V ln ∑X′w∈Sw e X′ T wC T w ( ) + γtr(W T (Srow + Scol - 2S)W) (3) 式中 γ 是语义组合权重,表示语义约束模型在联合 模型中所占的比重大小。 γ 在词向量学习过程中扮 演相当重要的角色,该参数设置值过小时会弱化先 验知识对词向量学习的影响,若过大则会破坏词向 量学习的通用性,无论哪种情况都不利于词向量的 学习。 该模型目标在于最小化目标函数 O,采用变 量交替迭代策略求取最优解。 当 γ = 0 时表示没有 融合语义信息,即为 EMF 模型。 2.4 模型求解 目标函数,即式(3)不是关于 C 和 W 的联合凸 函数,但却是关于 C 或 W 的凸函数,因此本文采用 被广泛应用于矩阵分解的变量交替迭代优化策略 求取模型的最优解。 分别对 C、W 求偏导数,得到 ∂O ∂C = (EX CTW X - X) W T (4) ∂O ∂W = C(EX CTW X - X) + γ(L + L T )W (5) 式中:L = Srow +Scol -2S;EX| CTW X 位于 w 行 c 列的值是 EX| CTW X(w,c) = Q(w,c)σ c T ( w) ,Q 位于 w 行 c 列的 值 是 Q(w,c) = k #(w)#(c) #(w,c) + #(w,c),σ (x) = 1 1 + e -x 。 本文的优化更新策略为 W ← W + η C(EX| CTW X - X) + γ(L + L T [ )W] (6) C ← C + η[ (EX CTW X - X) W T ] (7) 在一次循环中先对 W 迭代更新,直到目标函数 O 对 W 收敛为止,然后对 C 迭代更新,再次使目标 函数 O 对 C 收敛,至此一次循环结束,依此循环下 去直到最终目标函数关于 C 和 W 都收敛为止。 第 5 期 陈培,等:融合语义信息的矩阵分解词向量学习模型 ·663·

·664. 智能系统学报 第12卷 算法KbEMF算法的伪代码 3.2实验设置 输入共现矩阵X,语义关系矩阵S,学习率7, 下列实验展示了由KEMF获取的词向量在不 最大迭代次数K,k: 同任务中的性能表现。为保持实验效果的一致性, 输出Wx,Cx 所有模型设置相同的参数。词向量维数统一设置 1)随机初始化:W。,C。 为200,学习率设置为6×10-7,上下文窗口为5,迭 2)fori=1toK,执行 代次数设置为300。 3)W=W- 另外,语义组合权重的大小也对实验有重要影 4)forj=1tok,执行 响。对于单词类比推理和单词相似度量任务本文 5)W.=W+n[W-(ExI W-W)+y(L+L) 均采取相同的实验策略寻找最佳语义组合权重,下 w] 面以单词类比推理任务为例详细说明最佳语义组 6)j=j+1 7)C:=C- 合权重找寻的实验过程。设定y∈[0.01,100],首 先实验y=0.01,0.1,1,10,100的单词推理正确率, 8)forj=1tok,执行 9)C:=C:+(ExIcwX-X)W: 如图1(b)所示,y=0.01,0.1,1时KbEMF没有提 升实验效果,因为语义信息所起作用太小:在y= 10)j=j+1 11)i=i+1 100时KbEMF实验效果反而更差,这是过分强调语 义信息破坏了词向量的通用性:只有在y=10时 3实验与结果 KbEMF效果较好,则最佳语义组合权重在y=10附 本节主要展示融合语义信息后获取的词向量 近的可能性最大。然后在y∈[1,10]和y∈[10, 在单词类比推理和单词相似度量任务上的性能表 100]采取同样的策略继续寻找下去,最终会得到最 现。首先介绍实验数据集及实验设置,然后分别描 佳组合权重。实验结果表明,不同任务在不同词频 述每个实验的任务和结果,并分析实验结果。 下的最优语义组合权重也不同。 3.1数据集 3.3单词类比推理 本实验选择Ewik9'作为训练语料库,经过去 给出一个问题a:b:c:d,a、b、c、d各表示一 除原始语料库中HTML元数据、超链接等预处理操 个单词其中d是未知的,类比推理任务的目标在 作后,得到一个词汇量将近13亿的训练数据集。然 于找到一个最合适的d使得a,b,c,d的词向量 后通过设置单词过滤词频限制词汇表的大小,把低 满足vec(d)与vec(b)-vec(a)+vec(c)的余弦距 于设定过滤词频的单词剔除词汇表,因此,不同过 离最近。例如,语义推理Germary:Berlin:: 滤词频产生不同大小的词汇表。 France:d,则需要找出一个向量vec(d),使它与 本实验选用WordNet2作为知识库,WordNet2有 vec(Berlin)-vec(Germary)+vec(France)最近似, 120000同义词集合,其中包含150000单词。本文 如果vec(d)对应的d是Paris则推理正确。同 借助JWI从WordNet2中抽取单词间的语义关系: 理,又如语法推理quick:quickly:slow:d,如果找 同一个同义词集合内单词对的同义关系,以及不同 到d是slowly则推理正确。该实验任务的评价指 集合间单词对的上下位关系。 标是推理出单词d的正确率,正确率越高,则 不同的实验任务所用的测试数据集也不相同。 在单词类比推理任务中,本文使用的测试集为 KbEMF学得的词向量越好。 谷歌查询数据集(Google query dataset),该数据集 本实验评估了不同参数设置对KbEMF模型影 包含19544个问题,共14种关系类型,其中5种语 响,图1是词频为6000次时,分别改变模型中词向 义关系,9种语法关系。在单词相似度量任务中,本 量维度及语义组合权重所绘制的。 文使用下列3个数据集:Luong等2使用的稀有单 从图1(a)可以看出,词向量维度小于200时, 词,Finkelstein等2]使用的Wordsim-353(WS353) 随着词向量维度增加单词推理正确率在提升,词向 数据集(RW),Huang等[o发布的上下文单词相似 量维度在200~350之间实验效果趋向于稳定,因此 数据集(SCWS)。它们分别包含2003、2034、353个 在同时兼顾实验速度与效果的情况下,本文选择学 单词对及相应的人工标注的相似度分值。 习200维度的词向量

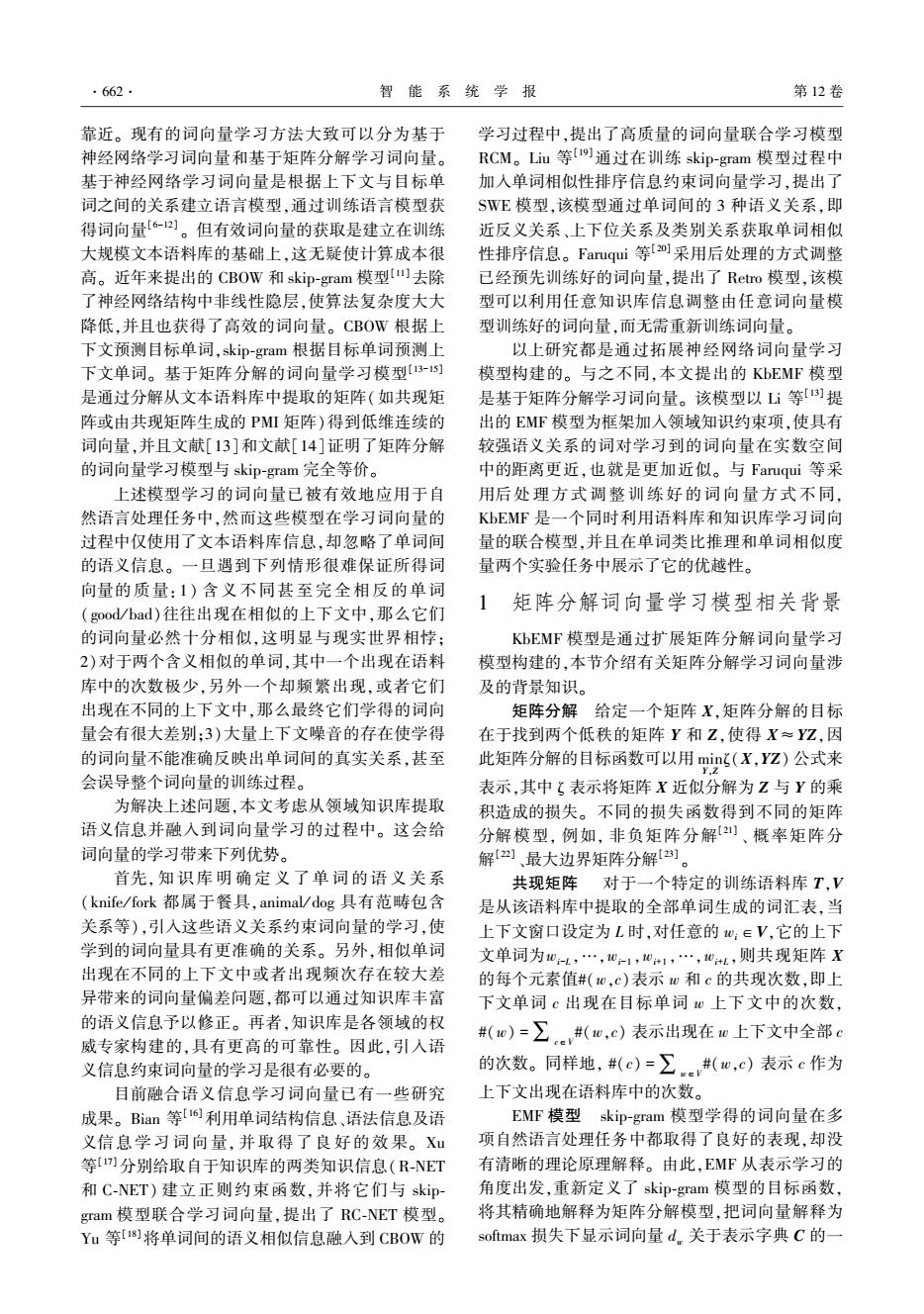

算法 KbEMF 算法的伪代码 输入 共现矩阵 X,语义关系矩阵 S,学习率 η, 最大迭代次数 K,k; 输出 WK ,CK 。 1)随机初始化: W0 ,C0 2)for i = 1 to K,执行 3)Wi =Wi-1 4)for j = 1 to k, 执行 5) Wi = Wi + η[Wi-1 EX CT ( i-1WiW - W) + γ(L + L T ) Wi ] 6)j = j+1 7) Ci = Ci-1 8)for j = 1 to k, 执行 9) Ci = Ci + η EX C T i Wi ( X - X) W T i 10)j = j+1 11)i = i+1 3 实验与结果 本节主要展示融合语义信息后获取的词向量 在单词类比推理和单词相似度量任务上的性能表 现。 首先介绍实验数据集及实验设置,然后分别描 述每个实验的任务和结果,并分析实验结果。 3.1 数据集 本实验选择 Enwik9 1 作为训练语料库,经过去 除原始语料库中 HTML 元数据、超链接等预处理操 作后,得到一个词汇量将近 13 亿的训练数据集。 然 后通过设置单词过滤词频限制词汇表的大小,把低 于设定过滤词频的单词剔除词汇表,因此,不同过 滤词频产生不同大小的词汇表。 本实验选用 WordNet 2 作为知识库,WordNet 2 有 120 000同义词集合,其中包含150 000单词。 本文 借助 JWI 3 从 WordNet 2 中抽取单词间的语义关系: 同一个同义词集合内单词对的同义关系,以及不同 集合间单词对的上下位关系。 不同的实验任务所用的测试数据集也不相同。 在单词类比推理任务中,本文使用的测试集为 谷歌查询数据集(Google query dataset 4 ),该数据集 包含19 544个问题,共 14 种关系类型,其中 5 种语 义关系,9 种语法关系。 在单词相似度量任务中,本 文使用下列 3 个数据集:Luong 等[24] 使用的稀有单 词,Finkelstein 等[25] 使用的 Wordsim⁃353 ( WS353) 数据集(RW),Huang 等[6] 发布的上下文单词相似 数据集(SCWS)。 它们分别包含 2003、2034、353 个 单词对及相应的人工标注的相似度分值。 3.2 实验设置 下列实验展示了由 KbEMF 获取的词向量在不 同任务中的性能表现。 为保持实验效果的一致性, 所有模型设置相同的参数。 词向量维数统一设置 为 200,学习率设置为 6 × 10 -7 ,上下文窗口为 5,迭 代次数设置为 300。 另外,语义组合权重的大小也对实验有重要影 响。 对于单词类比推理和单词相似度量任务本文 均采取相同的实验策略寻找最佳语义组合权重,下 面以单词类比推理任务为例详细说明最佳语义组 合权重找寻的实验过程。 设定 γ ∈ [0.01,100],首 先实验 γ = 0.01,0.1,1,10,100 的单词推理正确率, 如图 1 (b)所示, γ = 0.01,0.1,1 时 KbEMF 没有提 升实验效果,因为语义信息所起作用太小;在 γ = 100 时 KbEMF 实验效果反而更差,这是过分强调语 义信息破坏了词向量的通用性;只有在 γ = 10 时 KbEMF 效果较好,则最佳语义组合权重在 γ = 10 附 近的可能性最大。 然后在 γ ∈ [1,10]和 γ ∈ [10, 100]采取同样的策略继续寻找下去,最终会得到最 佳组合权重。 实验结果表明,不同任务在不同词频 下的最优语义组合权重也不同。 3.3 单词类比推理 给出一个问题 a ∶ b ∶ ∶c ∶ d,a、b、c、d 各表示一 个单词其中 d 是未知的,类比推理任务的目标在 于找到一个最合适的 d 使得 a, b, c, d 的词向量 满足 vec( d)与 vec( b) -vec( a) +vec( c) 的余弦距 离 最 近。 例 如, 语 义 推 理 Germary ∶ Berlin ∶ ∶ France ∶ d,则需要找出一个向量 vec( d) ,使它与 vec( Berlin) ⁃vec( Germary) +vec( France) 最近似, 如果 vec( d) 对应的 d 是 Paris 则推理正确。 同 理,又如语法推理 quick:quickly ∶ ∶slow ∶ d,如果找 到 d 是 slowly 则推理正确。 该实验任务的评价指 标 是 推 理 出 单 词 d 的 正 确 率, 正 确 率 越 高, 则 KbEMF 学得的词向量越好。 本实验评估了不同参数设置对 KbEMF 模型影 响,图 1 是词频为6 000次时,分别改变模型中词向 量维度及语义组合权重所绘制的。 从图 1 (a)可以看出,词向量维度小于 200 时, 随着词向量维度增加单词推理正确率在提升,词向 量维度在 200~350 之间实验效果趋向于稳定,因此 在同时兼顾实验速度与效果的情况下,本文选择学 习 200 维度的词向量。 ·664· 智 能 系 统 学 报 第 12 卷

第5期 陈培,等:融合语义信息的矩阵分解词向量学习模型 ·665 78.0 下面通过将KbEMF与EMF、Retro(CBOW)、 77.5 Retro(Skip-gram)、SWE进行比较来说明KbEMF的 77.0 优越性。Retro根据知识库信息对预先训练好的词 76.5 向量进行微调,该模型的缺点在于无法在语料库学 76.0 习词向量阶段利用丰富的语义信息。虽然SWE同 75.5 时利用了语义信息和语料库信息学习词向量,但该 75.0 模型的基础框架skip-gram只考虑了语料库的局部 共现信息。本文提出的KEMF则克服了上述模型 74.5 00.010.11351015203050100 的弱点,同时利用语料信息和语义信息学习词向 语义组合权重 (a)向量维度 量,并且它所分解的共现矩阵覆盖了语料库的全局 78.0r 共现信息。表1展示了词频为3500时KEMF与 77.5 EMF,Retro(CBOW)、Retro(Skip-gram)5、SWE的单 词推理正确率。 77.0 表1 KbEMF与其他方法的单词推理正确率 76.5 Table 1 Performance of KbEMF compared to other approaches 76.0 名 方法 75.5 单词推理正确率 EMF 80.93 75. 50100150200250300350400 Retro(CBOW) 78.47 维度 (b)语义组合权重 Retro(Skip-gram) 77.30 图1 KbEMF在不同向量维度和语义组合权重的正确率 SWE 79.77 Fig.1 Performance when incorporating semantic knowledge KbEMF 83.01 related to word analogical reasoning for different 表1中KEMF对应的单词推理正确率最高,这 vector sizes and semantic combination weights 说明该模型所获取的词向量质量最优。 图1(b)中随着语义组合权重增大,单词推理 3.4单词相似度量 正确率在提升,继续增大正确率反而减小,说明过 单词相似度量是评估词向量优劣的又一经典 大或过小的语义组合权重都不利于学习词向量。 实验。该实验把人工标注的词对相似度作为词对 从该实验还可以看出,语义组合权重在[5,20]之间 相似度的标准值,把计算得到的词对向量余弦值作 单词推理正确率最高,词向量在该任务中表现最优。 为词对相似度的估计值,然后计算词对相似度的标 图2展示了在不同过滤词频下,KbEMF的单词 准值与估计值之间的斯皮尔曼相关系数(spearman 推理正确率均在不同程度上高于EMF,尤其在词频 correlation coefficient),并将它作为词向量优劣的评 为3500时效果最佳。对于不同词频,该实验均设 价指标。斯皮尔曼相关系数的值越高表明单词对 置语义组合权重y-10,尽管该参数值在某些词频 相似度的估计值与标准值越一致,学习的词向量 下不是最优的,却在一定程度上说明本文模型的普 越好。 遍适用性。 由于单词相似度量希望相似度高或相关度高 84 e-KbEMF模型 的词对间彼此更靠近,语义信息的融入使具有强语 0 +EMF模型 义关系的词对获得更相似的词向量。那么计算所 7 得的关系词对向量的余弦值越大,词对相似度的标 准值与估计值之间的斯皮尔曼相关系数就越高。 72 与单词类比推理实验过程类似,通过调整 68 10 KbEMF模型参数(词向量维度、语义组合权重以及 1.01.52.02.53.03.54.04.55.05.56.0 过滤词频次 单词过滤词频),获得单词相似度量实验中表现优 图2不同过滤词频下EMF与KbEMF的正确率对比 异的词向量。 Fig.2 Performance of KbEMF compared to EMF for 本实验比较了KbEMF与SWE、Retro在单词相 different word frequencies 似度量任务中的性能表现,结果展示在表2中。由

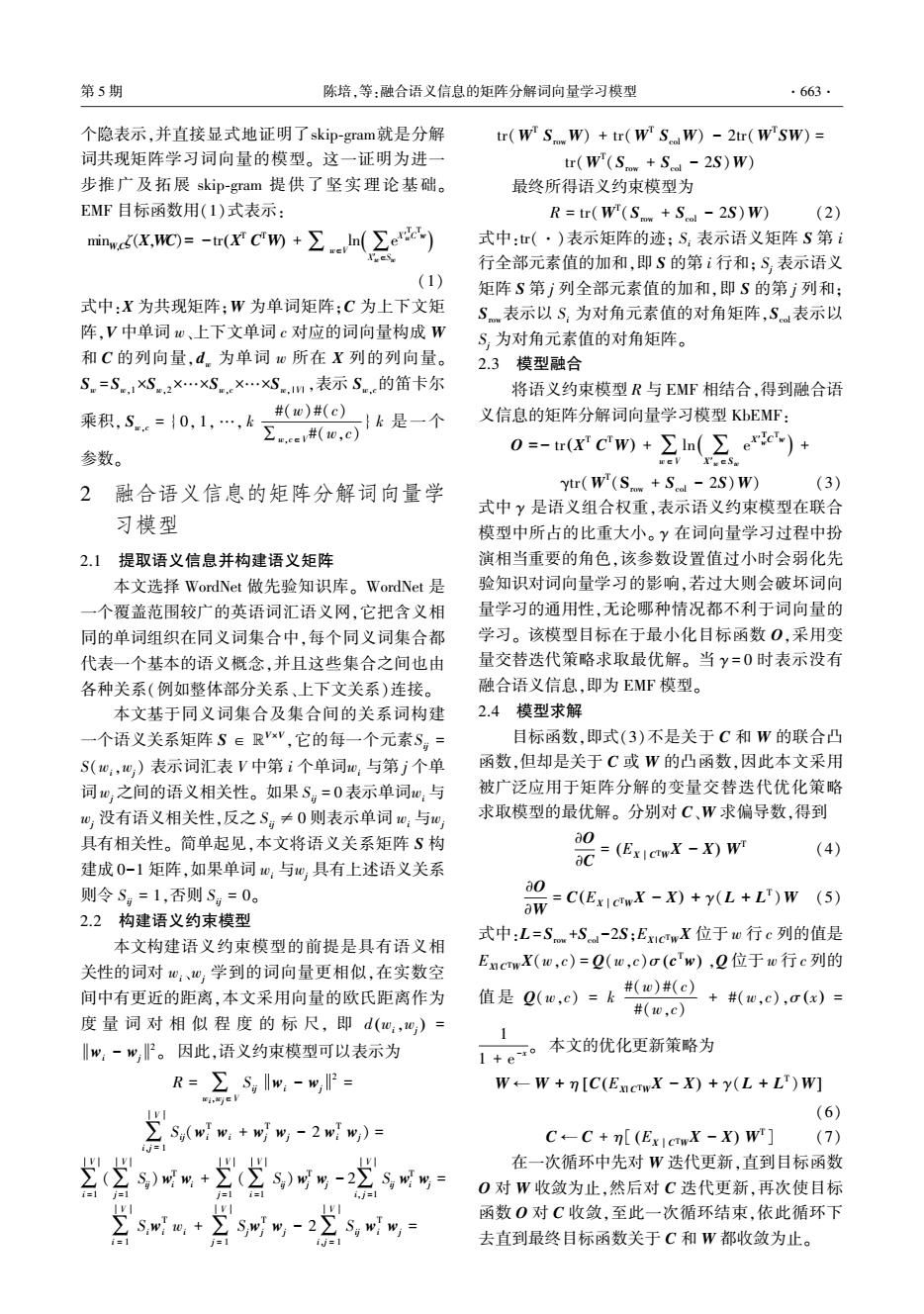

(a)向量维度 (b)语义组合权重 图 1 KbEMF 在不同向量维度和语义组合权重的正确率 Fig.1 Performance when incorporating semantic knowledge related to word analogical reasoning for different vector sizes and semantic combination weights 图 1 ( b)中随着语义组合权重增大,单词推理 正确率在提升,继续增大正确率反而减小,说明过 大或过小的语义组合权重都不利于学习词向量。 从该实验还可以看出,语义组合权重在[5,20]之间 单词推理正确率最高,词向量在该任务中表现最优。 图 2 展示了在不同过滤词频下,KbEMF 的单词 推理正确率均在不同程度上高于 EMF,尤其在词频 为 3 500 时效果最佳。 对于不同词频,该实验均设 置语义组合权重 γ = 10,尽管该参数值在某些词频 下不是最优的,却在一定程度上说明本文模型的普 遍适用性。 图 2 不同过滤词频下 EMF 与 KbEMF 的正确率对比 Fig.2 Performance of KbEMF compared to EMF for different word frequencies 下面通过将 KbEMF 与 EMF、Retro ( CBOW)、 Retro(Skip⁃gram) 5 、SWE 进行比较来说明 KbEMF 的 优越性。 Retro 根据知识库信息对预先训练好的词 向量进行微调,该模型的缺点在于无法在语料库学 习词向量阶段利用丰富的语义信息。 虽然 SWE 同 时利用了语义信息和语料库信息学习词向量,但该 模型的基础框架 skip⁃gram 只考虑了语料库的局部 共现信息。 本文提出的 KbEMF 则克服了上述模型 的弱点,同时利用语料信息和语义信息学习词向 量,并且它所分解的共现矩阵覆盖了语料库的全局 共现信息。 表 1 展示了词频为 3 500 时 KbEMF 与 EMF、Retro(CBOW)、 Retro(Skip⁃gram) 5 、SWE 的单 词推理正确率。 表 1 KbEMF 与其他方法的单词推理正确率 Table 1 Performance of KbEMF compared to other approaches % 方法 单词推理正确率 EMF 80.93 Retro(CBOW) 78.47 Retro(Skip⁃gram) 77.30 SWE 79.77 KbEMF 83.01 表 1 中 KbEMF 对应的单词推理正确率最高,这 说明该模型所获取的词向量质量最优。 3.4 单词相似度量 单词相似度量是评估词向量优劣的又一经典 实验。 该实验把人工标注的词对相似度作为词对 相似度的标准值,把计算得到的词对向量余弦值作 为词对相似度的估计值,然后计算词对相似度的标 准值与估计值之间的斯皮尔曼相关系数( spearman correlation coefficient),并将它作为词向量优劣的评 价指标。 斯皮尔曼相关系数的值越高表明单词对 相似度的估计值与标准值越一致,学习的词向量 越好。 由于单词相似度量希望相似度高或相关度高 的词对间彼此更靠近,语义信息的融入使具有强语 义关系的词对获得更相似的词向量。 那么计算所 得的关系词对向量的余弦值越大,词对相似度的标 准值与估计值之间的斯皮尔曼相关系数就越高。 与单词 类 比 推 理 实 验 过 程 类 似, 通 过 调 整 KbEMF 模型参数(词向量维度、语义组合权重以及 单词过滤词频),获得单词相似度量实验中表现优 异的词向量。 本实验比较了 KbEMF 与 SWE、Retro 在单词相 似度量任务中的性能表现,结果展示在表 2 中。 由 第 5 期 陈培,等:融合语义信息的矩阵分解词向量学习模型 ·665·

·666 智能系统学报 第12卷 于不同数据集下最佳语义组合权重不同,该实验针 [C]//Association for the Advancement of Artificial 对数据集WS353/SCWS/RW分别设置语义组合权 Intelligence.Austin Texas,USA,2015:2418-2424. 重为y=1,y=1,y=15。 [3]MAAS A L.DALY R E,PHAM P T,et al.Learning word 表2不同数据集下KbMF与其他方法的斯皮尔曼相关系数 vectors for sentiment analysis[C]//Proceedings of the 49th Table 2 Spearman correlation coefficients of KbEMF compared Annual Meeting of the Association for Computational to other approaches on different datasets Linguistics.Portland Oregon,USA,2011:142-150. [4]DHILLON P,FOSTER D P,UNGAR L H.Multi-view 数据集 方法 learning of word embeddings via cca [C]//Advances in WS353 SCWs RW Neural Information Processing Systems.Granada,Spain, EMF 0.7918 0.6474 0.6786 2011:199-207. Retro(CBOW) 0.7816 0.6685 0.6071 [5]BANSAL M,GIMPEL K,LIVESCU K.Tailoring continuous word representations for dependency parsing[C]//Meeting Retro(Skip-gram) 0.6930 0.6449 0.7143 of the Association for Computational Linguistics.Baltimore SWE 0.7965 0.6593 0.6429 Maryland,USA,2014:809-815. KbEMF 0.7999 0.6740 0.7500 [6]HUANG E H.SOCHER R,MANNING C D,et al.Improving word representations via global context and multiple word 表2中KbEMF在上述3个数据集的斯皮尔曼 prototypes[C]//Meeting of the Association for Computational 相关系数均有所提升,因为KbEMF相比较Retro在 Linguistics.Jeju Island,Korea,2012:873-882. 语料库学习词向量阶段就融入了语义知识库信息, [7]MNIH A,HINTON G.Three new graphical models for 相较于SWE则运用了语料库全局的共现信息,因此 statistical language modelling[C]//Proceedings of the 24th 表现最好。尤其KEMF在RW上的斯皮尔曼相关 International Conference on Machine Learning.New York, 系数提升显著,这说明语义知识库信息的融入有助 USA,2007:641-648. 于改善学习稀有单词的词向量。 [8 MNIH A,HINTON G.A scalable hierarchical distributed language model C]//Advances in Neural Information 4 结束语 Processing Systems.Vancouver,Canada,2008:1081-1088. 学习高效的词向量对自然语言处理至关重要。 [9]BENGIO Y,DUCHARME R,VINCENT P,et al.A neural 仅依赖语料库学习词向量无法很好地体现单词本 probabilistic language model[J].Journal of machine learning research,2003,3(02):1137-1155. 身的含义及单词间复杂的关系,因此本文通过从丰 [10]COLLOBERT R,WESTON J,BOTTOU L,et al.Natural 富的知识库提取有价值的语义信息作为对单一依 language processing (almost)from scratch[J].Journal of 赖语料库信息的约束监督,提出了融合语义信息的 machine learning research,2011,12(8):2493-2537. 矩阵分解词向量学习模型,该模型大大改善了词向 [11]MIKOLOV T,CHEN K,CORRADO G,ET AL.Efficient 量的质量。在实验中将Enwik9作为训练文本语料 estimation of word representations in vector space[C]/ 库并且将WordNet作为先验知识库,将学到的词向 International Conference on Learning Representations 量用于单词相似度量和单词类比推理两项任务中, Scottsdale,USA,2013. 充分展示了本文模型的优越性。 [12]BAIN J,Gao B,Liu T Y.Knowledge-powered deep leaming 在后续的研究工作中,我们将继续探索结合其 for word embedding [C]//Joint European Conference on 他知识库(如PPDB、WAN等),从中抽取更多类型 Machine Leaming and Knowledge Discovery in Databases. 的语义信息(如部分整体关系、多义词等),进而定 Springer,Berlin,Heidelberg,2014:132-148. [13]LI Y,XU L,TIAN F,ET AL.Word embedding revisited:a 义不同更有针对性的语义约束模型,进一步改善词 new representation leamning and explicit matrix factorization 向量。并将它们用于文本挖掘和自然语言处理任 perspective [C]//International Conference on Artificial 务中。 Intelligence.Buenos Aires,Argentina,2015:3650-3656. 参考文献: [14]LEVY O,GOLDBERG Y.Neural word embedding as implicit matrix factorization [C]//Advances in Neural [1]TURIAN J,RATINOV L,BENGIO Y.Word representations:a Information Processing Systems.Montreal Quebec, simple and general method for semi-supervised leaming[C]// Canada,2014:2177-2185. Proceedings of the 48th Annual Meeting of the Association for [15 PENNINGTON J,SOCHER R,MANNING C.Glove: Computational Linguistics.Uppsala,Sweden,2010:384-394. global vectors for word representation[C]//Conference on [2]LIU Y,LIU Z,CHUA T S,et al.Topical word embeddings Empirical Methods in Natural Language Processing.Doha

于不同数据集下最佳语义组合权重不同,该实验针 对数据集 WS353 / SCWS / RW 分别设置语义组合权 重为 γ = 1,γ = 1,γ = 15。 表2 不同数据集下 KbEMF 与其他方法的斯皮尔曼相关系数 Table 2 Spearman correlation coefficients of KbEMF compared to other approaches on different datasets 方法 数据集 WS353 SCWS RW EMF 0.791 8 0.647 4 0.678 6 Retro(CBOW) 0.781 6 0.668 5 0.607 1 Retro(Skip⁃gram) 0.693 0 0.644 9 0.714 3 SWE 0.796 5 0.659 3 0.642 9 KbEMF 0.799 9 0.674 0 0.750 0 表 2 中 KbEMF 在上述 3 个数据集的斯皮尔曼 相关系数均有所提升,因为 KbEMF 相比较 Retro 在 语料库学习词向量阶段就融入了语义知识库信息, 相较于 SWE 则运用了语料库全局的共现信息,因此 表现最好。 尤其 KbEMF 在 RW 上的斯皮尔曼相关 系数提升显著,这说明语义知识库信息的融入有助 于改善学习稀有单词的词向量。 4 结束语 学习高效的词向量对自然语言处理至关重要。 仅依赖语料库学习词向量无法很好地体现单词本 身的含义及单词间复杂的关系,因此本文通过从丰 富的知识库提取有价值的语义信息作为对单一依 赖语料库信息的约束监督,提出了融合语义信息的 矩阵分解词向量学习模型,该模型大大改善了词向 量的质量。 在实验中将 Enwik9 作为训练文本语料 库并且将 WordNet 作为先验知识库,将学到的词向 量用于单词相似度量和单词类比推理两项任务中, 充分展示了本文模型的优越性。 在后续的研究工作中,我们将继续探索结合其 他知识库(如 PPDB、WAN 等),从中抽取更多类型 的语义信息(如部分整体关系、多义词等),进而定 义不同更有针对性的语义约束模型,进一步改善词 向量。 并将它们用于文本挖掘和自然语言处理任 务中。 参考文献: [ 1]TURIAN J, RATINOV L, BENGIO Y. Word representations: a simple and general method for semi⁃supervised learning[C] / / Proceedings of the 48th Annual Meeting of the Association for Computational Linguistics. Uppsala, Sweden, 2010: 384-394. [2]LIU Y, LIU Z, CHUA T S, et al. Topical word embeddings [ C ] / / Association for the Advancement of Artificial Intelligence. Austin Texas, USA, 2015: 2418-2424. [3]MAAS A L, DALY R E, PHAM P T, et al. Learning word vectors for sentiment analysis[C] / / Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics. Portland Oregon, USA, 2011: 142-150. [4] DHILLON P, FOSTER D P, UNGAR L H. Multi⁃view learning of word embeddings via cca [ C] / / Advances in Neural Information Processing Systems. Granada, Spain, 2011: 199-207. [5]BANSAL M, GIMPEL K, LIVESCU K. Tailoring continuous word representations for dependency parsing[ C] / / Meeting of the Association for Computational Linguistics. Baltimore Maryland, USA, 2014: 809-815. [6]HUANG E H, SOCHER R, MANNING C D, et al. Improving word representations via global context and multiple word prototypes[C] / / Meeting of the Association for Computational Linguistics. Jeju Island, Korea, 2012: 873-882. [7] MNIH A, HINTON G. Three new graphical models for statistical language modelling[C] / / Proceedings of the 24th International Conference on Machine Learning. New York, USA, 2007: 641-648. [8 ] MNIH A, HINTON G. A scalable hierarchical distributed language model [ C ] / / Advances in Neural Information Processing Systems. Vancouver, Canada, 2008:1081-1088. [9]BENGIO Y, DUCHARME R, VINCENT P, et al. A neural probabilistic language model[J]. Journal of machine learning research, 2003, 3(02): 1137-1155. [10]COLLOBERT R, WESTON J, BOTTOU L, et al. Natural language processing (almost) from scratch[ J]. Journal of machine learning research, 2011, 12(8): 2493-2537. [11]MIKOLOV T, CHEN K, CORRADO G, ET AL. Efficient estimation of word representations in vector space [ C] / / International Conference on Learning Representations. Scottsdale, USA,2013. [12]BAIN J, Gao B, Liu T Y. Knowledge⁃powered deep learning for word embedding [ C] / / Joint European Conference on Machine Learning and Knowledge Discovery in Databases. Springer, Berlin, Heidelberg, 2014: 132-148. [13]LI Y, XU L, TIAN F, ET AL. Word embedding revisited: a new representation learning and explicit matrix factorization perspective [ C ] / / International Conference on Artificial Intelligence. Buenos Aires, Argentina, 2015: 3650-3656. [14] LEVY O, GOLDBERG Y. Neural word embedding as implicit matrix factorization [ C ] / / Advances in Neural Information Processing Systems. Montreal Quebec, Canada, 2014: 2177-2185. [ 15 ] PENNINGTON J, SOCHER R, MANNING C. Glove: global vectors for word representation[C] / / Conference on Empirical Methods in Natural Language Processing. Doha, ·666· 智 能 系 统 学 报 第 12 卷

第5期 陈培,等:融合语义信息的矩阵分解词向量学习模型 ·667. Qatar,2014:1532-1543 [22 MNIH A,SALAKHUTDINOV R.Probabilistie matrix [16]BIAN J,GAO B,LIU T Y.Knowledge-powered deep factorization [C]//Advances in Neural Information learning for word embedding [C ]//Joint European Processing Systems.Vancouver,Canada,2008: Conference on Machine Learning and Knowledge Discovery 1257-1264. in Databases.Berlin,Germany,2014:132-148. [23 SREBRO N,RENNIE J D M,JAAKKOLA T.Maximum- [17]XU C,BAI Y,BIAN J,et al.Rc-net:a general margin matrix factorization [J].Advances in neural framework for incorporating knowledge into word information processing systems,2004,37(2):1329-1336. representations C]//Proceedings of the 23rd ACM [24]LUONG T,SOCHER R,MANNING C D.Better word International Conference on Conference on Information and representations with recursive neural networks for morphology Knowledge Management.Shanghai,China,2014: [C]//Seventeenth Conference on Computational Natural 1219-1228. Language Learning.Sofia,Bulgaria,2013:104-113. [18]YU M,DREDZE M.Improving lexical embeddings with [25]FINKELSTEIN R L.Placing search in context:the concept semantic knowledge[C]//Meeting of the Association for revisited[]].ACM transactions on information systems, Computational Linguistics.Baltimore Maryland,USA, 2002,20(1):116-131. 2014:545-550. 作者简介: [19]LIU Q,JIANG H,WEI S,et al.Learning semantic word 陈培,女,1990年生,硕士研究生, embeddings based on ordinal knowledge constraints[C]/ 主要研究方向为自然语言处理、情感 The 53rd Annual Meeting of the Association for 分析。 Computational Linguistics and the 7th International Joint Conference of the Asian Federation of Natural Language Processing.Beijing,China,2015:1501-1511. [20 FARUQUI M,DODGE J,JAUHAR S K,et al. Retrofitting word vectors to semantic lexicons [C]//The 景丽萍,女,1978年生,教授,博士, 2015 Conference of the North American Chapter of the 主要研究方向为数据挖掘、文本挖掘、 Association for Computational Linguistics.Colorado,USA, 生物信息学、企业智能。 2015:1606-1615. [21]LEE DD.SEUNG H S.Algorithms for non-negative matrix factorization [C ]//Advances in Neural Information Processing Systems.Vancouver,Canada,2001:556-562

Qatar, 2014: 1532-1543. [ 16] BIAN J, GAO B, LIU T Y. Knowledge⁃powered deep learning for word embedding [ C ] / / Joint European Conference on Machine Learning and Knowledge Discovery in Databases. Berlin, Germany, 2014: 132-148. [ 17 ] XU C, BAI Y, BIAN J, et al. Rc⁃net: a general framework for incorporating knowledge into word representations [ C ] / / Proceedings of the 23rd ACM International Conference on Conference on Information and Knowledge Management. Shanghai, China, 2014: 1219-1228. [18] YU M, DREDZE M. Improving lexical embeddings with semantic knowledge [ C] / / Meeting of the Association for Computational Linguistics. Baltimore Maryland, USA, 2014: 545-550. [19]LIU Q, JIANG H, WEI S, et al. Learning semantic word embeddings based on ordinal knowledge constraints[C] / / The 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference of the Asian Federation of Natural Language Processing. Beijing, China, 2015: 1501-1511. [ 20 ] FARUQUI M, DODGE J, JAUHAR S K, et al. Retrofitting word vectors to semantic lexicons [ C] / / The 2015 Conference of the North American Chapter of the Association for Computational Linguistics. Colorado, USA, 2015: 1606-1615. [21]LEE D D, SEUNG H S. Algorithms for non⁃negative matrix factorization [ C ] / / Advances in Neural Information Processing Systems.Vancouver, Canada, 2001: 556-562. [22 ] MNIH A, SALAKHUTDINOV R. Probabilistic matrix factorization [ C ] / / Advances in Neural Information Processing Systems. Vancouver, Canada, 2008: 1257-1264. [23] SREBRO N, RENNIE J D M, JAAKKOLA T. Maximum⁃ margin matrix factorization [ J ]. Advances in neural information processing systems, 2004, 37(2):1329-1336. [24] LUONG T, SOCHER R, MANNING C D. Better word representations with recursive neural networks for morphology [ C ] / / Seventeenth Conference on Computational Natural Language Learning. Sofia, Bulgaria,2013: 104-113. [25]FINKELSTEIN R L. Placing search in context:the concept revisited [ J]. ACM transactions on information systems, 2002, 20(1): 116-131. 作者简介: 陈培,女,1990 年生,硕士研究生, 主要研究方向为自然语言处理、情感 分析。 景丽萍,女,1978 年生,教授,博士, 主要研究方向为数据挖掘、文本挖掘、 生物信息学、企业智能。 第 5 期 陈培,等:融合语义信息的矩阵分解词向量学习模型 ·667·