第12卷第5期 智能系统学报 Vol.12 No.5 2017年10月 CAAI Transactions on Intelligent Systems 0ct.2017 D0I:10.11992/tis.201706031 网络出版地址:http:/kns.cmki.net/kcms/detail/23.1538.TP.20171021.1350.008.html 分层强化学习综述 周文吉,俞扬 (南京大学软件新技术国家重点实验室,江苏南京210023) 摘要:强化学习(reinforcement learning)是机器学习和人工智能领域的重要分支,近年来受到社会各界和企业的广 泛关注。强化学习算法要解决的主要问题是,智能体如何直接与环境进行交互来学习策略。但是当状态空间维度 增加时,传统的强化学习方法往往面临着维度灾难,难以取得好的学习效果。分层强化学习(hierarchical reinforcement learning)致力于将一个复杂的强化学习问题分解成几个子问题并分别解决,可以取得比直接解决整个 问题更好的效果。分层强化学习是解决大规模强化学习问题的潜在途径,然而其受到的关注不高。本文将介绍和 回顾分层强化学习的几大类方法。 关键词:人工智能:机器学习:强化学习:分层强化学习:深度强化学习:马尔可夫决策过程:半马尔可夫决策过程:维 度灾难 中图分类号:TP391文献标志码:A文章编号:1673-4785(2017)05-0590-05 中文引用格式:周文吉,俞扬.分层强化学习综述[J].智能系统学报,2017,12(5):590-594. 英文引用格式:ZHOU Wenji,YU Yang.Summarize of hierarchical reinforcement learning[J].CAAI transactions on intelligent systems,2017,12(5):590-594. Summarize of hierarchical reinforcement learning ZHOU Wenji,YU Yang National Key Laboratory for Novel Software Technology,Nanjing University,Nanjing 210023,China) Abstract:Reinforcement Learning(RL)is an important research area in the field of machine learning and artificial intelligence and has received increasing attentions in recent years.The goal in RL is to maximize long-term total reward by interacting with the environment.Traditional RL algorithms are limited due to the so-called curse of dimensionality,and their learning abilities degrade drastically with increases in the dimensionality of the state space.Hierarchical reinforcement learning (HRL)decomposes the RL problem into sub-problems and solves each of them to improve learning ability.HRL offers a potential way to solve large-scale RL,which has received insufficient attention to date.In this paper,we introduce and review several main HRL methods. Keywords:artificial intelligence;machine learning;reinforcement learning;hierarchical reinforcement learning; deep reinforcement learning;Markov decision process;semi-Markov decision process;dimensional curse 强化学习要研究的问题是智能体(agents)如何速增长,强化学习难以取得理想的效果。为了解决 在一个环境(environment)中学到一定的策略 维度灾难,研究者提出了分层强化学习(hierarchical (policy),使得长期的奖赏(reward)最大。但是传统 reinforcement learning,HRL)。HRL的主要目标是 的强化学习方法面临着维度灾难,即当环境较为复 将复杂的问题分解成多个小问题,分别解决小问题 杂或者任务较为困难时,agent的状态(state)空间过 从而达到解决原问题的目的山。近些年来,人们认 大,会导致需要学习的参数以及所需的存储空间急 为分层强化学习基本可以解决强化学习的维度灾 难问题2-),转而将研究方向转向如何将复杂的问题 收稿日期:2017-06-09.网络出版日期:2017-10-21 抽象成不同的层级,从而更好地解决这些问题)」 基金项目:国家自然科学基金项目(61375061):江苏省自然科学基金 项目(BK20160066). 现在已有的一些分层学习大致可以分为4大 通信作者:俞扬.E-mail:yuy@nju.eu.cn. 类,分别是基于选项(option)的强化学习、基于分层

第 12 卷第 5 期 智 能 系 统 学 报 Vol.12 №.5 2017 年 10 月 CAAI Transactions on Intelligent Systems Oct. 2017 DOI:10.11992 / tis.201706031 网络出版地址:http: / / kns.cnki.net / kcms/ detail / 23.1538.TP.20171021.1350.008.html 分层强化学习综述 周文吉,俞扬 (南京大学 软件新技术国家重点实验室,江苏 南京 210023) 摘 要:强化学习(reinforcement learning) 是机器学习和人工智能领域的重要分支,近年来受到社会各界和企业的广 泛关注。 强化学习算法要解决的主要问题是,智能体如何直接与环境进行交互来学习策略。 但是当状态空间维度 增加时,传统的强化 学 习 方 法 往 往 面 临 着 维 度 灾 难, 难 以 取 得 好 的 学 习 效 果。 分 层 强 化 学 习 ( hierarchical reinforcement learning) 致力于将一个复杂的强化学习问题分解成几个子问题并分别解决,可以取得比直接解决整个 问题更好的效果。 分层强化学习是解决大规模强化学习问题的潜在途径,然而其受到的关注不高。 本文将介绍和 回顾分层强化学习的几大类方法。 关键词:人工智能;机器学习;强化学习;分层强化学习;深度强化学习;马尔可夫决策过程;半马尔可夫决策过程;维 度灾难 中图分类号:TP391 文献标志码:A 文章编号:1673-4785(2017)05-0590-05 中文引用格式:周文吉,俞扬.分层强化学习综述[J]. 智能系统学报, 2017, 12(5): 590-594. 英文引用格式:ZHOU Wenji, YU Yang. Summarize of hierarchical reinforcement learning[ J]. CAAI transactions on intelligent systems, 2017, 12(5): 590-594. Summarize of hierarchical reinforcement learning ZHOU Wenji, YU Yang (National Key Laboratory for Novel Software Technology, Nanjing University, Nanjing 210023, China) Abstract:Reinforcement Learning (RL) is an important research area in the field of machine learning and artificial intelligence and has received increasing attentions in recent years. The goal in RL is to maximize long⁃term total reward by interacting with the environment. Traditional RL algorithms are limited due to the so⁃called curse of dimensionality, and their learning abilities degrade drastically with increases in the dimensionality of the state space. Hierarchical reinforcement learning (HRL) decomposes the RL problem into sub⁃problems and solves each of them to improve learning ability. HRL offers a potential way to solve large⁃scale RL, which has received insufficient attention to date. In this paper, we introduce and review several main HRL methods. Keywords:artificial intelligence; machine learning; reinforcement learning; hierarchical reinforcement learning; deep reinforcement learning; Markov decision process; semi⁃Markov decision process; dimensional curse 收稿日期:2017-06-09. 网络出版日期:2017-10-21. 基金项目:国家自然科学基金项目(61375061); 江苏省自然科学基金 项目(BK20160066). 通信作者:俞扬. E⁃mail:yuy@ nju.edu.cn. 强化学习要研究的问题是智能体( agents)如何 在一 个 环 境 ( environment ) 中 学 到 一 定 的 策 略 (policy),使得长期的奖赏(reward)最大。 但是传统 的强化学习方法面临着维度灾难,即当环境较为复 杂或者任务较为困难时,agent 的状态(state)空间过 大,会导致需要学习的参数以及所需的存储空间急 速增长,强化学习难以取得理想的效果。 为了解决 维度灾难,研究者提出了分层强化学习(hierarchical reinforcement learning, HRL)。 HRL 的主要目标是 将复杂的问题分解成多个小问题,分别解决小问题 从而达到解决原问题的目的[1] 。 近些年来,人们认 为分层强化学习基本可以解决强化学习的维度灾 难问题[2-3] ,转而将研究方向转向如何将复杂的问题 抽象成不同的层级,从而更好地解决这些问题[4] 。 现在已有的一些分层学习大致可以分为 4 大 类,分别是基于选项(option)的强化学习、基于分层

第5期 周文吉,等:分层强化学习综述 .591. 抽象机(hierarchical of abstract machines)的分层强 作a可以得到的期望累积奖赏。我们也将Q"(s,a) 化学习、基于MaxQ值函数分解(MaxQ value 叫作Q函数,其具体的数学定义表示为 function decomposition)的分层强化学习,以及端到 Q(s,a)=E{u,+yT+1+yr+2+…s,=s,a,=a,π 端的(end to end)分层强化学习。 同样的,我们也希望通过学习到一个最优的Q 背景知识 函数Q·,使agent可以直接通过Q函数来选择当前 1 状态下应该执行的动作。 在本节中,我们主要介绍强化学习、马尔可夫 经过多年的研究,已经出现一些算法,致力于 决策过程(Markov decision process)和半马尔克夫决 解决传统的强化学习问题,比如Q-Learning、蒙特卡 策过程(Semi-Markov decision process)的定义以及 洛方法(Monte--Carlo learning)、时序差分方法 相关的背景知识。 (temporal-difference learning)等。其中Q-Learning 1.1强化学习与马尔可夫决策过程 方法常常在分层强化学习中被使用。Q-Learning通 强化学习是机器学习和人工智能中一个重要 过不断迭代更新Q函数的值来逼近最优的Q·。其 的领域,主要研究的问题是agent如何通过直接与 迭代式如下 环境交互来学习策略,使得长期的奖赏最大。强化 Q+1(s,a)=(1-a4)Q(s,a)+ 学习有一些特点,比如无监督学习,奖赏的反馈有 (r +y max(s',a')) 延迟,agent选择的动作会影响之后接收的数据等。 其中s'表示下一个状态。 大多数关于强化学习的研究都是建立在马尔 1.2半马尔可夫决策过程 可夫决策过程(MDP)的基础上,MDP可以表示为一 马尔可夫决策过程中,选择一个动作后,agent 个五元组(S,A,P,R,y〉。其中,S为状态(state)的 会立刻根据状态转移方程P跳转到下一个状态,而 有限集合,集合中某个状态表示为s∈S:A为动作 在半马尔可夫决策过程(SMDP)中,当前状态到下 (action)的有限集合,集合中某个动作表示为a∈ 一个状态的步数是个随机变量?,即在某个状态s A,A为状态s下可执行的动作集合;P为状态转移 下选择一个动作a后,经过?步才会以一个概率转 方程,P(s's,a)表示在状态s执行动作a后将以 移到下一个状态s'。此时的状态转移概率是s和 P(s'|s,a)的概率跳转到状态s';R为奖赏函数 的联合概率P(s',rs,a)。根据r的定义域不同, (reward function);y为折损系数(discount factor), SMDP所定义的系统也有所不同。当,的取值为实 0≤y≤1。假设一个agent观察到自己的状态s,此 数值,则SMDP构建了一个连续时间-离散事件系 时它选择一个动作a,它会得到一个即时的奖赏r:= 统(continuous--time discrete-event system)[);而当T R(s,a),然后以P(s'1s,a)的概率达到下一个状态 的取值为正整数,则是一个离散时间SMDP s'。马尔可夫决策过程有马尔可夫性,即系统的下 (discrete-time SMDP)[6。出于简单考虑,绝大部分 个状态只与当前状态有关,与之前的状态无关。当 分层强化学习都是在离散时间SMDP上进行讨论。 马尔可夫决策过程中作出决策时,只需要考虑当前 的状态,而不需要历史数据,这样大大降低了问题 2分层强化学习方法 的复杂度。 分层强化学习是将复杂的强化学习问题分解 强化学习需要agent学习到一个策略π:S× 成一些容易解决的子问题(sub-problem),通过分别 A→[0,1],通过π(s,a)的值来指导agent进行动 解决这些子问题,最终解决原本的强化学习问 作的选择。给定一个策略π和一个状态s,V”表示 题-]。常见的分层强化学习方法可以大致分为四 从s开始按照策略π进行选择可以得到的期望累积 大类,分别为基于选项(option)的强化学习、基于分 奖赏。我们将V称作值函数(value function),其具 层抽象机(hierarchical of abstract machines)的分层 体的数学定义为V"(s)=E{,+yT+1+yr+2+…+ 强化学习、基于MaxQ函数分解(MaxQ value Ps=s,π}。强化学习的目标是学到一个最优 function decomposition)的分层强化学习,以及端到 的策略π·,最大化每一个状态下的V值,此时的最 端的(end to end)的分层强化学习。本节将对它们 优值函数记作V·。 逐一进行探讨。 除了值函数,动作-值函数(action-value 2.1基于选项的分层强化学习 function)也在强化学习中扮演着重要的角色,记作 “选项”(option)的概念在1999年由Sutton等 Q(s,a),表示给定一个策略π,在状态s上执行动 人提出[1o,是一种对动作的抽象。一般的,option

抽象机(hierarchical of abstract machines) 的分层强 化学 习、 基 于 MaxQ 值 函 数 分 解 ( MaxQ value function decomposition) 的分层强化学习,以及端到 端的(end to end)分层强化学习。 1 背景知识 在本节中,我们主要介绍强化学习、马尔可夫 决策过程(Markov decision process)和半马尔克夫决 策过程( Semi⁃Markov decision process) 的定义以及 相关的背景知识。 1.1 强化学习与马尔可夫决策过程 强化学习是机器学习和人工智能中一个重要 的领域,主要研究的问题是 agent 如何通过直接与 环境交互来学习策略,使得长期的奖赏最大。 强化 学习有一些特点,比如无监督学习,奖赏的反馈有 延迟,agent 选择的动作会影响之后接收的数据等。 大多数关于强化学习的研究都是建立在马尔 可夫决策过程(MDP)的基础上,MDP 可以表示为一 个五元组 〈S,A,P,R,γ〉。 其中,S 为状态(state)的 有限集合,集合中某个状态表示为 s∈S;A 为动作 (action)的有限集合,集合中某个动作表示为 a∈ A, A 为状态 s 下可执行的动作集合;P 为状态转移 方程, P(s′ s,a) 表示在状态 s 执行动作 a 后将以 P(s′ s,a) 的概率跳转到状态 s′; R 为奖赏函数 (reward function); γ 为折损系数( discount factor), 0 ≤γ ≤ 1。 假设一个 agent 观察到自己的状态 s,此 时它选择一个动作 a,它会得到一个即时的奖赏 r a s = R(s,a) ,然后以 P(s′| s,a) 的概率达到下一个状态 s′。 马尔可夫决策过程有马尔可夫性,即系统的下 个状态只与当前状态有关,与之前的状态无关。 当 马尔可夫决策过程中作出决策时,只需要考虑当前 的状态,而不需要历史数据,这样大大降低了问题 的复杂度。 强化学习需要 agent 学习到一个策略 π:S × A →[0,1] ,通过 π(s,a) 的值来指导 agent 进行动 作的选择。 给定一个策略 π 和一个状态 s, V π s 表示 从 s 开始按照策略 π 进行选择可以得到的期望累积 奖赏。 我们将 V 称作值函数( value function),其具 体的数学定义为 V π (s) = E{rt + γrt+1 + γ 2 rt+2 + … + r n rt+n s = st,π}。 强化学习的目标是学到一个最优 的策略 π ∗ , 最大化每一个状态下的 V 值,此时的最 优值函数记作 V ∗ 。 除 了 值 函 数, 动 作 - 值 函 数 ( action⁃value function)也在强化学习中扮演着重要的角色,记作 Q π (s,a), 表示给定一个策略 π, 在状态 s 上执行动 作 a 可以得到的期望累积奖赏。 我们也将 Q π (s,a) 叫作 Q 函数,其具体的数学定义表示为 Q π (s,a) = E{rt + γrt+1 + γ 2 rt+2 + … st = s,at = a,π} 同样的,我们也希望通过学习到一个最优的 Q 函数 Q ∗ ,使 agent 可以直接通过 Q 函数来选择当前 状态下应该执行的动作。 经过多年的研究,已经出现一些算法,致力于 解决传统的强化学习问题,比如 Q⁃Learning、蒙特卡 洛方 法 ( Monte⁃Carlo learning )、 时 序 差 分 方 法 ( temporal⁃difference learning) 等。 其 中 Q⁃Learning 方法常常在分层强化学习中被使用。 Q⁃Learning 通 过不断迭代更新 Q 函数的值来逼近最优的 Q ∗ 。 其 迭代式如下 Qk+1(s,a) = (1 - αk)Qk(s,a) + αk(r + γ maxa′∈As′ Qk(s′,a′)) 其中 s′ 表示下一个状态。 1.2 半马尔可夫决策过程 马尔可夫决策过程中,选择一个动作后,agent 会立刻根据状态转移方程 P 跳转到下一个状态,而 在半马尔可夫决策过程( SMDP) 中,当前状态到下 一个状态的步数是个随机变量 τ, 即在某个状态 s 下选择一个动作 a 后,经过 τ 步才会以一个概率转 移到下一个状态 s′。 此时的状态转移概率是 s 和 τ 的联合概率 P(s′,τ s,a)。 根据 τ 的定义域不同, SMDP 所定义的系统也有所不同。 当 τ 的取值为实 数值,则 SMDP 构建了一个连续时间-离散事件系 统(continuous⁃time discrete⁃event system) [5] ;而当 τ 的取 值 为 正 整 数, 则 是 一 个 离 散 时 间 SMDP (discrete⁃time SMDP) [6] 。 出于简单考虑,绝大部分 分层强化学习都是在离散时间 SMDP 上进行讨论。 2 分层强化学习方法 分层强化学习是将复杂的强化学习问题分解 成一些容易解决的子问题( sub⁃problem),通过分别 解决这 些 子 问 题, 最 终 解 决 原 本 的 强 化 学 习 问 题[7-9] 。 常见的分层强化学习方法可以大致分为四 大类,分别为基于选项(option)的强化学习、基于分 层抽象机(hierarchical of abstract machines) 的分层 强化 学 习、 基 于 MaxQ 函 数 分 解 ( MaxQ value function decomposition) 的分层强化学习,以及端到 端的(end to end)的分层强化学习。 本节将对它们 逐一进行探讨。 2.1 基于选项的分层强化学习 “选项” ( option) 的概念在 1999 年由 Sutton 等 人提出[10] ,是一种对动作的抽象。 一般的, option 第 5 期 周文吉,等:分层强化学习综述 ·591·

·592. 智能系统学报 第12卷 可表示为一个三元组〈1,π,B〉。其中,T:S×A→ 在cal类型的状态时,当前状态机H:将被挂起,开 [0,1]表示此option中的策略;B:S→[0,1]表示终 始初始化下一个状态机H,即把H,的状态设置为 止条件,B(s)表示状态s有B(s)的概率终止并退 f(s,),其中j的值根据m得出,m表示第i个状态 出此option;ISS表示option的初始状态集合。 机在时刻t时的状态。choice类型的状态则是非确 option〈1,π,B〉在状态s上可用,当且仅当s∈I。 定性地选择当前状态机的下一个状态。stop状态则 当option开始执行时,agent通过该option的r进行 是停止当前状态机的活动,恢复调用它的状态机的 动作选择直到终止。值得注意的是,一个单独的动 活动,同时agent根据之前选择的动作进行状态转 作a也可以是一个option,通常被称作one-step 移并得到奖赏。如果在这个过程中没有选择出动 option,I={s:a∈A,},并且对任意的状态s都有 作,例如某个状态机H,刚被调用就被随机函数∫初 B(s)=1。 始化到了一个stop状态以至于返回时并没有选出 基于option的分层强化学习的过程如下:假设 要执行的动作,则M保持当前的状态。 agent当前在某个状态,选择一个option,通过这个 HAMs也可以通过改进Q-Learning算法进行学 option的策略,agent选择了一个动作或者另一个 习。对于一个马尔可夫决策过程M和任意一个状 option。若选择了一个动作,则直接执行转移到下一 态机H,H。M是一个MDP四,其中状态集合为S× 个状态;若选择了另一个option,则用选择的新 SH,动作集合为A×AH。只有当H的状态是choice option继续选择,直到最后得出一个动作。 类型的状态时,H。M才需要进行决策,其他状态下 为了使用option来解决分层强化学习问题,我 都可以根据状态机的状态自动进行状态转移,所以 们还需要定义一个更高层级的策略:S×O,一[0, 实际上H。M是个SMDP。因此我们需要维护的Q 1]。其中,0表示所有option的集合,而O,表示状 函数为Q([s。,m.],a),其中,c表示H。M中需要 态s下可用的option的集合;u(s,o)表示在状态s 作出选择的状态的下标,[s,m]被称作选择点 时以u(s,o)的概率选择o作为当前的option。此时 (choice point)。此时Q-Learning的更新公式为 的Q函数定义为 Q([s,m],a)=(1-a)Q([s。,m],a)+a[+ Q(s,0)=E{,+yr+1+yr+2+…0,=0,s=s} yr+1+…+y-7r-1+ymax.Q([s,m'],a')] 此时的Q-Learning的更新公式为 其中,T为由s到s'所经过的步数。 Q+i(s,0)=(1-4)Q(s,0,)+a(,+yT41+…+ 2.3基于MaxQ值函数分解的分层强化学习 yr+ymax)) MaxQ值函数分解(MaxQ value function 其中,a:为第k轮迭代时的学习率,T表示option o decomposition),是由Dietterich提出的另外一种分层 在执行T步之后在状态s,停止,而o'为在o执行 强化学习的方法[)。首先将一个马尔可夫决策过 结束后的下一个option.。可以注意到,当所有的 程M分解成多个子任务{M。,M,…,Mn},M。为根 option均为one-step option时,这个Q-Learning就退 子任务,解决了M。就意味着解决了原问题M。对 化为普通的Q-Learning过程。 于每一个子任务M,都有一个终止断言(termination 2.2基于分层抽象机的分层强化 predicate)T:和一个动作集合A:。这个动作集合中 分层抽象机(hierarchies of abstract machines, 的元素既可以是其他的子任务,也可以是一个MDP HAMs,)是Par和Russell提出的方法[山。和 中的action。一个子任务的目标是转移到一个状 option的方法类似,HAMs的方法也是建立在SMDP 态,可以满足终止断言,使得此子任务完成并终止。 的理论基础之上的。HAMs的主要思想是将当前所 我们需要学到一个高层次的策略π={π。,…,π}, 在状态以及有限状态机的状态结合考虑,从而选择 其中π:为子任务M的策略。 不同的策略。 令V(i,s)表示子任务i在状态s的值函数,即该 令M为一个有限MDP,S为状态集合,A为动 子问题从状态s开始一直按照某个策略执行最终达 作集合。{H,}为一个有限状态机的集合,其中每个 到终止状态的期望累计奖赏。类似的,令Q(i,s,)为 有限状态机H都有一个状态集合S:、一个概率转移 子任务i在状态s执行动作j之后按照某个策略执行 方程6:以及一个随机函数f:S→S,。每个状态机 直到达到终止状态的期望累计奖赏,可以表示为 都有4种类型的状态,即动作(action)、调用(call)、 Q(i,s,j)=E(r +yr+yr2+.s=s,T) 选择(choice)以及停止(stop)。action类型的状态 假设选择的动作j一共执行了?步才返回,那么我 会根据状态机的具体状态执行一个MDP中的动作。 们可以把Q函数写成

可表示为一个三元组 〈I,π,β〉。 其中, π:S × A → [0,1] 表示此option中的策略; β:S → [0,1] 表示终 止条件, β(s) 表示状态 s 有 β(s) 的概率终止并退 出此 option; I ⊆ S 表示 option 的初始状态集合。 option 〈I,π,β〉 在状态 s 上可用,当且仅当 s ∈ I。 当 option 开始执行时,agent 通过该 option 的 π 进行 动作选择直到终止。 值得注意的是,一个单独的动 作 a 也 可 以 是 一 个 option, 通 常 被 称 作 one⁃step option, I = {s:a ∈ As} ,并且对任意的状态 s 都有 β(s) = 1。 基于 option 的分层强化学习的过程如下:假设 agent 当前在某个状态,选择一个 option,通过这个 option 的策略, agent 选择了一个动作或者另一个 option。 若选择了一个动作,则直接执行转移到下一 个状态; 若选择 了 另 一 个 option, 则 用 选 择 的 新 option 继续选择,直到最后得出一个动作。 为了使用 option 来解决分层强化学习问题,我 们还需要定义一个更高层级的策略 μ:S × Os → [0, 1] 。 其中,O 表示所有 option 的集合,而 Os 表示状 态 s 下可用的 option 的集合; μ(s,o) 表示在状态 s 时以 μ(s,o) 的概率选择 o 作为当前的 option。 此时 的 Q 函数定义为 Q μ (s,o) = E{rt + γrt+1 + γ 2 rt+2 + … or = o,st = s} 此时的 Q⁃Learning 的更新公式为 Qk+1(st,ot) = (1 - αk)Qk(st,ot) + αk(rt + γrt+1 + … + γ τ-1 rt+τ + γ τ maxo′∈Os′ Qk(st+τ,o′)) 其中, αk 为第 k 轮迭代时的学习率, τ 表示 option o 在执行 τ 步之后在状态 st+τ 停止,而 o′ 为在 o 执行 结束后的下一个 option。 可以注意到, 当所有的 option 均为 one⁃step option 时,这个 Q⁃Learning 就退 化为普通的 Q⁃Learning 过程。 2.2 基于分层抽象机的分层强化 分层抽象机 ( hierarchies of abstract machines, HAMs,) 是 Parr 和 Russell 提 出 的 方 法[11] 。 和 option 的方法类似,HAMs 的方法也是建立在 SMDP 的理论基础之上的。 HAMs 的主要思想是将当前所 在状态以及有限状态机的状态结合考虑,从而选择 不同的策略。 令 M 为一个有限 MDP,S 为状态集合,A 为动 作集合。 {Hi}为一个有限状态机的集合,其中每个 有限状态机 Hi 都有一个状态集合 Si、一个概率转移 方程 δi 以及一个随机函数 f i:S → Si。 每个状态机 都有 4 种类型的状态,即动作( action)、调用( call)、 选择( choice) 以及停止( stop)。 action 类型的状态 会根据状态机的具体状态执行一个 MDP 中的动作。 在 call 类型的状态时,当前状态机 Hi 将被挂起,开 始初始化下一个状态机 Hj,即把 Hj 的状态设置为 f j(st) ,其中 j 的值根据 m i t 得出, m i t 表示第 i 个状态 机在时刻 t 时的状态。 choice 类型的状态则是非确 定性地选择当前状态机的下一个状态。 stop 状态则 是停止当前状态机的活动,恢复调用它的状态机的 活动,同时 agent 根据之前选择的动作进行状态转 移并得到奖赏。 如果在这个过程中没有选择出动 作,例如某个状态机 Hi刚被调用就被随机函数 f i 初 始化到了一个 stop 状态以至于返回时并没有选出 要执行的动作,则 M 保持当前的状态。 HAMs 也可以通过改进 Q⁃Learning 算法进行学 习。 对于一个马尔可夫决策过程 M 和任意一个状 态机 H, H M 是一个 MDP [11] ,其中状态集合为 S × SH, 动作集合为 A × AH。 只有当 H 的状态是 choice 类型的状态时, H M 才需要进行决策,其他状态下 都可以根据状态机的状态自动进行状态转移,所以 实际上 H M 是个 SMDP。 因此我们需要维护的 Q 函数为 Q([sc,mc],ac), 其中,c 表示 H M 中需要 作出选择的状态的下标, [ sc, mc ] 被称作选择点 (choice point)。 此时 Q⁃Learning 的更新公式为 Qk+1([sc,mc],ac) = (1 - αk)Qk([sc,mc],ac) + α[rt + γrt+1 + … + γ τ-1 rt+τ-1 + γ τ maxa′Qk([s′c,m′c],a′)] 其中, τ 为由 sc到 s′c 所经过的步数。 2.3 基于 MaxQ 值函数分解的分层强化学习 MaxQ 值 函 数 分 解 ( MaxQ value function decomposition),是由 Dietterich 提出的另外一种分层 强化学习的方法[12] 。 首先将一个马尔可夫决策过 程 M 分解成多个子任务{M0 ,M1 ,…,Mn },M0 为根 子任务,解决了 M0 就意味着解决了原问题 M。 对 于每一个子任务 Mi,都有一个终止断言(termination predicate) Ti 和一个动作集合 Ai。 这个动作集合中 的元素既可以是其他的子任务,也可以是一个 MDP 中的 action。 一个子任务的目标是转移到一个状 态,可以满足终止断言,使得此子任务完成并终止。 我们需要学到一个高层次的策略 π = {π0 ,…,πn }, 其中 πi 为子任务 Mi的策略。 令 V(i,s)表示子任务 i 在状态 s 的值函数,即该 子问题从状态 s 开始一直按照某个策略执行最终达 到终止状态的期望累计奖赏。 类似的,令 Q(i,s,j)为 子任务 i 在状态 s 执行动作 j 之后按照某个策略执行 直到达到终止状态的期望累计奖赏,可以表示为 Q(i,s,j) = E(rt + γrt+1 + γ 2 rt+2 + … st = s,π) 假设选择的动作 j 一共执行了 τ 步才返回,那么我 们可以把 Q 函数写成 ·592· 智 能 系 统 学 报 第 12 卷

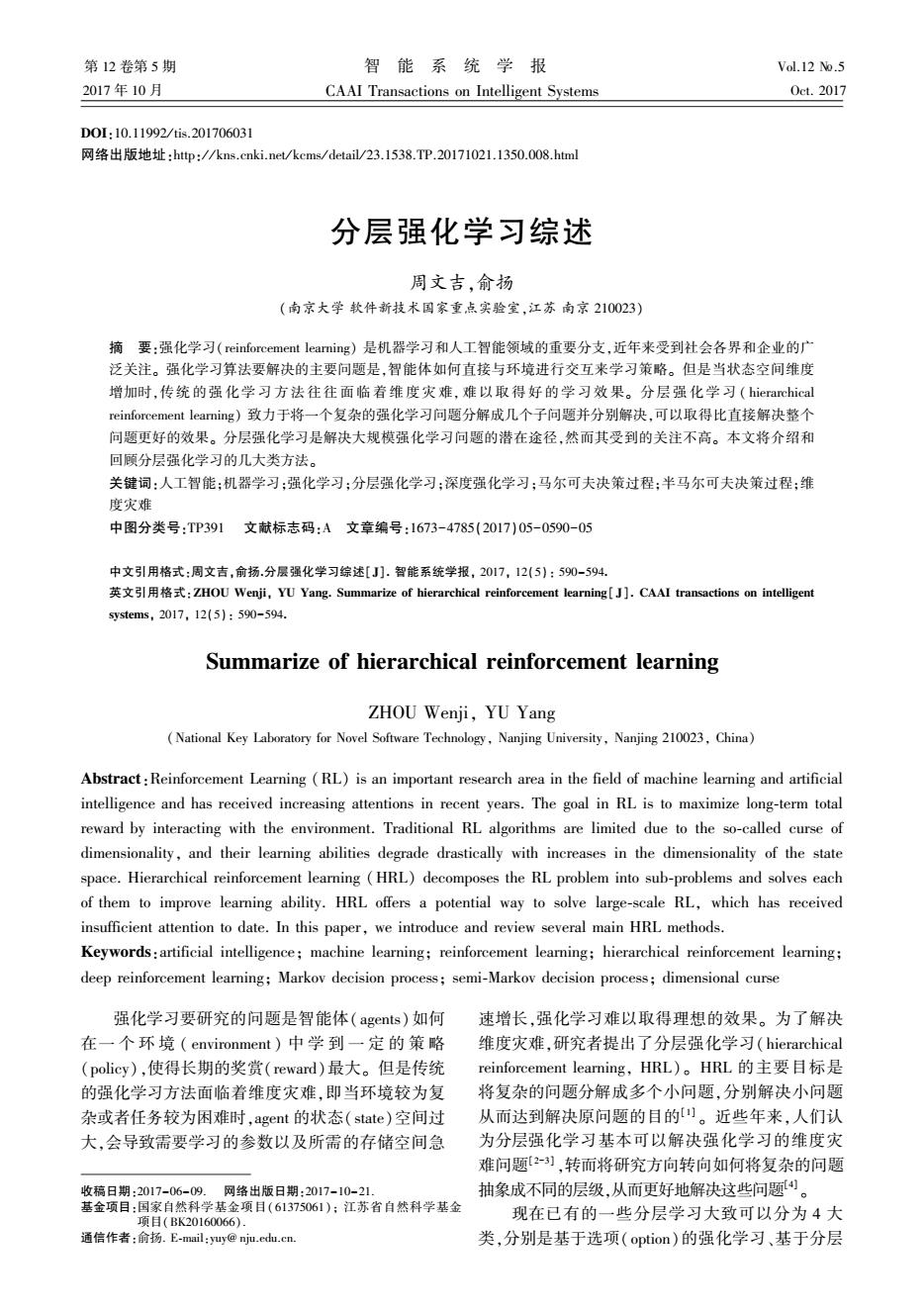

第5期 周文吉,等:分层强化学习综述 ·593· 0(》=E1yhn+2yl5…m 有人提出利用蚁群算法启发式地寻找合理的 1=0 划分点)。作者利用蚁群算法根据信息素的变化 其中右边的第1项实际上是V(,s),第2项叫作完 程度寻找“瓶颈”(bottle neck),瓶颈像一座桥梁一 成函数(completion function),记作C(i,s,j)。则Q 样连接着问题空间中不同的连续区域。图2为一个 函数的贝尔曼方程可以写为 Grid Word问题,agent需要从状态s出发到达状态 Q(i,s》=∑P(s',rls,i)(VG,s)+ g。通过蚁群算法分析信息素的变化程度找出瓶颈 ' y"max,Q(i,s',j))=V(j,s)+C(i,s,j) 在两个房间的窄门处,即图2中的状态v附近。 当选择的动作j完成后,得到下一个状态s'以及做 完这个动作经过的时间?,则可更新完成函数 C+1(i,s,j)=(1-a)C,(i,sj)+ a,y'[max V(a',s')+C,(i,s',a')] 这样也就更新了Q函数。 图I为利用MaxQ方法解决taxi problem的任 务划分示意图[町 图2通过蚁群算法找到从s到g的最短路径 Fig.2 Shortest path between s and g found by ant system Root 通过多次探索留下的信息素密集程度来找到 Get Put 瓶颈即可将问题空间划分,再使用基于option的分 层强化学习即可解决。 Pickup Navigate(r) Dropoff 除了启发式的抽象方法,有人还提出使用神经 网络结构来自动进行问题的分层抽象和学习140]。 North South East West 近些年来神经网络快速发展,尤其是在图像识别领 图1出租车问题的任务图 域,更是取得了很多成果。因此有人尝试通过结合 Fig.1 Task graph for the taxi problem 神经网络和强化学习来设计电子游戏的AI,输入为 出租车问题是指一个出租车agent需要到特定 游戏画面,通过神经网络和强化学习学习到游戏策 位置接一位乘客并且把他送到特定的位置让其下 略。有些游戏复杂度较高,需要使用分层强化学 车。一共有6个动作,分别是上车(pick up)、下车 习。文献[14]中提出了Option-Critie架构,旨在通 (drop off),以及向东南西北四个方向开车的动作。 过神经网络强大的学习能力,模糊发现option和学 这里使用MaxQ方法,将原问题分解成了get和put 习option之间的界限,直接通过神经网络一起训练。 两个子任务,这两个子任务又进行分解,©t分解成 在一些游戏上取得了比不使用分层强化学习的 一个基本动作pick up和一个子任务navigate,而put Deep Q Network更好的结果。文献[l5]中提出了 也分解成了一个基本动作drop off和一个子任务 Manager--Worker架构,Manager负责给Worker一个 navigate。子任务navigate(t)表示t时刻应该开车的 子目标,而Worker根据子目标和当前所处的状态给 方向。对于这个强化学习问题,agent首先选择get, 出具体执行的动作。在这个方法中,Manager和 然后get子问题navigate,直到到达乘客所在地,然 Worker分别是两个不同的神经网络,并且用各自的 后get选择pick up动作,乘客上车。之后agent选 梯度分别进行优化,在实验中也取得了很好的效果。 择put子任务,put子任务选择navigate,直到到达乘 人工进行分层和抽象,不仅费时费力,而且容 客目的地,之后put子任务选择drop off动作,乘客 易忽视问题中不易发现的内在联系。因此使用端 下车,任务完成。 到端的分层强化学习,从分层抽象到训练学习,都 2.4端到端的的分层强化学习 通过机器学习的方法自动进行必然是今后人们不 上述的几种方法,都需要人工来做很多工作, 断研究的方向。 比如人工进行option的选取,人工进行HAMs的构 3总束语 建,人工划分子任务等。人工设计不仅耗时耗力, 并且会直接影响最终强化学习结果的好坏。近些 本文对于分层强化学习进行了回顾。首先介 年来人们关注如何让agent自己学到合理的分层抽 绍了强化学习、马尔科夫决策过程以及半马尔科夫 象,而非人为进行划分和指定。 决策过程的定义和基本概念,规定了本文的符号使

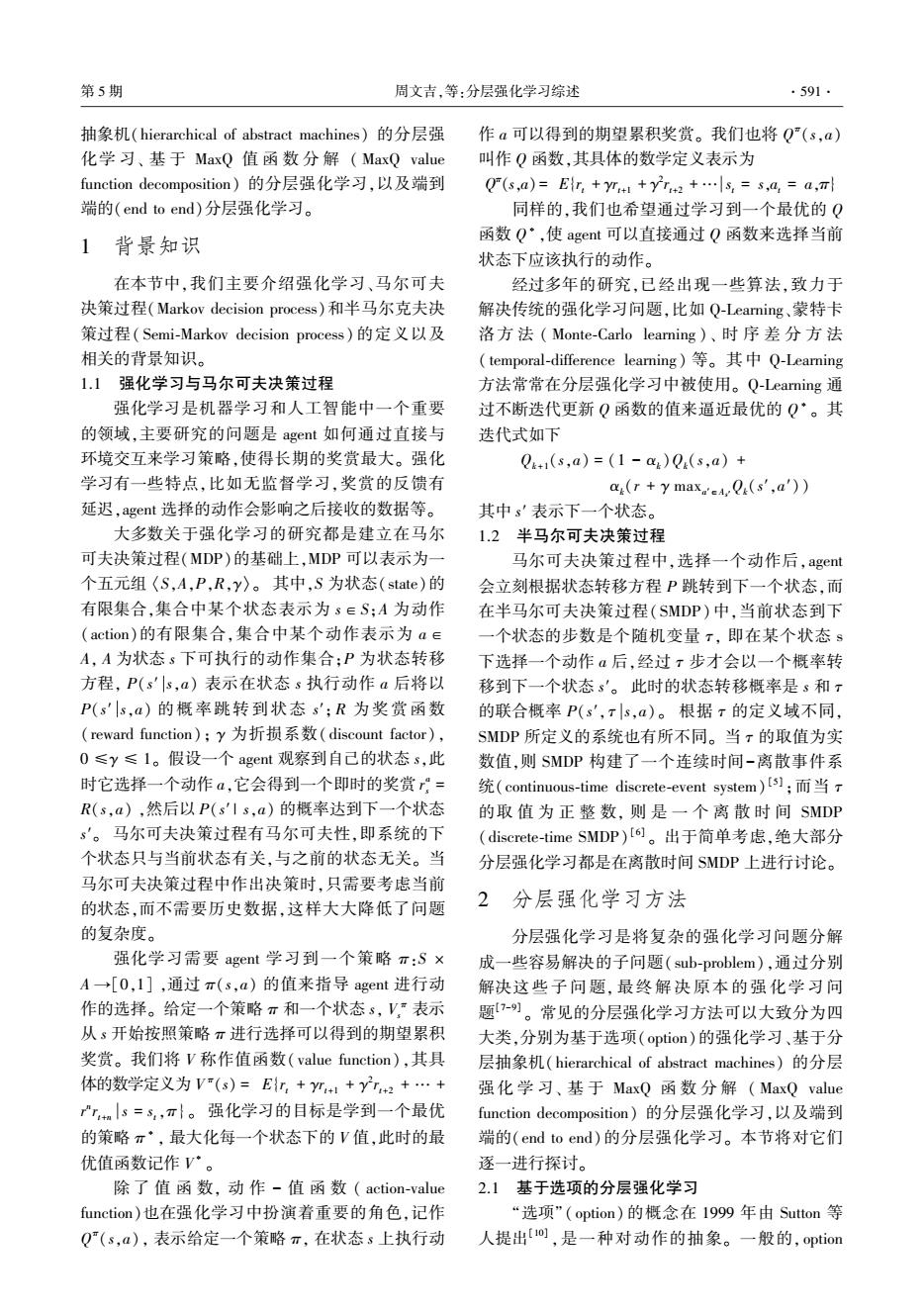

Q(i,s,j) = E{∑ τ-1 u = 0 γ u rt+u + ∑ ¥ u = τ γ u rt+u st = s,π} 其中右边的第 1 项实际上是 V(j,s),第 2 项叫作完 成函数( completion function),记作 C( i,s,j)。 则 Q 函数的贝尔曼方程可以写为 Q(i,s,j) = ∑s′,τ P(s′,τ s,j)(V(j,s) + γ τ maxj′Q(i,s′, j′)) = V(j,s) + C(i,s,j) 当选择的动作 j 完成后,得到下一个状态 s′ 以及做 完这个动作经过的时间 τ, 则可更新完成函数 Ct+1(i,s,j) = (1 - αt)Ct(i,s,j) + αtγ τ [maxa′V(a′,s′) + Ct(i,s′,a′)] 这样也就更新了 Q 函数。 图 1 为利用 MaxQ 方法解决 taxi problem 的任 务划分示意图[12] 。 图 1 出租车问题的任务图 Fig.1 Task graph for the taxi problem 出租车问题是指一个出租车 agent 需要到特定 位置接一位乘客并且把他送到特定的位置让其下 车。 一共有 6 个动作,分别是上车( pick up)、下车 (drop off),以及向东南西北四个方向开车的动作。 这里使用 MaxQ 方法,将原问题分解成了 get 和 put 两个子任务,这两个子任务又进行分解,get 分解成 一个基本动作 pick up 和一个子任务 navigate,而 put 也分解成了一个基本动作 drop off 和一个子任务 navigate。 子任务 navigate(t)表示 t 时刻应该开车的 方向。 对于这个强化学习问题,agent 首先选择 get, 然后 get 子问题 navigate,直到到达乘客所在地,然 后 get 选择 pick up 动作,乘客上车。 之后 agent 选 择 put 子任务,put 子任务选择 navigate,直到到达乘 客目的地,之后 put 子任务选择 drop off 动作,乘客 下车,任务完成。 2.4 端到端的的分层强化学习 上述的几种方法,都需要人工来做很多工作, 比如人工进行 option 的选取,人工进行 HAMs 的构 建,人工划分子任务等。 人工设计不仅耗时耗力, 并且会直接影响最终强化学习结果的好坏。 近些 年来人们关注如何让 agent 自己学到合理的分层抽 象,而非人为进行划分和指定。 有人提出利用蚁群算法启发式地寻找合理的 划分点[13] 。 作者利用蚁群算法根据信息素的变化 程度寻找“瓶颈” ( bottle neck),瓶颈像一座桥梁一 样连接着问题空间中不同的连续区域。 图 2 为一个 Grid Word 问题,agent 需要从状态 s 出发到达状态 g。 通过蚁群算法分析信息素的变化程度找出瓶颈 在两个房间的窄门处,即图 2 中的状态 v 附近。 图 2 通过蚁群算法找到从 s 到 g 的最短路径 Fig.2 Shortest path between s and g found by ant system 通过多次探索留下的信息素密集程度来找到 瓶颈即可将问题空间划分,再使用基于 option 的分 层强化学习即可解决。 除了启发式的抽象方法,有人还提出使用神经 网络结构来自动进行问题的分层抽象和学习[14-20] 。 近些年来神经网络快速发展,尤其是在图像识别领 域,更是取得了很多成果。 因此有人尝试通过结合 神经网络和强化学习来设计电子游戏的 AI,输入为 游戏画面,通过神经网络和强化学习学习到游戏策 略。 有些游戏复杂度较高,需要使用分层强化学 习。 文献[14] 中提出了 Option⁃Critic 架构,旨在通 过神经网络强大的学习能力,模糊发现 option 和学 习 option 之间的界限,直接通过神经网络一起训练。 在一些游戏上取得了比不使用分层强化学习的 Deep Q Network 更好的结果。 文献[15] 中提出了 Manager⁃Worker 架构,Manager 负责给 Worker 一个 子目标,而 Worker 根据子目标和当前所处的状态给 出具体执行的动作。 在这个方法中, Manager 和 Worker 分别是两个不同的神经网络,并且用各自的 梯度分别进行优化,在实验中也取得了很好的效果。 人工进行分层和抽象,不仅费时费力,而且容 易忽视问题中不易发现的内在联系。 因此使用端 到端的分层强化学习,从分层抽象到训练学习,都 通过机器学习的方法自动进行必然是今后人们不 断研究的方向。 3 总束语 本文对于分层强化学习进行了回顾。 首先介 绍了强化学习、马尔科夫决策过程以及半马尔科夫 决策过程的定义和基本概念,规定了本文的符号使 第 5 期 周文吉,等:分层强化学习综述 ·593·

.594. 智能系统学报 第12卷 用。然后,在第2节分4个方面,阐述了Sutton等提 [12]DIETTERICH T G.Hierarchical reinforcement learning 出的option方法,Par和Russell提出的HAMs方法 with the MAXQ value function decomposition[J].Journal 以及Dierrerich等提出的MaxQ方法,阐述了这些方 of artificial intelligence research,2000,13:227-303. 13 MOHSEN G,TAGHIZADEH N,et al.Automatic 法具体的计算方法。分析了近两年来的研究方向, abstraction in reinforcement learning using ant system 介绍了一些端到端的、自动抽象的分层强化学习。 algorithm[C]//In Proceedings of AAAI Spring 分层强化学习是解决大规模强化学习的潜在途径, Symposium:Lifelong Machine Learning.Stanford,USA, 然而其受到的关注不足。希望本篇综述能够引起 2013:114-122 更多人关注分层强化学习。 [14]PIERRE-LUC BACON,JEAN HARB.The option-critic architecture[C]//In Proceeding of 31th AAAl Conference 参考文献: on Artificial Intelligence.San Francisco,USA,2017: 1726-1734. [1 BARTO A G.MAHADEVAN S.Recent advances in [15]VEZHNEVETS A S,OSINDERO S,SCHAUL T,et al. hierarchical reinforcement learning[J].Discrete event FeUdal networks for hierarchical reinforcement dynamic8 ystems,2013,13(4):341-379. learning[C]//In Proceedings of the 34th International [2]YAN Q,LIU Q,HU D.A hierarchical reinforcement Conference on Machine Learning.Sydney,Australia, learning algorithm based on heuristic reward function[Cl// 2017:3540-3549. In Proceedings of 2nd International Conference on Advanced 16 MNIH V,KAVUKCUOGLU K,SILVER D,et al. Computer Control.Shenyang,China,2010,3:371-376. Human-level control through deep reinforcement learning[J]. [3]DETHLEFS N,CUAYAHUITL H.Combining hierarchical Nature,2015,518(2):529-533. reinforcement learning and Bayesian networks for natural [17]TEJAS D.K,KARTHNIK N,ARDAVAN S,et al. language generation in situated dialogue[C]//European Hierarchical deep reinforcement leaming:integrating Workshop on Natural Language Generation.Nancy,France, temporal abstraction and intrinsic motivation[C]//Annual 2011:110-120. Conference on Neural Information Processing Systems. [4]AL-EMRAN M.Hierarchical reinforcement learning:a Barcelona,Spain,2016:3675-3683. survey[J].International journal of computing and digital [18]CARLOS FLORENSA,YAN D,PIETER A.Stochastic systems,2015,4(2):137-143. neural networks for hierarchical reinforcement learning [5]MAHADEVAN S,MARCHALLECK N.Self-improving factory EB/OL].Berkeley,USA,arXiv.2017,https://arxiv simulation using continuous-time average-reward reinforcement org/pdf/1704.03012.pdf. learning[C].In Proceedings of the Machine Learning [19]LAKSHMINARAYANAN A S,KRISHNAMURTHY R. International Workshop.Nashville,USA,1997:202-210. KUMAR P,et al.Option discovery in hierarchical [6]HOWARD R A.Semi-Markov and decision processes[M]. reinforcement learning using spatio-temporal clustering New York:DOVER Publications,2007. [EB/OL].Madras,India,arXiv,2016,https://arxiv. [7]GIL P,NUNES L.Hierarchical reinforcement learning using org/pdf/1605.05359.pdf. path clustering [C]//In Proceedings of 8th Iberian [20]XUE B,GLEN B.DeepLoco:dynamic locomotion skills Conference on Information Systems and Technologies using hierarchical deep reinforcement learning[J].ACM Lisboa,Portugal,2013:1-6. transactions on graphics,2017,36(4):1-13. 8]STULP F,SCHAAL S.Hierarchical reinforcement learning 作者简介: with movement primitives C]//In Proceedings of 11th 周文吉,男,1995年生,硕士研究 IEEE-RAS International Conference on Humanoid Robots. 生,主要研究方向为强化学习和数据 Bled,Slovenia,2011:231-238. 挖掘。 [9]DU X.LI Q.HAN J.Applying hierarchical reinforcement learning to computer games[C]//In Proceedings of IEEE International Conference on Automation and Logistics. Xian,China,2009:929-932. [10]SUTTON R S,PRECUP D,SINGH S.Between MDPs and semi-MDPs:a framework for temporal abstraction in 俞扬,男.1982年生,副教授,博士 reinforcement learning J].Artificial intelligence,1999. 生导师,主要研究方向为人工智能、机 112(1/2):181-211. 器学习、演化计算、数据挖掘。曾获 [11 PARR R,RUSSELL S.Reinforcement learning with 2013年全国优秀博士学位论文奖,2011 hierarchies of machines [C]//Advances in Neural 年中国计算机学会优秀博士学位论文 Information Processing Systems.Colorado,USA,1998: 奖。发表论文40余篇。 1043-1049

用。 然后,在第 2 节分 4 个方面,阐述了 Sutton 等提 出的 option 方法,Parr 和 Russell 提出的 HAMs 方法 以及 Dierrerich 等提出的 MaxQ 方法,阐述了这些方 法具体的计算方法。 分析了近两年来的研究方向, 介绍了一些端到端的、自动抽象的分层强化学习。 分层强化学习是解决大规模强化学习的潜在途径, 然而其受到的关注不足。 希望本篇综述能够引起 更多人关注分层强化学习。 参考文献: [ 1 ] BARTO A G, MAHADEVAN S. Recent advances in hierarchical reinforcement learning[J]. Discrete event dynamic systems, 2013,13(4): 341-379. [2 ] YAN Q, LIU Q, HU D. A hierarchical reinforcement learning algorithm based on heuristic reward function[C] / / In Proceedings of 2nd International Conference on Advanced Computer Control. Shenyang, China, 2010, 3:371-376. [3] DETHLEFS N, CUAYÁHUITL H. Combining hierarchical reinforcement learning and Bayesian networks for natural language generation in situated dialogue[C] / / European Workshop on Natural Language Generation. Nancy, France, 2011: 110-120. [ 4 ] AL⁃EMRAN M. Hierarchical reinforcement learning: a survey[ J]. International journal of computing and digital systems, 2015, 4(2):137-143. [5] MAHADEVAN S, MARCHALLECK N. Self⁃improving factory simulation using continuous⁃time average⁃reward reinforcement learning [ C ]. In Proceedings of the Machine Learning International Workshop. Nashville, USA, 1997: 202-210. [6] HOWARD R A. Semi⁃Markov and decision processes[M]. New York: DOVER Publications, 2007. [7]GIL P, NUNES L. Hierarchical reinforcement learning using path clustering [ C ] / / In Proceedings of 8th Iberian Conference on Information Systems and Technologies. Lisboa, Portugal, 2013: 1-6. [8]STULP F, SCHAAL S. Hierarchical reinforcement learning with movement primitives [ C ] / / In Proceedings of 11th IEEE⁃RAS International Conference on Humanoid Robots. Bled, Slovenia, 2011: 231-238. [9]DU X, LI Q, HAN J. Applying hierarchical reinforcement learning to computer games [ C] / / In Proceedings of IEEE International Conference on Automation and Logistics. Xian, China, 2009: 929-932. [10]SUTTON R S, PRECUP D, SINGH S. Between MDPs and semi⁃MDPs: a framework for temporal abstraction in reinforcement learning [ J]. Artificial intelligence, 1999, 112(1 / 2): 181-211. [ 11 ] PARR R, RUSSELL S. Reinforcement learning with hierarchies of machines [ C ] / / Advances in Neural Information Processing Systems. Colorado, USA, 1998: 1043-1049. [12 ] DIETTERICH T G. Hierarchical reinforcement learning with the MAXQ value function decomposition[J]. Journal of artificial intelligence research, 2000, 13: 227-303. [ 13 ] MOHSEN G, TAGHIZADEH N, et al. Automatic abstraction in reinforcement learning using ant system algorithm[C] / / In Proceedings of AAAI Spring Symposium: Lifelong Machine Learning. Stanford, USA, 2013: 114-122. [14] PIERRE⁃LUC BACON, JEAN HARB. The option - critic architecture[C] / / In Proceeding of 31th AAAI Conference on Artificial Intelligence. San Francisco, USA, 2017: 1726-1734. [15] VEZHNEVETS A S, OSINDERO S, SCHAUL T, et al. FeUdal networks for hierarchical reinforcement learning[C] / / In Proceedings of the 34th International Conference on Machine Learning. Sydney, Australia, 2017: 3540-3549. [ 16 ] MNIH V, KAVUKCUOGLU K, SILVER D, et al. Human⁃level control through deep reinforcement learning[J]. Nature, 2015, 518(2): 529-533. [17] TEJAS D. K, KARTHNIK N, ARDAVAN S, et al. Hierarchical deep reinforcement learning: integrating temporal abstraction and intrinsic motivation[C] / / Annual Conference on Neural Information Processing Systems. Barcelona, Spain, 2016: 3675-3683. [18] CARLOS FLORENSA, YAN D, PIETER A. Stochastic neural networks for hierarchical reinforcement learning [EB/ OL]. Berkeley, USA, arXiv. 2017, https: / / arxiv. org / pdf / 1704.03012.pdf. [19] LAKSHMINARAYANAN A S, KRISHNAMURTHY R, KUMAR P, et al. Option discovery in hierarchical reinforcement learning using spatio⁃temporal clustering [EB/ OL]. Madras, India, arXiv, 2016, https: / / arxiv. org / pdf / 1605.05359.pdf. [20]XUE B , GLEN B. DeepLoco: dynamic locomotion skills using hierarchical deep reinforcement learning[ J]. ACM transactions on graphics,2017, 36(4):1-13. 作者简介: 周文吉,男,1995 年生,硕士研究 生,主要研究方向为强化学习和数据 挖掘。 俞扬,男,1982 年生,副教授,博士 生导师,主要研究方向为人工智能、机 器学 习、 演 化 计 算、 数 据 挖 掘。 曾 获 2013 年全国优秀博士学位论文奖,2011 年中国计算机学会优秀博士学位论文 奖。 发表论文 40 余篇。 ·594· 智 能 系 统 学 报 第 12 卷