第12卷第5期 智能系统学报 Vol.12 No.5 2017年10月 CAAI Transactions on Intelligent Systems 0ct.2017 D0I:10.11992/is.201706026 网络出版地址:htp:/kns.cmki.net/kcms/detail/23.1538.TP.20171021.1350.010.html 基于语义特征的多视图情感分类方法 吴钟强12,张耀文12,商琳12 (1.南京大学计算机软件新技术国家重点实验室,江苏南京210046:2.南京大学计算机科学与技术系,江苏南京210046) 摘要:情感分析也称为意见挖掘,是对文本中所包含的情感倾向进行分析的技术。目前很多情感分析工作都是基 于纯文本的。而在微博上,除了文本,大量的图片信息也蕴含了丰富的情感信息。本文提出了一种基于文本和图像 的多模态分类算法,通过使用潜在语义分析,将文本特征和图像特征分别映射到同维度下的语义空间,得到各自的 语义特征,并用SVM2K进行分类。利用新浪微博热门微博栏目下爬取的文字和配图的微博数据进行了实验。实验 结果表明,通过融合文本和图像的语义特征,情感分类的效果好于单独使用文本特征或者图像特征。 关键词:情感分析:文本挖掘:潜在语义分析:多模态:语义特征:特征融合:特征提取 中图分类号:TP181文献标志码:A文章编号:1673-4785(2017)05-0745-07 中文引用格式:吴钟强,张撮文,商琳.基于语义特征的多视图情感分类方法[J].智能系统学报,2017,12(5):745-751. 英文引用格式:WU Zhongqiang,ZHANG Yaowen,SHANG Lin.Multi-view sentiment classification of microblogs based on semantic features[J].CAAI transactions on intelligent systems,2017,12(5):745-751. Multi-view sentiment classification of microblogs based on semantic features WU Zhongqiang2,ZHANG Yaowen'2,SHANG Lin'2 (1.State Key Laboratory of Novel Software Technology,Nanjing University,Nanjing 210046,China;2.Department of Computer Science and Technology,Nanjing University,Nanjing 210046,China) Abstract:The objective in sentiment analysis is to analyze the sentiment tendency contained in subjective text.Most sentiment analysis methods deal with text only and ignore the information provided in the corresponding pictures.In this paper,we propose a multi-view microblog analysis method based on semantic features.Using latent semantic analysis,we map both the text and image features to the semantic space in the same dimensionality,and use SVM- 2K to obtain and classify the respective semantic features.We conducted experiments by crawling text and pictures from popular microblogs.The results show that,by combining the semantic features of text and pictures,the sentiment classification result is better than that obtained using text or image features alone. Keywords:sentiment analysis;text mining;latent semantic analysis;multi-view;semantic features;feature fusion;feature extraction 随着互联网的快速发展,微博自2006年以来已 析的技术。随着Pang等将机器学习方法成功 经成为社交网络的最主要应用之一。用户可以通 应用在情感分类之后,情感分析领域不断涌现新的 过手机或平板电脑等终端设备在微博上发布动态。 工作,针对于粒度的不同可以分为文档级别到 近年来,从微博数据中挖掘出有价值的信息引起了 (document level)、句子级别](sentence level)和方 很多研究者的关注。情感分析或意见挖掘,是一种 面级别+s(aspect level)。情感分析的应用也越来 对人们发表的观点、表达的情感或商品评价进行分 越广泛,如Liu等[将其用于预测销售业绩上, Mishne等]使用博文的情感来预测电影票房, 收稿日期:2017-06-08.网络出版日期:2017-10-21. 基金项目:国家自然科学基金项目(61672276):江苏省自然科学基金项 0'Connor将文本中的情感与票选关联[]。但是绝 目(20161406). 通信作者:吴钟强.E-mail:wuzqchom@163.com 大多数研究都只是基于文本,结合微博图像进行情

第 12 卷第 5 期 智 能 系 统 学 报 Vol.12 №.5 2017 年 10 月 CAAI Transactions on Intelligent Systems Oct. 2017 DOI:10.11992 / tis.201706026 网络出版地址:http: / / kns.cnki.net / kcms/ detail / 23.1538.TP.20171021.1350.010.html 基于语义特征的多视图情感分类方法 吴钟强1,2 ,张耀文1,2 ,商琳1,2 (1.南京大学 计算机软件新技术国家重点实验室,江苏 南京 210046; 2. 南京大学 计算机科学与技术系,江苏 南京 210046) 摘 要:情感分析也称为意见挖掘,是对文本中所包含的情感倾向进行分析的技术。 目前很多情感分析工作都是基 于纯文本的。 而在微博上,除了文本,大量的图片信息也蕴含了丰富的情感信息。 本文提出了一种基于文本和图像 的多模态分类算法,通过使用潜在语义分析,将文本特征和图像特征分别映射到同维度下的语义空间,得到各自的 语义特征,并用 SVM⁃2K 进行分类。 利用新浪微博热门微博栏目下爬取的文字和配图的微博数据进行了实验。 实验 结果表明,通过融合文本和图像的语义特征,情感分类的效果好于单独使用文本特征或者图像特征。 关键词:情感分析;文本挖掘;潜在语义分析;多模态;语义特征;特征融合;特征提取 中图分类号:TP181 文献标志码:A 文章编号:1673-4785(2017)05-0745-07 中文引用格式:吴钟强,张耀文,商琳. 基于语义特征的多视图情感分类方法[J]. 智能系统学报, 2017, 12(5): 745-751. 英文引 用 格 式: WU Zhongqiang, ZHANG Yaowen, SHANG Lin. Multi⁃view sentiment classification of microblogs based on semantic features[J]. CAAI transactions on intelligent systems, 2017, 12(5): 745-751. Multi⁃view sentiment classification of microblogs based on semantic features WU Zhongqiang 1, 2 , ZHANG Yaowen 1,2 , SHANG Lin 1,2 (1. State Key Laboratory of Novel Software Technology, Nanjing University, Nanjing 210046, China; 2. Department of Computer Science and Technology, Nanjing University, Nanjing 210046, China) Abstract:The objective in sentiment analysis is to analyze the sentiment tendency contained in subjective text. Most sentiment analysis methods deal with text only and ignore the information provided in the corresponding pictures. In this paper, we propose a multi⁃view microblog analysis method based on semantic features. Using latent semantic analysis, we map both the text and image features to the semantic space in the same dimensionality, and use SVM⁃ 2K to obtain and classify the respective semantic features. We conducted experiments by crawling text and pictures from popular microblogs. The results show that, by combining the semantic features of text and pictures, the sentiment classification result is better than that obtained using text or image features alone. Keywords: sentiment analysis; text mining; latent semantic analysis; multi⁃view; semantic features; feature fusion; feature extraction 收稿日期:2017-06-08. 网络出版日期:2017-10-21. 基金项目:国家自然科学基金项目(61672276);江苏省自然科学基金项 目(20161406). 通信作者:吴钟强.E⁃mail: wuzqchom@ 163.com. 随着互联网的快速发展,微博自 2006 年以来已 经成为社交网络的最主要应用之一。 用户可以通 过手机或平板电脑等终端设备在微博上发布动态。 近年来,从微博数据中挖掘出有价值的信息引起了 很多研究者的关注。 情感分析或意见挖掘,是一种 对人们发表的观点、表达的情感或商品评价进行分 析的技术[1] 。 随着 Pang 等[2] 将机器学习方法成功 应用在情感分类之后,情感分析领域不断涌现新的 工作,针 对 于 粒 度 的 不 同 可 以 分 为 文 档 级 别[2] (document level)、句子级别[3] ( sentence level) 和方 面级别[4-5] (aspect level)。 情感分析的应用也越来 越广泛, 如 Liu 等[6] 将其用于预测销售业绩上, Mishne 等[7] 使 用 博 文 的 情 感 来 预 测 电 影 票 房, O’Connor将文本中的情感与票选关联[8] 。 但是绝 大多数研究都只是基于文本,结合微博图像进行情

·746 智能系统学报 第12卷 感分类的工作较少。但图像也是传达情感信息的 SVD)技术将词-文档矩阵分解,可以将原始高维空 重要渠道。对于文本和图像并存的情况,图像也可 间中表示的词和文档投射到低维语义空间。 以作为传播情感的载体,如果仅对文本部分进行特 LSA首先构造一个词-文档矩阵N=[X:]。其 征的提取,可能导致对微博整体情感特征提取的缺 中矩阵的行表示词,列表示文档,X表示第i个词 失,使得整体情感分类的结果不理想。 在第广个文档中的权重。矩阵中的一行‘:= 要使用不同视图的特征就涉及特征融合问题。 [x1x2…xm]代表某个词和所有文档之间的关系, 特征融合被广泛应用在多个领域,如目标跟踪和识 矩阵中的一列d,=[xyxg…x]代表某个文档和 别)、图像处理0]等领域,主要可以分为串行融合 所有词语之间的关系(x:≠0表示该文档包含该词 和并行融合山。 汇,其值表示第i个词在第个文档中的权重)。两 本文通过复数矩阵融合的方式并使用潜在语 个行向量的点积·1,「代表文档中两个词(第i个 义分析2](latent semantic analysis,LSA)技术提出了 词和第p个词)的相关性;两个列的点积d·d,代表 基于语义特征的多视图分类方法。首先,将文本和 两个文档(第j篇文档和第g篇文档)的相关性。由 图像并行融合之后的特征,通过潜在语义分析将原 于一个词一般出现在几个特定文档中,故矩阵N通 始的文本和图像特征映射到低维的概念空间(语义 常是一个稀疏矩阵。而通过奇异值分解,可以将高 空间)得到文本和图像的语义特征:然后,通过语义 维的系数矩阵转化成低维的稠密矩阵。任何一个 特征训练分类器:最后,将分类器用于微博的情感 矩阵都可以使用奇异值分解],假设矩阵N为m× 分类。实验通过爬取的新浪微博数据集验证了本 n矩阵,则奇异值分解定义如式(1): 文提出的方法能够有效地提高多视图情感分类的 N=UEV (1) 效果,同时分析了几个常用特征的利弊。 式中:U为m×m的矩阵,Σ为m×n矩阵,V为n× 1潜在语义分析方法简介 n矩阵。矩阵U、V为奇异向量组成的正交方阵。Σ 是奇异值的对角矩阵,Σ=iag(σ1,02,…,0n),其中U1, 1.1潜在语义分析概念 02,un是矩阵N的n个奇异值,且σ1≥02≥…≥ 在信息检索或者文本分析领域,通常使用向量 σ.。得到了奇异值之后,取前r个最大的奇异值以 空间模型2(vector space model,VSM)来表示一篇 及对应的特征向量即可以得到矩阵的低阶近似,如 文档。它将一篇文档或者一段话表示成向量,方便 式(2)所示: 进行各种数学处理。虽然此种方法在一些应用中 N'≈U''VT (2) 可以获得不错的效果,但在实际生活中,可能存在 式中:U'mw=[u1山2…山,],'x=diag(o1,02,…, 多次同义的问题,而VSM并不能很好地发现词与词 o,),Vn=[12…,]T,为奇异值从大到小排列 之间在语义上的关系。 的对角矩阵,其中r的值远小于m和n。目标是使 LSA可以在一定程度上解决上述问题。LSA源 得N与N'尽可能相似同时获得尽可能小的r,其中 自信息检索领域问题:如何从query中找到相关的 r是语义空间的维度。之后,可以在该空间内计算 文档)]。LSA试图表达一个词背后隐藏的语义信 词之间、文档之间以及词与文档之间的相似性度 息,它把词和文档都映射到一个语义空间并在这个 量等。 空间内进行各种运算。这种想法是受到心理语言 学家的启发[。LSA认为文本中的词语存在着潜 2基于语义特征的多视图情感分类 在的语义结构,同义词被映射到相同的语义空间之 现有的情感分类研究工作很多都是围绕文本 后应该有很大的关联度。 展开的,但微博除了文本还存在大量的图片,如果 1.2潜在语义分析 能够将文本和图片结合,就可以获得比纯文本更多 LSA是一种无监督的学习技术,处理的是词- 的信息量。但若仅仅使用原始特征,有可能带来维 文档矩阵(在本文中处理的是文本和图像特征融合 度灾难问题。 后的复数矩阵)。构建词-文档矩阵之后,LSA通过 本文提出的基于语义特征的多视图情感分类 使用奇异值分解1(singular value decomposition, 方法将文本和图像特征并行融合,并使用LSA抽取

感分类的工作较少。 但图像也是传达情感信息的 重要渠道。 对于文本和图像并存的情况,图像也可 以作为传播情感的载体,如果仅对文本部分进行特 征的提取,可能导致对微博整体情感特征提取的缺 失,使得整体情感分类的结果不理想。 要使用不同视图的特征就涉及特征融合问题。 特征融合被广泛应用在多个领域,如目标跟踪和识 别[9] 、图像处理[10]等领域,主要可以分为串行融合 和并行融合[11] 。 本文通过复数矩阵融合的方式并使用潜在语 义分析[2] (latent semantic analysis, LSA)技术提出了 基于语义特征的多视图分类方法。 首先,将文本和 图像并行融合之后的特征,通过潜在语义分析将原 始的文本和图像特征映射到低维的概念空间(语义 空间)得到文本和图像的语义特征;然后,通过语义 特征训练分类器;最后,将分类器用于微博的情感 分类。 实验通过爬取的新浪微博数据集验证了本 文提出的方法能够有效地提高多视图情感分类的 效果,同时分析了几个常用特征的利弊。 1 潜在语义分析方法简介 1.1 潜在语义分析概念 在信息检索或者文本分析领域,通常使用向量 空间模型[12] (vector space model, VSM)来表示一篇 文档。 它将一篇文档或者一段话表示成向量,方便 进行各种数学处理。 虽然此种方法在一些应用中 可以获得不错的效果,但在实际生活中,可能存在 多次同义的问题,而 VSM 并不能很好地发现词与词 之间在语义上的关系。 LSA 可以在一定程度上解决上述问题。 LSA 源 自信息检索领域问题:如何从 query 中找到相关的 文档[13] 。 LSA 试图表达一个词背后隐藏的语义信 息,它把词和文档都映射到一个语义空间并在这个 空间内进行各种运算。 这种想法是受到心理语言 学家的启发[14] 。 LSA 认为文本中的词语存在着潜 在的语义结构,同义词被映射到相同的语义空间之 后应该有很大的关联度。 1.2 潜在语义分析 LSA 是一种无监督的学习技术,处理的是词- 文档矩阵(在本文中处理的是文本和图像特征融合 后的复数矩阵)。 构建词-文档矩阵之后,LSA 通过 使用奇异值分解[15] ( singular value decomposition, SVD)技术将词-文档矩阵分解,可以将原始高维空 间中表示的词和文档投射到低维语义空间。 LSA 首先构造一个词-文档矩阵 N = [Xij]。 其 中矩阵的行表示词,列表示文档, Xij 表示第 i 个词 在第 j 个 文 档 中 的 权 重。 矩 阵 中 的 一 行 t i = [xi1 xi2 … xin ] 代表某个词和所有文档之间的关系, 矩阵中的一列 dj = [x1j x2j … xmj] T 代表某个文档和 所有词语之间的关系( xij ≠ 0 表示该文档包含该词 汇,其值表示第 i 个词在第 j 个文档中的权重)。 两 个行向量的点积 t i·t p T 代表文档中两个词(第 i 个 词和第 p 个词)的相关性;两个列的点积 d T j ·dq 代表 两个文档(第 j 篇文档和第 q 篇文档)的相关性。 由 于一个词一般出现在几个特定文档中,故矩阵 N 通 常是一个稀疏矩阵。 而通过奇异值分解,可以将高 维的系数矩阵转化成低维的稠密矩阵。 任何一个 矩阵都可以使用奇异值分解[15] ,假设矩阵 N 为 m × n 矩阵,则奇异值分解定义如式(1): N = UΣ V T (1) 式中:U 为 m × m 的矩阵, Σ 为 m × n 矩阵,V 为 n × n 矩阵。 矩阵 U、V 为奇异向量组成的正交方阵。 Σ 是奇异值的对角矩阵,Σ =diag(σ1,σ2,…,σn ),其中 σ1, σ2,…σn 是矩阵 N 的 n 个奇异值,且 σ1 ≥ σ2 ≥ … ≥ σn 。 得到了奇异值之后,取前 r 个最大的奇异值以 及对应的特征向量即可以得到矩阵的低阶近似,如 式(2)所示: N′ ≈ U′Σ′V′ T (2) 式中:U′m×r = [ u1 u2 … ur ],Σ′r×r = diag(σ1 ,σ2 ,…, σr),V′ T r×n = [v1 v2… vr] T ,Σ′为奇异值从大到小排列 的对角矩阵,其中 r 的值远小于 m 和 n。 目标是使 得 N 与 N′尽可能相似同时获得尽可能小的 r,其中 r 是语义空间的维度。 之后,可以在该空间内计算 词之间、文档之间以及词与文档之间的相似性度 量等。 2 基于语义特征的多视图情感分类 现有的情感分类研究工作很多都是围绕文本 展开的,但微博除了文本还存在大量的图片,如果 能够将文本和图片结合,就可以获得比纯文本更多 的信息量。 但若仅仅使用原始特征,有可能带来维 度灾难问题。 本文提出的基于语义特征的多视图情感分类 方法将文本和图像特征并行融合,并使用 LSA 抽取 ·746· 智 能 系 统 学 报 第 12 卷

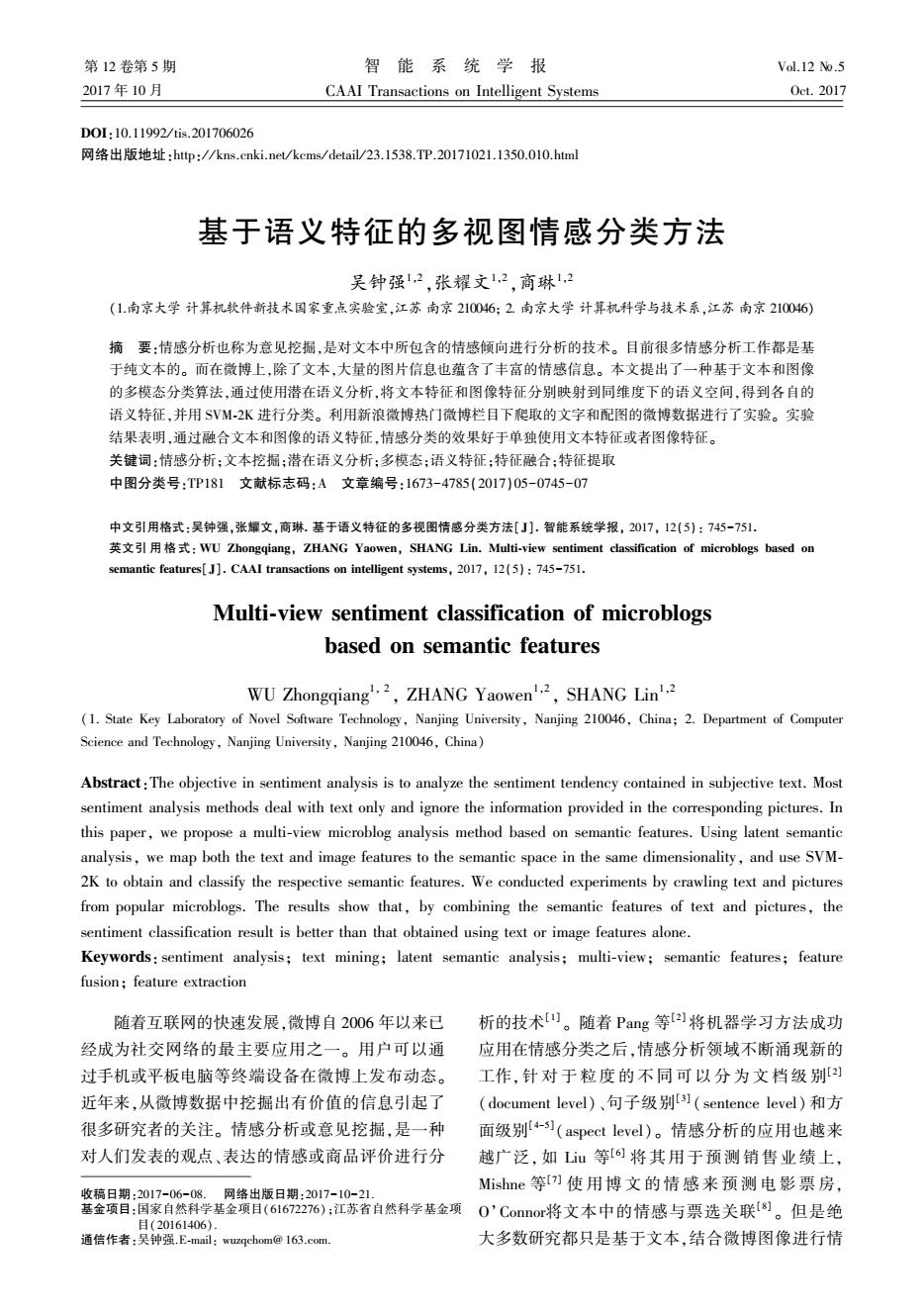

第5期 吴钟强,等:基于语义特征的多视图情感分类方法 .747. 各自的语义特征,其流程如图1所示。 的整体关系,即复数的实部表示文本特征,虚部表 示图像特征。由于复数矩阵分解之后仍为复数矩 文本训练集 图像训练集 阵,故分解之后的实部和虚部分别对应文本和图像 文本预处理 图像预处理 文本测试集 图像测试集 的语义特征。 特 特 文本特征和图像特征融合方法如式(4)所示, 提 取 取 将融合之后的复合特征称为一个新的文档d。 d=&+i那 (4) 基于文本和图像的 潜在语义分析 式中:实部α为文本特征向量,虚部B,为图像特征 向量,0是权重因子。极端情况: 本语义特 片语义特 当00时,融合的特征d≈&,此时近似于纯 文本特征。 当9→+o时,则d≈B,即此时近似于使用纯 SVM-2K 图像特征的分类效果。 结果 在本文工作中,我们将文本和图片同等对待, 图1基于语义特征的多视图情感分类方法流程图 因此设0=1。假设有m条微博,文本和图像的语义 Fig.1 Flow chart of sentiment classification of 空间的维度为n。那么由复数构成新的文档集合用 microblogs based on semantic features 矩阵表示如式(5)所示: 图像和文本的特征融合,在信息检索领域里的 「a11+邛11a12+邛12… in+iBin 跨模型检索(cross-modal retrieval)中已经有相应的 a21+邛21a2+iB2 …a2n+邛2 应用。但使用较多的融合方式是文本和图像特征 的串行融合[o」 N= a1+邛 a2+邛2 cn+邛m Wag等[1o在3D目标检索时,使用的两组特 征串行融合方式如式(3)所示: aml+iB2+i邛na 011 B11B2 B (5) 021 …2 …B21B2 B 式中:a,是第i条微博文本的第j维特征,B,是第i N= 条微博图像对应的第j维特征。 0 X2 B B2 B. 对上面的复数矩阵N进行奇异值分解并进行 低阶近似,把高维的空间映射到低维的语义空间。 a2… C …B … Bnm」 将其映射到语义空间之后,再分别提取分解后低阶 (3) 近似矩阵的每个元素的实部和虚部,得到文本和图 式中:m表示样本的个数,n表示第1个视图的特征 片在低维空间的新特征,即语义特征。最后将提取 的文本和图片的语义特征用于训练多视图分类器 维度,t表示第2个视图的特征维度。α:是第i个样 SVM-2K,并使用测试集测试模型分类结果。具 本的第j维特征,B,是第i个样本的第j维特征。 体步骤如下: 但是这样将两种不同属性的特征强行拼接在 1)提取微博数据中的文本数据和图像数据,然 一个特征空间中,应用到微博中会失去原有的物理 后将文本和图像数据分成训练集和测试集。 特性:一条微博是由文字和配图组成的整体。一条 2)分别对文本和图像进行预处理,并提取文本 微博的文字和配图有一定的内在联系,而不是两个 和图像的特征。 独立的个体。基于并行融合方法[],本文对于融 3)将文本特征和图像特征进行融合,形成一个 合前后的文本和图像特征使用复数进行表示。将 复数矩阵。对该复数矩阵进行奇异值分解降维。 文字图片的特征使用复数进行融合,可以反应微博 将降维后的矩阵分离实部和虚部分别得到文本的

各自的语义特征,其流程如图 1 所示。 图 1 基于语义特征的多视图情感分类方法流程图 Fig.1 Flow chart of sentiment classification of microblogs based on semantic features 图像和文本的特征融合,在信息检索领域里的 跨模型检索( cross⁃modal retrieval)中已经有相应的 应用。 但使用较多的融合方式是文本和图像特征 的串行融合[10] 。 Wang 等 [16] 在 3D 目标检索时,使用的两组特 征串行融合方式如式(3)所示: N = α11 α12 … α1n … β11 β12 … β1t α21 α22 … α2n … β21 β22 … β2t ︙ ︙ ︙ ︙ ︙ ︙ αj1 αj2 … αjn … βj1 βj2 … βjt ︙ ︙ ︙ ︙ ︙ ︙ αm1 αm2 … αmn … βm1 βm2 … βmt é ë ê ê ê ê ê ê ê ê êê ù û ú ú ú ú ú ú ú ú úú (3) 式中: m 表示样本的个数, n 表示第 1 个视图的特征 维度, t 表示第 2 个视图的特征维度。 αij 是第 i 个样 本的第 j 维特征, βij 是第 i 个样本的第 j 维特征。 但是这样将两种不同属性的特征强行拼接在 一个特征空间中,应用到微博中会失去原有的物理 特性:一条微博是由文字和配图组成的整体。 一条 微博的文字和配图有一定的内在联系,而不是两个 独立的个体。 基于并行融合方法[ 10 ] ,本文对于融 合前后的文本和图像特征使用复数进行表示。 将 文字图片的特征使用复数进行融合,可以反应微博 的整体关系,即复数的实部表示文本特征,虚部表 示图像特征。 由于复数矩阵分解之后仍为复数矩 阵,故分解之后的实部和虚部分别对应文本和图像 的语义特征。 文本特征和图像特征融合方法如式(4) 所示, 将融合之后的复合特征称为一个新的文档 dj。 dj = αj + iθβj (4) 式中:实部 αj 为文本特征向量,虚部 βj 为图像特征 向量,θ 是权重因子。 极端情况: 当 θ→0 时,融合的特征 dj ≈ αj, 此时近似于纯 文本特征。 当 θ →+ ¥时,则dj ≈ βj, 即此时近似于使用纯 图像特征的分类效果。 在本文工作中,我们将文本和图片同等对待, 因此设 θ = 1。 假设有 m 条微博,文本和图像的语义 空间的维度为 n 。 那么由复数构成新的文档集合用 矩阵表示如式(5)所示: N = α11 + iβ11 α12 + iβ12 … α1n + iβ1n α21 + iβ21 α22 + iβ22 … α2n + iβ2n ︙ ︙ ︙ αj1 + iβj1 αj2 + iβj2 … αjn + iβjn ︙ ︙ ︙ αm1 + iβm1 αm2 + iβm2 … αmn + iβmn é ë ê ê ê ê ê ê ê ê êê ù û ú ú ú ú ú ú ú ú úú (5) 式中:αij是第 i 条微博文本的第 j 维特征, βij 是第 i 条微博图像对应的第 j 维特征。 对上面的复数矩阵 N 进行奇异值分解并进行 低阶近似,把高维的空间映射到低维的语义空间。 将其映射到语义空间之后,再分别提取分解后低阶 近似矩阵的每个元素的实部和虚部,得到文本和图 片在低维空间的新特征,即语义特征。 最后将提取 的文本和图片的语义特征用于训练多视图分类器 SVM⁃2K [17] ,并使用测试集测试模型分类结果。 具 体步骤如下: 1)提取微博数据中的文本数据和图像数据,然 后将文本和图像数据分成训练集和测试集。 2)分别对文本和图像进行预处理,并提取文本 和图像的特征。 3)将文本特征和图像特征进行融合,形成一个 复数矩阵。 对该复数矩阵进行奇异值分解降维。 将降维后的矩阵分离实部和虚部分别得到文本的 第 5 期 吴钟强,等:基于语义特征的多视图情感分类方法 ·747·

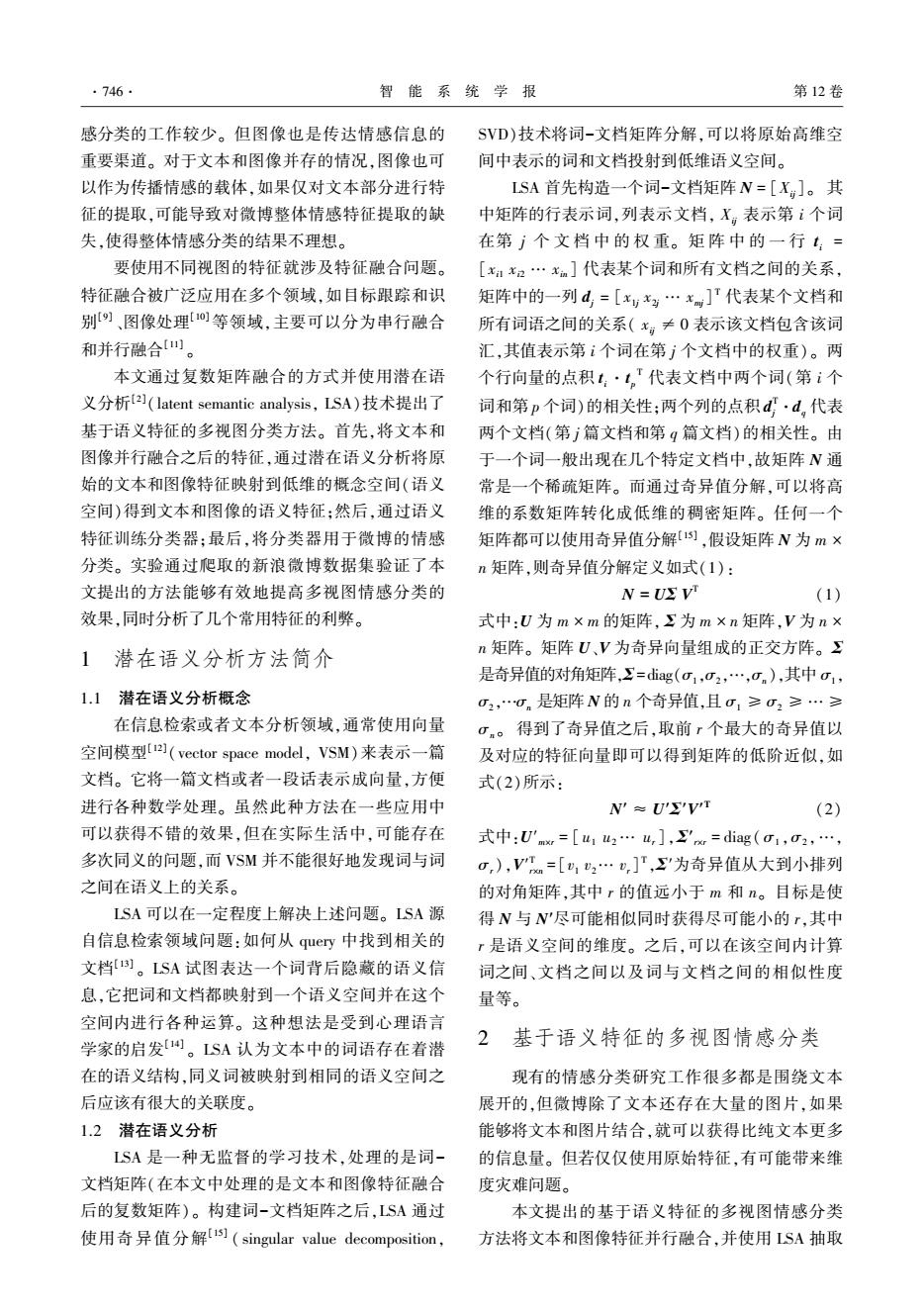

·748· 智能系统学报 第12卷 语义特征和图片的语义特征,语义特征提取过程如 提出方法的有效性我们采取了交叉验证的方式,其 算法所示。 中700条数据作为训练集,300条数据作为测试集。 4)将该语义特征在SVM-2K分类器中进行训 数据采集过程如图2所示。 练,然后用测试集验证。 微博模拟登陆 网页采集器 URL调度器 5)得到测试集的情感分类结果。 算法语义特征提取 输入trainset,testset; 信总抽取 URL数据库 输出lsa_trainset,lsa_testset 1)txtimgtr+Text(trainset)+ixImage(trainset); /*Text函数取数据集中的文本数据,Image函 微博 提取URL 数取数据集中的图像数据,ⅰ为虚数的单位i*/; 2)txtimage+Text(testset)+ix Image(testset); 图2新浪微博数据采集过程 3)C0MPS_LSA←-300: Fig.2 Sina micro-blog data acquisition process 4)comTxtlmgTr+txtimgtr 将得到的微博数据作如下数据预处理: /*txtimgtr为矩阵txtimgtr的转置*/; 1)过滤微博的一些冗余信息,如网址、转发对 5)[U,Σ,VT]=swd(comTxtImgTr,COMPS_LSA); 象、表情符号等。 6)US-U(:,1:COMPS_ISA); 2)将得到的微博文本和图像分离并编号,同一 7)SS-S(1 COMPS_LSA,1:COMPS_LSA); 条微博的文本和图片编号相同。 /*对矩阵进行奇异值分解,取前COMPS_LSA= 3)分词:我们使用汉语分词系统ICTCLAS1]对 300个最大的奇异值,也即为语义空间的维度*/: 微博的文本进行分词。 8)comTxtImgTe←-comTxtImgTe·U·inv(SS); 4)去除停用词:分词后,去除一些无意义的停 9)comTxtlmgTr←comTxtlmg'·US·inv(SS): 用词。 /*inv为取矩阵的逆的函数*/; 3.2实验设计 实验中我们设置LSA语义空间的维度r=300, 10)lsa_Ttr+Text(comTxtImgTr); 11)Isa_Tte+-Text(comTxtImgTe); 分别用向量空间模型(vector space model)和布尔模 型(Bool model)进行加权。由于Tan等[]已经证 12)Isa_Itr+Image(comTxtImgTr); 明对于情感分类来说,6000维度已经可以充分表示 13)Isa_Ite+Image(comTxtImgTe); 文本。除了选取6000作为特征维度,我们展示了 14)return Isa_Ttr+lsi_Itr,Isa_Tte Isi_Ite 特征维度为5000维下的实验结果。 3 实验 在文本特征选择时,使用了文档频率(document frequency,DF)、互信息(mutual information,Ml)、卡 本节实验是为了验证多视图语义特征融合的 方分布(Chi-squared distribution,CH)和信息增益 有效性。我们使用了基于复数表示的文本特征和 (Information Gain,IG)这4种文本特征选择的方 图像特征的并行融合方法,并将其进行潜在语义分 法,并比较了这4种特征做情感分类时的结果:对于 析。将文本特征和图像特征分别映射到同维度下 图像,我们提取了图像的亮度、饱和度、色相、纹理、 语义空间,得到各自的语义特征,将得到的语义特 灰度共生矩阵。然后将提取的特征通过LSA映射 征用于训练分类器,最后使用测试集验证了微博情 到一个语义空间得到各自的语义特征,最后将文本 感分类的效果。 和图像的语义特征使用SVM-2K进行分类,并使用 3.1数据集 测试集测试得到情感分类的结果。通过实验结果 实验的数据集为爬虫从新浪微博的热门微博 验证本文提出的基于文本和图像的语义特征情感 下爬取的。为了完成本文的任务,在爬取微博的时 分类方法的有效性。 候仅仅保留同时含有文字和配图的微博。最终留 3.3实验结果 下1000条微博数据并手动进行标注。为了验证所 表1展示了文本特征为5000维度时,使用纯

语义特征和图片的语义特征,语义特征提取过程如 算法所示。 4) 将该语义特征在 SVM⁃2K 分类器中进行训 练,然后用测试集验证。 5)得到测试集的情感分类结果。 算法 语义特征提取 输入 trainset, testset; 输出 lsa_trainset, lsa_testset。 1)txtimgtr←Text(trainset) + i×Image(trainset); / ∗ Text 函数取数据集中的文本数据,Image 函 数取数据集中的图像数据,i 为虚数的单位 i∗/ ; 2)txtimage←Text(testset) + i × Image(testset); 3)COMPS_LSA←300 ; 4)comTxtImgTr← txtimgtr T / ∗ txtimgtr T 为矩阵 txtimgtr 的转置∗/ ; 5) [U,Σ,V T ] = svd(comTxtImgTr,COMPS_LSA) ; 6)US←U( ∶, 1 ∶COMPS_LSA); 7)SS← S(1 ∶COMPS_LSA, 1 ∶COMPS_LSA); / ∗ 对矩阵进行奇异值分解,取前 COMPS_LSA= 300 个最大的奇异值,也即为语义空间的维度∗/ ; 8)comTxtImgTe←comTxtImgTe·U·inv(SS); 9)comTxtImgTr ←comTxtImgTr T·US·inv(SS); / ∗ inv 为取矩阵的逆的函数∗/ ; 10)lsa_Ttr←Text(comTxtImgTr); 11)lsa_Tte←Text(comTxtImgTe); 12)lsa_Itr←Image(comTxtImgTr); 13)lsa_Ite←Image(comTxtImgTe); 14)return lsa_Ttr+lsi_Itr, lsa_Tte + lsi_Ite。 3 实验 本节实验是为了验证多视图语义特征融合的 有效性。 我们使用了基于复数表示的文本特征和 图像特征的并行融合方法,并将其进行潜在语义分 析。 将文本特征和图像特征分别映射到同维度下 语义空间,得到各自的语义特征,将得到的语义特 征用于训练分类器,最后使用测试集验证了微博情 感分类的效果。 3.1 数据集 实验的数据集为爬虫从新浪微博的热门微博 下爬取的。 为了完成本文的任务,在爬取微博的时 候仅仅保留同时含有文字和配图的微博。 最终留 下 1 000 条微博数据并手动进行标注。 为了验证所 提出方法的有效性我们采取了交叉验证的方式,其 中 700 条数据作为训练集,300 条数据作为测试集。 数据采集过程如图 2 所示。 图 2 新浪微博数据采集过程 Fig.2 Sina micro⁃blog data acquisition process 将得到的微博数据作如下数据预处理: 1)过滤微博的一些冗余信息,如网址、转发对 象、表情符号等。 2)将得到的微博文本和图像分离并编号,同一 条微博的文本和图片编号相同。 3)分词:我们使用汉语分词系统 ICTCLAS [18]对 微博的文本进行分词。 4)去除停用词:分词后,去除一些无意义的停 用词。 3.2 实验设计 实验中我们设置 LSA 语义空间的维度 r = 300, 分别用向量空间模型(vector space model)和布尔模 型(Bool model) 进行加权。 由于 Tan 等 [19]已经证 明对于情感分类来说,6 000 维度已经可以充分表示 文本。 除了选取 6 000 作为特征维度,我们展示了 特征维度为 5 000 维下的实验结果。 在文本特征选择时,使用了文档频率(document frequency, DF)、互信息(mutual information, MI)、卡 方分布(Chi-squared distribution, CHI)和信息增益 (Information Gain, IG) 这 4 种文本特征选择的方 法,并比较了这 4 种特征做情感分类时的结果;对于 图像,我们提取了图像的亮度、饱和度、色相、纹理、 灰度共生矩阵。 然后将提取的特征通过 LSA 映射 到一个语义空间得到各自的语义特征,最后将文本 和图像的语义特征使用 SVM⁃2K 进行分类,并使用 测试集测试得到情感分类的结果。 通过实验结果 验证本文提出的基于文本和图像的语义特征情感 分类方法的有效性。 3.3 实验结果 表 1 展示了文本特征为 5 000 维度时,使用纯 ·748· 智 能 系 统 学 报 第 12 卷

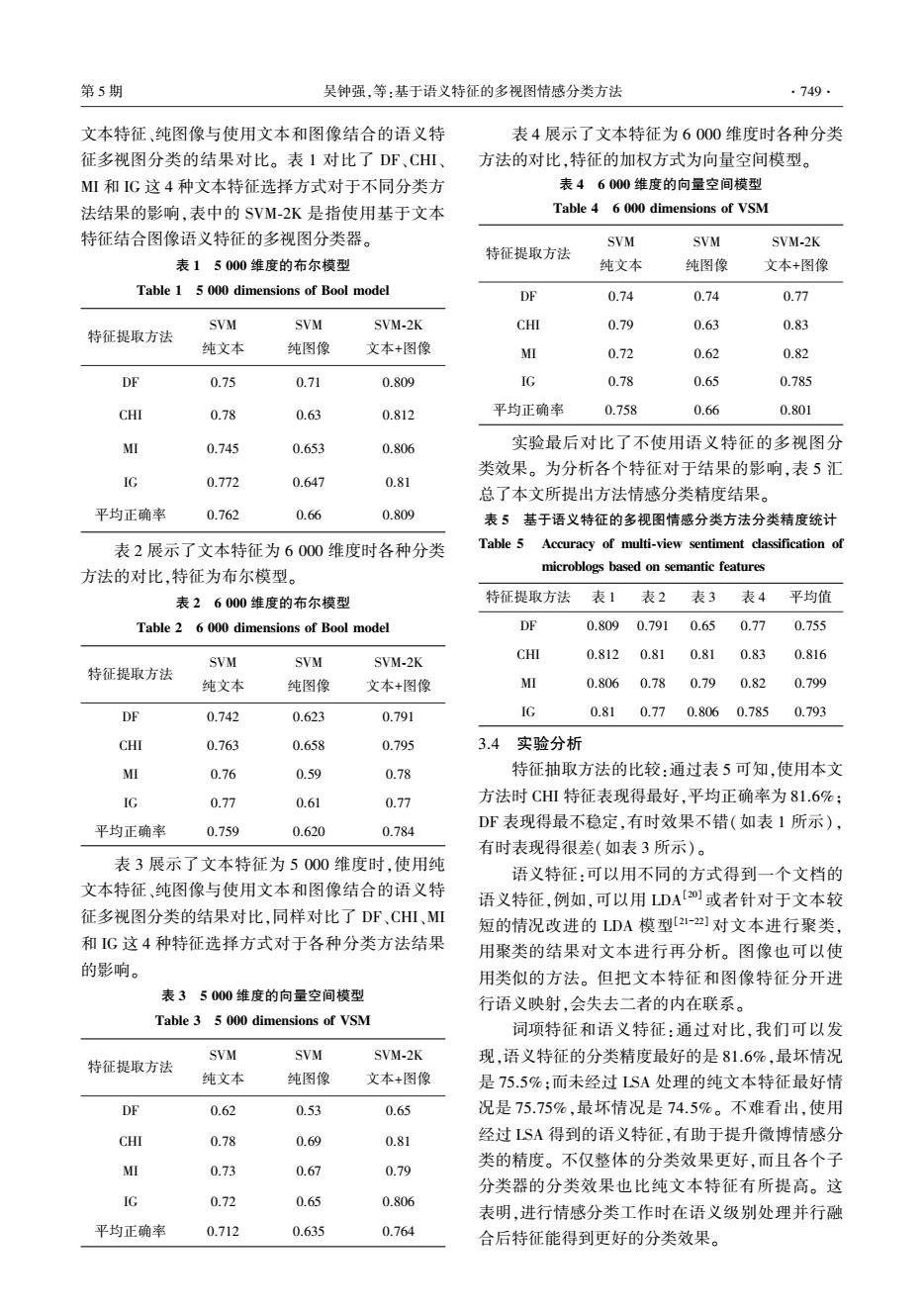

第5期 吴钟强,等:基于语义特征的多视图情感分类方法 .749 文本特征、纯图像与使用文本和图像结合的语义特 表4展示了文本特征为6000维度时各种分类 征多视图分类的结果对比。表1对比了DF、CHⅢ 方法的对比,特征的加权方式为向量空间模型。 MI和IG这4种文本特征选择方式对于不同分类方 表46000维度的向量空间模型 法结果的影响,表中的SVM-2K是指使用基于文本 Table 4 6 000 dimensions of VSM 特征结合图像语义特征的多视图分类器。 SVM SVM SVM-2K 特征提取方法 表15000维度的布尔模型 纯文本 纯图像 文本+图像 Table 1 5 000 dimensions of Bool model DF 0.74 0.74 0.77 SVM SVM SVM-2K CHI 0.79 0.63 0.83 特征提取方法 纯文本 纯图像 文本+图像 MI 0.72 0.62 0.82 DF 0.75 0.71 0.809 IG 0.78 0.65 0.785 CHI 0.78 0.63 0.812 平均正确率 0.758 0.66 0.801 MI 0.745 0.653 0.806 实验最后对比了不使用语义特征的多视图分 类效果。为分析各个特征对于结果的影响,表5汇 IG 0.772 0.647 0.81 总了本文所提出方法情感分类精度结果。 平均正确率 0.762 0.66 0.809 表5基于语义特征的多视图情感分类方法分类精度统计 表2展示了文本特征为6000维度时各种分类 Table 5 Accuracy of multi-view sentiment classification of 方法的对比,特征为布尔模型。 microblogs based on semantic features 表26000维度的布尔模型 特征提取方法 表1 表2 表3 表4 平均值 Table 2 6 000 dimensions of Bool model DE 0.809 0.791 0.65 0.77 0.755 SVM SVM SVM-2K CHI 0.812 0.81 0.81 0.83 0.816 特征提取方法 纯文本 纯图像 文本+图像 MI 0.806 0.78 0.79 0.82 0.799 DF 0.742 0.623 0.791 IG 0.81 0.77 0.8060.785 0.793 CHI 0.763 0.658 0.795 3.4 实验分析 MI 0.76 0.59 0.78 特征抽取方法的比较:通过表5可知,使用本文 IG 0.77 0.61 0.77 方法时CHⅢ特征表现得最好,平均正确率为81.6%; 平均正确率 0.759 0.620 0.784 DF表现得最不稳定,有时效果不错(如表1所示), 有时表现得很差(如表3所示)。 表3展示了文本特征为5000维度时,使用纯 语义特征:可以用不同的方式得到一个文档的 文本特征、纯图像与使用文本和图像结合的语义特 语义特征,例如,可以用DA[20或者针对于文本较 征多视图分类的结果对比,同样对比了DF、CHⅢ、MI 短的情况改进的LDA模型[2I-]对文本进行聚类, 和IG这4种特征选择方式对于各种分类方法结果 用聚类的结果对文本进行再分析。图像也可以使 的影响。 用类似的方法。但把文本特征和图像特征分开进 表35000维度的向量空间模型 行语义映射,会失去二者的内在联系。 Table 3 5 000 dimensions of VSM 词项特征和语义特征:通过对比,我们可以发 SVM SVM SVM-2K 现,语义特征的分类精度最好的是81.6%,最坏情况 特征提取方法 纯文本 纯图像 文本+图像 是75.5%:而未经过LSA处理的纯文本特征最好情 DF 0.62 0.53 0.65 况是75.75%,最坏情况是74.5%。不难看出,使用 CHI 0.78 0.69 0.81 经过LSA得到的语义特征,有助于提升微博情感分 MI 类的精度。不仅整体的分类效果更好,而且各个子 0.73 0.67 0.79 分类器的分类效果也比纯文本特征有所提高。这 IG 0.72 0.65 0.806 表明,进行情感分类工作时在语义级别处理并行融 平均正确率 0.712 0.635 0.764 合后特征能得到更好的分类效果

文本特征、纯图像与使用文本和图像结合的语义特 征多视图分类的结果对比。 表 1 对比了 DF、CHI、 MI 和 IG 这 4 种文本特征选择方式对于不同分类方 法结果的影响,表中的 SVM⁃2K 是指使用基于文本 特征结合图像语义特征的多视图分类器。 表 1 5 000 维度的布尔模型 Table 1 5 000 dimensions of Bool model 特征提取方法 SVM 纯文本 SVM 纯图像 SVM⁃2K 文本+图像 DF 0.75 0.71 0.809 CHI 0.78 0.63 0.812 MI 0.745 0.653 0.806 IG 0.772 0.647 0.81 平均正确率 0.762 0.66 0.809 表 2 展示了文本特征为 6 000 维度时各种分类 方法的对比,特征为布尔模型。 表 2 6 000 维度的布尔模型 Table 2 6 000 dimensions of Bool model 特征提取方法 SVM 纯文本 SVM 纯图像 SVM⁃2K 文本+图像 DF 0.742 0.623 0.791 CHI 0.763 0.658 0.795 MI 0.76 0.59 0.78 IG 0.77 0.61 0.77 平均正确率 0.759 0.620 0.784 表 3 展示了文本特征为 5 000 维度时,使用纯 文本特征、纯图像与使用文本和图像结合的语义特 征多视图分类的结果对比,同样对比了 DF、CHI、MI 和 IG 这 4 种特征选择方式对于各种分类方法结果 的影响。 表 3 5 000 维度的向量空间模型 Table 3 5 000 dimensions of VSM 特征提取方法 SVM 纯文本 SVM 纯图像 SVM⁃2K 文本+图像 DF 0.62 0.53 0.65 CHI 0.78 0.69 0.81 MI 0.73 0.67 0.79 IG 0.72 0.65 0.806 平均正确率 0.712 0.635 0.764 表 4 展示了文本特征为 6 000 维度时各种分类 方法的对比,特征的加权方式为向量空间模型。 表 4 6 000 维度的向量空间模型 Table 4 6 000 dimensions of VSM 特征提取方法 SVM 纯文本 SVM 纯图像 SVM⁃2K 文本+图像 DF 0.74 0.74 0.77 CHI 0.79 0.63 0.83 MI 0.72 0.62 0.82 IG 0.78 0.65 0.785 平均正确率 0.758 0.66 0.801 实验最后对比了不使用语义特征的多视图分 类效果。 为分析各个特征对于结果的影响,表 5 汇 总了本文所提出方法情感分类精度结果。 表 5 基于语义特征的多视图情感分类方法分类精度统计 Table 5 Accuracy of multi⁃view sentiment classification of microblogs based on semantic features 特征提取方法 表 1 表 2 表 3 表 4 平均值 DF 0.809 0.791 0.65 0.77 0.755 CHI 0.812 0.81 0.81 0.83 0.816 MI 0.806 0.78 0.79 0.82 0.799 IG 0.81 0.77 0.806 0.785 0.793 3.4 实验分析 特征抽取方法的比较:通过表 5 可知,使用本文 方法时 CHI 特征表现得最好,平均正确率为 81.6%; DF 表现得最不稳定,有时效果不错(如表 1 所示), 有时表现得很差(如表 3 所示)。 语义特征:可以用不同的方式得到一个文档的 语义特征,例如,可以用 LDA [20] 或者针对于文本较 短的情况改进的 LDA 模型[21-22] 对文本进行聚类, 用聚类的结果对文本进行再分析。 图像也可以使 用类似的方法。 但把文本特征和图像特征分开进 行语义映射,会失去二者的内在联系。 词项特征和语义特征:通过对比,我们可以发 现,语义特征的分类精度最好的是 81.6%,最坏情况 是 75.5%;而未经过 LSA 处理的纯文本特征最好情 况是 75.75%,最坏情况是 74.5%。 不难看出,使用 经过 LSA 得到的语义特征,有助于提升微博情感分 类的精度。 不仅整体的分类效果更好,而且各个子 分类器的分类效果也比纯文本特征有所提高。 这 表明,进行情感分类工作时在语义级别处理并行融 合后特征能得到更好的分类效果。 第 5 期 吴钟强,等:基于语义特征的多视图情感分类方法 ·749·

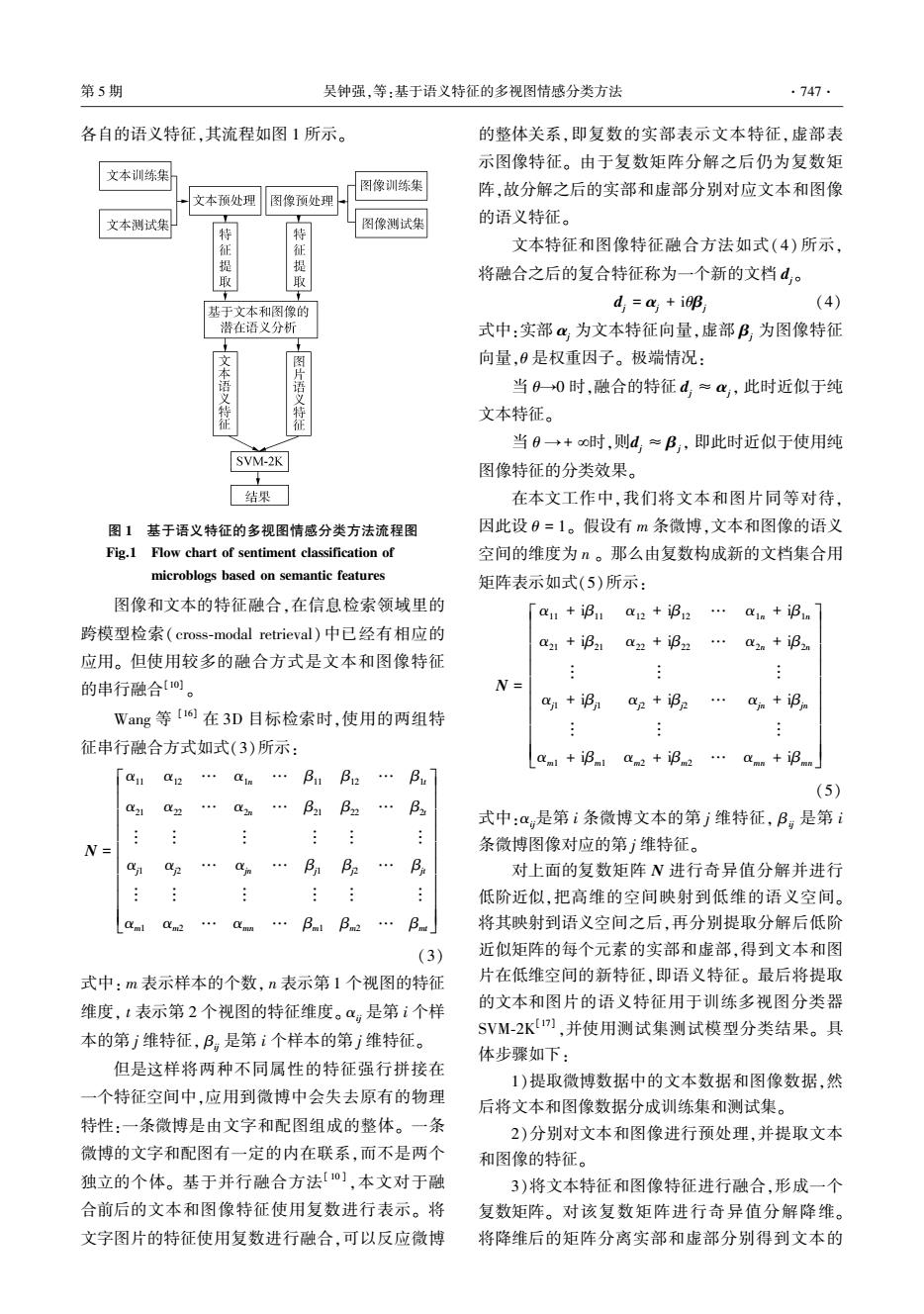

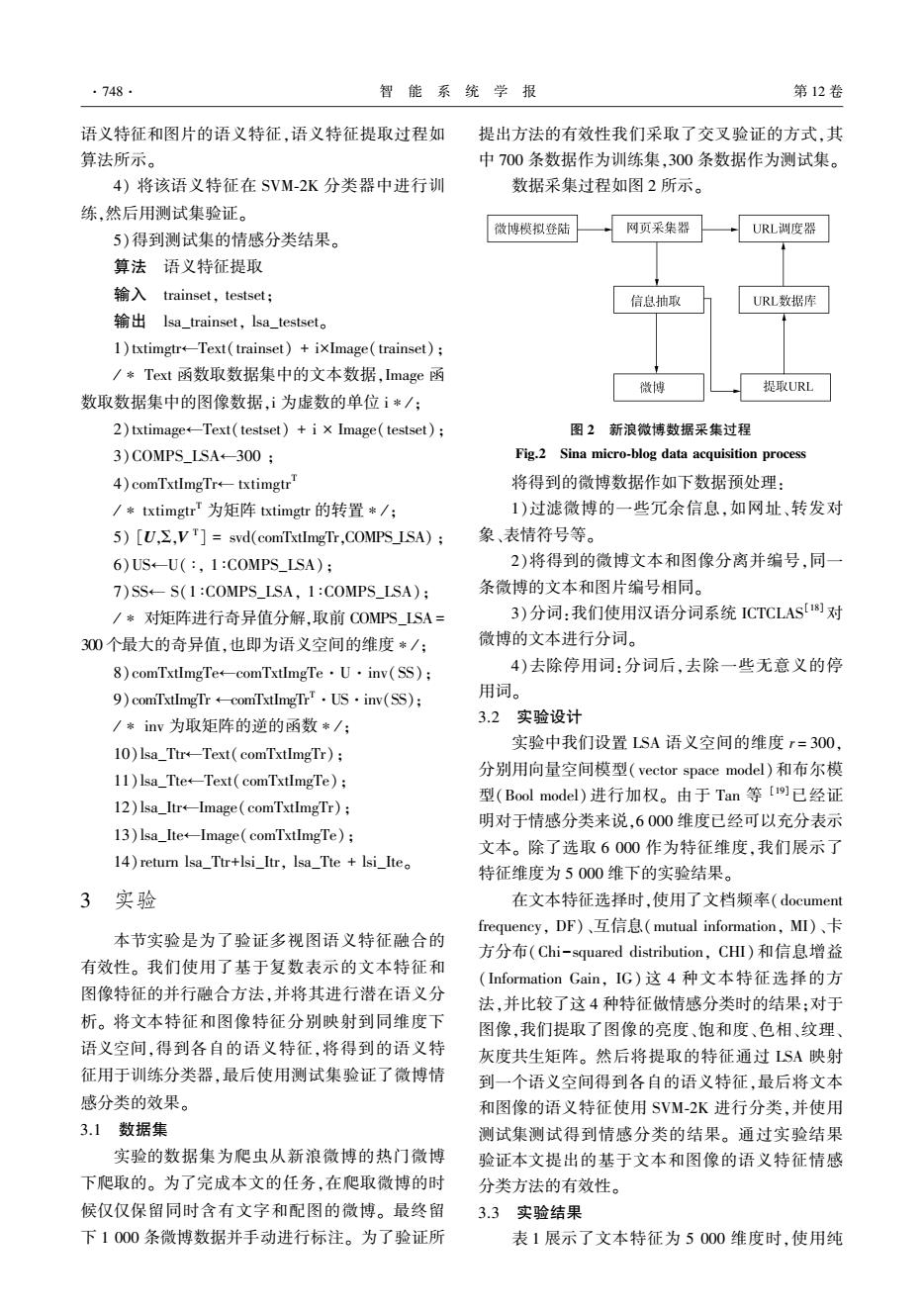

·750 智能系统学报 第12卷 在用户发的带有文本和图片的微博数据中,我 息、地理位置信息等。如何有效地利用这些因素提 们可以发现,本文所提出的基于语义特征的多视图 高情感分类精度有待进一步的研究。 微博情感分类方法的效果明显优于只考虑纯文本 的情况。例如,微博“我希望躺在向日葵上,即使沮 参考文献: 丧,也能朝着阳光”,其配图如图3所示。若使用纯 [1]LIU B.Sentiment analysis and opinion mining[J].Synthesis 文本将其分类得到的是负面的,而若采用本文提出 lectures on human language technologies,2012,5(1): 的多视图语义特征方法将其分类得到的为正面情 1-167. 感。再如,微博“一个人不会,也不可能,将祂的全 [2]PANG T B,PANG B,LEE L.Thumbs up?Sentiment 部呈现给你。你所看到的永远是祂的局部,而局部 classification using machine learning J].Proceedings of EMNLP,2002:79-86. 永远是美好的。”其配图如图4所示。若仅使用纯 [3]TACKSTROM O,MCDONALD R.Semi-supervised latent 文本分类则分类结果为正面情感。采用本文提出 variable models for sentence-level sentiment analysis[C]// 的方法,则得到的是负面情感,而负面情感更加符 The 49th Annual Meeting of the Association for 合事实的判断。进而说明了本文方法的有效性。 Computational Linguistics.Stroudsburg,USA,2011: 569-574. [4]QIU G,LIU B,BU J,et al.Opinion word expansion and target extraction through double propagation[]]. Computational linguistics,2011,37(1):9-27. [5]WU Y.ZAHNG Q.HUANG X,et al.Phrase Dependency Parsing for Opinion Mining[C]//Proceedings of the 2009 Conference on Empirical Methods in Natural Language 图3示例1配图 Processing.Stroudsburg,USA,2009:1533-1541. Fig.3 Image in case 1 [6]LIU Y,HUANG X,AN A,et al.ARSA:a sentiment- aware model for predicting sales performance using blogs [C]//International ACM SIGIR Conference on Research and Development in Information Retrieval.New York,USA, 2007:607-614. [7]MISHNE G,GLANCE N S.Predicting movie sales from blogger sentiment [C]//National Conference on Artificial Intelligence.Menlo Park,USA,2006:155-158. [8]O'CONNOR B,BALASUBRAMANYAN R,ROUTLEDGE 图4示例2配图 B R,et al.From tweets to polls:linking text sentiment to Fig.4 Image in case 2 public opinion time series[C]//Proceedings of the Fourth International AAAI Conference on Weblogs and Social 4结束语 Media.Menlo Park,USA,2010:122-129. 9]CHIANG H C,MOSES R L,POTTER L C.Model-based 本文首先利用并行特征融合方式,将文本和图 Bayesian feature matching with application to synthetic 像合理地组合在一起,然后用潜在语义分析技术, aperture radar target recognition[J].Pattern recognition, 将文本和图像特征统一地映射到一个语义空间,最 2001,34(8):1539-1553. 后使用多视图分类器SVM-2K进行分类。实验表 [10]MCCULLOUGH C L.Feature and data-level fusion of 明,基于本文多视图的语义特征方法的情感分类获 infrared and visual images[J].Proceedings of SPIE-the 得了比单纯的文本特征或者图像特征更好的效果。 international society for optical engineering,1999,3719: 312-318. 使用融合后的语义特征不管是文本特征做情感分 [11]YANG J,YANG J Y,ZHANG D,et al.Feature fusion: 类还是单从图像特征做情感分类,都比原来的分类 parallel strategy vs.serial strategy[J].Pattern 精度有所提高。但是在31小节数据预处理时难免 recognition,2003,36(6):1369-1381. 会剔除一些有用的信息,如表情、终端信息、转发信 [12]SALTON G,WONG A,YANG C S.A vector space model

在用户发的带有文本和图片的微博数据中,我 们可以发现,本文所提出的基于语义特征的多视图 微博情感分类方法的效果明显优于只考虑纯文本 的情况。 例如,微博“我希望躺在向日葵上,即使沮 丧,也能朝着阳光”,其配图如图 3 所示。 若使用纯 文本将其分类得到的是负面的,而若采用本文提出 的多视图语义特征方法将其分类得到的为正面情 感。 再如,微博“一个人不会,也不可能,将祂的全 部呈现给你。 你所看到的永远是祂的局部,而局部 永远是美好的。” 其配图如图 4 所示。 若仅使用纯 文本分类则分类结果为正面情感。 采用本文提出 的方法,则得到的是负面情感,而负面情感更加符 合事实的判断。 进而说明了本文方法的有效性。 图 3 示例 1 配图 Fig.3 Image in case 1 图 4 示例 2 配图 Fig.4 Image in case 2 4 结束语 本文首先利用并行特征融合方式,将文本和图 像合理地组合在一起,然后用潜在语义分析技术, 将文本和图像特征统一地映射到一个语义空间,最 后使用多视图分类器 SVM⁃2K 进行分类。 实验表 明,基于本文多视图的语义特征方法的情感分类获 得了比单纯的文本特征或者图像特征更好的效果。 使用融合后的语义特征不管是文本特征做情感分 类还是单从图像特征做情感分类,都比原来的分类 精度有所提高。 但是在 3.1 小节数据预处理时难免 会剔除一些有用的信息,如表情、终端信息、转发信 息、地理位置信息等。 如何有效地利用这些因素提 高情感分类精度有待进一步的研究。 参考文献: [1]LIU B. Sentiment analysis and opinion mining[J]. Synthesis lectures on human language technologies, 2012, 5 ( 1): 1-167. [2] PANG T B, PANG B, LEE L. Thumbs up? Sentiment classification using machine learning [ J ]. Proceedings of EMNLP, 2002: 79-86. [3] TÄCKSTRÖM O, MCDONALD R. Semi⁃supervised latent variable models for sentence⁃level sentiment analysis[C] / / The 49th Annual Meeting of the Association for Computational Linguistics. Stroudsburg, USA, 2011: 569-574. [4]QIU G, LIU B, BU J, et al. Opinion word expansion and target extraction through double propagation[J]. Computational linguistics, 2011, 37(1): 9-27. [5]WU Y, ZAHNG Q, HUANG X, et al. Phrase Dependency Parsing for Opinion Mining [ C] / / Proceedings of the 2009 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, USA, 2009: 1533-1541. [6] LIU Y, HUANG X, AN A, et al. ARSA: a sentiment - aware model for predicting sales performance using blogs [C] / / International ACM SIGIR Conference on Research and Development in Information Retrieval. New York, USA, 2007: 607-614. [7] MISHNE G, GLANCE N S. Predicting movie sales from blogger sentiment [ C] / / National Conference on Artificial Intelligence. Menlo Park, USA, 2006: 155-158. [8] OCONNOR B, BALASUBRAMANYAN R, ROUTLEDGE B R, et al. From tweets to polls: linking text sentiment to public opinion time series[C] / / Proceedings of the Fourth International AAAI Conference on Weblogs and Social Media. Menlo Park, USA, 2010: 122-129. [9]CHIANG H C, MOSES R L, POTTER L C. Model-based Bayesian feature matching with application to synthetic aperture radar target recognition [ J]. Pattern recognition, 2001, 34(8): 1539-1553. [ 10 ] MCCULLOUGH C L. Feature and data⁃level fusion of infrared and visual images [ J]. Proceedings of SPIE⁃the international society for optical engineering, 1999, 3719: 312-318. [11]YANG J, YANG J Y, ZHANG D, et al. Feature fusion: parallel strategy vs. serial strategy[J]. Pattern recognition, 2003, 36(6): 1369-1381. [12]SALTON G, WONG A, YANG C S. A vector space model ·750· 智 能 系 统 学 报 第 12 卷

第5期 吴钟强.等:基于语义特征的多视图情感分类方法 ·751. for automatic indexing M ]New York:ACM,1975: [21]ZHAO W X,JIANG J,WENG J,et al.Comparing twitter 613-620. and traditional media using topic models[J].Lecture [13]DEERWESTER S,DUMAIS ST,FURNAS G W.Indexing notes in computer science,2011,6611:338-349. by latent semantic analysis[J].Journal of the american [22]YAN X,GUO J,LAN Y,et al.A biterm topic model for society for information science,1990,41:391-407. short texts[C]//Proceedings of the 22nd interational [14]REHDER B,SCHREINER M E,WOLFE M B W,et al. conference on World Wide Web.New York,USA,2013: Using latent semantic analysis to assess knowledge:some 1445-1456. technical considerations[J].Discourse processes,1998. 作者简介: 25(2/3):337-354. 吴钟强,男,1992年生,硕士研究 [15]GOLUB G H,REINSCH C.Singular value decomposition 生,主要研究方向为文本挖掘、情感 and least squares solutions[].Numerische mathematik, 分析。 1970.14(5):403-420. [16]WANG F,PENG J,LI Y.Hypergraph based feature fusion for 3-D object retrieval[J].Neurocomputing,2015,151: 612-619 [17]FARQUHAR J D R,HARDOON D R,MENG H,et al. 张耀文,男,1989年生,硕士研究 Two view learning:SVM-2K,theory and practice[C]/ 生,主要研究方向为文本挖掘、情感 International Conference on Neural Information Processing 分析。 Systems.Stroud sburg,USA,2005:355-362. [18 ZHANG H P,YU H K,XIONG D Y,et al.HHMM- based Chinese lexical analyzer ICTCLAS[C]// Proceedings of the second SIGHAN workshop on Chinese language Processing-Volume 17.Stroudsburg,USA, 商琳,女,1973年生,副教授,博士, 2003:758-759. 主要研究方向为计算智能、机器学习、 [19]TAN S,ZHANG J.An empirical study of sentiment 文本挖掘等。 analysis for chinese documents[J].Expert systems with applications,2008,34(4):2622-2629. [20]BLEI D M,NG A Y,JORDAN M I.Latent dirichlet allocation[].Journal of machine learning research, 2003.3:993-1022

for automatic indexing [ M]. New York: ACM, 1975: 613-620. [13]DEERWESTER S, DUMAIS S T, FURNAS G W. Indexing by latent semantic analysis [ J]. Journal of the american society for information science, 1990, 41: 391-407. [14]REHDER B, SCHREINER M E, WOLFE M B W, et al. Using latent semantic analysis to assess knowledge: some technical considerations[ J]. Discourse processes, 1998, 25(2 / 3): 337-354. [15]GOLUB G H, REINSCH C. Singular value decomposition and least squares solutions[ J]. Numerische mathematik, 1970, 14(5): 403-420. [16]WANG F, PENG J, LI Y. Hypergraph based feature fusion for 3⁃D object retrieval[J]. Neurocomputing, 2015, 151: 612-619. [17]FARQUHAR J D R, HARDOON D R, MENG H, et al. Two view learning: SVM⁃2K, theory and practice[C] / / International Conference on Neural Information Processing Systems. Stroud sburg, USA, 2005: 355-362. [18] ZHANG H P, YU H K, XIONG D Y, et al. HHMM - based Chinese lexical analyzer ICTCLAS[C] / / Proceedings of the second SIGHAN workshop on Chinese language Processing⁃Volume 17. Stroudsburg, USA, 2003: 758-759. [19] TAN S, ZHANG J. An empirical study of sentiment analysis for chinese documents [ J]. Expert systems with applications, 2008, 34(4): 2622-2629. [20] BLEI D M, NG A Y, JORDAN M I. Latent dirichlet allocation[J]. Journal of machine learning research, 2003, 3: 993-1022. [21]ZHAO W X, JIANG J, WENG J, et al. Comparing twitter and traditional media using topic models [ J ]. Lecture notes in computer science, 2011, 6611: 338-349. [22]YAN X, GUO J, LAN Y, et al. A biterm topic model for short texts[C] / / Proceedings of the 22nd international conference on World Wide Web. New York, USA, 2013: 1445-1456. 作者简介: 吴钟强,男,1992 年生,硕士研究 生,主要研究方 向 为 文 本 挖 掘、 情 感 分析。 张耀文,男,1989 年生,硕士研究 生,主要研究方 向 为 文 本 挖 掘、 情 感 分析。 商琳,女,1973 年生,副教授,博士, 主要研究方向为计算智能、 机器学习、 文本挖掘等。 第 5 期 吴钟强,等:基于语义特征的多视图情感分类方法 ·751·