历华毛子种枝大学 图神经网络 XIDIAN UNIVERSITY 1.图神经网络简介 2.图神经网络的种类 3.图卷积网络 2

1.图神经网络简介 2.图神经网络的种类 3. 图卷积网络 图神经网络 2

面些毛子种枝大票 1.图神经网络简介 XIDIAN UNIVERSITY 图神经网络是处理图数据的神经网络 深度学习在很多领域的成功部分归功于: ●计算资源的快速发展(GPU); ●大规模训练数据集的获取; ●深度学习对欧式数据(图像、视频、文本)的隐含表示的提取能力 ■ 然而,有大量的数据是非欧式的,图数据是非欧式的,因为图数据是非规 则的,节点的排列是无序的,每个节点的邻居数量也不同。这就导致在图 像数据上很好用的模型操作,比如卷积,无法直接用在图数据上。 传统机器学习一般都假定数据点之间是相互独立的,而图中的数据点(节 点)不是独立的,与其他节点存在各种以边描述的各种关系

1. 图神经网络简介 3 图神经网络是处理图数据的神经网络 深度学习在很多领域的成功部分归功于: 计算资源的快速发展(GPU); 大规模训练数据集的获取; 深度学习对欧式数据(图像、视频、文本)的隐含表示的提取能力 然而,有大量的数据是非欧式的,图数据是非欧式的,因为图数据是非规 则的,节点的排列是无序的,每个节点的邻居数量也不同。这就导致在图 像数据上很好用的模型操作,比如卷积,无法直接用在图数据上。 传统机器学习一般都假定数据点之间是相互独立的,而图中的数据点(节 点)不是独立的,与其他节点存在各种以边描述的各种关系

历安毛子代枚大等 1.图神经网络简介 XIDIAN UNIVERSITY 怎样把深度学习方法扩展到图数据? ●卷积神经网络、递归神经网络、深度自编码器拓展设计成图 神经网络 ●比如图卷积操作。一个2维的图像卷积操作,一个像素点的 值是对其周围被滤波器大小划定的区域取加权平均,其邻居 的数量是固定的、有序的。扩展到图卷积以后,图卷积是对 每个节点及其邻居的特征值取平均,每个节点的邻居数量不 固定,也无序

1. 图神经网络简介 4 怎样把深度学习方法扩展到图数据? 卷积神经网络、递归神经网络、深度自编码器拓展设计成图 神经网络 比如图卷积操作。一个2维的图像卷积操作,一个像素点的 值是对其周围被滤波器大小划定的区域取加权平均,其邻居 的数量是固定的、有序的。扩展到图卷积以后,图卷积是对 每个节点及其邻居的特征值取平均,每个节点的邻居数量不 固定,也无序

面些毛子种枝大学 2.图神经网络的种类 XIDIAN UNIVERSITY ① 循环图神经网络(recurrent GNNs(RecGNNs)) 循环图神经网络假定节点总是和自己的邻居节点交换信息、消息等,直到到 达一个稳定的平衡点,以此来学习目标节点的表示。这种方式计算复杂性较 高,目前关于这种方法的改进也主要集中于这个方向。循环神经网络研究的 比较早,对后面的的卷积神经网络有重要的启发,基于空间的神经网络也继 承了消息传递的方法

2. 图神经网络的种类 5 ① 循环图神经网络(recurrent GNNs (RecGNNs)) 循环图神经网络假定节点总是和自己的邻居节点交换信息、消息等,直到到 达一个稳定的平衡点,以此来学习目标节点的表示。这种方式计算复杂性较 高,目前关于这种方法的改进也主要集中于这个方向。循环神经网络研究的 比较早,对后面的的卷积神经网络有重要的启发,基于空间的神经网络也继 承了消息传递的方法

历些毛子代枝大皇 2.图神经网络的种类 XIDIAN UNIVERSITY ②卷积图神经网络(convolutional GNNs) 受到卷积神经网络在计算机视觉领域巨大成功的影响,很多学者定义了 不同的图卷积操作以处理图数据,这类图神经网络称为图卷积网络( GCNs)。卷积图神经网络将格点数据上的卷积操作推广到了图数据上, 主要的思路就是通过整合一个节点y,的特征x,以及它的所有邻居y,( y,∈「(),「()表示节点v邻居集合)的特征来得到这个节点的表达。与循 环神经网络不同的是,图卷积网络通常有多个卷积层以提取高阶的节点 表达。许多复杂的图神经网络模型都包含有多个图卷积层,比如用于节 点分类的图神经网络,用于图分类的图神经网络。 ·图卷积网络主要有两个方向:基于谱的图卷积网络和基于空间的图卷积 网络

2. 图神经网络的种类 6 ② 卷积图神经网络(convolutional GNNs ) • 受到卷积神经网络在计算机视觉领域巨大成功的影响,很多学者定义了 不同的图卷积操作以处理图数据,这类图神经网络称为图卷积网络( GCNs)。卷积图神经网络将格点数据上的卷积操作推广到了图数据上, 主要的思路就是通过整合一个节点vi的特征xi以及它的所有邻居vj( vj∈Г(i), Г(i)表示节点vi邻居集合)的特征来得到这个节点的表达。与循 环神经网络不同的是,图卷积网络通常有多个卷积层以提取高阶的节点 表达。许多复杂的图神经网络模型都包含有多个图卷积层,比如用于节 点分类的图神经网络,用于图分类的图神经网络。 • 图卷积网络主要有两个方向:基于谱的图卷积网络和基于空间的图卷积 网络

历安毛子代枚大” 2.图神经网络的种类 XIDIAN UNIVERSITY ③图自编码器 (graph autoencoders (GAEs)) 获取合适的embedding来表示图中的节点不是容易的事,而如果能找到 合适的embedding,就能将它们用在其他任务中。 GAE通过encoder-decoder的结构可以获取到图中节点的embedding, 来支持接下来的任务,如节点分类、链接预测等。 ④ 空时图神经网络(spatial--temporal GNNs) 空时图是指网络节点的属性随时间变化的图,空时图神经网络是可以处 理空时图的神经网络

2. 图神经网络的种类 7 ③ 图自编码器(graph autoencoders (GAEs)) • 获取合适的 embedding 来表示图中的节点不是容易的事,而如果能找到 合适的 embedding,就能将它们用在其他任务中。 • GAE 通过encoder-decoder 的结构可以获取到图中节点的 embedding, 来支持接下来的任务,如节点分类、链接预测等。 ④ 空时图神经网络(spatial–temporal GNNs) 空时图是指网络节点的属性随时间变化的图,空时图神经网络是可以处 理空时图的神经网络

面些毛子代技大” 2.图神经网络的种类 XIDIAN UNIVERSITY 图神经网络与网络嵌入(graph embedding): ·网络嵌入的目的是将网络节点用低维向量来表示,同时 保留网络拓扑结构和节点内容信息,使得后续的图分析 任务,例如节点分类、聚类、推荐等,可以用现成的算 法(比如用SVM来实现分类)来实现。 ·图神经网络则是从端到端处理与图相关任务的深度学习 模型。许多图神经网络可以明确的提取高层表达而不是 节点表示。 Embedding GNN (方法) (任务) 因子分解 表示学习 度学习 节点分类 随机游走 链路预测 8

2. 图神经网络的种类 8 图神经网络与网络嵌入(graph embedding): • 网络嵌入的目的是将网络节点用低维向量来表示,同时 保留网络拓扑结构和节点内容信息,使得后续的图分析 任务,例如节点分类、聚类、推荐等,可以用现成的算 法(比如用SVM来实现分类)来实现。 • 图神经网络则是从端到端处理与图相关任务的深度学习 模型。许多图神经网络可以明确的提取高层表达而不是 节点表示

历安毛子代枚大” 2.图神经网络的种类 XIDIAN UNIVERSITY 图神经网络与网络嵌入(graph embedding): ·图神经网络是可以设计成针对各种任务的一组神经 网络,而网络嵌入则是进行网络节点表示的各种方 法。 ·图神经网络可以通过一个类似图自动编码器的框架 实现网络嵌入,而网络嵌入则包含了许多非深度学 习的方法,比如矩阵分解、随机游走等。 Embedding GNN (方法)】 (任务) 因子分解 度学习 节点分类 随机游走 链路预测

2. 图神经网络的种类 9 图神经网络与网络嵌入(graph embedding): • 图神经网络是可以设计成针对各种任务的一组神经 网络,而网络嵌入则是进行网络节点表示的各种方 法。 • 图神经网络可以通过一个类似图自动编码器的框架 实现网络嵌入,而网络嵌入则包含了许多非深度学 习的方法,比如矩阵分解、随机游走等

历些毛子代枝大学 (3)图卷积网络 XIDIAN UNIVERSITY 图卷积网络主要有两类:基于谱的卷积图神经网络和基于空 间的卷积图神经网络。 ·基于谱的方法是从信号处理中滤波的角度定义卷积,图卷积 操作被定义成从图信号中去除噪声;求解拉普拉斯矩阵的特 征值和特征向量,定义傅里叶变换和逆傅里叶变换,然后定 义卷积。 ·基于空间的方法则继承了循环图神经网络通过信息传播来定 义卷积的方法

(3)图卷积网络 10 • 图卷积网络主要有两类:基于谱的卷积图神经网络和基于空 间的卷积图神经网络。 • 基于谱的方法是从信号处理中滤波的角度定义卷积,图卷积 操作被定义成从图信号中去除噪声;求解拉普拉斯矩阵的特 征值和特征向量,定义傅里叶变换和逆傅里叶变换,然后定 义卷积。 • 基于空间的方法则继承了循环图神经网络通过信息传播来定 义卷积的方法

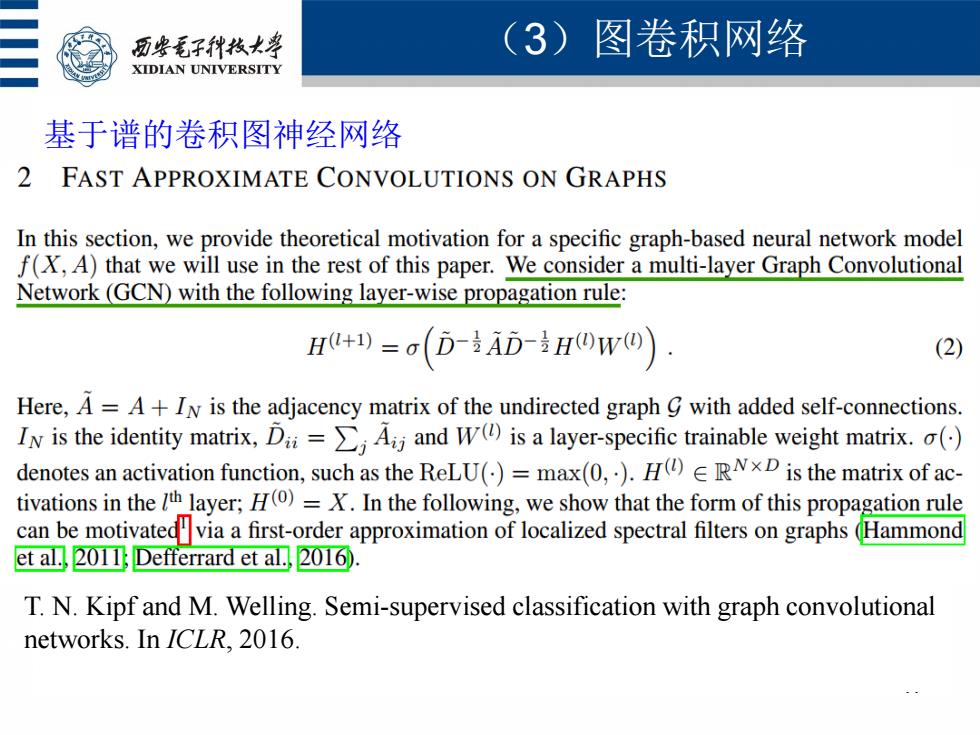

历安毛子代枚大学 (3)图卷积网络 XIDIAN UNIVERSITY 基于谱的卷积图神经网络 2 FAST APPROXIMATE CONVOLUTIONS ON GRAPHS In this section,we provide theoretical motivation for a specific graph-based neural network model f(X,A)that we will use in the rest of this paper.We consider a multi-layer Graph Convolutional Network(GCN)with the following layer-wise propagation rule: H+)=o(D-AD-HOwO) (2) Here,A=A+IN is the adjacency matrix of the undirected graph with added self-connections. IN is the identity matrix,DAjand W(is a layer-specific trainable weight matrix.( denotes an activation function,such as the ReLU()=max(0,).H(ERND is the matrix of ac- tivations in theh layer;H()=X.In the following,we show that the form of this propagation rule can be motivatedvia a first-order approximation of localized spectral filters on graphs(Hammond et al.,2011;Defferrard et al.,2016). T.N.Kipf and M.Welling.Semi-supervised classification with graph convolutional networks.In ICLR.2016

(3)图卷积网络 11 基于谱的卷积图神经网络 T. N. Kipf and M. Welling. Semi-supervised classification with graph convolutional networks. In ICLR, 2016