第六章特征选择 966 模式识别的三大核心问题: 特征数据采集与预处理 分类识别 特征选择与提取 分类识别的正确率取决于对象的表示、训练学 习和分类识别算法,我们在前面各章的介绍中详细 讨论了第二方面的内容。本章介绍的特征提取与选 择问题则是对象表示的一个关键问题

模式识别的三大核心问题: •特征数据采集与预处理 •分类识别 •特征选择与提取 分类识别的正确率取决于对象的表示、训练学 习和分类识别算法,我们在前面各章的介绍中详细 讨论了第二方面的内容。本章介绍的特征提取与选 择问题则是对象表示的一个关键问题。 第六章 特征选择

第六章特征选择 J966 通常在得到实际对象的若干具体特征之后, 再由这些原始特征产生出对分类识别最有效、数 目最少的特征,这就是特征提取与选择的任务。 从本质上讲,我们的目的是使在最小维数特 征空间中异类模式点相距较远(类间距离较大) 而同类模式点相距较近(类内距离较小)

通常在得到实际对象的若干具体特征之后, 再由这些原始特征产生出对分类识别最有效、数 目最少的特征,这就是特征提取与选择的任务。 从本质上讲,我们的目的是使在最小维数特 征空间中异类模式点相距较远(类间距离较大) ,而同类模式点相距较近(类内距离较小)。 第六章 特征选择

966 特征选择与提取的任务: 选出最有代表性的特征,实现特征空间维数 的压缩,用最少的特征达到所要求的分类识别 正确率。 存在两个困难: ·获得的特征测量值不多。实现方法及经济上 的限制等提供的分类信息是否足够,是否能获得较 好的分类效果 ·获得的测量值太多。特征维数灾难

特征选择与提取的任务: 存在两个困难: 选出最有代表性的特征,实现特征空间维数 的压缩,用最少的特征达到所要求的分类识别 正确率。 •获得的特征测量值不多。实现方法及经济上 的限制等提供的分类信息是否足够,是否能获得较 好的分类效果 •获得的测量值太多。特征维数灾难

/96 错误的认识: 认为特征越多越好。当分类器不满足要求时, 想通过增加新的特征,来改善分类器性能。但实标 发现,特征数目达某限度后,不但不能改善分类器 性能,反而工作恶化一“特征维数灾难

错误的认识: 认为特征越多越好。当分类器不满足要求时, 想通过增加新的特征,来改善分类器性能。但实际 发现,特征数目达某限度后,不但不能改善分类器 性能,反而工作恶化——“特征维数灾难”

问题: /966 如何去掉冗余特征,如何保证分类识别精度的 前提下,减少特征维数,提高分类器运算效率和准 确度。 实际上,特征存在很多无用信息,即使有用, 有的也不能反映客体类别本质,'.要通过变换才 能得到更有意义的量。 例如:图像灰值分布中,提取反映纹理和几何形 状等性质的量,有利于分类器达最优性能。 '.需研究特征选择和提取方法→维数压缩

问题: 实际上,特征存在很多无用信息,即使有用, 有的也不能反映客体类别本质,∴要通过变换才 能得到更有意义的量。 例如:图像灰值分布中,提取反映纹理和几何形 状等性质的量,有利于分类器达最优性能。 ∴需研究特征选择和提取方法维数压缩 如何去掉冗余特征,如何保证分类识别精度的 前提下,减少特征维数,提高分类器运算效率和准 确度

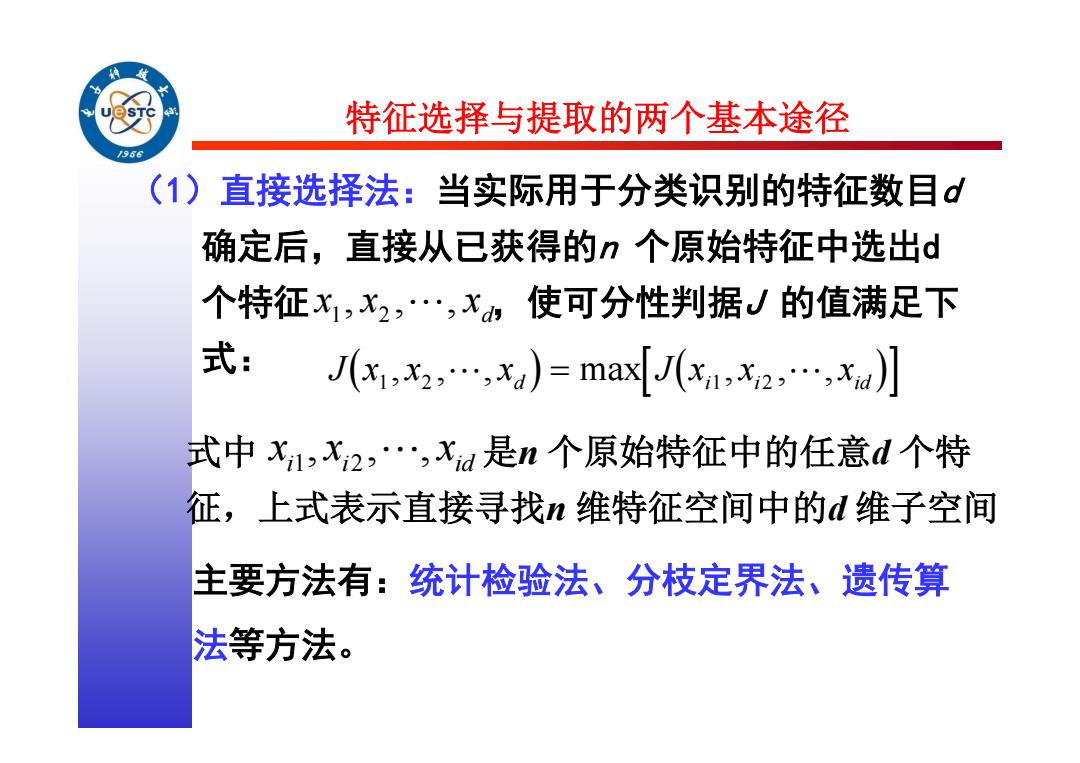

特征选择与提取的两个基本途径 966 (1)直接选择法:当实际用于分类识别的特征数目 确定后,直接从已获得的n个原始特征中选出d 个特征x1,x2,…,x使可分性判据J的值满足下 式: (x,x,,xa)=maJ,x2,…,xa】 式中x1,x2,…,Xa是n个原始特征中的任意d个特 征,上式表示直接寻找n维特征空间中的d维子空间 主要方法有:统计检验法、分枝定界法、遗传算 法等方法

特征选择与提取的两个基本途径 (1)直接选择法:当实际用于分类识别的特征数目d 确定后,直接从已获得的n 个原始特征中选出d 个特征 ,使可分性判据J 的值满足下 式: d x , x , , x 1 2 Jx1, x2 ,, xd max Jxi1, xi2 ,, xid 式中 是n 个原始特征中的任意d 个特 征,上式表示直接寻找n 维特征空间中的d 维子空间。 i i id x , x , , x 1 2 主要方法有:统计检验法、分枝定界法、遗传算 法等方法

特征选择与提取的两个基本途径 /96 (2)变换法,在使判据J取最大的目标下,对n 个原始特征进行变换降维,即对原n维特征空 间进行坐标变换,然后再取子空间。 主要方法有:基于可分性判据的特征选择、基于 误判概率的特征选择、离散K-L变换法(DKLT)、 基于决策界的特征选择等方法

(2)变换法,在使判据J 取最大的目标下,对n 个原始特征进行变换降维,即对原n 维特征空 间进行坐标变换,然后再取子空间。 主要方法有:基于可分性判据的特征选择、基于 误判概率的特征选择、离散K-L变换法(DKLT)、 基于决策界的特征选择等方法。 特征选择与提取的两个基本途径

预处理 /96 数据归一化 口各维特征存在度量单位等方面的差异 口常用方法是限制到0,1川或者[-1,1川 剔除离群值(outlier) 口与随机变量的平均值距离很远的点,通常是检测 或者测量手段导致的误差 缺失数据处理 口检测或者采样过程中的不完全数据 口补0,平均值

预处理 数据归一化 各维特征存在度量单位等方面的差异 常用方法是限制到[0,1]或者[-1,1] 剔除离群值(outlier) 与随机变量的平均值距离很远的点,通常是检测 或者测量手段导致的误差 缺失数据处理 检测或者采样过程中的不完全数据 补0,平均值…

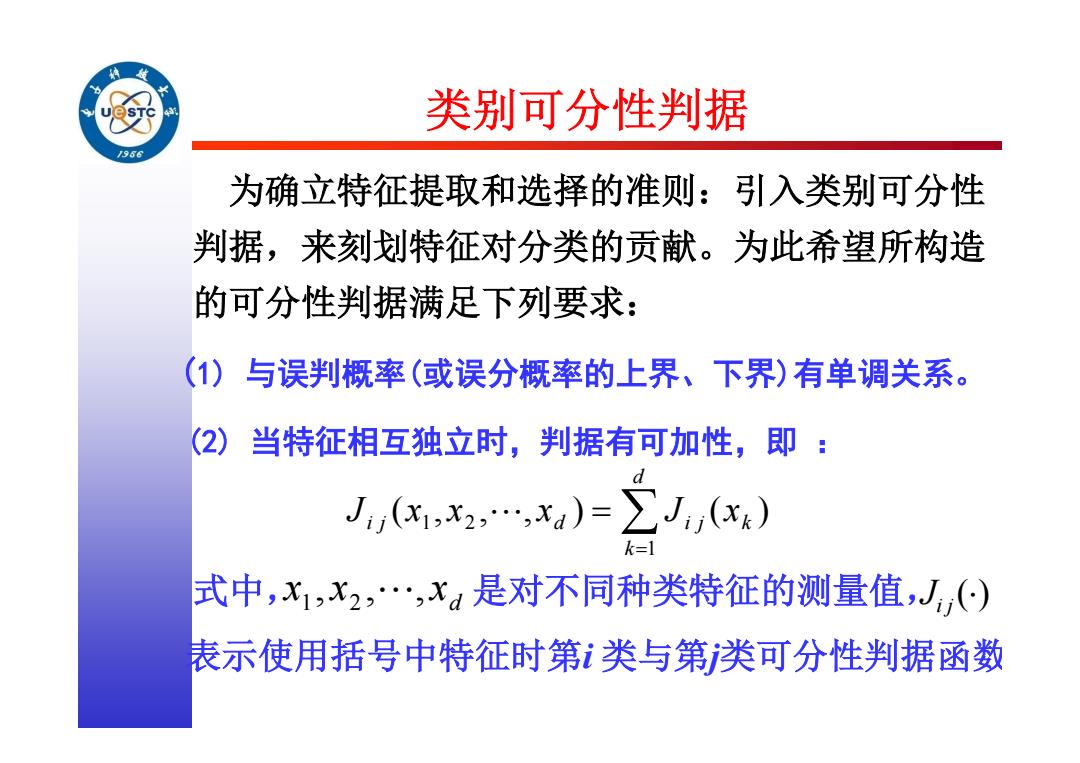

类别可分性判据 J966 为确立特征提取和选择的准则:引入类别可分性 判据,来刻划特征对分类的贡献。为此希望所构造 的可分性判据满足下列要求: (1)与误判概率(或误分概率的上界、下界)有单调关系。 (2)当特征相互独立时,判据有可加性,即: J(x1,x2,…,xa)=∑J,() k=1 式中,x1,x2,…,x是对不同种类特征的测量值,J() 表示使用括号中特征时第类与第类可分性判据函数

类别可分性判据 为确立特征提取和选择的准则:引入类别可分性 判据,来刻划特征对分类的贡献。为此希望所构造 的可分性判据满足下列要求: (1) 与误判概率(或误分概率的上界、下界)有单调关系。 (2) 当特征相互独立时,判据有可加性,即 : J x x x J x i j d i j k d k ( , , , ) ( ) 1 2 1 式中,x x x 1 2 d , ,, 是对不同种类特征的测量值,Ji j() 表示使用括号中特征时第i 类与第j类可分性判据函数

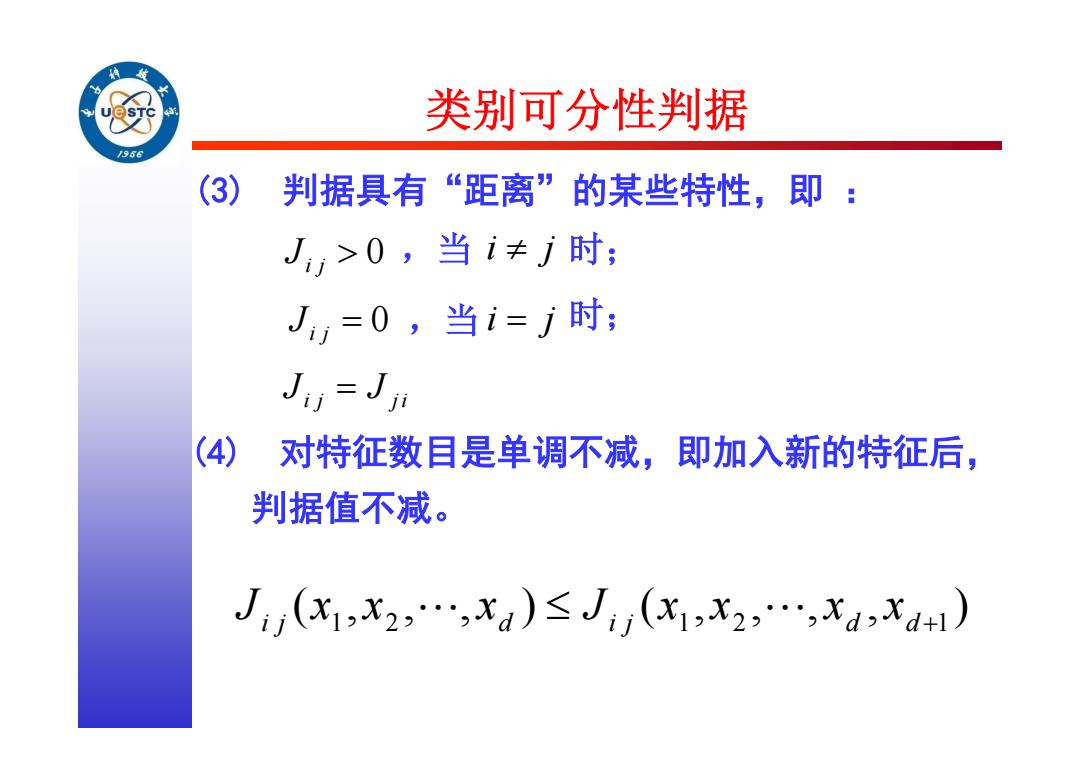

类别可分性判据 /96 (3) 判据具有“距离”的某些特性,即: J>0,当i≠j时; J=0,当i=j时; Ju=Jn (4) 对特征数目是单调不减,即加入新的特征后, 判据值不减。 Ji(x1,X2,,Xa)≤Ji(X1,X2,…,xaxa+)

(3) 判据具有“距离”的某些特性,即 : Ji j 0 ,当 i j 时; Ji j 0 ,当 i j 时; J J i j j i (4) 对特征数目是单调不减,即加入新的特征后, 判据值不减。 J x x x J x x x x i j d i j d d ( , , , ) ( , , , , ) 1 2 1 2 +1 类别可分性判据