第11卷第2期 智能系统学报 Vol.11 No.2 2016年4月 CAAI Transactions on Intelligent Systems Apr.2016 D0I:10.11992/is.201507013 网络出版地址:http://www.cnki.net/kcms/detail/23.1538.TP.20160315.1239.014.html 适合大规模数据集的增量式模糊聚类算法 李滔,王士同 (江南大学数字媒体学院,江苏无锡214122) 摘要:FCPM算法已被成功地应用到模糊系统建模上,但其在某一类的聚类中心已知的大规模数据上的聚类性能 较差。为了避免这个缺点,参照单程模糊c均值(SPFCM)聚类算法、在线模糊c均值(OFCM)聚类算法,提出了适合 大规模数据集的增量式模糊聚类算法(Incremental fuzz四y(c+p)-means clustering,IFCM(c+p))。通过在每个数据块 中使用FCPM算法进行聚类,把每个数据块的聚类中心及其附近的一些样本点加入到下一个数据块参与聚类,同时 添加平衡因子以提高算法聚类性能。同SPFCM、OFCM以及rseFCM算法相比,IFCM(c+p)对初始聚类中心不敏感。 实验表明在没有花费很多运行时间的情况下,IFCM(c+p)算法的聚类性能比SPFCM算法和rseFCM算法更具优势, 因此该算法更适合处理某一类聚类中心已知的大规模数据集。 关键词:增量式模糊聚类;FCPM;IFCM(c+p);平衡因子;大规模数据集 中图分类号:TP391.4文献标志码:A文章编号:1673-4785(2016)02-0188-12 中文引用格式:李滔,王士同.适合大规模数据集的增量式模糊聚类算法[J].智能系统学报,2016,11(2):188-199. 英文引用格式:LITao,WANG Shitong.Incremental fuzzy(c+tp-means clustering for large data[J】.CAAI transactions on intelli- gent systems,2016,11(2):188-199. Incremental fuzzy (c+p)-means clustering for large data LI Tao,WANG Shitong (School of Digital Media,Jiangnan University,Wuxi 214122,China) Abstract:FCPM has been demonstrated to be successful in fuzzy system modeling,however,it will be ineffective for large data clustering tasks where the cluster centers of one class are known.In order to circumvent this draw- back,referring to single-pass fuzzy c-means (SPFCM)clustering algorithm and online fuzzy c-means (OFCM) clustering algorithm,the incremental fuzzy clustering algorithm for large data called IFCM(c+p)is proposed in this paper.FCPM algorithm is used to cluster for each data block at first,and then the clustering centers of data block and some of the sample points being near them are joined into the next block to be clustered,meanwhile the bal- ance factor is given to enhance the clustering performance.In contrast to SPFCM,OFCM and rseFCM,IFCM(c+ p)is not sensitive to the initial cluster centers.The experiments indicate the proposed clustering algorithm IFCM(c +p)is competitive to the clustering algorithms SPFCM and rseFCM in the clustering performance without the loss of running time a lot,hence it is especially suitable for large data clustering tasks where the cluster centers of one class are known. Keywords:incremental fuzzy clustering;FCPM;IFCM(c+p);balance factor;large data 聚类就是将物理或抽象的对象按照自己的某些 属性聚集成类的过程,并尽可能使得类(或者簇)之 间对象的差异程度最大,而类内(或者簇内)的相似 收稿日期:2015-07-06.网络出版日期:2016-03-15 基金项目:国家自然科学基金项目(61272210). 程度达到最大。聚类过程没有先验知识指导,仅凭 通信作者:李滔.E-mail:chasingdreaml19@163.com. 对象间的相似程度作为类属划分的准则,是无监督

第 11 卷第 2 期 智 能 系 统 学 报 Vol.11 №.2 2016 年 4 月 CAAI Transactions on Intelligent Systems Apr. 2016 DOI:10.11992 / tis.201507013 网络出版地址:http: / / www.cnki.net / kcms/ detail / 23.1538.TP.20160315.1239.014.html 适合大规模数据集的增量式模糊聚类算法 李滔,王士同 (江南大学 数字媒体学院,江苏 无锡 214122) 摘 要:FCPM 算法已被成功地应用到模糊系统建模上,但其在某一类的聚类中心已知的大规模数据上的聚类性能 较差。 为了避免这个缺点,参照单程模糊 c 均值(SPFCM)聚类算法、在线模糊 c 均值(OFCM)聚类算法,提出了适合 大规模数据集的增量式模糊聚类算法(Incremental fuzzy (c+p)⁃means clustering ,IFCM( c+p))。 通过在每个数据块 中使用 FCPM 算法进行聚类,把每个数据块的聚类中心及其附近的一些样本点加入到下一个数据块参与聚类,同时 添加平衡因子以提高算法聚类性能。 同 SPFCM、OFCM 以及 rseFCM 算法相比,IFCM( c+p)对初始聚类中心不敏感。 实验表明在没有花费很多运行时间的情况下,IFCM(c+p)算法的聚类性能比 SPFCM 算法和 rseFCM 算法更具优势, 因此该算法更适合处理某一类聚类中心已知的大规模数据集。 关键词:增量式模糊聚类;FCPM;IFCM(c+p);平衡因子;大规模数据集 中图分类号: TP391.4 文献标志码:A 文章编号:1673⁃4785(2016)02⁃0188⁃12 中文引用格式:李滔,王士同. 适合大规模数据集的增量式模糊聚类算法[J]. 智能系统学报, 2016, 11(2): 188⁃199. 英文引用格式:LI Tao, WANG Shitong. Incremental fuzzy (c+p)⁃means clustering for large data[J]. CAAI transactions on intelli⁃ gent systems, 2016, 11(2): 188⁃199. Incremental fuzzy ( c+p) ⁃means clustering for large data LI Tao, WANG Shitong (School of Digital Media, Jiangnan University, Wuxi 214122, China) Abstract:FCPM has been demonstrated to be successful in fuzzy system modeling, however, it will be ineffective for large data clustering tasks where the cluster centers of one class are known. In order to circumvent this draw⁃ back, referring to single⁃pass fuzzy c⁃means ( SPFCM) clustering algorithm and online fuzzy c⁃means (OFCM) clustering algorithm, the incremental fuzzy clustering algorithm for large data called IFCM(c+p) is proposed in this paper. FCPM algorithm is used to cluster for each data block at first, and then the clustering centers of data block and some of the sample points being near them are joined into the next block to be clustered, meanwhile the bal⁃ ance factor is given to enhance the clustering performance. In contrast to SPFCM, OFCM and rseFCM, IFCM(c+ p) is not sensitive to the initial cluster centers. The experiments indicate the proposed clustering algorithm IFCM(c +p) is competitive to the clustering algorithms SPFCM and rseFCM in the clustering performance without the loss of running time a lot, hence it is especially suitable for large data clustering tasks where the cluster centers of one class are known. Keywords: incremental fuzzy clustering; FCPM; IFCM(c+p); balance factor; large data 收稿日期:2015⁃07⁃06. 网络出版日期:2016⁃03⁃15. 基金项目:国家自然科学基金项目(61272210). 通信作者:李滔. E⁃mail:chasingdream119@ 163.com. 聚类就是将物理或抽象的对象按照自己的某些 属性聚集成类的过程,并尽可能使得类(或者簇)之 间对象的差异程度最大,而类内(或者簇内)的相似 程度达到最大。 聚类过程没有先验知识指导,仅凭 对象间的相似程度作为类属划分的准则,是无监督

第2期 李滔,等:适合大规模数据集的增量式模糊聚类算法 ·189· 分类学习的一部分。最为经典的模糊聚类算法之一 Jacek M.Leski对FCM算法进行了改进,提出了模 就是J.C.Bezdek教授在20世纪80年代提出的模糊 糊c+p均值聚类算法FCPM,并采用了新的方法初 c均值聚类算法[),该算法被成功地应用到了在诸 始化聚类中心[。对于某一类的聚类中心,它能吸 多问题的解决上。 引属于该类的样本并排斥属于其他类的样本,这样 随着科学技术的发展,数据库中的数据更新速 更清楚地确定了样本的“归属”问题。对于小样本 度日益加快、数据容量不断增大,若仍然采用原来的 数据,FCPM算法可以保持不错的聚类性能,但其在 聚类算法对这样的大规模数据进行聚类将产生以下 大规模数据集上的聚类性能明显降低而且有较大的 几个问题:1)数据更新前得到的聚类结果可能与数 时间花费,甚至可能由于无法加载进内存而导致算 据更新后的聚类结果不匹配:2)对更新后的数据进 法失效。对于以往的增量式模糊聚类算法,比如 行重新聚类会导致较高的时间复杂度和计算资源的 SPFCM算法和OFCM算法都是通过对样本加权以 浪费:3)还可能由于系统内存不足的原因而导致该 影响每个数据块产生的聚类中心,但数据块间聚类 算法失效。鉴于这些问题,Fazli Can教授在1990年 中心的相互影响程度不明显甚至可能会由于上一次 提出的增量式聚类算法]使得这些问题得以解决。 聚类结果的加入而干扰新的数据进行聚类。为了解 所谓增量式聚类是指利用前期数据已取得的聚类结 决以上问题,通过FCPM算法计算每个数据块的聚 果,对新增数据进行分批或者逐批次地进行聚类的 类中心,把离聚类中心最近的一些样本点连同聚类 过程。研究增量式模糊聚类算法对于避免重复聚类 中心一起加入到下一个数据块中参与聚类,同时添 造成的计算资源浪费,提高聚类性能等都具有十分 加平衡项以提高聚类性能,文中提出了适合大规模 重要的意义。 数据集的增量式聚类算法FCM(c+p)。 近几年,研究者们提出了很多关于增量式聚类 1 相关算法 的算法。这些算法大致可以被分为3类:1)对大数 据进行随机抽样获取小样本进行计算,例如,L 设N元样本集合X={x1,x2,…,xw},x(k= Kaufman等提出的CLARA),S.Guha等)提出的 1,2,…,N)表示其中的某一个样本,其中每一个样 CURE:2)按序将小样本加载进内存的单程算法 本都有D={d,d2,…,dn}CR"一共n个特征,d (single--pass),具有代表性的有F.Can在文献[5]和 (j=1,2,…,n)表示其中的某一个特征。FCM算法 [6]中提出的增量式算法:3)采取类图表结构的数 将N个样本按照它所固有的特征划分成c簇,用4 据转换算法,如T.Zhang等提出的BIRCH刀和R. 表示第k个样本隶属于第i簇的程度,那么划分成c Ng等[)提出的CLARANS,对于增量式模糊聚类算 簇后得到的隶属度矩阵是U=u:}CRxw,i∈[1, 法;B.U.Shankar等提出了快速模糊c均值算法 c],k∈[1,N]。对于模糊划分而言,所有的样本都 FFCM,T.Chengt]提出了多阶段的随机模糊c均值 需要满足下面的条件: 算法MRFCM,J.E.Kolen等[)提出了随机抽样模 MeN={U∈RexN I Lik∈[0,1], 糊c均值算法rsFCM,Dhanesh Kothari等I]提出了 i∈[1,c],k∈[1,N]}; 将随机抽样的结果扩展到整个数据集上的扩展随机 抽样模糊c均值算法rseFCM。除此之外,还有基于 FCM的单程模糊c均值算法SPFCM)、在线模糊c N 均值算法OFCM1),以及在这基础上发展的基于核 Vk∈[1,N]; 4e(0,W,ie[1,c] k=1 的模糊c均值算法spkFCM和okFCMU1],Yangtao 由此可见,模糊划分矩阵U的每一列的和都必 Wang等i提出的基于多重中心的增量式模糊聚类 须等于1,这样才能确保每一个样本都能够被完整 算法在相关性大数据上的应用。最近Bhm等[) 地划分到它所属的簇中。 受到动力学中同步现象的启发提出了一种新颖的同 通过使用欧式距离寻求最小均方误差,可以得 步聚类算法Symc,但是这种算法在大规模数据集上 到FCM模型的目标函数(其中m为模糊指数): 的聚类受到了相当大的限制,基于此应文豪等]在 此基础上提出了快速自适应同步聚类算法FAKCS。 J(U,V)= ZZx-v. (1)》 i=1k= 传统的F℃M算法对初始聚类中心敏感且容易 在式(1)的条件下通过拉格朗日乘子法可以得 陷入局部最优,同时也忽略了类间的相互影响。 出隶属度矩阵U和聚类中心V的更新公式。由于

分类学习的一部分。 最为经典的模糊聚类算法之一 就是 J.C.Bezdek 教授在 20 世纪 80 年代提出的模糊 c 均值聚类算法[1] ,该算法被成功地应用到了在诸 多问题的解决上。 随着科学技术的发展,数据库中的数据更新速 度日益加快、数据容量不断增大,若仍然采用原来的 聚类算法对这样的大规模数据进行聚类将产生以下 几个问题:1)数据更新前得到的聚类结果可能与数 据更新后的聚类结果不匹配;2)对更新后的数据进 行重新聚类会导致较高的时间复杂度和计算资源的 浪费;3)还可能由于系统内存不足的原因而导致该 算法失效。 鉴于这些问题,Fazli Can 教授在 1990 年 提出的增量式聚类算法[2] 使得这些问题得以解决。 所谓增量式聚类是指利用前期数据已取得的聚类结 果,对新增数据进行分批或者逐批次地进行聚类的 过程。 研究增量式模糊聚类算法对于避免重复聚类 造成的计算资源浪费,提高聚类性能等都具有十分 重要的意义。 近几年,研究者们提出了很多关于增量式聚类 的算法。 这些算法大致可以被分为 3 类:1)对大数 据进行随机抽样获取小样本进行计算, 例如, L. Kaufman 等提出的 CLARA [3] , S. Guha 等[4] 提出的 CURE;2) 按序将小样本加载进内存的单程算法 (single⁃pass),具有代表性的有 F. Can 在文献[5]和 [6]中提出的增量式算法;3)采取类图表结构的数 据转换算法,如 T. Zhang 等提出的 BIRCH [7] 和 R. Ng 等[8] 提出的 CLARANS,对于增量式模糊聚类算 法;B. U. Shankar 等[9] 提出了快速模糊 c 均值算法 FFCM,T. Cheng [10]提出了多阶段的随机模糊 c 均值 算法 MRFCM,J. F. Kolen 等[11] 提出了随机抽样模 糊 c 均值算法 rsFCM,Dhanesh Kothari 等[12] 提出了 将随机抽样的结果扩展到整个数据集上的扩展随机 抽样模糊 c 均值算法 rseFCM。 除此之外,还有基于 FCM 的单程模糊 c 均值算法 SPFCM [13] 、在线模糊 c 均值算法 OFCM [14] ,以及在这基础上发展的基于核 的模糊 c 均值算法 spkFCM 和 okFCM [15] ,Yangtao Wang 等[16]提出的基于多重中心的增量式模糊聚类 算法在相关性大数据上的应用。 最近 Böhm 等[17] 受到动力学中同步现象的启发提出了一种新颖的同 步聚类算法 Sync,但是这种算法在大规模数据集上 的聚类受到了相当大的限制,基于此应文豪等[18] 在 此基础上提出了快速自适应同步聚类算法 FAKCS。 传统的 FCM 算法对初始聚类中心敏感且容易 陷入局部最优, 同时也忽略了类间的相互影响。 Jacek M. Leski 对 FCM 算法进行了改进,提出了模 糊 c+p 均值聚类算法 FCPM,并采用了新的方法初 始化聚类中心[19] 。 对于某一类的聚类中心,它能吸 引属于该类的样本并排斥属于其他类的样本,这样 更清楚地确定了样本的“归属” 问题。 对于小样本 数据,FCPM 算法可以保持不错的聚类性能,但其在 大规模数据集上的聚类性能明显降低而且有较大的 时间花费,甚至可能由于无法加载进内存而导致算 法失效。 对于以往的增量式模糊聚类算法,比如 SPFCM 算法和 OFCM 算法都是通过对样本加权以 影响每个数据块产生的聚类中心,但数据块间聚类 中心的相互影响程度不明显甚至可能会由于上一次 聚类结果的加入而干扰新的数据进行聚类。 为了解 决以上问题,通过 FCPM 算法计算每个数据块的聚 类中心,把离聚类中心最近的一些样本点连同聚类 中心一起加入到下一个数据块中参与聚类,同时添 加平衡项以提高聚类性能,文中提出了适合大规模 数据集的增量式聚类算法 IFCM(c+p)。 1 相关算法 设 N 元样本集合 X = { x1 ,x2 ,…,xN} , xk(k = 1,2,…,N) 表示其中的某一个样本,其中每一个样 本都有 D = {d1 ,d2 ,…,dn } ⊂ R n 一共 n 个特征, dj (j =1,2,…,n) 表示其中的某一个特征。 FCM 算法 将 N 个样本按照它所固有的特征划分成 c 簇,用 μik 表示第 k 个样本隶属于第 i 簇的程度,那么划分成 c 簇后得到的隶属度矩阵是 U = {μik} ⊂ R c×N ,i ∈ [1, c],k ∈ [1,N] 。 对于模糊划分而言,所有的样本都 需要满足下面的条件: MfcN = {U ∈ R c×N | μik ∈ [0,1], ∀i ∈ [1,c],k ∈ [1,N]}; ∑ c i = 1 μik = 1, ∀k ∈ [1,N];∑ N k = 1 μik ∈ (0,N),∀i ∈ [1,c] ì î í ï ï ï ï ï ï ï ï 由此可见,模糊划分矩阵 U 的每一列的和都必 须等于 1,这样才能确保每一个样本都能够被完整 地划分到它所属的簇中。 通过使用欧式距离寻求最小均方误差,可以得 到 FCM 模型的目标函数(其中 m 为模糊指数): J(U,V) = ∑ c i = 1 ∑ N k = 1 μ m ik‖ xk - vi‖ 2 (1) 在式(1)的条件下通过拉格朗日乘子法可以得 出隶属度矩阵 U 和聚类中心 V 的更新公式。 由于 第 2 期 李滔,等: 适合大规模数据集的增量式模糊聚类算法 ·189·

·190 智能系统学报 第11卷 篇幅有限,FCM算法的具体更新公式以及计算步骤 献[19]详细介绍了新的聚类中心初始化方法及 在此不做赘述。 FCPM算法,此处不再赘述。 传统的F℃M算法让聚类中心尽可能地靠近样 如文献[19]所示,FCPM算法在模糊系统建模 本点,概率约束也只考虑了聚类中心之间的排斥力, 上得到了很好的应用。该算法采用新的初始化聚类 所有的样本重要性相同,同时对初始聚类中心敏感、 中心的方法有效地避免了CM算法对初始聚类中 容易陷入局部最优,得到的聚类结果往往不理想。 心敏感的问题,通过先确定已知类聚类中心来求未 Jacek M.Leski考虑了类别间的相互影响,利用了新 知类聚类中心的方法以提高算法的聚类性能。通过 的方法初始化聚类中心,采用固定一类求其他类的 实验可以发现,FCPM算法对一类已知的小样本数 方法,在FCM算法的基础上提出了模糊c+p均值聚 据集有着不错的聚类性能,但对现实中的大规模数 类算法FCPM。 据集而言,该算法的聚类性能会下降、算法效率会大 FCPM算法中来自其他类的样本对本类的聚类 大降低甚至会由于样本过大而导致算法失效。基于 会产生影响,在某一类中,聚类中心应该吸引属于该 这些问题,本文提出了适合大规模数据集的增量式 类的样本,而排斥其他类的样本。设有c个聚类中 模糊聚类算法IFCM(c+p)。 心来自一类,而p个聚类中心来自另一类,该算法把 N个样本划分成为c簇,可得目标函数为 2 适合大规模数据集的增量式模糊聚 J(U,T,V)= 名AI+ 类算法IFCM(c+p) 含区1 (2) 2.1FCM(c+p)算法 在增量式模糊聚类算法中,对每一个数据块进 式中:V表示第i簇的聚类中心,表示已知的聚类 行聚类的算法起着举足轻重的作用。针对以往基于 中心。对所有的样本而言,都应该满足如下关系: FCM的增量式模糊聚类算法对初始聚类中心敏感 之4a+2a=14e[0,1]. 的问题,文中采用了FCPM算法中提到的特别的方 i=1 j=1 法初始化聚类中心。另外在传统的增量式模糊聚类 54∈[0,1],Vk∈[1,N] (3) 算法中,不管是静态的还是动态的、单程的还是在线 式中:“表示第k个样本属于第i簇的程度,t表 的、一个中心或者是多个中心(多个中心形成了一 示第k个样本属于第j簇的程度, 利用拉格朗 个约束对)等等的方法,都没有考虑数据块之间聚 日乘子法,可以得到划分矩阵U、T以及聚类中心V 类中心的相互影响,提及的FCM(c+p)算法很好地 的更新公式: 解决了这些问题。 ‖x-:川 为了增加数据块间聚类中心的相互影响程度, 儿= 点1岳+名 1x4-2,Ⅱ房 本文添加了一个平衡项“名I-旷,其中a Vk∈[1,N],ie[1,c] (4) 被称为平衡因子,往往它的取值与J(U,T,V)有 川-子1品 关。由此,可以得到提及算法的目标函数: 三1出高+名1-21品 r=1 J0,I.V=U,70+21V-I3 Vk∈[1,N],je[1,P] (5) 立 含宫11+名含G1 k=1 V= -,ie[1,c] (6) 名I%-rI (7) 式中:":表示第i簇的聚类中心,以表示第k个样 针对FCM算法对初始聚类中心敏感的问题, 本属于第i簇的程度,(.表示第k个样本属于第j FCPM算法采用了新的方法初始化聚类中心。通过 簇的程度,乙表示已知的第j簇的聚类中心,:表 该方法初始化未知类的聚类中心V,使用FCM算法 示经过FCPM算法得到的上一个数据块的聚类中 初始化已知类的聚类中心Z,再依次通过式(4)、 心。对所有的样本而言,都应该满足式(3)所示的 (5)和(6)获取模糊划分矩阵U和聚类中心V。文 关系

篇幅有限,FCM 算法的具体更新公式以及计算步骤 在此不做赘述。 传统的 FCM 算法让聚类中心尽可能地靠近样 本点,概率约束也只考虑了聚类中心之间的排斥力, 所有的样本重要性相同,同时对初始聚类中心敏感、 容易陷入局部最优,得到的聚类结果往往不理想。 Jacek M. Leski 考虑了类别间的相互影响,利用了新 的方法初始化聚类中心,采用固定一类求其他类的 方法,在 FCM 算法的基础上提出了模糊 c+p 均值聚 类算法 FCPM。 FCPM 算法中来自其他类的样本对本类的聚类 会产生影响,在某一类中,聚类中心应该吸引属于该 类的样本,而排斥其他类的样本。 设有 c 个聚类中 心来自一类,而 p 个聚类中心来自另一类,该算法把 N 个样本划分成为 c 簇,可得目标函数为 J(U,T,V) = ∑ c i = 1 ∑ N k = 1 μ m ik ‖ xk - vi‖2 + ∑ p j = 1 ∑ N k = 1 ζ m jk ‖ xk - zj‖2 (2) 式中: Vi 表示第 i 簇的聚类中心, zj 表示已知的聚类 中心。 对所有的样本而言,都应该满足如下关系: ∑ c i = 1 μik + ∑ p j = 1 ζjk = 1,μik ∈ [0,1], ζjk ∈ [0,1],∀k ∈ [1,N] (3) 式中: μik 表示第 k 个样本属于第 i 簇的程度, ζjk 表 示第 k 个样本属于第 j 簇的程度, 利用拉格朗 日乘子法,可以得到划分矩阵 U、T 以及聚类中心 V 的更新公式: μik = ‖ xk - vi‖ 2 1-m ∑ c l = 1 ‖ xk - vl‖ 2 1-m + ∑ p r = 1 ‖ xk - zr‖ 2 1-m ∀k ∈ [1,N],i ∈ [1,c] (4) ζjk = ‖xk - zj‖ 2 1-m ∑ c l = 1 ‖ xk - vl‖ 2 1-m + ∑ p r = 1 ‖ xk - zr‖ 2 1-m ∀k ∈ [1,N],j ∈ [1,p] (5) vi = ∑ N k = 1 μ m ik xk ∑ N k = 1 μ m ik ,∀i ∈ [1,c] (6) 针对 FCM 算法对初始聚类中心敏感的问题, FCPM 算法采用了新的方法初始化聚类中心。 通过 该方法初始化未知类的聚类中心 V,使用 FCM 算法 初始化已知类的聚类中心 Z,再依次通过式( 4)、 (5)和(6)获取模糊划分矩阵 U 和聚类中心 V。 文 献[19] 详细介绍了新的聚类中心初始化方法及 FCPM 算法,此处不再赘述。 如文献[19]所示,FCPM 算法在模糊系统建模 上得到了很好的应用。 该算法采用新的初始化聚类 中心的方法有效地避免了 FCM 算法对初始聚类中 心敏感的问题,通过先确定已知类聚类中心来求未 知类聚类中心的方法以提高算法的聚类性能。 通过 实验可以发现,FCPM 算法对一类已知的小样本数 据集有着不错的聚类性能,但对现实中的大规模数 据集而言,该算法的聚类性能会下降、算法效率会大 大降低甚至会由于样本过大而导致算法失效。 基于 这些问题,本文提出了适合大规模数据集的增量式 模糊聚类算法 IFCM(c+p)。 2 适合大规模数据集的增量式模糊聚 类算法 IFCM(c+p) 2.1 IFCM(c+p)算法 在增量式模糊聚类算法中,对每一个数据块进 行聚类的算法起着举足轻重的作用。 针对以往基于 FCM 的增量式模糊聚类算法对初始聚类中心敏感 的问题,文中采用了 FCPM 算法中提到的特别的方 法初始化聚类中心。 另外在传统的增量式模糊聚类 算法中,不管是静态的还是动态的、单程的还是在线 的、一个中心或者是多个中心(多个中心形成了一 个约束对)等等的方法,都没有考虑数据块之间聚 类中心的相互影响,提及的 IFCM(c+p)算法很好地 解决了这些问题。 为了增加数据块间聚类中心的相互影响程度, 本文添加了一个平衡项 α∑ c i = 1 ‖ vi - v o i ‖2 ,其中 α 被称为平衡因子,往往它的取值与 J(U,T,V) 有 关。 由此,可以得到提及算法的目标函数: J(U,T,V,α) = J(U,T,V) + α∑ c i = 1 ‖ Vi - V o i ‖2 = ∑ c i = 1 ∑ N k = 1 μ m ik ‖ xk - vi‖2 + ∑ p j = 1 ∑ N k = 1 ζ m jk ‖ xk - zj‖2 + α∑ c i = 1 ‖ vi - v o i ‖2 (7) 式中: vi 表示第 i 簇的聚类中心, μik 表示第 k 个样 本属于第 i 簇的程度, ζjk 表示第 k 个样本属于第 j 簇的程度, zj 表示已知的第 j 簇的聚类中心, V o i 表 示经过 FCPM 算法得到的上一个数据块的聚类中 心。 对所有的样本而言,都应该满足式(3) 所示的 关系。 ·190· 智 能 系 统 学 报 第 11 卷

第2期 李滔,等:适合大规模数据集的增量式模糊聚类算法 ·191· 下面采用拉格朗日极值法求模糊划分矩阵U、 整个数据集的聚类中心。 T以及聚类中心V的更新公式。 α=0时的情况仅仅考虑了某一数据块的聚类 G(U.T.V,A)= 中心及其周围的o个样本点对下一个数据块的聚 J〔U,T,a)-a(h4+-= 类性能的影响,这样得出的聚类效果并不理想。为 j=I 了提高聚类性能,应该考虑数据块间聚类中心的相 J(U,T,V)+a 互影响即α≠0时的情况,此时平衡项的加入很好 地提高了聚类性能。 A(∑u 如下所述为IFCM(c+p)算法的具体计算步骤。 j=1 输入:X,c,P,m,no,E; 输出:聚类中心V。 i= 1)把样本集x随机划分成大小相等的s个子集 即x={X,X2,…,X} i=1 Hk∈[1,N] (8) 2)定义一个空的集合Xnn和Xm; 对G(U,T,V,入)中的各个变量分别求偏导并 3)遍历所有的数据块获取聚类中心: 令其等于零得: forl=1,2,…,s ①初始化未知类和已知类的聚类中心V、Z: u山=m2g1x-:2-A=0 ②把从上一数据块获得的样本X添加到当 i=1 前数据块,即X,={X,UXae}; pu=m立1-名2-A=0 ③使用式(4)、(5)和(10)计算当前数据块 的聚类中心V,; -1=0 ④取出距当前数据块的聚类中心最近的n。个 i=1 i=1 样本点存入Xm中; 》=-2∑44x4-:‖+ ⑤把聚类中心V,及其附近的n。个样本点存人 8. i=1 Xn中,即Xm={V,UX}; 2a∑Iy:-I=0 end for i=1 上述算法步骤2)的X用以存放每一个数据 (9) 块产生的聚类中心及其附近的n。个样本点Xm, 通过(9)可以很容易地求出模糊划分矩阵的更 3)对这s个数据块进行遍历,求其聚类中心。3)中 新公式u和,如式(4)、(5)所示。可以发现,模 的主要迭代过程在每个数据块中使用FCPM算法计 糊划分矩阵U和T与平衡因子α无关。 算聚类中心,使用欧氏距离求距聚类中心最近的o 由式(9)第4个等式可得 个样本点,并把它们一同加入到下一个数据块中去 参与聚类。注意在初始化聚类中心时,采用前面提 ∑x4+a 到的FCPM算法的初始化方法对已知类和未知类的 k= V:= -,ie[1,c] (10) 聚类中心Z、V进行初始化,聚类中心V和模糊隶属 ∑a+a k=1 度矩阵U的更新公式分别为(10)、(4),‖·‖表 从式(10)可以看出,根据平衡因子α是否等于 示求欧氏距离。FCPM算法的迭代终止于聚类中心 0,又可以分为两种情况。 的连续变化值的Frobenius范数小于ε。整个IFCM 当α=0即不考虑数据块间聚类中心的相互影 (c+p)算法终止于所有的数据块遍历结束并获得最 响时,在每一个数据块的聚类过程中,将某个数据块 终的聚类中心。 产生的聚类中心加入下一个数据块中参与聚类,为 2.2算法的可行性分析 了增大对数据块间聚类效果的影响程度,把距聚类 正如传统的增量式聚类算法一样,IFCM(c+p)算 中心最近的n。个样本点也一同加入下一个数据块 法对每个数据块进行聚类。在IFCM(c+p)算法中, 参与聚类,以此类推,直至计算出最后一个数据块的 没有添加平衡项时,将每个数据块的c个聚类中心及 聚类中心,这个最终的聚类中心就是我们所要求的 距其最近的。个样本点作为一次聚类结果的历史信

下面采用拉格朗日极值法求模糊划分矩阵 U、 T 以及聚类中心 V 的更新公式。 G(U,T,V,λ) = J(U,T,V,α) - λ(∑ c i = 1 μik + ∑ p j = 1 ζjk - 1) = J(U,T,V) + α∑ c i = 1 ‖ vi - v o i ‖2 - λ(∑ c i = 1 μik + ∑ p j = 1 ζjk - 1) = ∑ c i = 1 μ m ik ‖ xk - vi‖2 + ∑ p j = 1 ζ m jk ‖ xk - zj‖2 + α∑ c i = 1 ‖ vi - v o i ‖2 - λ(∑ c i = 1 μik + ∑ p j = 1 ζjk - 1) ∀k ∈ [1,N] (8) 对 G(U,T,V,λ) 中的各个变量分别求偏导并 令其等于零得: ∂J(U,T,V,λ) ∂μik = m∑ c i = 1 μ m-1 ik ‖ xk - vi‖2 - λ = 0 ∂J(U,T,V,λ) ∂ζik = m∑ c i = 1 ζ m-1 jk ‖ xk - zj‖2 - λ = 0 ∂J(U,T,V,λ) ∂λ = ∑ c i = 1 μik + ∑ p j = 1 ζjk - 1 = 0 ∂J(U,T,V,λ) ∂vi = - 2∑ c i = 1 μ m ik‖ xk - vi‖ + 2α∑ c i = 1 ‖ vi - v o i ‖ = 0 ì î í ï ï ï ï ï ï ï ï ï ï ï ï ï ï ïï (9) 通过(9)可以很容易地求出模糊划分矩阵的更 新公式 μik 和 ζjk ,如式(4)、(5)所示。 可以发现,模 糊划分矩阵 U 和 T 与平衡因子 α 无关。 由式(9)第 4 个等式可得 vi = ∑ N k = 1 μ m ik xk + α v o i ∑ N k = 1 μ m ik + α ,∀i ∈ [1,c] (10) 从式(10)可以看出,根据平衡因子 α 是否等于 0,又可以分为两种情况。 当 α = 0 即不考虑数据块间聚类中心的相互影 响时,在每一个数据块的聚类过程中,将某个数据块 产生的聚类中心加入下一个数据块中参与聚类,为 了增大对数据块间聚类效果的影响程度,把距聚类 中心最近的 n0 个样本点也一同加入下一个数据块 参与聚类,以此类推,直至计算出最后一个数据块的 聚类中心,这个最终的聚类中心就是我们所要求的 整个数据集的聚类中心。 α = 0 时的情况仅仅考虑了某一数据块的聚类 中心及其周围的 n0 个样本点对下一个数据块的聚 类性能的影响,这样得出的聚类效果并不理想。 为 了提高聚类性能,应该考虑数据块间聚类中心的相 互影响即 α ≠ 0 时的情况,此时平衡项的加入很好 地提高了聚类性能。 如下所述为 IFCM(c+p)算法的具体计算步骤。 输入:X, c,p,m,n0 ,ε ; 输出:聚类中心 V。 1)把样本集 x 随机划分成大小相等的 s 个子集 即 x = {X1 ,X2 ,…,Xs} ; 2)定义一个空的集合 Xincre 和 Xnear ; 3)遍历所有的数据块获取聚类中心: for l = 1,2,…,s ①初始化未知类和已知类的聚类中心 V、Z; ②把从上一数据块获得的样本 Xincre 添加到当 前数据块,即 Xl = {Xl ∪ Xincre} ; ③使用式( 4) 、( 5) 和( 10) 计算当前数据块 的聚类中心 Vl ; ④取出距当前数据块的聚类中心最近的 n0 个 样本点存入 Xnear 中; ⑤把聚类中心 Vl 及其附近的 n0 个样本点存入 Xincre 中,即 Xincre = {Vl ∪ Xnear} ; end for 上述算法步骤 2)的 Xincre 用以存放每一个数据 块产生的聚类中心及其附近的 n0 个样本点 Xnear , 3)对这 s 个数据块进行遍历,求其聚类中心。 3)中 的主要迭代过程在每个数据块中使用 FCPM 算法计 算聚类中心,使用欧氏距离求距聚类中心最近的 n0 个样本点,并把它们一同加入到下一个数据块中去 参与聚类。 注意在初始化聚类中心时,采用前面提 到的 FCPM 算法的初始化方法对已知类和未知类的 聚类中心 Z、V 进行初始化,聚类中心 V 和模糊隶属 度矩阵 U 的更新公式分别为(10)、(4), ‖·‖ 表 示求欧氏距离。 FCPM 算法的迭代终止于聚类中心 的连续变化值的 Frobenius 范数小于 ε。 整个 IFCM (c+p)算法终止于所有的数据块遍历结束并获得最 终的聚类中心。 2.2 算法的可行性分析 正如传统的增量式聚类算法一样,IFCM(c+p)算 法对每个数据块进行聚类。 在 IFCM(c+p)算法中, 没有添加平衡项时,将每个数据块的 c 个聚类中心及 距其最近的 n0 个样本点作为一次聚类结果的历史信 第 2 期 李滔,等: 适合大规模数据集的增量式模糊聚类算法 ·191·

·192· 智能系统学报 第11卷 息加入到新增数据中,即每次都有c+n。个样本点加 3 相关实验研究 入到新增数据中参与聚类,那么这些历史信息的加入 势必将影响新增数据的聚类效果。如果历史信息恰 3.1评价指标 好位于新增数据附近,则其聚类效果将变好,如果历 为了公正地对各聚类算法的聚类效果做出合理 史信息远离它们,历史信息的加入反而会导致一个很 的评价,本文采用如下3种评价指标进行算法的性 差的聚类效果。对于SPFCM算法和OFCM算法而 能分析。 言,它们通过添加样本权值以增加聚类效果,在一定 3.l.1算法运行时间的加速比speedup 程度上比仅仅添加历史信息得到的聚类效果要好,但 该指标反映了聚类算法在指定数据集下运行时 也存在上面所提到的一些问题。为了克服以上问题, 间的比较情况。定义加速比: 提到的FCM(c+p)算法添加了平衡项,通过平衡项 speedup =tfall/tineremental 中的平衡因子去改变数据块间聚类中心的相互影响 式中:t表示在整个数据集下采用FCPM算法所运 程度,此时即便历史信息远离新增数据,通过合理调 行的时间;incremea表示采用增量式算法比如SPF 节平衡因子α的取值也可以使得聚类中心吸引它周 CM、IFCM(c+p)等所运行的时间。 围的新增数据,从而提高聚类效果。 2)归一化互信息(normalized mutual informa- tion,NMI)[20-21] 2.3算法复杂度 文献[I5]详细介绍了rseFCM、SPFCM算法的 时间和空间复杂度,如表1所示,本文提到的CPM NMI 及FCM(c+p)算法的时间和空间复杂度也如表I 会N·会g 所示。其中t表示非增量式算法的迭代次数,t表 示增量式算法中每个数据块的平均迭代次数,d表 式中:N表示样本总数,N表示经本文聚类算法之 后第i簇的样本总数,N表示真实数据集的第j类 示数据集维数,c表示未知类的聚类个数,p表示已 的样本总数,M表示第i簇与第j类的契合程度,即 知类的聚类个数,s表示数据块的个数,。表示在 二者共有的样本总数。 IFCM(c+p)算法中距每个数据块的聚类中心最近的 3)芮氏指标(rand index,RI)[20-2] 样本点个数。 表1各算法的时间、空间复杂度 foo +f RI = -N(N-1)/2 Table 1 Time and space complexity of algorithms 式中:∫表示样本点具有不同的类标签并且属于不 算法 时间复杂度 空间复杂度 同类的配对样本数目,∫,则表示样本点具有相同的 FCPM O(tnd(c p)+te) O(n(d+c+p)) 类标签并且属于同一类的配对样本数目,N表示样 rseFCM 0(te'dn/s) O((d+c)n/s) 本总数。 SPFCM 0(nd'c2) 0((d+c)n/s) 以上NMI、I两种指标,其取值范围均为[O, 1],且取值越靠近1越能反映该聚类算法在某数据 IFCM(c+p)0(t'nd(c p)+t'c)O((d +e+p+no)n/'s) 集下的聚类效果越好,反之越靠近0则反映该聚类 如表1所示,本文提到的算法均在相同环境下 算法的聚类效果越差。加速比speedup越大反映了 运行,都对同一数据集X进行处理,时间复杂度都 增量式聚类算法的运行时间越短。 为O(n)。然而从第3部分的实验可以看出,各算 3.2实验结果 法的运行时间存在着显著不同。对于增量式模糊聚 1)实验环境 类算法,由于它们在每个数据块的处理中能够快速 本文所有的实验均在如表2的环境中进行。 收敛因而可以使得算法总的运行时间减少。 2)实验数据集 本文提到的增量式模糊聚类算法都是对数据进 实验所选取的数据集包括人工数据集2D15 行分块处理,因此需要计算每个数据块所占用的空 http://www.uef.fi/en/sipu/datasets)UCI http:// 间即为n/s。如表1所示,同seFCM和SPFCM算 archive.ics.uci.edu/ml/datasets..html)、标准数据集 法相比,由于IFCM(c+p)算法需要存储聚类中心及 waveform、forest和手写数字数据集MNIST(htp:/ 其周围的一些样本,因此需要占用相对较多的存储 yann.lecun.com/exdb/mnist/)。各数据集的分布情 空间,也就拥有相对高的空间复杂度。 况如表3

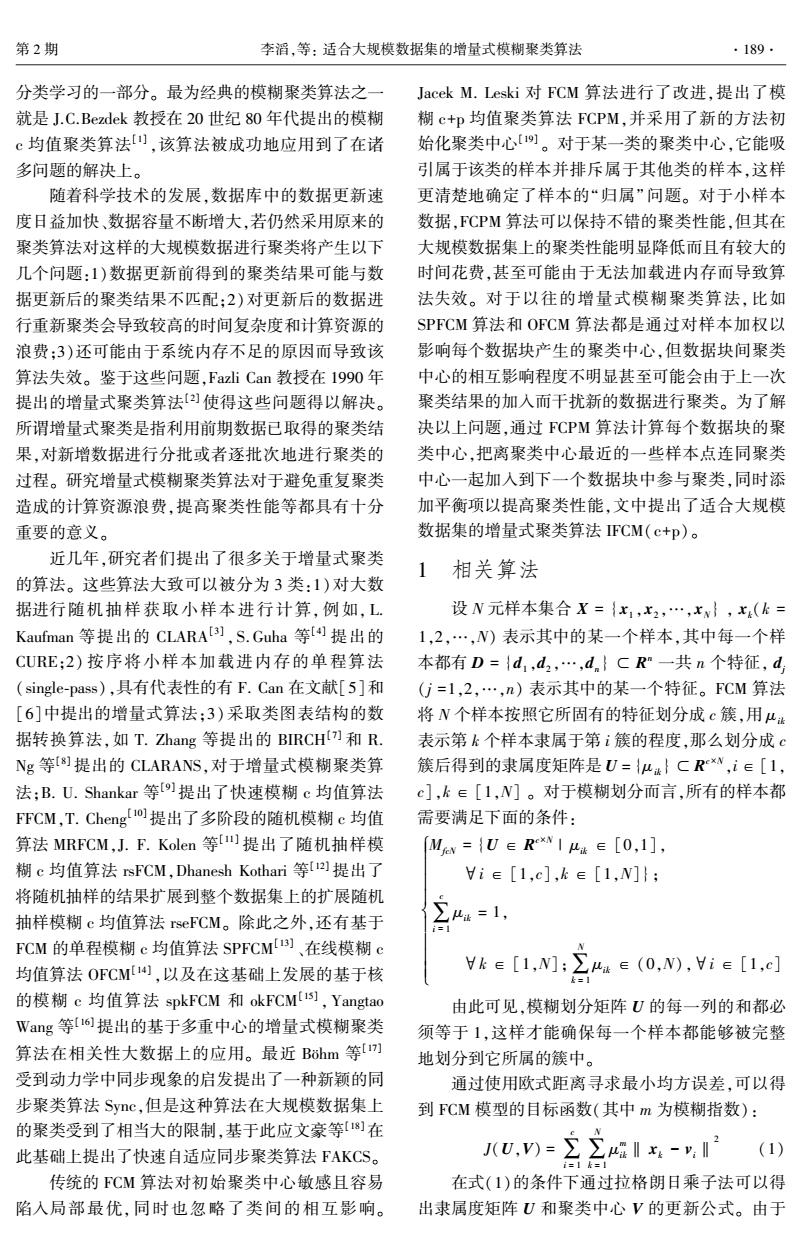

息加入到新增数据中,即每次都有 c + n0 个样本点加 入到新增数据中参与聚类,那么这些历史信息的加入 势必将影响新增数据的聚类效果。 如果历史信息恰 好位于新增数据附近,则其聚类效果将变好,如果历 史信息远离它们,历史信息的加入反而会导致一个很 差的聚类效果。 对于 SPFCM 算法和 OFCM 算法而 言,它们通过添加样本权值以增加聚类效果,在一定 程度上比仅仅添加历史信息得到的聚类效果要好,但 也存在上面所提到的一些问题。 为了克服以上问题, 提到的 IFCM(c+p)算法添加了平衡项,通过平衡项 中的平衡因子去改变数据块间聚类中心的相互影响 程度,此时即便历史信息远离新增数据,通过合理调 节平衡因子 α 的取值也可以使得聚类中心吸引它周 围的新增数据,从而提高聚类效果。 2.3 算法复杂度 文献[15] 详细介绍了 rseFCM、SPFCM 算法的 时间和空间复杂度,如表 1 所示,本文提到的 FCPM 及 IFCM( c+p) 算法的时间和空间复杂度也如表 1 所示。 其中 t 表示非增量式算法的迭代次数, t ' 表 示增量式算法中每个数据块的平均迭代次数, d 表 示数据集维数, c 表示未知类的聚类个数, p 表示已 知类的聚类个数, s 表示数据块的个数, n0 表示在 IFCM(c+p)算法中距每个数据块的聚类中心最近的 样本点个数。 表 1 各算法的时间、空间复杂度 Table 1 Time and space complexity of algorithms 算法 时间复杂度 空间复杂度 FCPM O(tnd(c + p) + tc) O(n(d + c + p)) rseFCM O(tc 2 dn / s) O((d + c)n / s) SPFCM O(ndt′c 2 ) O((d + c)n / s) IFCM(c+p) O(t′nd(c + p) + t′c) O((d + c + p + n0 )n / s) 如表 1 所示,本文提到的算法均在相同环境下 运行,都对同一数据集 X 进行处理,时间复杂度都 为 O(n) 。 然而从第 3 部分的实验可以看出,各算 法的运行时间存在着显著不同。 对于增量式模糊聚 类算法,由于它们在每个数据块的处理中能够快速 收敛因而可以使得算法总的运行时间减少。 本文提到的增量式模糊聚类算法都是对数据进 行分块处理,因此需要计算每个数据块所占用的空 间即为 n / s 。 如表 1 所示,同 rseFCM 和 SPFCM 算 法相比,由于 IFCM(c+p)算法需要存储聚类中心及 其周围的一些样本,因此需要占用相对较多的存储 空间,也就拥有相对高的空间复杂度。 3 相关实验研究 3.1 评价指标 为了公正地对各聚类算法的聚类效果做出合理 的评价,本文采用如下 3 种评价指标进行算法的性 能分析。 3.1.1 算法运行时间的加速比 speedup 该指标反映了聚类算法在指定数据集下运行时 间的比较情况。 定义加速比: speedup = t full / t incremental 式中: t full 表示在整个数据集下采用 FCPM 算法所运 行的时间; t incremental 表示采用增量式算法比如 SPF⁃ CM、IFCM(c+p)等所运行的时间。 2) 归一化互信息 ( normalized mutual informa⁃ tion,NMI) [20⁃21] NMI = ∑ c i = 1 ∑ c j = 1 N j i log N·N j i Ni·Nj æ è ç ö ø ÷ ∑ c i = 1 Ni log Ni N æ è ç ö ø ÷ · ∑ c j = 1 Nj log Nj N æ è ç ö ø ÷ 式中: N 表示样本总数, Ni 表示经本文聚类算法之 后第 i 簇的样本总数, Nj 表示真实数据集的第 j 类 的样本总数, N j i 表示第 i 簇与第 j 类的契合程度,即 二者共有的样本总数。 3)芮氏指标(rand index,RI) [20⁃22] RI = f 00 + f 11 N(N - 1) / 2 式中: f 00 表示样本点具有不同的类标签并且属于不 同类的配对样本数目, f 11 则表示样本点具有相同的 类标签并且属于同一类的配对样本数目, N 表示样 本总数。 以上 NMI、RI 两种指标,其取值范围均为[ 0, 1],且取值越靠近 1 越能反映该聚类算法在某数据 集下的聚类效果越好,反之越靠近 0 则反映该聚类 算法的聚类效果越差。 加速比 speedup 越大反映了 增量式聚类算法的运行时间越短。 3.2 实验结果 1)实验环境 本文所有的实验均在如表 2 的环境中进行。 2)实验数据集 实验所选取的数据集包括人工数据集 2D15 ( http: / / www. uef. fi / en / sipu / datasets)、UCI ( http: / / archive.ics. uci. edu / ml / datasets. html)、 标准数据集 waveform、forest 和手写数字数据集 MNIST( http: / / yann.lecun. com / exdb / mnist / )。 各数据集的分布情 况如表 3。 ·192· 智 能 系 统 学 报 第 11 卷

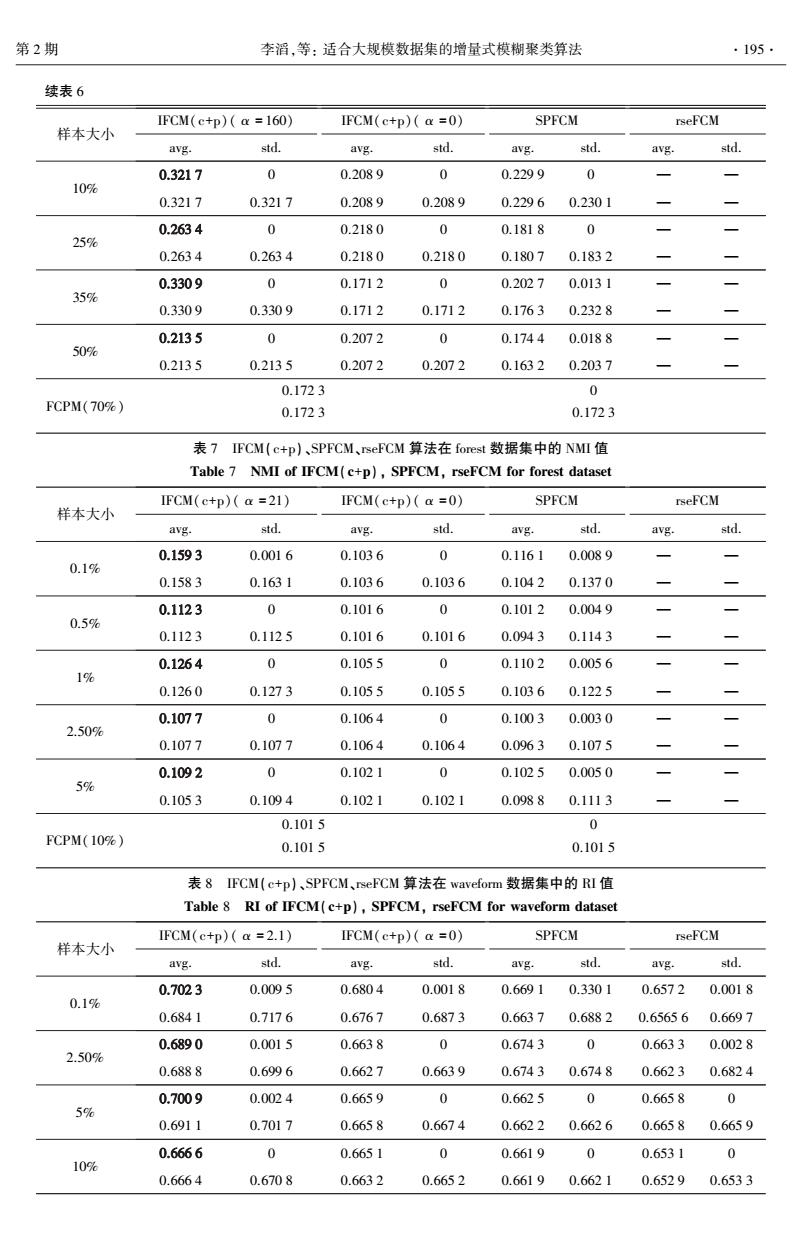

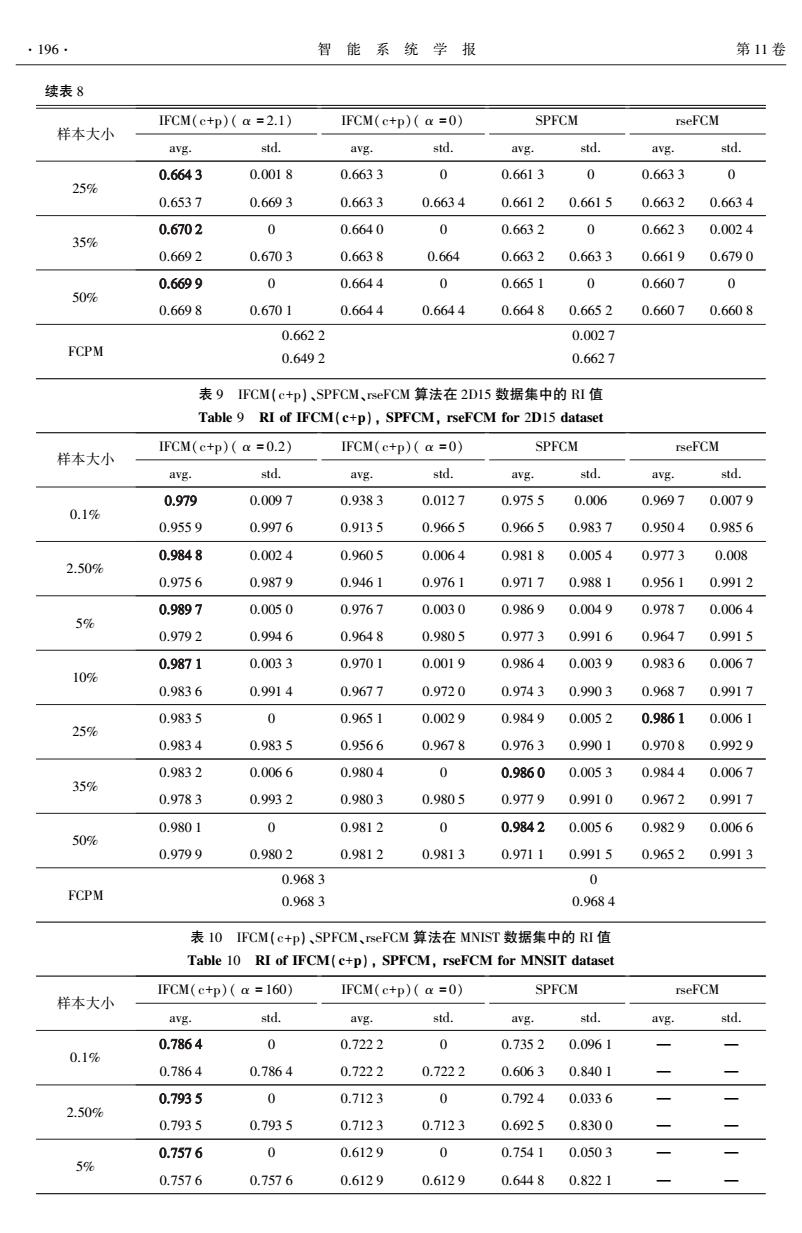

第2期 李滔,等:适合大规模数据集的增量式模糊聚类算法 ·193 表2实验环境 本文中所有的参数都按如下取值:模糊指数 Table 2 Experiment environment m取2,最大迭代次数均为100,迭代终止参数ε 结构 具体参数 取1e-3,聚类中心附近的样本点个数no取5,其 操作系统 Windows7专业版64位 中数据集2D15、waveform重复试验50次,由于数 处理器 Intel(R)Xeon(R)E5-1620 v2@3.7GHz 据集MNIST和forest样本过大,我们重复试验20 运行内存 64G 次。数据块的大小应由用户指定,但在实验中, 软件及版本 MATLAB7.11.0.584(R2010h) 由于计算机内存受限,forest数据集的数据块大 小依次取0.1%、0.5%、1%、2.5%、5%,其余均按 表3各数据集的分布情况 照整个数据集的1%、2.5%、5%、10%、25%、50% Table 3 Distribution of the datasets 随机抽取。取MNIST数据集70%的样本、forest 数据集 大小 维数 类别数 数据集10%的样本参与FCPM算法的聚类。平 2D15 5000 2 15 衡因子α的具体取值也由用户指定,但是必须在 waveform 5000 21 3 给定的经验值范围内取值,本文中的所有α值均 forest 581012 54 7 是在多次重复实验中,提到的聚类指标的均值达 MNIST 70000 784 10 到最好的时候的取值。我们计算提到的几种算 MNIST数据集是手写数字集的一个子集,包含了 法在各个数据集上的NMI和RI的最值、均值以 70000张28×28像素的数字0~9的图像,每个像素 及标准差,其中均值反映了算法的平均聚类性 都在整数0~255之间取值。为加快运算,对MNIST 能,最值和标准差反映了算法的稳定鲁棒性。 数据集中的所有样本分别除以255进行归一化处 4)算法性能比较 理1s。为方便计算,本文随机取forest的581000个 本文采用SPFCM算法和rseFCM算法同IFCM 样本进行计算。同样,对其他数据集也进行归一化处 (c+p)算法在聚类性能和加速比上进行比较。 理以加快运算,即用每个特征的所有样本与该特征的 1)各算法在数据集上的聚类性能比较 最小值作差再除以该特征的最大值与最小值之差。 各算法在指定数据集下的聚类性能如表4~11 3)实验参数设置 所示,其中最优均值已用黑体标出。 表4FCM(c+p)、SPFCM、rseFCM算法的NMI值 Table 4 NMI of IFCM(c+p),SPFCM,rseFCM FCM(c+p)(a=2.1) IFCM(c+p)(a=0) SPFCM rseFCM 样本大小 avg. std. avg. std. avg. std. avg. std. 0.4107 0.0233 0.4091 0.0026 0.3909 0.0074 0.3078 0.0037 1% 0.3855 0.4398 0.3980 0.4173 0.3567 0.4248 0.3061 0.3332 0.4329 0.0062 0.3484 0 0.3613 0.0018 0.3199 0.0040 2.50% 0.4320 0.4756 0.3472 0.3485 0.3488 0.3616 0.3185 0.3474 0.4194 0.0079 0.3345 0.0010 0.3369 0 0.3463 0 5% 0.3872 0.4220 0.3343 0.3415 0.3365 0.3371 0.3463 0.3464 0.3411 a 0.3332 0 0.3259 0 0.2964 0 10% 0.3409 0.3415 0.3299 0.3333 0.3258 0.3263 0.2958 0.2968 0.3350 0.0049 0.3308 0 0.3245 0 0.3362 0 25% 0.3025 0.3442 0.3307 0.3309 0.3237 0.3251 0.3361 0.3363 0.3656 0 0.3253 0 0.3311 0 0.3259 0 35% 0.3617 0.3660 0.3251 0.3254 0.3311 0.3312 0.3257 0.3265 0.3556 0 0.3354 0 0.3361 0 0.3241 50% 0 0.3554 0.3558 0.3353 0.3354 0.3349 0.3365 0.3239 0.3246 0.3285 0.0081 FCPM 0.2892 0.3302 从各表中的实验结果对比发现,增量式模糊聚 类算法的聚类性能均优于FCPM算法。在人工数据

表 2 实验环境 Table 2 Experiment environment 结构 具体参数 操作系统 Windows 7 专业版 64 位 处理器 Intel(R)Xeon(R)E5⁃1620 v2@ 3.7GHz 运行内存 64G 软件及版本 MATLAB 7.11.0.584 (R2010b) 表 3 各数据集的分布情况 Table 3 Distribution of the datasets 数据集 大小 维数 类别数 2D15 5 000 2 15 waveform 5 000 21 3 forest 581 012 54 7 MNIST 70 000 784 10 MNIST 数据集是手写数字集的一个子集,包含了 70 000 张 28 × 28 像素的数字 0~9 的图像,每个像素 都在整数 0 ~ 255 之间取值。 为加快运算,对 MNIST 数据集中的所有样本分别除以 255 进行归一化处 理[15] 。 为方便计算,本文随机取 forest 的 581 000 个 样本进行计算。 同样,对其他数据集也进行归一化处 理以加快运算,即用每个特征的所有样本与该特征的 最小值作差再除以该特征的最大值与最小值之差。 3)实验参数设置 本文中所有的参数都按如下取值:模糊指数 m 取 2,最大迭代次数均为 100,迭代终止参数 ε 取 1e-3,聚类中心附近的样本点个数 n0 取 5,其 中数据集 2D15、waveform 重复试验 50 次,由于数 据集 MNIST 和 forest 样本过大,我们重复试验 20 次。 数据块的大小应由用户指定,但在实验中, 由于计算机内存受限, forest 数据集的数据块大 小依次取0.1%、0. 5%、1%、2. 5%、5%,其余均按 照整个数据集的 1%、2.5%、5%、10%、25%、50% 随机抽取。 取 MNIST 数据集 70% 的样本、 forest 数据集 10% 的样本参与 FCPM 算法的聚类。 平 衡因子 α 的具体取值也由用户指定,但是必须在 给定的经验值范围内取值,本文中的所有 α 值均 是在多次重复实验中,提到的聚类指标的均值达 到最好的时候的取值。 我们计算提到的几种算 法在各个数据集上的 NMI 和 RI 的最值、均值以 及标准差,其中均值反映了算法的 平 均 聚 类 性 能,最值和标准差反映了算法的稳定鲁棒性。 4)算法性能比较 本文采用 SPFCM 算法和 rseFCM 算法同 IFCM (c+p)算法在聚类性能和加速比上进行比较。 1)各算法在数据集上的聚类性能比较 各算法在指定数据集下的聚类性能如表 4 ~ 11 所示,其中最优均值已用黑体标出。 表 4 IFCM(c+p)、SPFCM、rseFCM 算法的 NMI 值 Table 4 NMI of IFCM(c+p), SPFCM, rseFCM 样本大小 IFCM(c+p)( α = 2.1) avg. std. IFCM(c+p)( α = 0) avg. std. SPFCM avg. std. rseFCM avg. std. 1% 0.410 7 0.023 3 0.409 1 0.002 6 0.390 9 0.007 4 0.307 8 0.003 7 0.385 5 0.439 8 0.398 0 0.417 3 0.356 7 0.424 8 0.306 1 0.333 2 2.50% 0.432 9 0.006 2 0.348 4 0 0.361 3 0.001 8 0.319 9 0.004 0 0.432 0 0.475 6 0.347 2 0.348 5 0.348 8 0.361 6 0.318 5 0.347 4 5% 0.419 4 0.007 9 0.334 5 0.001 0 0.336 9 0 0.346 3 0 0.387 2 0.422 0 0.334 3 0.341 5 0.336 5 0.337 1 0.346 3 0.346 4 10% 0.341 1 0 0.333 2 0 0.325 9 0 0.296 4 0 0.340 9 0.341 5 0.329 9 0.333 3 0.325 8 0.326 3 0.295 8 0.296 8 25% 0.335 0 0.004 9 0.330 8 0 0.324 5 0 0.336 2 0 0.302 5 0.344 2 0.330 7 0.330 9 0.323 7 0.325 1 0.336 1 0.336 3 35% 0.365 6 0 0.325 3 0 0.331 1 0 0.325 9 0 0.361 7 0.366 0 0.325 1 0.325 4 0.331 1 0.331 2 0.325 7 0.326 5 50% 0.355 6 0 0.335 4 0 0.336 1 0 0.324 1 0 0.355 4 0.355 8 0.335 3 0.335 4 0.334 9 0.336 5 0.323 9 0.324 6 FCPM 0.328 5 0.008 1 0.289 2 0.330 2 从各表中的实验结果对比发现,增量式模糊聚 类算法的聚类性能均优于 FCPM 算法。 在人工数据 第 2 期 李滔,等: 适合大规模数据集的增量式模糊聚类算法 ·193·

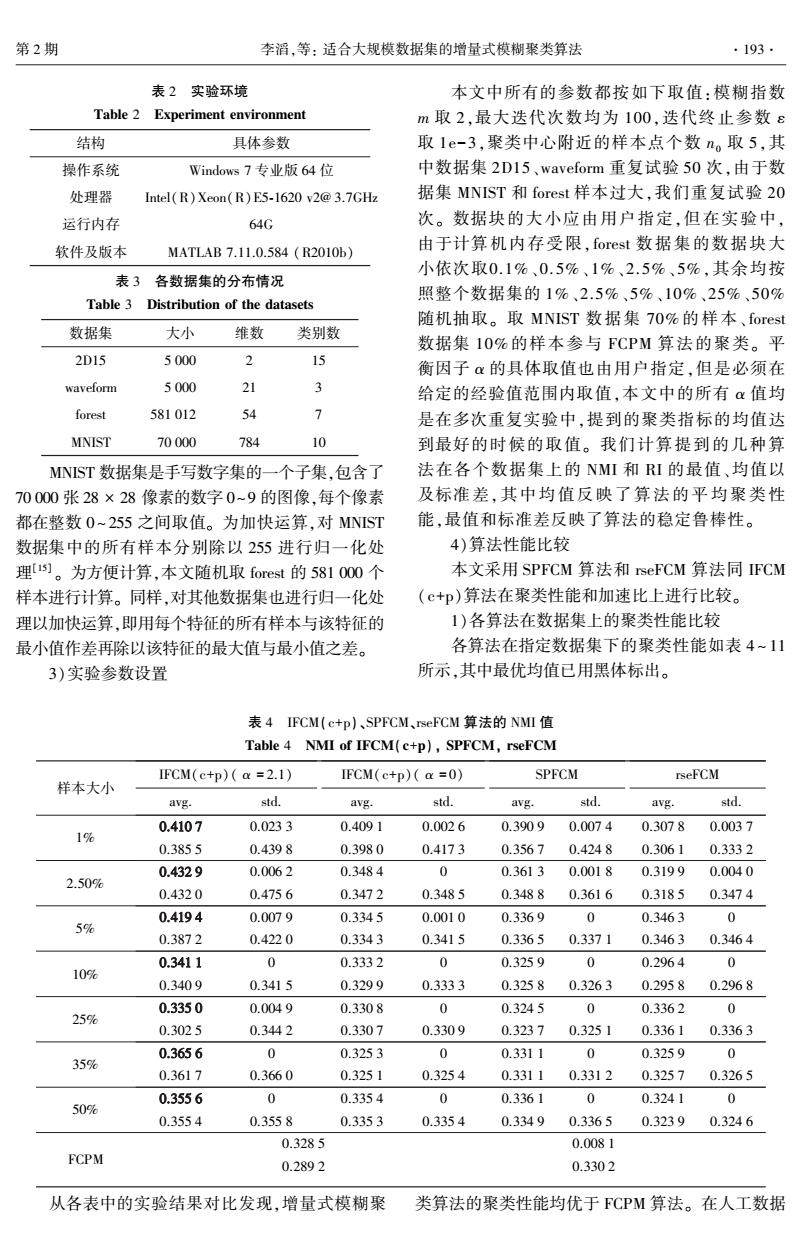

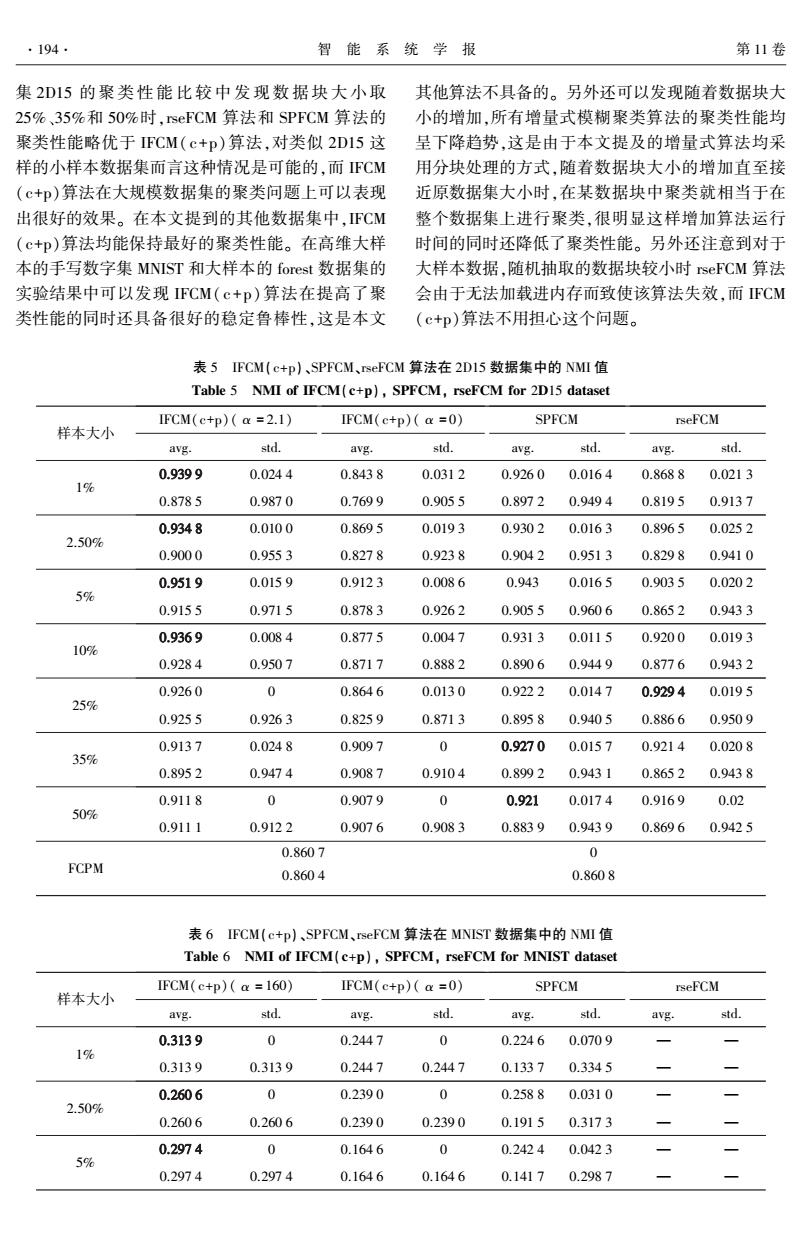

194. 智能系统学报 第11卷 集2D15的聚类性能比较中发现数据块大小取 其他算法不具备的。另外还可以发现随着数据块大 25%、35%和50%时,rseFCM算法和SPFCM算法的 小的增加,所有增量式模糊聚类算法的聚类性能均 聚类性能略优于IFCM(c+p)算法,对类似2DI5这 呈下降趋势,这是由于本文提及的增量式算法均采 样的小样本数据集而言这种情况是可能的,而FCM 用分块处理的方式,随着数据块大小的增加直至接 (c+p)算法在大规模数据集的聚类问题上可以表现 近原数据集大小时,在某数据块中聚类就相当于在 出很好的效果。在本文提到的其他数据集中,FCM 整个数据集上进行聚类,很明显这样增加算法运行 (c+p)算法均能保持最好的聚类性能。在高维大样 时间的同时还降低了聚类性能。另外还注意到对于 本的手写数字集MNIST和大样本的forest数据集的 大样本数据,随机抽取的数据块较小时rseFCM算法 实验结果中可以发现FCM(c+p)算法在提高了聚 会由于无法加载进内存而致使该算法失效,而FCM 类性能的同时还具备很好的稳定鲁棒性,这是本文 (c+p)算法不用担心这个问题。 表5IFCM(c+p)、SPFCM、rseFCM算法在2D15数据集中的NMI值 Table 5 NMI of IFCM(c+p),SPFCM,rseFCM for 2D15 dataset FCM(c+p)(a=2.1) IFCM(c+p)(a =0) SPFCM rseFCM 样本大小 avg. std. avg. std. avg. std. avg. std. 0.9399 0.0244 0.8438 0.0312 0.9260 0.0164 0.8688 0.0213 1% 0.8785 0.9870 0.7699 0.9055 0.8972 0.9494 0.8195 0.9137 0.9348 0.0100 0.8695 0.0193 0.9302 0.0163 0.8965 0.0252 2.509% 0.9000 0.9553 0.8278 0.9238 0.9042 0.9513 0.8298 0.9410 0.9519 0.0159 0.9123 0.0086 0.943 0.0165 0.9035 0.0202 5% 0.9155 0.9715 0.8783 0.9262 0.9055 0.9606 0.8652 0.9433 0.9369 0.0084 0.8775 0.0047 0.9313 0.0115 0.9200 0.0193 10% 0.9284 0.9507 0.8717 0.8882 0.8906 0.9449 0.8776 0.9432 0.9260 0 0.8646 0.0130 0.9222 0.0147 0.9294 0.0195 25% 0.9255 0.9263 0.8259 0.8713 0.8958 0.9405 0.8866 0.9509 0.9137 0.0248 0.9097 0 0.9270 0.0157 0.9214 0.0208 35% 0.8952 0.9474 0.9087 0.9104 0.8992 0.9431 0.8652 0.9438 0.9118 0 0.9079 0 0.921 0.0174 0.9169 0.02 50% 0.9111 0.9122 0.9076 0.9083 0.8839 0.9439 0.8696 0.9425 0.8607 0 FCPM 0.8604 0.8608 表6FCM(c+p)、SPFCM、rseFCM算法在MNIST数据集中的NMI值 Table 6 NMI of IFCM(c+p),SPFCM,rseFCM for MNIST dataset FCM(c+p)(a=160) IFCM(c+p)(a =0) SPFCM rseFCM 样本大小 avg. std. avg. std. avg. std. avg. std. 0.3139 0 0.2447 0 0.2246 0.0709 1% 0.3139 0.3139 0.2447 0.2447 0.1337 0.3345 0.2606 0 0.2390 0 0.2588 0.0310 2.50% 0.2606 0.2606 0.2390 0.2390 0.1915 0.3173 0.2974 0 0.1646 0 0.2424 0.0423 5% 0.2974 0.2974 0.1646 0.1646 0.1417 0.2987

集 2D15 的 聚 类 性 能 比 较 中 发 现 数 据 块 大 小 取 25%、35%和 50%时,rseFCM 算法和 SPFCM 算法的 聚类性能略优于 IFCM( c+p)算法,对类似 2D15 这 样的小样本数据集而言这种情况是可能的,而 IFCM (c+p)算法在大规模数据集的聚类问题上可以表现 出很好的效果。 在本文提到的其他数据集中,IFCM (c+p)算法均能保持最好的聚类性能。 在高维大样 本的手写数字集 MNIST 和大样本的 forest 数据集的 实验结果中可以发现 IFCM( c+p) 算法在提高了聚 类性能的同时还具备很好的稳定鲁棒性,这是本文 其他算法不具备的。 另外还可以发现随着数据块大 小的增加,所有增量式模糊聚类算法的聚类性能均 呈下降趋势,这是由于本文提及的增量式算法均采 用分块处理的方式,随着数据块大小的增加直至接 近原数据集大小时,在某数据块中聚类就相当于在 整个数据集上进行聚类,很明显这样增加算法运行 时间的同时还降低了聚类性能。 另外还注意到对于 大样本数据,随机抽取的数据块较小时 rseFCM 算法 会由于无法加载进内存而致使该算法失效,而 IFCM (c+p)算法不用担心这个问题。 表 5 IFCM(c+p)、SPFCM、rseFCM 算法在 2D15 数据集中的 NMI 值 Table 5 NMI of IFCM(c+p), SPFCM, rseFCM for 2D15 dataset 样本大小 IFCM(c+p)( α = 2.1) avg. std. IFCM(c+p)( α = 0) avg. std. SPFCM avg. std. rseFCM avg. std. 1% 0.939 9 0.024 4 0.843 8 0.031 2 0.926 0 0.016 4 0.868 8 0.021 3 0.878 5 0.987 0 0.769 9 0.905 5 0.897 2 0.949 4 0.819 5 0.913 7 2.50% 0.934 8 0.010 0 0.869 5 0.019 3 0.930 2 0.016 3 0.896 5 0.025 2 0.900 0 0.955 3 0.827 8 0.923 8 0.904 2 0.951 3 0.829 8 0.941 0 5% 0.951 9 0.015 9 0.912 3 0.008 6 0.943 0.016 5 0.903 5 0.020 2 0.915 5 0.971 5 0.878 3 0.926 2 0.905 5 0.960 6 0.865 2 0.943 3 10% 0.936 9 0.008 4 0.877 5 0.004 7 0.931 3 0.011 5 0.920 0 0.019 3 0.928 4 0.950 7 0.871 7 0.888 2 0.890 6 0.944 9 0.877 6 0.943 2 25% 0.926 0 0 0.864 6 0.013 0 0.922 2 0.014 7 0.929 4 0.019 5 0.925 5 0.926 3 0.825 9 0.871 3 0.895 8 0.940 5 0.886 6 0.950 9 35% 0.913 7 0.024 8 0.909 7 0 0.927 0 0.015 7 0.921 4 0.020 8 0.895 2 0.947 4 0.908 7 0.910 4 0.899 2 0.943 1 0.865 2 0.943 8 50% 0.911 8 0 0.907 9 0 0.921 0.017 4 0.916 9 0.02 0.911 1 0.912 2 0.907 6 0.908 3 0.883 9 0.943 9 0.869 6 0.942 5 FCPM 0.860 7 0 0.860 4 0.860 8 表 6 IFCM(c+p)、SPFCM、rseFCM 算法在 MNIST 数据集中的 NMI 值 Table 6 NMI of IFCM(c+p), SPFCM, rseFCM for MNIST dataset 样本大小 IFCM(c+p)( α = 160) avg. std. IFCM(c+p)( α = 0) avg. std. SPFCM avg. std. rseFCM avg. std. 1% 0.313 9 0 0.244 7 0 0.224 6 0.070 9 — — 0.313 9 0.313 9 0.244 7 0.244 7 0.133 7 0.334 5 — — 2.50% 0.260 6 0 0.239 0 0 0.258 8 0.031 0 — — 0.260 6 0.260 6 0.239 0 0.239 0 0.191 5 0.317 3 — — 5% 0.297 4 0 0.164 6 0 0.242 4 0.042 3 — — 0.297 4 0.297 4 0.164 6 0.164 6 0.141 7 0.298 7 — — ·194· 智 能 系 统 学 报 第 11 卷

第2期 李滔,等:适合大规模数据集的增量式模糊聚类算法 ·195. 续表6 IFCM(c+p)(a =160) IFCM(c+p)(a=0) SPFCM rseFCM 样本大小 avg. std. avg. std. avg. std. avg. std 0.3217 0 0.2089 0 0.2299 0 10% 0.3217 0.3217 0.2089 0.2089 0.2296 0.2301 0.2634 0 0.2180 0 0.1818 0 25% 0.2634 0.2634 0.2180 0.2180 0.1807 0.1832 0.3309 0 0.1712 0 0.2027 0.0131 35% 0.3309 0.3309 0.1712 0.1712 0.1763 0.2328 0.2135 0 0.2072 0 0.1744 0.0188 50% 0.2135 0.2135 0.2072 0.2072 0.16320.2037 0.1723 0 FCPM(70%) 0.1723 0.1723 表7FCM(c+p)、SPFCM、rseFCM算法在forest数据集中的NMI值 Table 7 NMI of IFCM(c+p),SPFCM,rseFCM for forest dataset IFCM(c+p)(a =21) IFCM(c+p)(a =0) SPFCM rseFCM 样本大小 avg. std. avg. std. avg. std. avg. std. 0.1593 0.0016 0.1036 0 0.1161 0.0089 0.1% 0.1583 0.1631 0.1036 0.1036 0.1042 0.1370 0.1123 0 0.1016 0 0.1012 0.0049 0.5% 0.1123 0.1125 0.1016 0.1016 0.0943 0.1143 0.1264 0 0.1055 0 0.1102 0.0056 1% 0.1260 0.1273 0.1055 0.1055 0.1036 0.1225 0.1077 0 0.1064 0 0.1003 0.0030 2.50% 0.1077 0.1077 0.1064 0.1064 0.0963 0.1075 0.1092 0 0.1021 0.1025 0.0050 5% 0.1053 0.1094 0.1021 0.1021 0.0988 0.1113 0.1015 0 FCPM(10%) 0.1015 0.1015 表8 IFCM(c+p)、SPFCM、rseFCM算法在waveform数据集中的RI值 Table 8 RI of IFCM(c+p),SPFCM,rseFCM for waveform dataset FCM(c+p)(a=2.1) IFCM(c+p)(a=0) SPFCM rseFCM 样本大小 avg. std. avg. std. avg. std. avg. std. 0.7023 0.0095 0.6804 0.0018 0.6691 0.3301 0.6572 0.0018 0.1% 0.6841 0.7176 0.6767 0.6873 0.6637 0.6882 0.65656 0.6697 0.6890 0.0015 0.6638 0 0.6743 0 0.6633 0.0028 2.50% 0.6888 0.6996 0.6627 0.6639 0.6743 0.6748 0.6623 0.6824 0.7009 0.0024 0.6659 0 0.6625 0 0.6658 0 5% 0.6911 0.7017 0.6658 0.6674 0.6622 0.6626 0.66580.6659 0.6666 0 0.6651 0 0.6619 0 0.6531 0 10% 0.6664 0.6708 0.6632 0.6652 0.6619 0.6621 0.6529 0.6533

续表 6 样本大小 IFCM(c+p)( α = 160) avg. std. IFCM(c+p)( α = 0) avg. std. SPFCM avg. std. rseFCM avg. std. 10% 0.321 7 0 0.208 9 0 0.229 9 0 — — 0.321 7 0.321 7 0.208 9 0.208 9 0.229 6 0.230 1 — — 25% 0.263 4 0 0.218 0 0 0.181 8 0 — — 0.263 4 0.263 4 0.218 0 0.218 0 0.180 7 0.183 2 — — 35% 0.330 9 0 0.171 2 0 0.202 7 0.013 1 — — 0.330 9 0.330 9 0.171 2 0.171 2 0.176 3 0.232 8 — — 50% 0.213 5 0 0.207 2 0 0.174 4 0.018 8 — — 0.213 5 0.213 5 0.207 2 0.207 2 0.163 2 0.203 7 — — FCPM(70%) 0.172 3 0 0.172 3 0.172 3 表 7 IFCM(c+p)、SPFCM、rseFCM 算法在 forest 数据集中的 NMI 值 Table 7 NMI of IFCM(c+p), SPFCM, rseFCM for forest dataset 样本大小 IFCM(c+p)( α = 21) avg. std. IFCM(c+p)( α = 0) avg. std. SPFCM avg. std. rseFCM avg. std. 0.1% 0.159 3 0.001 6 0.103 6 0 0.116 1 0.008 9 — — 0.158 3 0.163 1 0.103 6 0.103 6 0.104 2 0.137 0 — — 0.5% 0.112 3 0 0.101 6 0 0.101 2 0.004 9 — — 0.112 3 0.112 5 0.101 6 0.101 6 0.094 3 0.114 3 — — 1% 0.126 4 0 0.105 5 0 0.110 2 0.005 6 — — 0.126 0 0.127 3 0.105 5 0.105 5 0.103 6 0.122 5 — — 2.50% 0.107 7 0 0.106 4 0 0.100 3 0.003 0 — — 0.107 7 0.107 7 0.106 4 0.106 4 0.096 3 0.107 5 — — 5% 0.109 2 0 0.102 1 0 0.102 5 0.005 0 — — 0.105 3 0.109 4 0.102 1 0.102 1 0.098 8 0.111 3 — — FCPM(10%) 0.101 5 0 0.101 5 0.101 5 表 8 IFCM(c+p)、SPFCM、rseFCM 算法在 waveform 数据集中的 RI 值 Table 8 RI of IFCM(c+p), SPFCM, rseFCM for waveform dataset 样本大小 IFCM(c+p)( α = 2.1) avg. std. IFCM(c+p)( α = 0) avg. std. SPFCM avg. std. rseFCM avg. std. 0.1% 0.702 3 0.009 5 0.680 4 0.001 8 0.669 1 0.330 1 0.657 2 0.001 8 0.684 1 0.717 6 0.676 7 0.687 3 0.663 7 0.688 2 0.6565 6 0.669 7 2.50% 0.689 0 0.001 5 0.663 8 0 0.674 3 0 0.663 3 0.002 8 0.688 8 0.699 6 0.662 7 0.663 9 0.674 3 0.674 8 0.662 3 0.682 4 5% 0.700 9 0.002 4 0.665 9 0 0.662 5 0 0.665 8 0 0.691 1 0.701 7 0.665 8 0.667 4 0.662 2 0.662 6 0.665 8 0.665 9 10% 0.666 6 0 0.665 1 0 0.661 9 0 0.653 1 0 0.666 4 0.670 8 0.663 2 0.665 2 0.661 9 0.662 1 0.652 9 0.653 3 第 2 期 李滔,等: 适合大规模数据集的增量式模糊聚类算法 ·195·

196. 智能系统学报 第11卷 续表8 FCM(c+p)(a=2.1) IFCM(c+p)(a=0) SPFCM rseFCM 样本大小 avg std. avg. std. avg. std. avg. std. 0.6643 0.0018 0.6633 0 0.6613 0 0.6633 0 25% 0.6537 0.6693 0.6633 0.6634 0.6612 0.6615 0.6632 0.6634 0.6702 0 0.6640 0 0.6632 0 0.6623 0.0024 35% 0.6692 0.6703 0.6638 0.664 0.6632 0.6633 0.6619 0.6790 0.6699 0 0.6644 0 0.6651 0 0.6607 0 50% 0.6698 0.6701 0.6644 0.6644 0.6648 0.6652 0.6607 0.6608 0.6622 0.0027 FCPM 0.6492 0.6627 表9IFCM(c+p)、SPFCM、rseFCM算法在2D15数据集中的RI值 Table 9 RI of IFCM(c+p),SPFCM,rseFCM for 2D15 dataset IFCM(c+p)a =0.2) IFCM(c+p)(a=0) SPFCM rseFCM 样本大小 avg std. avg. std. avg. std. avg. std. 0.979 0.0097 0.9383 0.0127 0.9755 0.006 0.9697 0.0079 0.1% 0.9559 0.9976 0.9135 0.9665 0.9665 0.9837 0.9504 0.9856 0.9848 0.0024 0.9605 0.0064 0.9818 0.0054 0.9773 0.008 2.509% 0.9756 0.9879 0.9461 0.9761 0.9717 0.9881 0.9561 0.9912 0.9897 0.0050 0.9767 0.0030 0.9869 0.0049 0.9787 0.0064 5% 0.9792 0.9946 0.9648 0.9805 0.9773 0.9916 0.9647 0.9915 0.9871 0.0033 0.9701 0.0019 0.9864 0.0039 0.9836 0.0067 10% 0.9836 0.9914 0.9677 0.9720 0.9743 0.9903 0.9687 0.9917 0.9835 0 0.9651 0.0029 0.9849 0.0052 0.9861 0.0061 25% 0.9834 0.9835 0.9566 0.9678 0.9763 0.9901 0.9708 0.9929 0.9832 0.0066 0.9804 0 0.9860 0.0053 0.9844 0.0067 35% 0.9783 0.9932 0.9803 0.9805 0.9779 0.9910 0.9672 0.9917 0.9801 0 0.9812 0 0.9842 0.0056 0.9829 0.0066 50% 0.9799 0.9802 0.9812 0.9813 0.9711 0.9915 0.9652 0.9913 0.9683 0 FCPM 0.9683 0.9684 表I0IFCM(c+p)、SPFCM、rseFCM算法在MNIST数据集中的RI值 Table 10 RI of IFCM(c+p),SPFCM,rseFCM for MNSIT dataset IFCM(c+p)(a =160) IFCM(c+p)(a=0) SPFCM rseFCM 样本大小 avg std. avg. std. avg. std. avg. std. 0.7864 0 0.7222 0 0.7352 0.0961 0.1% 0.7864 0.7864 0.7222 0.7222 0.6063 0.8401 0.7935 0 0.7123 0 0.7924 0.0336 2.50% 0.7935 0.7935 0.7123 0.7123 0.6925 0.8300 0.7576 0 0.6129 0 0.7541 0.0503 5% 0.7576 0.7576 0.6129 0.6129 0.6448 0.8221

续表 8 样本大小 IFCM(c+p)( α = 2.1) avg. std. IFCM(c+p)( α = 0) avg. std. SPFCM avg. std. rseFCM avg. std. 25% 0.664 3 0.001 8 0.663 3 0 0.661 3 0 0.663 3 0 0.653 7 0.669 3 0.663 3 0.663 4 0.661 2 0.661 5 0.663 2 0.663 4 35% 0.670 2 0 0.664 0 0 0.663 2 0 0.662 3 0.002 4 0.669 2 0.670 3 0.663 8 0.664 0.663 2 0.663 3 0.661 9 0.679 0 50% 0.669 9 0 0.664 4 0 0.665 1 0 0.660 7 0 0.669 8 0.670 1 0.664 4 0.664 4 0.664 8 0.665 2 0.660 7 0.660 8 FCPM 0.662 2 0.002 7 0.649 2 0.662 7 表 9 IFCM(c+p)、SPFCM、rseFCM 算法在 2D15 数据集中的 RI 值 Table 9 RI of IFCM(c+p), SPFCM, rseFCM for 2D15 dataset 样本大小 IFCM(c+p)( α = 0.2) avg. std. IFCM(c+p)( α = 0) avg. std. SPFCM avg. std. rseFCM avg. std. 0.1% 0.979 0.009 7 0.938 3 0.012 7 0.975 5 0.006 0.969 7 0.007 9 0.955 9 0.997 6 0.913 5 0.966 5 0.966 5 0.983 7 0.950 4 0.985 6 2.50% 0.984 8 0.002 4 0.960 5 0.006 4 0.981 8 0.005 4 0.977 3 0.008 0.975 6 0.987 9 0.946 1 0.976 1 0.971 7 0.988 1 0.956 1 0.991 2 5% 0.989 7 0.005 0 0.976 7 0.003 0 0.986 9 0.004 9 0.978 7 0.006 4 0.979 2 0.994 6 0.964 8 0.980 5 0.977 3 0.991 6 0.964 7 0.991 5 10% 0.987 1 0.003 3 0.970 1 0.001 9 0.986 4 0.003 9 0.983 6 0.006 7 0.983 6 0.991 4 0.967 7 0.972 0 0.974 3 0.990 3 0.968 7 0.991 7 25% 0.983 5 0 0.965 1 0.002 9 0.984 9 0.005 2 0.986 1 0.006 1 0.983 4 0.983 5 0.956 6 0.967 8 0.976 3 0.990 1 0.970 8 0.992 9 35% 0.983 2 0.006 6 0.980 4 0 0.986 0 0.005 3 0.984 4 0.006 7 0.978 3 0.993 2 0.980 3 0.980 5 0.977 9 0.991 0 0.967 2 0.991 7 50% 0.980 1 0 0.981 2 0 0.984 2 0.005 6 0.982 9 0.006 6 0.979 9 0.980 2 0.981 2 0.981 3 0.971 1 0.991 5 0.965 2 0.991 3 FCPM 0.968 3 0 0.968 3 0.968 4 表 10 IFCM(c+p)、SPFCM、rseFCM 算法在 MNIST 数据集中的 RI 值 Table 10 RI of IFCM(c+p), SPFCM, rseFCM for MNSIT dataset 样本大小 IFCM(c+p)( α = 160) avg. std. IFCM(c+p)( α = 0) avg. std. SPFCM avg. std. rseFCM avg. std. 0.1% 0.786 4 0 0.722 2 0 0.735 2 0.096 1 — — 0.786 4 0.786 4 0.722 2 0.722 2 0.606 3 0.840 1 — — 2.50% 0.793 5 0 0.712 3 0 0.792 4 0.033 6 — — 0.793 5 0.793 5 0.712 3 0.712 3 0.692 5 0.830 0 — — 5% 0.757 6 0 0.612 9 0 0.754 1 0.050 3 — — 0.757 6 0.757 6 0.612 9 0.612 9 0.644 8 0.822 1 — — ·196· 智 能 系 统 学 报 第 11 卷

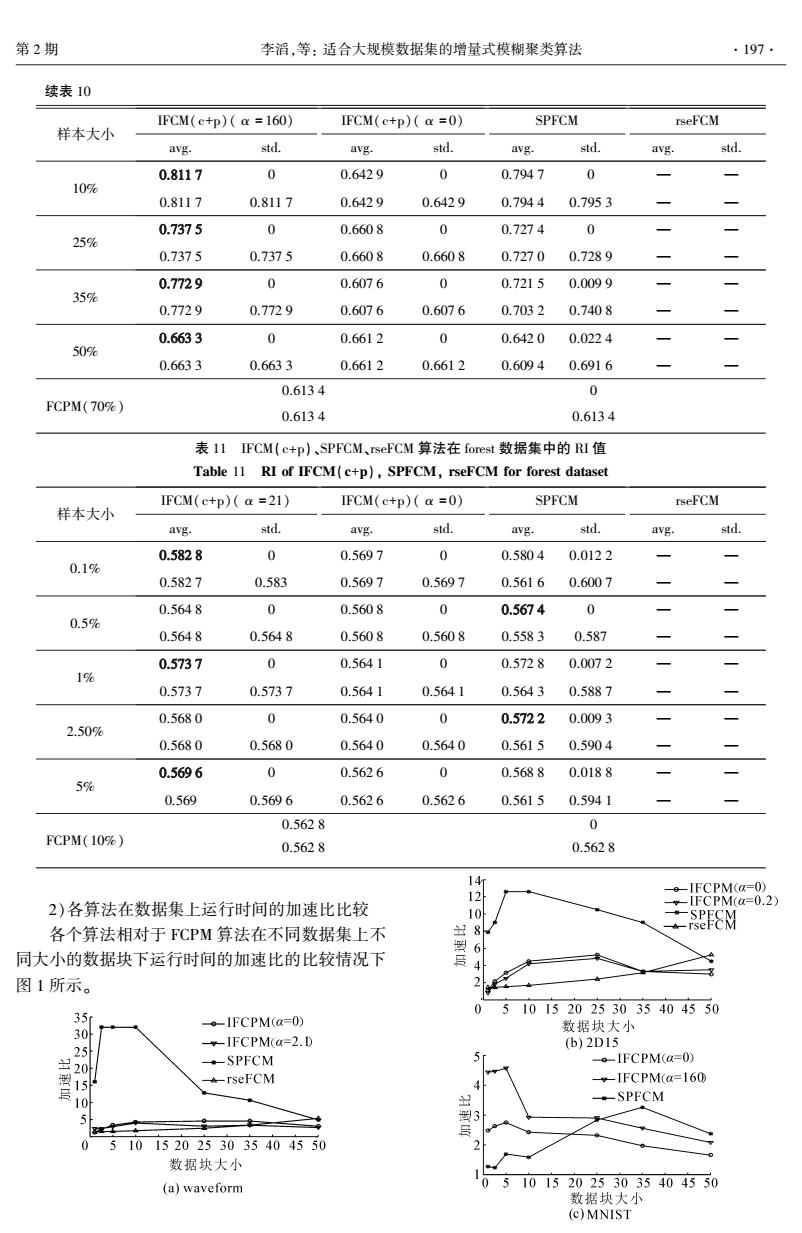

第2期 李滔,等:适合大规模数据集的增量式模糊聚类算法 197. 续表10 IFCM(c+p)(a =160) IFCM(c+p)(a =0) SPFCM rseFCM 样本大小 avg. std. avg. std. avg. std. avg. std. 0.8117 0 0.6429 0 0.7947 0 10% 0.8117 0.8117 0.6429 0.6429 0.79440.7953 0.7375 0 0.6608 0 0.7274 0 25% 0.7375 0.7375 0.6608 0.6608 0.7270 0.7289 0.7729 0 0.6076 0 0.7215 0.0099 35% 0.7729 0.7729 0.6076 0.6076 0.7032 0.7408 0.6633 0 0.6612 0 0.6420 0.0224 50% 0.6633 0.6633 0.6612 0.6612 0.60940.6916 0.6134 0 FCPM(70%) 0.6134 0.6134 表I1IFCM(c+p)、SPFCM、rseFCM算法在forest数据集中的RI值 Table 11 RI of IFCM(c+p),SPFCM,rseFCM for forest dataset IFCM(c+p)a=21) IFCM(c+p)(a =0) SPFCM rseFCM 样本大小 avg. std. avg. std. avg. std. avg. std. 0.5828 0 0.5697 0 0.5804 0.0122 0.1% 0.5827 0.583 0.5697 0.5697 0.5616 0.6007 0.5648 0 0.5608 0 0.5674 0 0.5% 0.5648 0.5648 0.5608 0.5608 0.5583 0.587 0.5737 0 0.5641 0 0.5728 0.0072 1% 0.5737 0.5737 0.5641 0.5641 0.5643 0.5887 0.5680 0 0.5640 0 0.5722 0.0093 2.50% 0.5680 0.5680 0.5640 0.5640 0.5615 0.5904 0.5696 0 0.5626 0 0.5688 0.0188 5% 0.569 0.5696 0.5626 0.5626 0.5615 0.5941 0.5628 0 FCPM(10%) 0.5628 0.5628 4 -IFCPM(a=0) 12 2)各算法在数据集上运行时间的加速比比较 -IFCPM(a=0.2) 各个算法相对于FCPM算法在不同数据集上不 出 8 同大小的数据块下运行时间的加速比的比较情况下 6 图1所示。 5101520253035404550 35 。-IFCPM(a=O) 30H 数据块大小 25 IFCPM(a=2.D (b)2D15 20叶 。SPFCM 。-IFCPM(a=0) 殿15 rseFCM 。-IFCPM(a=160 10 -SPFCM 5 型3 5 101520253035404550 数据块大小 (a)waveform 05101520253035404550 数据块大小 (c)MNIST

续表 10 样本大小 IFCM(c+p)( α = 160) avg. std. IFCM(c+p)( α = 0) avg. std. SPFCM avg. std. rseFCM avg. std. 10% 0.811 7 0 0.642 9 0 0.794 7 0 — — 0.811 7 0.811 7 0.642 9 0.642 9 0.794 4 0.795 3 — — 25% 0.737 5 0 0.660 8 0 0.727 4 0 — — 0.737 5 0.737 5 0.660 8 0.660 8 0.727 0 0.728 9 — — 35% 0.772 9 0 0.607 6 0 0.721 5 0.009 9 — — 0.772 9 0.772 9 0.607 6 0.607 6 0.703 2 0.740 8 — — 50% 0.663 3 0 0.661 2 0 0.642 0 0.022 4 — — 0.663 3 0.663 3 0.661 2 0.661 2 0.609 4 0.691 6 — — FCPM(70%) 0.613 4 0 0.613 4 0.613 4 表 11 IFCM(c+p)、SPFCM、rseFCM 算法在 forest 数据集中的 RI 值 Table 11 RI of IFCM(c+p), SPFCM, rseFCM for forest dataset 样本大小 IFCM(c+p)( α = 21) avg. std. IFCM(c+p)( α = 0) avg. std. SPFCM avg. std. rseFCM avg. std. 0.1% 0.582 8 0 0.569 7 0 0.580 4 0.012 2 — — 0.582 7 0.583 0.569 7 0.569 7 0.561 6 0.600 7 — — 0.5% 0.564 8 0 0.560 8 0 0.567 4 0 — — 0.564 8 0.564 8 0.560 8 0.560 8 0.558 3 0.587 — — 1% 0.573 7 0 0.564 1 0 0.572 8 0.007 2 — — 0.573 7 0.573 7 0.564 1 0.564 1 0.564 3 0.588 7 — — 2.50% 0.568 0 0 0.564 0 0 0.572 2 0.009 3 — — 0.568 0 0.568 0 0.564 0 0.564 0 0.561 5 0.590 4 — — 5% 0.569 6 0 0.562 6 0 0.568 8 0.018 8 — — 0.569 0.569 6 0.562 6 0.562 6 0.561 5 0.594 1 — — FCPM(10%) 0.562 8 0 0.562 8 0.562 8 2)各算法在数据集上运行时间的加速比比较 各个算法相对于 FCPM 算法在不同数据集上不 同大小的数据块下运行时间的加速比的比较情况下 图 1 所示。 第 2 期 李滔,等: 适合大规模数据集的增量式模糊聚类算法 ·197·