中国辩学我术大 Focal Loss for Dense Object Detection Facebook AI Research (FAIR) SA19006022胡彬

Focal Loss for Dense Object Detection Facebook AI Research (FAIR) SA19006022 胡彬

中国学我术大 论文简介 理论方案 实验结果

论文简介 理论方案 实验结果

中国绅学我术大草 论文简介 问题引入: 目前目标检测的框架一般分为两种:基于候选区域的two-stagel的检测框架(r-cnn系列),基于回归的 one-stage的检测框架(yolo、ssd系列),two-stage?效果好但是速度慢,one-stage速度快但是效果差。 为什么one-stagel的检测器准确率不高?作者给出的解释是由于正负样本不均衡的问题。样本中会存在 大量的easy examples,.且都是负样本(属于背景的样本)。这样,en masse easy negative examples:会对loss起主 要贡献作用,进而主导梯度的更新方向。网络无法学习有用的信息,无法对object进行准确分类。 (1)training is inefficient as most locations are easy negatives that contribute no useful learning signal; (2)en masse,the easy negatives can overwhelm training and lead to degenerate models

论文简介 问题引入: 目前目标检测的框架一般分为两种:基于候选区域的two-stage的检测框架(r-cnn系列),基于回归的 one-stage的检测框架(yolo、ssd系列),two-stage效果好但是速度慢,one-stage速度快但是效果差。 为什么one-stage的检测器准确率不高?作者给出的解释是由于正负样本不均衡的问题。样本中会存在 大量的easy examples,且都是负样本(属于背景的样本)。这样,en masse easy negative examples会对loss起主 要贡献作用,进而主导梯度的更新方向。网络无法学习有用的信息,无法对object进行准确分类。 (1) training is inefficient as most locations are easy negatives that contribute no useful learning signal; (2) en masse, the easy negatives can overwhelm training and lead to degenerate models

中国绅学我术大草 论文简介 负样本数量太大,占总的1oss的大部分,而且多是容易分类的,因此使得模型的优化方向并不是我们所 希望的那样。先前也有一些算法来处理类别不均衡的问题,比如OHEM(online hard example mining), OHEM算法虽然增加了错分类样本的权重,但是OHEM算法忽略了容易分类的样本。 针对类别不均衡问题,作者提出一种新的损失函数:focal loss,这个损失函数是在标准交叉熵损失基 础上修改得到的。这个函数可以通过减少易分类样本的权重,使得模型在训练时更专注于难分类的样本。 为了证明focal loss的有效性,作者设计了一个dense detector:RetinaNet,.并且在训练时采用focal loss训练。 实验证明RetinaNet不仅可以达到one-stage detector的速度,也能有two-stage detectorl的准确率

论文简介 负样本数量太大,占总的loss的大部分,而且多是容易分类的,因此使得模型的优化方向并不是我们所 希望的那样。先前也有一些算法来处理类别不均衡的问题,比如OHEM(online hard example mining), OHEM算法虽然增加了错分类样本的权重,但是OHEM算法忽略了容易分类的样本。 针对类别不均衡问题,作者提出一种新的损失函数:focal loss,这个损失函数是在标准交叉熵损失基 础上修改得到的。这个函数可以通过减少易分类样本的权重,使得模型在训练时更专注于难分类的样本。 为了证明focal loss的有效性,作者设计了一个dense detector:RetinaNet,并且在训练时采用focal loss训练。 实验证明RetinaNet不仅可以达到one-stage detector的速度,也能有two-stage detector的准确率

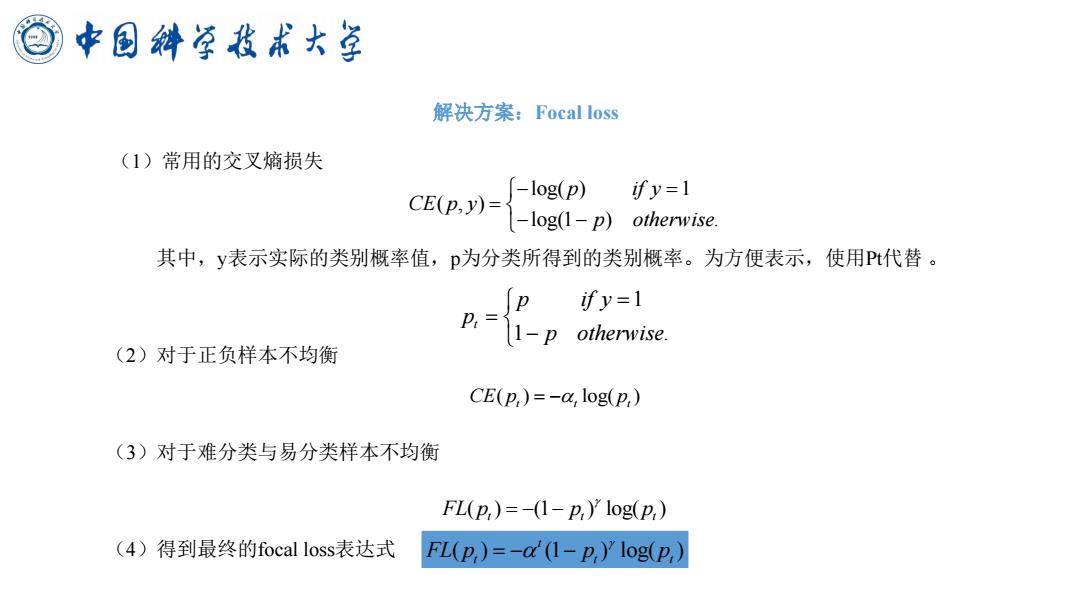

中国绅学我术大草 解决方案:Focal loss (1)常用的交叉熵损失 -log(p) CE(p,y)= ify=1 -log(1-p)otherwise 其中,y表示实际的类别概率值,p为分类所得到的类别概率。为方便表示,使用Pt代替。 ify=1 p,11-p otherwise. (2)对于正负样本不均衡 CE(p,)=-a,log(p,) (3)对于难分类与易分类样本不均衡 FL(p,)=-(1-2,)'log(p,) (4)得到最终的focal loss表达式 FL(p,)=-ad1-p,)'1og(P,)

解决方案:Focal loss (1)常用的交叉熵损失 其中,y表示实际的类别概率值,p为分类所得到的类别概率。为方便表示,使用Pt代替 。 (2)对于正负样本不均衡 (3)对于难分类与易分类样本不均衡 (4)得到最终的focal loss表达式 log( ) 1 ( , ) log(1 ) . p if y CE p y p otherwise − = = − − 1 1 . t p if y p p otherwise = = − ( ) log( ) CE p p t t t = − ( ) (1 ) log( ) FL p p p t t t = − − ( ) (1 ) log( ) t FL p p p t t t = − −

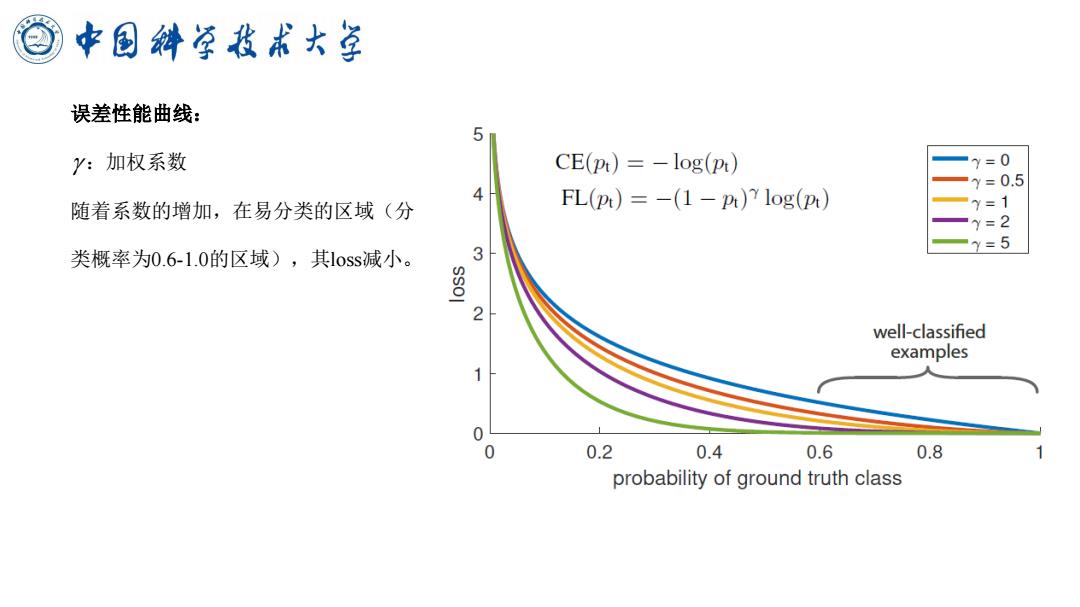

中国斜学我术大草 误差性能曲线: 5 y:加权系数 CE(pt)=-log(pt) =y=0 —y=0.5 4 随着系数的增加,在易分类的区域(分 FL(pt)=-(1-p)7 log(pt) y=1 y=2 义=5 类概率为0.6-1.0的区域),其1oss减小。 2 well-classified examples 0 0 0.2 0.4 0.6 0.8 probability of ground truth class

误差性能曲线: :加权系数 随着系数的增加,在易分类的区域(分 类概率为0.6-1.0的区域),其loss减小。

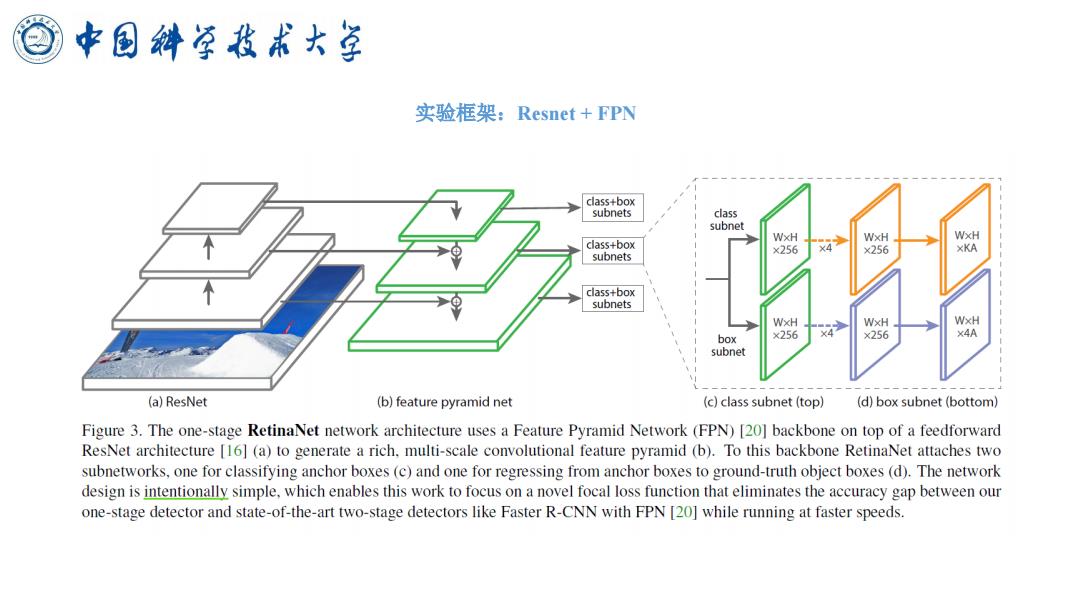

中国绅学我术大草 实验框架:Resnet+FPN 1 class+box subnets class subnet WxH class+box ×256 x4 WxH WxH ×256 XKA subnets class+box subnets WxH WxH WxH ×256 ×256 x4A box subnet (a)ResNet (b)feature pyramid net (c)class subnet (top) (d)box subnet (bottom) Figure 3.The one-stage RetinaNet network architecture uses a Feature Pyramid Network(FPN)[20]backbone on top of a feedforward ResNet architecture [16](a)to generate a rich.multi-scale convolutional feature pyramid (b).To this backbone RetinaNet attaches two subnetworks,one for classifying anchor boxes (c)and one for regressing from anchor boxes to ground-truth object boxes (d).The network design is intentionally simple,which enables this work to focus on a novel focal loss function that eliminates the accuracy gap between our one-stage detector and state-of-the-art two-stage detectors like Faster R-CNN with FPN [20]while running at faster speeds

实验框架:Resnet + FPN

中国绅学我术大草 实验框架:Resnet+FPN 作者为了测试所提出的损失函数的性能,在网络结构上没有做过多的设计。检测所利用的网络结构是 Resnet+FPN,设计了两路分支分别用来得到检测框以及检测结果的置信度,并将此结构命名为RetinaNet。 Anchors:作者用了translation-invariant anchor boxes平移不变anchor,在每个金字塔层,作者用的长宽比 是{1:2,1:l,2:1}。在每层,对于三个长宽比的anchor,加了anchor的形状的{20,2{1/3},2^2/3}}的 anchor。对于每层,有A=9个anchor。 Classification Subnet:分类子网络在每个空间位置,为A个anchor和K个类别,预测目标存在的概率。子 网络的参数在整个金字塔的层间共享。 Box Regression Subnet:与object classification子网络平行,作者在金字塔每个层都接到一个的FCN上, 意图回归每个anchor box.对邻近ground truth object的偏移量

实验框架:Resnet + FPN 作者为了测试所提出的损失函数的性能,在网络结构上没有做过多的设计。检测所利用的网络结构是 Resnet + FPN,设计了两路分支分别用来得到检测框以及检测结果的置信度,并将此结构命名为RetinaNet。 Anchors:作者用了translation-invariant anchor boxes 平移不变anchor,在每个金字塔层,作者用的长宽比 是{ 1:2, 1:1, 2:1 }。在每层,对于三个长宽比的anchor,加了anchor的形状的{ 2^0, 2^{1/3}, 2^{2/3} }的 anchor。对于每层,有A=9个anchor。 Classification Subnet:分类子网络在每个空间位置,为A个anchor和K个类别,预测目标存在的概率。子 网络的参数在整个金字塔的层间共享。 Box Regression Subnet:与object classification子网络平行,作者在金字塔每个层都接到一个的FCN上, 意图回归每个anchor box对邻近ground truth object的偏移量

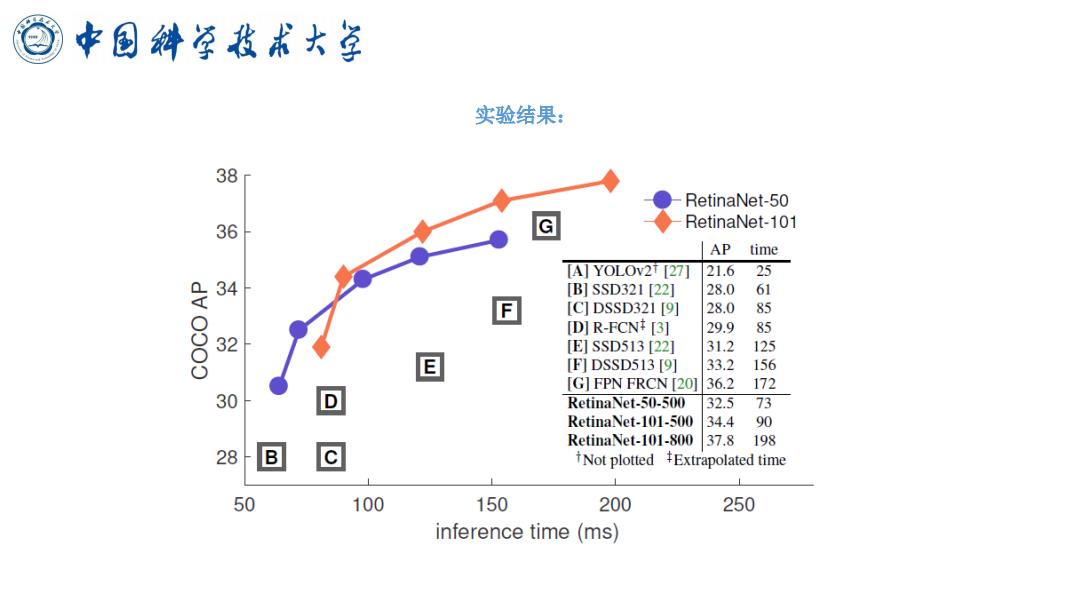

中国斜学我术大草 实验结果: 38 RetinaNet-50 36 RetinaNet-101 AP time [A]YOLOV2T [27] 21.6 25 34 B]SSD321[22] 28.0 61 E [C]DSSD321[9] 28.0 85 [D]R-FCN+[3] 29.9 85 32 [E]SSD513[22] 31.2 125 E [F]DSSD513[9] 33.2 156 [G]FPN FRCN [20]36.2 172 30 D RetinaNet-50-500 32.573 RetinaNet-101-500 34.4 90 @ RetinaNet-101-800 37.8198 28 B Not plotted Extrapolated time 50 100 150 200 250 inference time(ms)

实验结果:

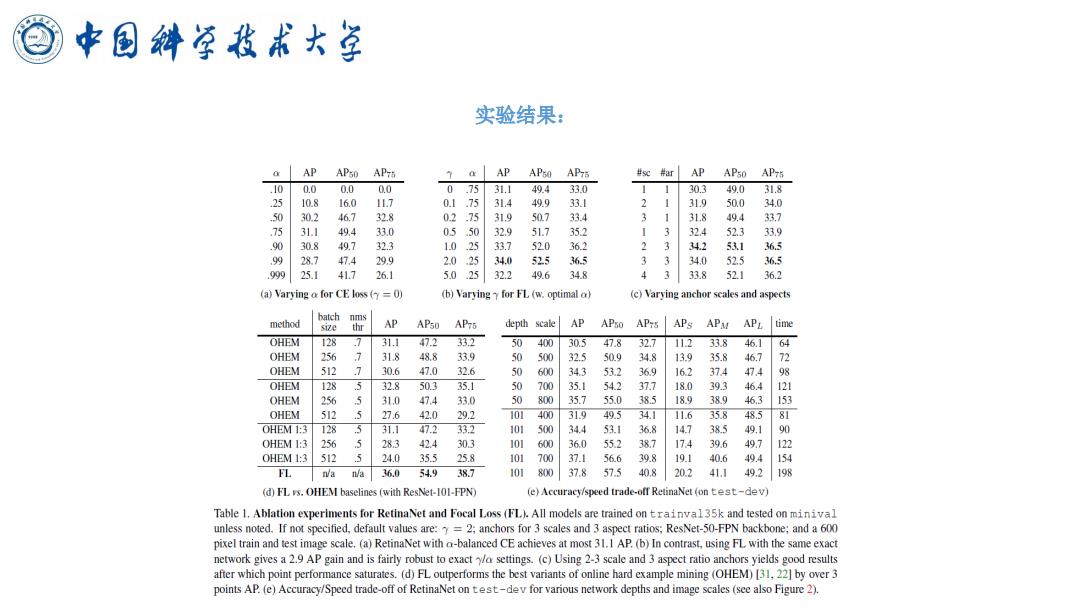

中国斜学我术大草 实验结果: axAP AP50 APi 7a AP APso AP7s #sc #ar AP APso AP75 .100.0 0.0 0.0 07531.149.4 33.0 30.349.0 31.8 .25 10.8 16.0 1L.7 1 .75 31.4 49.9 33.1 31.9 50.0 34.0 50 30.2 46.7 32.8 0 .7 31.9 507 33.4 1 318 49.4 33.7 .75 31.1 49.4 33.0 05 50 32.9 51.7 352 324 523 33.9 .90 30.8 497 32.3 1.0 33.7 520 362 2 342 531 36.5 .99 28.7 47.4 29.9 2.0 34.0 525 36.5 34.0 525 36.5 999 25.1 41.7 26.1 5.0 25 32.2 49.6 34.8 3 33.8 52.1 36.2 (a)Varying a for CE loss(=0) (b)Varying for FL (w.optimal a) (c)Varying anchor seales and aspects method batch nms size thr AP APso AP75 depth scale AP APso AP7s APs APM APL time OHEM 128 .7 31.1 47.2 33.2 50 400 30.5 47.8 32.7 112 33.8 46.1 64 OHEM 256 7 318 48.8 339 500 32.5 50.9 34.8 13.9 35.8 46.7 7 OHEM 512 7 30.6 47.0 32.6 西 600 343 53.2 36.9 162 374 47.4 OHEM 128 5 32.8 503 35.1 700 35.1 54.2 37.7 18.0 393 46.4 OHEM 256 5 31.0 47.4 33.0 5 800 35.7 55.0 385 189 389 46.3 153 OHEM 512 27.6 42.0 29.2 101400 319 49.5 34.1 11.6 358 48.5 81 OHEM1:3128 31.147.2 33.2 101 500 34.4 53.1 36.8 147 385 49.1 OHEM 1:3 256 5 283 424 30.3 101 600 36.0 55.2 387 174 39.6 49.7 122 OHEM 1:3 512 5 24.0 35.5 25.8 101 700 37.1 56.6 39.8 19.1 40.6 49.4 154 FL aa36.054938.7 101 8M00 37.8 57.5 40.8 202 41.1 49.2198 (d)FL vs.OHEM baselines (with ResNet-101-FPN) (e)Accuracy/speed trade-off RetinaNet (on test-dev) Table 1.Ablation experiments for RetinaNet and Focal Loss (FL).All models are trained on trainval35k and tested on minival unless noted.If not specified,default values are:y=2;anchors for 3 scales and 3 aspect ratios;ResNet-50-FPN backbone;and a 600 pixel train and test image scale.(a)RetinaNet with a-balanced CE achieves at most 31.I AP.(b)In contrast,using FL with the same exact network gives a 2.9 AP gain and is fairly robust to exactya settings.(c)Using 2-3 scale and 3 aspect ratio anchors yields good results after which point performance saturates.(d)FL outperforms the best variants of online hard example mining (OHEM)[31,22]by over3 points AP.(e)Accuracy/Speed trade-off of RetinaNet on test-dev for various network depths and image scales (see also Figure 2)

实验结果: