大 1958 Augmented Reality based on Edge Computing using the example of Remote Live Support 课程:多媒体通信 姓名:廖君 学号:SA19006033

Augmented Reality based on Edge Computing using the example of Remote Live Support 姓名:廖君 课程:多媒体通信 学号:SA19006033

目录 姿 發 01 02 03 04 05 提出问题 研究背景 研究方法 实验结果 总结与感想

2 目 录 01 02 04 05 提出问题 研究背景 实验结果 总结与感想 03 研究方法

01提出问题 医疗机构等行业应用 Altoleci ●当前AR设备在计算性能和图形性能方面仍然有 很多不足之处,存在由网络引起的时延问题, 缺乏为用户提供良好的AR体验。 ·将AR应用程序投入运行并在不同的移动设备上, 并在本地保持最新状态的成本非常昂贵。 ·缺乏有效的相机姿态跟踪方法。将虚拟注释放 置并保留在适当的现实3D位置。 Animal Cell

01 提出问题 •当前AR设备在计算性能和图形性能方面仍然有 很多不足之处,存在由网络引起的时延问题, 缺乏为用户提供良好的AR体验。 •将AR应用程序投入运行并在不同的移动设备上, 并在本地保持最新状态的成本非常昂贵。 •缺乏有效的相机姿态跟踪方法。将虚拟注释放 置并保留在适当的现实3D位置

02研究背景 相机姿 相机捕获图像 AR远程 态跟踪 惯性测量单元 视频会议系统 协助系统 可穿戴 将部分处理工作外包给 设备 处理单元集群,会引起 时延

02 研究背景 可穿戴 设备 相机姿 AR远程 态跟踪 协助系统 将部分处理工作外包给 处理单元集群,会引起 时延 相机捕获图像 惯性测量单元 视频会议系统

03研究方法 Unity-Aup 客户端 针对计算性能和跟踪问题, Mobile Operator Device 作者提出了一种基于边缘计算 Transmission I Detalls Transmission IV Details 的AR架构,实现了AR远程实时 Data: Data: Live Video Stream Live Video Stream 支持应用程序。 IMU Data (optional) with annotations 边缘服 创新点1:加入边缘服务 Access Server Point (cintMUnt) 务器 器,使用边缘计算 创新点2:提出了新的跟踪 Transmission ll Details Transmission lll Details Data: 方法 Data: -Live Video Stream) Single picture (with annotation) Picture ID -Picture ID Annotation Annotation ID Laptop Remote 远程端 Expert Fig.1.Remote Support System Architecture Overview

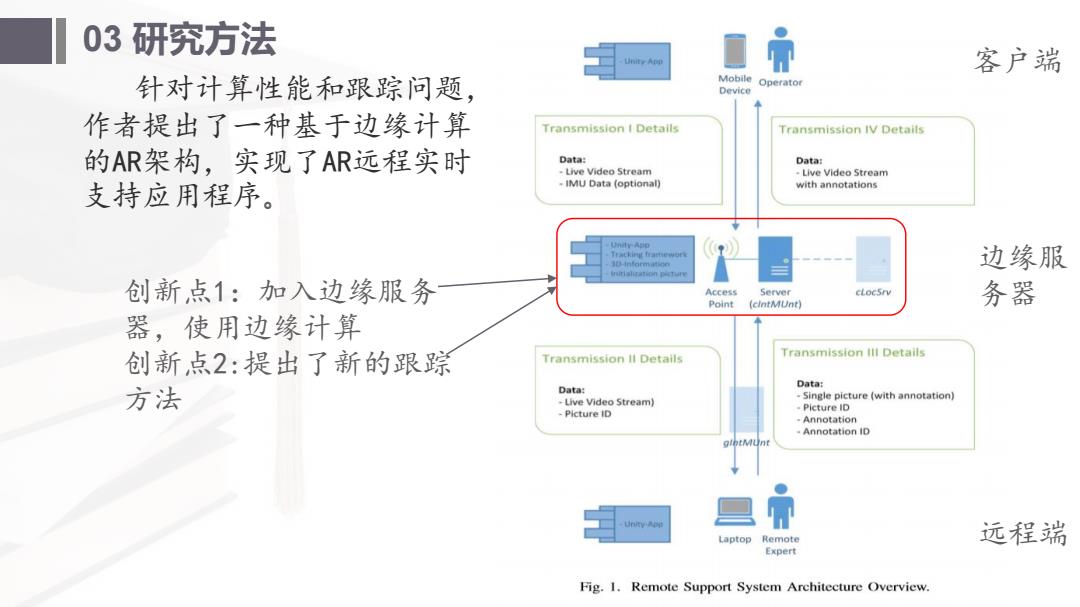

03 研究方法 针对计算性能和跟踪问题, 作者提出了一种基于边缘计算 的AR架构,实现了AR远程实时 支持应用程序 。 客户端 边缘服 务器 远程端 创新点 1:加入边缘服务 器,使用边缘计算 创新点2:提出了新的跟踪 方法

03研究方法 Mobile Operator Device 客户端:摄像头捕获视频帧,再与一些 IMU数据一起发送到边缘服务器。 Transmission I Details Transmission IV Details 边缘服务器端:完成跟踪过程,并将估 Data: Data: -Live Video Stream Live Video Stream IMU Data (optional) with annotations 计的每帧相机姿态保存在边缘服务器上。 使用WAN通过网关将视频流转发给远程专 家。 远程专家:实时看到传入的视频流,并 Access Server cLocSrv Point (clntMUnt) 可以随时暂停,向其中加入一些有用的注 释。这些注释与对应的图片ID一起发送回 Transmission Ill Details Transmission ll Details Data: 边缘服务器。 Data: Live Video Stream) Single picture (with annotation) -Picture ID Picture ID 边缘服务器能够将带注释的图片与保存 Annotation Annotation ID t 的相机姿态进行匹配,将这些注释在3D中 正确显示。一旦显示了新的注释,服务器 将其渲染到视频流帧中,并返送到客户端。 Laptop Remote Expert Fig.1.Remote Support System Architecture Overview

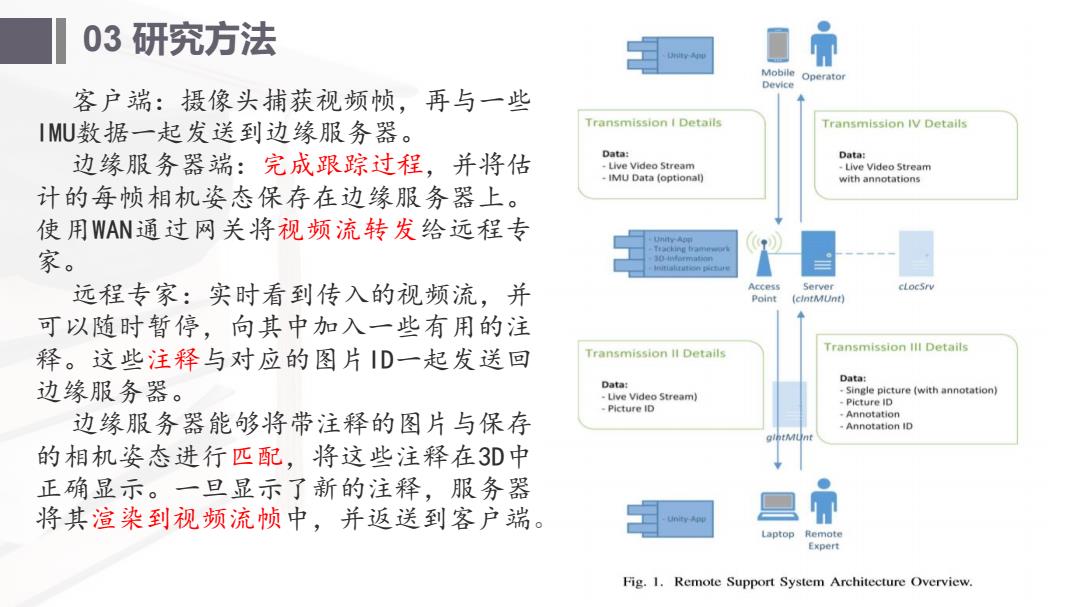

03 研究方法 客户端:摄像头捕获视频帧,再与一些 IMU数据一起发送到边缘服务器。 边缘服务器端:完成跟踪过程,并将估 计的每帧相机姿态保存在边缘服务器上。 使用WAN通过网关将视频流转发给远程专 家。 远程专家:实时看到传入的视频流,并 可以随时暂停,向其中加入一些有用的注 释。这些注释与对应的图片ID一起发送回 边缘服务器。 边缘服务器能够将带注释的图片与保存 的相机姿态进行匹配,将这些注释在3D中 正确显示。一旦显示了新的注释,服务器 将其渲染到视频流帧中,并返送到客户端

03研究方法 Real-time Client Device Video frame is IMU data are Display AR video 颅间跟踪方法:提出了基于带有惯 grabbed gathered frame 性测量值的EKF的视觉-惯性融合跟踪 方法。跟踪过程概述如下: Data are sent to the Send AR video frame edge serve时 to elient 1.使用惯性测量值的EKF的预测步骤, Edge Server Initialation done? 渲染要跟踪的视觉特征的外观。 西 Get localization data 2.由于预测的特征要与当前视频帧中 from location server Tracking Render 的可见特征相匹配,只需要在每个预 Pose estimation with Save estimated sensor fusion camera pose ¥4de0rann 测特征位置的附近进行快速搜索。 Register annotation n30 3.图像中匹配出的2D特征位置及其已 知3D位置一起用于EKF的校正步骤,然 Send video frame to Send annotations to remote expert edge server Remote Device 后从滤波器状态读取当前姿态。 Pause video Fig.2.Remote Live Support activity diagram

03 研究方法 帧间跟踪方法:提出了基于带有惯 性测量值的EKF的视觉-惯性融合跟踪 方法。跟踪过程概述如下: 1.使用惯性测量值的EKF的预测步骤, 渲 染 要 跟 踪 的 视 觉 特 征 的 外 观 。 2.由于预测的特征要与当前视频帧中 的可见特征相匹配,只需要在每个预 测特征位置的附近进行快速搜索。 3.图像中匹配出的2D特征位置及其已 知3D位置一起用于EKF的校正步骤,然 后从滤波器状态读取当前姿态

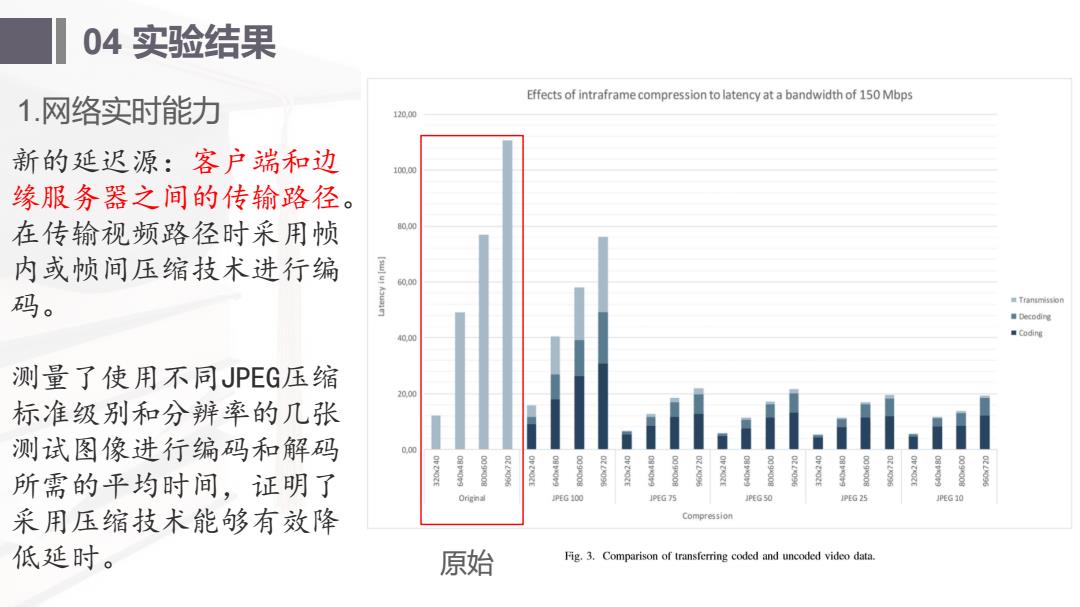

04实验结果 1.网络实时能力 Effects of intraframe compression to latency at a bandwidth of 150 Mbps 120.00 新的延迟源:客户端和边 10000 缘服务器之间的传输路径。 在传输视频路径时采用顿 80,0 内或帧间压缩技术进行编 60.00 码。 量Transmission ■Decoding 40.00 ■Coding 测量了使用不同JPEG压缩 20.00 标准级别和分辨率的几张 . 测试图像进行编码和解码 0.00 所需的平均时间,证明了 PEG 100 IPEG 75 PG25 JPEG 10 采用压缩技术能够有效降 Compression 低延时。 原始 Fig.3.Comparison of transferring coded and uncoded video data

04 实验结果 新的延迟源:客户端和边 缘服务器之间的传输路径。 在传输视频路径时采用帧 内或帧间压缩技术进行编 码。 测量了使用不同JPEG压缩 标准级别和分辨率的几张 测试图像进行编码和解码 所需的平均时间,证明了 采用压缩技术能够有效降 低延时。 1.网络实时能力 原始

04实验结果 2.相机跟踪 在一个室内环境中进行了实 验,该环境具有墙壁的3D模型以 及已注册的ORB特征(用于初始化) 和KLT特征(用于跟踪)。 EKF用于将uEye摄像机的视觉 特征匹配与XSens IMU的同步惯性 测量结果融合在一起。相机提供 的图像分辨率为752×480像素, 使用的CPU是Intel Xeon3.07GHz, Live view 12GB RAM. Fig.4.Camera view from the tracking experiment with 3D augmentations

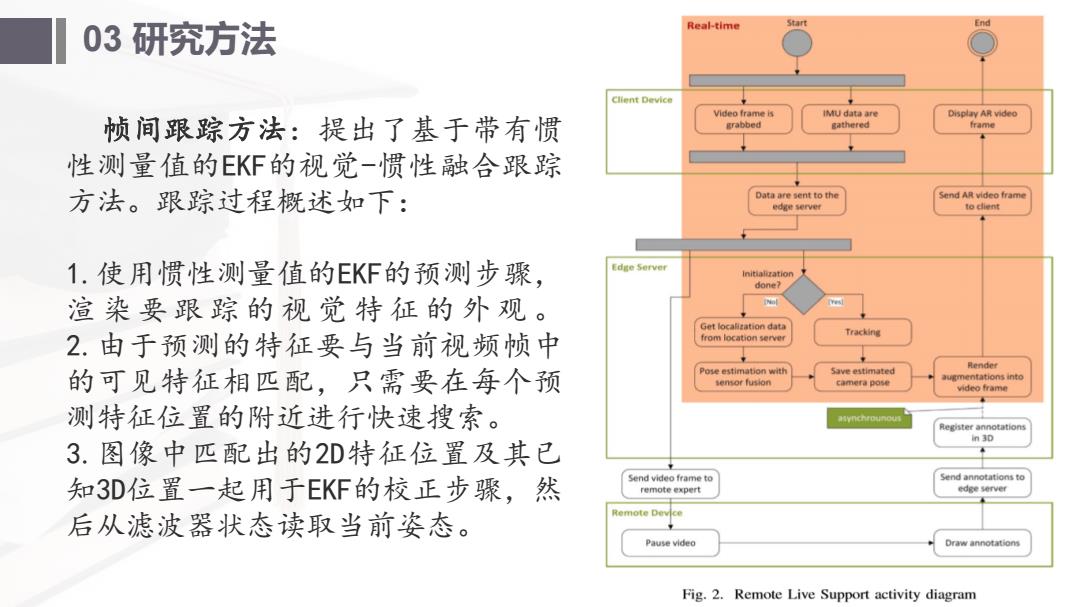

04 实验结果 在一个室内环境中进行了实 验,该环境具有墙壁的3D模型以 及已注册的ORB特征(用于初始化) 和KLT特征(用于跟踪)。 EKF用于将uEye摄像机的视觉 特征匹配与XSens IMU的同步惯性 测量结果融合在一起。相机提供 的图像分辨率为752×480像素, 使用的CPU是Intel Xeon 3.07GHz, 12GB RAM。 2.相机跟踪

04实验结果 2.相机跟踪 10 9.75 9.32 所有服务器操作所需的总时 间总计为25.78ms,这导致使用 (S4 6.36 752×480的分辨率的单个帧的总 体端到端延迟约为50ms 5 (14.5ms+25.78ms+10.5ms)。 awn-un.I# 0.16 0.19 0 A B D E A:EKP Prediction B:Pred.Rendering C:Matching D:EKF Comrection E ugm.Rendering Fig.5.Runtime measurements of tracking algorithm

04 实验结果 所有服务器操作所需的总时 间总计为25.78ms,这导致使用 752×480的分辨率的单个帧的总 体端到端延迟约为50ms (14.5ms+25.78ms+10.5ms)。 2.相机跟踪