第8卷第5期 智能系统学报 VoL.8 No.5 2013年10月 CAAI Transactions on Intelligent Systems 0ct.2013 D0:10.3969/j.issn.1673-4785.201110007 网络出版地址:http://www.cnki.net/kcms/detail/23.1538.TP.20130929.1049.003.html 线性插值框架下矩阵步态识别的性能分析 贲晛烨,张鹏,潘婷婷,王科俊 (1.山东大学信息科学与工程学院,山东济南250100:2.哈尔滨工程大学自动化学院,黑龙江哈尔滨150001) 摘要:针对现有的步态周期检测方法检测效果不佳以及行走速度变化对步态识别性能有很大影响的问题,提出的 基于矩的步态周期检测方法中,Zernike矩需要人体居中、尺度归一的前期预处理过程,而伪Zernike矩具有能描述运 动图像的特点,它可以避免人体居中、尺度归一等处理,以便直接测试步态的周期性.根据行走时的两帧之间的特征 取决于前一帧和后一帧的特征,提出了基于线性插值的矩阵步态识别算法框架,并且将投影特征、Hough变换特征、 Trace变换特征和Fan-Beam映射特征应用在CASIA(B)步态库上,验证了框架的有效性,为解决步态识别问题带来 新的方法与思路这种基于线性插值的矩阵步态识别特征本质上是一种权值不同的能量形式. 关键词:步态识别:矩阵步态识别:线性插值框架;步态周期检测;Zernike矩;伪Zernike矩 中图分类号:TP391.41文献标志码:A文章编号:1673-4785(2013)05-0415-11 中文引用格式:贲晛烨,张鹏,潘婷婷,等.线性插值框架下矩阵步态识别的性能分析[J】.智能系统学报,2013,8(5):415425. 英文引用格式:BEN Xianye,ZHANG Peng,PAN Tingting,etal.Performance analysis of matrix gait recognition under linear in- terpolation framework[J].CAAI Transactions on Intelligent Systems,2013,8(5):415-425. Performance analysis of matrix gait recognition under linear interpolation framework BEN Xianye',ZHANG Peng',PAN Tingting',WANG Kejun2 (1.School of Information Science and Engineering,Shandong University,Ji'nan 250100,China;2.College of Automation,Harbin Engineering University,Harbin 150001,China) Abstract:The existing gait period detection methods are not ideal and the performance of gait recognition is signifi- cantly influenced by walking speed.Several novel gait period detection methods based on moments are proposed in this paper.The Zernike moment requires preprocessing including the assurance that the image of the human body is proportioned normally and is centered properly;the pseudo-Zernike moment may directly describe the motion im- age,and it may avoid the need for such processing of making the image of the human body centered and sized nor- mally,so as to directly detect gait periodicity.As the features of one frame are only decided by those of the prior and the rear frames in walking,a framework for a matrix gait recognition algorithm based on linear interpolation is proposed.Subsequently,the projection features,Hough transform feature,Trace transform feature and Fan-Beam mapping feature are applied to the CASIA(B)gait database to prove the validity of the gait recognition framework. This brings new methods and understanding for solving gait recognition problems.This matrix gait recognition feature based on linear interpolation is essentially an energy form with different weighted values. Keywords:gait recognition;matrix gait recognition;linear interpolation framework;gait period detection;Zernike moment;pseudo-Zernike moment 步态识别是在人没有觉察的远距离情况下,通 特征具有稳定性、普遍性、可采集性和惟一性,因此 过捕捉动态与静态信息来进行身份识别.由于步态 可用于不同场合下的身份识别与认证).Nixon等] 收稿日期:2011-10-19.网络出版日期:2013-09-29 总结了南安普敦大学2002年之前研发的步态识别 基金项目:国家自然科学基金资助项目(61201370):高等学校博士学 技术,同时预言了步态应用于生物特征识别的潜能, 科点专项科研基金资助项目(20120131120030):中国博土 后科学基金面上项目(2013M530321):山东省博土后创新 2005年,Boulgouris等I)首先将步态识别与其他生 项目专项资金项目(201303100):山东大学自主创新基金 物特征识别做了比较,提出步态识别可以作为多生 资助项目(2012GN043,2012DX007). 通信作者:贲現烨.E-mail:benxianyeye@l63.com 物特征识别技术的一部分,接着给出了步态识别系

第 8 卷第 5 期 智 能 系 统 学 报 Vol.8 №.5 2013 年 10 月 CAAI Transactions on Intelligent Systems Oct. 2013 DOI:10.3969 / j.issn.1673 ̄4785.201110007 网络出版地址:http: / / www.cnki.net / kcms/ detail / 23.1538.TP.20130929.1049.003.html 线性插值框架下矩阵步态识别的性能分析 贲晛烨1 ꎬ张鹏1 ꎬ潘婷婷1 ꎬ王科俊2 (1.山东大学 信息科学与工程学院ꎬ山东 济南 250100ꎻ 2.哈尔滨工程大学 自动化学院ꎬ黑龙江 哈尔滨 150001) 摘 要:针对现有的步态周期检测方法检测效果不佳以及行走速度变化对步态识别性能有很大影响的问题ꎬ提出的 基于矩的步态周期检测方法中ꎬZernike 矩需要人体居中、尺度归一的前期预处理过程ꎬ而伪 Zernike 矩具有能描述运 动图像的特点ꎬ它可以避免人体居中、尺度归一等处理ꎬ以便直接测试步态的周期性.根据行走时的两帧之间的特征 取决于前一帧和后一帧的特征ꎬ提出了基于线性插值的矩阵步态识别算法框架ꎬ并且将投影特征、Hough 变换特征、 Trace 变换特征和 Fan ̄Beam 映射特征应用在 CASIA(B)步态库上ꎬ验证了框架的有效性ꎬ为解决步态识别问题带来 新的方法与思路.这种基于线性插值的矩阵步态识别特征本质上是一种权值不同的能量形式. 关键词:步态识别ꎻ矩阵步态识别ꎻ线性插值框架ꎻ步态周期检测ꎻZernike 矩ꎻ伪 Zernike 矩 中图分类号:TP391.41 文献标志码:A 文章编号:1673 ̄4785(2013)05 ̄0415 ̄11 中文引用格式:贲晛烨ꎬ张鹏ꎬ潘婷婷ꎬ等.线性插值框架下矩阵步态识别的性能分析[J]. 智能系统学报ꎬ 2013ꎬ 8(5): 415 ̄425. 英文引用格式:BEN Xianyeꎬ ZHANG Pengꎬ PAN Tingtingꎬ et al. Performance analysis of matrix gait recognition under linear in ̄ terpolation framework[J]. CAAI Transactions on Intelligent Systemsꎬ 2013ꎬ 8(5): 415 ̄425. Performance analysis of matrix gait recognition under linear interpolation framework BEN Xianye 1 ꎬ ZHANG Peng 1 ꎬ PAN Tingting 1 ꎬ WANG Kejun 2 (1. School of Information Science and Engineeringꎬ Shandong Universityꎬ Ji’ nan 250100ꎬ Chinaꎻ 2. College of Automationꎬ Harbin Engineering Universityꎬ Harbin 150001ꎬ China) Abstract:The existing gait period detection methods are not ideal and the performance of gait recognition is signifi ̄ cantly influenced by walking speed. Several novel gait period detection methods based on moments are proposed in this paper. The Zernike moment requires preprocessing including the assurance that the image of the human body is proportioned normally and is centered properlyꎻ the pseudo ̄Zernike moment may directly describe the motion im ̄ ageꎬ and it may avoid the need for such processing of making the image of the human body centered and sized nor ̄ mallyꎬ so as to directly detect gait periodicity. As the features of one frame are only decided by those of the prior and the rear frames in walkingꎬ a framework for a matrix gait recognition algorithm based on linear interpolation is proposed. Subsequentlyꎬ the projection featuresꎬ Hough transform featureꎬ Trace transform feature and Fan ̄Beam mapping feature are applied to the CASIA(B) gait database to prove the validity of the gait recognition framework. This brings new methods and understanding for solving gait recognition problems. This matrix gait recognition feature based on linear interpolation is essentially an energy form with different weighted values. Keywords:gait recognitionꎻ matrix gait recognitionꎻ linear interpolation frameworkꎻ gait period detectionꎻ Zernike momentꎻ pseudo ̄Zernike moment 收稿日期:2011 ̄10 ̄19. 网络出版日期:2013 ̄09 ̄29. 基金项目:国家自然科学基金资助项目(61201370)ꎻ高等学校博士学 科点专项科研基金资助项目(20120131120030)ꎻ中国博士 后科学基金面上项目(2013M530321)ꎻ山东省博士后创新 项目专项资金项目( 201303100)ꎻ山东大学自主创新基金 资助项目(2012GN043ꎬ2012DX007). 通信作者:贲晛烨. E ̄mail: benxianyeye@ 163.com. 步态识别是在人没有觉察的远距离情况下ꎬ通 过捕捉动态与静态信息来进行身份识别.由于步态 特征具有稳定性、普遍性、可采集性和惟一性ꎬ因此 可用于不同场合下的身份识别与认证[1] .Nixon 等[2] 总结了南安普敦大学 2002 年之前研发的步态识别 技术ꎬ同时预言了步态应用于生物特征识别的潜能. 2005 年ꎬBoulgouris 等[3] 首先将步态识别与其他生 物特征识别做了比较ꎬ提出步态识别可以作为多生 物特征识别技术的一部分ꎬ接着给出了步态识别系

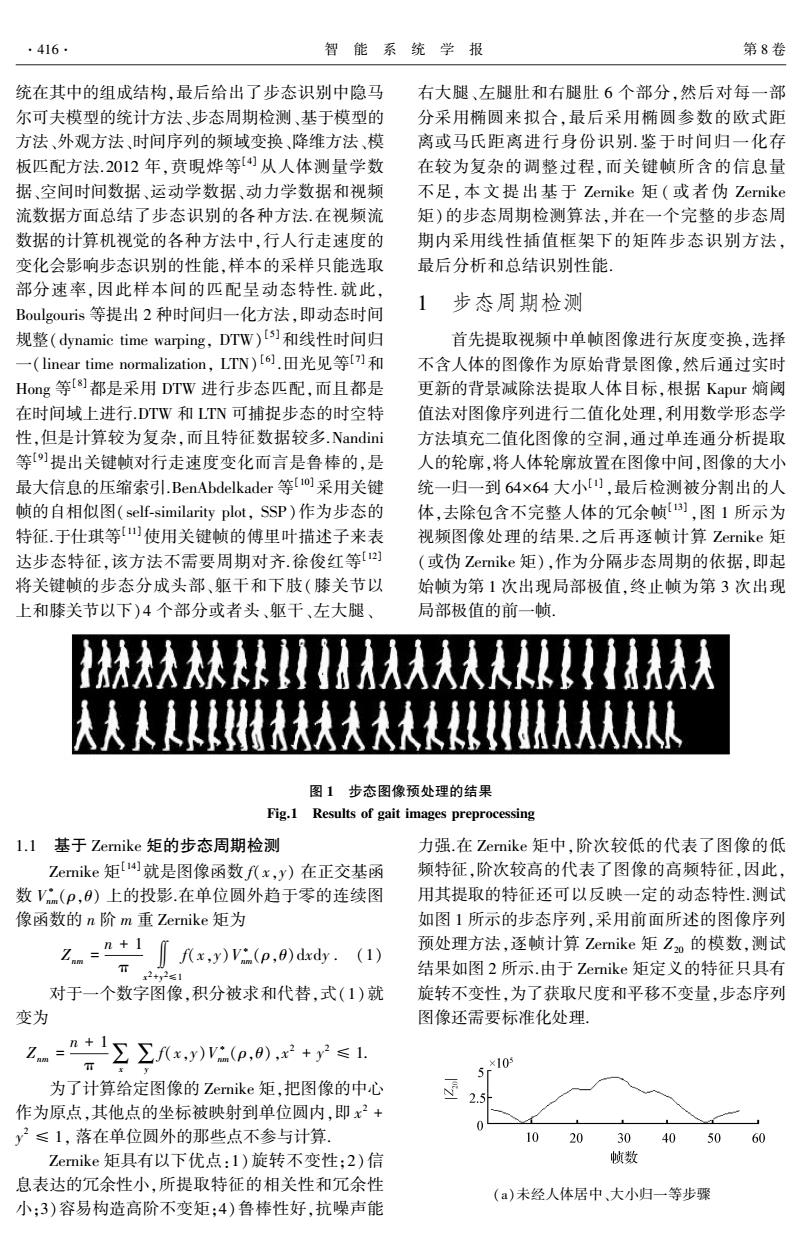

416 智能系统学报 第8卷 统在其中的组成结构,最后给出了步态识别中隐马 右大腿、左腿肚和右腿肚6个部分,然后对每一部 尔可夫模型的统计方法、步态周期检测、基于模型的 分采用椭圆来拟合,最后采用椭圆参数的欧式距 方法、外观方法、时间序列的频域变换、降维方法、模 离或马氏距离进行身份识别.鉴于时间归一化存 板匹配方法.2012年,贲現烨等从人体测量学数 在较为复杂的调整过程,而关键帧所含的信息量 据、空间时间数据、运动学数据、动力学数据和视频 不足,本文提出基于Zernike矩(或者伪Zernike 流数据方面总结了步态识别的各种方法.在视频流 矩)的步态周期检测算法,并在一个完整的步态周 数据的计算机视觉的各种方法中,行人行走速度的 期内采用线性插值框架下的矩阵步态识别方法, 变化会影响步态识别的性能,样本的采样只能选取 最后分析和总结识别性能, 部分速率,因此样本间的匹配呈动态特性.就此, 1 Boulgouris等提出2种时间归一化方法,即动态时间 步态周期检测 规整(dynamic time warping,DTW))和线性时间归 首先提取视频中单帧图像进行灰度变换,选择 一(linear time normalization,LTN)[6.田光见等f]和 不含人体的图像作为原始背景图像,然后通过实时 Hog等[8)都是采用DTW进行步态匹配,而且都是 更新的背景减除法提取人体目标,根据Kapur嫡阈 在时间域上进行.DTW和LTN可捕捉步态的时空特 值法对图像序列进行二值化处理,利用数学形态学 性,但是计算较为复杂,而且特征数据较多.Nandini 方法填充二值化图像的空洞,通过单连通分析提取 等)提出关键帧对行走速度变化而言是鲁棒的,是 人的轮廓,将人体轮廓放置在图像中间,图像的大小 最大信息的压缩索引.BenAbdelkader等[o]采用关键 统一归一到64×64大小),最后检测被分割出的人 帧的自相似图(self-similarity plot,SSP)作为步态的 体,去除包含不完整人体的冗余帧),图1所示为 特征于仕琪等)使用关键帧的傅里叶描述子来表 视频图像处理的结果.之后再逐帧计算Zernike矩 达步态特征,该方法不需要周期对齐.徐俊红等[] (或伪Zernike矩),作为分隔步态周期的依据,即起 将关键帧的步态分成头部、躯干和下肢(膝关节以 始帧为第1次出现局部极值,终止帧为第3次出现 上和膝关节以下)4个部分或者头、躯干、左大腿、 局部极值的前一帧。 图1步态图像预处理的结果 Fig.1 Results of gait images preprocessing l.l基于Zernike矩的步态周期检测 力强.在Zernike矩中,阶次较低的代表了图像的低 Zernike矩就是图像函数f(x,y)在正交基函 频特征,阶次较高的代表了图像的高频特征,因此, 数Vm(P,9)上的投影.在单位圆外趋于零的连续图 用其提取的特征还可以反映一定的动态特性.测试 像函数的n阶m重Zernike矩为 如图1所示的步态序列,采用前面所述的图像序列 2n=+1 ∬fx,y)Va(p,)dxdy.(1) 预处理方法,逐帧计算Zernike矩Zo的模数,测试 下2+3261 结果如图2所示.由于Zernike矩定义的特征只具有 对于一个数字图像,积分被求和代替,式(1)就 旋转不变性,为了获取尺度和平移不变量,步态序列 变为 图像还需要标准化处理, 名=”告Σ,.0+≤1 ×10 为了计算给定图像的Zernike矩,把图像的中心 作为原点,其他点的坐标被映射到单位圆内,即x2+ y2≤1,落在单位圆外的那些点不参与计算, 10 2030 40 50 60 Zernike矩具有以下优点:1)旋转不变性;2)信 帧数 息表达的冗余性小,所提取特征的相关性和冗余性 (a)未经人体居中、大小归一等步骤 小:3)容易构造高阶不变矩:4)鲁棒性好,抗噪声能

统在其中的组成结构ꎬ最后给出了步态识别中隐马 尔可夫模型的统计方法、步态周期检测、基于模型的 方法、外观方法、时间序列的频域变换、降维方法、模 板匹配方法.2012 年ꎬ贲晛烨等[4] 从人体测量学数 据、空间时间数据、运动学数据、动力学数据和视频 流数据方面总结了步态识别的各种方法.在视频流 数据的计算机视觉的各种方法中ꎬ行人行走速度的 变化会影响步态识别的性能ꎬ样本的采样只能选取 部分速率ꎬ因此样本间的匹配呈动态特性. 就此ꎬ Boulgouris 等提出 2 种时间归一化方法ꎬ即动态时间 规整(dynamic time warpingꎬ DTW) [5]和线性时间归 一(linear time normalizationꎬ LTN) [6] .田光见等[7]和 Hong 等[8]都是采用 DTW 进行步态匹配ꎬ而且都是 在时间域上进行.DTW 和 LTN 可捕捉步态的时空特 性ꎬ但是计算较为复杂ꎬ而且特征数据较多.Nandini 等[9]提出关键帧对行走速度变化而言是鲁棒的ꎬ是 最大信息的压缩索引.BenAbdelkader 等[10]采用关键 帧的自相似图(self ̄similarity plotꎬ SSP)作为步态的 特征.于仕琪等[11]使用关键帧的傅里叶描述子来表 达步态特征ꎬ该方法不需要周期对齐.徐俊红等[12] 将关键帧的步态分成头部、躯干和下肢(膝关节以 上和膝关节以下)4 个部分或者头、躯干、左大腿、 右大腿、左腿肚和右腿肚 6 个部分ꎬ然后对每一部 分采用椭圆来拟合ꎬ最后采用椭圆参数的欧式距 离或马氏距离进行身份识别.鉴于时间归一化存 在较为复杂的调整过程ꎬ而关键帧所含的信息量 不足ꎬ 本 文 提 出 基 于 Zernike 矩 ( 或 者 伪 Zernike 矩)的步态周期检测算法ꎬ并在一个完整的步态周 期内采用线性插值框架下的矩阵步态识别方法ꎬ 最后分析和总结识别性能. 1 步态周期检测 首先提取视频中单帧图像进行灰度变换ꎬ选择 不含人体的图像作为原始背景图像ꎬ然后通过实时 更新的背景减除法提取人体目标ꎬ根据 Kapur 熵阈 值法对图像序列进行二值化处理ꎬ利用数学形态学 方法填充二值化图像的空洞ꎬ通过单连通分析提取 人的轮廓ꎬ将人体轮廓放置在图像中间ꎬ图像的大小 统一归一到 64×64 大小[1] ꎬ最后检测被分割出的人 体ꎬ去除包含不完整人体的冗余帧[13] ꎬ图 1 所示为 视频图像处理的结果.之后再逐帧计算 Zernike 矩 (或伪 Zernike 矩)ꎬ作为分隔步态周期的依据ꎬ即起 始帧为第 1 次出现局部极值ꎬ终止帧为第 3 次出现 局部极值的前一帧. 图 1 步态图像预处理的结果 Fig.1 Results of gait images preprocessing 1.1 基于 Zernike 矩的步态周期检测 Zernike 矩[14]就是图像函数 f(xꎬy) 在正交基函 数 V ∗ nm(ρꎬθ) 上的投影.在单位圆外趋于零的连续图 像函数的 n 阶 m 重 Zernike 矩为 Znm = n + 1 π ∬ x 2+y 2≤1 f(xꎬy)V ∗ nm(ρꎬθ)dxdy . (1) 对于一个数字图像ꎬ积分被求和代替ꎬ式(1)就 变为 Znm = n + 1 π ∑x ∑y f(xꎬy)V ∗ nm(ρꎬθ)ꎬx 2 + y 2 ≤ 1. 为了计算给定图像的 Zernike 矩ꎬ把图像的中心 作为原点ꎬ其他点的坐标被映射到单位圆内ꎬ即 x 2 + y 2 ≤ 1ꎬ 落在单位圆外的那些点不参与计算. Zernike 矩具有以下优点:1)旋转不变性ꎻ2)信 息表达的冗余性小ꎬ所提取特征的相关性和冗余性 小ꎻ3)容易构造高阶不变矩ꎻ4)鲁棒性好ꎬ抗噪声能 力强.在 Zernike 矩中ꎬ阶次较低的代表了图像的低 频特征ꎬ阶次较高的代表了图像的高频特征ꎬ因此ꎬ 用其提取的特征还可以反映一定的动态特性.测试 如图 1 所示的步态序列ꎬ采用前面所述的图像序列 预处理方法ꎬ逐帧计算 Zernike 矩 Z20 的模数ꎬ测试 结果如图 2 所示.由于 Zernike 矩定义的特征只具有 旋转不变性ꎬ为了获取尺度和平移不变量ꎬ步态序列 图像还需要标准化处理. (a)未经人体居中、大小归一等步骤 416 智 能 系 统 学 报 第 8 卷

第5期 贲硯烨,等:线性插值框架下矩阵步态识别的性能分析 ·417- ×10 10 10 10203040 5060 帧数 10 2030 40 5060 帧数 (b)经人体居中、大小归一等步骤 图2使用Z如的模数的检测效果 (a)未经人体居中、大小归一等步骤 Fig.2 Detection results using the modulus of Zernike moment Z2o ×10 10 1.2基于伪Zernike矩的步态周期检测 伪Zernike矩[s]的离散化公式为 20 3040 5060 帧数 三三R_pep(-jm,Nx,以 (b)经人体居中、大小归一等步骤 图3使用Z。的模数的检测效果 式中:p=√x2+y2表示极距,0表示极角,fx, Fig.3 Detection results using the modulus of pseudo- Zernike moment Zo y)(-1≤x≤1,-1≤y≤1)表示以坐标原点为 圆心的单位圆的灰度图像, ×103 2.5 Rm(p)= 2.0 n-1ml (2n+1-s)! (a!(-m!(m1! 1.0 0.5 p-6±VB-4c 10 2030 4050 60 2a 帧数 伪Zernike矩的优点如下:l)旋转不变性;2)鲁 棒性好,即对形状的微小改变和噪声具有鲁棒性,同 图4使用Z的模数的检测效果 Zernike矩相比,在相同阶的情况下,伪Zernike矩具 Fig.4 Detection results using the modulus of pseudo- Zernike moment Z 有更多的低阶矩,低阶矩越多,抗噪声的能力就越 强,例如当阶为5时,伪Zernike矩有21个矩,而 2 线性插值的矩阵步态识别算法框架 Zernike矩只有12个矩;3)信息表达的冗余性小:4) 信息表达的高效性,一幅图像可以用很少的伪 根据人行走时2帧之间的特征决定于前一帧和 后一帧的特征,采用牛顿线性插值法将离散的步态 Zernike矩集合很好地表示,且具有较小的均方误 序列模拟成近似连续步态,为实现识别阶段快速的 差;5)多层次表达,相关的一组伪Zernike矩的小集 匹配,通过构造特征模板将一个周期的步态序列图 合就可以有效地表示一个模式的全部形状,其中低 像表征为矩阵.牛顿线性插值法可表达成两点式,即 阶矩描述的是一个模式的整体形状,而高阶矩描述 的是模式的细节:6)能描述运动图像,可用于运动 g(x)=f(xo)- +)二和 0-x1 x1-x0 图像序列分析. 式中:(xof(xo)与(x1f(x1)表示直线上的2 仍然测试如图1所示的步态序列,采用前述图 个点 像序列预处理方法,逐帧计算伪Zernike矩Z。的模 令f。表示第n幅步态单帧图像,F。是此图像对 数,测试结果如图3所示.利用伪Zernike矩的优点 应的特征,即t时刻恰好对应第n幅步态图像: 6),在前述预处理的标准中心化之前逐帧计算伪 F(t)=F,t=n. 通过牛顿线性插值构造出第n帧和第n+1帧 Zernike矩Z的模数,测试结果如图4所示. 之间的特征为

(b)经人体居中、大小归一等步骤 图 2 使用 Z20 的模数的检测效果 Fig. 2 Detection results using the modulus of Zernike moment Z20 1.2 基于伪 Zernike 矩的步态周期检测 伪 Zernike 矩[ 15 ]的离散化公式为 Z p nm = n + 1 π ∑ 1 x = -1∑ 1 y = -1 Rnm(ρ)exp( - jmθxy)f(xꎬy). 式中: ρ = x 2 + y 2 表示极距ꎬ θxy 表示极角ꎬ f(xꎬ y)( - 1 ≤ x ≤ 1ꎬ - 1 ≤ y ≤ 1) 表示以坐标原点为 圆心的单位圆的灰度图像ꎬ Rnm(ρ) = ∑ n-| m | s = 0 (( - 1) s (2n + 1 - s)! s! (n - m - s)! (n + m + 1 - s)! × ρ n-s - b ± b 2 - 4ac 2a ). 伪 Zernike 矩的优点如下:1)旋转不变性ꎻ2)鲁 棒性好ꎬ即对形状的微小改变和噪声具有鲁棒性ꎬ同 Zernike 矩相比ꎬ在相同阶的情况下ꎬ伪 Zernike 矩具 有更多的低阶矩ꎬ低阶矩越多ꎬ抗噪声的能力就越 强ꎬ例如当阶为 5 时ꎬ伪 Zernike 矩有 21 个矩ꎬ而 Zernike 矩只有 12 个矩ꎻ3)信息表达的冗余性小ꎻ4) 信息表 达 的 高 效 性ꎬ 一 幅 图 像 可 以 用 很 少 的 伪 Zernike 矩集合很好地表示ꎬ且具有较小的均方误 差ꎻ5)多层次表达ꎬ相关的一组伪 Zernike 矩的小集 合就可以有效地表示一个模式的全部形状ꎬ其中低 阶矩描述的是一个模式的整体形状ꎬ而高阶矩描述 的是模式的细节ꎻ6) 能描述运动图像ꎬ可用于运动 图像序列分析. 仍然测试如图 1 所示的步态序列ꎬ采用前述图 像序列预处理方法ꎬ逐帧计算伪 Zernike 矩 Z p 10 的模 数ꎬ测试结果如图 3 所示.利用伪 Zernike 矩的优点 6)ꎬ在前述预处理的标准中心化之前逐帧计算伪 Zernike 矩 Z p 53 的模数ꎬ测试结果如图 4 所示. (a)未经人体居中、大小归一等步骤 (b)经人体居中、大小归一等步骤 图 3 使用 Z p 10 的模数的检测效果 Fig.3 Detection results using the modulus of pseudo ̄ Zernike moment Z p 10 图 4 使用 Z p 53 的模数的检测效果 Fig.4 Detection results using the modulus of pseudo ̄ Zernike moment Z p 53 2 线性插值的矩阵步态识别算法框架 根据人行走时 2 帧之间的特征决定于前一帧和 后一帧的特征ꎬ采用牛顿线性插值法将离散的步态 序列模拟成近似连续步态ꎬ为实现识别阶段快速的 匹配ꎬ通过构造特征模板将一个周期的步态序列图 像表征为矩阵.牛顿线性插值法可表达成两点式ꎬ即 g(x) = f(x0 ) x - x1 x0 - x1 + f(x1 ) x - x0 x1 - x0 . 式中: (x0 ꎬf(x0 )) 与 (x1 ꎬf(x1 )) 表示直线上的 2 个点. 令 f n 表示第 n 幅步态单帧图像ꎬ Fn 是此图像对 应的特征ꎬ即 t 时刻恰好对应第 n 幅步态图像: F(t) = Fn ꎬ t = n. 通过牛顿线性插值构造出第 n 帧和第 n+1 帧 之间的特征为 第 5 期 贲晛烨ꎬ等:线性插值框架下矩阵步态识别的性能分析 417

.418 智能系统学报 第8卷 F(t)=(n+1-t)F.+(t-n)Fa1, 3 实例化 n<t<n+1. (2) 式中:F+1为第n+1帧步态图像的特征 本节分别用投影特征、Hough变换特征、Trace 通过对一个步态周期内的图像进行加权积分, 变换特征和Fan-Beam映射特征将F(t)进行实例 得到一个步态周期序列图像的特征: 化.投影特征在降维中使用经典主成分分析方法,其 他特征则采用广义主成分分析方法.实验环境为 G,=7F()0(o,)d (3) Pentium(R)Dual-Core CPU E5200@2.50GHz、 式中:T表示该周期序列的周期,心是频率,t为时 2.O0GB内存的PC机,研究对象为CASIA(B)库的 间,Q(w,t)为加权函数: 侧面视角(目标运动方向与摄像机的光轴方向垂 Q(w,t)=1 +j+cos(wt)+jsin(wt).(4) 直)的步态样本,每人正常行走状态下取6个样本, Q(0,t)既包括描述静态结构信息的特征(式 前3个样本用于训练,后3个样本用于测试,使用最 (4)中的前2项),又包括描述动态运动信息的特征 近邻(nearest neighbor,NN)分类器测试识别率来评 (式(4)中的后2项).关于心值的选择将在第3节 价各种特征的有效性[). 的实例中提到. 3.1投影特征 由式(2)~(4)的连续步态离散化得 由于投影特征简单、直观,可以看成是矩阵的一 1 A-1n+I 种特例.首先将F(t)实例化为投影特征,选取式(5) 之J(n+1-)F.+(t-n)F)× Cr= 中合适的心值.单帧步态图像的特征是投影角度为 (1 cos(wt)+j(1 sin(wt))dt.(5) 0°、45°、90°和135°的单一角度和组合角度的投影. 式(5)即是线性插值的矩阵步态识别算法框 表1给出了不同个体在各个角度下的投影特征 架,该框架实现简单,将特征F。(F+1)进行实例化 用欧氏距离度量的相似度结果,其中0xy-z代表第 来实现新的步态识别算法, (10x+y)个人的第z段视频。 表1采用欧氏距离的相似度量 Table 1 Similarity measured by Euclidean distance 0° 45 90° 135 角度 个体 001-1 001-2 020-1 001-1 001-2 020-1 001-1 001-2 020-1 001-1 001-2 020-1 001-1 24 39 245 244 241 292 297 295 226 231 238 0° 001-2 24 0 26 244 242 240 287 292 290 224 230 236 020-1 39 26 235 231 275 281 277 218 223 228 001-1 245 244 237 26 115 115 117 44 40 40 45° 001-2 244 242 235 117 117 119 45 42 41 020-1 241 240 2 52 47 39 001-1 292 287 275 115 23 123 116 111 90° 001-2 297 292 28 11 117 11 21 124 117 111 020-1 295 290 2 127 120 112 001-1 226 224 218 45 52 123 124 127 17 27 1359 001-2 231 230 223 40 42 47 116 117 120 17 0 25 020-1 238 236 228 40 41 39 111 111 112 27 25 0 从表1中得出:特定角度的特征只与其相同 n(1≤n≤16,n∈N),分别测试在单一角度和组 的测试角度的特征具有很高的相似性,而与其他 合角度下的识别率,结果如图5所示.可以看出:当 角度的投影特征相差很大,同一角度不同人的特 n=5,即0=5π/16T时,单一角度投影和组合角度 征也具有很好的聚类性.改变频率o=nπ/16T的 投影都能得到最佳的识别率,且组合角度投影优于

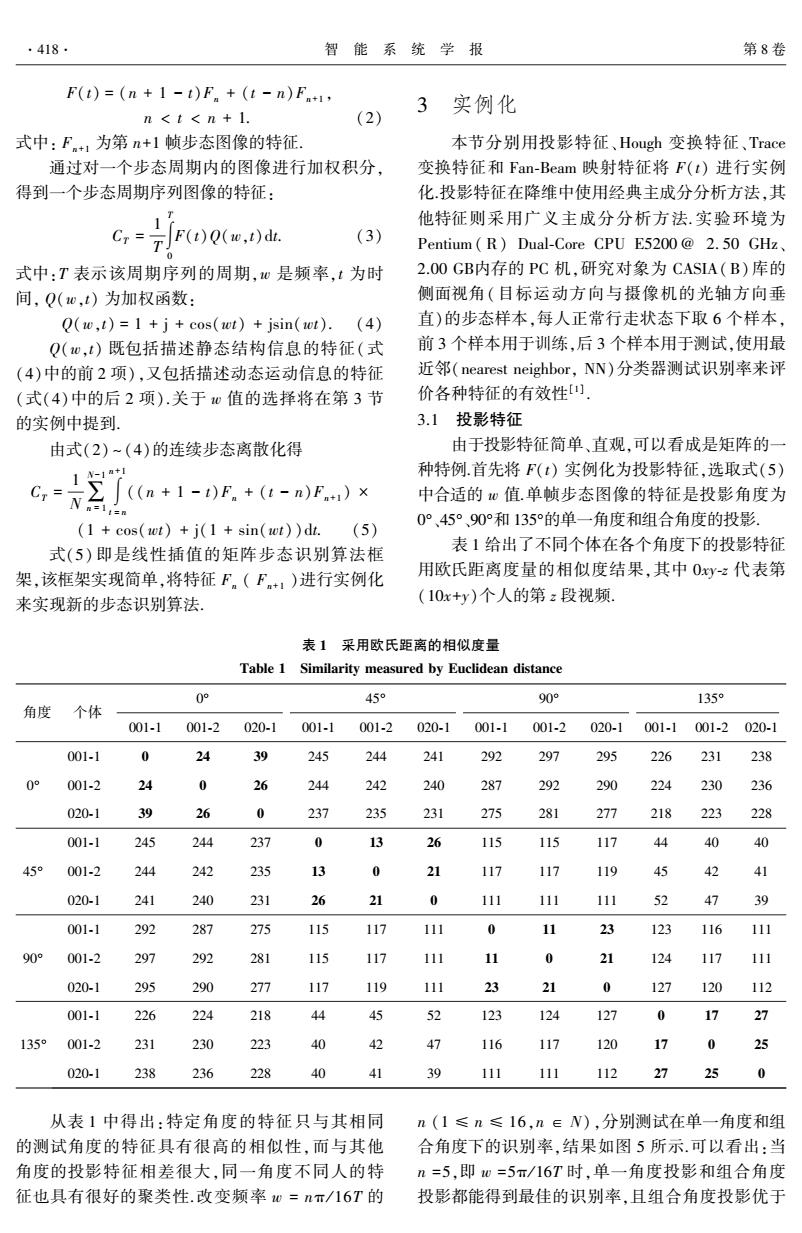

F(t) = (n + 1 - t)Fn + (t - n)Fn+1 ꎬ n < t < n + 1. (2) 式中: Fn+1 为第 n+1 帧步态图像的特征. 通过对一个步态周期内的图像进行加权积分ꎬ 得到一个步态周期序列图像的特征: CT = 1 T ∫ T 0 F(t)Q(wꎬt)dt. (3) 式中:T 表示该周期序列的周期ꎬw 是频率ꎬt 为时 间ꎬ Q(wꎬt) 为加权函数: Q(wꎬt) = 1 + j + cos(wt) + jsin(wt). (4) Q(wꎬt) 既包括描述静态结构信息的特征(式 (4)中的前 2 项)ꎬ又包括描述动态运动信息的特征 (式(4)中的后 2 项).关于 w 值的选择将在第 3 节 的实例中提到. 由式(2) ~ (4)的连续步态离散化得 CT = 1 N∑ N-1 n = 1 ∫ n+1 t = n ((n + 1 - t)Fn + (t - n)Fn+1 ) × (1 + cos(wt) + j(1 + sin(wt))dt. (5) 式(5) 即是线性插值的矩阵步态识别算法框 架ꎬ该框架实现简单ꎬ将特征 Fn ( Fn+1 )进行实例化 来实现新的步态识别算法. 3 实例化 本节分别用投影特征、Hough 变换特征、Trace 变换特征和 Fan ̄Beam 映射特征将 F(t) 进行实例 化.投影特征在降维中使用经典主成分分析方法ꎬ其 他特征则采用广义主成分分析方法. 实验环境为 Pentium ( R) Dual ̄Core CPU E5200 @ 2. 50 GHz、 2.00 GB内存的 PC 机ꎬ研究对象为 CASIA(B)库的 侧面视角(目标运动方向与摄像机的光轴方向垂 直)的步态样本ꎬ每人正常行走状态下取 6 个样本ꎬ 前 3 个样本用于训练ꎬ后 3 个样本用于测试ꎬ使用最 近邻(nearest neighborꎬ NN)分类器测试识别率来评 价各种特征的有效性[1] . 3.1 投影特征 由于投影特征简单、直观ꎬ可以看成是矩阵的一 种特例.首先将 F(t) 实例化为投影特征ꎬ选取式(5) 中合适的 w 值.单帧步态图像的特征是投影角度为 0°、45°、90°和 135°的单一角度和组合角度的投影. 表 1 给出了不同个体在各个角度下的投影特征 用欧氏距离度量的相似度结果ꎬ其中 0xy ̄z 代表第 (10x+y)个人的第 z 段视频. 表 1 采用欧氏距离的相似度量 Table 1 Similarity measured by Euclidean distance 角度 个体 0° 001 ̄1 001 ̄2 020 ̄1 45° 001 ̄1 001 ̄2 020 ̄1 90° 001 ̄1 001 ̄2 020 ̄1 135° 001 ̄1 001 ̄2 020 ̄1 0° 001 ̄1 0 24 39 245 244 241 292 297 295 226 231 238 001 ̄2 24 0 26 244 242 240 287 292 290 224 230 236 020 ̄1 39 26 0 237 235 231 275 281 277 218 223 228 45° 001 ̄1 245 244 237 0 13 26 115 115 117 44 40 40 001 ̄2 244 242 235 13 0 21 117 117 119 45 42 41 020 ̄1 241 240 231 26 21 0 111 111 111 52 47 39 90° 001 ̄1 292 287 275 115 117 111 0 11 23 123 116 111 001 ̄2 297 292 281 115 117 111 11 0 21 124 117 111 020 ̄1 295 290 277 117 119 111 23 21 0 127 120 112 135° 001 ̄1 226 224 218 44 45 52 123 124 127 0 17 27 001 ̄2 231 230 223 40 42 47 116 117 120 17 0 25 020 ̄1 238 236 228 40 41 39 111 111 112 27 25 0 从表 1 中得出:特定角度的特征只与其相同 的测试角度的特征具有很高的相似性ꎬ而与其他 角度的投影特征相差很大ꎬ同一角度不同人的特 征也具有很好的聚类性.改变频率 w = nπ / 16T 的 n (1 ≤ n ≤ 16ꎬn ∈ N) ꎬ分别测试在单一角度和组 合角度下的识别率ꎬ结果如图 5 所示.可以看出:当 n =5ꎬ即 w =5π/ 16T 时ꎬ单一角度投影和组合角度 投影都能得到最佳的识别率ꎬ且组合角度投影优于 418 智 能 系 统 学 报 第 8 卷

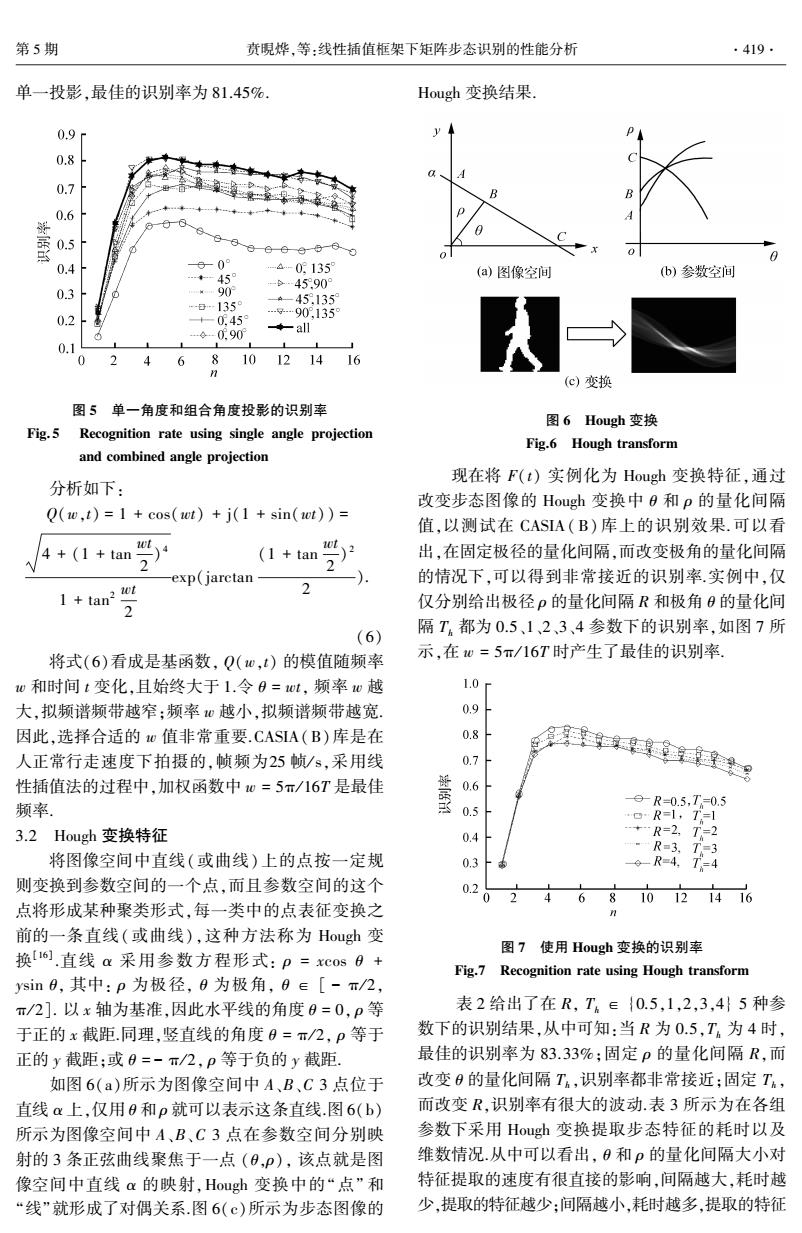

第5期 贲硯烨,等:线性插值框架下矩阵步态识别的性能分析 419. 单一投影,最佳的识别率为81.45%. Hough变换结果. 0.9r y 0.8 0.7 0.6 季 0.5 0 0.4 60° -4-0135 …◆-459 (a)图像空间 b)参数空间 -6-45909 0.3 -日…1359 445135 0.2 +-0.459 …g909,135 …g-0.90 ◆all 0.1 1 0 46810121416 (c)变换 图5单一角度和组合角度投影的识别率 图6 Hough变换 Fig.5 Recognition rate using single angle projection Fig.6 Hough transform and combined angle projection 现在将F(t)实例化为Hough变换特征,通过 分析如下: 改变步态图像的Hough变换中0和p的量化间隔 Q(w,t)=1 cos(wt)+j(1 sin(wt))= 值,以测试在CASIA(B)库上的识别效果.可以看 4+(1+tan2 1+am学 出,在固定极径的量化间隔,而改变极角的量化间隔 exp(jarctan 的情况下,可以得到非常接近的识别率.实例中,仅 1+tan? 2 仅分别给出极径p的量化间隔R和极角8的量化间 隔T都为0.5、1、2、3、4参数下的识别率,如图7所 (6) 将式(6)看成是基函数,Q(w,t)的模值随频率 示,在0=5π/16T时产生了最佳的识别率. w和时间t变化,且始终大于1.令0=wt,频率w越 1.0r 大,拟频谱频带越窄:频率心越小,拟频谱频带越宽. o 因此,选择合适的地值非常重要.CASIA(B)库是在 0.8 人正常行走速度下拍摄的,帧频为25帧/s,采用线 0.7 生痒g 性插值法的过程中,加权函数中0=5π/16T是最佳 薹 0.6 频率。 05 9R-0.5,T=0.5 oR=1,T=1 3.2 Hough变换特征 0.4 +R=2,T=2 R=3,T3 将图像空间中直线(或曲线)上的点按一定规 0.3 6-R=4,T4 则变换到参数空间的一个点,而且参数空间的这个 0.2 0 6 810121416 点将形成某种聚类形式,每一类中的点表征变换之 前的一条直线(或曲线),这种方法称为Hough变 换[16].直线a采用参数方程形式:p=xCos0+ 图7使用Hough变换的识别率 Fig.7 Recognition rate using Hough transform ysin0,其中:p为极径,0为极角,0e[-π/2, π/2].以x轴为基准,因此水平线的角度0=0,p等 表2给出了在R,T∈{0.5,1,2,3,4}5种参 于正的x截距.同理,竖直线的角度0=π/2,p等于 数下的识别结果,从中可知:当R为0.5,T。为4时, 正的y截距;或0=-π/2,p等于负的y截距. 最佳的识别率为83.33%;固定p的量化间隔R,而 如图6(a)所示为图像空间中A、B、C3点位于 改变0的量化间隔T,识别率都非常接近;固定T, 直线α上,仅用0和p就可以表示这条直线.图6(b) 而改变R,识别率有很大的波动.表3所示为在各组 所示为图像空间中A、B、C3点在参数空间分别映 参数下采用Hough变换提取步态特征的耗时以及 射的3条正弦曲线聚焦于一点(0,P),该点就是图 维数情况.从中可以看出,0和p的量化间隔大小对 像空间中直线α的映射,Hough变换中的“点”和 特征提取的速度有很直接的影响,间隔越大,耗时越 “线”就形成了对偶关系.图6(©)所示为步态图像的 少,提取的特征越少:间隔越小,耗时越多,提取的特征

单一投影ꎬ最佳的识别率为 81.45%. 图 5 单一角度和组合角度投影的识别率 Fig. 5 Recognition rate using single angle projection and combined angle projection 分析如下: Q(wꎬt) = 1 + cos(wt) + j(1 + sin(wt)) = 4 + (1 + tan wt 2 ) 4 1 + tan 2 wt 2 exp(jarctan (1 + tan wt 2 ) 2 2 ). (6) 将式(6)看成是基函数ꎬ Q(wꎬt) 的模值随频率 w 和时间 t 变化ꎬ且始终大于 1.令 θ = wtꎬ 频率 w 越 大ꎬ拟频谱频带越窄ꎻ频率 w 越小ꎬ拟频谱频带越宽. 因此ꎬ选择合适的 w 值非常重要.CASIA(B)库是在 人正常行走速度下拍摄的ꎬ帧频为25 帧/ sꎬ采用线 性插值法的过程中ꎬ加权函数中 w = 5π/ 16T 是最佳 频率. 3.2 Hough 变换特征 将图像空间中直线(或曲线) 上的点按一定规 则变换到参数空间的一个点ꎬ而且参数空间的这个 点将形成某种聚类形式ꎬ每一类中的点表征变换之 前的一条直线(或曲线)ꎬ这种方法称为 Hough 变 换[16] .直线 α 采用参数方程形式: ρ = xcos θ + ysin θꎬ 其中: ρ 为极径ꎬ θ 为极角ꎬ θ ∈ [ - π/ 2ꎬ π/ 2]. 以 x 轴为基准ꎬ因此水平线的角度 θ = 0ꎬ ρ 等 于正的 x 截距.同理ꎬ竖直线的角度 θ = π/ 2ꎬ ρ 等于 正的 y 截距ꎻ或 θ = - π/ 2ꎬ ρ 等于负的 y 截距. 如图 6(a)所示为图像空间中 A、B、C 3 点位于 直线 α 上ꎬ仅用 θ 和 ρ 就可以表示这条直线.图 6(b) 所示为图像空间中 A、B、C 3 点在参数空间分别映 射的 3 条正弦曲线聚焦于一点 (θꎬρ)ꎬ 该点就是图 像空间中直线 α 的映射ꎬHough 变换中的“点” 和 “线”就形成了对偶关系.图 6(c)所示为步态图像的 Hough 变换结果. 图 6 Hough 变换 Fig.6 Hough transform 现在将 F(t) 实例化为 Hough 变换特征ꎬ通过 改变步态图像的 Hough 变换中 θ 和 ρ 的量化间隔 值ꎬ以测试在 CASIA(B) 库上的识别效果. 可以看 出ꎬ在固定极径的量化间隔ꎬ而改变极角的量化间隔 的情况下ꎬ可以得到非常接近的识别率.实例中ꎬ仅 仅分别给出极径 ρ 的量化间隔 R 和极角 θ 的量化间 隔 Th 都为 0.5、1、2、3、4 参数下的识别率ꎬ如图 7 所 示ꎬ在 w = 5π/ 16T 时产生了最佳的识别率. 图 7 使用 Hough 变换的识别率 Fig.7 Recognition rate using Hough transform 表 2 给出了在 Rꎬ Th ∈ {0.5ꎬ1ꎬ2ꎬ3ꎬ4} 5 种参 数下的识别结果ꎬ从中可知:当 R 为 0.5ꎬTh 为 4 时ꎬ 最佳的识别率为 83.33%ꎻ固定 ρ 的量化间隔 Rꎬ而 改变 θ 的量化间隔 Th ꎬ识别率都非常接近ꎻ固定 Th ꎬ 而改变 Rꎬ识别率有很大的波动.表 3 所示为在各组 参数下采用 Hough 变换提取步态特征的耗时以及 维数情况.从中可以看出ꎬ θ 和 ρ 的量化间隔大小对 特征提取的速度有很直接的影响ꎬ间隔越大ꎬ耗时越 少ꎬ提取的特征越少ꎻ间隔越小ꎬ耗时越多ꎬ提取的特征 第 5 期 贲晛烨ꎬ等:线性插值框架下矩阵步态识别的性能分析 419

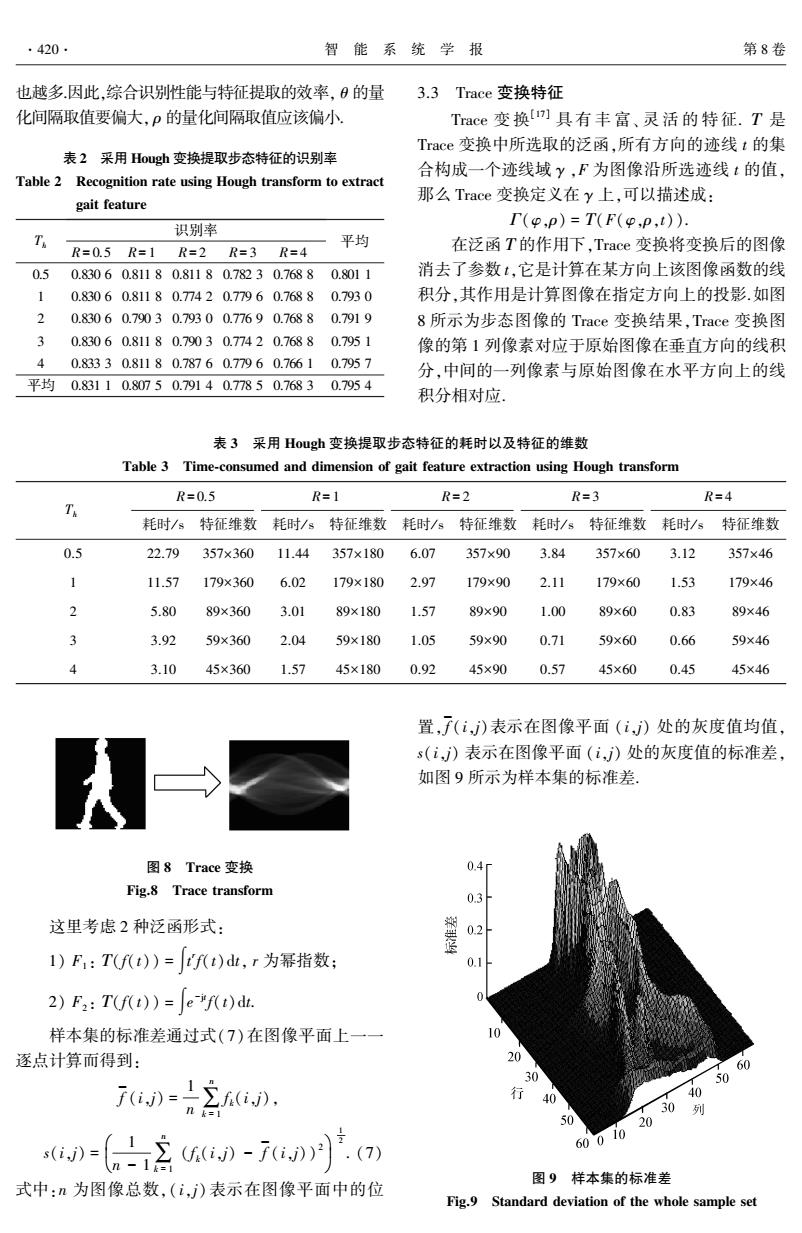

·420 智能系统学报 第8卷 也越多.因此,综合识别性能与特征提取的效率,日的量 3.3 Trace变换特征 化间隔取值要偏大,p的量化间隔取值应该偏小. Trace变换)具有丰富、灵活的特征.T是 Trace变换中所选取的泛函,所有方向的迹线t的集 表2采用Hough变换提取步态特征的识别率 合构成一个迹线域y,F为图像沿所选迹线t的值, Table 2 Recognition rate using Hough transform to extract 那么Trace变换定义在y上,可以描述成: gait feature 识别率 I(o,p)=T(F(o.p,t)). 平均 R=0.5R=1R=2R=3R=4 在泛函T的作用下,Trace变换将变换后的图像 0.5 0.83060.81180.81180.78230.76880.8011 消去了参数t,它是计算在某方向上该图像函数的线 1 0.83060.81180.7420.77960.76880.7930 积分,其作用是计算图像在指定方向上的投影.如图 0.83060.79030.79300.77690.76880.7919 8所示为步态图像的Trace变换结果,Trace变换图 0.83060.81180.79030.77420.76880.7951 像的第1列像素对应于原始图像在垂直方向的线积 A 0.83330.81180.78760.77960.76610.7957 分,中间的一列像素与原始图像在水平方向上的线 平均0.83110.80750.79140.77850.7683.0.7954 积分相对应 表3采用Hough变换提取步态特征的耗时以及特征的维数 Table 3 Time-consumed and dimension of gait feature extraction using Hough transform R=0.5 R=1 R=2 R=3 R=4 耗时/s特征维数 耗时/s特征维数 耗时/s特征维数 耗时/s特征维数 耗时/s 特征维数 0.5 22.79 357×360 11.44 357×180 6.07 357×90 3.84 357×60 3.12 357×46 1 11.57 179×360 6.02 179×180 2.97 179×90 2.11 179×60 1.53 179×46 2 5.80 89×360 3.01 89×180 1.57 89×90 1.00 89×60 0.83 89×46 3 3.92 59×360 2.04 59×180 1.05 59×90 0.71 59×60 0.66 59×46 3.10 45×360 1.57 45×180 0.92 45×90 0.57 45×60 0.45 45×46 置,(i,)表示在图像平面(i,》处的灰度值均值, s(i,)表示在图像平面(i,)处的灰度值的标准差, 如图9所示为样本集的标准差。 图8 Trace变换 0.4 Fig.8 Trace transform 0.3 这里考虑2种泛函形式: 1)F:Tf()=f(t)d山,r为幂指数; 0.1 2)F2:T(f(t))=e-"f(t)dt. 样本集的标准差通过式(7)在图像平面上一一 10 逐点计算而得到: 20 0 60 50 行 40 40 30 列 50 20 )-(2)-7°(a) 60010 图9样本集的标准差 式中:n为图像总数,(i,)表示在图像平面中的位 Fig.9 Standard deviation of the whole sample set

也越多.因此ꎬ综合识别性能与特征提取的效率ꎬ θ 的量 化间隔取值要偏大ꎬ ρ 的量化间隔取值应该偏小. 表 2 采用 Hough 变换提取步态特征的识别率 Table 2 Recognition rate using Hough transform to extract gait feature Th 识别率 R= 0.5 R= 1 R= 2 R= 3 R= 4 平均 0.5 0.830 6 0.811 8 0.811 8 0.782 3 0.768 8 0.801 1 1 0.830 6 0.811 8 0.774 2 0.779 6 0.768 8 0.793 0 2 0.830 6 0.790 3 0.793 0 0.776 9 0.768 8 0.791 9 3 0.830 6 0.811 8 0.790 3 0.774 2 0.768 8 0.795 1 4 0.833 3 0.811 8 0.787 6 0.779 6 0.766 1 0.795 7 平均 0.831 1 0.807 5 0.791 4 0.778 5 0.768 3 0.795 4 3.3 Trace 变换特征 Trace 变 换[17] 具 有 丰 富、 灵 活 的 特 征. Τ 是 Trace 变换中所选取的泛函ꎬ所有方向的迹线 t 的集 合构成一个迹线域 γ ꎬF 为图像沿所选迹线 t 的值ꎬ 那么 Trace 变换定义在 γ 上ꎬ可以描述成: Γ(φꎬρ) = Τ(F(φꎬρꎬt)). 在泛函 Τ 的作用下ꎬTrace 变换将变换后的图像 消去了参数 tꎬ它是计算在某方向上该图像函数的线 积分ꎬ其作用是计算图像在指定方向上的投影.如图 8 所示为步态图像的 Trace 变换结果ꎬTrace 变换图 像的第 1 列像素对应于原始图像在垂直方向的线积 分ꎬ中间的一列像素与原始图像在水平方向上的线 积分相对应. 表 3 采用 Hough 变换提取步态特征的耗时以及特征的维数 Table 3 Time ̄consumed and dimension of gait feature extraction using Hough transform Th R= 0.5 R= 1 R= 2 R= 3 R= 4 耗时/ s 特征维数 耗时/ s 特征维数 耗时/ s 特征维数 耗时/ s 特征维数 耗时/ s 特征维数 0.5 22.79 357×360 11.44 357×180 6.07 357×90 3.84 357×60 3.12 357×46 1 11.57 179×360 6.02 179×180 2.97 179×90 2.11 179×60 1.53 179×46 2 5.80 89×360 3.01 89×180 1.57 89×90 1.00 89×60 0.83 89×46 3 3.92 59×360 2.04 59×180 1.05 59×90 0.71 59×60 0.66 59×46 4 3.10 45×360 1.57 45×180 0.92 45×90 0.57 45×60 0.45 45×46 图 8 Trace 变换 Fig.8 Trace transform 这里考虑 2 种泛函形式: 1) F1 : Τ(f(t)) = ∫t r f(t)dtꎬ r 为幂指数ꎻ 2) F2 : Τ(f(t)) = ∫e -jt f(t)dt. 样本集的标准差通过式(7)在图像平面上一一 逐点计算而得到: f - (iꎬj) = 1 n ∑ n k = 1 f k(iꎬj)ꎬ s(iꎬj) = 1 n - 1∑ n k = 1 (f k(iꎬj) - f - (iꎬj)) æ 2 è ç ö ø ÷ 1 2 . (7) 式中:n 为图像总数ꎬ( iꎬj) 表示在图像平面中的位 置ꎬ f - (iꎬj)表示在图像平面 (iꎬj) 处的灰度值均值ꎬ s(iꎬj) 表示在图像平面 (iꎬj) 处的灰度值的标准差ꎬ 如图 9 所示为样本集的标准差. 图 9 样本集的标准差 Fig.9 Standard deviation of the whole sample set 420 智 能 系 统 学 报 第 8 卷

第5期 贲硯烨,等:线性插值框架下矩阵步态识别的性能分析 ·421. 考虑到Trace变换的基区分对待各区域,而肢 也都是84.14%.大部分条件下,改变值,识别率低 体和头部的中心区域的标准差很小,因此同时考虑 于单纯Radon变换的识别率.方案2是对内环加大 泛函F,(r=0)和F(r≠0).方案1:外环(t≥t.)对 度量作用,而如图9所示,发现外环的差异点较多, 应泛函F(r≠0),内环(t<th)对应泛函F(r= 对内环加大度量作用不利于身份识别.当a=6时, 0);方案2:外环(t≥t)对应泛函F(r=0),内环 距离度量对识别效果有影响,而当。值较小时 (t<t6)对应泛函F,(r≠0).在泛函F,(r=1/16) (th≤5),识别率与单纯Radon变换相同,距离度 下实验,阈值t分隔了内环和外环,图10为不同 量未有作用 下2种方案的识别率.在方案1中,对内环进行Ra F,相当于将图像映射在复数域,即可得到实部 don变换,而对外环加大距离的度量作用.当ta较小 和虚部).F,可看成图像分别与实部模板cost和虚 时,距离度量作用施加的范围较大,当t。=1时,即为 部模板sint的内积.如图ll所示,angle表示复数 泛函F,(r≠0)下的Trace变换;反之,当t4较大时, 矩阵中每个元素的相位角,可以得到实部模板与虚 距离度量作用施加的范围较小,当t。=33时,即为 部模板的相位差π/2. Radon变换.同理分析方案2,仅仅对内环加大距离 度量作用,对外环只进行Radon变换,当t.较小时, 实部 距离度量作用施加的范围较小,当6=1时,即为 Radon变换:当th较大时,距离度量作用施加的范围 -0.80.4 0.40.8 angle 较大,当ta=33时,即为泛函F,(r≠0)下的Trace 虚部 变换山 0.850r -一方案1 图11使用泛函F,的Trace变换 0.845 ·。·方案2 0.840扣t* Fig.11 Trace transform using functional F2 0.835●+4 采用图11中的实部、虚部、相位角作为特征的 解0.830 最佳识别率分别为83.60%、83.87%和83.87%,通过 二维主成分分析对这3种特征进行降维[山],最终得 0.820F 到的维数均为14×95. 0.815 华 0.810 3.4Fan-Beam映射特征 0.805 Fan-Beam映射与Trace变换类似,也是计算在 0 101520253035 某组特定方向上直线的积分,它计算的是扇形直线 上的线积分.Fan-Beam映射的每一行像素与特定距 图10不同。下2种方案的识别率 离的映射特征对应,每一列像素与特定角度上的映 Fig.10 Recognition rate under parameter t among two 射特征对应.如图l2所示为步态图像的Fan-Beam schemes 映射结果 对应于方案1下的t≤5,同时考虑泛函F,在 r=0和r≠0时实现分段的Trace变换的最佳识别 率为84.14%,这是由于人体中心区域的标准差很小 (如图9所示),这部分环内的距离度量对结果影响 不大:随着t的增加,识别率有所变化,但一直小于 84.14%,当6<t≤11,18<th≤21,t。=32时,这 图12Fan-Beam映射 些区间内的识别率与Radon变换的识别率相同,也 Fig.12 Fan-Beam projection 就是距离度量对结果影响不大:而其他区间内的识 Fan-Beam映射]的可调参数为光线密度e和 别率却低于单纯Radon变换的识别率,也就是距离 点光源s到原点o的距离d,由于Fan-Beam映射特 度量并没有起到有利作用 征越充分,其对应的重建效果越接近于源步态图像, 方案2下,在th=6时和tw=32时的最佳识别率 因此通过Fan-Beam反映射[1)]重建图像的效果来研

考虑到 Trace 变换的基区分对待各区域ꎬ而肢 体和头部的中心区域的标准差很小ꎬ因此同时考虑 泛函 F1(r = 0)和 F1(r≠0) .方案 1:外环 (t≥t h ) 对 应泛函 F1(r ≠ 0)ꎬ 内环 (t < t h ) 对应泛函 F1 ( r = 0)ꎻ方案 2:外环 (t ≥ t h ) 对应泛函 F1 (r = 0)ꎬ内环 (t < t h ) 对应泛函 F1(r ≠ 0). 在泛函 F1( r = 1 / 16) 下实验ꎬ阈值 t h 分隔了内环和外环ꎬ图 10 为不同 t h 下 2 种方案的识别率.在方案 1 中ꎬ对内环进行 Ra ̄ don 变换ꎬ而对外环加大距离的度量作用.当 t h 较小 时ꎬ距离度量作用施加的范围较大ꎬ当 t h = 1 时ꎬ即为 泛函 F1(r ≠0) 下的 Trace 变换ꎻ反之ꎬ当 t h 较大时ꎬ 距离度量作用施加的范围较小ꎬ当 t h = 33 时ꎬ即为 Radon 变换.同理分析方案 2ꎬ仅仅对内环加大距离 度量作用ꎬ对外环只进行 Radon 变换ꎬ当 t h 较小时ꎬ 距离度量作用施加的范围较小ꎬ当 t h = 1 时ꎬ即为 Radon 变换ꎻ当 t h 较大时ꎬ距离度量作用施加的范围 较大ꎬ当 t h = 33 时ꎬ即为泛函 F1(r ≠ 0) 下的 Trace 变换[1] . 图 10 不同 th 下 2 种方案的识别率 Fig.10 Recognition rate under parameter th among two schemes 对应于方案 1 下的 t h ≤ 5ꎬ同时考虑泛函 F1 在 r = 0 和 r ≠ 0 时实现分段的 Trace 变换的最佳识别 率为 84.14%ꎬ这是由于人体中心区域的标准差很小 (如图 9 所示)ꎬ这部分环内的距离度量对结果影响 不大ꎻ随着 t h 的增加ꎬ识别率有所变化ꎬ但一直小于 84.14%ꎬ当 6 < t h ≤ 11ꎬ 18 < t h ≤ 21ꎬ t h = 32 时ꎬ这 些区间内的识别率与 Radon 变换的识别率相同ꎬ也 就是距离度量对结果影响不大ꎻ而其他区间内的识 别率却低于单纯 Radon 变换的识别率ꎬ也就是距离 度量并没有起到有利作用. 方案 2 下ꎬ在 t h = 6 时和 t h = 32 时的最佳识别率 也都是 84.14%.大部分条件下ꎬ改变 t h 值ꎬ识别率低 于单纯 Radon 变换的识别率.方案 2 是对内环加大 度量作用ꎬ而如图 9 所示ꎬ发现外环的差异点较多ꎬ 对内环加大度量作用不利于身份识别.当 t h = 6 时ꎬ 距离度量对识别效果有影响ꎬ 而当 t h 值较小时 (t h ≤ 5)ꎬ 识别率与单纯 Radon 变换相同ꎬ距离度 量未有作用. F2 相当于将图像映射在复数域ꎬ即可得到实部 和虚部[1] . F2 可看成图像分别与实部模板 cos t 和虚 部模板 sin t 的内积.如图 11 所示ꎬ angle 表示复数 矩阵中每个元素的相位角ꎬ可以得到实部模板与虚 部模板的相位差 π/ 2. 图 11 使用泛函 F2 的 Trace 变换 Fig.11 Trace transform using functional F2 采用图 11 中的实部、虚部、相位角作为特征的 最佳识别率分别为 83.60%、83.87%和 83.87%ꎬ通过 二维主成分分析对这 3 种特征进行降维[1] ꎬ最终得 到的维数均为 14×95. 3.4 Fan ̄Beam 映射特征 Fan ̄Beam 映射与 Trace 变换类似ꎬ也是计算在 某组特定方向上直线的积分ꎬ它计算的是扇形直线 上的线积分.Fan ̄Beam 映射的每一行像素与特定距 离的映射特征对应ꎬ每一列像素与特定角度上的映 射特征对应.如图 12 所示为步态图像的 Fan ̄Beam 映射结果. 图 12 Fan ̄Beam 映射 Fig.12 Fan ̄Beam projection Fan ̄Beam 映射[1]的可调参数为光线密度 e 和 点光源 s 到原点 o 的距离 dꎬ由于 Fan ̄Beam 映射特 征越充分ꎬ其对应的重建效果越接近于源步态图像ꎬ 因此通过 Fan ̄Beam 反映射[18]重建图像的效果来研 第 5 期 贲晛烨ꎬ等:线性插值框架下矩阵步态识别的性能分析 421

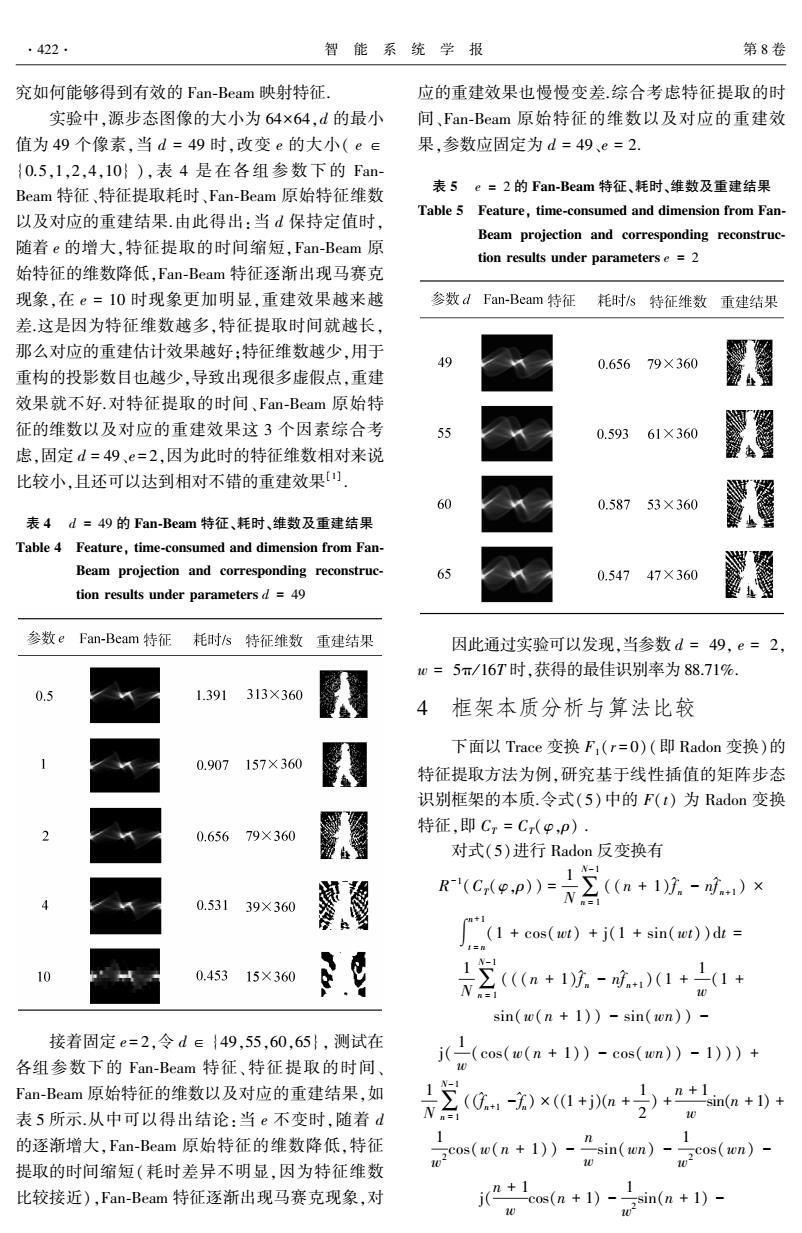

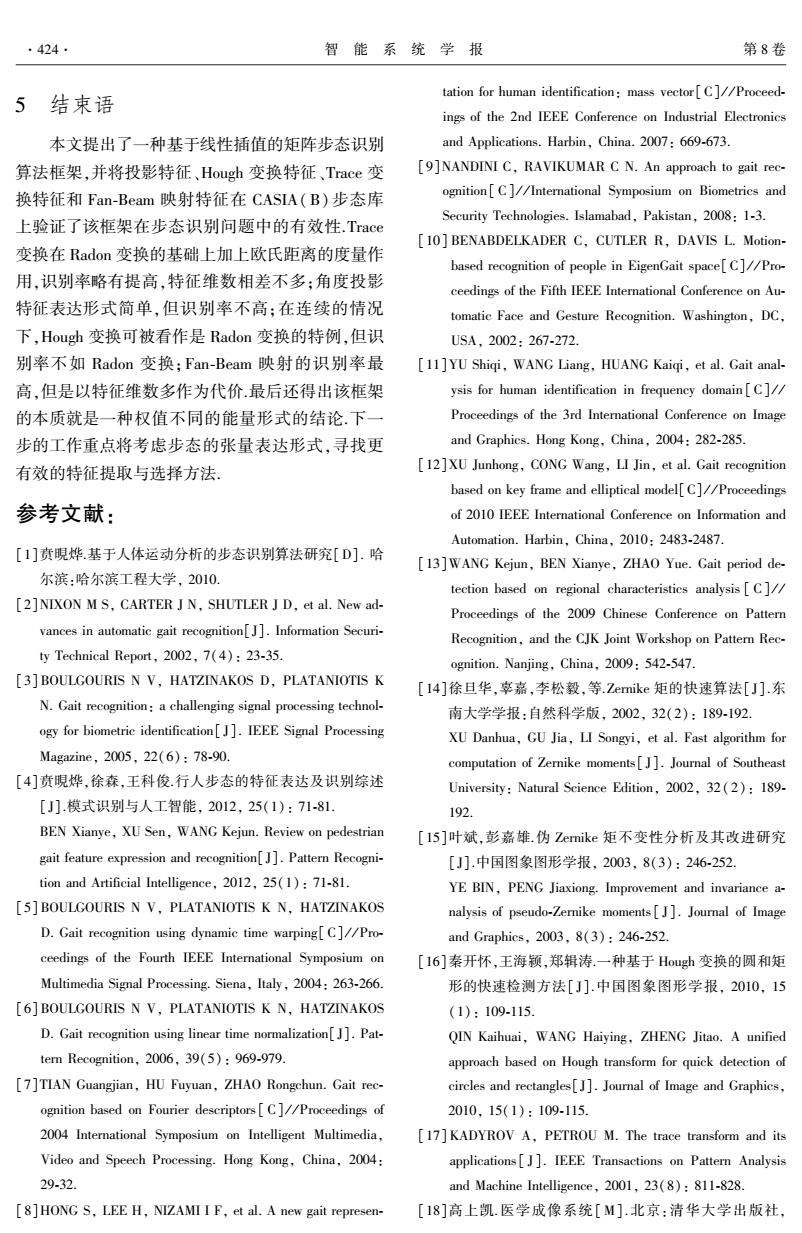

.422. 智能系统学报 第8卷 究如何能够得到有效的Fan-Beam映射特征 应的重建效果也慢慢变差综合考虑特征提取的时 实验中,源步态图像的大小为64×64,d的最小 间、Fan-Beam原始特征的维数以及对应的重建效 值为49个像素,当d=49时,改变e的大小(e∈ 果,参数应固定为d=49、e=2. {0.5,1,2,4,10}),表4是在各组参数下的Fan Beam特征、特征提取耗时、Fan-Beam原始特征维数 表5e=2的Fan-Beam特征、耗时、维数及重建结果 Table 5 Feature,time-consumed and dimension from Fan- 以及对应的重建结果.由此得出:当d保持定值时, Beam projection and corresponding reconstruc- 随着e的增大,特征提取的时间缩短,Fan-Beam原 tion results under parameters e 2 始特征的维数降低,Fan-Beam特征逐渐出现马赛克 现象,在e=10时现象更加明显,重建效果越来越 参数dFan-Beam特征 耗时s特征维数重建结果 差这是因为特征维数越多,特征提取时间就越长, 那么对应的重建估计效果越好:特征维数越少,用于 49 0.65679×360 重构的投影数目也越少,导致出现很多虚假点,重建 效果就不好.对特征提取的时间、Fan-Beam原始特 征的维数以及对应的重建效果这3个因素综合考 0.59361×360 虑,固定d=49、e=2,因为此时的特征维数相对来说 比较小,且还可以达到相对不错的重建效果四 60 0.58753×360 表4d=49的Fan-Beam特征、耗时、维数及重建结果 Table 4 Feature,time-consumed and dimension from Fan- Beam projection and corresponding reconstruc- 65 0.54747×360 tion results under parameters d =49 参数eFan-Beam特征耗时s特征维数 重建结果 因此通过实验可以发现,当参数d=49,e=2, 0=5π/16T时,获得的最佳识别率为88.71%. 0.5 1.391313×360 4框架本质分析与算法比较 下面以Trace变换F,(r=O)(即Radon变换)的 0.907 157×360 特征提取方法为例,研究基于线性插值的矩阵步态 识别框架的本质.令式(5)中的F(t)为Radon变换 0.65679×360 特征,即Cr=C(p,p). 对式(5)进行Radon反变换有 R(CH(.p))= 0.53139×360 恩 N三n+17.-味)× (+cos()+j(+sin())dt= 0.45315×360 三(e以-成1+ sin(w(n+1))-sin(wn))- 接着固定e=2,令d∈{49,55,60,65},测试在 各组参数下的Fan-Beam特征、特征提取的时间、 j((c(w(n+)-co(m1)) Fan-Beam原始特征的维数以及对应的重建结果,如 (-宝)xa+a+++a+D+ 表5所示.从中可以得出结论:当e不变时,随着d N= 的逐渐增大,Fan-Beam原始特征的维数降低,特征 cos(w(n+1))-nsin(wn)-cos(wn)- 提取的时间缩短(耗时差异不明显,因为特征维数 比较接近),Fan-Beam特征逐渐出现马赛克现象,对 *1 os(n+1)-,sin(n+1)- 10

究如何能够得到有效的 Fan ̄Beam 映射特征. 实验中ꎬ源步态图像的大小为 64×64ꎬd 的最小 值为 49 个像素ꎬ当 d = 49 时ꎬ改变 e 的大小( e ∈ {0.5ꎬ1ꎬ2ꎬ4ꎬ10} )ꎬ表 4 是在各组参数 下 的 Fan ̄ Beam 特征、特征提取耗时、Fan ̄Beam 原始特征维数 以及对应的重建结果.由此得出:当 d 保持定值时ꎬ 随着 e 的增大ꎬ特征提取的时间缩短ꎬFan ̄Beam 原 始特征的维数降低ꎬFan ̄Beam 特征逐渐出现马赛克 现象ꎬ在 e = 10 时现象更加明显ꎬ重建效果越来越 差.这是因为特征维数越多ꎬ特征提取时间就越长ꎬ 那么对应的重建估计效果越好ꎻ特征维数越少ꎬ用于 重构的投影数目也越少ꎬ导致出现很多虚假点ꎬ重建 效果就不好.对特征提取的时间、Fan ̄Beam 原始特 征的维数以及对应的重建效果这 3 个因素综合考 虑ꎬ固定 d = 49、e = 2ꎬ因为此时的特征维数相对来说 比较小ꎬ且还可以达到相对不错的重建效果[1] . 表 4 d = 49 的 Fan ̄Beam 特征、耗时、维数及重建结果 Table 4 Featureꎬ time ̄consumed and dimension from Fan ̄ Beam projection and corresponding reconstruc ̄ tion results under parameters d = 49 接着固定 e = 2ꎬ令 d ∈ {49ꎬ55ꎬ60ꎬ65}ꎬ 测试在 各组参数下的 Fan ̄Beam 特征、特征提取的时间、 Fan ̄Beam 原始特征的维数以及对应的重建结果ꎬ如 表 5 所示.从中可以得出结论:当 e 不变时ꎬ随着 d 的逐渐增大ꎬFan ̄Beam 原始特征的维数降低ꎬ特征 提取的时间缩短(耗时差异不明显ꎬ因为特征维数 比较接近)ꎬFan ̄Beam 特征逐渐出现马赛克现象ꎬ对 应的重建效果也慢慢变差.综合考虑特征提取的时 间、Fan ̄Beam 原始特征的维数以及对应的重建效 果ꎬ参数应固定为 d = 49、e = 2. 表 5 e = 2 的 Fan ̄Beam 特征、耗时、维数及重建结果 Table 5 Featureꎬ time ̄consumed and dimension from Fan ̄ Beam projection and corresponding reconstruc ̄ tion results under parameters e = 2 因此通过实验可以发现ꎬ当参数 d = 49ꎬ e = 2ꎬ w = 5π/ 16T 时ꎬ获得的最佳识别率为 88.71%. 4 框架本质分析与算法比较 下面以 Trace 变换 F1(r = 0)(即 Radon 变换)的 特征提取方法为例ꎬ研究基于线性插值的矩阵步态 识别框架的本质.令式(5)中的 F(t) 为 Radon 变换 特征ꎬ即 CT = CT(φꎬρ) . 对式(5)进行 Radon 反变换有 R -1 (CT(φꎬρ)) = 1 N∑ N-1 n = 1 ((n + 1) ^ f n - n ^ f n+1 ) × ∫ n+1 t = n (1 + cos(wt) + j(1 + sin(wt))dt = 1 N∑ N-1 n = 1 (((n + 1) ^ f n - n ^ f n+1 )(1 + 1 w (1 + sin(w(n + 1)) - sin(wn)) - j( 1 w (cos(w(n + 1)) - cos(wn)) - 1))) + 1 N∑ N-1 n = 1 (( ^ f n+1 -^ f n) × ((1 + j)(n + 1 2 ) + n + 1 w sin(n + 1) + 1 w 2 cos(w(n + 1)) - n w sin(wn) - 1 w 2 cos(wn) - j( n + 1 w cos(n + 1) - 1 w 2 sin(n + 1) - 422 智 能 系 统 学 报 第 8 卷

第5期 贲硯烨,等:线性插值框架下矩阵步态识别的性能分析 .423. ”cos(wn)+2sin(wn)). 如图13所示,尝试将经过Radon变换和加权积 (8) 10 分的特征进行Radon反变换,对Radon变换后的步 式中:了n和了.,分别为第n帧和第n+1帧的Radon 态特征进行加权积分,一个步态周期中各帧的权值 反变换结果 不同,因为相对于步态的静态信息,更多的是考虑步 为了简化式(8),令 态的动态信息.因此,实际上采用所提的这种框架构 造出来的特征是一种权值不同的能量形式 Φ=1+二(1+sin(o(n+1)-sin(n))- j((cos(no(n+1))-cos(cn))-1), 业-1+D(a+2》+"中i wsin(n +1)+ cos(w(n +1))-sin(wn)-mcos(wn) ji(*1 co(+1)-sin(n+1)- (e+n》 图13 Radon反变换的结果 0 Fig.13 Result from inverse Radon transform 所以,式(8)可以表示成: 线性插值框架下的各种实例化中:角度投影特 征虽然识别率不高,但是特征表达形式简短:Radon R(C(ep)=∑(n+1以-听)b+ 变换是Trace变换的特例,它还相当于多角度投影 2 特征;Hough变换可被看作是Radon变换的特例, Radon变换中多出了一个密度项和对数变换,略优 于Hough变换;Trace变换将Radon变换与欧氏距离 ,(n+1)Φ-) 的度量作用一并运用之后,识别率较单纯Radon变 换略有提高,特征维数也差不多:Fan-Beam映射以 式中:R-(·)表示Radon反变换,它的作用在于图 特征维数多作为代价,因此识别率最高,且最终降维 像各个方向上的投影特征能够重建原图像的信息, 后的维数也依然最大,导致匹配耗时也最长 图像集合为凸集是Radon反变换完全重建的充分必 最后,表6给出了所提出的基于线性插值的矩 要条件,因此经过图像坐标平面中每一点的各个方 阵步态识别框架的最佳方法与其他现有方法的比较 向的线积分惟一确定了该点的灰度值, 结果,其中分类器都使用NN.Baselinet1]和DTWIs) 目前将Radon变换的原坐标系xoy绕原点逆时 的识别效果不如本文方法好,同时计算量都大于本 针旋转p,得到新的sot坐标系,那么原直线方程 文所提框架的计算量.文献[11]未考虑其他帧的特 p=xcos9+ysin表达成另一种形式的参数方程: 征,仅使用关键帧的傅里叶描述子提取步态特征,因 (x scos tsin o, 而识别效果最不佳.实际上,融合方法的识别效果会 (y ssin o tcos o. 更佳,计算量也会更大,由于本文方法没有采用融合 则Radon变换可以写成 决策,因此这里没有与融合方法进行比较. R(o,p)=R(,s)= fscssinics)dt. 表6本框架与其他方法的比较 Table 6 Comparison of this proposed framework and oth- Radon反变换的表达形式(x,y)为 er algorithms 方法 识别率 文献[l9]:Baseline 0.7984 ysin o+g)dodg. 文献[11]:KFD 0.7500 式中:R,(e,9)=R(e, -p =xcos o ysin +g 文献[5]:DTW 0.8091 aq 框架下的Fan-Beam 0.8871 为以(x,y)为中心、q为半径的圆的切线

n w cos(wn) + 1 w 2 sin(wn)))). (8) 式中: ^ f n 和 ^ f n+1 分别为第 n 帧和第 n+1 帧的 Radon 反变换结果. 为了简化式(8)ꎬ令 Φ = 1 + 1 w (1 + sin(w(n + 1)) - sin(wn)) - j( 1 w (cos(w(n + 1)) - cos(wn)) - 1)ꎬ Ψ = (1 + j)(n + 1 2 ) + n + 1 w sin(n + 1) + 1 w 2 cos(w(n + 1)) - n w sin(wn) - 1 w 2 cos(wn) - j( n + 1 w cos(n + 1) - 1 w 2 sin(n + 1) - n w cos(wn) + 1 w 2 sin(wn)). 所以ꎬ式(8)可以表示成: R -1 (CT(φꎬρ)) = 1 N∑ N-1 n = 1 ((n + 1) ^ f n - n ^ f n+1)Φ + 1 N∑ N-1 n = 1 ( ^ f n+1 - ^ f n )Ψ = 1 N∑ N-1 n = 1 (Ψ - nΦ) ^ f n+1 + 1 N∑ N-1 n = 1 ((n + 1)Φ - Ψ) ^ f n . 式中: R -1 () 表示 Radon 反变换ꎬ它的作用在于图 像各个方向上的投影特征能够重建原图像的信息ꎬ 图像集合为凸集是 Radon 反变换完全重建的充分必 要条件ꎬ因此经过图像坐标平面中每一点的各个方 向的线积分惟一确定了该点的灰度值. 目前将 Radon 变换的原坐标系 xoy 绕原点逆时 针旋转 φꎬ 得到新的 sot 坐标系ꎬ那么原直线方程 ρ =xcos φ + ysin φ 表达成另一种形式的参数方程: x = scos φ - tsin φꎬ y = ssin φ + tcos φ. { 则 Radon 变换可以写成 R(φꎬρ) = R(φꎬs) = ∫ ¥ -¥ f(scos φ - tsin φꎬssin φ + tcos φ)dt. Radon 反变换的表达形式 ^ f(xꎬy) 为 ^ f(xꎬy) = - 1 2π 2 lim ε→0 ∫ ¥ ε 1 q ∫ 2π 0 R1(φꎬxcos φ + ysin φ + q)dφdq. 式中: R1(φꎬq) = ∂R(φꎬq) ∂q ꎬ p = xcos φ + ysin φ + q 为以(xꎬy)为中心、q 为半径的圆的切线. 如图 13 所示ꎬ尝试将经过 Radon 变换和加权积 分的特征进行 Radon 反变换ꎬ对 Radon 变换后的步 态特征进行加权积分ꎬ一个步态周期中各帧的权值 不同ꎬ因为相对于步态的静态信息ꎬ更多的是考虑步 态的动态信息.因此ꎬ实际上采用所提的这种框架构 造出来的特征是一种权值不同的能量形式. 图 13 Radon 反变换的结果 Fig.13 Result from inverse Radon transform 线性插值框架下的各种实例化中:角度投影特 征虽然识别率不高ꎬ但是特征表达形式简短ꎻRadon 变换是 Trace 变换的特例ꎬ它还相当于多角度投影 特征ꎻHough 变换可被看作是 Radon 变换的特例ꎬ Radon 变换中多出了一个密度项和对数变换ꎬ略优 于 Hough 变换ꎻTrace 变换将 Radon 变换与欧氏距离 的度量作用一并运用之后ꎬ识别率较单纯 Radon 变 换略有提高ꎬ特征维数也差不多ꎻFan ̄Beam 映射以 特征维数多作为代价ꎬ因此识别率最高ꎬ且最终降维 后的维数也依然最大ꎬ导致匹配耗时也最长. 最后ꎬ表 6 给出了所提出的基于线性插值的矩 阵步态识别框架的最佳方法与其他现有方法的比较 结果ꎬ其中分类器都使用 NN.Baseline [19] 和 DTW [5] 的识别效果不如本文方法好ꎬ同时计算量都大于本 文所提框架的计算量.文献[11]未考虑其他帧的特 征ꎬ仅使用关键帧的傅里叶描述子提取步态特征ꎬ因 而识别效果最不佳.实际上ꎬ融合方法的识别效果会 更佳ꎬ计算量也会更大ꎬ由于本文方法没有采用融合 决策ꎬ因此这里没有与融合方法进行比较. 表 6 本框架与其他方法的比较 Table 6 Comparison of this proposed framework and oth ̄ er algorithms 方 法 识别率 文献[19]:Baseline 0.798 4 文献[11]:KFD 0.750 0 文献[5]:DTW 0.809 1 框架下的 Fan ̄Beam 0.887 1 第 5 期 贲晛烨ꎬ等:线性插值框架下矩阵步态识别的性能分析 423

.424. 智能系统学报 第8卷 tation for human identification:mass vector[C]//Proceed- 结束语 ings of the 2nd IEEE Conference on Industrial Electronics 本文提出了一种基于线性插值的矩阵步态识别 and Applications.Harbin,China.2007:669-673. 算法框架,并将投影特征、Hough变换特征、Trace变 [9]NANDINI C,RAVIKUMAR C N.An approach to gait rec- 换特征和Fan-Beam映射特征在CASIA(B)步态库 ognition[C]//International Symposium on Biometrics and 上验证了该框架在步态识别问题中的有效性.Trace Security Technologies.Islamabad,Pakistan,2008:1-3. [10]BENABDELKADER C,CUTLER R,DAVIS L.Motion- 变换在Radon变换的基础上加上欧氏距离的度量作 based recognition of people in EigenGait space[C]//Pro- 用,识别率略有提高,特征维数相差不多:角度投影 ceedings of the Fifth IEEE International Conference on Au- 特征表达形式简单,但识别率不高:在连续的情况 tomatic Face and Gesture Recognition.Washington,DC, 下,Hough变换可被看作是Radon变换的特例,但识 USA,2002:267-272. 别率不如Radon变换:Fan-Beam映射的识别率最 [11]YU Shiqi,WANG Liang,HUANG Kaiqi,et al.Gait anal- 高,但是以特征维数多作为代价.最后还得出该框架 ysis for human identification in frequency domain[C]// 的本质就是一种权值不同的能量形式的结论.下一 Proceedings of the 3rd International Conference on Image 步的工作重点将考虑步态的张量表达形式,寻找更 and Graphics.Hong Kong,China,2004:282-285. 有效的特征提取与选择方法 [12]XU Junhong,CONG Wang,LI Jin,et al.Gait recognition based on key frame and elliptical model[C]//Proceedings 参考文献: of 2010 IEEE International Conference on Information and Automation.Harbin,China,2010:2483-2487. [1]贲晛烨基于人体运动分析的步态识别算法研究[D].哈 [13]WANG Kejun,BEN Xianye,ZHAO Yue.Gait period de- 尔滨:哈尔滨工程大学,2010 tection based on regional characteristics analysis[C]// [2]NIXON M S,CARTER J N,SHUTLER J D,et al.New ad- Proceedings of the 2009 Chinese Conference on Pattern vances in automatic gait recognitionJ.Information Securi- Recognition,and the CJK Joint Workshop on Pattern Rec- ty Technical Report,2002,7(4):23-35. ognition.Nanjing,China,2009:542-547. [3]BOULGOURIS N V,HATZINAKOS D,PLATANIOTIS K [l4]徐旦华,幸嘉,李松毅,等.Zernike矩的快速算法[J].东 N.Gait recognition:a challenging signal processing technol- 南大学学报:自然科学版,2002,32(2):189-192. ogy for biometric identification[J].IEEE Signal Processing XU Danhua,GU Jia,LI Songyi,et al.Fast algorithm for Magazine,2005,22(6):78-90. computation of Zernike moments[J].Journal of Southeast [4]贲晛烨,徐森,王科俊.行人步态的特征表达及识别综述 University:Natural Science Edition,2002,32(2):189- [J].模式识别与人工智能,2012,25(1):71-81 192. BEN Xianye,XU Sen,WANG Kejun.Review on pedestrian [l5]叶斌,彭嘉雄.伪Zernike矩不变性分析及其改进研究 gait feature expression and recognition[J].Pattern Recogni- [J].中国图象图形学报,2003,8(3):246-252 tion and Artificial Intelligence,2012,25(1):71-81. YE BIN,PENG Jiaxiong.Improvement and invariance a- [5]BOULGOURIS N V,PLATANIOTIS K N,HATZINAKOS nalysis of pseudo-Zernike moments[J].Journal of Image D.Gait recognition using dynamic time warping[C]//Pro- and Graphics,2003,8(3):246-252. ceedings of the Fourth IEEE International Symposium on [16]秦开怀,王海颖,郑辑涛.一种基于Hough变换的圆和矩 Multimedia Signal Processing.Siena,Italy,2004:263-266. 形的快速检测方法[J].中国图象图形学报,2010,15 [6]BOULGOURIS N V,PLATANIOTIS K N,HATZINAKOS (1):109-115. D.Gait recognition using linear time normalization[J].Pat- QIN Kaihuai,WANG Haiying,ZHENG Jitao.A unified tern Recognition,2006,39(5):969-979. approach based on Hough transform for quick detection of [7]TIAN Guangjian,HU Fuyuan,ZHAO Rongchun.Gait rec- circles and rectangles[J].Journal of Image and Graphics, ognition based on Fourier descriptors[C]//Proceedings of 2010,15(1):109-115. 2004 International Symposium on Intelligent Multimedia, [17]KADYROV A,PETROU M.The trace transform and its Video and Speech Processing.Hong Kong,China,2004: applications[J].IEEE Transactions on Pattern Analysis 29-32. and Machine Intelligence,2001,23(8):811-828. [8 HONG S,LEE H,NIZAMI I F,et al.A new gait represen- [18]高上凯.医学成像系统[M].北京:清华大学出版社

5 结束语 本文提出了一种基于线性插值的矩阵步态识别 算法框架ꎬ并将投影特征、Hough 变换特征、Trace 变 换特征和 Fan ̄Beam 映射特征在 CASIA(B) 步态库 上验证了该框架在步态识别问题中的有效性.Trace 变换在 Radon 变换的基础上加上欧氏距离的度量作 用ꎬ识别率略有提高ꎬ特征维数相差不多ꎻ角度投影 特征表达形式简单ꎬ但识别率不高ꎻ在连续的情况 下ꎬHough 变换可被看作是 Radon 变换的特例ꎬ但识 别率不如 Radon 变换ꎻFan ̄Beam 映射的识别率最 高ꎬ但是以特征维数多作为代价.最后还得出该框架 的本质就是一种权值不同的能量形式的结论.下一 步的工作重点将考虑步态的张量表达形式ꎬ寻找更 有效的特征提取与选择方法. 参考文献: [1]贲晛烨.基于人体运动分析的步态识别算法研究[D]. 哈 尔滨:哈尔滨工程大学ꎬ 2010. [2]NIXON M Sꎬ CARTER J Nꎬ SHUTLER J Dꎬ et al. New ad ̄ vances in automatic gait recognition[J]. Information Securi ̄ ty Technical Reportꎬ 2002ꎬ 7(4): 23 ̄35. [3] BOULGOURIS N Vꎬ HATZINAKOS Dꎬ PLATANIOTIS K N. Gait recognition: a challenging signal processing technol ̄ ogy for biometric identification[ J]. IEEE Signal Processing Magazineꎬ 2005ꎬ 22(6): 78 ̄90. [4]贲晛烨ꎬ徐森ꎬ王科俊.行人步态的特征表达及识别综述 [J].模式识别与人工智能ꎬ 2012ꎬ 25(1): 71 ̄81. BEN Xianyeꎬ XU Senꎬ WANG Kejun. Review on pedestrian gait feature expression and recognition[J]. Pattern Recogni ̄ tion and Artificial Intelligenceꎬ 2012ꎬ 25(1): 71 ̄81. [5] BOULGOURIS N Vꎬ PLATANIOTIS K Nꎬ HATZINAKOS D. Gait recognition using dynamic time warping[C] / / Pro ̄ ceedings of the Fourth IEEE International Symposium on Multimedia Signal Processing. Sienaꎬ Italyꎬ 2004: 263 ̄266. [6] BOULGOURIS N Vꎬ PLATANIOTIS K Nꎬ HATZINAKOS D. Gait recognition using linear time normalization[J]. Pat ̄ tern Recognitionꎬ 2006ꎬ 39(5): 969 ̄979. [7]TIAN Guangjianꎬ HU Fuyuanꎬ ZHAO Rongchun. Gait rec ̄ ognition based on Fourier descriptors [ C] / / Proceedings of 2004 International Symposium on Intelligent Multimediaꎬ Video and Speech Processing. Hong Kongꎬ Chinaꎬ 2004: 29 ̄32. [8]HONG Sꎬ LEE Hꎬ NIZAMI I Fꎬ et al. A new gait represen ̄ tation for human identification: mass vector[C] / / Proceed ̄ ings of the 2nd IEEE Conference on Industrial Electronics and Applications. Harbinꎬ China. 2007: 669 ̄673. [9]NANDINI Cꎬ RAVIKUMAR C N. An approach to gait rec ̄ ognition[ C] / / International Symposium on Biometrics and Security Technologies. Islamabadꎬ Pakistanꎬ 2008: 1 ̄3. [10] BENABDELKADER Cꎬ CUTLER Rꎬ DAVIS L. Motion ̄ based recognition of people in EigenGait space[C] / / Pro ̄ ceedings of the Fifth IEEE International Conference on Au ̄ tomatic Face and Gesture Recognition. Washingtonꎬ DCꎬ USAꎬ 2002: 267 ̄272. [11]YU Shiqiꎬ WANG Liangꎬ HUANG Kaiqiꎬ et al. Gait anal ̄ ysis for human identification in frequency domain [ C] / / Proceedings of the 3rd International Conference on Image and Graphics. Hong Kongꎬ Chinaꎬ 2004: 282 ̄285. [12]XU Junhongꎬ CONG Wangꎬ LI Jinꎬ et al. Gait recognition based on key frame and elliptical model[C] / / Proceedings of 2010 IEEE International Conference on Information and Automation. Harbinꎬ Chinaꎬ 2010: 2483 ̄2487. [13]WANG Kejunꎬ BEN Xianyeꎬ ZHAO Yue. Gait period de ̄ tection based on regional characteristics analysis [ C] / / Proceedings of the 2009 Chinese Conference on Pattern Recognitionꎬ and the CJK Joint Workshop on Pattern Rec ̄ ognition. Nanjingꎬ Chinaꎬ 2009: 542 ̄547. [14]徐旦华ꎬ辜嘉ꎬ李松毅ꎬ等.Zernike 矩的快速算法[ J].东 南大学学报:自然科学版ꎬ 2002ꎬ 32(2): 189 ̄192. XU Danhuaꎬ GU Jiaꎬ LI Songyiꎬ et al. Fast algorithm for computation of Zernike moments[ J]. Journal of Southeast University: Natural Science Editionꎬ 2002ꎬ 32( 2): 189 ̄ 192. [15]叶斌ꎬ彭嘉雄.伪 Zernike 矩不变性分析及其改进研究 [J].中国图象图形学报ꎬ 2003ꎬ 8(3): 246 ̄252. YE BINꎬ PENG Jiaxiong. Improvement and invariance a ̄ nalysis of pseudo ̄Zernike moments [ J]. Journal of Image and Graphicsꎬ 2003ꎬ 8(3): 246 ̄252. [16]秦开怀ꎬ王海颍ꎬ郑辑涛.一种基于 Hough 变换的圆和矩 形的快速检测方法[ J].中国图象图形学报ꎬ 2010ꎬ 15 (1): 109 ̄115. QIN Kaihuaiꎬ WANG Haiyingꎬ ZHENG Jitao. A unified approach based on Hough transform for quick detection of circles and rectangles[J]. Journal of Image and Graphicsꎬ 2010ꎬ 15(1): 109 ̄115. [17]KADYROV Aꎬ PETROU M. The trace transform and its applications [ J]. IEEE Transactions on Pattern Analysis and Machine Intelligenceꎬ 2001ꎬ 23(8): 811 ̄828. [18]高上凯. 医学成像系统[ M]. 北京:清华大学出版社ꎬ 424 智 能 系 统 学 报 第 8 卷