第10卷第6期 智能系统学报 Vol.10 No.6 2015年12月 CAAI Transactions on Intelligent Systems Dec.2015 D0I:10.11992.tis.201509025 一种特征加权融合人脸识别方法 孙劲光2,孟凡宇2 (1.辽宁工程技术大学电子与信息工程学院,辽宁葫芦岛125000:2.辽宁省数字化矿山装备工程技术研究中心,辽 宁阜新123000) 摘要:针对传统人脸识别算法在非限制条件下识别准确率不高的问题,提出了一种特征加权融合人脸识别方法 (DLWF)。根据人脸面部左眼、右眼、鼻子,嘴、下巴等5个器官位置,将人脸图像划分成5个局部采样区域:将得到 的5个局部采样区域和整幅人脸图像分别输入到对应的神经网络中进行网络权值调整,完成子网络的构建:利用 softmax回归求出6个相似度向量并组成相似度矩阵与权向量相乘得出最终的识别结果。经ORL和WFL人脸库上 进行实验验证,识别准确率分别达到97%和91.63%。实验结果表明:该算法能够有效提高人脸识别能力,与传统识 别算法相比在限制条件和非限制条件下都具有较高的识别准确率。 关键词:人脸识别:非限制条件:深度自信网络:局部特征:特征融合:全局特征 中图分类号:TN911.73文献标志码:A文章编号:1673-4785(2015)06-0912-09 中文引用格式:孙劲光,孟凡宇.一种特征加权融合人脸识别方法[J].智能系统学报,2015,10(6):912-920. 英文引用格式:SUN Jinguang,MENG Fanyu.Face recognition by weighted fusion of facial features[J].CAAI Transactions on In- telligent Systems,2015,10(6):912-920. Face recognition by weighted fusion of facial features SUN Jinguang'2,MENG Fanyu2 (1.School of Electronics and Information Engineering,Liaoniing Technical University,Huludao 125000,China;2.LiaoNing Digital Mining Equipment Engineering Technology Research Center,Fuxin 123000,China) Abstract:The accuracy of face recognition is low under unconstrained conditions.To solve this problem,we pro- pose a new method based on deep learning and the weighted fusion of facial features.First,we divide facial feature points into five regions using an active shape model and then sample different facial components corresponding to those facial feature points.A corresponding deep belief network (DBN)was then trained based on these regional samples to obtain optimal network parameters.The five regional sampling regions and entire facial image obtained were then inputted into a corresponding neural network to adjust the network weight and complete the construction of sub-networks.Finally,using softmax regression,we obtained six similarity vectors of different components.These six similarity vectors comprise a similarity matrix,which is then multiplied by the weight vector to derive the final recognition result.Recognition accuracy was 97%and 91.63%on the ORL and WFL face databases,respectively. Compared with traditional recognition algorithms such as SVM,DBN,PCA,and FIP+LDA,recognition rates for both databases were improved in both constrained and unconstrained conditions.On the basis of these experimental results,we conclude that the proposed algorithm demonstrates high efficiency in face recognition. Keywords:face recognition;unconstrained condition;deep belief networks;local feature;feature fusion;overall feature 收稿日期:2015-09-17. 人脸识别一直是模式识别和计算机视觉领域的 基金项目:国家科技支撑计划资助项目(2013BAH12F02) 通信作者:孟凡字.E-mail:mengfanyul991@163.com

第 10 卷第 6 期 智 能 系 统 学 报 Vol.10 №.6 2015 年 12 月 CAAI Transactions on Intelligent Systems Dec. 2015 DOI:10.11992.tis.201509025 一种特征加权融合人脸识别方法 孙劲光1,2 ,孟凡宇2 (1.辽宁工程技术大学 电子与信息工程学院, 辽宁 葫芦岛 125000; 2.辽宁省数字化矿山装备工程技术研究中心, 辽 宁 阜新 123000) 摘 要:针对传统人脸识别算法在非限制条件下识别准确率不高的问题,提出了一种特征加权融合人脸识别方法 (DLWF + )。 根据人脸面部左眼、右眼、鼻子、嘴、下巴等 5 个器官位置,将人脸图像划分成 5 个局部采样区域;将得到 的 5 个局部采样区域和整幅人脸图像分别输入到对应的神经网络中进行网络权值调整,完成子网络的构建;利用 softmax 回归求出 6 个相似度向量并组成相似度矩阵与权向量相乘得出最终的识别结果。 经 ORL 和 WFL 人脸库上 进行实验验证,识别准确率分别达到 97%和 91.63%。 实验结果表明:该算法能够有效提高人脸识别能力,与传统识 别算法相比在限制条件和非限制条件下都具有较高的识别准确率。 关键词:人脸识别;非限制条件;深度自信网络;局部特征;特征融合;全局特征 中图分类号: TN911.73 文献标志码:A 文章编号:1673⁃4785(2015)06⁃0912⁃09 中文引用格式:孙劲光,孟凡宇. 一种特征加权融合人脸识别方法[J]. 智能系统学报, 2015, 10(6): 912⁃920. 英文引用格式:SUN Jinguang, MENG Fanyu. Face recognition by weighted fusion of facial features[J]. CAAI Transactions on In⁃ telligent Systems, 2015, 10(6): 912⁃920. Face recognition by weighted fusion of facial features SUN Jinguang 1, 2 , MENG Fanyu 2 (1. School of Electronics and Information Engineering, Liaoniing Technical University, Huludao 125000, China; 2. LiaoNing Digital Mining Equipment Engineering Technology Research Center, Fuxin 123000, China) Abstract:The accuracy of face recognition is low under unconstrained conditions. To solve this problem, we pro⁃ pose a new method based on deep learning and the weighted fusion of facial features. First, we divide facial feature points into five regions using an active shape model and then sample different facial components corresponding to those facial feature points. A corresponding deep belief network (DBN) was then trained based on these regional samples to obtain optimal network parameters. The five regional sampling regions and entire facial image obtained were then inputted into a corresponding neural network to adjust the network weight and complete the construction of sub⁃networks. Finally, using softmax regression, we obtained six similarity vectors of different components. These six similarity vectors comprise a similarity matrix, which is then multiplied by the weight vector to derive the final recognition result. Recognition accuracy was 97% and 91.63% on the ORL and WFL face databases, respectively. Compared with traditional recognition algorithms such as SVM, DBN, PCA, and FIP +LDA, recognition rates for both databases were improved in both constrained and unconstrained conditions. On the basis of these experimental results, we conclude that the proposed algorithm demonstrates high efficiency in face recognition. Keywords: face recognition; unconstrained condition; deep belief networks; local feature; feature fusion; overall feature 收稿日期:2015⁃09⁃17. 基金项目:国家科技支撑计划资助项目(2013BAH12F02). 通信作者:孟凡宇. E⁃mail:mengfanyu1991@ 163.com. 人脸识别一直是模式识别和计算机视觉领域的

第6期 孙劲光,等:一种特征加权融合人脸识别方法 ·913· 研究热点。人脸图像像素矩阵较大同时特征维数也 1.2基本思想 较高,进行识别难度较大,因此设计出高效的特征提 为建立人脸面部局部特征深度学习模型,首先 取器成为人脸识别的关键。其中最典型方法为主成 利用人脸面部的主要特征点将人脸分成若干子区 分分析法(principal components analysis,PCA)[),其 域:然后将这些小的子区域和整幅人脸经归一化处 思想首先,把一副图像按行或列拉直成一个高维列 理,输入到对应的DBN网络进行训练,得到各个子 向量,然后,求取整个训练样本集高维列向量的协方 区域和整幅人脸的相似度概率向量:最后将左眼、右 差矩阵,求此协方差矩阵的特征向量和特征值得到 眼、鼻子、嘴、下巴等器官和整个面部的相似度向量 投影变换矩阵,最后,把人脸图像高维特征通过投影 加权后进行分类。DLWF+分为以下4个主要阶段: 变换矩阵映射到低维空间中,得到人脸的低维表示 1)人脸面部区域划分 特征:在人脸识别研究中,利用PCA方法对高维特 利用haar方法进行人脸检测,提取出人脸面部 征进行降维处理,获得了良好的效果,是最为成功的 主要区域,并根据人脸面部主要器官左眼、右眼、鼻 线性鉴别分析方法之一。但实际的应用中,PCA方 子、嘴巴、下巴等进行子区域的划分。 法进行线性鉴别分析通常会产生小样本问题(即样 2)网络模型的构建并确定权值 本个数远小于特征维数):被识别人脸图像是在非 利用上一步求取得到的各个区域和整幅人脸图 限制条件下提取时,应用PCA算法提取的特征并不 像分别输入到对应的子网络中,进行权值的调整,完 适合作为分类的特征。 成网络模型的构建。对各个子区域分别进行识别得 人们利用深度神经网络进行人脸识别主要分为 出识别率作为各自的权重。 2类:1)利用深度神经网络特征提取后再应用其他 3)求取面部隶属度矩阵 分类器进行识别26:2)直接在深度神经网络增加 通过将测试集不同区域的采样块分别输入到对 分类层进行识别。汤晓鸥9]等利用卷积神经网 应的子网络中,取出个区域的相似度向量,并利用求 络进行人脸验证取得了良好的效果,在LFW人脸库 得的各个相似度向量组成相似度矩阵。 上的识别率已经达到99.15%:解决了人脸识别问题 4)加权求和得出识别结果。 中的二分类问题。 将相似度矩阵进行加权得出测试图像对应于每 为了解决传统人脸识别方法在复杂背景下和人 个类别的综合评分,评分最高的类别即作为最终的 脸多姿态条件下进行识别时,识别率不高的问题,本 识别结果。 文提出了一种特征加权融合人脸识别方法。本文的 1.3基本原理 主要贡献是通过将人脸面部进行区域划分提取得到 1.3.1主动形状模型 了人脸面部的局部特征,并结合整幅人脸的全局特 主动形状模型是由Cootes等B1]在1995年提出。 征进行相似度矩阵的求取,通过各部分的贡献度不 同进行加权得出最终判别结果,提出了基于相似度 该模型主要由全局形状模型和局部纹理模型构成。 矩阵加权的深度网络模型(deep learning and weigh- 1)全局形状模型 ted fusion,DLWF)人脸识别方法。 ASM利用点分布模型表示人脸形状S:,S:= [x1y1x2y2…x。yn](n为特征点数 1 基于相似度加权评分深度网络模型 目),其中具有N个训练样本的训练集表示为2= 1.1问题描述 {S,S2,…,Sw}。 利用传统深度信念网络[11进行人脸识别, 将训练样本对齐完成后,采用主成分分析 输入的是整张人脸的像素级特征,忽略了人脸图 (PCA)方法建立形状模型,过程如下: 像局部结构特征,网络难以学习得到人脸局部特 ①计算对齐完成后训练样本平均形状: 征[]:在自然条件下,所获得的人脸图像通常受 (1) 到背景、光照等外界因素的影响,很难确定哪些 面部器官在识别过程中所起到的比重大,哪些器 ②计算形状向量的协方差矩阵: 官起的比重小,使得在实际研究过程中对相似度 c= ∑(s.-5)(s-5) (2) 加权的权值确定变得复杂。因此本文重点解决 提取人脸局部特征的深度学习模型及多特征加 ③对C进行特征分解,得到特征值入(入≥ 权识别方法权值确定2个问题。 入+1,入k≠0,k=1,2,…,2n)和特征向量P4o

研究热点。 人脸图像像素矩阵较大同时特征维数也 较高,进行识别难度较大,因此设计出高效的特征提 取器成为人脸识别的关键。 其中最典型方法为主成 分分析法(principal components analysis,PCA) [1] ,其 思想首先,把一副图像按行或列拉直成一个高维列 向量,然后,求取整个训练样本集高维列向量的协方 差矩阵,求此协方差矩阵的特征向量和特征值得到 投影变换矩阵,最后,把人脸图像高维特征通过投影 变换矩阵映射到低维空间中,得到人脸的低维表示 特征;在人脸识别研究中,利用 PCA 方法对高维特 征进行降维处理,获得了良好的效果,是最为成功的 线性鉴别分析方法之一。 但实际的应用中,PCA 方 法进行线性鉴别分析通常会产生小样本问题(即样 本个数远小于特征维数);被识别人脸图像是在非 限制条件下提取时,应用 PCA 算法提取的特征并不 适合作为分类的特征。 人们利用深度神经网络进行人脸识别主要分为 2 类:1)利用深度神经网络特征提取后再应用其他 分类器进行识别[2⁃6] ;2) 直接在深度神经网络增加 分类层进行识别[7⁃8] 。 汤晓鸥[9] 等利用卷积神经网 络进行人脸验证取得了良好的效果,在 LFW 人脸库 上的识别率已经达到 99.15%;解决了人脸识别问题 中的二分类问题。 为了解决传统人脸识别方法在复杂背景下和人 脸多姿态条件下进行识别时,识别率不高的问题,本 文提出了一种特征加权融合人脸识别方法。 本文的 主要贡献是通过将人脸面部进行区域划分提取得到 了人脸面部的局部特征,并结合整幅人脸的全局特 征进行相似度矩阵的求取,通过各部分的贡献度不 同进行加权得出最终判别结果,提出了基于相似度 矩阵加权的深度网络模型(deep learning and weigh⁃ ted fusion,DLWF + )人脸识别方法。 1 基于相似度加权评分深度网络模型 1.1 问题描述 利用传统深度信念网络[ 10⁃11] 进行人脸识别, 输入的是整张人脸的像素级特征,忽略了人脸图 像局部结构特征,网络难以学习得到人脸局部特 征[ 12] ;在自然条件下,所获得的人脸图像通常受 到背景、光照等外界因素的影响,很难确定哪些 面部器官在识别过程中所起到的比重大,哪些器 官起的比重小,使得在实际研究过程中对相似度 加权的权值确定变得复杂。 因此本文重点解决 提取人脸局部特征的深度学习模型及多特征加 权识别方法权值确定 2 个问题。 1.2 基本思想 为建立人脸面部局部特征深度学习模型,首先 利用人脸面部的主要特征点将人脸分成若干子区 域;然后将这些小的子区域和整幅人脸经归一化处 理,输入到对应的 DBN 网络进行训练,得到各个子 区域和整幅人脸的相似度概率向量;最后将左眼、右 眼、鼻子、嘴、下巴等器官和整个面部的相似度向量 加权后进行分类。 DLWF +分为以下 4 个主要阶段: 1)人脸面部区域划分 利用 haar 方法进行人脸检测,提取出人脸面部 主要区域,并根据人脸面部主要器官左眼、右眼、鼻 子、嘴巴、下巴等进行子区域的划分。 2)网络模型的构建并确定权值 利用上一步求取得到的各个区域和整幅人脸图 像分别输入到对应的子网络中,进行权值的调整,完 成网络模型的构建。 对各个子区域分别进行识别得 出识别率作为各自的权重。 3)求取面部隶属度矩阵 通过将测试集不同区域的采样块分别输入到对 应的子网络中,取出个区域的相似度向量,并利用求 得的各个相似度向量组成相似度矩阵。 4)加权求和得出识别结果。 将相似度矩阵进行加权得出测试图像对应于每 个类别的综合评分,评分最高的类别即作为最终的 识别结果。 1.3 基本原理 1.3.1 主动形状模型 主动形状模型是由 Cootes 等[13⁃15]在 1995 年提出。 该模型主要由全局形状模型和局部纹理模型构成。 1)全局形状模型 ASM 利用点分布模型表示人脸形状 Si, Si = [x1 y1 x2 y2 … xn yn ] T ( n 为 特 征 点 数 目),其中具有 N 个训练样本的训练集表示为 Ω = {S1 ,S2 ,…,SN }。 将训练 样 本 对 齐 完 成 后, 采 用 主 成 分 分 析 (PCA)方法建立形状模型,过程如下: ①计算对齐完成后训练样本平均形状: S _ = 1 N∑ n i = 1 Si (1) ②计算形状向量的协方差矩阵: C = 1 N - 1 ∑ N i = 1 (Si - S _ )(Si - S _ ) T (2) ③对 C 进行特征分解,得到特征值 λk( λk ≥ λk+1 ,λk≠0,k = 1,2,…,2n)和特征向量 Pk。 第 6 期 孙劲光,等:一种特征加权融合人脸识别方法 ·913·

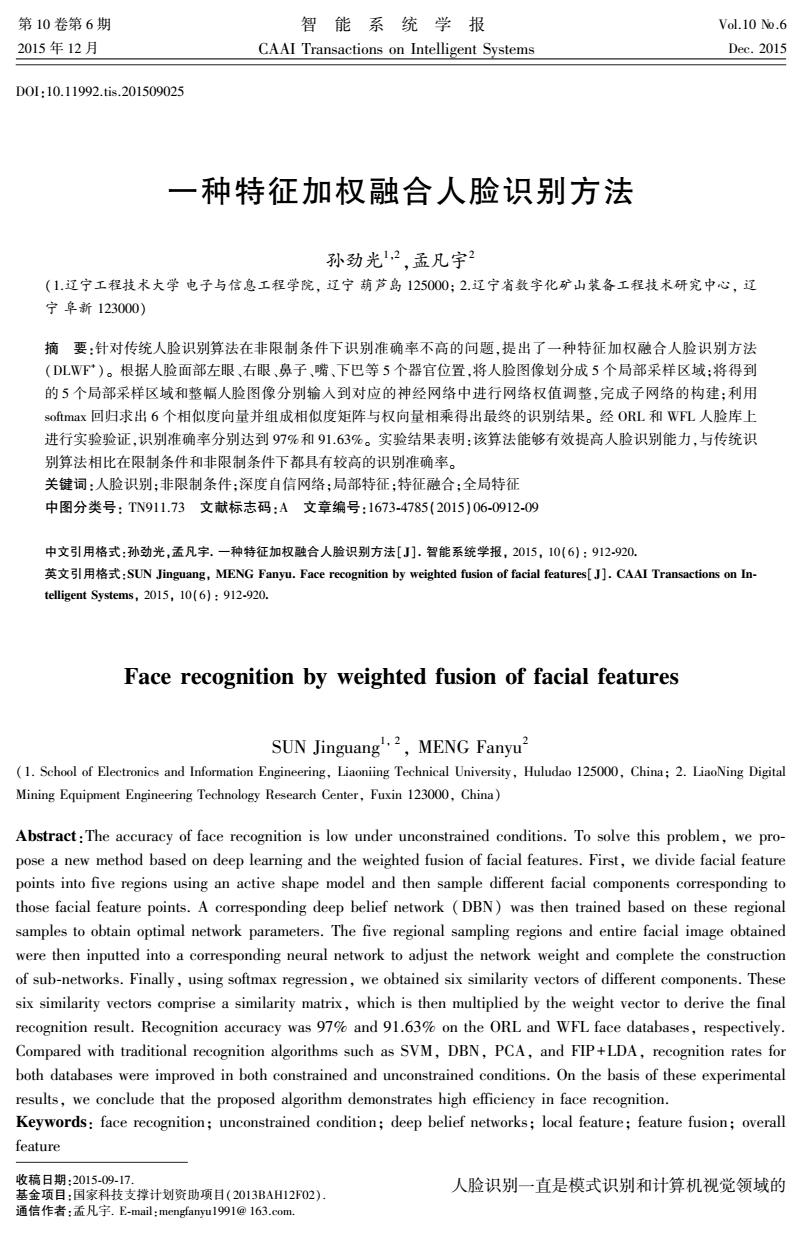

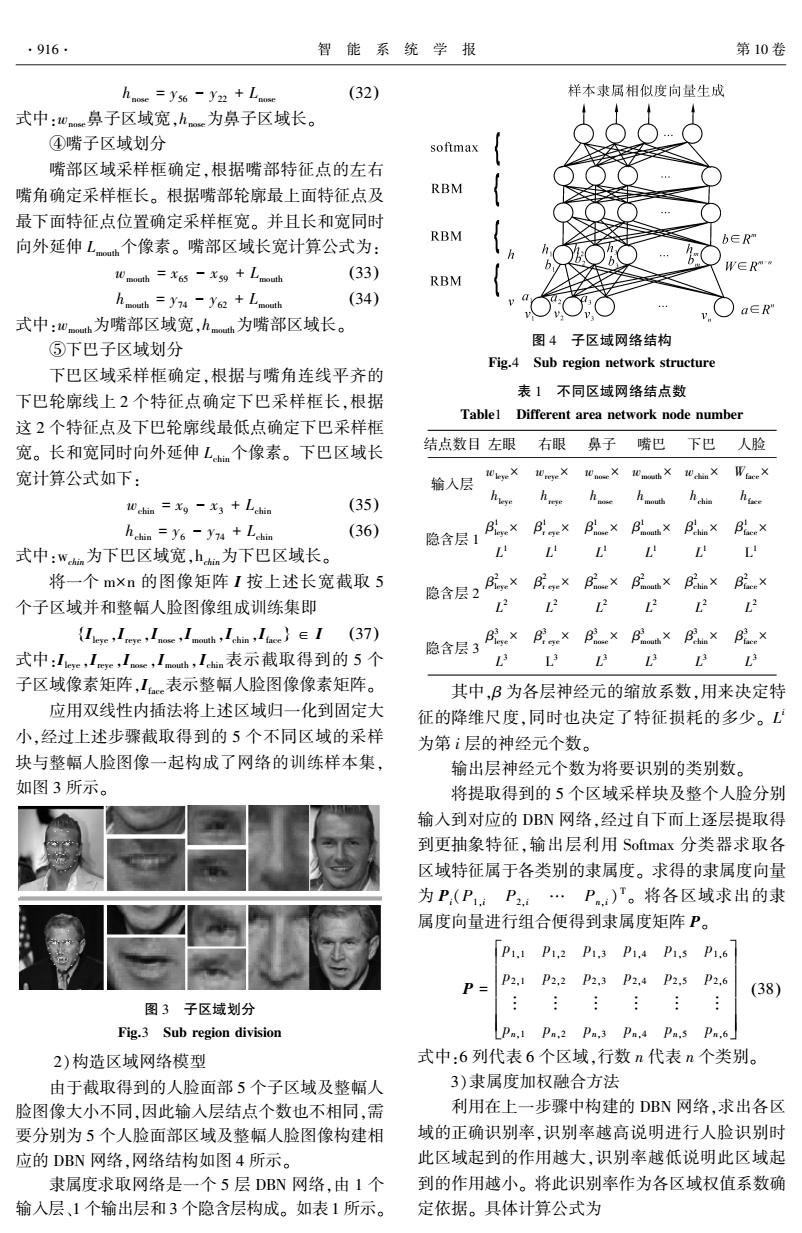

·914. 智能系统学报 第10卷 ④提取前t个特征值[入,入2…入,],令 如图1所示。 -≥ (3) 式中:7为所选特征占总特征比例,一般为95%~ 98%。求得特征向量P=[p1P2…p],最终求 得全局形状模型: S=S+Pb (4) 式中:b为主分量参数,控制前t个模式系数,且 b,取值: 图1人脸面部特征点 -3√八:≤b:≤3√八 (5) Fig.1 Facial feature points 全局形状模型的作用,在搜索更新过程中,通过改变 1.3.2深度信念网络(DBN) 形状参数,找到最佳的匹配模型,将形状变化约束在 DBN模拟人大脑的组织结构,由低级到高级地 模型允许范围内。 提取数据的抽象特征I6。DBN由多个RBM堆叠 2)局部纹理模型 而成,RBM被当做是一个动力学系统在给定一组状 局部纹理模型构建过程如下: 态(v,h)下的能量定义为 ①以第i个样本第j个标定点为中心,与相邻2 点连线垂直方向一定长度范围(也称Profile邻域), E(m,h/0)=-】 内外各取k个点的灰度值作为该点灰度信息: (12) 8=[8.1g.2…8i.2k+1门 (6) 式中:n,n分别为可见层和隐含层中神经元数目。 ②求g,梯度dg: ,为可见层第i个神经元状态,h为隐含层第j个神 dg可=[g.2-g,1…g,2站+1-g.24] (7) 经元状态,α:为可见层中第i个神经元偏置,b为隐 对dg归一化处理得 含层第j个神经元偏置,w,为可见层第i个神经元 G= dg可 (8) 与隐含层第j广个神经元之间连接权重,0表示需要训 2k |dgl 练调整模型参数0={a,b,w。 用向量形式表示为 式中:dg.1=8.(41)-8,1。 E(v,h/0)=-a"v-b"h -h"wv (13) 对训练样本集所有图像的第j个特征点进行相 同操作,求得第j个特征点的N个局部纹理G,G, 当给定模型参数0={a,b,w}时,利用式(12) 定义的能量函数,可以求出可视层v和隐含层h联 …,Gy° 合概率分布: ③得到标记点j对应的平均纹理G,和协方差矩 阵C。,即为该点的局部纹理模型。 p(,h/0)=ew0 14) (9) Z。=∑eo (15) c.h c*片26,-G6,-6 式中:Z(0)为归一化因子。 (10) 当给定可视层节点时,隐含层节点h:为0或1 局部纹理模型作用是在搜索过程中,确定每个 的条件概率分布为 特征点最佳候选点。其中,马氏距离d(G';)最小的 p(h=1/w)=o(a,+∑0g:) (16) 点,就是该特征点的最佳候选点。 p(h:=0/m)=1-p(h=1/m) (17) d(G)=(G,-G)'CG(G,-G)(11) 当给定隐含层节点时,可视层节点:为0或1 式中:G'是在j点附近采样得到,经过归一化处理 的条件概率分布为 纹理向量。 p(u:=1/h)=(6,+∑0gh) (18) 利用上述模型方法提取到的77个面部特征点

④提取前 t 个特征值[λ1 λ2 … λt],令 ∑ t i = 1 λi ∑ 2n i = 1 λi ≥ η (3) 式中:η 为所选特征占总特征比例,一般为 95% ~ 98%。 求得特征向量 P = [p1 p2 … pt],最终求 得全局形状模型: S = S _ + Pb (4) 式中:b 为主分量参数,控制前 t 个模式系数,且 bi取值: - 3 λi ≤ bi ≤ 3 λi (5) 全局形状模型的作用,在搜索更新过程中,通过改变 形状参数,找到最佳的匹配模型,将形状变化约束在 模型允许范围内。 2)局部纹理模型 局部纹理模型构建过程如下: ①以第 i 个样本第 j 个标定点为中心,与相邻 2 点连线垂直方向一定长度范围(也称 Profile 邻域), 内外各取 k 个点的灰度值作为该点灰度信息: gij = [gij,1 gij,2 … gij,2k+1 ] (6) ②求 gij梯度 dgij: dgij = [gij,2 - gij,1 … gij,2k+1 - gij,2k] (7) 对 dgij归一化处理得 Gij = 1 ∑ 2k l = 1 | dgij,l | dgij (8) 式中: dgij,l = gij,(l+1) - gij,l 。 对训练样本集所有图像的第 j 个特征点进行相 同操作,求得第 j 个特征点的 N 个局部纹理 G1j,G2j, …,GNj。 ③得到标记点 j 对应的平均纹理 Gj和协方差矩 阵 Cgj,即为该点的局部纹理模型。 G _ j = 1 N∑ N i = 1 Gij (9) Cgj = 1 N ∑ N i = 1 (Gij - Gj _ )(Gij - Gj _ ) T (10) 局部纹理模型作用是在搜索过程中,确定每个 特征点最佳候选点。 其中,马氏距离 d(G′j)最小的 点,就是该特征点的最佳候选点。 d(G′j) = (G′j - Gj _ ) TC -1 Gj (G′j - Gj _ ) (11) 式中:G′ij是在 j 点附近采样得到,经过归一化处理 纹理向量。 利用上述模型方法提取到的 77 个面部特征点 如图 1 所示。 图 1 人脸面部特征点 Fig.1 Facial feature points 1.3.2 深度信念网络(DBN) DBN 模拟人大脑的组织结构,由低级到高级地 提取数据的抽象特征[16] 。 DBN 由多个 RBM 堆叠 而成,RBM 被当做是一个动力学系统在给定一组状 态(v,h)下的能量定义为 E(v,h / θ) = - ∑ nv i = 1 ai vi - ∑ nh j = 1 bjhj - ∑ nv i = 1 ∑ nh j = 1 hjwi,j vi (12) 式中:nv、nk分别为可见层和隐含层中神经元数目。 vi为可见层第 i 个神经元状态,hj为隐含层第 j 个神 经元状态,ai为可见层中第 i 个神经元偏置,bj为隐 含层第 j 个神经元偏置,ωi,j为可见层第 i 个神经元 与隐含层第 j 个神经元之间连接权重,θ 表示需要训 练调整模型参数 θ= {a,b,w}。 用向量形式表示为 E(v,h / θ) = - a T v - b T h - h Twv (13) 当给定模型参数 θ = { a,b,w}时,利用式(12) 定义的能量函数,可以求出可视层 v 和隐含层 h 联 合概率分布: p(v,h / θ) = 1 Zθ e -E(v,h/ θ) (14) Zθ = ∑v,h e -E(v,h/ θ) (15) 式中:Z(θ)为归一化因子。 当给定可视层节点时,隐含层节点 hi为 0 或 1 的条件概率分布为 p(hi = 1 / v) = σ(ai + ∑i wij vi) (16) p(hi = 0 / v) = 1 - p(hj = 1 / v) (17) 当给定隐含层节点时,可视层节点 vi 为 0 或 1 的条件概率分布为 p(vi = 1 / h) = σ(bj + ∑ j wijhj) (18) ·914· 智 能 系 统 学 报 第 10 卷

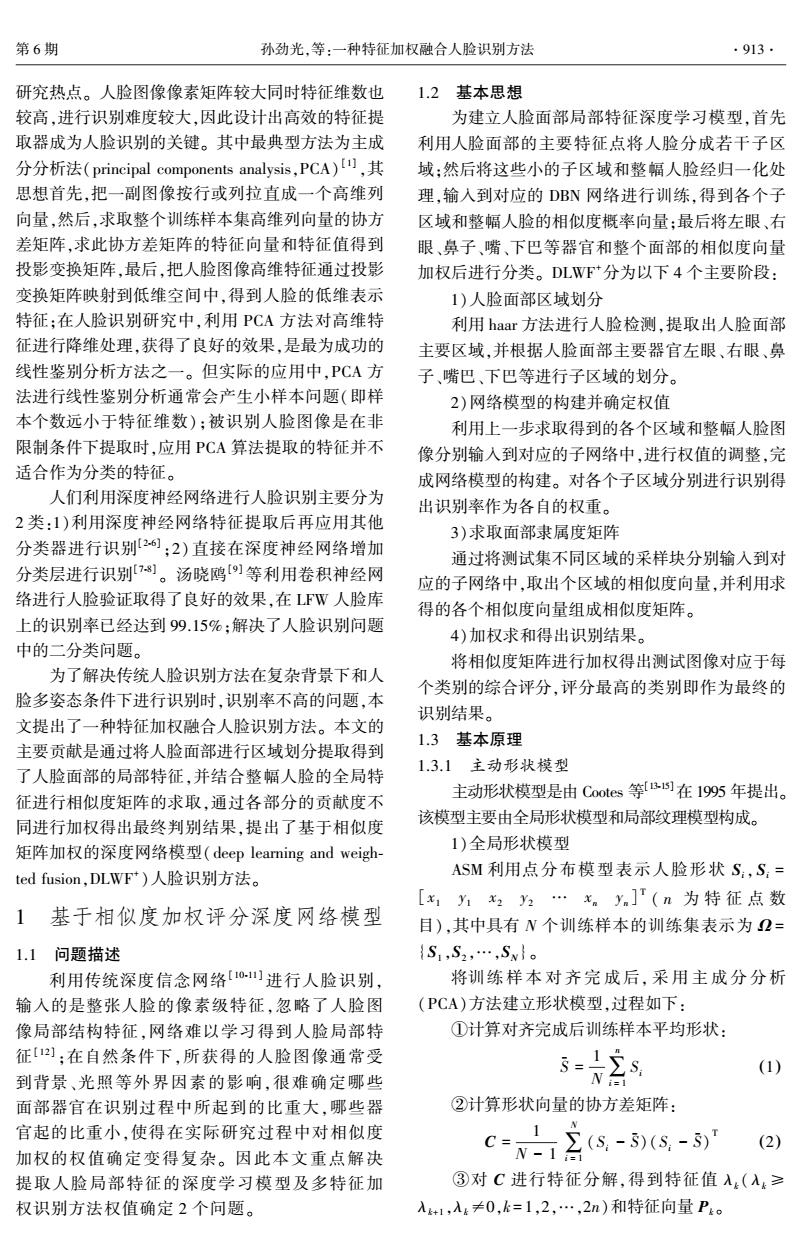

第6期 孙劲光,等:一种特征加权融合人脸识别方法 915· p(:=0/h)=1-p(:=1/h) (19) J(0)=- e 第k和k+1层隐含单元满足: p(h因Ih+)=Πp(h)I+)) (20) (24) p(h=11h+)=(b+∑Wh+) 式中:1{·}表示指示函数,花括号中表达式为真, (21) 那么函数值为1,否则函数值为0。加号后面部分为 式中:w(x)=1/(1+e),b,为第k层的偏置,W) 了防止模型过拟合所加的权衰减项。其中,入为模 为第k和k+1层之间权值,在DBN中将(h-),hD) 型参数,在实验部分确定。分析可知无法直接求取 看作为为一个RBM模型。结构如图2。 可以使J(0)最小的0的解析解,通过迭代优化算法 输出数据 标准标注信息 求解。计算代价函数梯度公式为 (●】 ●) RBM 反向传播 ,89= V ●● H p(y0=jlx0:0))]+A0 (25) RBM 微调 1.4本文研究方法(DLFW) 7 ●● 。。。DH 本文研究重点内容如下: RBM 微调 1)面部区域划分 利用主动形状模型确定人脸面部主要特征点,对 输入数据) 于每张人脸面部图像能得到一个特征点位置向量: 图2DBN结构模型 x2=(x,0,y.0,x,1y,1,…,x,a-1).(a-1) ①左眼子区域划分 Fig.2 DBN structure model 左眼区域采样框确定,根据左眼眼角确定采样 1.3.3 Softmax回归 框长,眉毛轮廓线最高点与眼晴轮廓线最低点确定 Softmax回归将只能够解决二分类问题的Logis- 采样框宽。为了获取左眼区域更多细节特征,长和 tic回归扩展至能够解决多分类问题。 宽同时向外延伸L个像素。左眼区域长宽计算公 假定Softmax回归模型训练样本来自k个不同 式如下: 的类别,共有m个,那么这m个训练样本组成的训 Wleye=-+Lleye (27) 练样本集为{(x0,y9),…,(x,ym)},则So hleve =y36-yn Llere (28) mar回归的假设函数为 式中:0为左眼区域宽,h为左眼区域长,I为 「p(yo=1xo;0)1 从原始图像矩阵I上截取的左眼区域矩阵。 ho(x())= p(y0=2x0:0) ②右眼子区域划分 右眼区域采样框确定,根据右眼眼角确定采样框 Lp(yo=kx⊙:0) 长,眉毛轮廓线最高点及眼晴轮廓线最低,点确定采样 「e7 框宽。为获取右眼区域更多细节特征,长和宽同时向 e( 外延伸L个像素。此区域长宽计算公式为 (22) ∑e( W reye=Lme (29) j= Le) hrye =y46-y2+L (30) 式中:假设向量h,(x))的每个元素p(y0=jlx; 式中:w为右眼区域宽,h为右眼区域长。 0)表示样本x0属于类别j的概率。0,02,…,0为 ③鼻子子区域划分 鼻子区域采样框确定,根据鼻子轮廓线最低点 模型参数,其中0,∈R1,将这些向量写成矩阵: 及眉毛轮廓线最前端特征点确定鼻子区域采样框 -01 长。根据鼻子轮廓线最左边特征点及最右边特征点 (23) 确定采样框的宽。长和宽同时向外延伸L个像 素。鼻子区域长宽计算公式如下: 则模型代价函数定义: W nose =xs4 -x58 Lnose (31)

p(vi = 0 / h) = 1 - p(vi = 1 / h) (19) 第 k 和 k+1 层隐含单元满足: p(h (k) | h (k+1) = Π i p(h (k) i | h (k+1) ) (20) p(h (k) i = 1 | h (k+1) ) = σ(b (k) i + ∑ j W (k) ij h (k+1) j ) (21) 式中:σ(x)= 1/ (1+e -x ),bi (k) 为第 k 层的偏置,Wij (k ) 为第 k 和 k+1 层之间权值,在 DBN 中将p(h (l-1) ,h (l) ) 看作为为一个 RBM 模型。 结构如图 2。 图 2 DBN 结构模型 Fig.2 DBN structure model 1.3.3 Softmax 回归 Softmax 回归将只能够解决二分类问题的 Logis⁃ tic 回归扩展至能够解决多分类问题。 假定 Softmax 回归模型训练样本来自 k 个不同 的类别,共有 m 个,那么这 m 个训练样本组成的训 练样本集为{(x (1) ,y (1) ),…,( x (m) ,y (m) )},则 Soft⁃ max 回归的假设函数为 hθ(x (i) ) = p(y (i) = 1 x (i) ;θ) p(y (i) = 2 x (i) ;θ) ︙ p(y (i) = k x (i) ;θ) é ë ê ê ê ê ê ù û ú ú ú ú ú = 1 ∑ k j = 1 e ϑT j x(i) e ϑT 1 x(i) e ϑT 2 x(i) ︙ e ϑT k x(i) é ë ê ê ê ê êê ù û ú ú ú ú úú (22) 式中:假设向量 hθ(x (i) )的每个元素 p( y (i) = j | x (i) ; θ)表示样本 x (i)属于类别 j 的概率。 θ1 , θ2 ,…,θk为 模型参数,其中 θi∈R n+1 ,将这些向量写成矩阵: θ = - θ T 1 - - θ T 2 - - θ T 3 - é ë ê ê ê ê ù û ú ú ú ú (23) 则模型代价函数定义: J(θ) = - 1 m [∑ m i = 1 ∑ k j = 1 1{y (i) = j}log e θT j x (i) Σ k l = 1 e θT l x (i) ] + λ 2 ∑ k i = 1 ∑ n j = 0 θ 2 ij (24) 式中:1{ ·}表示指示函数,花括号中表达式为真, 那么函数值为 1,否则函数值为 0。 加号后面部分为 了防止模型过拟合所加的权衰减项。 其中, λ 为模 型参数,在实验部分确定。 分析可知无法直接求取 可以使 J(θ) 最小的 θ 的解析解,通过迭代优化算法 求解。 计算代价函数梯度公式为 Ñθj = - 1 m∑ m i = 1 [x (i) (1{y (i) = j} - p(y (i) = j | x (i) ;θ))] + λθj (25) 1.4 本文研究方法(DLFW + ) 本文研究重点内容如下: 1)面部区域划分 利用主动形状模型确定人脸面部主要特征点,对 于每张人脸面部图像能得到一个特征点位置向量: xi = (xi,0 ,yi,0 ,xi,1 ,yi,1 ,…,xi,(n-1) ,yi,(n-1) ) ①左眼子区域划分 左眼区域采样框确定,根据左眼眼角确定采样 框长,眉毛轮廓线最高点与眼睛轮廓线最低点确定 采样框宽。 为了获取左眼区域更多细节特征,长和 宽同时向外延伸 Lleye个像素。 左眼区域长宽计算公 式如下: wleye = x30 - x34 + Lleye (27) hleye = y36 - y17 + Lleye (28) 式中:wleye为左眼区域宽,hleye为左眼区域长,Ileye 为 从原始图像矩阵 I 上截取的左眼区域矩阵。 ②右眼子区域划分 右眼区域采样框确定,根据右眼眼角确定采样框 长,眉毛轮廓线最高点及眼睛轮廓线最低点确定采样 框宽。 为获取右眼区域更多细节特征,长和宽同时向 外延伸 Lreye个像素。 此区域长宽计算公式为 wreye = x44 - x40 + Lreye (29) hreye = y46 - y24 + Lreye (30) 式中:wreye为右眼区域宽,hreye为右眼区域长。 ③鼻子子区域划分 鼻子区域采样框确定,根据鼻子轮廓线最低点 及眉毛轮廓线最前端特征点确定鼻子区域采样框 长。 根据鼻子轮廓线最左边特征点及最右边特征点 确定采样框的宽。 长和宽同时向外延伸 Lnose 个像 素。 鼻子区域长宽计算公式如下: wnose = x54 - x58 + Lnose (31) 第 6 期 孙劲光,等:一种特征加权融合人脸识别方法 ·915·

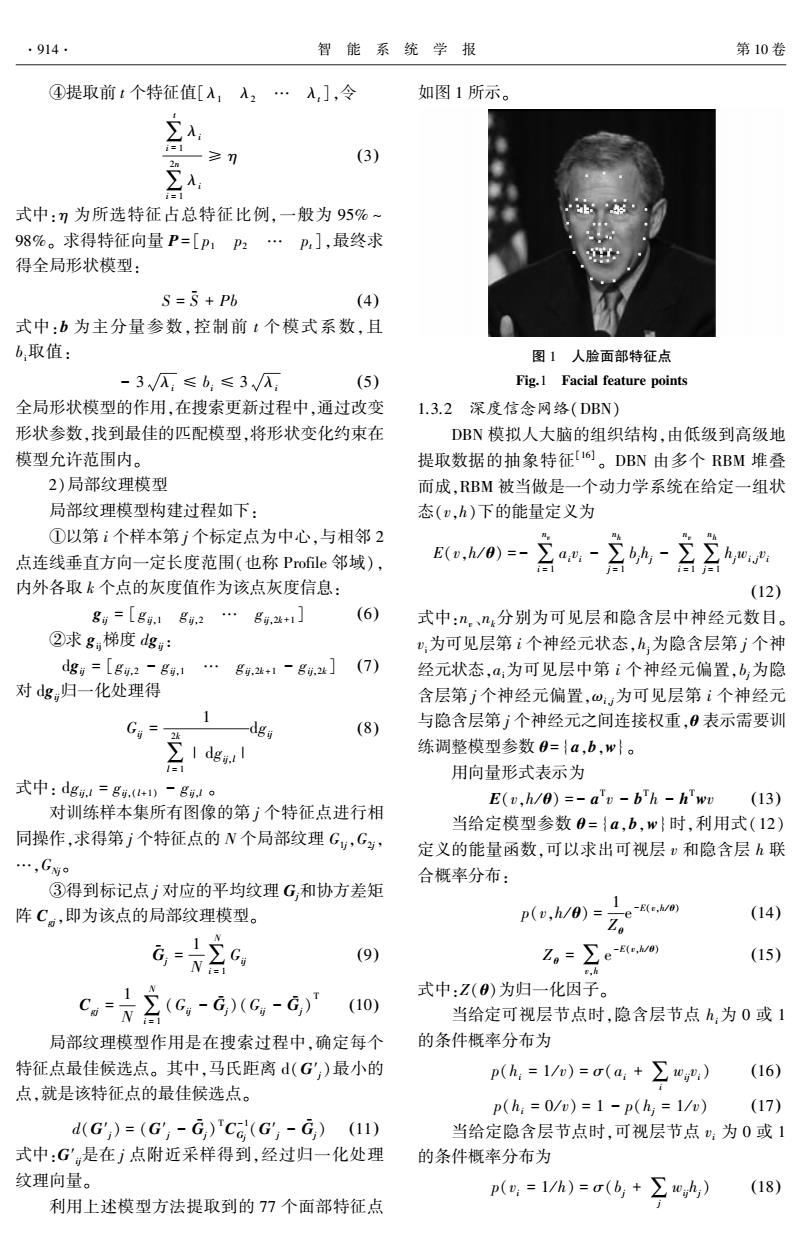

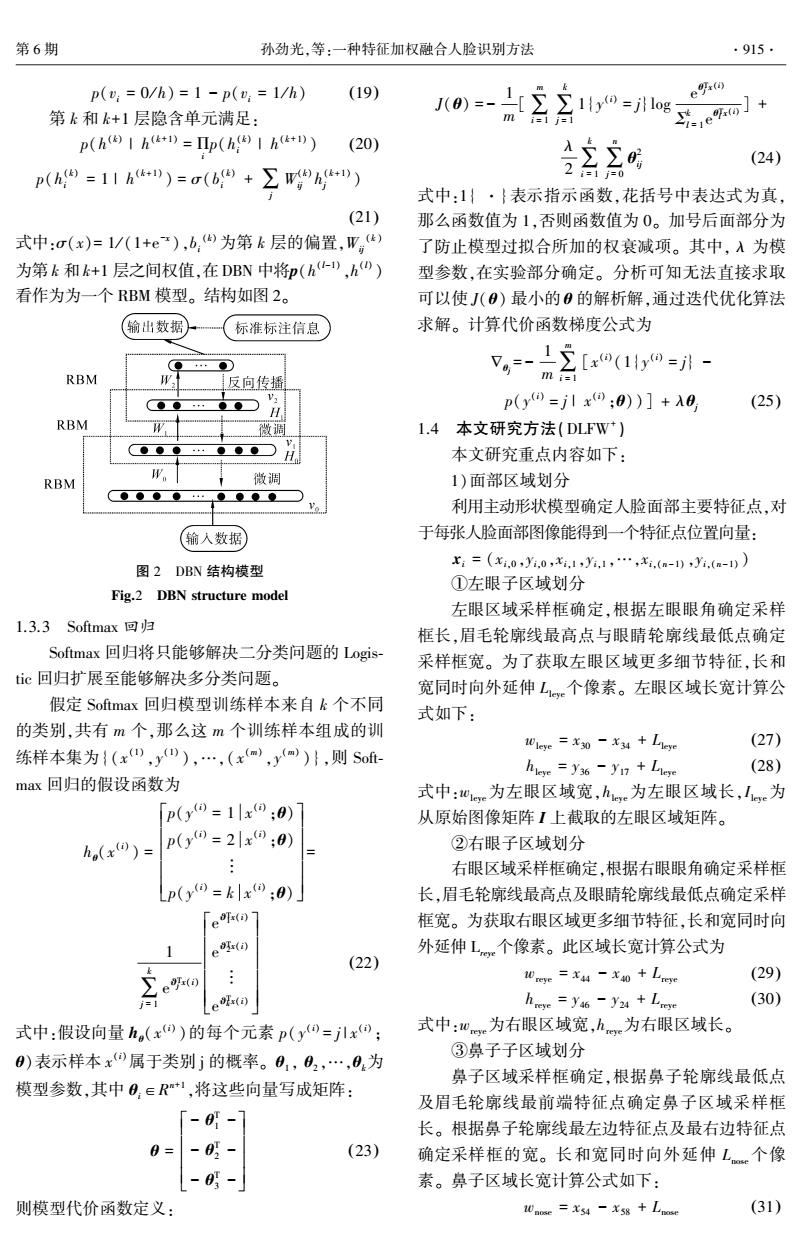

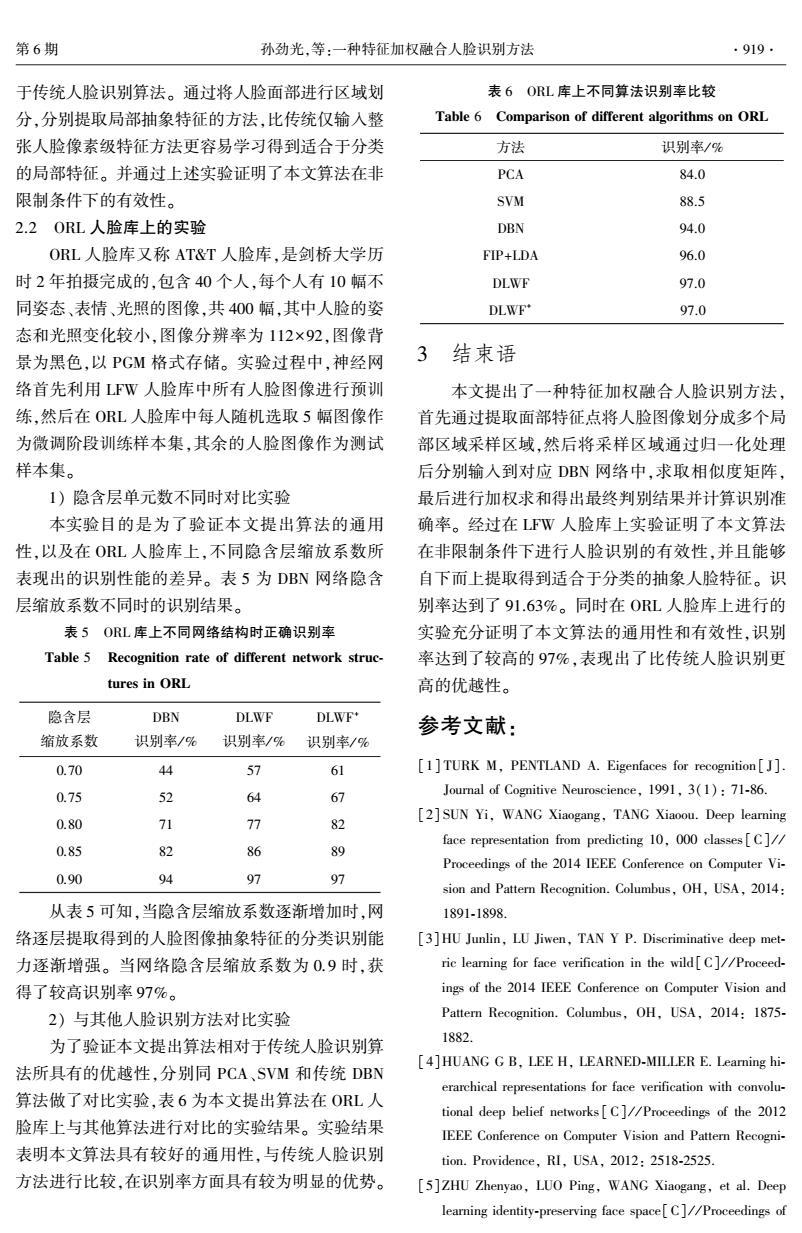

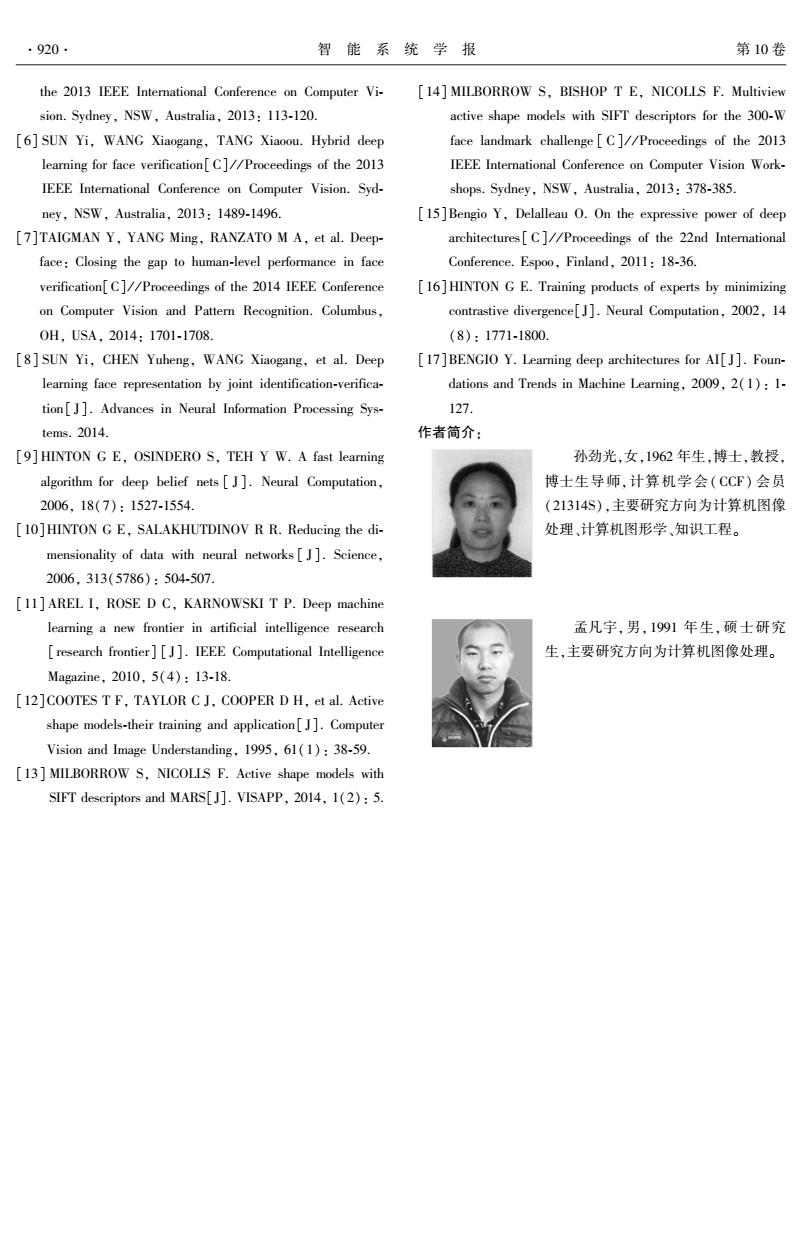

·916· 智能系统学报 第10卷 h aose =ys6 -y22 +Lmowe (32) 样本隶属相似度向量生成 式中:W鼻子区域宽,h为鼻子区域长。 ④嘴子区域划分 softmax 嘴部区域采样框确定,根据嘴部特征点的左右 嘴角确定采样框长。根据嘴部轮廓最上面特征点及 RBM 最下面特征点位置确定采样框宽。并且长和宽同时 RBM 向外延伸L个像素。嘴部区域长宽计算公式为: b∈R t0 mouth=mouth (33) W∈R RBM hmouth =y4-62 Lmouth (34) a∈R" 式中:wmuh为嘴部区域宽,hh为嘴部区域长。 图4子区域网络结构 ⑤下巴子区域划分 Fig.4 Sub region network structure 下巴区域采样框确定,根据与嘴角连线平齐的 表1不同区域网络结点数 下巴轮廓线上2个特征点确定下巴采样框长,根据 Tablel Different area network node number 这2个特征点及下巴轮廓线最低点确定下巴采样框 宽。长和宽同时向外延伸L个像素。下巴区域长 结点数目左眼右眼 鼻子嘴巴下巴人脸 宽计算公式如下: 输人层”X机neX0×”a×超×用大 Wehin=x-x3+Lchin (35) hae h oouth hdin htee hchin =y6-y14 Lchin (36) 隐含层11 e×Boe×Bn×Bh×Bin×βie× 式中:whn为下巴区域宽,hhn为下巴区域长。 L L 将一个m×n的图像矩阵I按上述长宽截取5 隐含层2民XE×民×民×民×B院× 个子区域并和整幅人脸图像组成训练集即 2 L22 (leye,Inove,Imouth Ichin II (37) 隐含层3民×民×民×R×R风x民× 式中:Lee,Le,lc,Ih,ldin表示截取得到的5个 子区域像素矩阵,l表示整幅人脸图像像素矩阵。 其中,B为各层神经元的缩放系数,用来决定特 应用双线性内插法将上述区域归一化到固定大 征的降维尺度,同时也决定了特征损耗的多少。 小,经过上述步骤截取得到的5个不同区域的采样 为第i层的神经元个数。 块与整幅人脸图像一起构成了网络的训练样本集, 输出层神经元个数为将要识别的类别数。 如图3所示。 将提取得到的5个区域采样块及整个人脸分别 输入到对应的DBN网络,经过自下而上逐层提取得 到更抽象特征,输出层利用Softmax分类器求取各 区域特征属于各类别的隶属度。求得的隶属度向量 为P(PP…P。)T。将各区域求出的隶 属度向量进行组合便得到隶属度矩阵P。 P1.1P1,2P1.3P1,4P1,5P1,6 P2.1P2,2P2.3P2,4P2.5P2,6 P= (38) 图3子区域划分 Fig.3 Sub region division Pn.1 Pn.2 Pn,3 Pn.4 Pa.s Pn.6 2)构造区域网络模型 式中:6列代表6个区域,行数n代表n个类别。 由于截取得到的人脸面部5个子区域及整幅人 3)隶属度加权融合方法 脸图像大小不同,因此输人层结点个数也不相同,需 利用在上一步骤中构建的DBN网络,求出各区 要分别为5个人脸面部区域及整幅人脸图像构建相 域的正确识别率,识别率越高说明进行人脸识别时 应的DBN网络,网络结构如图4所示。 此区域起到的作用越大,识别率越低说明此区域起 隶属度求取网络是一个5层DBN网络,由1个 到的作用越小。将此识别率作为各区域权值系数确 输入层、1个输出层和3个隐含层构成。如表1所示。 定依据。具体计算公式为

hnose = y56 - y22 + Lnose (32) 式中:wnose鼻子区域宽,hnose为鼻子区域长。 ④嘴子区域划分 嘴部区域采样框确定,根据嘴部特征点的左右 嘴角确定采样框长。 根据嘴部轮廓最上面特征点及 最下面特征点位置确定采样框宽。 并且长和宽同时 向外延伸 Lmouth个像素。 嘴部区域长宽计算公式为: wmouth = x65 - x59 + Lmouth (33) hmouth = y74 - y62 + Lmouth (34) 式中:wmouth为嘴部区域宽,hmouth为嘴部区域长。 ⑤下巴子区域划分 下巴区域采样框确定,根据与嘴角连线平齐的 下巴轮廓线上 2 个特征点确定下巴采样框长,根据 这 2 个特征点及下巴轮廓线最低点确定下巴采样框 宽。 长和宽同时向外延伸 Lchin个像素。 下巴区域长 宽计算公式如下: wchin = x9 - x3 + Lchin (35) hchin = y6 - y74 + Lchin (36) 式中:wchin为下巴区域宽,hchin为下巴区域长。 将一个 m×n 的图像矩阵 I 按上述长宽截取 5 个子区域并和整幅人脸图像组成训练集即 Ileye,Ireye,Inose,Imouth ,Ichin ,Iface { } ∈ I (37) 式中:Ileye,Ireye,Inose,Imouth ,Ichin表示截取得到的 5 个 子区域像素矩阵,Iface表示整幅人脸图像像素矩阵。 应用双线性内插法将上述区域归一化到固定大 小,经过上述步骤截取得到的 5 个不同区域的采样 块与整幅人脸图像一起构成了网络的训练样本集, 如图 3 所示。 图 3 子区域划分 Fig.3 Sub region division 2)构造区域网络模型 由于截取得到的人脸面部 5 个子区域及整幅人 脸图像大小不同,因此输入层结点个数也不相同,需 要分别为 5 个人脸面部区域及整幅人脸图像构建相 应的 DBN 网络,网络结构如图 4 所示。 隶属度求取网络是一个 5 层 DBN 网络,由 1 个 输入层、1 个输出层和 3 个隐含层构成。 如表 1 所示。 图 4 子区域网络结构 Fig.4 Sub region network structure 表 1 不同区域网络结点数 Table1 Different area network node number 结点数目 左眼 右眼 鼻子 嘴巴 下巴 人脸 输入层 wleye × hleye wreye × hreye wnose × hnose wmouth × hmouth wchin × hchin Wface × hface 隐含层 1 β 1 leye × L 1 β 1 r eye × L 1 β 1 nose × L 1 β 1 mouth × L 1 β 1 chin × L 1 β 1 face × L 1 隐含层 2 β 2 leye × L 2 β 2 r eye × L 2 β 2 nose × L 2 β 2 mouth × L 2 β 2 chin × L 2 β 2 face × L 2 隐含层 3 β 3 leye × L 3 β 3 r eye × L 3 β 3 nose × L 3 β 3 mouth × L 3 β 3 chin × L 3 β 3 face × L 3 其中,β 为各层神经元的缩放系数,用来决定特 征的降维尺度,同时也决定了特征损耗的多少。 L i 为第 i 层的神经元个数。 输出层神经元个数为将要识别的类别数。 将提取得到的 5 个区域采样块及整个人脸分别 输入到对应的 DBN 网络,经过自下而上逐层提取得 到更抽象特征,输出层利用 Softmax 分类器求取各 区域特征属于各类别的隶属度。 求得的隶属度向量 为 Pi(P1,i P2,i … Pn,i ) T 。 将各区域求出的隶 属度向量进行组合便得到隶属度矩阵 P。 P = p1,1 p1,2 p1,3 p1,4 p1,5 p1,6 p2,1 p2,2 p2,3 p2,4 p2,5 p2,6 ︙ ︙ ︙ ︙ ︙ ︙ pn,1 pn,2 pn,3 pn,4 pn,5 pn,6 é ë ê ê ê ê ê ù û ú ú ú ú ú (38) 式中:6 列代表 6 个区域,行数 n 代表 n 个类别。 3)隶属度加权融合方法 利用在上一步骤中构建的 DBN 网络,求出各区 域的正确识别率,识别率越高说明进行人脸识别时 此区域起到的作用越大,识别率越低说明此区域起 到的作用越小。 将此识别率作为各区域权值系数确 定依据。 具体计算公式为 ·916· 智 能 系 统 学 报 第 10 卷

第6期 孙劲光,等:一种特征加权融合人脸识别方法 .917· Pi DBN网络各层权值矩阵W,及偏置矩阵B精调。 (39) p p2 +p3 +ps +ps +p6 8)训练完成后,将各层权值矩阵W,及偏置矩阵 使得w1+w2+w3+w4+w5+w6=1,对人脸图像进行识 B保存,供识别时使用。 别时,利用求得的权值矩阵P与隶属度向量ω相 算法2分类算法 乘,计算公式如下: 1)对于一张给定的待识别人脸图像,利用ASM 01 模型提取出人脸面部特征点向量: P1,1P1,2P1,3 P1.4P1,5 P1.6 91 02 x=[x0y0x1为1…xa-)ya-)] P2,1 P2,2 P2,3 P2.4 P2.5 P2.6 q42 2)根据面部特征点向量x,确定5个采样区域位 P3,1P3.2P33P3.4 P3.5 P3.6 93 04 置,并计算5采样框的长和宽weh1e、0ee、he、 .· Ws mosehpose、Imouth、moth、2 chin,h chin o Pn.2 Pn.3 Pn.4 Pn.s Pn.6] 3)在原图像I中根据上步求出的采样框大小, ⊙6J 进行采样得到5个子区域Iie,Ie,Isc,Iuib, (40) 从而求得此待识别人脸图像隶属于各类别的综 Ichin}∈lo 4)将5个子区域及整幅人脸图像利用双线性 合评分向量Q=[9192… qn]。其中评分最高 内插法归一化到规定大小。而后进行灰度化、灰度 的类别,即为最终识别结果。 拉伸等预处理操作。 1.5算法描述 5)将4)中得到的子区域拉直成列向量,输入到 特征加权融合的人脸识别方法具体算法实现过 由训练完成的权值矩阵W及偏置矩阵B构造的 程如下: DBN网络中,求出隶属度矩阵P。 算法1训练算法。 1)利用ASM模型标注LFW人脸库中全部 6)将隶属度矩阵P与权值向量ω(ω1,ω2,ω3, 13233幅图像,人脸面部特征点向量x:=(x0,y.0, ω4,ω5,ω6)相乘求出此待识别人脸图像隶属于各个 类别的综合评分向量Q=[9192…9.]。 x,1y,1,光.(a-1)y,(a-))0 2)根据面部特征点向量x,确定5个采样区域 7)找出评分向量Q中获得评分最高的类,作为 位置,并计算5采样框的长和宽0e、h、0e 分类结果。 heye、0mse、hpose、i0 moathhmoth、W chin、hchin 2实验结果及分析 3)在灰度化后原图像I中根据上步求出的采样 框大小,进行采样得到5个子区域Le,I,Ic 本文算法分别在LFW(Labeled Faces in the Inmh,Ihin}∈I,以眼睛区域为例: Wild Database)人脸库和ORL(Olivetti research labo- ratory)人脸库上进行仿真实验,证明了本文算法的 x11 X12 有效性。在LFW人脸库实验目的是为了验证本文 x21 x22 (41) 算法在非限制条件下识别的有效性,同时,由于 LFW人脸库中有13233幅人脸图像为DBN预训练 _hieye:1 Xhiege:2 提供了充足的训练样本,保证DBN参数能够趋近全 式中:x表示采样后子区域内像素值。 局最优)。为了进一步评估本文算法通用性,在 4)将5个子区域及整幅人脸图像利用双线性 OL人脸库上同样进行了比较和测试。进行本文 内插法归一化到规定大小,并拉直成列向量: 实验硬件环境为:3.50GHz的Intel(R)Core(TM) 1e=[xix2…h,] (42) i5-4690CPU,8.00GB内存。 5)对5个子区域及整幅人脸图像进行灰度 2.1LFW人脸库上的实验 化、灰度拉伸等预处理操作,形成初调训练样本 LFW人脸库包含5749人的13233幅人脸图 集,从将要用于测试的类别中选取一部分作为精 像。其中,1680人包含2幅及以上人脸图像,4069 调训练样本集。 人只有一幅人脸图像。图像分辨率为250×250,以 6)利用得到的6个初调训练样本集分别对6个 JPEG格式存储,绝大多数为彩色图像,少数为灰度 DBN网络应用对比散度方法[)进行预训练调整各 图像。LFW主要用于在非限制条件下人脸识别研 层权值矩阵W,及偏置矩阵B:。式中:i表示第i层。 究,以成为学术界和工业界识别性能评价基准。 7)应用反向传播方法,在精调训练样本集上对 LFW人脸库能充分表现自然条件下人脸图像的变

ωi = pi p1 + p2 + p3 + p4 + p5 + p6 (39) 使得 ω1 +ω2 +ω3 +ω4 +ω5 +ω6 = 1,对人脸图像进行识 别时,利用求得的权值矩阵 P 与隶属度向量 ω 相 乘,计算公式如下: p1,1 p1,2 p1,3 p1,4 p1,5 p1,6 p2,1 p2,2 p2,3 p2,4 p2,5 p2,6 p3,1 p3,2 p3,3 p3,4 p3,5 p3,6 ︙ ︙ ︙ ︙ ︙ ︙ pn,1 pn,2 pn,3 pn,4 pn,5 pn,6 é ë ê ê ê ê ê ê ê ù û ú ú ú ú ú ú ú ω1 ω2 ω3 ω4 ω5 ω6 é ë ê ê ê ê ê ê ê ê ê ù û ú ú ú ú ú ú ú ú ú = q1 q2 q3 ︙ qn é ë ê ê ê ê ê ê ê ù û ú ú ú ú ú ú ú (40) 从而求得此待识别人脸图像隶属于各类别的综 合评分向量 Q = [q1 q2 … qn ]。 其中评分最高 的类别,即为最终识别结果。 1.5 算法描述 特征加权融合的人脸识别方法具体算法实现过 程如下: 算法 1 训练算法。 1) 利用 ASM 模型标注 LFW 人脸库中全部 13233 幅图像,人脸面部特征点向量 xi = ( xi,0 ,yi,0 , xi,1 ,yi,1 ,…xi,(n-1) ,yi,(n-1) )。 2)根据面部特征点向量 xi,确定 5 个采样区域 位置,并计算 5 采样框的长和宽 wleye、 hleye、 wreye、 hreye、wnose、hnose、wmouth 、hmoth 、wchin 、hchin 。 3)在灰度化后原图像 I 中根据上步求出的采样 框大小,进行采样得到 5 个子区域 Ileye,Ireye,Inose, Imouth ,Ichin }∈I,以眼睛区域为例: Ileye = x11 x12 … x1,wleye x21 x22 … x2,wleye ︙ ︙ ︙ xhleye ,1 xhleye ,2 … xhleye ,wleye é ë ê ê ê ê ê ê ù û ú ú ú ú ú ú (41) 式中:xij表示采样后子区域内像素值。 4)将 5 个子区域及整幅人脸图像利用双线性 内插法归一化到规定大小,并拉直成列向量: Ileye = x11 x12 … xhleyewleye [ ] T (42) 5)对 5 个子区域及整幅人脸图像进行灰度 化、灰度拉伸等预处理操作,形成初调训练样本 集,从将要用于测试的类别中选取一部分作为精 调训练样本集。 6)利用得到的 6 个初调训练样本集分别对 6 个 DBN 网络应用对比散度方法[17] 进行预训练调整各 层权值矩阵 Wi及偏置矩阵 Bi。 式中:i 表示第 i 层。 7)应用反向传播方法,在精调训练样本集上对 DBN 网络各层权值矩阵 Wi及偏置矩阵 Bi精调。 8)训练完成后,将各层权值矩阵 Wi及偏置矩阵 Bi保存,供识别时使用。 算法 2 分类算法 1)对于一张给定的待识别人脸图像,利用 ASM 模型提取出人脸面部特征点向量: x = [x0 y0 x1 y1 … x(n-1) y(n-1) ] 2) 根据面部特征点向量 x,确定 5 个采样区域位 置,并计算 5 采样框的长和宽 wleye、hleye、wreye、hreye、 wnose、hnose、wmouth 、hmoth 、wchin 、hchin 。 3)在原图像 I 中根据上步求出的采样框大小, 进行 采 样 得 到 5 个 子 区 域 Ileye, Ireye, Inose, Imouth , Ichin }∈I。 4)将 5 个子区域及整幅人脸图像利用双线性 内插法归一化到规定大小。 而后进行灰度化、灰度 拉伸等预处理操作。 5)将 4)中得到的子区域拉直成列向量,输入到 由训练完成的权值矩阵 Wi 及偏置矩阵 Bi 构造的 DBN 网络中,求出隶属度矩阵 P。 6)将隶属度矩阵 P 与权值向量 ω(ω1 ,ω2 ,ω3 , ω4 ,ω5 ,ω6 )相乘求出此待识别人脸图像隶属于各个 类别的综合评分向量 Q = [q1 q2 … qn ]。 7)找出评分向量 Q 中获得评分最高的类,作为 分类结果。 2 实验结果及分析 本文算法分别在 LFW ( Labeled Faces in the Wild Database)人脸库和 ORL(Olivetti research labo⁃ ratory)人脸库上进行仿真实验,证明了本文算法的 有效性。 在 LFW 人脸库实验目的是为了验证本文 算法在非限制条件下识别的有效性, 同时, 由于 LFW 人脸库中有 13 233 幅人脸图像为 DBN 预训练 提供了充足的训练样本,保证 DBN 参数能够趋近全 局最优[18] 。 为了进一步评估本文算法通用性,在 ORL 人脸库上同样进行了比较和测试。 进行本文 实验硬件环境为:3.50 GHz 的 Intel(R) Core( TM) i5⁃4690 CPU,8.00 GB 内存。 2.1 LFW 人脸库上的实验 LFW 人脸库包含 5 749 人的 13 233 幅人脸图 像。 其中,1 680 人包含 2 幅及以上人脸图像,4 069 人只有一幅人脸图像。 图像分辨率为 250×250,以 JPEG 格式存储,绝大多数为彩色图像,少数为灰度 图像。 LFW 主要用于在非限制条件下人脸识别研 究,以成为学术界和工业界识别性能评价基准。 LFW 人脸库能充分表现自然条件下人脸图像的变 第 6 期 孙劲光,等:一种特征加权融合人脸识别方法 ·917·

·918 智能系统学报 第10卷 化,如光照、姿态、表情、背景、性别等。 表3不同训练样本数正确识别率 本文选取人脸库中包含图像数目大于或等于 Table 3 Recognition rate of different training samples 25幅的人作为实验对象,包括29人共2458幅图 微调阶段训练样本数/% 方法 像。每人随机选取5幅人脸图像作为训练样本,其 10 15 余图像作为测试样本。将这些图像首先根据人脸面 PCA 23 27 29 部五官的位置进行区域的划分,然后归一化到固定 SWM 35.5 44 55 大小(下巴区域88×33、嘴部区域51×34、左眼和右 DBN 82.5 83.5 86 眼区域44×31、鼻子区域32×46),由此生成训练、测 FIP+LDA 83 85.5 86 试样本。 DLWF 85.25 87.5 88 1)隐含层单元设置压缩比不同时对比实验 DLWE 86.5 88.25 89.5 DBN的分类能力主要取决于自下向上、多层提 取得到特征的有效性。为了能够获得更多细节特 由表3可知,本文提出算法经过非监督的预训 征,5个区域长和宽分别向外扩大了Liege LeL 练,为DBN参数提供了较好的初始化值,再经过少 LhLn,它们的取值为各区域长的0.2倍。在构 量有标签的训练样本有监督的微调,便能达到较好 建DBN时,确定各隐含层神经元个数至关重要。因 的识别效果。随着训练样本数不断增加开始时识别 为LFW人脸库中图像都是在没有限制的自然条件 准确率明显上升,而后趋于不变,表明本文算法在非 下采集的,所以人脸图像特征较为复杂,并且含有较 限制条件下进行识别具有良好的鲁棒性。同时,表 多噪声,为了能够有效提取人脸图像抽象特征,首先 3也表明了本文算法比直接输入整张人脸图像像素 应该讨论网络构建问题中,不同隐含层神经元个数 级特征的DBN识别准确率更高。传统的人脸识别 对网络识别性能的影响。实验结果如表2所示。 算法如PCA、SVM等在训练样本个数较少时,所提 表2不同网络结构的正确识别率 取的底维特征分类能力并不强。随着训练样本个数 Table 2 Recognition rate of different network structures 增加,提取的特征分类能力有所增强,但在非限制条 隐含层 DBN DLWF DLWF 件下算法的识别精度并不高。 缩放系数 识别率/% 识别率/% 识别率/% 3)类别数不同时对比实验 0.70 55.75 56.25 58.45 实验3目的是为了验证本文算法在非限制条件 下的普适性和有效性。从LFW中选择拥有人脸图 0.75 64.50 66.75 69.35 像数目大于或等于25幅图像的39个人作为实验的 0.80 68.25 70.25 73.85 候选样本,从其中随机挑选出10、20、30人作为实验 0.85 71.10 74.50 79.25 对象,每人随机挑选出5幅人脸图像作为训练样本, 0.90 82.50 85.25 88.55 其余图像作为测试样本。每次随机选择不同人脸图 由表2可知,随着隐含层神经元缩放系数增加, 像进行实验,求取平均值作为最终结果。本次实验 深度神经网络能够更好地提取得到适合于分类的人 采用的DBN网络隐含层缩放系数与实验2相同,实 脸图像抽象特征,但计算量也随之增大。同时,隐含 验结果如表4所示。 层神经元数目相同时,本文提出算法的识别率均高 表4类别数不同时不同算法正确识别率 于只输入整张人脸图像像素级特征的传统深度神经 Table 4 Recognition rate of different algorithms 网络算法。 类别数/% 2)训练样本数不同时对比实验 方法 10 20 30 实验2的目的是为了测试本文算法在不同数 PCA 27.32 25.74 24.63 量训练样本的情况下,与传统人脸识别算法在识 SVM 41.65 38.23 36.46 别率方面所表现的优劣程度。由于在实际应用 DBN 83.71 84.05 85.21 环境中很难采集得到大量有标签的训练样本,所 FIP+LDA 84.61 86.72 87.51 以在具有较低的训练样本个数条件下,能取得较 好的识别效果就变得尤为重要。表3为深度神 DLWF 85.93 87.16 88.76 经网络隐含层结点数目的缩放系数为0.9时,在 DLWF 86.72 87.84 91.63 不同训练样本数目的条件下,与传统人脸识别方 经过在LFW人脸库上实验可知,本文提出的人 法进行比较的结果。 脸识别算法在非限制条件下的鲁棒性和准确率均高

化,如光照、姿态、表情、背景、性别等。 本文选取人脸库中包含图像数目大于或等于 25 幅的人作为实验对象,包括 29 人共 2458 幅图 像。 每人随机选取 5 幅人脸图像作为训练样本,其 余图像作为测试样本。 将这些图像首先根据人脸面 部五官的位置进行区域的划分,然后归一化到固定 大小(下巴区域 88×33、嘴部区域 51×34、左眼和右 眼区域 44×31、鼻子区域 32×46),由此生成训练、测 试样本。 1) 隐含层单元设置压缩比不同时对比实验 DBN 的分类能力主要取决于自下向上、多层提 取得到特征的有效性。 为了能够获得更多细节特 征,5 个区域长和宽分别向外扩大了 Lleye、Lreye、Lnose、 Lmouth 、Lchin ,它们的取值为各区域长的 0.2 倍。 在构 建 DBN 时,确定各隐含层神经元个数至关重要。 因 为 LFW 人脸库中图像都是在没有限制的自然条件 下采集的,所以人脸图像特征较为复杂,并且含有较 多噪声,为了能够有效提取人脸图像抽象特征,首先 应该讨论网络构建问题中,不同隐含层神经元个数 对网络识别性能的影响。 实验结果如表 2 所示。 表 2 不同网络结构的正确识别率 Table 2 Recognition rate of different network structures 隐含层 缩放系数 DBN 识别率/ % DLWF 识别率/ % DLWF + 识别率/ % 0.70 55.75 56.25 58.45 0.75 64.50 66.75 69.35 0.80 68.25 70.25 73.85 0.85 71.10 74.50 79.25 0.90 82.50 85.25 88.55 由表 2 可知,随着隐含层神经元缩放系数增加, 深度神经网络能够更好地提取得到适合于分类的人 脸图像抽象特征,但计算量也随之增大。 同时,隐含 层神经元数目相同时,本文提出算法的识别率均高 于只输入整张人脸图像像素级特征的传统深度神经 网络算法。 2) 训练样本数不同时对比实验 实验 2 的目的是为了测试本文算法在不同数 量训练样本的情况下,与传统人脸识别算法在识 别率方面所表现的优劣程度。 由于在实际应用 环境中很难采集得到大量有标签的训练样本,所 以在具有较低的训练样本个数条件下,能取得较 好的识别效果就变得尤为重要。 表 3 为深度神 经网络隐含层结点数目的缩放系数为 0. 9 时,在 不同训练样本数目的条件下,与传统人脸识别方 法进行比较的结果。 表 3 不同训练样本数正确识别率 Table 3 Recognition rate of different training samples 方法 微调阶段训练样本数/ % 5 10 15 PCA 23 27 29 SWM 35.5 44 55 DBN 82.5 83.5 86 FIP+LDA 83 85.5 86 DLWF 85.25 87.5 88 DLWF + 86.5 88.25 89.5 由表 3 可知,本文提出算法经过非监督的预训 练,为 DBN 参数提供了较好的初始化值,再经过少 量有标签的训练样本有监督的微调,便能达到较好 的识别效果。 随着训练样本数不断增加开始时识别 准确率明显上升,而后趋于不变,表明本文算法在非 限制条件下进行识别具有良好的鲁棒性。 同时,表 3 也表明了本文算法比直接输入整张人脸图像像素 级特征的 DBN 识别准确率更高。 传统的人脸识别 算法如 PCA、SVM 等在训练样本个数较少时,所提 取的底维特征分类能力并不强。 随着训练样本个数 增加,提取的特征分类能力有所增强,但在非限制条 件下算法的识别精度并不高。 3) 类别数不同时对比实验 实验 3 目的是为了验证本文算法在非限制条件 下的普适性和有效性。 从 LFW 中选择拥有人脸图 像数目大于或等于 25 幅图像的 39 个人作为实验的 候选样本,从其中随机挑选出 10、20、30 人作为实验 对象,每人随机挑选出 5 幅人脸图像作为训练样本, 其余图像作为测试样本。 每次随机选择不同人脸图 像进行实验,求取平均值作为最终结果。 本次实验 采用的 DBN 网络隐含层缩放系数与实验 2 相同,实 验结果如表 4 所示。 表 4 类别数不同时不同算法正确识别率 Table 4 Recognition rate of different algorithms 方法 类别数/ % 10 20 30 PCA 27.32 25.74 24.63 SVM 41.65 38.23 36.46 DBN 83.71 84.05 85.21 FIP+LDA 84.61 86.72 87.51 DLWF 85.93 87.16 88.76 DLWF + 86.72 87.84 91.63 经过在 LFW 人脸库上实验可知,本文提出的人 脸识别算法在非限制条件下的鲁棒性和准确率均高 ·918· 智 能 系 统 学 报 第 10 卷

第6期 孙劲光,等:一种特征加权融合人脸识别方法 .919. 于传统人脸识别算法。通过将人脸面部进行区域划 表6ORL库上不同算法识别率比较 分,分别提取局部抽象特征的方法,比传统仅输入整 Table 6 Comparison of different algorithms on ORL 张人脸像素级特征方法更容易学习得到适合于分类 方法 识别率/% 的局部特征。并通过上述实验证明了本文算法在非 PCA 84.0 限制条件下的有效性。 SVM 88.5 2.20RL人脸库上的实验 DBN 94.0 ORL人脸库又称AT&T人脸库,是剑桥大学历 FIP+LDA 96.0 时2年拍摄完成的,包含40个人,每个人有10幅不 DLWF 97.0 同姿态、表情、光照的图像,共400幅,其中人脸的姿 DLWF 97.0 态和光照变化较小,图像分辨率为112×92,图像背 景为黑色,以PGM格式存储。实验过程中,神经网 3 结束语 络首先利用LFW人脸库中所有人脸图像进行预训 本文提出了一种特征加权融合人脸识别方法, 练,然后在ORL人脸库中每人随机选取5幅图像作 首先通过提取面部特征点将人脸图像划分成多个局 为微调阶段训练样本集,其余的人脸图像作为测试 部区域采样区域,然后将采样区域通过归一化处理 样本集。 后分别输入到对应DBN网络中,求取相似度矩阵, 1)隐含层单元数不同时对比实验 最后进行加权求和得出最终判别结果并计算识别准 本实验目的是为了验证本文提出算法的通用 确率。经过在LFW人脸库上实验证明了本文算法 性,以及在ORL人脸库上,不同隐含层缩放系数所 在非限制条件下进行人脸识别的有效性,并且能够 表现出的识别性能的差异。表5为DBN网络隐含 自下而上提取得到适合于分类的抽象人脸特征。识 层缩放系数不同时的识别结果。 别率达到了91.63%。同时在0RL人脸库上进行的 表5OL库上不同网络结构时正确识别率 实验充分证明了本文算法的通用性和有效性,识别 Table 5 Recognition rate of different network struc- 率达到了较高的97%,表现出了比传统人脸识别更 tures in ORL 高的优越性。 隐含层 DBN DLWF DLWF* 参考文献: 缩放系数 识别率/% 识别率/%识别率/% 0.70 44 57 61 [1]TURK M,PENTLAND A.Eigenfaces for recognition [J]. 0.75 52 64 67 Journal of Cognitive Neuroscience,1991,3(1):71-86. 0.80 71 77 82 [2]SUN Yi,WANG Xiaogang,TANG Xiaoou.Deep learning face representation from predicting 10,000 classes[C]// 0.85 82 86 89 Proceedings of the 2014 IEEE Conference on Computer Vi- 0.90 94 97 97 sion and Pattern Recognition.Columbus,OH,USA,2014: 从表5可知,当隐含层缩放系数逐渐增加时,网 1891-1898. 络逐层提取得到的人脸图像抽象特征的分类识别能 [3]HU Junlin,LU Jiwen,TAN Y P.Discriminative deep met- 力逐渐增强。当网络隐含层缩放系数为0.9时,获 ric learning for face verification in the wild[C]//Proceed- 得了较高识别率97%。 ings of the 2014 IEEE Conference on Computer Vision and 2)与其他人脸识别方法对比实验 Pattern Recognition.Columbus,OH,USA,2014:1875- 为了验证本文提出算法相对于传统人脸识别算 1882 [4]HUANG G B,LEE H,LEARNED-MILLER E.Learning hi- 法所具有的优越性,分别同PCA、SVM和传统DBN erarchical representations for face verification with convolu- 算法做了对比实验,表6为本文提出算法在OL人 tional deep belief networks[C]//Proceedings of the 2012 脸库上与其他算法进行对比的实验结果。实验结果 IEEE Conference on Computer Vision and Pattern Recogni- 表明本文算法具有较好的通用性,与传统人脸识别 tion.Providence,RI,USA,2012:2518-2525. 方法进行比较,在识别率方面具有较为明显的优势。 [5]ZHU Zhenyao,LUO Ping,WANG Xiaogang,et al.Deep learning identity-preserving face space[C]//Proceedings of

于传统人脸识别算法。 通过将人脸面部进行区域划 分,分别提取局部抽象特征的方法,比传统仅输入整 张人脸像素级特征方法更容易学习得到适合于分类 的局部特征。 并通过上述实验证明了本文算法在非 限制条件下的有效性。 2.2 ORL 人脸库上的实验 ORL 人脸库又称 AT&T 人脸库,是剑桥大学历 时 2 年拍摄完成的,包含 40 个人,每个人有 10 幅不 同姿态、表情、光照的图像,共 400 幅,其中人脸的姿 态和光照变化较小,图像分辨率为 112×92,图像背 景为黑色,以 PGM 格式存储。 实验过程中,神经网 络首先利用 LFW 人脸库中所有人脸图像进行预训 练,然后在 ORL 人脸库中每人随机选取 5 幅图像作 为微调阶段训练样本集,其余的人脸图像作为测试 样本集。 1) 隐含层单元数不同时对比实验 本实验目的是为了验证本文提出算法的通用 性,以及在 ORL 人脸库上,不同隐含层缩放系数所 表现出的识别性能的差异。 表 5 为 DBN 网络隐含 层缩放系数不同时的识别结果。 表 5 ORL 库上不同网络结构时正确识别率 Table 5 Recognition rate of different network struc⁃ tures in ORL 隐含层 缩放系数 DBN 识别率/ % DLWF 识别率/ % DLWF + 识别率/ % 0.70 44 57 61 0.75 52 64 67 0.80 71 77 82 0.85 82 86 89 0.90 94 97 97 从表 5 可知,当隐含层缩放系数逐渐增加时,网 络逐层提取得到的人脸图像抽象特征的分类识别能 力逐渐增强。 当网络隐含层缩放系数为 0.9 时,获 得了较高识别率 97%。 2) 与其他人脸识别方法对比实验 为了验证本文提出算法相对于传统人脸识别算 法所具有的优越性,分别同 PCA、SVM 和传统 DBN 算法做了对比实验,表 6 为本文提出算法在 ORL 人 脸库上与其他算法进行对比的实验结果。 实验结果 表明本文算法具有较好的通用性,与传统人脸识别 方法进行比较,在识别率方面具有较为明显的优势。 表 6 ORL 库上不同算法识别率比较 Table 6 Comparison of different algorithms on ORL 方法 识别率/ % PCA 84.0 SVM 88.5 DBN 94.0 FIP+LDA 96.0 DLWF 97.0 DLWF + 97.0 3 结束语 本文提出了一种特征加权融合人脸识别方法, 首先通过提取面部特征点将人脸图像划分成多个局 部区域采样区域,然后将采样区域通过归一化处理 后分别输入到对应 DBN 网络中,求取相似度矩阵, 最后进行加权求和得出最终判别结果并计算识别准 确率。 经过在 LFW 人脸库上实验证明了本文算法 在非限制条件下进行人脸识别的有效性,并且能够 自下而上提取得到适合于分类的抽象人脸特征。 识 别率达到了 91.63%。 同时在 ORL 人脸库上进行的 实验充分证明了本文算法的通用性和有效性,识别 率达到了较高的 97%,表现出了比传统人脸识别更 高的优越性。 参考文献: [1] TURK M, PENTLAND A. Eigenfaces for recognition[ J]. Journal of Cognitive Neuroscience, 1991, 3(1): 71⁃86. [2] SUN Yi, WANG Xiaogang, TANG Xiaoou. Deep learning face representation from predicting 10, 000 classes [ C] / / Proceedings of the 2014 IEEE Conference on Computer Vi⁃ sion and Pattern Recognition. Columbus, OH, USA, 2014: 1891⁃1898. [3]HU Junlin, LU Jiwen, TAN Y P. Discriminative deep met⁃ ric learning for face verification in the wild[C] / / Proceed⁃ ings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH, USA, 2014: 1875⁃ 1882. [4]HUANG G B, LEE H, LEARNED⁃MILLER E. Learning hi⁃ erarchical representations for face verification with convolu⁃ tional deep belief networks [ C] / / Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recogni⁃ tion. Providence, RI, USA, 2012: 2518⁃2525. [5]ZHU Zhenyao, LUO Ping, WANG Xiaogang, et al. Deep learning identity⁃preserving face space[C] / / Proceedings of 第 6 期 孙劲光,等:一种特征加权融合人脸识别方法 ·919·

.920. 智能系统学报 第10卷 the 2013 IEEE International Conference on Computer Vi- [14]MILBORROW S,BISHOP T E,NICOLLS F.Multiview sion.Sydney,NSW,Australia,2013:113-120. active shape models with SIFT descriptors for the 300-W [6]SUN Yi,WANG Xiaogang,TANG Xiaoou.Hybrid deep face landmark challenge [C]//Proceedings of the 2013 learning for face verification[C]//Proceedings of the 2013 IEEE International Conference on Computer Vision Work- IEEE International Conference on Computer Vision.Syd- shops.Sydney,NSW,Australia,2013:378-385. ney,NSW,Australia,2013:1489-1496. [15]Bengio Y,Delalleau 0.On the expressive power of deep [7]TAIGMAN Y,YANG Ming,RANZATO M A,et al.Deep- architectures[C]//Proceedings of the 22nd International face:Closing the gap to human-level performance in face Conference.Espoo,Finland,2011:18-36. verification[C]//Proceedings of the 2014 IEEE Conference [16]HINTON G E.Training products of experts by minimizing on Computer Vision and Pattern Recognition.Columbus, contrastive divergence[J].Neural Computation,2002,14 0H,USA,2014:1701-1708. (8):1771-1800. [8]SUN Yi,CHEN Yuheng,WANG Xiaogang,et al.Deep [17]BENGIO Y.Learning deep architectures for AI[J].Foun- learning face representation by joint identification-verifica- dations and Trends in Machine Learning,2009,2(1):1- tion[J].Advances in Neural Information Processing Sys- 127. tems.2014. 作者简介: [9]HINTON G E,OSINDERO S,TEH Y W.A fast learning 孙劲光,女,1962年生,博士,教授 algorithm for deep belief nets[J].Neural Computation, 博士生导师,计算机学会(CCF)会员 2006,18(7):1527-1554. (21314S),主要研究方向为计算机图像 [10]HINTON G E,SALAKHUTDINOV RR.Reducing the di- 处理、计算机图形学、知识工程。 mensionality of data with neural networks[J].Science, 2006.313(5786):504-507. [11]AREL I,ROSE D C,KARNOWSKI T P.Deep machine learning a new frontier in artificial intelligence research 孟凡宇,男,1991年生,硕士研究 [research frontier][J].IEEE Computational Intelligence 生,主要研究方向为计算机图像处理。 Magazine,2010,5(4):13-18. [12]COOTES T F,TAYLOR C J,COOPER D H,et al.Active shape models-their training and application[].Computer Vision and Image Understanding,1995,61(1):38-59. [13]MILBORROW S,NICOLIS F.Active shape models with SIFT descriptors and MARS[J].VISAPP,2014,1(2):5

the 2013 IEEE International Conference on Computer Vi⁃ sion. Sydney, NSW, Australia, 2013: 113⁃120. [6] SUN Yi, WANG Xiaogang, TANG Xiaoou. Hybrid deep learning for face verification[C] / / Proceedings of the 2013 IEEE International Conference on Computer Vision. Syd⁃ ney, NSW, Australia, 2013: 1489⁃1496. [7]TAIGMAN Y, YANG Ming, RANZATO M A, et al. Deep⁃ face: Closing the gap to human⁃level performance in face verification[C] / / Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH, USA, 2014: 1701⁃1708. [8] SUN Yi, CHEN Yuheng, WANG Xiaogang, et al. Deep learning face representation by joint identification⁃verifica⁃ tion[ J]. Advances in Neural Information Processing Sys⁃ tems. 2014. [9] HINTON G E, OSINDERO S, TEH Y W. A fast learning algorithm for deep belief nets [ J ]. Neural Computation, 2006, 18(7): 1527⁃1554. [10]HINTON G E, SALAKHUTDINOV R R. Reducing the di⁃ mensionality of data with neural networks [ J]. Science, 2006, 313(5786): 504⁃507. [11] AREL I, ROSE D C, KARNOWSKI T P. Deep machine learning a new frontier in artificial intelligence research [research frontier] [ J]. IEEE Computational Intelligence Magazine, 2010, 5(4): 13⁃18. [12]COOTES T F, TAYLOR C J, COOPER D H, et al. Active shape models⁃their training and application[ J]. Computer Vision and Image Understanding, 1995, 61(1): 38⁃59. [13] MILBORROW S, NICOLLS F. Active shape models with SIFT descriptors and MARS[J]. VISAPP, 2014, 1(2): 5. [14] MILBORROW S, BISHOP T E, NICOLLS F. Multiview active shape models with SIFT descriptors for the 300⁃W face landmark challenge [ C] / / Proceedings of the 2013 IEEE International Conference on Computer Vision Work⁃ shops. Sydney, NSW, Australia, 2013: 378⁃385. [15]Bengio Y, Delalleau O. On the expressive power of deep architectures[ C] / / Proceedings of the 22nd International Conference. Espoo, Finland, 2011: 18⁃36. [16]HINTON G E. Training products of experts by minimizing contrastive divergence[J]. Neural Computation, 2002, 14 (8): 1771⁃1800. [17]BENGIO Y. Learning deep architectures for AI[ J]. Foun⁃ dations and Trends in Machine Learning, 2009, 2(1): 1⁃ 127. 作者简介: 孙劲光,女,1962 年生,博士,教授, 博士生导师,计算机学会( CCF) 会员 (21314S),主要研究方向为计算机图像 处理、计算机图形学、知识工程。 孟凡宇,男, 1991 年生,硕士研究 生,主要研究方向为计算机图像处理。 ·920· 智 能 系 统 学 报 第 10 卷