第10卷第6期 智能系统学报 Vol.10 No.6 2015年12月 CAAI Transactions on Intelligent Systems Dee.2015 D0L:10.11992/is.201505006 网络出版地址:http://www.cnki.net/kcms/detail/23.1538.tp.20151111.1700.010.html 分层结构的双人交互行为识别方法 姬晓飞,王昌汇,王扬扬 (沈阳航空航天大学自动化学院,辽宁沈阳110136) 摘要:针对日常生活中双人交互行为因运动区域难以分割,造成无法准确识别的问题,提出了一种基于分层结构 的双人交互行为识别方法。该方法首先按照交互行为双方身体是否接触作为分界点,将整个交互行为分为开始阶 段、执行阶段和结束阶段。将开始阶段与结束阶段左右两侧人体所在矩形区域分别提取作为该兴趣区域,将执行阶 段双人所在矩形区域整体提取作为感兴趣区域,分别提取HOG特征。使用1NN分类器获得每个阶段的每个对象的 识别概率,最终通过加权融合各个阶段各个对象的识别概率实现对该交互行为的识别。利用UT-interaction数据库 对该方法进行测试的实验结果表明,该方法实现简单,并具有良好的识别效果。 关键词:计算机视觉:交互动作;动作识别;方向梯度直方图:分层模型:最近邻分类器;UT-interaction数据库;加 权融合 中图分类号:TP391.4文献标志码:A文章编号:1673-4785(2015)06-0893-08 中文引用格式:姬晓飞,王昌汇,王扬扬.分层结构的双人交互行为识别方法[J].智能系统学报,2015,10(6):893-900. 英文引用格式:JI Xiaofei,WANG Changhui,WANG Yangyang.Human interaction behavior-recognition method based on hierar- chical structure[J].CAAI Transactions on Intelligent Systems,2015,10(6):893-900. Human interaction behavior-recognition method based on hierarchical structure JI Xiaofei,WANG Changhui,WANG Yangyang (School of Automation,Shenyang Aerospace University,Shenyang 110136,China) Abstract:To solve the problem of double interaction behavior recognition,in this paper we propose a novel interac- tion behavior-recognition method based on hierarchical structure.First,the interactive behavior of both areas of body contact is determined as the cut-off point.The interaction process is then divided into three stages-the start, execution,and end stages.We extract the left and right human body regions in the start and end stages,respective- ly.Both human body regions are extracted as a whole in the execute stage.Next,we utilize a histogram of oriented gradients (HOG)descriptor to describe information on the regions of interest of each stage.Thereafter,we use the nearest neighbor classifier to obtain the recognition probability of each object in each stage.Finally,we obtain the recognition result from the weighted fusion of this recognition probability.The experimental results,using the UT- interaction dataset,demonstrate that the proposed approach is easy to implement and has good recognition effect. Keywords:computer vision;human interaction;action recognition;histogram of oriented gradient;layered mod- el;nearest neighbor classifier;ut-interaction database;weighted fusion 基于视频的人体动作识别研究是计算机视觉领 域的重要研究方向,具有广阔的应用前景2)。根 据行为的复杂程度,一般可以把人的行为分成4类: 收稿日期:2015-05-06.网络出版日期:2015-11-11 基金项目:国家自然科学基金资助项目(61103123):辽宁省教育厅科技局部行为、单人行为、双人交互行为、人群行为3)。 研究基金资助项目(L2014066). 通信作者:姬晓飞.E-mail:jixiaofei7804@126.com, 目前,在单人的行为识别领域已经有很多研究成果, 而对于双人交互行为的研究还比较少。其主要原因

第 10 卷第 6 期 智 能 系 统 学 报 Vol.10 №.6 2015 年 12 月 CAAI Transactions on Intelligent Systems Dec. 201 通信作者:姬晓飞. E⁃mail:jixi ( ao L 5 DOI:10.11992 / tis.201505006 网络出版地址:http: / / www.cnki.net / kcms/ detail / 23.1538.tp.20151111.1700.010.html 分层结构的双人交互行为识别方法 姬晓飞,王昌汇,王扬扬 (沈阳航空航天大学 自动化学院,辽宁 沈阳 110136) 摘 要:针对日常生活中双人交互行为因运动区域难以分割,造成无法准确识别的问题,提出了一种基于分层结构 的双人交互行为识别方法。 该方法首先按照交互行为双方身体是否接触作为分界点,将整个交互行为分为开始阶 段、执行阶段和结束阶段。 将开始阶段与结束阶段左右两侧人体所在矩形区域分别提取作为该兴趣区域,将执行阶 段双人所在矩形区域整体提取作为感兴趣区域,分别提取 HOG 特征。 使用 1NN 分类器获得每个阶段的每个对象的 识别概率,最终通过加权融合各个阶段各个对象的识别概率实现对该交互行为的识别。 利用 UT⁃interaction 数据库 对该方法进行测试的实验结果表明,该方法实现简单,并具有良好的识别效果。 关键词:计算机视觉;交互动作;动作识别;方向梯度直方图;分层模型;最近邻分类器;UT⁃interaction 数据库;加 权融合 中图分类号:TP391.4 文献标志码:A 文章编号:1673⁃4785(2015)06⁃0893⁃08 中文引用格式:姬晓飞,王昌汇,王扬扬. 分层结构的双人交互行为识别方法[J]. 智能系统学报, 2015, 10(6): 893⁃900. 英文引用格式:JI Xiaofei,WANG Changhui,WANG Yangyang. Human interaction behavior⁃recognition method based on hierar⁃ chical structure[J]. CAAI Transactions on Intelligent Systems, 2015, 10(6): 893⁃900. Human interaction behavior⁃recognition method based on hierarchical structure JI Xiaofei, WANG Changhui, WANG Yangyang (School of Automation, Shenyang Aerospace University, Shenyang 110136, China) Abstract:To solve the problem of double interaction behavior recognition, in this paper we propose a novel interac⁃ tion behavior⁃recognition method based on hierarchical structure. First, the interactive behavior of both areas of body contact is determined as the cut⁃off point. The interaction process is then divided into three stages⁃the start, execution, and end stages. We extract the left and right human body regions in the start and end stages, respective⁃ ly. Both human body regions are extracted as a whole in the execute stage. Next, we utilize a histogram of oriented gradients (HOG) descriptor to describe information on the regions of interest of each stage. Thereafter, we use the nearest neighbor classifier to obtain the recognition probability of each object in each stage. Finally, we obtain the recognition result from the weighted fusion of this recognition probability. The experimental results, using the UT⁃ interaction dataset, demonstrate that the proposed approach is easy to implement and has good recognition effect. Keywords: computer vision; human interaction; action recognition; histogram of oriented gradient; layered mod⁃ el; nearest neighbor classifier; ut⁃interaction database; weighted fusion 收稿日期:2015⁃05⁃06. 网络出版日期:2015⁃11⁃11. 基金项目:国家自然科学基金资助项目(61103123);辽宁省教育厅科技 基于视频的人体动作识别研究是计算机视觉领 域的重要研究方向,具有广阔的应用前景[1⁃2] 。 研究基金资助项目 f 2 ei 0 7 1 8 4 0 0 4 6 @ 6) 1 . 26.com. 根 据行为的复杂程度,一般可以把人的行为分成 4 类: 局部行为、单人行为、双人交互行为、人群行为[3] 。 目前,在单人的行为识别领域已经有很多研究成果, 而对于双人交互行为的研究还比较少。 其主要原因

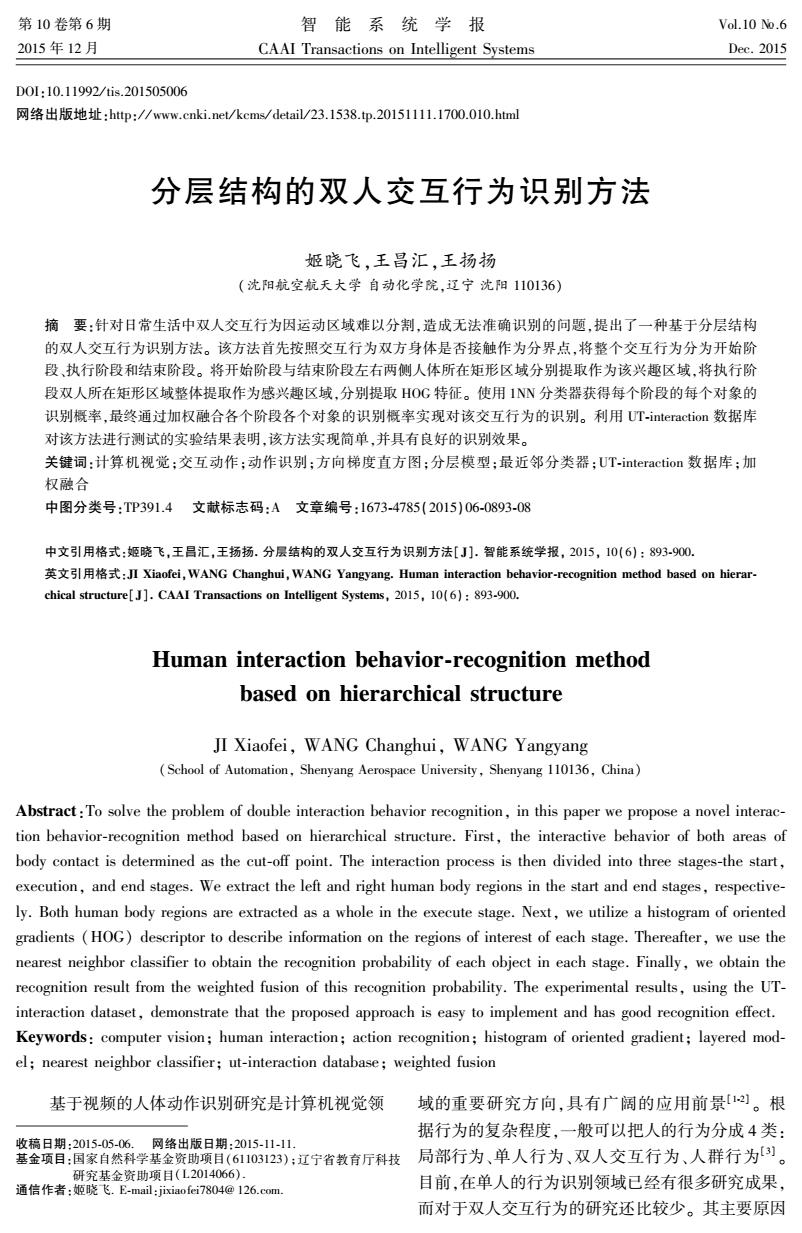

·894 智能系统学报 第10卷 在于,双人交互行为的识别除了具有动作识别所面 的基于整体的识别方法与能够准确描述交互双方行 临的主要困难(图像采集设备的抖动、场景内光照 为的基于个体分割的识别方法相结合,提出了一种 强度的变化、非主要目标的遮挡等),其最主要的问 分层识别方法。该方法采用将整个交互行为过程分 题在于在双人交互行为中,如何描述动作执行双方 为3层,在交互行为的开始阶段与结束阶段分别识 的身体姿态以及交互行为的复杂的时空关系。目 别交互行为双方的个体动作,再融合判断:在交互行 前,对于双人交互行为的识别方法,大致可分为以下 为的执行阶段,将双人交互行为作为一个整体进行 2种,基于整体的交互动作识别和基于个体分割的 识别判断;最终加权融合3个阶段的分类概率。 交互动作识别。 1分层处理 基于整体的交互动作识别方法主要是将交互行 为执行双方看做一个整体,通过描述该整体的时空关 近年来,针对双人交互行为识别的特征提取,可 系来代表其所表示的双人交互行为的特征,通过将待 以分成2种类型:1)将双人交互行为整体作为感兴 测试样本与训练模板的特征进行匹配,来实现交互动 趣区域进行处理[4),这种方法很好地呈现了双人 作的识别和理解。此类方法多关注的是交互动作 交互行为的全局特征,但是无法表现交互行为的内 的时空特征表示及相应的时空匹配算法的研究。Yu 在属性,所以识别的准确性有限:2)将交互行为的 等采用金字塔时空关系匹配核对交互动作进行识 双方分割开来,分别对其所进行的动作进行识别,然 别。Yuan等[6提出构造时空上下文核函数进行交互 后再将识别结果融合判断[910。这种方法虽然很好 视频的匹配识别。这些方法特征提取过程实现简单, 地表达双人交互行为中人与人之间的运动关系,但 但交互动作时空关系匹配的计算复杂度较高,且识别 是在复杂的交互场景下,由于交互在动作的执行过 的准确度不高。近年来,一些研究者引入相对复杂的 程中存在身体遮挡等因素,直接影响了运动目标区 时空特征表示方法对交互行为整体进行描述,以期提 域获取的准确性,这对识别单人原子动作产生了较 高识别的准确度。Burghouts等)通过引入时空布局 大影响。 (spatio-temporal layout)描述来提高时空特征的类间 为了充分表达双人交互行为中双方的运动关 区分能力,大大提高了交互行为识别的准确性:L 系,并且避免交互行为中的遮挡影响单人原子动作 等[]提出了基于GA训练的随机森林方法及有效的 的识别,文中采用分层识别的方法对交互行为进行 时空匹配方法实现交互行为的识别与理解。综上所 识别,其过程如图1所示。 述,基于整体的交互动作识别与理解方法将交互动作 首先,将交互行为分为3个阶段:交互行为开始 作为一个单人动作处理,无需对交互动作的特征进行 阶段、交互行为执行阶段和交互行为结束阶段,对于 动作个体的分割,处理思路简单,但是由于该类方法 各个阶段的感兴趣区域的分割提取,文中采用了不 无法准确表示交互动作中交互的内在属性,因此其识 同的方法。 别的准确性有限,往往需要十分复杂的特征表示及匹 1)交互行为开始阶段:在交互行为开始阶段, 配方法来保证识别的准确性。 交互行为双方的位置关系是由远及近的,在这一过 基于个体分割的交互行为识别与理解方法,就 程中,通过帧间差分的方式,可以获得交互行为双方 是将交互行为理解为单个人的子动作之间的时空组 的剪影信息,根据2个剪影的边界信息,可以分别获 合,在识别的过程中先识别交互行为中单个个体动 得以交互行为双方为主,冗余信息极少的感兴趣区 作的含义,再结合2个个体之间的时空关系,获得最 域,其过程如图2所示。 终的识别结果。Kong等[9提出训练基于SVM的识 2)交互行为执行阶段:在以交互行为双方为主 别模型对交互动作进行识别:Slimanit10]等提出了一 的2个感兴趣区域间的距离为0时,交互行为双方 种基于共生视觉词典的方法。该类方法原理简单、 身体出现接触,从这一时刻开始,意味着双人交互行 容易实现,但识别谁确性不高。总之,基于个体分割 为的准备阶段结束,双人交互行为进入执行阶段。 的交互动作识别与理解方法或者需要对人体的肢体 在这一个阶段中,为了避免由于交互行为双方身体 部分进行跟踪检测,或者需要对原子动作进行识别, 接触遮挡对于单人原子动作分割的影响,本文将双 在复杂的交互行为场景下,由于具有遮挡等因素的 人交互行为整体所在区域作为感兴趣区域,进行分 影响,准确地得到人体部分区域并准确地识别原子 割提取操作,文中采用帧间差分的方法,基于剪影特 动作是很难保证的。 征的边界信息分割提取双人交互行为的感兴趣区 基于以上分析,本文将能够完整表述全局信息 域。其过程如图3所示

在于,双人交互行为的识别除了具有动作识别所面 临的主要困难(图像采集设备的抖动、场景内光照 强度的变化、非主要目标的遮挡等),其最主要的问 题在于在双人交互行为中,如何描述动作执行双方 的身体姿态以及交互行为的复杂的时空关系。 目 前,对于双人交互行为的识别方法,大致可分为以下 2 种,基于整体的交互动作识别和基于个体分割的 交互动作识别。 基于整体的交互动作识别方法主要是将交互行 为执行双方看做一个整体,通过描述该整体的时空关 系来代表其所表示的双人交互行为的特征,通过将待 测试样本与训练模板的特征进行匹配,来实现交互动 作的识别和理解[4] 。 此类方法多关注的是交互动作 的时空特征表示及相应的时空匹配算法的研究。 Yu 等[5]采用金字塔时空关系匹配核对交互动作进行识 别。 Yuan 等[6]提出构造时空上下文核函数进行交互 视频的匹配识别。 这些方法特征提取过程实现简单, 但交互动作时空关系匹配的计算复杂度较高,且识别 的准确度不高。 近年来,一些研究者引入相对复杂的 时空特征表示方法对交互行为整体进行描述,以期提 高识别的准确度。 Burghouts 等[7]通过引入时空布局 (spatio⁃temporal layout)描述来提高时空特征的类间 区分能力,大大提高了交互行为识别的准确性;Li 等[8]提出了基于 GA 训练的随机森林方法及有效的 时空匹配方法实现交互行为的识别与理解。 综上所 述,基于整体的交互动作识别与理解方法将交互动作 作为一个单人动作处理,无需对交互动作的特征进行 动作个体的分割,处理思路简单,但是由于该类方法 无法准确表示交互动作中交互的内在属性,因此其识 别的准确性有限,往往需要十分复杂的特征表示及匹 配方法来保证识别的准确性。 基于个体分割的交互行为识别与理解方法,就 是将交互行为理解为单个人的子动作之间的时空组 合,在识别的过程中先识别交互行为中单个个体动 作的含义,再结合 2 个个体之间的时空关系,获得最 终的识别结果。 Kong 等[9]提出训练基于 SVM 的识 别模型对交互动作进行识别;Slimani [10]等提出了一 种基于共生视觉词典的方法。 该类方法原理简单、 容易实现,但识别准确性不高。 总之,基于个体分割 的交互动作识别与理解方法或者需要对人体的肢体 部分进行跟踪检测,或者需要对原子动作进行识别, 在复杂的交互行为场景下,由于具有遮挡等因素的 影响,准确地得到人体部分区域并准确地识别原子 动作是很难保证的。 基于以上分析,本文将能够完整表述全局信息 的基于整体的识别方法与能够准确描述交互双方行 为的基于个体分割的识别方法相结合,提出了一种 分层识别方法。 该方法采用将整个交互行为过程分 为 3 层,在交互行为的开始阶段与结束阶段分别识 别交互行为双方的个体动作,再融合判断;在交互行 为的执行阶段,将双人交互行为作为一个整体进行 识别判断;最终加权融合 3 个阶段的分类概率。 1 分层处理 近年来,针对双人交互行为识别的特征提取,可 以分成 2 种类型:1)将双人交互行为整体作为感兴 趣区域进行处理[4⁃8] ,这种方法很好地呈现了双人 交互行为的全局特征,但是无法表现交互行为的内 在属性,所以识别的准确性有限;2) 将交互行为的 双方分割开来,分别对其所进行的动作进行识别,然 后再将识别结果融合判断[9⁃10] 。 这种方法虽然很好 地表达双人交互行为中人与人之间的运动关系,但 是在复杂的交互场景下,由于交互在动作的执行过 程中存在身体遮挡等因素,直接影响了运动目标区 域获取的准确性,这对识别单人原子动作产生了较 大影响。 为了充分表达双人交互行为中双方的运动关 系,并且避免交互行为中的遮挡影响单人原子动作 的识别,文中采用分层识别的方法对交互行为进行 识别,其过程如图 1 所示。 首先,将交互行为分为 3 个阶段:交互行为开始 阶段、交互行为执行阶段和交互行为结束阶段,对于 各个阶段的感兴趣区域的分割提取,文中采用了不 同的方法。 1)交互行为开始阶段:在交互行为开始阶段, 交互行为双方的位置关系是由远及近的,在这一过 程中,通过帧间差分的方式,可以获得交互行为双方 的剪影信息,根据 2 个剪影的边界信息,可以分别获 得以交互行为双方为主,冗余信息极少的感兴趣区 域,其过程如图 2 所示。 2)交互行为执行阶段:在以交互行为双方为主 的 2 个感兴趣区域间的距离为 0 时,交互行为双方 身体出现接触,从这一时刻开始,意味着双人交互行 为的准备阶段结束,双人交互行为进入执行阶段。 在这一个阶段中,为了避免由于交互行为双方身体 接触遮挡对于单人原子动作分割的影响,本文将双 人交互行为整体所在区域作为感兴趣区域,进行分 割提取操作,文中采用帧间差分的方法,基于剪影特 征的边界信息分割提取双人交互行为的感兴趣区 域。 其过程如图 3 所示。 ·894· 智 能 系 统 学 报 第 10 卷

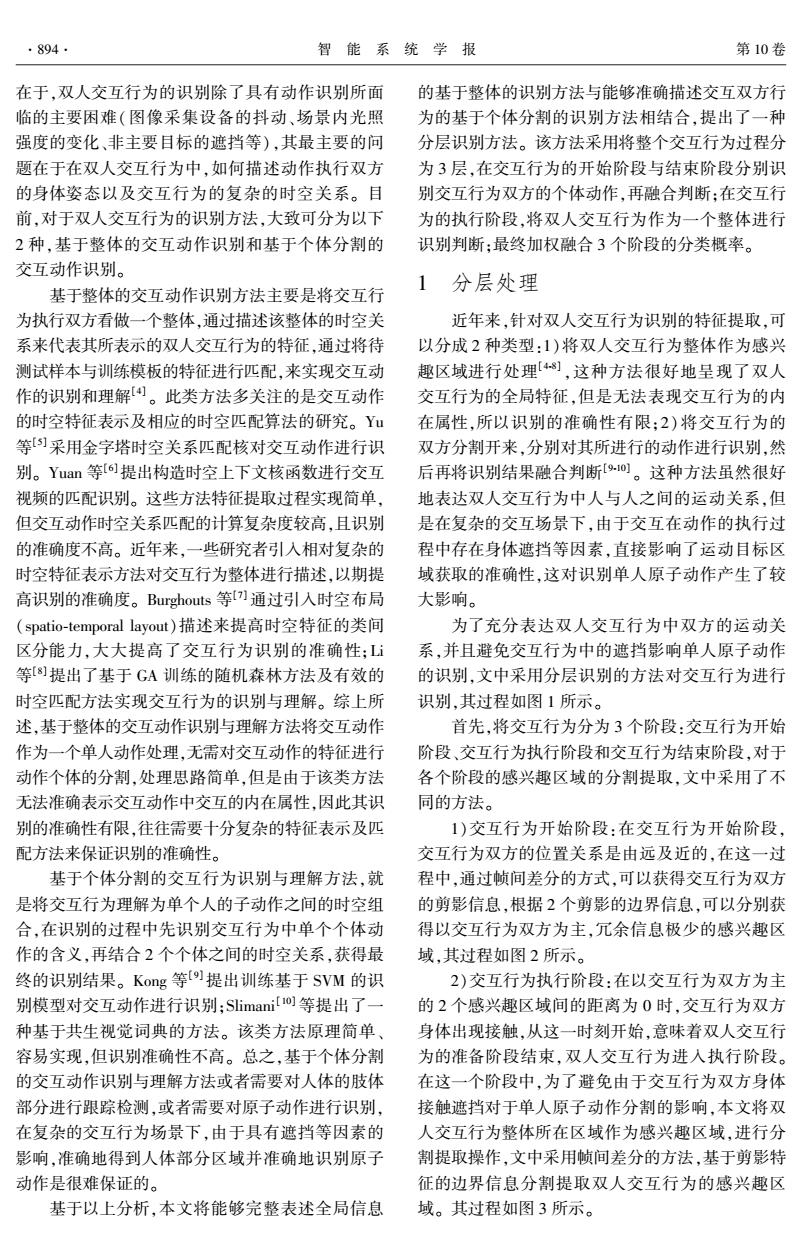

第6期 姬晓飞,等:分层结构的双人交互行为识别方法 .895. 交互行为开始阶段 交互行为执行阶段 交互行为结束阶段 提取 感兴趣区域 形成HOG 描述符 训练集形成的 训练集形成的 训练集形成的 训练集形成的 训练集形成的 获得各阶段 ln分类器 1nn分类器 lnn分类器 1nn分类器 ln分类器 识别概率 00099. 夏■ 加权融合获得 最终识别概率 图1分层识别方法结构图 Fig.1 Structure diagram of hierarchical recognition method 双方的距离逐渐拉开,但是双方的动作中仍然包含 针对不同交互行为的单人原子动作的特性。在这一 相邻帧帧差 顏訟绫 阶段,采用与开始阶段相同的感兴趣区域分割提取 方法,分别切割提取,帧差后交互行为双方间躯体剪 值化 提取感兴 趣区域 影的边界信息确定的矩形区域为感兴趣区域。 2 HOG特征的提取 图2 帧差法提取剪影所在感兴趣区域 为了能够在有效地描述感兴趣区域内的全局信 Fig.2 Frame difference extract the ROl 息的同时降低特征提取的复杂程度,文中采用HOG 描述符对每帧图像的感兴趣区域进行表征。 HOG特征]是一种不需要在相邻帧间进行处 理的简单全局特征表示法,其只需要在当前帧像素 相翎帧帧差 点间求取梯度的幅值和方向,并在不同方向区域上 对像素点幅值大小进行直方图统计即可。在完成统 计后,对当前帧各个方向区域的像素点幅值统计结 值化 果进行归一化处理,这样能够避免感兴趣区域变化 带来的尺度干扰问题。本文在提取HOG特征时具 体的流程如图4所示。 提取 感兴趣 双人所在区域 图3帧差法提取剪影所在感兴趣区域 Fig.3 Frame difference extract the ROl 3)交互行为结束阶段:当双人交互行为进行到 一定程度时,交互行为双方结束身体接触,交互行为 (a)原图一 (b)图一分区域(©)图一HOG特征

图 1 分层识别方法结构图 Fig.1 Structure diagram of hierarchical recognition method 图 2 帧差法提取剪影所在感兴趣区域 Fig.2 Frame difference extract the ROI 图 3 帧差法提取剪影所在感兴趣区域 Fig.3 Frame difference extract the ROI 3)交互行为结束阶段:当双人交互行为进行到 一定程度时,交互行为双方结束身体接触,交互行为 双方的距离逐渐拉开,但是双方的动作中仍然包含 针对不同交互行为的单人原子动作的特性。 在这一 阶段,采用与开始阶段相同的感兴趣区域分割提取 方法,分别切割提取,帧差后交互行为双方间躯体剪 影的边界信息确定的矩形区域为感兴趣区域。 2 HOG 特征的提取 为了能够在有效地描述感兴趣区域内的全局信 息的同时降低特征提取的复杂程度,文中采用 HOG 描述符对每帧图像的感兴趣区域进行表征。 HOG 特征[11]是一种不需要在相邻帧间进行处 理的简单全局特征表示法,其只需要在当前帧像素 点间求取梯度的幅值和方向,并在不同方向区域上 对像素点幅值大小进行直方图统计即可。 在完成统 计后,对当前帧各个方向区域的像素点幅值统计结 果进行归一化处理,这样能够避免感兴趣区域变化 带来的尺度干扰问题。 本文在提取 HOG 特征时具 体的流程如图 4 所示。 第 6 期 姬晓飞,等:分层结构的双人交互行为识别方法 ·895·

·896. 智能系统学报 第10卷 式中:心:代表分类票数,P:代表识别概率。 3.2分层识别概率的加权融合 通过使用帧帧最近邻分类器可以分别获得交互 行为开始阶段单人原子动作的识别概率、交互行为 (d)原图二 (e)图二分区域(D图二HOG特征 执行阶段整体的识别概率以及交互行为结束阶段单 图4不同阶段感兴趣区域HOG提取框图 人原子行为的识别概率。 Fig.4 HOG descriptor extraction of ROI in different stages 将3个阶段的识别概率进行融合的过程,分为: 1)计算图像的梯度 1)交互行为开始阶段,单人原子行为识别概率 T(x)=√P.(,y)+P,(x,y) (1) 的融合:在交互行为开始阶段,本文将交互行为双方 P(x.y) 身体所在感兴趣区域进行分别提取和识别,这样可 0=aretanp,(x.y) (2) 以分别获得交互行为双方在开始阶段的识别概率, 式中:T(x,y)和0分别表示像素点(x,y)梯度的 通过将两者加权融合,可以获得交互行为开始阶段 幅值大小和方向,P(x,y)和P,(x.y)分别为图像 的识别概率: 上任意像素点(x,y)的水平和垂直方向梯度。如 Pstan Ws X P wsx Par (6) 图4(b)和(e)分别为图像中各个像素点上梯度的 式中:P为待测试动作图像序列开始阶段的最终 直观表示。 的识别概率,P,为交互行为开始阶段左侧执行人所 2)梯度的直方图统计 做动作的识别概率,P为交互行为开始阶段右侧执 将1)中求取的梯度图像均等地划分为P× 行人所做动作的识别概率,01是融合过程中,左侧 Q(P=Q=4)个不重叠的子区域,并以每个子区域 执行人动作识别概率的权值,0是右侧执行人动作 的中心点为原点的圆周内,分割成大小相同的 识别概率的权值。权值经由大量实验获得。 K(K=12)个不重叠的扇形区间,在每个扇形区域 2)交互行为结束阶段,单人原子行为识别概率 内统计该子区域的所有像素点梯度,叠加所有子区 的融合:在交互行为结束阶段的单人原子行为识别 域的直方图特征构成最后的P×Q×K维特征向量。 概率融合的方法与在开始阶段融合的方法相同: Ped=04×P.+10erXP.e (7) 3 动作识别 式中:P为结束阶段的最终识别概率,权值0a与 3.1帧帧最近邻识别方法 w.经由大量的实验获得。 帧帧最近邻识别方法是一种简单有效的识 3)三阶段识别概率融合:分别获得3个阶段的 别方法,识别单人动作速度很快2。为了简化 识别概率后,通过加权融合的方式可以得到待测试 达到保证算法的实时性,文中选取了帧帧最近邻 动作图像序列的最终识别概率及结果: 的方法作为最终的识别方法。帧帧最近邻识别 PFinal=0,XPtn+0m×Pmiddle+0。×Pnd(8)) 方法如式(3)所示: 式中:P为待测试动作图像序列最终识别概率, g;(x)minlxxl ,k=1,2,...,c (3) P.为交互行为执行阶段识别概率,各个阶段的识 式中:x为待测试的样本的HOG描述符,x为训练 别概率加权参数心,、wm以及w.通过比较3个阶段 集中,第i类动作的第k帧所形成的HOG描述符。 的平均识别率获得,分别为25%、40%及35%。 通过式(3)可以求得与待测试样本距离最近的训练 4 实验与结果分析 集样本帧所属动作类别,就可以判断,待测样本与距 离最近的训练集样本帧属于同一动作类别。 4.1数据库信息 统计待测试动作图像序列某一阶段的每一帧的 本文所用实验数据均来自UT-interaction数据 识别结果,能够得到该图像序列在这一阶段的分类 库),其中包含2个子数据库,每个子数据库中包 票数结果,将该分类票数结果进行归一化操作可得 含握手、拥抱、踢、指、推、拳击6类动作,每类动作下 到该图像序列在这一阶段的识别概率: 包含有10个动作视频,除掉指动作,整个数据库由 V=U1,2,…,。 (4) 15人在真实场景下两两完成。该数据库中的视频 场景内大多含有杂乱的背景、相机抖动、变化的光照 Pi=- ,i=1,2,…,c (5) 等挑战因素。该数据库被广泛用于双人交互行为识 i=1 别研究中。本文的实验数据集由UT-interaction数

图 4 不同阶段感兴趣区域 HOG 提取框图 Fig.4 HOG descriptor extraction of ROI in different stages 1)计算图像的梯度 T(xi, yj) = Px (xi, yj) 2 + Py (xi, yj) 2 (1) θ = arctan Px(xi, yj) Py(xi, yj) (2) 式中: T(xi, yj) 和 θ 分别表示像素点 (xi, yj) 梯度的 幅值大小和方向, Px(xi, yj) 和 Py(xi, yj) 分别为图像 上任意像素点 (xi, yj) 的水平和垂直方向梯度。 如 图 4 (b)和(e)分别为图像中各个像素点上梯度的 直观表示。 2)梯度的直方图统计 将 1) 中求取的梯度图像均等地划分为 P × Q(P = Q = 4) 个不重叠的子区域,并以每个子区域 的中心 点 为 原 点 的 圆 周 内, 分 割 成 大 小 相 同 的 K(K =12) 个不重叠的扇形区间,在每个扇形区域 内统计该子区域的所有像素点梯度,叠加所有子区 域的直方图特征构成最后的 P × Q × K 维特征向量。 3 动作识别 3.1 帧帧最近邻识别方法 帧帧最近邻识别方法是一种简单有效的识 别方法,识别单人动作速度很快[ 12] 。 为了简化 达到保证算法的实时性,文中选取了帧帧最近邻 的方法作为最终的识别方法。 帧帧最近邻识别 方法如式( 3)所示: gi(x) = min‖x - x k i ‖,k = 1,2,…,c (3) 式中: x 为待测试的样本的 HOG 描述符, x k i 为训练 集中,第 i 类动作的第 k 帧所形成的 HOG 描述符。 通过式(3)可以求得与待测试样本距离最近的训练 集样本帧所属动作类别,就可以判断,待测样本与距 离最近的训练集样本帧属于同一动作类别。 统计待测试动作图像序列某一阶段的每一帧的 识别结果,能够得到该图像序列在这一阶段的分类 票数结果,将该分类票数结果进行归一化操作可得 到该图像序列在这一阶段的识别概率: V = v1 ,v2 ,…,vc (4) pi = vi ∑ c i = 1 vi ,i = 1,2,…,c (5) 式中: vi 代表分类票数, pi 代表识别概率。 3.2 分层识别概率的加权融合 通过使用帧帧最近邻分类器可以分别获得交互 行为开始阶段单人原子动作的识别概率、交互行为 执行阶段整体的识别概率以及交互行为结束阶段单 人原子行为的识别概率。 将 3 个阶段的识别概率进行融合的过程,分为: 1)交互行为开始阶段,单人原子行为识别概率 的融合:在交互行为开始阶段,本文将交互行为双方 身体所在感兴趣区域进行分别提取和识别,这样可 以分别获得交互行为双方在开始阶段的识别概率, 通过将两者加权融合,可以获得交互行为开始阶段 的识别概率: Pstart = wsl × Psl + wsr × Psr (6) 式中: Pstart 为待测试动作图像序列开始阶段的最终 的识别概率, Psl 为交互行为开始阶段左侧执行人所 做动作的识别概率, Psr 为交互行为开始阶段右侧执 行人所做动作的识别概率, wsl 是融合过程中,左侧 执行人动作识别概率的权值, wsr 是右侧执行人动作 识别概率的权值。 权值经由大量实验获得。 2)交互行为结束阶段,单人原子行为识别概率 的融合:在交互行为结束阶段的单人原子行为识别 概率融合的方法与在开始阶段融合的方法相同: Pend = wel × Pel + wer × Per (7) 式中: Pend 为结束阶段的最终识别概率,权值 wel 与 wer 经由大量的实验获得。 3)三阶段识别概率融合:分别获得 3 个阶段的 识别概率后,通过加权融合的方式可以得到待测试 动作图像序列的最终识别概率及结果: PFinal = ws × Pstart + wm × Pmiddle + we × Pend (8) 式中: PFinal 为待测试动作图像序列最终识别概率, Pmiddle 为交互行为执行阶段识别概率,各个阶段的识 别概率加权参数 ws 、 wm 以及 we 通过比较 3 个阶段 的平均识别率获得,分别为 25%、40%及 35%。 4 实验与结果分析 4.1 数据库信息 本文所用实验数据均来自 UT⁃interaction 数据 库[13] ,其中包含 2 个子数据库,每个子数据库中包 含握手、拥抱、踢、指、推、拳击 6 类动作,每类动作下 包含有 10 个动作视频,除掉指动作,整个数据库由 15 人在真实场景下两两完成。 该数据库中的视频 场景内大多含有杂乱的背景、相机抖动、变化的光照 等挑战因素。 该数据库被广泛用于双人交互行为识 别研究中。 本文的实验数据集由 UT⁃interaction 数 ·896· 智 能 系 统 学 报 第 10 卷

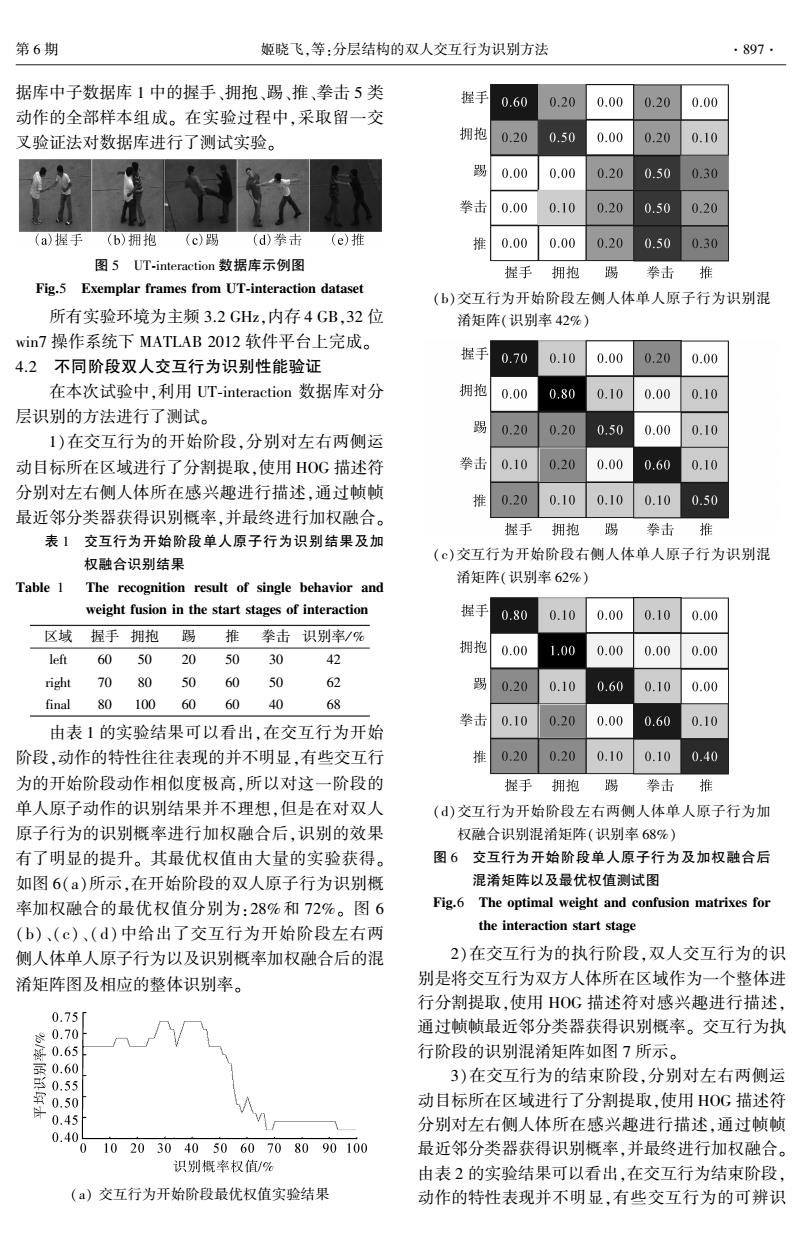

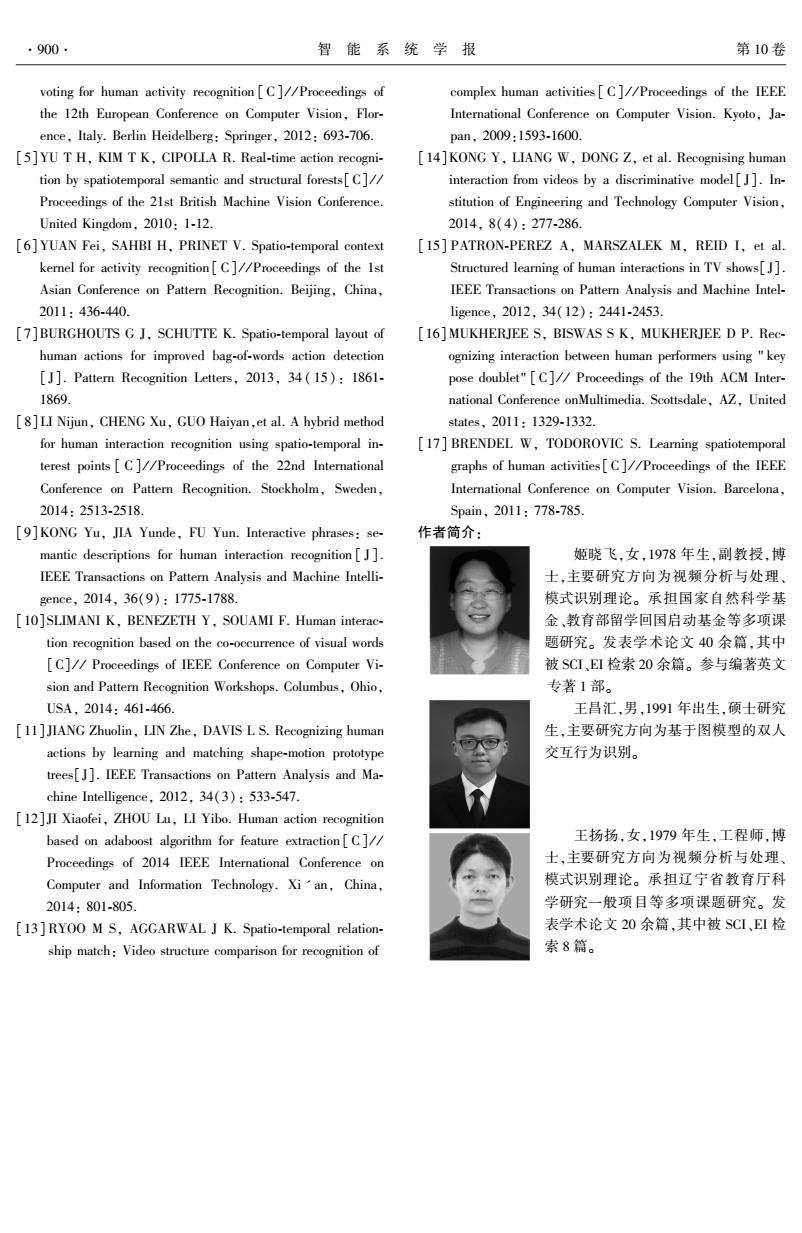

第6期 姬晓飞,等:分层结构的双人交互行为识别方法 ·897. 据库中子数据库1中的握手、拥抱、踢、推、拳击5类 握手 0.60 0.20 0.00 0.20 0.00 动作的全部样本组成。在实验过程中,采取留一交 叉验证法对数据库进行了测试实验。 拥抱 0.20 0.50 0.00 0.20 0.10 踢 0.00 0.00 0.20 0.50 0.30 拳击 0.00 0.10 0.20 0.50 0.20 (a)握手 (b)拥抱(c)踢(d)拳击 (e)推 推 0.00 0.00 0.20 0.50 0.30 图5UT-interaction数据库示例图 握手 拥抱 踢 拳击 推 Fig.5 Exemplar frames from UT-interaction dataset (b)交互行为开始阶段左侧人体单人原子行为识别混 所有实验环境为主频3.2GHz,内存4GB,32位 淆矩阵(识别率42%)】 win7操作系统下MATLAB2012软件平台上完成。 握手 4.2不同阶段双人交互行为识别性能验证 0.70 0.10 0.00 0.20 0.00 在本次试验中,利用UT-interaction数据库对分 拥抱 0.00 0.80 0.10 0.00 0.10 层识别的方法进行了测试。 雪 0.20 0.20 0.50 0.00 0.10 1)在交互行为的开始阶段,分别对左右两侧运 动目标所在区域进行了分割提取,使用HOG描述符 拳击 0.10 0.20 0.00 0.60 0.10 分别对左右侧人体所在感兴趣进行描述,通过帧帧 推 0.20 0.10 0.10 0.10 0.50 最近邻分类器获得识别概率,并最终进行加权融合。 握手 拥抱 踢 拳击 推 表1交互行为开始阶段单人原子行为识别结果及加 (©)交互行为开始阶段右侧人体单人原子行为识别混 权融合识别结果 淆矩阵(识别率62%) Table 1 The recognition result of single behavior and weight fusion in the start stages of interaction 握手 0.80 0.10 0.00 0.10 0.00 区域握手拥抱踢推拳击识别率/% 拥抱 left 42 0.00 1.00 0.00 0.00 0.00 6050205030 right 7080 5060 50 62 雪 0.20 0.10 0.60 0.10 0.00 final80100606040 68 拳击 0.10 0.20 0.00 0.60 0.10 由表1的实验结果可以看出,在交互行为开始 阶段,动作的特性往往表现的并不明显,有些交互行 推 0.20 0.20 0.10 0.10 0.40 为的开始阶段动作相似度极高,所以对这一阶段的 握手拥抱 踢 拳击 推 单人原子动作的识别结果并不理想,但是在对双人 ()交互行为开始阶段左右两侧人体单人原子行为加 原子行为的识别概率进行加权融合后,识别的效果 权融合识别混淆矩阵(识别率68%) 有了明显的提升。其最优权值由大量的实验获得。 图6交互行为开始阶段单人原子行为及加权融合后 如图6(a)所示,在开始阶段的双人原子行为识别概 混淆矩阵以及最优权值测试图 率加权融合的最优权值分别为:28%和72%。图6 Fig.6 The optimal weight and confusion matrixes for (b)、(c)、(d)中给出了交互行为开始阶段左右两 the interaction start stage 侧人体单人原子行为以及识别概率加权融合后的混 2)在交互行为的执行阶段,双人交互行为的识 淆矩阵图及相应的整体识别率。 别是将交互行为双方人体所在区域作为一个整体进 行分割提取,使用HOG描述符对感兴趣进行描述, 0.75 °0.70 通过帧帧最近邻分类器获得识别概率。交互行为执 解0.65 行阶段的识别混淆矩阵如图7所示。 s9 3)在交互行为的结束阶段,分别对左右两侧运 氧 0.50 动目标所在区域进行了分割提取,使用HOG描述符 0.45 分别对左右侧人体所在感兴趣进行描述,通过帧帧 0.40 0102030405060708090100 最近邻分类器获得识别概率,并最终进行加权融合。 识别概率权值/% 由表2的实验结果可以看出,在交互行为结束阶段, (a)交互行为开始阶段最优权值实验结果 动作的特性表现并不明显,有些交互行为的可辨识

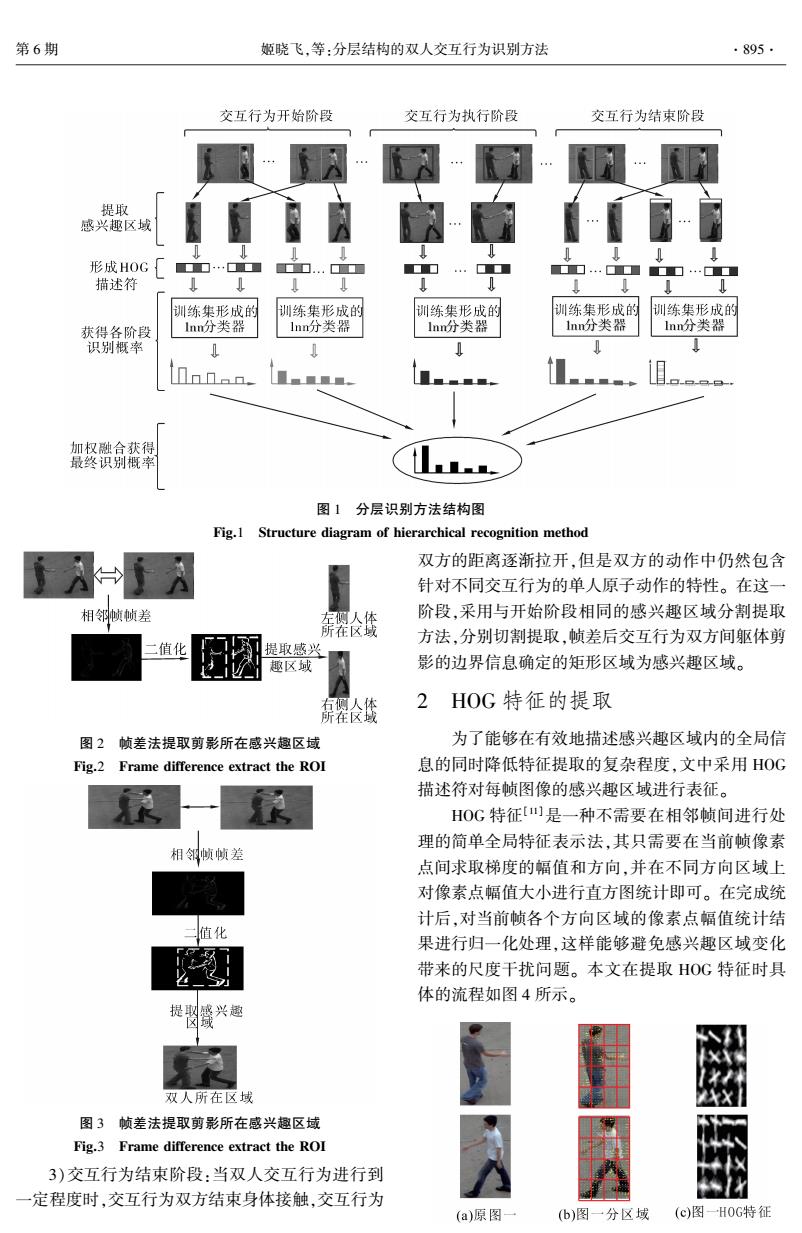

据库中子数据库 1 中的握手、拥抱、踢、推、拳击 5 类 动作的全部样本组成。 在实验过程中,采取留一交 叉验证法对数据库进行了测试实验。 图 5 UT⁃interaction 数据库示例图 Fig.5 Exemplar frames from UT⁃interaction dataset 所有实验环境为主频 3.2 GHz,内存 4 GB,32 位 win7 操作系统下 MATLAB 2012 软件平台上完成。 4.2 不同阶段双人交互行为识别性能验证 在本次试验中,利用 UT⁃interaction 数据库对分 层识别的方法进行了测试。 1)在交互行为的开始阶段,分别对左右两侧运 动目标所在区域进行了分割提取,使用 HOG 描述符 分别对左右侧人体所在感兴趣进行描述,通过帧帧 最近邻分类器获得识别概率,并最终进行加权融合。 表 1 交互行为开始阶段单人原子行为识别结果及加 权融合识别结果 Table 1 The recognition result of single behavior and weight fusion in the start stages of interaction 区域 握手 拥抱 踢 推 拳击 识别率/ % left 60 50 20 50 30 42 right 70 80 50 60 50 62 final 80 100 60 60 40 68 由表 1 的实验结果可以看出,在交互行为开始 阶段,动作的特性往往表现的并不明显,有些交互行 为的开始阶段动作相似度极高,所以对这一阶段的 单人原子动作的识别结果并不理想,但是在对双人 原子行为的识别概率进行加权融合后,识别的效果 有了明显的提升。 其最优权值由大量的实验获得。 如图 6(a)所示,在开始阶段的双人原子行为识别概 率加权融合的最优权值分别为:28%和 72%。 图 6 (b)、(c)、( d) 中给出了交互行为开始阶段左右两 侧人体单人原子行为以及识别概率加权融合后的混 淆矩阵图及相应的整体识别率。 (a) 交互行为开始阶段最优权值实验结果 (b)交互行为开始阶段左侧人体单人原子行为识别混 淆矩阵(识别率 42%) (c)交互行为开始阶段右侧人体单人原子行为识别混 淆矩阵(识别率 62%) (d)交互行为开始阶段左右两侧人体单人原子行为加 权融合识别混淆矩阵(识别率 68%) 图 6 交互行为开始阶段单人原子行为及加权融合后 混淆矩阵以及最优权值测试图 Fig.6 The optimal weight and confusion matrixes for the interaction start stage 2)在交互行为的执行阶段,双人交互行为的识 别是将交互行为双方人体所在区域作为一个整体进 行分割提取,使用 HOG 描述符对感兴趣进行描述, 通过帧帧最近邻分类器获得识别概率。 交互行为执 行阶段的识别混淆矩阵如图 7 所示。 3)在交互行为的结束阶段,分别对左右两侧运 动目标所在区域进行了分割提取,使用 HOG 描述符 分别对左右侧人体所在感兴趣进行描述,通过帧帧 最近邻分类器获得识别概率,并最终进行加权融合。 由表 2 的实验结果可以看出,在交互行为结束阶段, 动作的特性表现并不明显,有些交互行为的可辨识 第 6 期 姬晓飞,等:分层结构的双人交互行为识别方法 ·897·

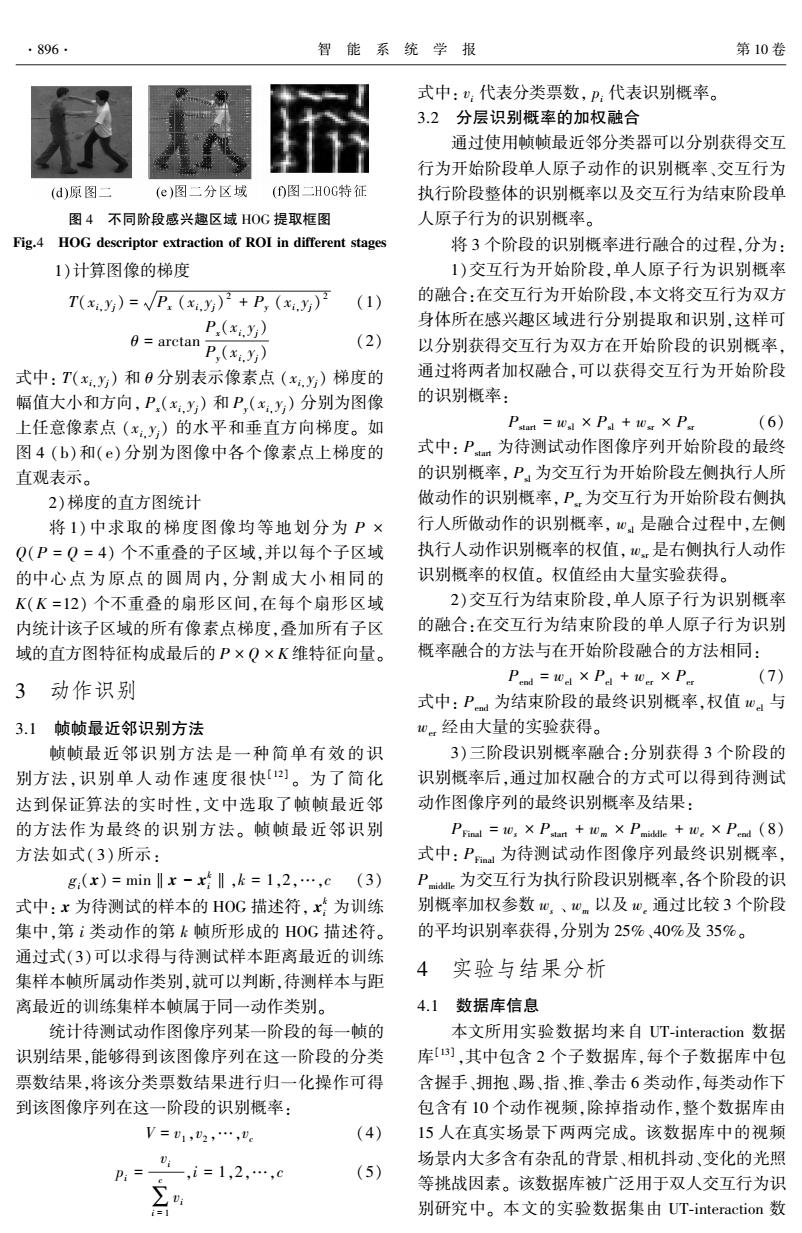

·898 智能系统学报 第10卷 度较低,所以在这一阶段单人原子动作的识别结果 握手 0.70 0.20 0.00 0.10 0.00 并不理想,但是在对左右两侧人体单人原子行为识 别概率进行加权融合后,识别的效果有了明显的提 拥抱 0.20 0.80 0.00 0.00 0.00 升。其最优权值由大量的实验获得。如图8(a)所 踢 0.10 0.00 0.90 0.00 0.00 示,在开始阶段的双人原子行为识别概率加权融合 的最优权值分别为:36%和64%。图8(b)、(c)、 拳击 0.00 050 0.10 0.20 0.20 ()中给出了交互行为结束阶段左右两侧人体单人 推 0.10 0.00 0.10 0.20 0.60 原子行为以及识别概率加权融合后的混淆矩阵图及 握手 拥抱 踢 拳击 推 相应的整体识别率。 (©)交互行为结束阶段右侧人体单人原子行为识别混 握手 1.00 0.00 0.00 0.00 0.00 淆矩阵(识别率64%) 拥抱 0.00 1.00 0.00 0.00 0.00 握手 0.90 0.10 0.00 0.00 0.00 踢 0.10 0.00 0.70 0.20 0.00 拥抱 0.20 0.80 0.00 0.00 0.00 拳击 0.00 0.00 0.10 0.50 0.40 踢 0.10 0.00 0.80 0.10 0.00 0.00 0.30 0.00 0.10 0.60 拳击 0.00 0.20 0.10 0.40 0.30 握手 拥抱 踢 拳击 推 推 0.00 0.00 0.10 0.20 0.70 图7 交互行为执行阶段双人交互行为识别混淆矩阵 握手 拥抱 拳击 农 (识别率76%)】 (d)交互行为结束阶段左右两侧人体单人原子行为加 Fig.7 Confusion matrixes for execution of interaction 权融合识别混淆矩阵(识别率72%) 表2交互行为结束阶段单人原子行为识别结果及加 图8交互行为结束阶段单人原子行为及加权融合后 权融合识别结果 混淆矩阵以及最优权值测试图 Table 2 The recognition result of single behavior and Fig.8 The optimal weight and Confusion matrixes for weight fusion in the end stages of interaction the interaction end stage 区域握手拥抱踢推拳击识别率/% 4)交互行为三阶段识别概率融合:根据交互行 Left 9060 20 30 70 54 为开始阶段以及交互行为结束阶段左右两侧单人原 Right 70 80 90 2060 64 子行为识别概率加权融合的最优权值选择过程,可 final 90 80 80 40 70 72 以发现,交互行为不同对象或不同阶段之间的识别 0.72 0.70 概率加权融合的最优权值差值与它们之间的平均识 0.68 解0.66 别率差值正相关,如表3所示。 0.64 表3交互行为开始与结束阶段单人原子行为识别率 0.62 0.60 与融合权值关系 0.58 Table 3 The relationship between recognition rate and 0.56 0.54 weight of each stage 0102030405060708090100 识别概率权值/% 识别率 权值 阶段 识别率差权值差/% (a)交互行为结束阶段最优权值实验结果 left right left right 握手 62 28 20 44 0.90 0.10 0.00 0.00 0.00 开始42 12 结束54 64 36 64 o 28 拥抱 0.10 0.60 0.10 0.10 0.10 所以,在双人交互行为识别最终的三阶段识别 踢 0.30 0.10 0.20 0.10 0.30 概率融合过程,本文根据各个阶段的平均识别率设 拳击 0.20 0.00 0.20 0.30 0.30 置的权值为:交互行为开始阶段识别概率加权参数 25%(该阶段平均识别率68%):交互行为执行阶段 0.00 0.10 0.10 0.10 0.70 识别概率加权参数40%(该阶段平均识别率76%): 握手 拥抱 踢 拳击 推 交互行为开始阶段识别概率加权参数35%(该阶段 (b)交互行为结束阶段左侧人体单人原子行为识别混 平均识别率72%)。实验结果对比如表4所示。通 淆矩阵(识别率54%)》 过将最终加权融合的识别结果与各个阶段识别结果

度较低,所以在这一阶段单人原子动作的识别结果 并不理想,但是在对左右两侧人体单人原子行为识 别概率进行加权融合后,识别的效果有了明显的提 升。 其最优权值由大量的实验获得。 如图 8( a)所 示,在开始阶段的双人原子行为识别概率加权融合 的最优权值分别为:36% 和 64%。 图 8 ( b)、 ( c)、 (d)中给出了交互行为结束阶段左右两侧人体单人 原子行为以及识别概率加权融合后的混淆矩阵图及 相应的整体识别率。 图 7 交互行为执行阶段双人交互行为识别混淆矩阵 (识别率 76%) Fig.7 Confusion matrixes for execution of interaction 表 2 交互行为结束阶段单人原子行为识别结果及加 权融合识别结果 Table 2 The recognition result of single behavior and weight fusion in the end stages of interaction 区域 握手 拥抱 踢 推 拳击 识别率/ % Left 90 60 20 30 70 54 Right 70 80 90 20 60 64 final 90 80 80 40 70 72 (a) 交互行为结束阶段最优权值实验结果 (b)交互行为结束阶段左侧人体单人原子行为识别混 淆矩阵(识别率 54%) (c)交互行为结束阶段右侧人体单人原子行为识别混 淆矩阵(识别率 64%) (d)交互行为结束阶段左右两侧人体单人原子行为加 权融合识别混淆矩阵(识别率 72%) 图 8 交互行为结束阶段单人原子行为及加权融合后 混淆矩阵以及最优权值测试图 Fig.8 The optimal weight and Confusion matrixes for the interaction end stage 4)交互行为三阶段识别概率融合:根据交互行 为开始阶段以及交互行为结束阶段左右两侧单人原 子行为识别概率加权融合的最优权值选择过程,可 以发现,交互行为不同对象或不同阶段之间的识别 概率加权融合的最优权值差值与它们之间的平均识 别率差值正相关,如表 3 所示。 表 3 交互行为开始与结束阶段单人原子行为识别率 与融合权值关系 Table 3 The relationship between recognition rate and weight of each stage 阶段 识别率 left right 权值 left right 识别率差 权值差/ % 开始 42 62 28 72 20 44 结束 54 64 36 64 10 28 所以,在双人交互行为识别最终的三阶段识别 概率融合过程,本文根据各个阶段的平均识别率设 置的权值为:交互行为开始阶段识别概率加权参数 25%(该阶段平均识别率 68%);交互行为执行阶段 识别概率加权参数 40%(该阶段平均识别率 76%); 交互行为开始阶段识别概率加权参数 35%(该阶段 平均识别率 72%)。 实验结果对比如表 4 所示。 通 过将最终加权融合的识别结果与各个阶段识别结果 ·898· 智 能 系 统 学 报 第 10 卷

第6期 姬晓飞,等:分层结构的双人交互行为识别方法 ·899- 进行对比能够发现,动作“握手”、“拥抱”以及“踢” 表5不同方法在UT-interaction数据库中的动作识别结果 这3种动作的识别率达到100%,动作“推”的识别 比较 率达到70%,优于各个阶段的识别效果,动作“拳 Table 5 Comparison of different algorithms for interaction 击”的识别率达到80%,优于各个阶段的识别效果。 recognition in UT-interaction dataset 表4各个阶段与最终融合识别效果 方法 识别率/% 用时/s Table 4 Each stages and the final fusion recognition results Three stage HOG+Inn 90 9.2578 不同阶段握手拥抱踢 推拳击识别率/9% global template +local 3D 85 开始阶段 80 100 60 6040 68 feature+discriminative model4] 执行阶段 100100 70 50 60 76 3D XYT s-t volume BoW+ 41 结束阶段 90 80804070 72 co-occurrence matrix[is] 最终融合 1001001007080 90 KLT tracking detection+local 图9给出了交互行为三阶段识别概率加权融合 descriptors+structured SVM(5] 84 后的最终识别混淆矩阵图。 Bipartite graph+key pose doublets(] 79.17 握手 1.00 0.00 0.00 0.00 0.00 2D+t tubes+spatio-temporal 拥抱 0.00 1.00 0.00 0.00 relationships graph mode) 78.9 14.2 0.00 踢 0.00 0.00 1.00 0.00 0.00 5 结束语 拳击 0.00 0.00 0.10 0.70 0.20 文中提出了一种将交互行为分阶段处理再融合 推 0.00 0.10 0.00 0.10 0.80 的方法,在交互行为的开始阶段和结束阶段,对交互 握手 拥抱 踢 拳击推 行为双方人体所在区域分别进行分割提取,这样能 图9三阶段识别概率加权融合混淆矩阵 够在最大程度的保留交互动作的动作特性的同时, Fig.9 The three stage recognition probability weigh- 减少包含复杂环境等因素的冗余背景信息的影响: ted fusion confusion matrix 在交互行为执行极端采用将接触的双方整体切割出 从混淆矩阵中可以看到,本文方法对大部 来的方式,即减少了冗余背景信息的影响,也避免了 分双人交互动作均能够正确识别,其识别率可 由于人体遮挡导致误分割情况造成的错误识别。在 达90%,尤其是对“握手”、“拥抱”及“踢”动作 UT-interaction数据库上的大量实验证明,该方法实 能够100%正确识别。从混淆矩阵的观察来看, 现简单,对交互行为有较好的识别效果。本文所提 动作“推”和“拳击”2组动作相互间存在较高的 出的方法对相似动作间的区分仍然存在一定误差, 识别误差,主要原因在于这2组动作的相似性 下一步的研究重点将是进一步完善特征的表示和识 较高造成。 别模型的构建,进一步提高识别率。 4.3不同方法识别效果比较 参考文献: 在表5中给出了近年来同样在UT-interaction 数据库中进行双人交互行为的识别结果。将本文所 [1]WEINLAND D,RONFARD R,BOYER E.A survey of vi- sion-based methods for action representation,segmentation 提出的方法与其进行比较,进而验证本方法对于双 and recognition[J].Computer Vision and Image Under- 人交互行为优秀的识别性能。 standing,2011,115(2):224-241. 从表5的实验结果对比可以看出,本文所提 [2]SEO H J,MILANFAR P.Action recognition from one exam- 出的方法在识别交互行为的准确率方面要明显 ple[J].IEEE Transactions on pattern Analysis and Machine 优于其他的识别方法。在识别速度方面,本文提 Intelligence,2011,33(5):867-882. 出的方法平均速度达到0.1416s/帧,由于样本 [3]吴联世,夏利民,罗大庸.人的交互行为识别与理解研 集帧数不同,对数据库的平均识别速度达到 究综述[J].计算机应用与软件,2011,28(11):60-63. 9.2578s/视频(各个视频平均包含65.38帧)。 WU Lianshi,XIA Limin,LUO Dayong.Survey on human interactive behaviour recognition and comprehension[J]. 相比于其他的识别方法,本文提出的识别方法的 Computer Applications and Software,2011,28(11):60- 优点在于并不需要建立复杂的概率模型,同时实 63. 验表明识别准确率较高。 [4]YU Gang,YUAN Junsong,LIU Zicheng.Propagative hough

进行对比能够发现,动作“握手”、“拥抱”以及“踢” 这 3 种动作的识别率达到 100%,动作“推”的识别 率达到 70%,优于各个阶段的识别效果,动作“拳 击”的识别率达到 80%,优于各个阶段的识别效果。 表 4 各个阶段与最终融合识别效果 Table 4 Each stages and the final fusion recognition results 不同阶段 握手 拥抱 踢 推 拳击 识别率/ % 开始阶段 80 100 60 60 40 68 执行阶段 100 100 70 50 60 76 结束阶段 90 80 80 40 70 72 最终融合 100 100 100 70 80 90 图 9 给出了交互行为三阶段识别概率加权融合 后的最终识别混淆矩阵图。 图 9 三阶段识别概率加权融合混淆矩阵 Fig.9 The three stage recognition probability weigh⁃ ted fusion confusion matrix 从混 淆 矩 阵 中 可 以 看 到,本 文 方 法 对 大 部 分双人交互动作均能够正确识别,其识别率可 达 90% ,尤其是对“ 握手” 、 “ 拥抱” 及“ 踢” 动作 能够 100%正确识别。 从混淆矩阵的观察来看, 动作“ 推” 和“ 拳击” 2 组动作相互间存在较高的 识别误差,主要原因在于这 2 组动作的相似性 较高造成。 4.3 不同方法识别效果比较 在表 5 中给出了近年来同样在 UT⁃interaction 数据库中进行双人交互行为的识别结果。 将本文所 提出的方法与其进行比较,进而验证本方法对于双 人交互行为优秀的识别性能。 从表 5 的实验结果对比可以看出,本文所提 出的方法在识别交互行为的准确率方面要明显 优于其他的识别方法。 在识别速度方面,本文提 出的方法平均速度达到 0. 141 6 s/ 帧,由于样本 集帧 数 不 同, 对 数 据 库 的 平 均 识 别 速 度 达 到 9.257 8 s/ 视频( 各个视频平均包含 65. 38 帧) 。 相比于其他的识别方法,本文提出的识别方法的 优点在于并不需要建立复杂的概率模型,同时实 验表明识别准确率较高。 表 5 不同方法在 UT⁃interaction 数据库中的动作识别结果 比较 Table 5 Comparison of different algorithms for interaction recognition in UT⁃interaction dataset 方法 识别率/ % 用时/ s Three stage HOG+1nn 90 9.2578 global template +local 3D feature+ discriminative model [14] 85 — 3D XYT s⁃t volume + BoW + co⁃occurrence matrix [15] 41 — KLT tracking detection+local descriptors+structured SVM [15] 84 — Bipartite graph+key pose doublets [16] 79.17 — 2D+t tubes+spatio⁃temporal relationships graph model [17] 78.9 14.2 5 结束语 文中提出了一种将交互行为分阶段处理再融合 的方法,在交互行为的开始阶段和结束阶段,对交互 行为双方人体所在区域分别进行分割提取,这样能 够在最大程度的保留交互动作的动作特性的同时, 减少包含复杂环境等因素的冗余背景信息的影响; 在交互行为执行极端采用将接触的双方整体切割出 来的方式,即减少了冗余背景信息的影响,也避免了 由于人体遮挡导致误分割情况造成的错误识别。 在 UT⁃interaction 数据库上的大量实验证明,该方法实 现简单,对交互行为有较好的识别效果。 本文所提 出的方法对相似动作间的区分仍然存在一定误差, 下一步的研究重点将是进一步完善特征的表示和识 别模型的构建,进一步提高识别率。 参考文献: [1]WEINLAND D, RONFARD R, BOYER E. A survey of vi⁃ sion⁃based methods for action representation, segmentation and recognition [ J]. Computer Vision and Image Under⁃ standing, 2011, 115(2): 224⁃241. [ 2]SEO H J, MILANFAR P. Action recognition from one exam⁃ ple[J]. IEEE Transactions on pattern Analysis and Machine Intelligence, 2011, 33(5): 867⁃882. [3]吴联世, 夏利民, 罗大庸. 人的交互行为识别与理解研 究综述[J]. 计算机应用与软件, 2011, 28 (11): 60⁃63. WU Lianshi, XIA Limin, LUO Dayong. Survey on human interactive behaviour recognition and comprehension [ J ]. Computer Applications and Software, 2011, 28 ( 11): 60⁃ 63. [4]YU Gang, YUAN Junsong, LIU Zicheng. Propagative hough 第 6 期 姬晓飞,等:分层结构的双人交互行为识别方法 ·899·

·900· 智能系统学报 第10卷 voting for human activity recognition [C]//Proceedings of complex human activities [C]//Proceedings of the IEEE the 12th European Conference on Computer Vision,Flor- International Conference on Computer Vision.Kyoto,Ja- ence,Italy.Berlin Heidelberg:Springer,2012:693-706. pan,2009:1593-1600. [5]YU T H,KIM T K,CIPOLLA R.Real-time action recogni- [14]KONG Y,LIANG W,DONG Z,et al.Recognising human tion by spatiotemporal semantic and structural forests[C]// interaction from videos by a discriminative model[J].In- Proceedings of the 21st British Machine Vision Conference. stitution of Engineering and Technology Computer Vision, United Kingdom,2010:1-12. 2014,8(4):277-286. [6]YUAN Fei,SAHBI H,PRINET V.Spatio-temporal context [15]PATRON-PEREZ A,MARSZALEK M,REID I,et al. kernel for activity recognition[C]//Proceedings of the Ist Structured learning of human interactions in TV shows[J. Asian Conference on Pattern Recognition.Beijing,China, IEEE Transactions on Pattern Analysis and Machine Intel- 2011:436-440. ligence,2012,34(12):2441-2453. [7]BURGHOUTS G J,SCHUTTE K.Spatio-temporal layout of [16]MUKHERJEE S,BISWAS S K,MUKHERJEE D P.Rec- human actions for improved bag-of-words action detection ognizing interaction between human performers using "key [J].Pattern Recognition Letters,2013,34(15):1861- pose doublet"[C]//Proceedings of the 19th ACM Inter- 1869. national Conference onMultimedia.Scottsdale,AZ,United [8]LI Nijun,CHENG Xu,GUO Haiyan,et al.A hybrid method states,2011:1329-1332. for human interaction recognition using spatio-temporal in- [17]BRENDEL W,TODOROVIC S.Learning spatiotemporal terest points[C]//Proceedings of the 22nd International graphs of human activities[C]//Proceedings of the IEEE Conference on Pattern Recognition.Stockholm,Sweden, International Conference on Computer Vision.Barcelona, 2014:2513-2518. Spain,2011:778-785. [9]KONG Yu,JIA Yunde,FU Yun.Interactive phrases:se- 作者简介: mantic descriptions for human interaction recognition[J]. 姬晓飞,女,1978年生,副教授,博 IEEE Transactions on Pattern Analysis and Machine Intelli- 士,主要研究方向为视频分析与处理、 gence,.2014,36(9):1775-1788. 模式识别理论。承担国家自然科学基 [10]SLIMANI K,BENEZETH Y,SOUAMI F.Human interac- 金、教育部留学回国启动基金等多项课 tion recognition based on the co-occurrence of visual words 题研究。发表学术论文40余篇,其中 [C]//Proceedings of IEEE Conference on Computer Vi- 被SCI、EI检索20余篇。参与编著英文 sion and Pattern Recognition Workshops.Columbus,Ohio, 专著1部。 USA,2014:461-466. 王昌汇,男,1991年出生,硕士研究 [11]JIANG Zhuolin,LIN Zhe,DAVIS L S.Recognizing human 生,主要研究方向为基于图模型的双人 actions by learning and matching shape-motion prototype 交互行为识别。 trees[J].IEEE Transactions on Pattern Analysis and Ma- chine Intelligence,2012,34(3):533-547. [12]JI Xiaofei,ZHOU Lu,LI Yibo.Human action recognition based on adaboost algorithm for feature extraction[C]// 王扬扬,女,1979年生,工程师,博 Proceedings of 2014 IEEE International Conference on 士,主要研究方向为视频分析与处理、 Computer and Information Technology.Xi'an,China, 模式识别理论。承担辽宁省教育厅科 2014:801-805. 学研究一般项目等多项课题研究。发 [13]RYOO M S,AGGARWAL J K.Spatio-temporal relation- 表学术论文20余篇,其中被SC1EI检 ship match:Video structure comparison for recognition of 索8篇

voting for human activity recognition [ C] / / Proceedings of the 12th European Conference on Computer Vision, Flor⁃ ence, Italy. Berlin Heidelberg: Springer, 2012: 693⁃706. [5]YU T H, KIM T K, CIPOLLA R. Real⁃time action recogni⁃ tion by spatiotemporal semantic and structural forests[C] / / Proceedings of the 21st British Machine Vision Conference. United Kingdom, 2010: 1⁃12. [6]YUAN Fei, SAHBI H, PRINET V. Spatio⁃temporal context kernel for activity recognition [ C] / / Proceedings of the 1st Asian Conference on Pattern Recognition. Beijing, China, 2011: 436⁃440. [7]BURGHOUTS G J, SCHUTTE K. Spatio⁃temporal layout of human actions for improved bag⁃of⁃words action detection [J]. Pattern Recognition Letters, 2013, 34 ( 15): 1861⁃ 1869. [8]LI Nijun, CHENG Xu, GUO Haiyan,et al. A hybrid method for human interaction recognition using spatio⁃temporal in⁃ terest points [ C] / / Proceedings of the 22nd International Conference on Pattern Recognition. Stockholm, Sweden, 2014: 2513⁃2518. [9]KONG Yu, JIA Yunde, FU Yun. Interactive phrases: se⁃ mantic descriptions for human interaction recognition [ J]. IEEE Transactions on Pattern Analysis and Machine Intelli⁃ gence, 2014, 36(9): 1775⁃1788. [10]SLIMANI K, BENEZETH Y, SOUAMI F. Human interac⁃ tion recognition based on the co⁃occurrence of visual words [C] / / Proceedings of IEEE Conference on Computer Vi⁃ sion and Pattern Recognition Workshops. Columbus, Ohio, USA, 2014: 461⁃466. [11]JIANG Zhuolin, LIN Zhe, DAVIS L S. Recognizing human actions by learning and matching shape⁃motion prototype trees[J]. IEEE Transactions on Pattern Analysis and Ma⁃ chine Intelligence, 2012, 34(3): 533⁃547. [12]JI Xiaofei, ZHOU Lu, LI Yibo. Human action recognition based on adaboost algorithm for feature extraction [ C] / / Proceedings of 2014 IEEE International Conference on Computer and Information Technology. Xi ' an, China, 2014: 801⁃805. [13] RYOO M S, AGGARWAL J K. Spatio⁃temporal relation⁃ ship match: Video structure comparison for recognition of complex human activities [ C] / / Proceedings of the IEEE International Conference on Computer Vision. Kyoto, Ja⁃ pan, 2009:1593⁃1600. [14]KONG Y, LIANG W, DONG Z, et al. Recognising human interaction from videos by a discriminative model[ J]. In⁃ stitution of Engineering and Technology Computer Vision, 2014, 8(4): 277⁃286. [15] PATRON⁃PEREZ A, MARSZALEK M, REID I, et al. Structured learning of human interactions in TV shows[J]. IEEE Transactions on Pattern Analysis and Machine Intel⁃ ligence, 2012, 34(12): 2441⁃2453. [16]MUKHERJEE S, BISWAS S K, MUKHERJEE D P. Rec⁃ ognizing interaction between human performers using " key pose doublet" [C] / / Proceedings of the 19th ACM Inter⁃ national Conference onMultimedia. Scottsdale, AZ, United states, 2011: 1329⁃1332. [17] BRENDEL W, TODOROVIC S. Learning spatiotemporal graphs of human activities[C] / / Proceedings of the IEEE International Conference on Computer Vision. Barcelona, Spain, 2011: 778⁃785. 作者简介: 姬晓飞,女,1978 年生,副教授,博 士,主要研究方向为视频分析与处理、 模式识别理论。 承担国家自然科学基 金、教育部留学回国启动基金等多项课 题研究。 发表学术论文 40 余篇,其中 被 SCI、EI 检索 20 余篇。 参与编著英文 专著 1 部。 王昌汇,男,1991 年出生,硕士研究 生,主要研究方向为基于图模型的双人 交互行为识别。 王扬扬,女,1979 年生,工程师,博 士,主要研究方向为视频分析与处理、 模式识别理论。 承担辽宁省教育厅科 学研究一般项目等多项课题研究。 发 表学术论文 20 余篇,其中被 SCI、EI 检 索 8 篇。 ·900· 智 能 系 统 学 报 第 10 卷