第3卷第2期 智能系统学报 Vol.3 No2 2008年4月 CAAI Transactions on Intelligent Systems Apr.2008 机器人视觉伺服研究综述 方勇纯 (南开大学信息技术科学学院,天津300071) 摘要:首先对于3种机器人视觉伺服策略,即基于位置的视觉伺服、基于图像的视觉伺服以及2.5维视觉伺服进行 了讨论.然后,对于视觉同服的研究方向和面临的主要问题,如机器人位姿提取、视觉同服系统的不确定性研究、图 像空间的路径规划、智能视觉伺服等进行了分析和讨论.在此基础上,对于机器人视觉伺服领域的未来研究重点,包 括如何使参考点位于视场之内,高速伺服策路以及鲁棒视觉伺服技术进行了分析和展望 关键词:机器人;视觉伺服:轨迹规划,鲁棒性 中图分类号:TP24文献标识码:A文章编号:1673-4785(2008)02-0109-06 A survey of robot visual servoing FANG Yong-chun (College of Information Technical Science,Nankai University,Tianjin 300071,China) Abstract:In this survey of visual servoing in robotics three visual servoing strategies are discussed:posi- tiombased visual servoing,image-based visual servoing,and 2.5 D visual servoing.The main research di- rections and some challenging problems in the visual servoing field are discussed,including the extraction of position/pose information from images,uncertainties in visual servoing systems,path planning in an im- age space,and intelligent visual seroving.Additionally,possible future research areas are analyzed.Ex- amples are the challenge of keeping reference points within camera images,fast servoing strategies,and robust visual servoing technologies. Key words:robot;visual servoing;path planning;robustness 为了使机器人能够在不确定动态环境下工作,踪!.这是一个集计算机、机器视觉、自动控制、机 必须提高它的学习能力与智能化水平,使其在恶劣 器人、实时系统分析等领域于一体的新兴交叉学 或者危险环境下完成自身定位、地图构建、自主搜索 科).近年来,随着图像处理模式识别等领域的快 等任务.为此,必须为机器人本体装配各种传感器, 速发展,图像中蕴含的信息被更多地挖掘出来并得 使它们能够获取关于外部环境的有关信息。 以应用,视觉伺服的精度和可靠性也日益提高,因此 视觉传感器由于具有成本低、信息丰富、算法简 增强了机器人对周围环境的学习能力,使其能够根 单、可靠性高等优点而被广泛应用于机器人控制系 据对环境的了解来进行智能决策,并完成指定的任 统,因此基于视觉的机器人控制视觉伺服逐渐 务 发展成为机器人领域最活跃的研究方向之一.所谓 1机器人视觉伺服策略 机器人视觉伺服,就是采用视觉传感器来间接检测 机器人当前位姿或者其关于目标体的相对位姿,在 根据反馈信息类型的差别,机器人视觉伺服一 此基础上,实现机器人的定位控制或者轨迹跟 般分为基于位置的视觉伺服(三维视觉伺服)和基于 图像的视觉伺服(二维视觉伺服)2种).由于这2 收稿日期:2007-0920. 种伺服方法各自存在不同的缺陷,后来又提出了将 基金项目:因家自然科学基金资助项目(60574027):天津市应用基础 研究计划资助项目(0刀CYBC05400) 两者相结合的2.5维视觉伺服方法 通讯作者:方勇纯.Email:yfang@robot.nankai..edu.cn. 1.1基于位置的视觉伺服 基于位置的视觉伺服基本结构如图1所示,它 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.htp://www.cnki.net

第 3 卷第 2 期 智 能 系 统 学 报 Vol. 3 №. 2 2008 年 4 月 CAA I Transactions on Intelligent Systems Apr. 2008 机器人视觉伺服研究综述 方勇纯 (南开大学 信息技术科学学院 , 天津 300071) 摘 要 :首先对于 3 种机器人视觉伺服策略 ,即基于位置的视觉伺服、基于图像的视觉伺服以及 2. 5 维视觉伺服进行 了讨论. 然后 ,对于视觉伺服的研究方向和面临的主要问题 ,如机器人位姿提取、视觉伺服系统的不确定性研究、图 像空间的路径规划、智能视觉伺服等进行了分析和讨论. 在此基础上 ,对于机器人视觉伺服领域的未来研究重点 ,包 括如何使参考点位于视场之内 ,高速伺服策略以及鲁棒视觉伺服技术进行了分析和展望. 关键词 :机器人 ;视觉伺服 ;轨迹规划 ;鲁棒性 中图分类号 : TP24 文献标识码 :A 文章编号 :167324785 (2008) 0220109206 A survey of robot visual servoing FAN G Yong2chun (College of Information Technical Science , Nankai University , Tianjin 300071 ,China) Abstract :In t his survey of visual servoing in robotics t hree visual servoing strategies are discussed : posi2 tion2based visual servoing , image2based visual servoing , and 2. 5 D visual servoing. The main research di2 rections and some challenging problems in t he visual servoing field are discussed , including t he extraction of position/ pose information from images , uncertainties in visual servoing systems , pat h planning in an im2 age space , and intelligent visual seroving. Additionally , po ssible f ut ure research areas are analyzed. Ex2 amples are t he challenge of keeping reference points wit hin camera images , fast servoing strategies , and robust visual servoing technologies. Keywords :robot ; visual servoing ; pat h planning ; robust ness 收稿日期 :2007209220. 基金项目 :国家自然科学基金资助项目(60574027) ;天津市应用基础 为了使机器人能够在不确定动态环境下工作 , 必须提高它的学习能力与智能化水平 ,使其在恶劣 或者危险环境下完成自身定位、地图构建、自主搜索 等任务. 为此 ,必须为机器人本体装配各种传感器 , 使它们能够获取关于外部环境的有关信息 研究计划资助项目(07J CYBJ C05400) . 通讯作者 :方勇纯. E2mail : yfang @robot . nankai. edu. cn. . 视觉传感器由于具有成本低、信息丰富、算法简 单、可靠性高等优点而被广泛应用于机器人控制系 统 ,因此基于视觉的机器人控制 ———视觉伺服逐渐 发展成为机器人领域最活跃的研究方向之一. 所谓 机器人视觉伺服 ,就是采用视觉传感器来间接检测 机器人当前位姿或者其关于目标体的相对位姿 ,在 此基础上 , 实现机器人的定位控制或者轨迹跟 踪[122 ] . 这是一个集计算机、机器视觉、自动控制、机 器人、实时系统分析等领域于一体的新兴交叉学 科[324 ] . 近年来 ,随着图像处理、模式识别等领域的快 速发展 ,图像中蕴含的信息被更多地挖掘出来并得 以应用 ,视觉伺服的精度和可靠性也日益提高 ,因此 增强了机器人对周围环境的学习能力 ,使其能够根 据对环境的了解来进行智能决策 ,并完成指定的任 务. 1 机器人视觉伺服策略 根据反馈信息类型的差别 ,机器人视觉伺服一 般分为基于位置的视觉伺服(三维视觉伺服) 和基于 图像的视觉伺服 (二维视觉伺服) 2 种[5 ] . 由于这 2 种伺服方法各自存在不同的缺陷 ,后来又提出了将 两者相结合的 2. 5 维视觉伺服方法. 1. 1 基于位置的视觉伺服 基于位置的视觉伺服基本结构如图 1 所示 ,它 © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net

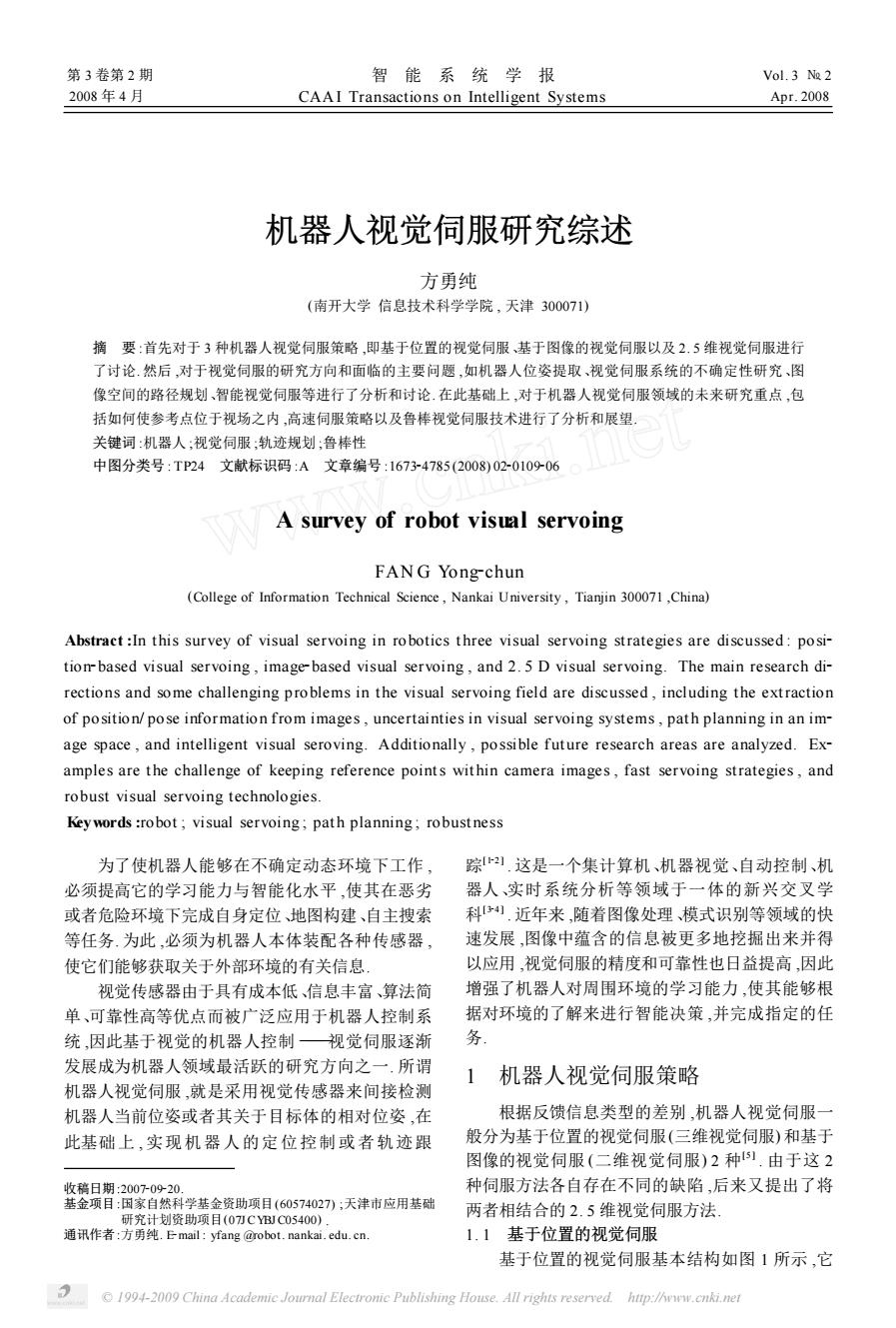

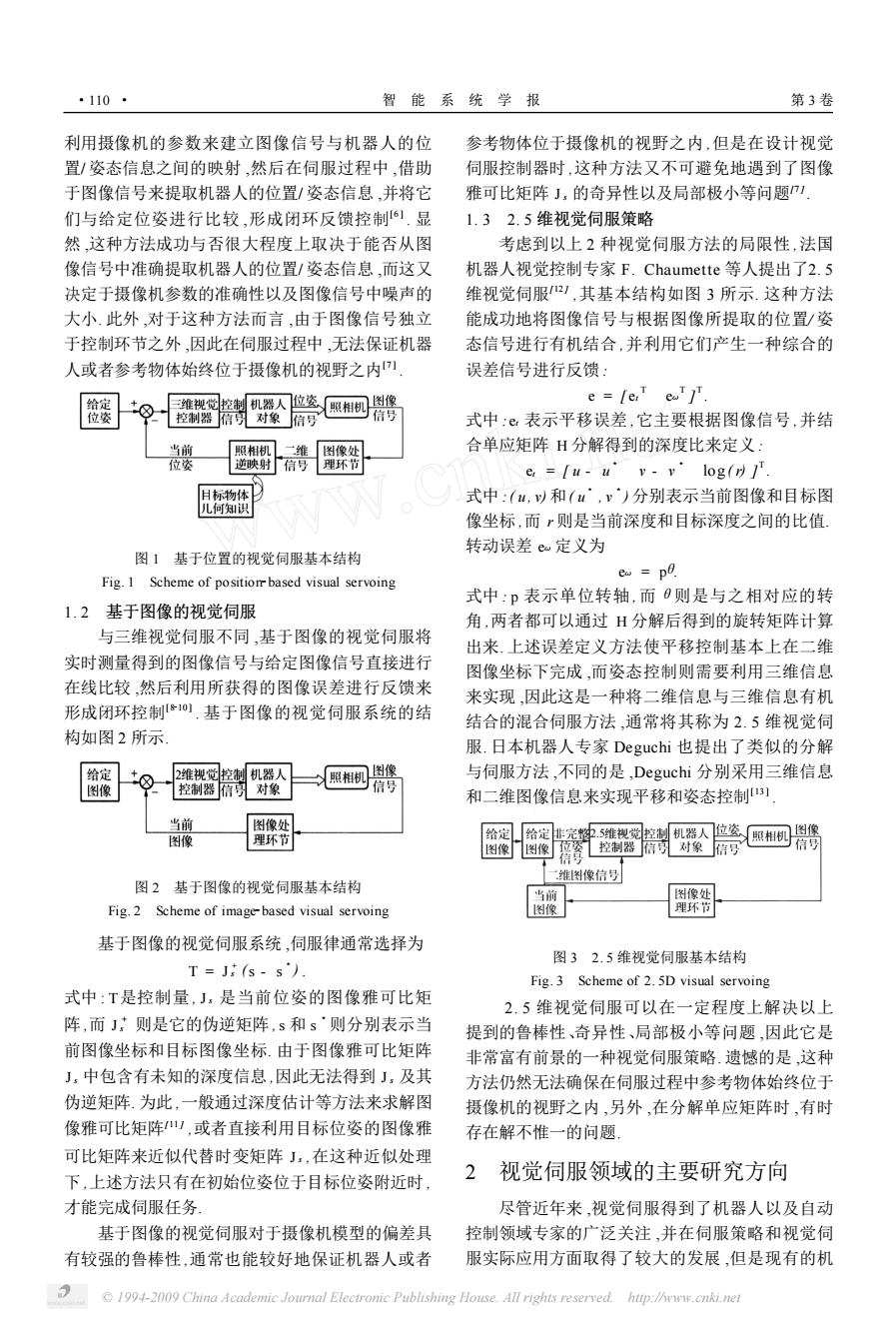

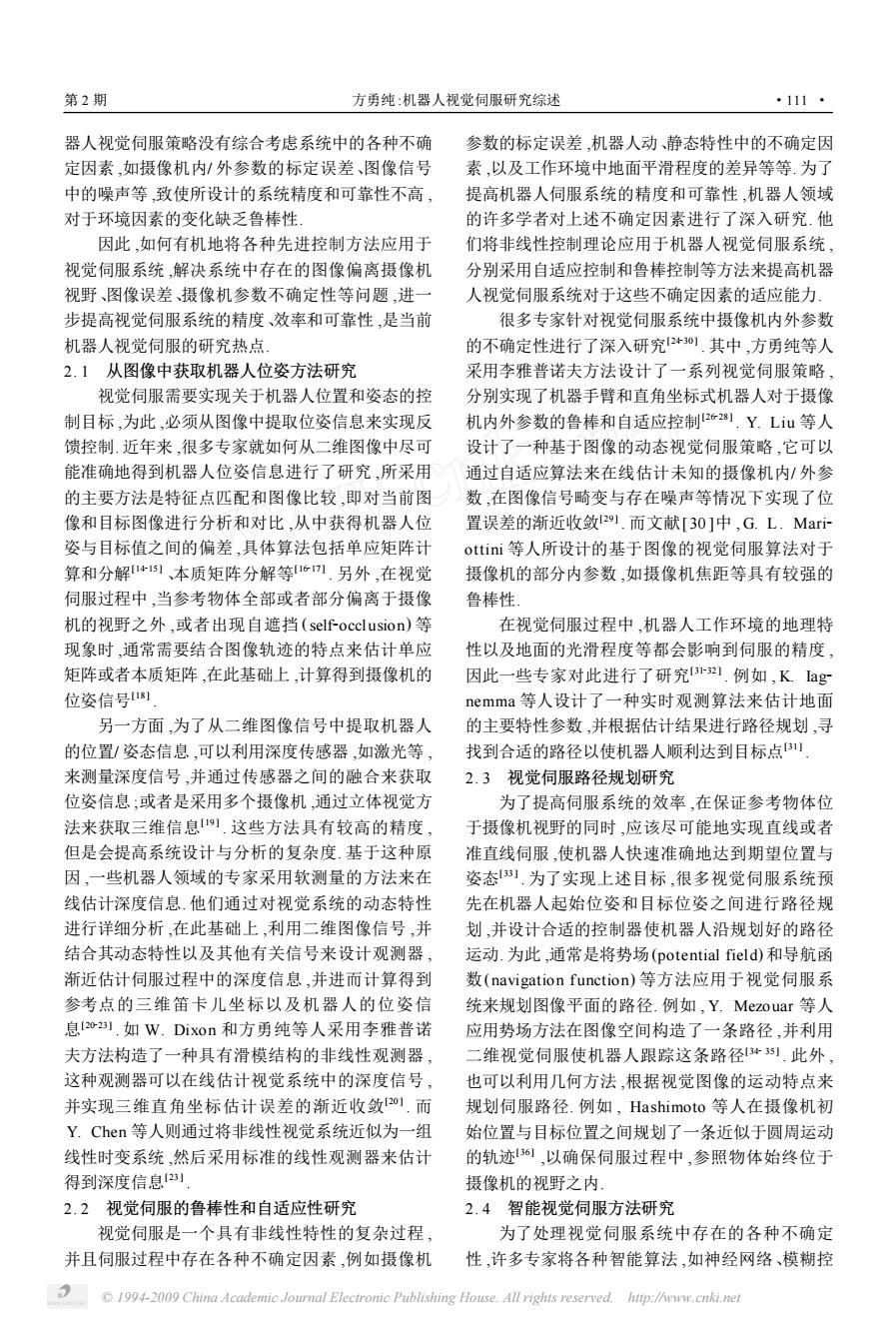

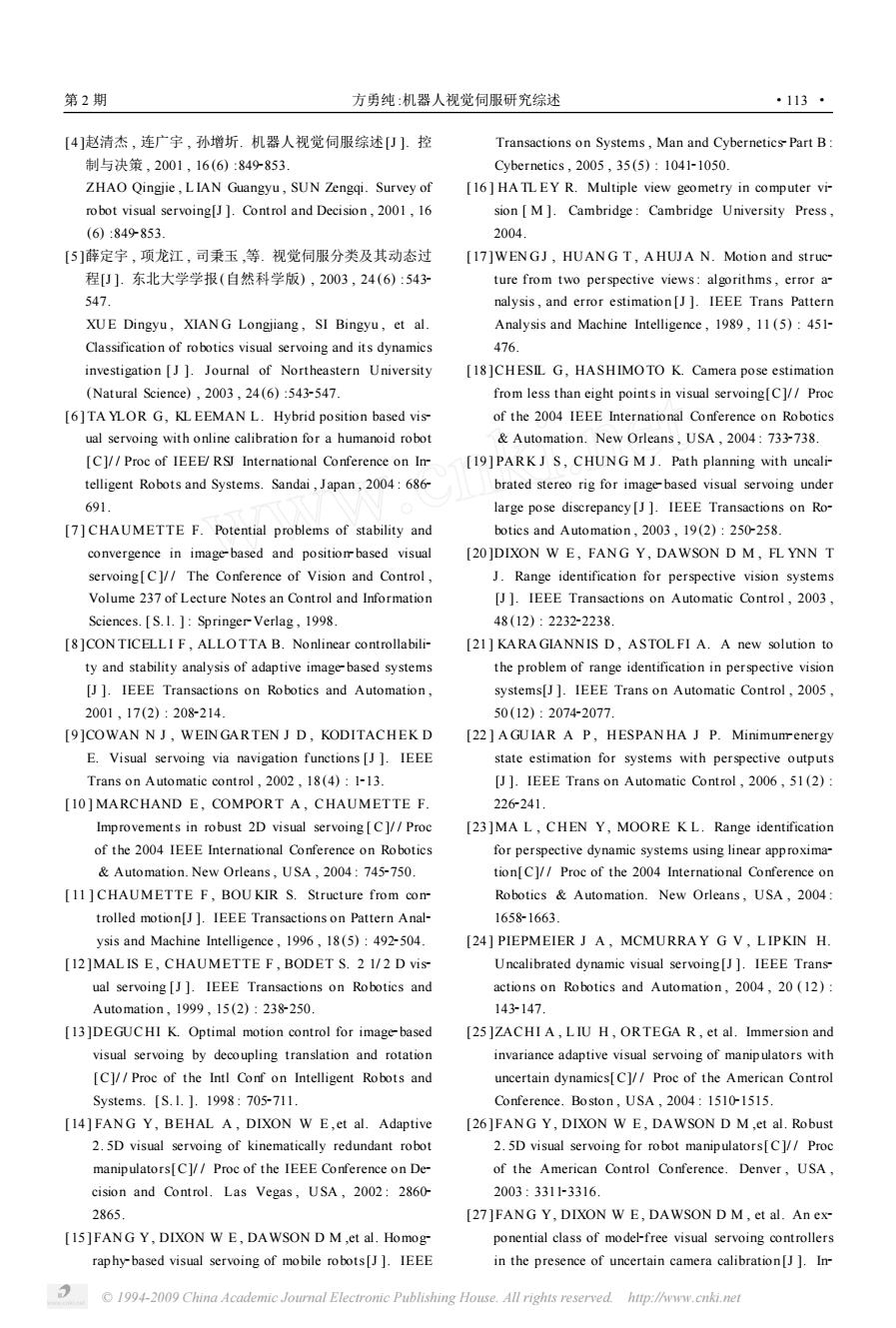

·110- 智能系统学报 第3卷 利用摄像机的参数来建立图像信号与机器人的位 参考物体位于摄像机的视野之内,但是在设计视觉 置/姿态信息之间的映射,然后在伺服过程中,借助 伺服控制器时,这种方法又不可避免地遇到了图像 于图像信号来提取机器人的位置/姿态信息,并将它 雅可比矩阵J,的奇异性以及局部极小等问题 们与给定位姿进行比较,形成闭环反馈控制.显 1.32.5维视觉伺服策略 然,这种方法成功与否很大程度上取决于能否从图 考虑到以上2种视觉伺服方法的局限性,法国 像信号中准确提取机器人的位置/姿态信息,而这又 机器人视觉控制专家F.Chaumette等人提出了2.5 决定于摄像机参数的准确性以及图像信号中噪声的 维视觉伺服),其基本结构如图3所示.这种方法 大小.此外,对于这种方法而言,由于图像信号独立 能成功地将图像信号与根据图像所提取的位置/姿 于控制环节之外,因此在伺服过程中,无法保证机器 态信号进行有机结合,并利用它们产生一种综合的 人或者参考物体始终位于摄像机的视野之内叮 误差信号进行反馈: 三维视觉控制机器人位姿 e=lerT eaTj 照相机 图像 位姿 控制器信可对象信号 信号 式中:©表示平移误差,它主要根据图像信号,并结 当前 照相机 刻像处 合单应矩阵H分解得到的深度比来定义: 位姿 如状身时 信号 理不打 e=Tu-u v-v'log(r) 日标物体 式中:(u,以和(u,v)分别表示当前图像和目标图 儿何知识 像坐标,而r则是当前深度和目标深度之间的比值 转动误差e定义为 图1基于位置的视觉伺服基本结构 eo po Fig.I Scheme of positionr based visual servoing 式中:p表示单位转轴,而0则是与之相对应的转 1.2基于图像的视觉伺服 角,两者都可以通过H分解后得到的旋转矩阵计算 与三维视觉伺服不同,基于图像的视觉伺服将 出来.上述误差定义方法使平移控制基本上在二维 实时测量得到的图像信号与给定图像信号直接进行 图像坐标下完成,而姿态控制则需要利用三维信息 在线比较,然后利用所获得的图像误差进行反馈来 来实现,因此这是一种将二维信息与三维信息有机 形成闭环控制*,基于图像的视觉伺服系统的结 结合的混合伺服方法,通常将其称为2.5维视觉伺 构如图2所示 服.日本机器人专家Deguchi也提出了类似的分解 给定 2维视觉控制机器人 照相机 图像 与伺服方法,不同的是,Deguchi分别采用三维信息 控制器信可对象 信号 和二维图像信息来实现平移和姿态控制] 当前 图像处 图像 理环节 图像门图像姿控制器信习对象信号 信号 维图像信号 图2基于图像的视觉伺服基本结构 当前 刻像处 Fig.2 Scheme of image-based visual servoing 图像 理环节 基于图像的视觉伺服系统,伺服律通常选择为 图32.5维视觉同服基本结构 T=J转(s-s Fig.3 Scheme of 2.5D visual servoing 式中:T是控制量,J,是当前位姿的图像雅可比矩 2.5维视觉伺服可以在一定程度上解决以上 阵,而J则是它的伪逆矩阵,s和s则分别表示当 提到的鲁棒性、奇异性、局部极小等问题,因此它是 前图像坐标和目标图像坐标.由于图像雅可比矩阵 非常富有前景的一种视觉伺服策略.遗憾的是,这种 J,中包含有未知的深度信息,因此无法得到J,及其 方法仍然无法确保在伺服过程中参考物体始终位于 伪逆矩阵.为此,一般通过深度估计等方法来求解图 摄像机的视野之内,另外,在分解单应矩阵时,有时 像雅可比矩阵),或者直接利用目标位姿的图像雅 存在解不惟一的问题 可比矩阵来近似代替时变矩阵J:,在这种近似处理 下,上述方法只有在初始位姿位于目标位姿附近时, 2视觉伺服领域的主要研究方向 才能完成伺服任务 尽管近年来,视觉伺服得到了机器人以及自动 基于图像的视觉伺服对于摄像机模型的偏差具 控制领域专家的广泛关注,并在伺服策略和视觉伺 有较强的鲁棒性,通常也能较好地保证机器人或者 服实际应用方面取得了较大的发展,但是现有的机 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.http://www.cnki.net

利用摄像机的参数来建立图像信号与机器人的位 置/ 姿态信息之间的映射 ,然后在伺服过程中 ,借助 于图像信号来提取机器人的位置/ 姿态信息 ,并将它 们与给定位姿进行比较 ,形成闭环反馈控制[6 ] . 显 然 ,这种方法成功与否很大程度上取决于能否从图 像信号中准确提取机器人的位置/ 姿态信息 ,而这又 决定于摄像机参数的准确性以及图像信号中噪声的 大小. 此外 ,对于这种方法而言 ,由于图像信号独立 于控制环节之外 ,因此在伺服过程中 ,无法保证机器 人或者参考物体始终位于摄像机的视野之内[7 ] . 图 1 基于位置的视觉伺服基本结构 Fig. 1 Scheme of position2based visual servoing 1. 2 基于图像的视觉伺服 与三维视觉伺服不同 ,基于图像的视觉伺服将 实时测量得到的图像信号与给定图像信号直接进行 在线比较 ,然后利用所获得的图像误差进行反馈来 形成闭环控制[ 8210 ] . 基于图像的视觉伺服系统的结 构如图 2 所示. 图 2 基于图像的视觉伺服基本结构 Fig. 2 Scheme of image2based visual servoing 基于图像的视觉伺服系统 ,伺服律通常选择为 T = J + s (s - s 3 ) . 式中 : T是控制量 , Js 是当前位姿的图像雅可比矩 阵 ,而 J + s 则是它的伪逆矩阵 ,s 和 s 3 则分别表示当 前图像坐标和目标图像坐标. 由于图像雅可比矩阵 Js 中包含有未知的深度信息 ,因此无法得到 Js 及其 伪逆矩阵. 为此 ,一般通过深度估计等方法来求解图 像雅可比矩阵[11 ] ,或者直接利用目标位姿的图像雅 可比矩阵来近似代替时变矩阵 Js ,在这种近似处理 下 ,上述方法只有在初始位姿位于目标位姿附近时 , 才能完成伺服任务. 基于图像的视觉伺服对于摄像机模型的偏差具 有较强的鲁棒性 ,通常也能较好地保证机器人或者 参考物体位于摄像机的视野之内 ,但是在设计视觉 伺服控制器时 ,这种方法又不可避免地遇到了图像 雅可比矩阵 Js 的奇异性以及局部极小等问题[7 ] . 1. 3 2. 5 维视觉伺服策略 考虑到以上 2 种视觉伺服方法的局限性 ,法国 机器人视觉控制专家 F. Chaumette 等人提出了2. 5 维视觉伺服[12 ] ,其基本结构如图 3 所示. 这种方法 能成功地将图像信号与根据图像所提取的位置/ 姿 态信号进行有机结合 ,并利用它们产生一种综合的 误差信号进行反馈 : e = [ et T eω T ] T . 式中 : et 表示平移误差 ,它主要根据图像信号 ,并结 合单应矩阵 H 分解得到的深度比来定义 : et = [ u - u 3 v - v 3 log ( r) ] T . 式中 : ( u , v) 和( u 3 , v 3 ) 分别表示当前图像和目标图 像坐标 ,而 r 则是当前深度和目标深度之间的比值. 转动误差 eω 定义为 eω = pθ. 式中 : p 表示单位转轴 , 而θ则是与之相对应的转 角 ,两者都可以通过 H 分解后得到的旋转矩阵计算 出来. 上述误差定义方法使平移控制基本上在二维 图像坐标下完成 ,而姿态控制则需要利用三维信息 来实现 ,因此这是一种将二维信息与三维信息有机 结合的混合伺服方法 ,通常将其称为 2. 5 维视觉伺 服. 日本机器人专家 Deguchi 也提出了类似的分解 与伺服方法 ,不同的是 ,Deguchi 分别采用三维信息 和二维图像信息来实现平移和姿态控制[13 ] . 图 3 2. 5 维视觉伺服基本结构 Fig. 3 Scheme of 2. 5D visual servoing 2. 5 维视觉伺服可以在一定程度上解决以上 提到的鲁棒性、奇异性、局部极小等问题 ,因此它是 非常富有前景的一种视觉伺服策略. 遗憾的是 ,这种 方法仍然无法确保在伺服过程中参考物体始终位于 摄像机的视野之内 ,另外 ,在分解单应矩阵时 ,有时 存在解不惟一的问题. 2 视觉伺服领域的主要研究方向 尽管近年来 ,视觉伺服得到了机器人以及自动 控制领域专家的广泛关注 ,并在伺服策略和视觉伺 服实际应用方面取得了较大的发展 ,但是现有的机 ·110 · 智 能 系 统 学 报 第 3 卷 © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net

第2期 方勇纯:机器人视觉伺服研究综述 ·111- 器人视觉伺服策略没有综合考虑系统中的各种不确 参数的标定误差,机器人动、静态特性中的不确定因 定因素,如摄像机内/外参数的标定误差、图像信号 素,以及工作环境中地面平滑程度的差异等等.为了 中的噪声等,致使所设计的系统精度和可靠性不高, 提高机器人伺服系统的精度和可靠性,机器人领域 对于环境因素的变化缺乏鲁棒性 的许多学者对上述不确定因素进行了深入研究.他 因此,如何有机地将各种先进控制方法应用于 们将非线性控制理论应用于机器人视觉伺服系统, 视觉伺服系统,解决系统中存在的图像偏离摄像机 分别采用自适应控制和鲁棒控制等方法来提高机器 视野、图像误差、摄像机参数不确定性等问题,进一 人视觉伺服系统对于这些不确定因素的适应能力 步提高视觉伺服系统的精度、效率和可靠性,是当前 很多专家针对视觉伺服系统中摄像机内外参数 机器人视觉伺服的研究热点 的不确定性进行了深入研究2*0).其中,方勇纯等人 2.1从图像中获取机器人位姿方法研究 采用李雅普诺夫方法设计了一系列视觉伺服策略 视觉伺服需要实现关于机器人位置和姿态的控 分别实现了机器手臂和直角坐标式机器人对于摄像 制目标,为此,必须从图像中提取位姿信息来实现反 机内外参数的鲁棒和自适应控制26],Y.Liu等人 馈控制近年来,很多专家就如何从二维图像中尽可 设计了一种基于图像的动态视觉伺服策略,它可以 能准确地得到机器人位姿信息进行了研究,所采用通过自适应算法来在线估计未知的摄像机内/外参 的主要方法是特征点匹配和图像比较,即对当前图 数,在图像信号畸变与存在噪声等情况下实现了位 像和目标图像进行分析和对比,从中获得机器人位 置误差的渐近收敛2).而文献[30]中,G.L.Mari 姿与目标值之间的偏差,具体算法包括单应矩阵计 ottini等人所设计的基于图像的视觉伺服算法对于 算和分解51、本质矩阵分解等16川.另外,在视觉 摄像机的部分内参数,如摄像机焦距等具有较强的 伺服过程中,当参考物体全部或者部分偏离于摄像 鲁棒性 机的视野之外,或者出现自遮挡(self-occlusion)等 在视觉伺服过程中,机器人工作环境的地理特 现象时,通常需要结合图像轨迹的特点来估计单应 性以及地面的光滑程度等都会影响到伺服的精度, 矩阵或者本质矩阵,在此基础上,计算得到摄像机的 因此一些专家对此进行了研究3r1.例如,Kag 位姿信号 nemma等人设计了一种实时观测算法来估计地面 另一方面,为了从二维图像信号中提取机器人 的主要特性参数,并根据估计结果进行路径规划,寻 的位置/姿态信息,可以利用深度传感器,如激光等, 找到合适的路径以使机器人顺利达到目标点B」 来测量深度信号,并通过传感器之间的融合来获取 2.3视觉伺服路径规划研究 位姿信息:或者是采用多个摄像机,通过立体视觉方 为了提高伺服系统的效率,在保证参考物体位 法来获取三维信息].这些方法具有较高的精度, 于摄像机视野的同时,应该尽可能地实现直线或者 但是会提高系统设计与分析的复杂度.基于这种原 准直线伺服,使机器人快速准确地达到期望位置与 因,一些机器人领域的专家采用软测量的方法来在 姿态3).为了实现上述目标,很多视觉伺服系统预 线估计深度信息.他们通过对视觉系统的动态特性 先在机器人起始位姿和目标位姿之间进行路径规 进行详细分析,在此基础上,利用二维图像信号,并 划,并设计合适的控制器使机器人沿规划好的路径 结合其动态特性以及其他有关信号来设计观测器, 运动.为此,通常是将势场(potential field)和导航函 渐近估计伺服过程中的深度信息,并进而计算得到 数(navigation function)等方法应用于视觉伺服系 参考点的三维笛卡儿坐标以及机器人的位姿信 统来规划图像平面的路径.例如,Y.Mezouar等人 息202!.如W.Dixon和方勇纯等人采用李雅普诺 应用势场方法在图像空间构造了一条路径,并利用 夫方法构造了一种具有滑模结构的非线性观测器, 二维视觉伺服使机器人跟踪这条路径435),此外, 这种观测器可以在线估计视觉系统中的深度信号, 也可以利用几何方法,根据视觉图像的运动特点来 并实现三维直角坐标估计误差的渐近收敛2].而 规划伺服路径.例如,Hashimoto等人在摄像机初 Y.Chen等人则通过将非线性视觉系统近似为一组 始位置与目标位置之间规划了一条近似于圆周运动 线性时变系统,然后采用标准的线性观测器来估计 的轨迹361,以确保伺服过程中,参照物体始终位于 得到深度信息2] 摄像机的视野之内」 2.2视觉伺服的鲁棒性和自适应性研究 2.4智能视觉伺服方法研究 视觉伺服是一个具有非线性特性的复杂过程, 为了处理视觉同服系统中存在的各种不确定 并且伺服过程中存在各种不确定因素,例如摄像机 性,许多专家将各种智能算法,如神经网络、模糊控 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved http://www.cnki.net

器人视觉伺服策略没有综合考虑系统中的各种不确 定因素 ,如摄像机内/ 外参数的标定误差、图像信号 中的噪声等 ,致使所设计的系统精度和可靠性不高 , 对于环境因素的变化缺乏鲁棒性. 因此 ,如何有机地将各种先进控制方法应用于 视觉伺服系统 ,解决系统中存在的图像偏离摄像机 视野、图像误差、摄像机参数不确定性等问题 ,进一 步提高视觉伺服系统的精度、效率和可靠性 ,是当前 机器人视觉伺服的研究热点. 2. 1 从图像中获取机器人位姿方法研究 视觉伺服需要实现关于机器人位置和姿态的控 制目标 ,为此 ,必须从图像中提取位姿信息来实现反 馈控制. 近年来 ,很多专家就如何从二维图像中尽可 能准确地得到机器人位姿信息进行了研究 ,所采用 的主要方法是特征点匹配和图像比较 ,即对当前图 像和目标图像进行分析和对比 ,从中获得机器人位 姿与目标值之间的偏差 ,具体算法包括单应矩阵计 算和分解[14215 ] 、本质矩阵分解等[16217 ] . 另外 ,在视觉 伺服过程中 ,当参考物体全部或者部分偏离于摄像 机的视野之外 ,或者出现自遮挡 (self2occlusion) 等 现象时 ,通常需要结合图像轨迹的特点来估计单应 矩阵或者本质矩阵 ,在此基础上 ,计算得到摄像机的 位姿信号[18 ] . 另一方面 ,为了从二维图像信号中提取机器人 的位置/ 姿态信息 ,可以利用深度传感器 ,如激光等 , 来测量深度信号 ,并通过传感器之间的融合来获取 位姿信息 ;或者是采用多个摄像机 ,通过立体视觉方 法来获取三维信息[19 ] . 这些方法具有较高的精度 , 但是会提高系统设计与分析的复杂度. 基于这种原 因 ,一些机器人领域的专家采用软测量的方法来在 线估计深度信息. 他们通过对视觉系统的动态特性 进行详细分析 ,在此基础上 ,利用二维图像信号 ,并 结合其动态特性以及其他有关信号来设计观测器 , 渐近估计伺服过程中的深度信息 ,并进而计算得到 参考点的三维笛卡儿坐标以及机器人的位姿信 息[20223 ] . 如 W. Dixon 和方勇纯等人采用李雅普诺 夫方法构造了一种具有滑模结构的非线性观测器 , 这种观测器可以在线估计视觉系统中的深度信号 , 并实现三维直角坐标估计误差的渐近收敛[20 ] . 而 Y. Chen 等人则通过将非线性视觉系统近似为一组 线性时变系统 ,然后采用标准的线性观测器来估计 得到深度信息[23 ] . 2. 2 视觉伺服的鲁棒性和自适应性研究 视觉伺服是一个具有非线性特性的复杂过程 , 并且伺服过程中存在各种不确定因素 ,例如摄像机 参数的标定误差 ,机器人动、静态特性中的不确定因 素 ,以及工作环境中地面平滑程度的差异等等. 为了 提高机器人伺服系统的精度和可靠性 ,机器人领域 的许多学者对上述不确定因素进行了深入研究. 他 们将非线性控制理论应用于机器人视觉伺服系统 , 分别采用自适应控制和鲁棒控制等方法来提高机器 人视觉伺服系统对于这些不确定因素的适应能力. 很多专家针对视觉伺服系统中摄像机内外参数 的不确定性进行了深入研究[24230 ] . 其中 ,方勇纯等人 采用李雅普诺夫方法设计了一系列视觉伺服策略 , 分别实现了机器手臂和直角坐标式机器人对于摄像 机内外参数的鲁棒和自适应控制[26228 ] . Y. Liu 等人 设计了一种基于图像的动态视觉伺服策略 ,它可以 通过自适应算法来在线估计未知的摄像机内/ 外参 数 ,在图像信号畸变与存在噪声等情况下实现了位 置误差的渐近收敛[ 29 ] . 而文献[ 30 ]中 , G. L . Mari2 ottini 等人所设计的基于图像的视觉伺服算法对于 摄像机的部分内参数 ,如摄像机焦距等具有较强的 鲁棒性. 在视觉伺服过程中 ,机器人工作环境的地理特 性以及地面的光滑程度等都会影响到伺服的精度 , 因此一些专家对此进行了研究[31232 ] . 例如 , K. Iag2 nemma 等人设计了一种实时观测算法来估计地面 的主要特性参数 ,并根据估计结果进行路径规划 ,寻 找到合适的路径以使机器人顺利达到目标点[31 ] . 2. 3 视觉伺服路径规划研究 为了提高伺服系统的效率 ,在保证参考物体位 于摄像机视野的同时 ,应该尽可能地实现直线或者 准直线伺服 ,使机器人快速准确地达到期望位置与 姿态[33 ] . 为了实现上述目标 ,很多视觉伺服系统预 先在机器人起始位姿和目标位姿之间进行路径规 划 ,并设计合适的控制器使机器人沿规划好的路径 运动. 为此 ,通常是将势场(potential field) 和导航函 数(navigation f unction) 等方法应用于视觉伺服系 统来规划图像平面的路径. 例如 , Y. Mezouar 等人 应用势场方法在图像空间构造了一条路径 ,并利用 二维视觉伺服使机器人跟踪这条路径[342 35 ] . 此外 , 也可以利用几何方法 ,根据视觉图像的运动特点来 规划伺服路径. 例如 , Hashimoto 等人在摄像机初 始位置与目标位置之间规划了一条近似于圆周运动 的轨迹[ 36 ] ,以确保伺服过程中 ,参照物体始终位于 摄像机的视野之内. 2. 4 智能视觉伺服方法研究 为了处理视觉伺服系统中存在的各种不确定 性 ,许多专家将各种智能算法 ,如神经网络、模糊控 第 2 期 方勇纯 :机器人视觉伺服研究综述 ·111 · © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net

·112· 智能系统学报 第3卷 制、遗传算法等,引入到视觉伺服系统中,通过智能 及它们之间的一系列中间图像共同构成,这样可以 视觉伺服来提高系统的可靠性.其中,基于神经网络 将大范围的视觉伺服问题分解为若干个小范围的视 的视觉伺服充分利用神经网络对于非线性映射的逼 觉伺服子任务,对每个子任务而言,其目标是控制机 近能力,利用它来建立机器人空间与图像空间的对 器人,使其到达轨迹上的相邻一幅图像;另一方面 应关系,这种方法无需对视觉模型等进行理论分 也可以通过主动视觉等技术来解决特征点偏离视野 析,但是通常需要对网络进行大量训练,并且其外推 的问题.例如,在伺服过程中,根据机器人的运动特 能力不强,因此,对于不同的工作环境,网络需要重 性对下一时刻的图像进行预测,在此基础上,通过云 新学习.基于模糊规则的伺服方法则根据人类视觉 台等来调整摄像机的方向,使参考物体尽可能位于 系统的经验来计算控制信号3,.这种方法对于环 像平面中心 境中的不确定性适应性强,但是伺服的精度一般不 2)高速伺服策略研究.视觉信息非常丰富,但是 高,并且需要较长时间来总结伺服规则 图像采集频率不高.此外,在伺服过程中,一般要通 过特征点提取、匹配、分析、比较等方法来获取机器 3结论与展望 人的位姿以实现反馈控制.整个过程计算量很大,周 综述国内外的研究情况可以看出,视觉伺服是 期较长,上述原因导致常见的伺服系统实时性较差, 一项多学科交叉的新兴研究领域,其研究进展将促 难以满足动态目标体跟踪等场合的需要.为了拓展 进机器人在SLAM(机器人同时定位与地图构建)、 视觉伺服领域的应用前景,必须开展高速视觉伺服 智能搜索等方面的研究,从而为提高机器人的智能 策略研究.一方面,需要研究计算机视觉的有关算 化水平与工作能力,扩展其在家庭服务、反恐防暴等 法,降低特征点提取和匹配等环节的复杂度,从图像 方面的进一步应用提供良好的技术积累, 中快速可靠地获取机器人位姿信息,同时在控制方 作为当前智能机器人领域一个方兴未艾的关键 法上应该通过图像特征预测等措施来降低信息反馈 研究方向,现在世界各国,如法国、日本、美国、意大 的时延;另一方面,可以充分利用其他辅助传感器, 利等发达国家都在大力进行视觉伺服方面的研究, 如移动机器人上广泛配置的光电码盘、声呐等,将视 并取得了较大的进展.但是,现有的各种视觉伺服方 觉和其他传感信号互相融合来提高伺服的速度 法,包括基于图像的视觉伺服、基于位置的视觉伺服 3)鲁棒视觉伺服技术研究.为了使视觉伺服系 以及2.5维视觉伺服,都存在奇异性、局部极小等不 统能够在复杂环境下工作,必须提高它对于各种不 同的缺陷.此外,通常的视觉伺服系统实时性较差, 确定因素的鲁棒性.为此,需要从理论上分析系统中 并且其中的伺服算法都局限于解决问题的某一个方 的各种不确定因素对伺服性能的影响,在此基础上, 面,一般都只能适用于某些特定的理想条件,特别是 采用李雅普诺夫等方法来设计自适应、滑模切换等 当系统中存在各种不确定因素,包括外界光照条件 各种非线性反馈环节,或者采用神经网络等智能控 变化、摄像机参数误差、机器人未知的运动特性、图 制方法,使伺服系统能够适应自身以及环境因素的 像噪声等时,现有的视觉伺服系统很难获得满意的 变化,使之在外界光照条件变化、摄像机参数突变、 伺服性能 存在图像畸变和噪声等情况下,仍然能够获得满意 为了将视觉伺服技术真正应用于机器人系统, 的伺服性能 必须提高视觉伺服系统的速度和精确度、鲁棒性、可 参考文献: 靠性以及智能化程度,使其在具有各种不确定因素 的复杂环境下能够可靠地工作.根据上述目标,视觉 [1]CHAUMETTE F,HUTCHINSON S.Visual servo com 伺服将可能在以下几个方面进行重点研究: trol part I:basic approaches[J ]IEEE Robotics &Au 1)确保伺服过程中参考物体始终位于摄像机视 tomation Magazine,2006(12):82-90. [2]CHAUMETTE F,HUTCHINSON S.Visual servo con 野之内.对于现有的视觉伺服系统而言,当机器人的 起始位姿与目标位姿相差较远时,在伺服过程中,参 trol part II:advanced approaches[J].IEEE Robotics& Automation Magazine,2007(3):109-118. 考物体经常偏离于摄像机视野之外,致使伺服失败 [3]王麟琨,徐德,谭民.机器人视觉伺服研究进展 这种缺陷严重地阻碍了视觉伺服技术的进一步应 [U].机器人,2004,26(3):277-282. 用.为了解决上述问题以提高伺服系统的可靠性,一 WANG Linkun,XU De,TAN Min.Survey of research 方面,可以采用图像平面路径规划方法,即在图像平 on robotic visual servoing[J ]Robot,2004,26(3):277- 面上构造一条目标路径,它由起始图像、目标图像以 282 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.htp://www.cnki.net

制、遗传算法等 ,引入到视觉伺服系统中 ,通过智能 视觉伺服来提高系统的可靠性. 其中 ,基于神经网络 的视觉伺服充分利用神经网络对于非线性映射的逼 近能力 ,利用它来建立机器人空间与图像空间的对 应关系[37 ] . 这种方法无需对视觉模型等进行理论分 析 ,但是通常需要对网络进行大量训练 ,并且其外推 能力不强 ,因此 ,对于不同的工作环境 ,网络需要重 新学习. 基于模糊规则的伺服方法则根据人类视觉 系统的经验来计算控制信号[38239 ] . 这种方法对于环 境中的不确定性适应性强 ,但是伺服的精度一般不 高 ,并且需要较长时间来总结伺服规则. 3 结论与展望 综述国内外的研究情况可以看出 ,视觉伺服是 一项多学科交叉的新兴研究领域 ,其研究进展将促 进机器人在 SLAM (机器人同时定位与地图构建) 、 智能搜索等方面的研究 ,从而为提高机器人的智能 化水平与工作能力 ,扩展其在家庭服务、反恐防暴等 方面的进一步应用提供良好的技术积累. 作为当前智能机器人领域一个方兴未艾的关键 研究方向 ,现在世界各国 ,如法国、日本、美国、意大 利等发达国家都在大力进行视觉伺服方面的研究 , 并取得了较大的进展. 但是 ,现有的各种视觉伺服方 法 ,包括基于图像的视觉伺服、基于位置的视觉伺服 以及 2. 5 维视觉伺服 ,都存在奇异性、局部极小等不 同的缺陷. 此外 ,通常的视觉伺服系统实时性较差 , 并且其中的伺服算法都局限于解决问题的某一个方 面 ,一般都只能适用于某些特定的理想条件 ,特别是 当系统中存在各种不确定因素 ,包括外界光照条件 变化、摄像机参数误差、机器人未知的运动特性、图 像噪声等时 ,现有的视觉伺服系统很难获得满意的 伺服性能. 为了将视觉伺服技术真正应用于机器人系统 , 必须提高视觉伺服系统的速度和精确度、鲁棒性、可 靠性以及智能化程度 ,使其在具有各种不确定因素 的复杂环境下能够可靠地工作. 根据上述目标 ,视觉 伺服将可能在以下几个方面进行重点研究 : 1) 确保伺服过程中参考物体始终位于摄像机视 野之内. 对于现有的视觉伺服系统而言 ,当机器人的 起始位姿与目标位姿相差较远时 ,在伺服过程中 ,参 考物体经常偏离于摄像机视野之外 ,致使伺服失败. 这种缺陷严重地阻碍了视觉伺服技术的进一步应 用. 为了解决上述问题以提高伺服系统的可靠性 ,一 方面 ,可以采用图像平面路径规划方法 ,即在图像平 面上构造一条目标路径 ,它由起始图像、目标图像以 及它们之间的一系列中间图像共同构成 ,这样可以 将大范围的视觉伺服问题分解为若干个小范围的视 觉伺服子任务 ,对每个子任务而言 ,其目标是控制机 器人 ,使其到达轨迹上的相邻一幅图像 ;另一方面 , 也可以通过主动视觉等技术来解决特征点偏离视野 的问题. 例如 ,在伺服过程中 ,根据机器人的运动特 性对下一时刻的图像进行预测 ,在此基础上 ,通过云 台等来调整摄像机的方向 ,使参考物体尽可能位于 像平面中心. 2) 高速伺服策略研究. 视觉信息非常丰富 ,但是 图像采集频率不高. 此外 ,在伺服过程中 ,一般要通 过特征点提取、匹配、分析、比较等方法来获取机器 人的位姿以实现反馈控制. 整个过程计算量很大 ,周 期较长. 上述原因导致常见的伺服系统实时性较差 , 难以满足动态目标体跟踪等场合的需要. 为了拓展 视觉伺服领域的应用前景 ,必须开展高速视觉伺服 策略研究. 一方面 ,需要研究计算机视觉的有关算 法 ,降低特征点提取和匹配等环节的复杂度 ,从图像 中快速可靠地获取机器人位姿信息 ,同时在控制方 法上应该通过图像特征预测等措施来降低信息反馈 的时延 ;另一方面 ,可以充分利用其他辅助传感器 , 如移动机器人上广泛配置的光电码盘、声呐等 ,将视 觉和其他传感信号互相融合来提高伺服的速度. 3) 鲁棒视觉伺服技术研究. 为了使视觉伺服系 统能够在复杂环境下工作 ,必须提高它对于各种不 确定因素的鲁棒性. 为此 ,需要从理论上分析系统中 的各种不确定因素对伺服性能的影响 ,在此基础上 , 采用李雅普诺夫等方法来设计自适应、滑模切换等 各种非线性反馈环节 ,或者采用神经网络等智能控 制方法 ,使伺服系统能够适应自身以及环境因素的 变化 ,使之在外界光照条件变化、摄像机参数突变、 存在图像畸变和噪声等情况下 ,仍然能够获得满意 的伺服性能. 参考文献 : [ 1 ]CHAUMETTE F , HU TCHINSON S. Visual servo con2 trol part I: basic approaches[J ]. IEEE Robotics & Au2 tomation Magazine , 2006 (12) : 82290. [ 2 ]CHAUMETTE F , HU TCHINSON S. Visual servo con2 trol part II: advanced approaches[J ]. IEEE Robotics & Automation Magazine , 2007 (3) : 1092118. [3 ]王麟琨 , 徐 德 , 谭 民. 机器人视觉伺服研究进展 [J ]. 机器人 , 2004 , 26 (3) : 2772282. WAN G Linkun , XU De , TAN Min. Survey of research on robotic visual servoing[J ]. Robot , 2004 , 26 (3) : 2772 282. ·112 · 智 能 系 统 学 报 第 3 卷 © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net

第2期 方勇纯:机器人视觉伺服研究综述 ·113 [4]赵清杰,连广宇,孙增圻.机器人视觉伺服综述[卩].控 Transactions on Systems,Man and Cybernetics Part B: 制与决策,2001,16(6):849853. Cybernetics,2005,35(5):1041-1050. ZHAO Qingjie,L IAN Guangyu,SUN Zengqi.Survey of [16]HA TL EY R.Multiple view geometry in computer vi- robot visual servoing[J ]Control and Decision,2001,16 sion M].Cambridge:Cambridge University Press, (6):849853. 2004. [5]薛定字,项龙江,司秉玉,等.视觉伺服分类及其动态过 [17]WENGJ,HUANG T,AHUJA N.Motion and struc- 程[J1.东北大学学报(自然科学版),2003,24(6):543 ture from two perspective views:algorithms,error a- 547 nalysis,and error estimation[J].IEEE Trans Pattern XUE Dingyu,XIANG Longjiang,SI Bingyu,et al. Analysis and Machine Intelligence,1989,11(5):451- Classification of robotics visual servoing and its dynamics 476. investigation [J ]Journal of Northeastern University [18]CHESIL G,HASHIMOTO K.Camera pose estimation (Natural Science),2003,24(6):543-547. from less than eight points in visual servoing[C]//Proc [6]TA YLOR G,KL EEMAN L.Hybrid position based vis- of the 2004 IEEE International Conference on Robotics ual servoing with online calibration for a humanoid robot Automation.New Orleans,USA,2004:733-738. [C]//Proc of IEEE/RSJ International Conference on In- [19]PARK J S,CHUNG M J.Path planning with uncali- telligent Robots and Systems.Sandai,Japan,2004:686- brated stereo rig for image-based visual servoing under 691. large pose discrepancy [J].IEEE Transactions on Ro- [7]CHAUMETTE F.Potential problems of stability and botics and Automation,2003,19(2):250-258. convergence in image-based and positiombased visual [20]DIXON W E.FANG Y,DAWSON D M,FL YNN T servoing[C]//The Conference of Vision and Control, J.Range identification for perspective vision systems Volume 237 of Lecture Notes an Control and Information [J ]IEEE Transactions on Automatic Control,2003, Sciences.[S.I.]Springer-Verlag,1998. 48(12):2232-2238. [8]CON TICELLI F,ALLOTTA B.Nonlinear controllabili- [21]KARA GIANNIS D,ASTOL FI A.A new solution to ty and stability analysis of adaptive image-based systems the problem of range identification in perspective vision [J ]IEEE Transactions on Robotics and Automation, systems[J].IEEE Trans on Automatic Control,2005, 2001,17(2):208-214. 50(12):2074-2077. [9]COWAN NJ,WEINGARTEN J D,KODITACHEK D [22]A GUIAR A P,HESPAN HA J P.Minimumrenergy E.Visual servoing via navigation functions [J ]IEEE state estimation for systems with perspective outputs Trans on Automatic control,2002,18(4):1-13. [J ]IEEE Trans on Automatic Control,2006,51(2): [10]MARCHAND E,COMPORT A,CHAUMETTE F. 226241 Improvements in robust 2D visual servoing [C]//Proc [23 ]MA L,CHEN Y,MOORE K L.Range identification of the 2004 IEEE International Conference on Robotics for perspective dynamic systems using linear approxima- &Automation.New Orleans,USA,2004:745-750. tion[C]//Proc of the 2004 International Conference on [11]CHAUMETTE F,BOU KIR S.Structure from con- Robotics Automation.New Orleans,USA,2004: trolled motion[J ]IEEE Transactions on Pattern Anal- 16581663. ysis and Machine Intelligence,1996,18(5):492-504. [24]PIEPMEIER J A,MCMURRAY G V,LIPKIN H. [12]MALIS E,CHAUMETTE F,BODET S.2 1/2 D vis- Uncalibrated dynamic visual servoing [J ]IEEE Trans- ual servoing [J].IEEE Transactions on Robotics and actions on Robotics and Automation,2004,20(12): Automation,1999,15(2):238250. 143147. [13]DEGUCHI K.Optimal motion control for image-based [25]ZACHI A,LIU H,ORTEGA R,et al.Immersion and visual servoing by decoupling translation and rotation invariance adaptive visual servoing of manipulators with [C]//Proc of the Intl Conf on Intelligent Robots and uncertain dynamics[C]//Proc of the American Control Systems.[S.1.l.1998:705711. Conference.Boston,USA,2004:1510-1515. [14]FANG Y,BEHAL A,DIXON W E,et al.Adaptive [26]FANG Y,DIXON W E,DAWSON D M,et al.Robust 2.5D visual servoing of kinematically redundant robot 2.5D visual servoing for robot manipulators[C]//Proc manipulators[Cl//Proc of the IEEE Conference on De- of the American Control Conference.Denver,USA, cision and Control.Las Vegas,USA,2002:2860- 2003:3311-3316. 2865. [27]FANG Y,DIXON W E,DAWSON D M,et al.An ex- [15]FANG Y,DIXON W E,DAWSON D M ,et al.Homog ponential class of model-free visual servoing controllers raphy-based visual servoing of mobile robots[J ]IEEE in the presence of uncertain camera calibration [J ]In- 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.htp://www.cnki.net

[4 ]赵清杰 , 连广宇 , 孙增圻. 机器人视觉伺服综述[J ]. 控 制与决策 , 2001 , 16 (6) :8492853. ZHAO Qingjie , L IAN Guangyu , SUN Zengqi. Survey of robot visual servoing[J ]. Control and Decision , 2001 , 16 (6) :8492853. [5 ]薛定宇 , 项龙江 , 司秉玉 ,等. 视觉伺服分类及其动态过 程[J ]. 东北大学学报(自然科学版) , 2003 , 24 (6) :5432 547. XU E Dingyu , XIAN G Longjiang , SI Bingyu , et al. Classification of robotics visual servoing and its dynamics investigation [ J ]. Journal of Northeastern University (Natural Science) , 2003 , 24 (6) :5432547. [6 ] TA YLOR G, KL EEMAN L. Hybrid position based vis2 ual servoing with online calibration for a humanoid robot [C]/ / Proc of IEEE/ RSJ International Conference on In2 telligent Robots and Systems. Sandai , J apan , 2004 : 6862 691. [7 ] CHAUMETTE F. Potential problems of stability and convergence in image2based and position2based visual servoing[ C]/ / The Conference of Vision and Control , Volume 237 of Lecture Notes an Control and Information Sciences. [ S. l. ] : Springer2Verlag , 1998. [8 ]CON TICELL I F , ALLO TTA B. Nonlinear controllabili2 ty and stability analysis of adaptive image2based systems [J ]. IEEE Transactions on Robotics and Automation , 2001 , 17 (2) : 2082214. [9 ]COWAN N J , WEIN GARTEN J D , KODITACHEK D E. Visual servoing via navigation functions [J ]. IEEE Trans on Automatic control , 2002 , 18 (4) : 1213. [10 ] MARCHAND E , COMPORT A , CHAUMETTE F. Improvements in robust 2D visual servoing [ C]/ / Proc of the 2004 IEEE International Conference on Robotics & Automation. New Orleans , USA , 2004 : 7452750. [ 11 ] CHAUMETTE F , BOU KIR S. Structure from con2 trolled motion[J ]. IEEE Transactions on Pattern Anal2 ysis and Machine Intelligence , 1996 , 18 (5) : 4922504. [12 ]MAL IS E , CHAUMETTE F , BODET S. 2 1/ 2 D vis2 ual servoing [J ]. IEEE Transactions on Robotics and Automation , 1999 , 15 (2) : 2382250. [13 ]DEGUCHI K. Optimal motion control for image2based visual servoing by decoupling translation and rotation [C]/ / Proc of the Intl Conf on Intelligent Robots and Systems. [ S. l. ]. 1998 : 7052711. [14 ] FAN G Y , BEHAL A , DIXON W E , et al. Adaptive 2. 5D visual servoing of kinematically redundant robot manipulators[C]/ / Proc of the IEEE Conference on De2 cision and Control. Las Vegas , USA , 2002 : 28602 2865. [15 ] FAN G Y , DIXON W E , DAWSON D M ,et al. Homog2 raphy2based visual servoing of mobile robots[J ]. IEEE Transactions on Systems , Man and Cybernetics2Part B : Cybernetics , 2005 , 35 (5) : 104121050. [16 ] HA TL EY R. Multiple view geometry in computer vi2 sion [ M ]. Cambridge : Cambridge University Press , 2004. [17 ]WEN G J , HUAN G T , A HUJ A N. Motion and struc2 ture from two perspective views: algorithms , error a2 nalysis , and error estimation [J ]. IEEE Trans Pattern Analysis and Machine Intelligence , 1989 , 11 (5) : 4512 476. [18 ]CHESIL G, HASHIMO TO K. Camera pose estimation from less than eight points in visual servoing[C]/ / Proc of the 2004 IEEE International Conference on Robotics & Automation. New Orleans , USA , 2004 : 7332738. [19 ] PARK J S , CHUN G M J. Path planning with uncali2 brated stereo rig for image2based visual servoing under large pose discrepancy [J ]. IEEE Transactions on Ro2 botics and Automation , 2003 , 19 (2) : 2502258. [20 ]DIXON W E , FAN G Y, DAWSON D M , FL YNN T J. Range identification for perspective vision systems [J ]. IEEE Transactions on Automatic Control , 2003 , 48 (12) : 223222238. [21 ] KARA GIANNIS D , ASTOL FI A. A new solution to the problem of range identification in perspective vision systems[J ]. IEEE Trans on Automatic Control , 2005 , 50 (12) : 207422077. [22 ] A GU IAR A P , HESPAN HA J P. Minimum2energy state estimation for systems with perspective outputs [J ]. IEEE Trans on Automatic Control , 2006 , 51 (2) : 2262241. [23 ]MA L , CHEN Y , MOORE K L. Range identification for perspective dynamic systems using linear approxima2 tion[C]/ / Proc of the 2004 International Conference on Robotics & Automation. New Orleans , USA , 2004 : 165821663. [24 ] PIEPMEIER J A , MCMURRA Y G V , L IPKIN H. Uncalibrated dynamic visual servoing[J ]. IEEE Trans2 actions on Robotics and Automation , 2004 , 20 ( 12) : 1432147. [ 25 ]ZACHI A , L IU H , ORTEGA R , et al. Immersion and invariance adaptive visual servoing of manipulators with uncertain dynamics[C]/ / Proc of the American Control Conference. Boston , USA , 2004 : 151021515. [26 ]FAN G Y, DIXON W E , DAWSON D M ,et al. Robust 2. 5D visual servoing for robot manipulators[ C]/ / Proc of the American Control Conference. Denver , USA , 2003 : 331123316. [ 27 ]FAN G Y, DIXON W E , DAWSON D M , et al. An ex2 ponential class of model2free visual servoing controllers in the presence of uncertain camera calibration [J ]. In2 第 2 期 方勇纯 :机器人视觉伺服研究综述 ·113 · © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net

·114 智能系统学报 第3卷 ternational Journal of Robotics and Automation,2006, [36]CHESI G,HASHIMOTO K,PRATTICHIZZO D,et 21(4):247-255. al.Keeping features in the field of view in eye-imhand [28]FANG Y,DIXON W E,DAWSON D M.Adaptive visual servoing:a switching approach [J ]IEEE Trans 2.5D visual servoing of cartesian robots [C]//Proc of on Robotics,2004,20(5):908-913. the Eighth International Conference on Control,Auto- [37]谢冬梅,曲道奎,徐方,基于神经网络的机器人视觉 mation,Robotics and Vision.Kunming,China,2004: 伺服控制[J].微计算机信息,2006,22(4):46. 68-73. XIE Dongmei,QU Daokui,XU Fang.Design of robot- [29]LIU Y,WANG H,LAM K.Dynamic visual servoing ic visual servo control based on neural network [J ] of robots in uncalibrated environment [C]//Proc of the Control and Automation,2006,22(4):4-6. IEEE Conference on Robotics and Automation.Barcelo- [38]张玉洁,徐纲.基于神经网络的视觉机器人模糊控制 na,Spain,2005:3142-3147. [0].深圳大学学报(理工版),2004,21(4):301-305. [301MARIOTTINI GL.ORIOLO G.PRATTICHIZZO D. ZHANG Yujie,XU Gang.Fuzzy control of visual robot Epipole-based visual servoing for nonholonomic mobile based on neural network [J].Journal of Shenzhen Uni- robots[C]//International Conference on Robotics and versity,2004,21(4):301-305. Automation.New Orleans,USA,2004:497-503. [39]钟金明,徐刚,张海波.模糊逆运动学控制方法在机 [31]IA GN EMMA K,KANG S,SHIBL Y H,et al.Online 器人视觉同服中的应用U],组合机床与自动化加工技 terrain parameter estimation for wheeled mobile robots 术,2005(7):4851. with application to planetary rovers[J].IEEE Trans on ZHON GJinming,XU Gang,ZHANG Haibo.A fuzzy Robotics,2004,20(5):921-927. inference resolved motion rate control for a visual servo [32]YE C,BORENSTEIN J.A novel filter for terrain map- robot[J].Modular Machine Tool Automatic Manu ping with laser rangefinders[J].IEEE Trans on Robot- facturing Technique,2005(7):48-51. ics,2004,20(5):913-921. 作者简介: [33]CHESI G,PRATTICHIZZO D,VICINO A.Straight 方勇纯,男,1973年生,教授,博士生 line patplanning in visual servoing[J ]Journal of Dy- 导师,EEE高级会员,中国自动化学会智 namic Systems,Measurement,and Control,2007,129: 能自动化专业委员会委员,主要研究方向 541-543. 为复杂系统非线性控制、机器人视觉控制 [34]MEZOUAR Y,CHAUMETTE F.Path planning for 等.发表论文60多篇,其中40余篇被 robust image-based control [J].IEEE Transactions on SCI或EI检索. Robotics and Automation,2002,18(4):534-549. [35]MEZOUAR Y,CHAUMETTE F.Path planning in image space for robust visual servoing[C]//Proc of In ternational Conference on Robotics and Automation Piscataway,USA,2000:2759-2764 第四届拟人系统大会 2008 International Conference Humanized Systems 自涂序彦教授在国内首次发起“拟人系统”研究以来,拟人系统科学受到广泛关注和深入研究。2005年 召开了第一届拟人系统大会。经过几年的沉淀和积累,第四届国际拟人系统大会将于2008年10月19-22 日在北京召开。会议主题涉及很多领域,包括人工生命、人工情感、复杂计算、脑科学、人工神经网络、自适应 系统、非线性系统、智能Aget、认知科学等。期盼广大研究者从不同领域、不同学科、不同视角剖析拟人科 学的奥秘和精华。希望人工智能学会的各位理事能够积极参与到“拟人系统”的研究中来,踊跃投稿,以文会 友。论文将在2008年6月1日截稿,会议文章ISTP检索,部分优秀论文推荐EI检索杂志发表。 联系人:杜军平((junpingdu@l26.com),郑金鑫(ichs08@gmail.com),王大亮(greateking@gmail. com). 会议网址:http:/caai.cn:8086/ichs08. 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.htp://www.cnki.net

方勇纯 , 男 , 1973 年生 ,教授 ,博士生 导师 ,IEEE 高级会员 ,中国自动化学会智 能自动化专业委员会委员 ,主要研究方向 为复杂系统非线性控制、机器人视觉控制 等. 发表论文 60 多篇 , 其中 40 余篇被 SCI 或 EI 检索. ternational Journal of Robotics and Automation , 2006 , 21 (4) : 2472255. [28 ] FAN G Y, DIXON W E , DAWSON D M. Adaptive 2. 5D visual servoing of cartesian robots[ C]/ / Proc of the Eighth International Conference on Control , Auto2 mation , Robotics and Vision. Kunming , China , 2004 : 68273. [29 ]L IU Y , WAN G H , LAM K. Dynamic visual servoing of robots in uncalibrated environment[ C]/ / Proc of the IEEE Conference on Robotics and Automation. Barcelo2 na , Spain , 2005 : 314223147. [30 ]MARIO TTINI G L , ORIOLO G, PRA TTICHIZZO D. Epipole2based visual servoing for nonholonomic mobile robots[ C ]/ / International Conference on Robotics and Automation. New Orleans , USA , 2004 : 4972503. [31 ]IA GN EMMA K , KAN G S , SHIBL Y H , et al. Online terrain parameter estimation for wheeled mobile robots with application to planetary rovers[J ]. IEEE Trans on Robotics , 2004 , 20 (5) : 9212927. [ 32 ] YE C , BORENSTEIN J. A novel filter for terrain map2 ping with laser rangefinders[J ]. IEEE Trans on Robot2 ics , 2004 , 20 (5) : 9132921. [33 ]CHESI G, PRA TTICHIZZO D , VICINO A. Straight line path2planning in visual servoing[J ]. Journal of Dy2 namic Systems , Measurement , and Control , 2007 ,129 : 5412543. [34 ] MEZOUAR Y , CHAUMETTE F. Path planning for robust image2based control [J ]. IEEE Transactions on Robotics and Automation , 2002 , 18 (4) : 5342549. [35 ] MEZOUAR Y , CHAUMETTE F. Path planning in image space for robust visual servoing[ C]/ / Proc of In2 ternational Conference on Robotics and Automation. Piscataway , USA , 2000 : 275922764. [36 ]CHESI G, HASHIMO TO K , PRA TTICHIZZO D , et al. Keeping features in the field of view in eye2in2hand visual servoing : a switching approach [J ]. IEEE Trans on Robotics , 2004 , 20 (5) : 9082913. [37 ]谢冬梅 , 曲道奎 , 徐 方. 基于神经网络的机器人视觉 伺服控制[J ]. 微计算机信息 , 2006 , 22 (4) : 426. XIE Dongmei , QU Daokui , XU Fang. Design of robot2 ic visual servo control based on neural network [J ]. Control and Automation , 2006 , 22 (4) : 426. [ 38 ]张玉洁 , 徐 纲. 基于神经网络的视觉机器人模糊控制 [J ]. 深圳大学学报(理工版) ,2004 , 21 (4) : 3012305. ZHAN G Yujie , XU Gang. Fuzzy control of visual robot based on neural network [J ]. Journal of Shenzhen Uni2 versity , 2004 , 21 (4) : 3012305. [39 ]钟金明 , 徐 刚 , 张海波. 模糊逆运动学控制方法在机 器人视觉伺服中的应用[J ]. 组合机床与自动化加工技 术 ,2005 (7) : 48251. ZHON G Jinming , XU Gang , ZHAN G Haibo. A fuzzy inference resolved motion rate control for a visual servo robot[J ]. Modular Machine Tool & Automatic Manu2 facturing Technique , 2005 (7) : 48251. 作者简介 : 第四届拟人系统大会 2008 International Conference Humanized Systems 自涂序彦教授在国内首次发起“拟人系统”研究以来 ,拟人系统科学受到广泛关注和深入研究。2005 年 召开了第一届拟人系统大会。经过几年的沉淀和积累 ,第四届国际拟人系统大会将于 2008 年 10 月 19 - 22 日在北京召开。会议主题涉及很多领域 ,包括人工生命、人工情感、复杂计算、脑科学、人工神经网络、自适应 系统、非线性系统、智能 Agent 、认知科学等。期盼广大研究者从不同领域、不同学科、不同视角剖析拟人科 学的奥秘和精华。希望人工智能学会的各位理事能够积极参与到“拟人系统”的研究中来 ,踊跃投稿 ,以文会 友。论文将在 2008 年 6 月 1 日截稿 ,会议文章 ISTP 检索 ,部分优秀论文推荐 EI 检索杂志发表。 联系人 :杜军平 (junpingdu @126. com) , 郑金鑫 (ichs08 @gmail. com) , 王大亮 ( greateking @gmail. com) . 会议网址 :http :/ / caai. cn :8086/ ichs08. ·114 · 智 能 系 统 学 报 第 3 卷 © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net