模糊联想记忆 路文 2006-11-27

模糊联想记忆 路文 2006-11-27

Outline ▣言 ▣模糊lebb FAMs ▣添加FAM规则 ▣联想输出与清晰化 ▣FAM系统结构 西安电子科技大学影彩像处理系统实验室

Outline 引言 模糊 Hebb FAMs 添加FAM规则 联想输出与清晰化 FAM系统结构 西安电子科技大学影像处理系统实验室

引言 冬Hebb假设:Donald O.Hebb在《The Organization of Behavior》)一书中提 出:“当细胞A的轴突到细胞B的距离近到足够激励它,且反复地或持续 地刺激B,那么在这两个细胞或一个细胞中将会发生某种增长过程或代谢 反应,增加A对细胞B的刺激效果”。 必 1987年美国Bart Kosko教授提出了一种称为模糊联想记忆神经网络(Fuz2y Associative MemoryFAM,这种联想记忆神经网络是将模糊控制的规 则隐含地分布在整个网络中,在神经网络的基础上通过学习训练产生模糊 规测,一次模糊联想记忆就是一次模糊逻辑推理。 在模糊控制、知识推理和模式匹配等领域有着广泛的应用前景。 西安电子科技大学影彩像处理系统实验室

引言 ❖ Hebb假设 :Donald O.Hebb 在《The Organization of Behavior》一书中提 出:“当细胞A的轴突到细胞B的距离近到足够激励它,且反复地或持续 地刺激B,那么在这两个细胞或一个细胞中将会发生某种增长过程或代谢 反应,增加A对细胞B的刺激效果”。 ❖ 1987年美国Bart Kosko教授提出了一种称为模糊联想记忆神经网络(Fuzzy Associative Memory——FAM,这种联想记忆神经网络是将模糊控制的规 则隐含地分布在整个网络中,在神经网络的基础上通过学习训练产生模糊 规则,一次模糊联想记忆就是一次模糊逻辑推理。 ❖ 在模糊控制、知识推理和模式匹配等领域有着广泛的应用前景。 西安电子科技大学影像处理系统实验室

模糊Hebb FAMs 经典的Hebb学习(作为一种非监督训练)有 m,==m,+S(x)S(y写) 对于一对给定的双极值行向量(X,Y),神经网络要把他们对 应起来用外积关系矩阵编码 M=XToY 种用最小关系编码的模糊Hebb关系矩阵 M=AT o B M=AB=min(ai,bi) 上述法则可叫做模糊外积,或最小关系编码。 西安电子科技大学影彩像处理系统实验室

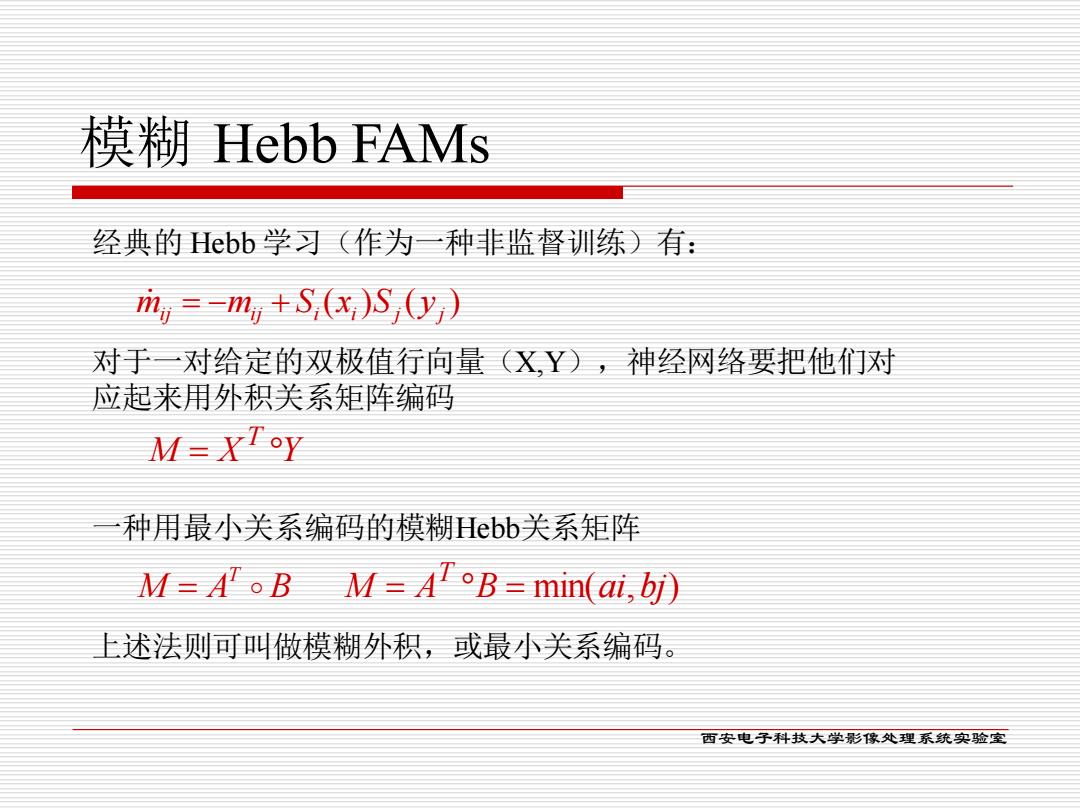

模糊 Hebb FAMs M X Y T = ( ) ( ) ij ij i i j j m = −m + S x S y M A B min(ai,bj) T = = 经典的 Hebb 学习(作为一种非监督训练)有: 对于一对给定的双极值行向量(X,Y),神经网络要把他们对 应起来用外积关系矩阵编码 西安电子科技大学影像处理系统实验室 一种用最小关系编码的模糊Hebb关系矩阵 M A B T = 上述法则可叫做模糊外积,或最小关系编码

模糊Hebb FAMs A=(0.3,0.4,0.8,1 B=(0.8,0.4,0.5) 0.3 0.3,0.3,0.3 M=ATB= 0.4 0.4,0.40.4 0.8,0.4,0.5)= 0.8 0.8,0.40.5 0.8,0.4,0.5 可以看出: 必 每列的元素是每个bj相对与A的最小值,每行是每个ai相对 与B的最小值。 水 如果A中的某个元素比B中的所有元素都大,则M矩阵中的 该行就是B行向量。 必 如果B中的某个元素比A中的所有元素都大,则M矩阵中的 该列就是整个A向量的转置。这就是后面要提出的向量的高 度H(A)。 西安电子科技大学影彩像处理系统实验室

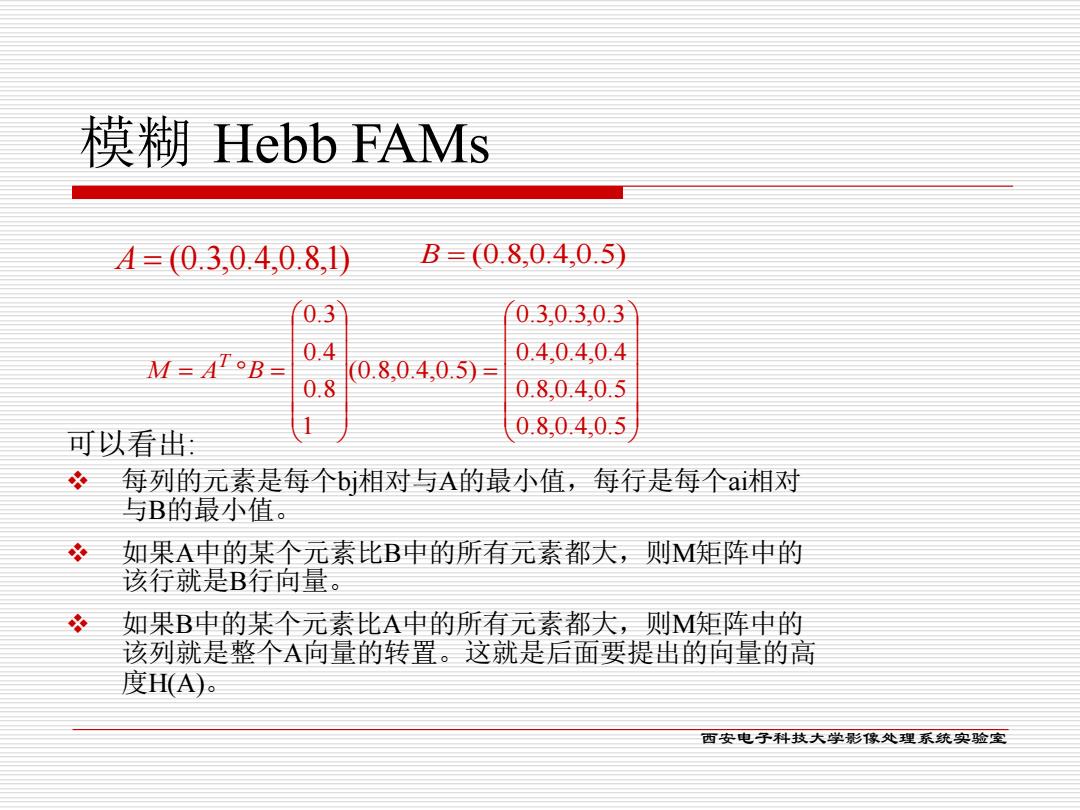

模糊 Hebb FAMs 可以看出: ❖ 每列的元素是每个bj相对与A的最小值,每行是每个ai相对 与B的最小值。 ❖ 如果A中的某个元素比B中的所有元素都大,则M矩阵中的 该行就是B行向量。 ❖ 如果B中的某个元素比A中的所有元素都大,则M矩阵中的 该列就是整个A向量的转置。这就是后面要提出的向量的高 度H(A)。 A = (0.3,0.4,0.8,1) B = (0.8,0.4,0.5) = = = 0.8,0.4,0.5 0.8,0.4,0.5 0.4,0.4,0.4 0.3,0.3,0.3 (0.8,0.4,0.5) 1 0.8 0.4 0.3 M A B T 西安电子科技大学影像处理系统实验室

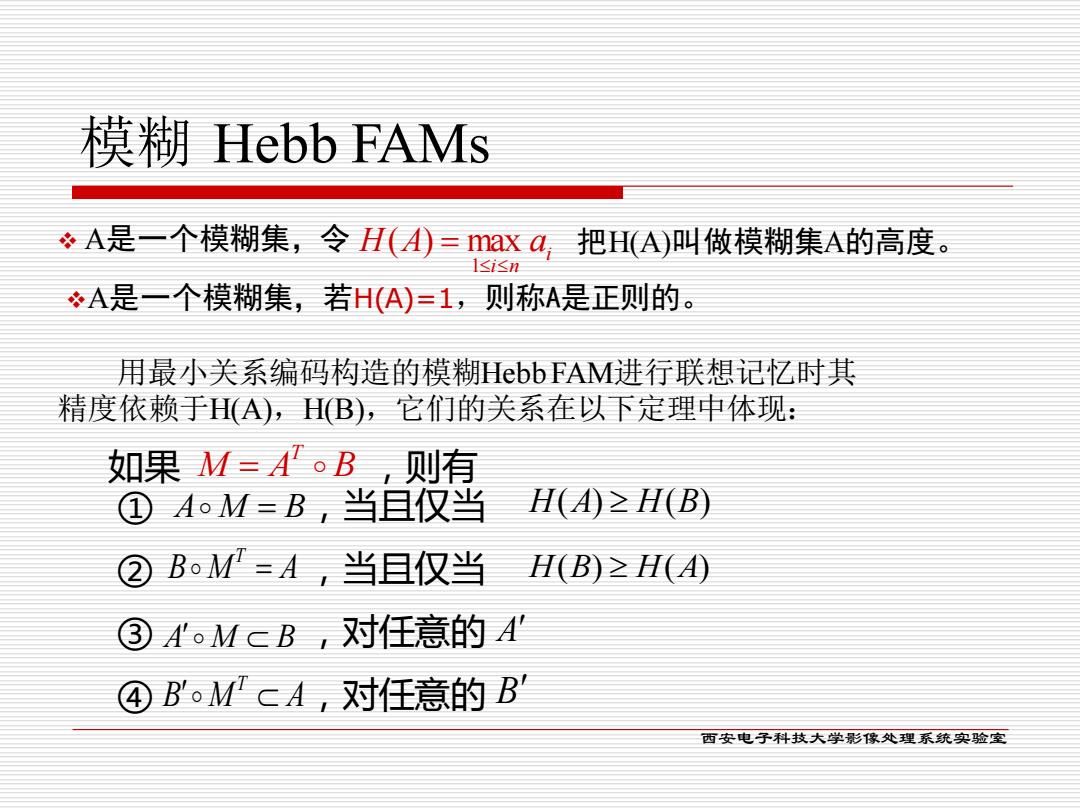

模糊Hebb FAMs ÷A是一个模糊集,令H(=maxa 把H(A)叫做模糊集A的高度。 1≤isn A是一个模糊集,若H(A)=1,则称A是正则的。 用最小关系编码构造的模糊bbFAM进行联想记忆时其 精度依赖于H(A),HB),它们的关系在以下定理中体现: 如果M=A。B,则有 ①AoM=B,当且仅当 H(A≥H(B) ②B。M=A,当且仅当 H(B)≥H(A ③。McB,对任意的建 ④B'oM'CA,对任意的B' 西安电子科技大学影彩像处理系统实验室

模糊 Hebb FAMs ③ ,对任意的 ④ ,对任意的 ② ,当且仅当 ① ,当且仅当 如果 M A B ,则有 T = A M = B B M A T = A M B B M A T H(A) H(B) H(B) H(A) A B 用最小关系编码构造的模糊Hebb FAM进行联想记忆时其 精度依赖于H(A),H(B),它们的关系在以下定理中体现: i i n H A a = 1 ❖ A是一个模糊集,令 ( ) max 把H(A)叫做模糊集A的高度。 ❖A是一个模糊集,若H(A)=1,则称A是正则的。 西安电子科技大学影像处理系统实验室

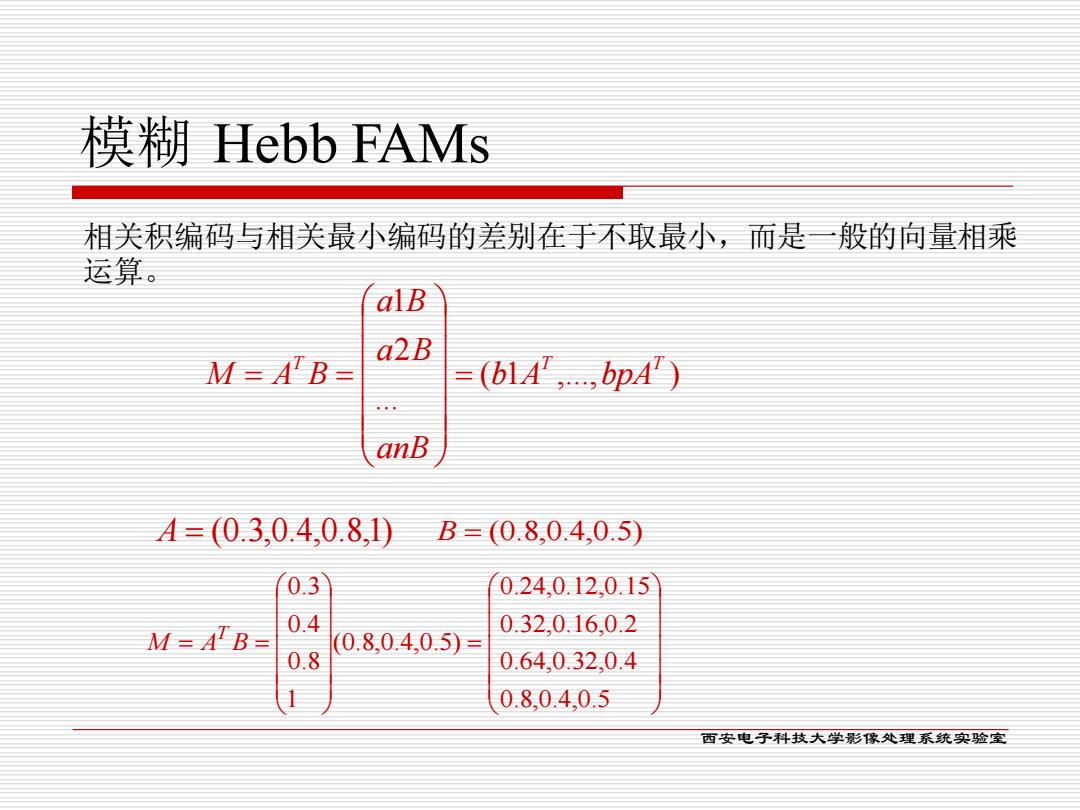

模糊Hebb FAMs 相关积编码与相关最小编码的差别在于不取最小,而是一般的向量相乘 运算。 alB a2B M=ATB= =(b1A',...pA) anB A=(0.3,0.4,0.81D B=(0.8,0.4,0.5) 0.3 0.24.0.12.0.15 0.4 M=AB= 0.32,0.16,0.2 0.8,0.4,0.5) 0.8 0.640.32,0.4 0.8,0.4,0.5 西安电子科技大学影彩像处理系统实验室

模糊 Hebb FAMs ( 1 ,..., ) ... 2 1 T T T b A bpA anB a B a B M A B = = = 相关积编码与相关最小编码的差别在于不取最小,而是一般的向量相乘 运算。 A = (0.3,0.4,0.8,1) B = (0.8,0.4,0.5) = = = 0.8,0.4,0.5 0.64,0.32,0.4 0.32,0.16,0.2 0.24,0.12,0.15 (0.8,0.4,0.5) 1 0.8 0.4 0.3 M A B T 西安电子科技大学影像处理系统实验室

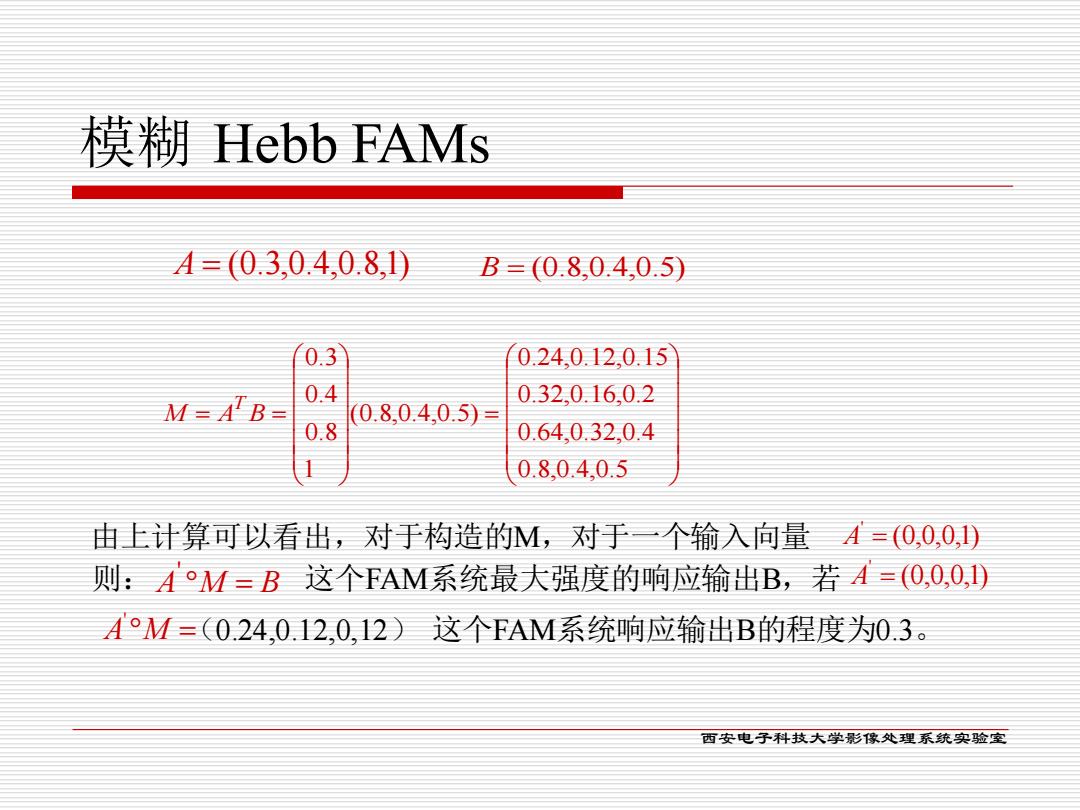

模糊Hebb FAMs A=(0.3,0.4,0.81D B=(0.8,0.4,0.5) 0.3 0.24.0.12,0.15 0.4 M=AB= 0.32,0.16,0.2 0.8,0.4,0.5) 0.8 0.640.32,0.4 0.8,0.4,0.5 由上计算可以看出,对于构造的M,对于一个输入向量A=(0,0,0,1) 则:A°M=B这个FAM系统最大强度的响应输出B,若=(O,0,0,D A°M=(0.24012,0,12)这个FAM系统响应输出B的程度为0.3。 西安电子科技大学影彩像处理系统实验室

模糊 Hebb FAMs (0,0,0,1) ' A = A M = B ' (0,0,0,1) ' A = A = (0.3,0.4,0.8,1) B = (0.8,0.4,0.5) = = = 0.8,0.4,0.5 0.64,0.32,0.4 0.32,0.16,0.2 0.24,0.12,0.15 (0.8,0.4,0.5) 1 0.8 0.4 0.3 M A B T 由上计算可以看出,对于构造的M,对于一个输入向量 则: 这个FAM系统最大强度的响应输出B,若 A ' M = (0.24,0.12,0,12) 这个FAM系统响应输出B的程度为0.3。 西安电子科技大学影像处理系统实验室

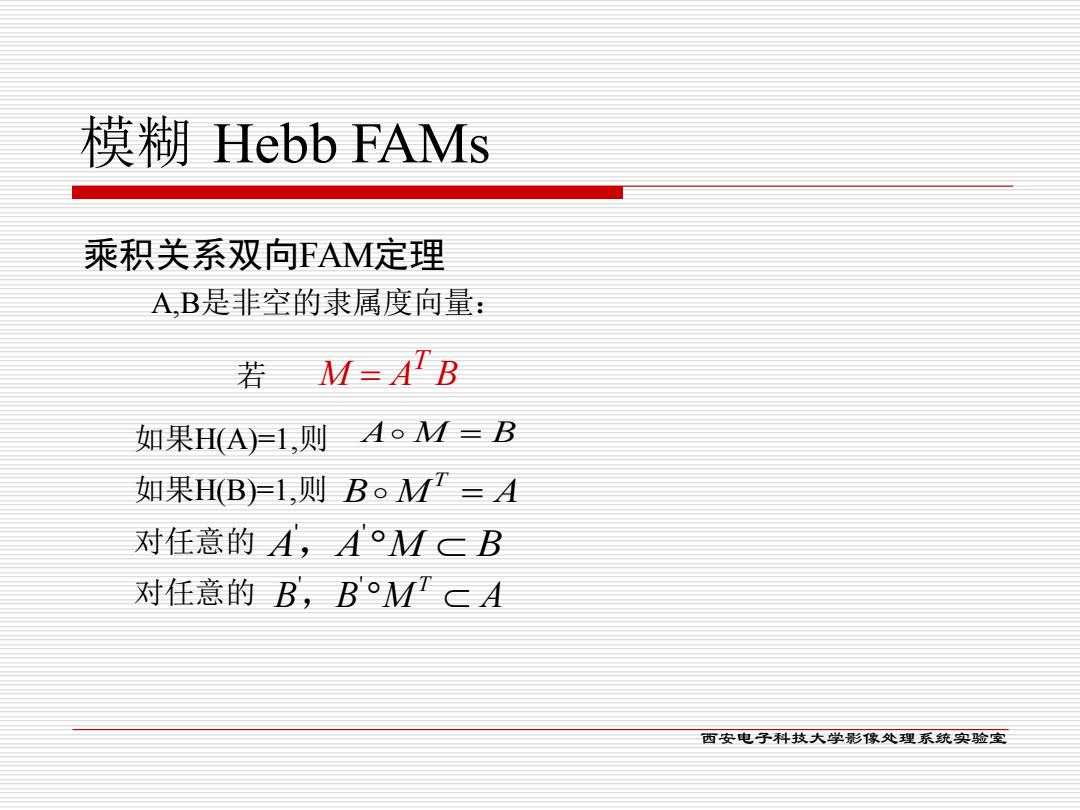

模糊Hebb FAMs 乘积关系双向FAM定理 AB是非空的隶属度向量: 若M=B 如果H(A)1,则AoM=B 如果H(B1,则B。M=A 对任意的A,A°McB 对任意的B,BMcA 西安电子科技大学影彩像处理系统实验室

模糊 Hebb FAMs M A B T = 如果H(A)=1,则 A M = B A,B是非空的隶属度向量: 若 B M A T = A A M B ' , ' B B M A T ' , ' 对任意的 对任意的 乘积关系双向FAM定理 如果H(B)=1,则 西安电子科技大学影像处理系统实验室

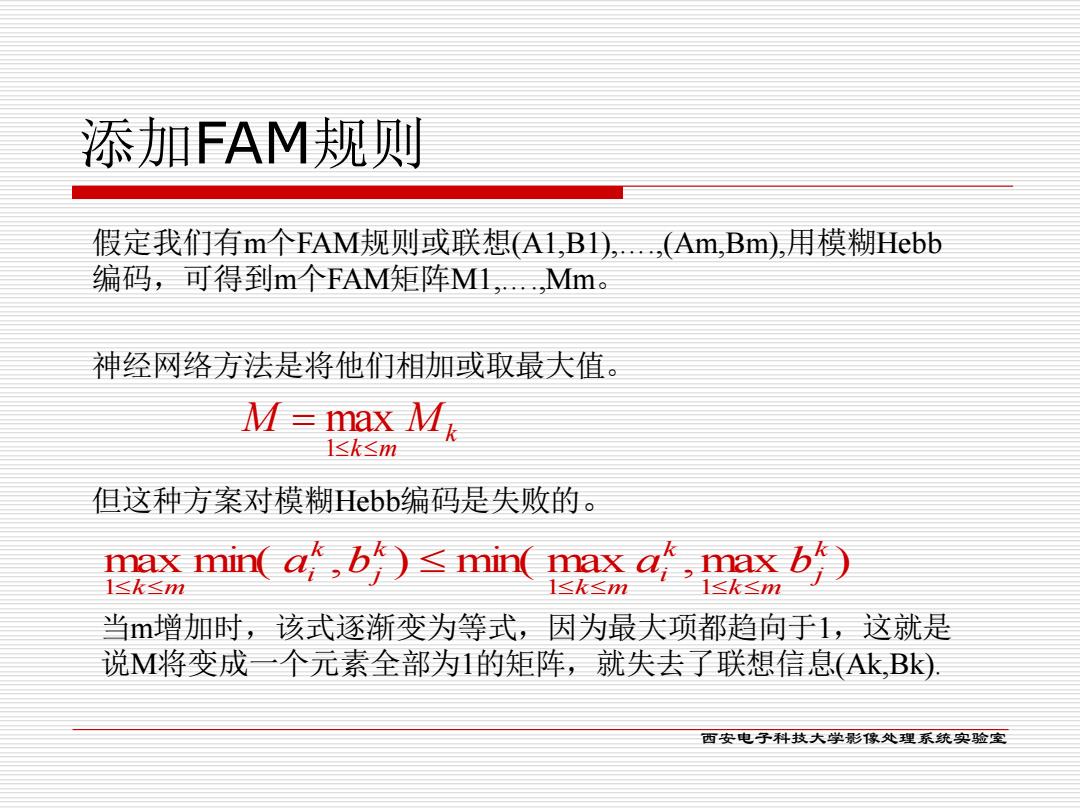

添加FAM规则 假定我们有m个FAM规则或联想(A1,B1).(Am,Bm),用模糊ebb 编码,可得到m个FAM矩阵M1,.Mm。 神经网络方法是将他们相加或取最大值。 M= max Mg 1≤k≤m 但这种方案对模糊Hebb编码是失败的。 mm(ab)≤mm(axa哈ab) 1≤k≤m 1≤k≤m 当m增加时,该式逐渐变为等式,因为最大项都趋向于1,这就是 说M将变成一个元素全部为1的矩阵,就失去了联想信息(Ak,Bk. 西安电子科技大学影彩像处理系统实验室

添加FAM规则 神经网络方法是将他们相加或取最大值。 k k m M M = 1 max 但这种方案对模糊Hebb编码是失败的。 max min( , ) min( max ,max ) 1 1 1 k j k m k i k m k j k i k m a b a b 假定我们有m个FAM规则或联想(A1,B1),….,(Am,Bm),用模糊Hebb 编码,可得到m个FAM矩阵M1,….,Mm。 当m增加时,该式逐渐变为等式,因为最大项都趋向于1,这就是 说M将变成一个元素全部为1的矩阵,就失去了联想信息(Ak,Bk). 西安电子科技大学影像处理系统实验室