有京大赞 选择性集成 金ERS (Selective Ensemble) 周志华 http://cs.nju.edu.cn/people/zhouzh/ Email:zhouzh@nju.edu.cn 南京大学计算机软件新技术国家重点实验室

选择性集成 (Selective Ensemble) 周志华 http://cs.nju.edu.cn/people/zhouzh/ Email: zhouzh@nju.edu.cn 南京大学计算机软件新技术国家重点实验室

泛化能力 泛化:generalization 泛化能力越强,处理新数据的能力越好 泛化能力是机器学习关注的基本问题之一 提高泛化能力是永远的追求

泛化:generalization 泛化能力越强,处理新数据的能力越好 泛化能力是机器学习关注的基本问题之一 提高泛化能力是永远的追求 泛化能力

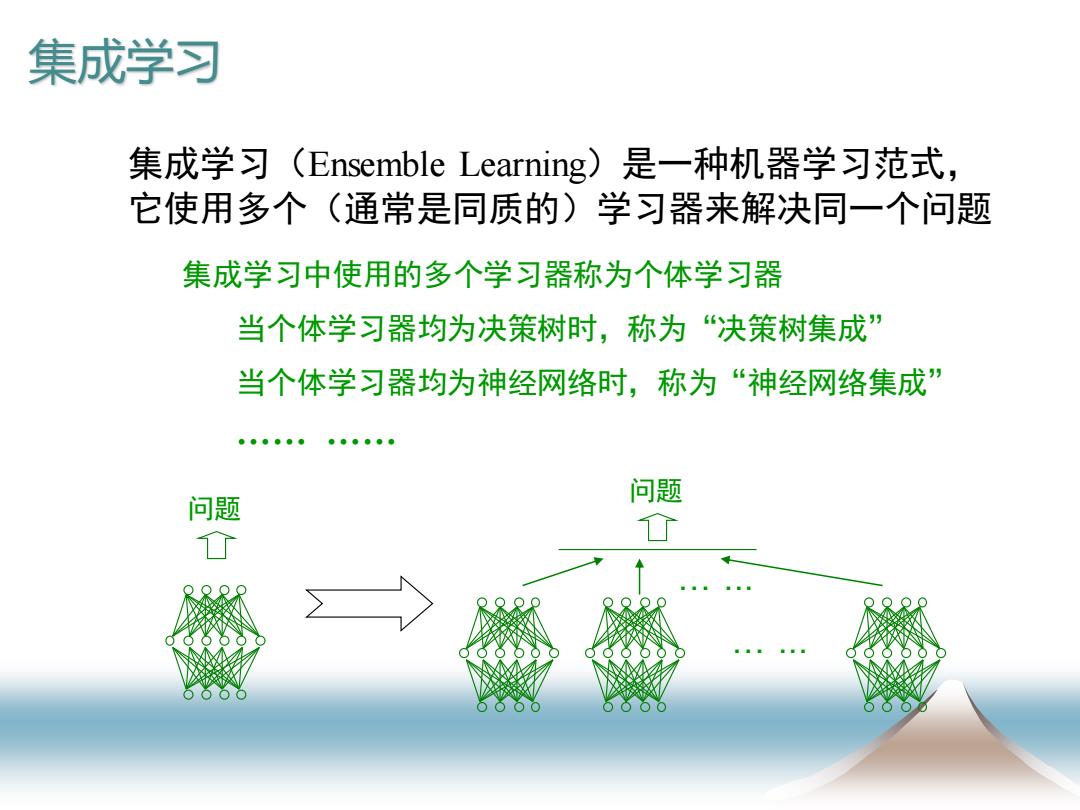

集成学习 集成学习(Ensemble Learning)是一种机器学习范式, 它使用多个(通常是同质的)学习器来解决同一个问题 集成学习中使用的多个学习器称为个体学习器 当个体学习器均为决策树时,称为“决策树集成” 当个体学习器均为神经网络时,称为“神经网络集成 问题 问题 0 0

集成学习(Ensemble Learning)是一种机器学习范式, 它使用多个(通常是同质的)学习器来解决同一个问题 集成学习 问题 … ... … ... 问题 集成学习中使用的多个学习器称为个体学习器 当个体学习器均为决策树时,称为“决策树集成” 当个体学习器均为神经网络时,称为“神经网络集成” …… ……

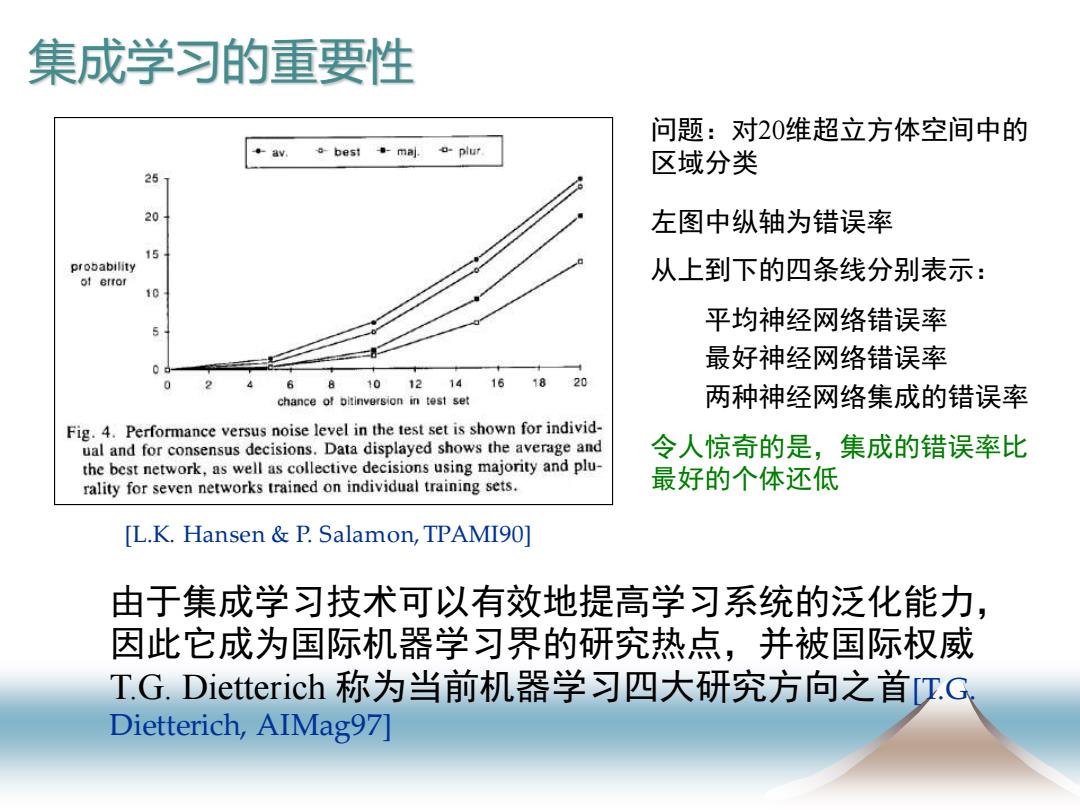

集成学习的重要性 问题:对20维超立方体空间中的 。bes时·maj.o-plur 区域分类 25 20 左图中纵轴为错误率 15 probability 从上到下的四条线分别表示: of error 10 平均神经网络错误率 最好神经网络错误率 6 81012141618 20 chance of bitinversion in test set 两种神经网络集成的错误率 Fig.4.Performance versus noise level in the test set is shown for individ- ual and for consensus decisions.Data displayed shows the average and 令人惊奇的是,集成的错误率比 the best network,as well as collective decisions using majority and plu- rality for seven networks trained on individual training sets. 最好的个体还低 [L.K.Hansen P.Salamon,TPAMI90] 由于集成学习技术可以有效地提高学习系统的泛化能力, 因此它成为国际机器学习界的研究热点,并被国际权威 T.G.Dietterich称为当前机器学习四大研究方向之首T.G Dietterich,AIMag97]

由于集成学习技术可以有效地提高学习系统的泛化能力, 因此它成为国际机器学习界的研究热点,并被国际权威 T.G. Dietterich 称为当前机器学习四大研究方向之首[T.G. Dietterich, AIMag97] 集成学习的重要性 问题:对20维超立方体空间中的 区域分类 左图中纵轴为错误率 从上到下的四条线分别表示: 平均神经网络错误率 最好神经网络错误率 两种神经网络集成的错误率 令人惊奇的是,集成的错误率比 最好的个体还低 [L.K. Hansen & P. Salamon, TPAMI90]

集成学习的用处 集成学习技术已经在行星探测、地震波分析、 Wb信息过滤、生物特征识别、计算机辅助医 疗诊断等众多领域得到了广泛的应用 只要能用到机器学习的地方,就能用到 集成学习

集成学习的用处 集成学习技术已经在行星探测、地震波分析、 Web信息过滤、生物特征识别、计算机辅助医 疗诊断等众多领域得到了广泛的应用 只要能用到机器学习的地方,就能用到 集成学习

如何构建好的集成 期望结果 期望结果 个体1(精度33.3%) 个体1(精度33.3%) 个体2(精度33.3%) 集成(精度33.3%) 个体2(精度33.3%) 集成(精度0%) 个体3(精度33.3%) 个体3(精度33.3%) 投票 投票 个体必须有差异 个体精度不能太低 EE-4 IA.Krogh &Vedelsby,NIPS94] 个体学习器越精确、差异越大,集成越好

期望结果 个体1 (精度33.3%) 个体2 (精度33.3%) 个体3 (精度33.3%) 集成(精度33.3%) 投票 个体必须有差异 期望结果 个体1 (精度33.3%) 个体2 (精度33.3%) 个体3 (精度33.3%) 集成 (精度0%) 投票 个体精度不能太低 E E A = − 个体学习器越精确、差异越大,集成越好 [A. Krogh & J. Vedelsby, NIPS94] 如何构建好的集成

个体越多越好吗? 既然多个个体的集成比单个个体更好,那么是 不是个体越多越好? 更多的个体意味着: ·在预测时需要更大的计算开销,因为要计算更多的个体预测 ·更大的存储开销,因为有更多的个体需要保存 个体的增加将使得个体间的差异越来越难以获得

既然多个个体的集成比单个个体更好,那么是 不是个体越多越好? 更多的个体意味着: • 在预测时需要更大的计算开销,因为要计算更多的个体预测 • 更大的存储开销,因为有更多的个体需要保存 个体的增加将使得个体间的差异越来越难以获得 个体越多越好吗?

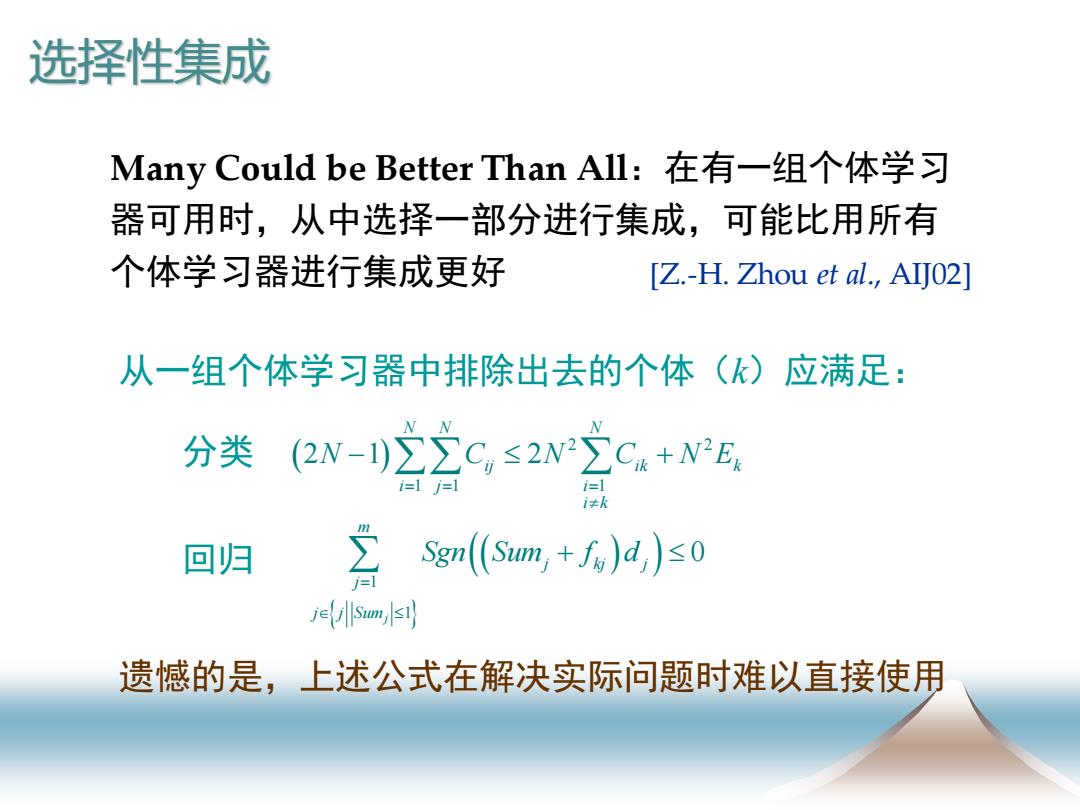

选择性集成 Many Could be Better Than All:在有一组个体学习 器可用时,从中选择一部分进行集成,可能比用所有 个体学习器进行集成更好 [Z.-H.Zhou et al.,AIJ02] 从一组个体学习器中排除出去的个体(k)应满足: 分类 (2w-1)22C,≤2w22C4+N2E 回归 立Sgn((Sumn,+,)d)s0 jesum s1 遗憾的是,上述公式在解决实际问题时难以直接使用

( ) 2 2 1 1 1 2 1 2 N N N ij ik k i j i i k N C N C N E = = = − + Many Could be Better Than All:在有一组个体学习 器可用时,从中选择一部分进行集成,可能比用所有 个体学习器进行集成更好 [Z.-H. Zhou et al., AIJ02] 从一组个体学习器中排除出去的个体(k)应满足: 分类 (( ) ) 1 1 0 j m j kj j j j j Sum Sgn Sum f d = + 选择性集成 回归 遗憾的是,上述公式在解决实际问题时难以直接使用

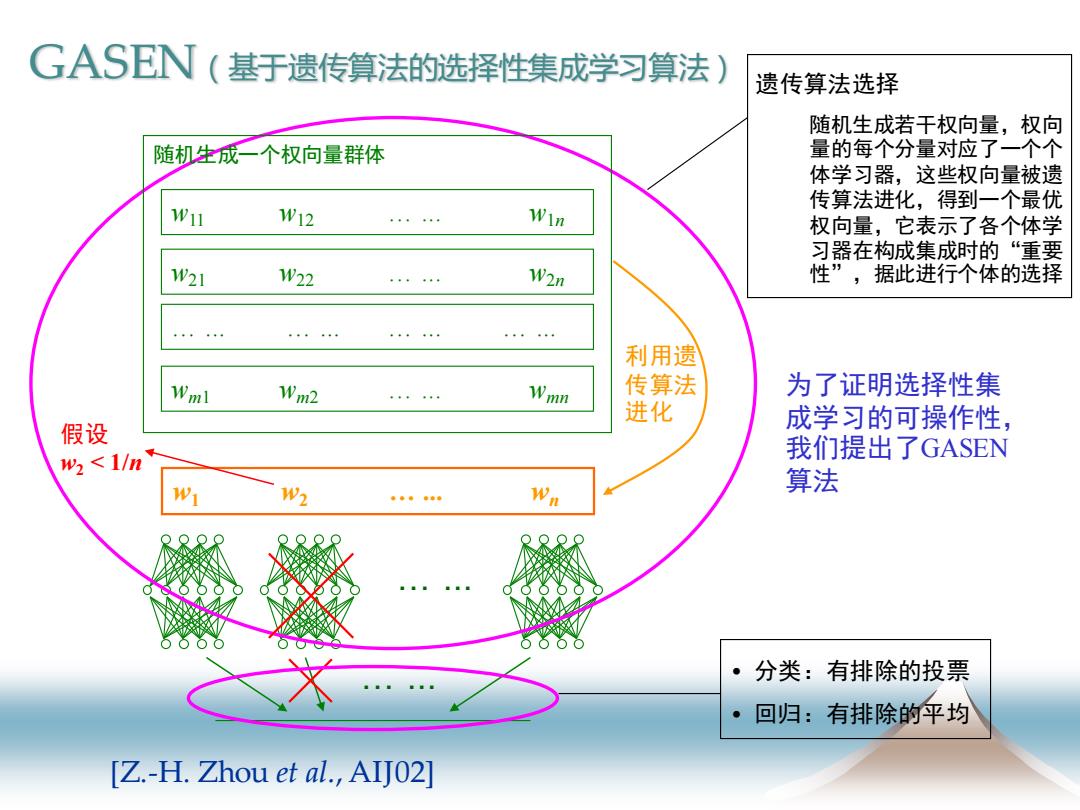

GASEN(基于遗传算法的选择性集成学习算法) 遗传算法选择 随机生成若干权向量,权向 随机生成一个权向量群体 量的每个分量对应了一个个 体学习器,这些权向量被遗 传算法进化,得到一个最优 W11 W12 。。。。。 Win 权向量,它表示了各个体学 习器在构成集成时的“重要 1W21 1W22 W2n 性”,据此进行个体的选择 …4…。4… 。。…… ·◆·。。 ”444”4 利用遗 Wml Wm2 Wmn 传算法 为了证明选择性集 进化 假设 成学习的可操作性, w<1/n 我们提出了GASEN W2 Wn 算法 第象象非非草 。 分类:有排除的投票 回归:有排除的平均 [Z.-H.Zhou et al.,AIJ02

… ... w1 w2 … ... wn 利用遗 传算法 进化 … ... 遗传算法选择 随机生成若干权向量,权向 量的每个分量对应了一个个 体学习器,这些权向量被遗 传算法进化,得到一个最优 权向量,它表示了各个体学 习器在构成集成时的“重要 性”,据此进行个体的选择 假设 w2 < 1/n • 分类:有排除的投票 • 回归:有排除的平均 为了证明选择性集 成学习的可操作性, 我们提出了GASEN 算法 w11 w12 … ... w1n w21 w22 … ... w2n wm1 wm2 … ... wmn 随机生成一个权向量群体 … ... … ... … ... … ... [Z.-H. Zhou et al., AIJ02] GASEN(基于遗传算法的选择性集成学习算法)

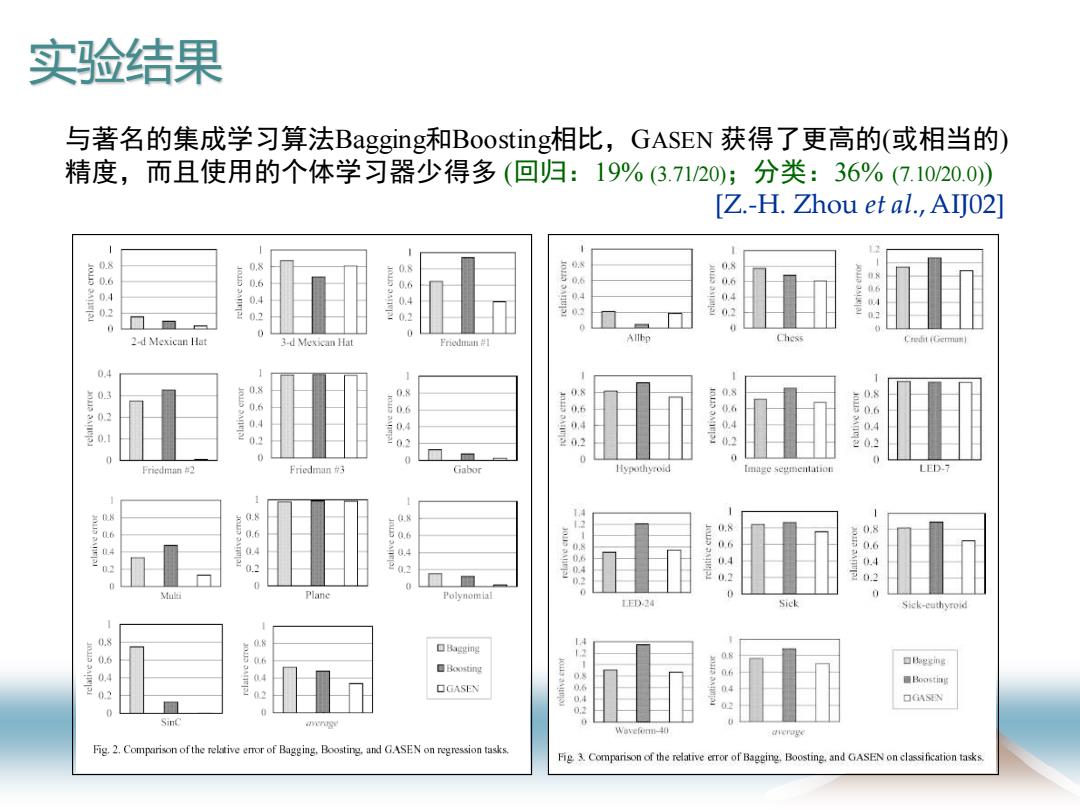

实验结果 与著名的集成学习算法Bagging和Boosting相比,GASEN获得了更高的(或相当的) 精度,而且使用的个体学习器少得多(回归:19%3.71/20);分类:36%(7.1020.0) [Z.-H.Zhou et al.,AIJ02 0.8 08 0 8 0 0.2 0 0 2-d Mexican Hat 3-d Mexican Hat Friodian Chess C.redit (Cermun 0.4 0.8 0.8 0.8 0 06 IOLD OMIEA 0 0 Friedman #2 Friedman 3 Gabor Hypothyroid LED-7 08 02 国 《 Plane Polynomial LED-24 Sick Sick-euthyroid 口agn坚 08 口eeing 04 口Boosting 6 ■Boostin 0.2 02 口GASEN 04 02 SinC Fig.2.Comparison of the relative eror of Bagging.Boosting.and GASEN on regression tasks. Fig 3.Comparison of the relative error of Bagging.Boosting.and GASEN on classification tasks

与著名的集成学习算法Bagging和Boosting相比,GASEN 获得了更高的(或相当的) 精度,而且使用的个体学习器少得多 (回归:19% (3.71/20);分类:36% (7.10/20.0)) [Z.-H. Zhou et al., AIJ02] 实验结果