第五章突触动力学Ⅱ:有监督学习 当现有的先验知识不完全时,就需要学习。学习的方式 取决于这一先验信息不完全的程度。在监督学习过程中,假 设已知未来学习系统的期望响应,并且使用期望值与实际值 的差值(即学习系统的误差)去修正系统的行为。而在非监 督学习中是不了解学习系统的期望响应的。 ---Ya.Z.Tsypkin 神经网络通过向环境获取知识并改进自身性能。一般是 按某种预定的度量调节自身的参数(如权值)随时间逐步达 到的。 ----B.F.Skinner

第五章 突触动力学Ⅱ:有监督学习 当现有的先验知识不完全时,就需要学习。学习的方式 取决于这一先验信息不完全的程度。在监督学习过程中,假 设已知未来学习系统的期望响应,并且使用期望值与实际值 的差值(即学习系统的误差)去修正系统的行为。而在非监 督学习中是不了解学习系统的期望响应的。 ----Ya.Z.Tsypkin 神经网络通过向环境获取知识并改进自身性能。一般是 按某种预定的度量调节自身的参数(如权值)随时间逐步达 到的。 ----B.F.Skinner

本章论述要点: 神经网络的分类: 按网络结构分为:反馈网络和前馈网络; 按学习方式分为:监督学习和非监督学习。 本章论述内容: 前馈网络的监督学习算法,包括感知器算法、最小均方误差算法和 反向传播(BP)算法。 理论基础: 本章论述了监督学习是对未知平均误差层的随机近似,即给定观察 得到的随机矢量样本对: (x1,y),(x2,2),…(xmym) 要估计一个未知函数:f:x一y,并且使期望误差函数EU]最小。误 差定义为期望特性与实际特性之差

本章论述要点: 神经网络的分类: 按网络结构分为:反馈网络和前馈网络; 按学习方式分为:监督学习和非监督学习。 本章论述内容: 前馈网络的监督学习算法,包括感知器算法、最小均方误差算法和 反向传播(BP) 算法。 理论基础: 本章论述了监督学习是对未知平均误差层的随机近似,即给定观察 得到的随机矢量样本对: 1 1 2 2 ( , ), ( , ), ( , ) m m x y x y x y 要估计一个未知函数:f : x—y,并且使期望误差函数E[J]最小。误 差定义为期望特性与实际特性之差

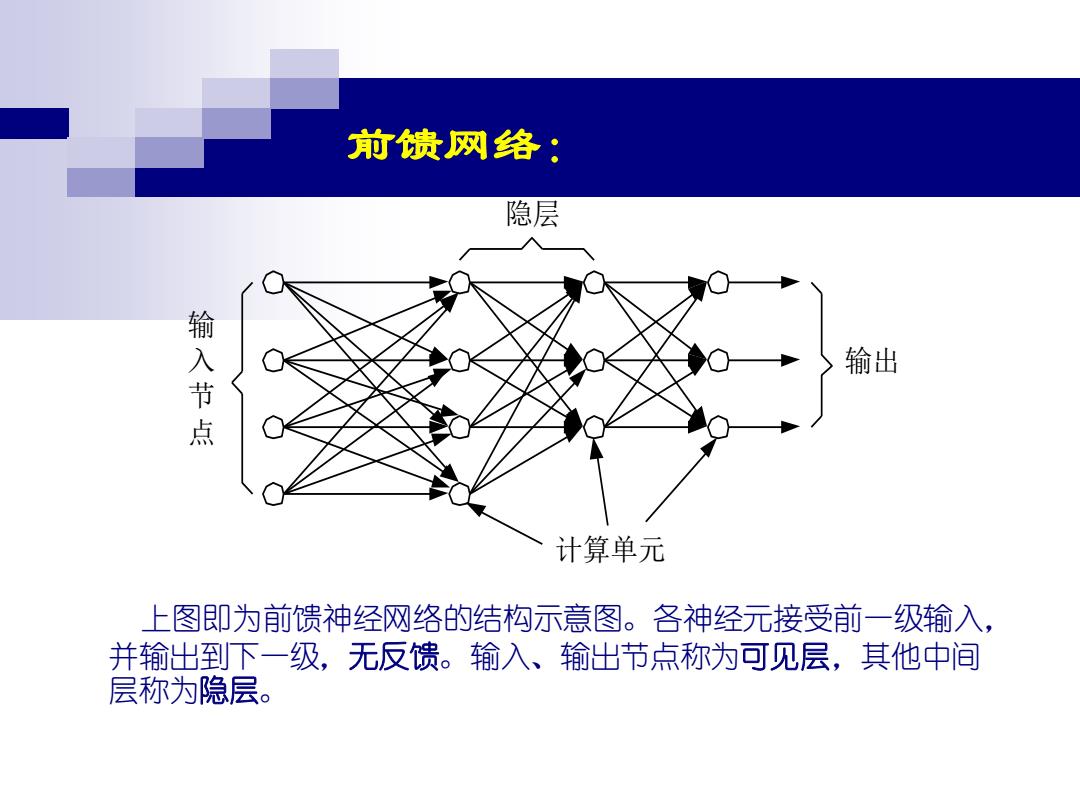

前债网络: 隐层 输 入节点 输出 计算单元 上图即为前馈神经网络的结构示意图。各神经元接受前一级输入, 并输出到下一级,无反馈。输入、输出节点称为可见层,其他中间 层称为隐层

前馈网络: 输出 隐层 输 入 节 点 计算单元 上图即为前馈神经网络的结构示意图。各神经元接受前一级输入, 并输出到下一级,无反馈。输入、输出节点称为可见层,其他中间 层称为隐层

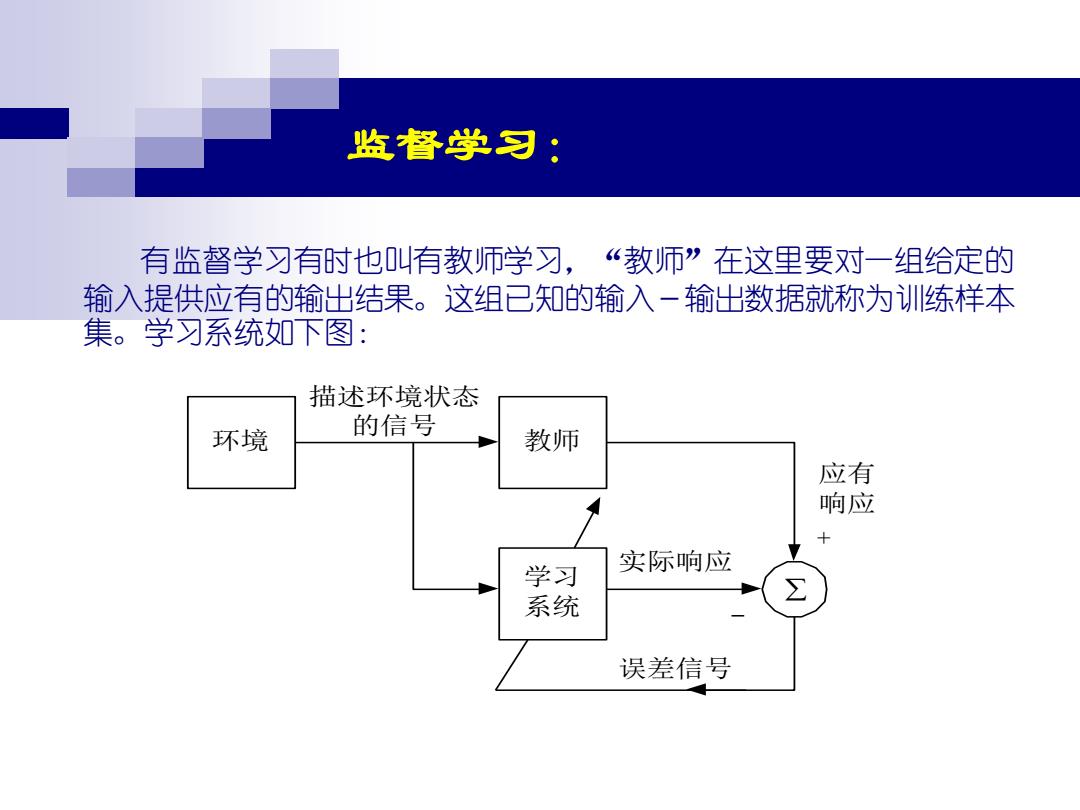

监督学习; 有监督学习有时也叫有教师学习,“教师”在这里要对一组给定的 输入提供应有的输出结果。这组已知的输入一输出数据就称为训练样本 集。学习系统如下图: 描述环境状态 环境 的信号 教师 应有 响应 学习 实际响应 系统 误差信号

监督学习: 有监督学习有时也叫有教师学习,“教师”在这里要对一组给定的 输入提供应有的输出结果。这组已知的输入-输出数据就称为训练样本 集。学习系统如下图: 环境 教师 学习 系统 实际响应 误差信号 应有 响应 描述环境状态 的信号 + -

论述内容: >有监督的函数估计 >有监督的学习相当于操作性条件反射 >有监督的学习相当于有先验知识的随机模式学习 >算法,感知器,LMS,BP

➢ 有监督的函数估计 ➢ 有监督的学习相当于操作性条件反射 ➢ 有监督的学习相当于有先验知识的随机模式学习 ➢ 算法,感知器,LMS,BP 论述内容:

有监督的函数估计: 神经网络引进的函数估计的概念为:已知随机样本矢量对 (x,y),…(xm,ym),要从这些样本中估计出产生这些样本 矢量对的函数,即:∫:x→y 其中:x,∈xcR” 是输入空间 y,∈yCRP 是输出空间 f 是要估计的泛函 所采用的方法为是使一个未知期望的误差函数E(J) (也叫目标函数)最小化

有监督的函数估计: 神经网络引进的函数估计的概念为:已知随机样本矢量对 1 1 , ), ( , ) m m (x y x y ,要从这些样本中估计出产生这些样本 矢量对的函数 f ,即: f x y : → 其中: n i x x R 是输入空间 p i y y R 是输出空间 f 是要估计的泛函 所采用的方法为是使一个未知期望的误差函数 E J( ) (也叫目标函数)最小化

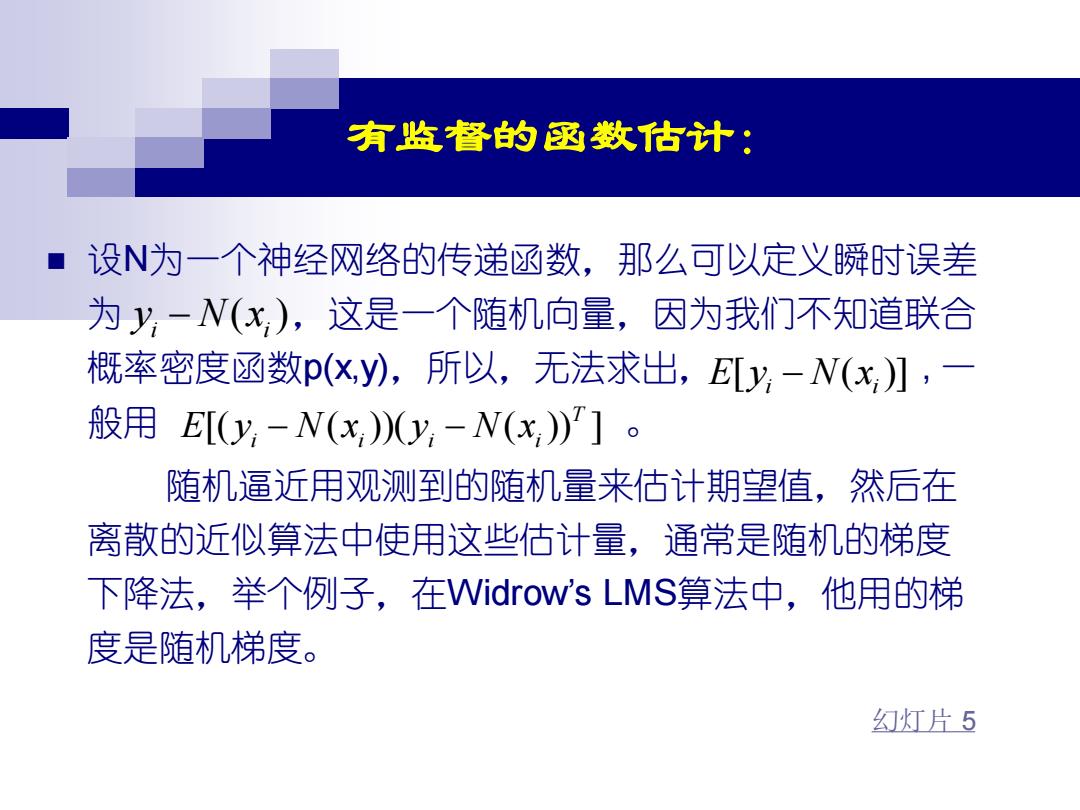

有监督的函数估计: ■设N为一个神经网络的传递函数,那么可以定义瞬时误差 为y,-W(x),这是一个随机向量,因为我们不知道联合 概率密度函数p(X,y),所以,无法求出,ELy-N(x】,一 般用Ey,-N(x)y,-N(x)']。 随机逼近用观测到的随机量来估计期望值,然后在 离散的近似算法中使用这些估计量,通常是随机的梯度 下降法,举个例子,在Vidrow's LMS算法中,他用的梯 度是随机梯度。 幻灯片5

有监督的函数估计: ◼ 设N为一个神经网络的传递函数,那么可以定义瞬时误差 为 ,这是一个随机向量,因为我们不知道联合 概率密度函数p(x,y),所以,无法求出, , 一 般用 。 随机逼近用观测到的随机量来估计期望值,然后在 离散的近似算法中使用这些估计量,通常是随机的梯度 下降法,举个例子,在Widrow’s LMS算法中,他用的梯 度是随机梯度。 ( ) i i y N x − [ ( )] E y N x i i − [( ( ))( ( )) ] T E y N x y N x i i i i − − 幻灯片 5

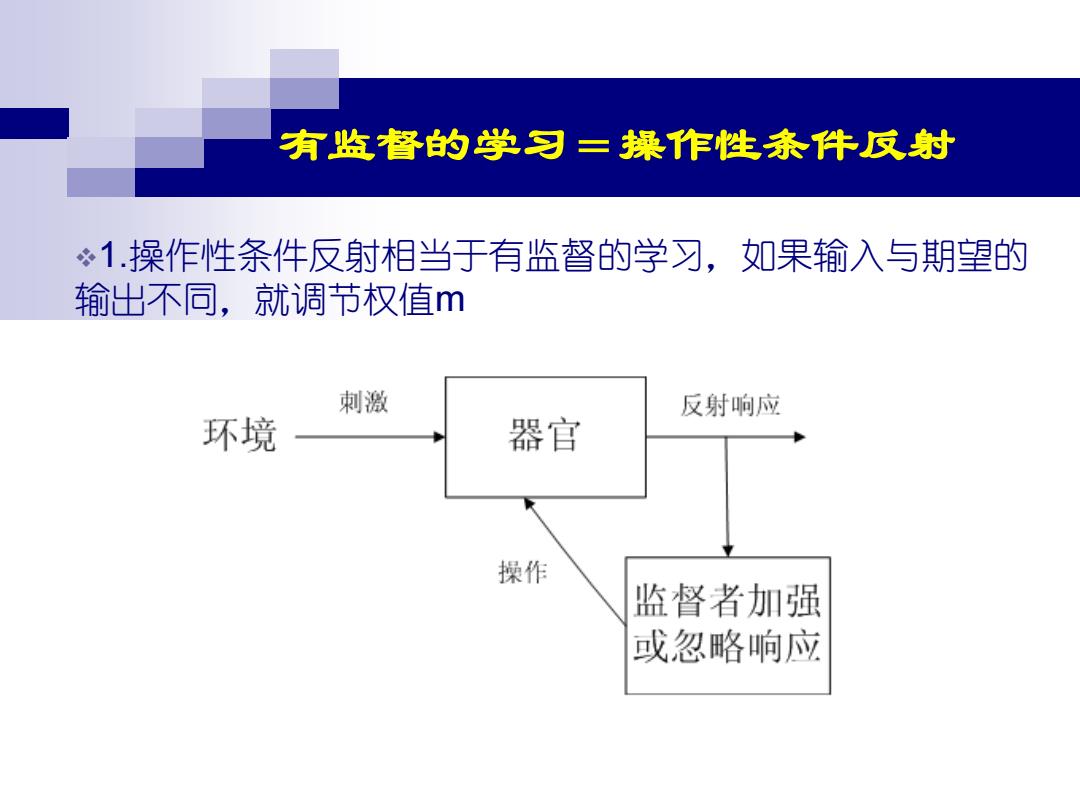

有监督的学习二操作性条件反射 1.操作性条件反射相当于有监督的学习,如果输入与期望的 输出不同,就调节权值m 刺激 反射响应 环境 器官 操作 监督者加强 或忽略响应

有监督的学习=操作性条件反射 幻灯片 5 ❖1.操作性条件反射相当于有监督的学习,如果输入与期望的 输出不同,就调节权值m

有监督的学习二操作性条件反射 2.传统条件反射(相对于非条件反射的概念),神经网络直接 把输入耦合到输出y 有效条件强化响应(Operant conditioning reinforce responses)。条件聚 类强化了刺激,例如,一个生物体学会了一刺激响应对:S→R,那么 在条件刺激S中加一个条件B进行学习,即: (B&S)→R或B→(S→R) 这样不断强化刺激,直到输入B时反应为R。这样就有:B→R 也就是学会了一条规测。这样的例子如巴普洛夫条件反射试验。 巴普 食物S 流口水R 巴普 流口水R 狗 洛夫 狗 洛夫 托铃档B 摇铃铛B

有监督的学习=操作性条件反射 幻灯片 5 ❖2.传统条件反射(相对于非条件反射的概念),神经网络直接 把输入x耦合到输出y 有效条件强化响应(Operant conditioning reinforce responses)。条件聚 类强化了刺激,例如,一个生物体学会了一刺激响应对: S R → 在条件刺激 S中加一个条件 B 进行学习,即: ( & ) ( ) B S R B S R → → → 或 这样不断强化刺激,直到输入 B 时反应为 R。这样就有: B R → 也就是学会了一条规则。这样的例子如巴普洛夫条件反射试验。 ,那么 返回

有监督的学习 =有先验知识的随机模式学习 例1:用已知的类隶属度作为随机模式学习的有监督学习 模式:定义为模式空间R”的一个点; 时变模式:空间R”中的一条轨迹线; 映射x:[0,T]→R”定义了从时间区间[0,T]到模式空间R” 中单点的映射。 概率密度p(x):为模式x在R”中的分布的一种描述。 模式类:为空间R”的子集。 目的:是用已知的样本:x(1),x(2)…及模式类来估计p(x)

有监督的学习 =有先验知识的随机模式学习 幻灯片 5 例1:用已知的类隶属度作为随机模式学习的有监督学习 模式:定义为模式空间 的一个点; n R 时变模式:空间 中的一条轨迹线; 映射 :[0, ] n x T R → 定义了从时间区间 [0, ] T 到模式空间 n R 中单点的映射。 概率密度 p x( ) :为模式 x 在 中的分布的一种描述。 模式类:为空间 的子集。 目的:是用已知的样本: x x (1), (2) 及模式类来估计 p x( ) n R n R n R