第9卷第5期 智能系统学报 Vol.9 No.5 2014年10月 CAAI Transactions on Intelligent Systems 0ct.2014 D0:10.3969/j.issn.1673-4785.201307057 一种简便的视角无关动作识别方法 王策,姬晓飞,李一波 (沈阳航空航天大学自动化学院,辽宁沈阳110136) 摘要:针对日常生活中人体执行动作时存在视角变化而导致难以识别的问题,提出一种基于视角空间切分的多视 角空间隐马尔可夫模型(HMM)概率融合的视角无关动作识别算法。该方法首先按照人体相对于摄像机的旋转方 向将视角空间分割为多个子空间,然后选取兴趣点视频段词袋特征与分区域的光流特征相融合,形成具有一定视角 鲁棒性特征对人体运动信息进行描述,并在每个子视角空间下利用HMM建立各人体动作的模型,最终通过将多视 角空间相应的动作模型似然概率加权融合,实现对未知视角动作的识别。利用多视角XMAS动作识别数据库对该 算法进行测试的实验结果表明,该算法实现简单且对未知视角下的动作具有较好识别结果。 关键词:动作识别:视角无关:视角空间切分;兴趣点;光流特征;混合特征;隐马尔可夫模型:似然概率加权融合 中图分类号:TP391.4文献标志码:A文章编号:1673-4785(2014)05-0577-07 中文引用格式:王策,姬晓飞,李一波.一种简便的视角无关动作识别方法[J].智能系统学报,2014,9(5):577-583. 英文引用格式:WANG Ce,JI Xiaofei,LI Yibo.Study on a simple view-.invariant action recognition method[J].CAAI Transac- tions on Intelligent Systems,2014,9(5):577-583. Study on a simple view-invariant action recognition method WANG Ce,JI Xiaofei LI Yibo (School of Automation,Shenyang Aerospace University,Shenyang 110136,China) Abstract:It is difficult to recognize the human actions under view changes in daily living.In order to solve this problem,a novel multi-view space hidden Markov model algorithm for view-invariant action recognition based on view space partitioning is proposed in this paper.First,the whole view space is partitioned into multiple sub-view spaces according to the rotation direction of a person relative to camera.Next,a view-robust feature representation by combination of the bag of interest point words in shot length-based video and amplitude histogram of local optical flow is utilized for describing the information of human actions.Thereafter,the human action models in each sub- view space are trained by HMM algorithm.Finally,the unknown view action is recognized via the likelihood proba- bility weighted fusion of the corresponding action models in multi-view space.The experimental results on multi- view action recognition dataset IXMAS demonstrated that the proposed approach is easy to implement and has satis- factory performance for the unknown view action recognition. Keywords:action recognition;view-invariant;view-space partitioning;interest points;optical flow;mixed fea- ture;hidden Markov model:likelihood probability weighted fusion 基于视频的动作识别研究具有广阔的应用前 与摄像机的成像平面平行,或要求摄像机随人体同 景12。目前大多数动作识别方法都要求运动人体 步运动,即人体相对于摄像机之间的视角固定或在 一定范围内运动,然而这样的要求在现实中往往不 收稿日期:2013-07-30. 基金项目:国家自然科学基金资助项目(61103123). 能得到满足。在实际应用中,人体相对于摄像机的 通信作者:姬晓飞.E-mail:jixiaofei7804@126.com 视角通常是任意的、不受约束的,这就要求动作识别

第 9 卷第 5 期 智 能 系 统 学 报 Vol.9 №.5 2014 年 10 月 CAAI Transactions on Intelligent Systems Oct. 2014 DOI:10.3969 / j.issn.1673⁃4785.201307057 一种简便的视角无关动作识别方法 王策,姬晓飞,李一波 (沈阳航空航天大学 自动化学院,辽宁 沈阳 110136) 摘 要:针对日常生活中人体执行动作时存在视角变化而导致难以识别的问题,提出一种基于视角空间切分的多视 角空间隐马尔可夫模型(HMM) 概率融合的视角无关动作识别算法。 该方法首先按照人体相对于摄像机的旋转方 向将视角空间分割为多个子空间,然后选取兴趣点视频段词袋特征与分区域的光流特征相融合,形成具有一定视角 鲁棒性特征对人体运动信息进行描述,并在每个子视角空间下利用 HMM 建立各人体动作的模型,最终通过将多视 角空间相应的动作模型似然概率加权融合,实现对未知视角动作的识别。 利用多视角 IXMAS 动作识别数据库对该 算法进行测试的实验结果表明,该算法实现简单且对未知视角下的动作具有较好识别结果。 关键词:动作识别;视角无关;视角空间切分;兴趣点;光流特征;混合特征;隐马尔可夫模型;似然概率加权融合 中图分类号: TP391.4 文献标志码:A 文章编号:1673⁃4785(2014)05⁃0577⁃07 中文引用格式:王策,姬晓飞,李一波. 一种简便的视角无关动作识别方法[J]. 智能系统学报, 2014, 9(5): 577⁃583. 英文引用格式:WANG Ce, JI Xiaofei , LI Yibo. Study on a simple view⁃invariant action recognition method[ J]. CAAI Transac⁃ tions on Intelligent Systems, 2014, 9(5): 577⁃583. Study on a simple view⁃invariant action recognition method WANG Ce, JI Xiaofei , LI Yibo (School of Automation, Shenyang Aerospace University, Shenyang 110136, China) Abstract:It is difficult to recognize the human actions under view changes in daily living. In order to solve this problem, a novel multi⁃view space hidden Markov model algorithm for view⁃invariant action recognition based on view space partitioning is proposed in this paper. First, the whole view space is partitioned into multiple sub⁃view spaces according to the rotation direction of a person relative to camera. Next, a view⁃robust feature representation by combination of the bag of interest point words in shot length⁃based video and amplitude histogram of local optical flow is utilized for describing the information of human actions. Thereafter, the human action models in each sub- view space are trained by HMM algorithm. Finally, the unknown view action is recognized via the likelihood proba⁃ bility weighted fusion of the corresponding action models in multi⁃view space. The experimental results on multi⁃ view action recognition dataset IXMAS demonstrated that the proposed approach is easy to implement and has satis⁃ factory performance for the unknown view action recognition. Keywords:action recognition; view⁃invariant; view⁃space partitioning; interest points; optical flow; mixed fea⁃ ture; hidden Markov model; likelihood probability weighted fusion 收稿日期:2013⁃07⁃30. 基金项目:国家自然科学基金资助项目(61103123). 通信作者:姬晓飞.E⁃mail:jixiaofei7804@ 126.com. 基于视频的动作识别研究具有广阔的应用前 景[1⁃2] 。 目前大多数动作识别方法都要求运动人体 与摄像机的成像平面平行,或要求摄像机随人体同 步运动,即人体相对于摄像机之间的视角固定或在 一定范围内运动,然而这样的要求在现实中往往不 能得到满足。 在实际应用中,人体相对于摄像机的 视角通常是任意的、不受约束的,这就要求动作识别

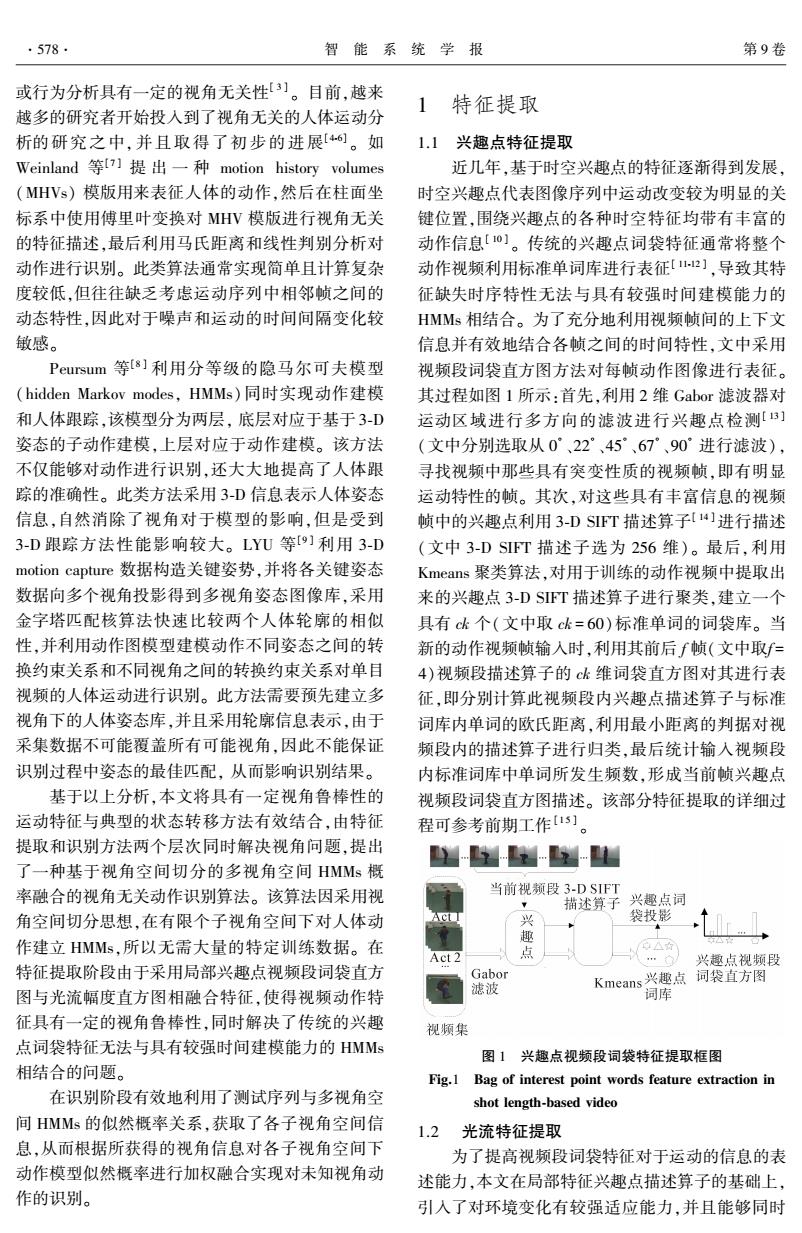

·578 智能系统学报 第9卷 或行为分析具有一定的视角无关性3)。目前,越来 1 特征提取 越多的研究者开始投入到了视角无关的人体运动分 析的研究之中,并且取得了初步的进展[6。如 1.1兴趣点特征提取 Weinland等[7】提出一种motion history volumes 近几年,基于时空兴趣点的特征逐渐得到发展, (MHVs)模版用来表征人体的动作,然后在柱面坐 时空兴趣点代表图像序列中运动改变较为明显的关 标系中使用傅里叶变换对MHV模版进行视角无关 键位置,围绕兴趣点的各种时空特征均带有丰富的 的特征描述,最后利用马氏距离和线性判别分析对 动作信息[]。传统的兴趣点词袋特征通常将整个 动作进行识别。此类算法通常实现简单且计算复杂 动作视频利用标准单词库进行表征2】,导致其特 度较低,但往往缺乏考虑运动序列中相邻帧之间的 征缺失时序特性无法与具有较强时间建模能力的 动态特性,因此对于噪声和运动的时间间隔变化较 HMMs相结合。为了充分地利用视频帧间的上下文 敏感。 信息并有效地结合各帧之间的时间特性,文中采用 Peursum等[8]利用分等级的隐马尔可夫模型 视频段词袋直方图方法对每帧动作图像进行表征。 (hidden Markov modes,HMMs)同时实现动作建模 其过程如图1所示:首先,利用2维Gabor滤波器对 和人体跟踪,该模型分为两层,底层对应于基于3-D 运动区域进行多方向的滤波进行兴趣点检测[B] 姿态的子动作建模,上层对应于动作建模。该方法 (文中分别选取从0°、22°、45°、67°、90°进行滤波), 不仅能够对动作进行识别,还大大地提高了人体跟 寻找视频中那些具有突变性质的视频帧,即有明显 踪的准确性。此类方法采用3-D信息表示人体姿态 运动特性的帧。其次,对这些具有丰富信息的视频 信息,自然消除了视角对于模型的影响,但是受到 帧中的兴趣点利用3-DSFT描述算子[14]进行描述 3-D跟踪方法性能影响较大。LYU等[9]利用3-D (文中3-DSIT描述子选为256维)。最后,利用 motion capture数据构造关键姿势,并将各关键姿态 Kmeans聚类算法,对用于训练的动作视频中提取出 数据向多个视角投影得到多视角姿态图像库,采用 来的兴趣点3-DSFT描述算子进行聚类,建立一个 金字塔匹配核算法快速比较两个人体轮廓的相似 具有ck个(文中取ck=60)标准单词的词袋库。当 性,并利用动作图模型建模动作不同姿态之间的转 新的动作视频帧输入时,利用其前后f帧(文中取f= 换约束关系和不同视角之间的转换约束关系对单目 4)视频段描述算子的ck维词袋直方图对其进行表 视频的人体运动进行识别。此方法需要预先建立多 征,即分别计算此视频段内兴趣点描述算子与标准 视角下的人体姿态库,并且采用轮廓信息表示,由于 词库内单词的欧氏距离,利用最小距离的判据对视 采集数据不可能覆盖所有可能视角,因此不能保证 频段内的描述算子进行归类,最后统计输入视频段 识别过程中姿态的最佳匹配,从而影响识别结果。 内标准词库中单词所发生频数,形成当前帧兴趣点 基于以上分析,本文将具有一定视角鲁棒性的 视频段词袋直方图描述。该部分特征提取的详细过 运动特征与典型的状态转移方法有效结合,由特征 程可参考前期工作1s] 提取和识别方法两个层次同时解决视角问题,提出 - 了一种基于视角空间切分的多视角空间HMMs概 率融合的视角无关动作识别算法。该算法因采用视 当前视频段3-D SIFT , 描述算子 兴趣点词 角空间切分思想,在有限个子视角空间下对人体动 袋投影 作建立HMMs,所以无需大量的特定训练数据。在 点 △☆ … 兴趣点视频段 特征提取阶段由于采用局部兴趣点视频段词袋直方 Gabor 滤波 Kmeans兴趣点词袋直方图 图与光流幅度直方图相融合特征,使得视频动作特 词库 征具有一定的视角鲁棒性,同时解决了传统的兴趣 视频集 点词袋特征无法与具有较强时间建模能力的HMMs 图1兴趣点视频段词袋特征提取框图 相结合的问题。 Fig.1 Bag of interest point words feature extraction in 在识别阶段有效地利用了测试序列与多视角空 shot length-based video 间HMMs的似然概率关系,获取了各子视角空间信 1.2光流特征提取 息,从而根据所获得的视角信息对各子视角空间下 为了提高视频段词袋特征对于运动的信息的表 动作模型似然概率进行加权融合实现对未知视角动 述能力,本文在局部特征兴趣点描述算子的基础上, 作的识别。 引入了对环境变化有较强适应能力,并且能够同时

或行为分析具有一定的视角无关性[ 3 ] 。 目前,越来 越多的研究者开始投入到了视角无关的人体运动分 析的研究之中, 并且取得了初步的进展[4⁃6] 。 如 Weinland 等[7 ] 提 出 一 种 motion history volumes (MHVs) 模版用来表征人体的动作,然后在柱面坐 标系中使用傅里叶变换对 MHV 模版进行视角无关 的特征描述,最后利用马氏距离和线性判别分析对 动作进行识别。 此类算法通常实现简单且计算复杂 度较低,但往往缺乏考虑运动序列中相邻帧之间的 动态特性,因此对于噪声和运动的时间间隔变化较 敏感。 Peursum 等[8 ] 利用分等级的隐马尔可夫模型 (hidden Markov modes, HMMs) 同时实现动作建模 和人体跟踪,该模型分为两层, 底层对应于基于 3⁃D 姿态的子动作建模,上层对应于动作建模。 该方法 不仅能够对动作进行识别,还大大地提高了人体跟 踪的准确性。 此类方法采用 3⁃D 信息表示人体姿态 信息,自然消除了视角对于模型的影响,但是受到 3⁃D 跟踪方法性能影响较大。 LYU 等[9 ] 利用 3⁃D motion capture 数据构造关键姿势,并将各关键姿态 数据向多个视角投影得到多视角姿态图像库,采用 金字塔匹配核算法快速比较两个人体轮廓的相似 性,并利用动作图模型建模动作不同姿态之间的转 换约束关系和不同视角之间的转换约束关系对单目 视频的人体运动进行识别。 此方法需要预先建立多 视角下的人体姿态库,并且采用轮廓信息表示,由于 采集数据不可能覆盖所有可能视角,因此不能保证 识别过程中姿态的最佳匹配, 从而影响识别结果。 基于以上分析,本文将具有一定视角鲁棒性的 运动特征与典型的状态转移方法有效结合,由特征 提取和识别方法两个层次同时解决视角问题,提出 了一种基于视角空间切分的多视角空间 HMMs 概 率融合的视角无关动作识别算法。 该算法因采用视 角空间切分思想,在有限个子视角空间下对人体动 作建立 HMMs,所以无需大量的特定训练数据。 在 特征提取阶段由于采用局部兴趣点视频段词袋直方 图与光流幅度直方图相融合特征,使得视频动作特 征具有一定的视角鲁棒性,同时解决了传统的兴趣 点词袋特征无法与具有较强时间建模能力的 HMMs 相结合的问题。 在识别阶段有效地利用了测试序列与多视角空 间 HMMs 的似然概率关系,获取了各子视角空间信 息,从而根据所获得的视角信息对各子视角空间下 动作模型似然概率进行加权融合实现对未知视角动 作的识别。 1 特征提取 1.1 兴趣点特征提取 近几年,基于时空兴趣点的特征逐渐得到发展, 时空兴趣点代表图像序列中运动改变较为明显的关 键位置,围绕兴趣点的各种时空特征均带有丰富的 动作信息[ 10 ] 。 传统的兴趣点词袋特征通常将整个 动作视频利用标准单词库进行表征[ 11⁃12 ] ,导致其特 征缺失时序特性无法与具有较强时间建模能力的 HMMs 相结合。 为了充分地利用视频帧间的上下文 信息并有效地结合各帧之间的时间特性,文中采用 视频段词袋直方图方法对每帧动作图像进行表征。 其过程如图 1 所示:首先,利用 2 维 Gabor 滤波器对 运动区域进行多方向的滤波进行兴趣点检测[ 13 ] (文中分别选取从 0 ° 、22 ° 、45 ° 、67 ° 、90 ° 进行滤波), 寻找视频中那些具有突变性质的视频帧,即有明显 运动特性的帧。 其次,对这些具有丰富信息的视频 帧中的兴趣点利用 3⁃D SIFT 描述算子[ 14 ] 进行描述 (文中 3⁃D SIFT 描述子选为 256 维)。 最后,利用 Kmeans 聚类算法,对用于训练的动作视频中提取出 来的兴趣点 3⁃D SIFT 描述算子进行聚类,建立一个 具有 ck 个(文中取 ck = 60)标准单词的词袋库。 当 新的动作视频帧输入时,利用其前后 f 帧(文中取f = 4)视频段描述算子的 ck 维词袋直方图对其进行表 征,即分别计算此视频段内兴趣点描述算子与标准 词库内单词的欧氏距离,利用最小距离的判据对视 频段内的描述算子进行归类,最后统计输入视频段 内标准词库中单词所发生频数,形成当前帧兴趣点 视频段词袋直方图描述。 该部分特征提取的详细过 程可参考前期工作[1 5 ] 。 图 1 兴趣点视频段词袋特征提取框图 Fig.1 Bag of interest point words feature extraction in shot length⁃based video 1.2 光流特征提取 为了提高视频段词袋特征对于运动的信息的表 述能力,本文在局部特征兴趣点描述算子的基础上, 引入了对环境变化有较强适应能力,并且能够同时 ·578· 智 能 系 统 学 报 第 9 卷

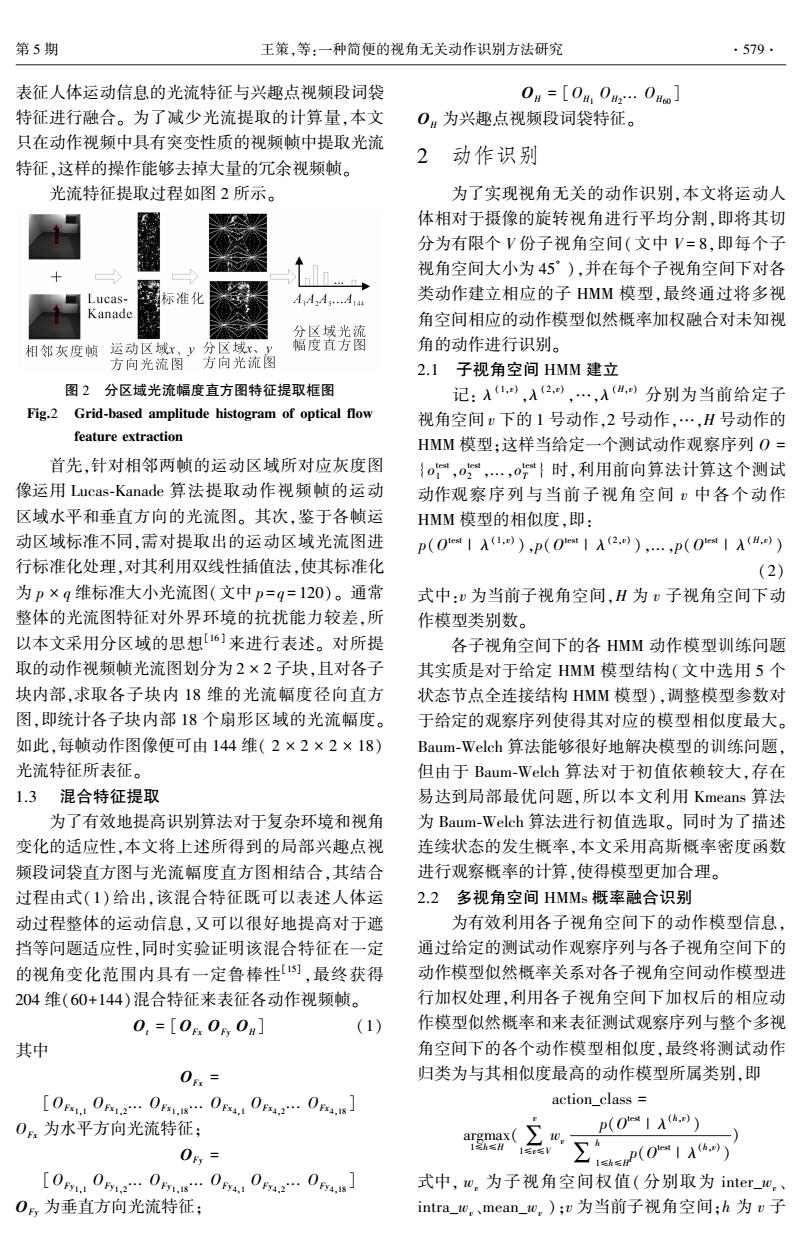

第5期 王策,等:一种简便的视角无关动作识别方法研究 ·579 表征人体运动信息的光流特征与兴趣点视频段词袋 0a=[0H,0…0Ho] 特征进行融合。为了减少光流提取的计算量,本文 O为兴趣点视频段词袋特征。 只在动作视频中具有突变性质的视频帧中提取光流 2动作识别 特征,这样的操作能够去掉大量的冗余视频帧。 光流特征提取过程如图2所示。 为了实现视角无关的动作识别,本文将运动人 体相对于摄像的旋转视角进行平均分割,即将其切 分为有限个V份子视角空间(文中V=8,即每个子 视角空间大小为45°),并在每个子视角空间下对各 Lucas- 标准化 AA2A…Aa4 类动作建立相应的子HMM模型,最终通过将多视 Kanade 角空间相应的动作模型似然概率加权融合对未知视 分区域光流 相邻灰度帧运动区域x、y分区域x、y 幅度直方图 角的动作进行识别。 方向光流图方向光流图 2.1子视角空间HMM建立 图2分区域光流幅度直方图特征提取框图 记:入,入2,…,H分别为当前给定子 Fig.2 Grid-based amplitude histogram of optical flow 视角空间下的1号动作,2号动作,…,H号动作的 feature extraction HMM模型:这样当给定一个测试动作观察序列O= 首先,针对相邻两帧的运动区域所对应灰度图 {,0,…,o}时,利用前向算法计算这个测试 像运用Lucas-Kanade算法提取动作视频帧的运动 动作观察序列与当前子视角空间)中各个动作 区域水平和垂直方向的光流图。其次,鉴于各帧运 HMM模型的相似度,即: 动区域标准不同,需对提取出的运动区域光流图进 p(01A1),p(0t1A2.),.,p(01AH.)) 行标准化处理,对其利用双线性插值法,使其标准化 (2) 为p×g维标准大小光流图(文中p=q=120)。通常 式中:v为当前子视角空间,H为v子视角空间下动 整体的光流图特征对外界环境的抗扰能力较差,所 作模型类别数。 以本文采用分区域的思想6)来进行表述。对所提 各子视角空间下的各HMM动作模型训练问题 取的动作视频帧光流图划分为2×2子块,且对各子 其实质是对于给定HMM模型结构(文中选用5个 块内部,求取各子块内18维的光流幅度径向直方 状态节点全连接结构HMM模型),调整模型参数对 图,即统计各子块内部18个扇形区域的光流幅度。 于给定的观察序列使得其对应的模型相似度最大。 如此.每帧动作图像便可由144维(2×2×2×18) Baum-Welch算法能够很好地解决模型的训练问题, 光流特征所表征。 但由于Baum-Welch算法对于初值依赖较大,存在 1.3混合特征提取 易达到局部最优问题,所以本文利用Kmeans算法 为了有效地提高识别算法对于复杂环境和视角 为Baum-Welch算法进行初值选取。同时为了描述 变化的适应性,本文将上述所得到的局部兴趣点视 连续状态的发生概率,本文采用高斯概率密度函数 频段词袋直方图与光流幅度直方图相结合,其结合 进行观察概率的计算,使得模型更加合理。 过程由式(1)给出,该混合特征既可以表述人体运 2.2多视角空间HMMs概率融合识别 动过程整体的运动信息,又可以很好地提高对于遮 为有效利用各子视角空间下的动作模型信息, 挡等问题适应性,同时实验证明该混合特征在一定 通过给定的测试动作观察序列与各子视角空间下的 的视角变化范围内具有一定鲁棒性),最终获得 动作模型似然概率关系对各子视角空间动作模型进 204维(60+144)混合特征来表征各动作视频帧。 行加权处理,利用各子视角空间下加权后的相应动 0,=[0g0s0a] (1) 作模型似然概率和来表征测试观察序列与整个多视 其中 角空间下的各个动作模型相似度,最终将测试动作 0.= 归类为与其相似度最高的动作模型所属类别,即 [00r2…0,s…0r40r4,a.0p.s] action class 0.为水平方向光流特征; p(O (h)) argmax( ∑o 12h≤H 0r= 1多e写V ∑1P(广1Aa [0g01e…01.s…0r40r4a…0ra,s] 式中,tw,为子视角空间权值(分别取为inter_.w。、 O。,为垂直方向光流特征: intra_.e,、mean_地,);w为当前子视角空间;h为v子

表征人体运动信息的光流特征与兴趣点视频段词袋 特征进行融合。 为了减少光流提取的计算量,本文 只在动作视频中具有突变性质的视频帧中提取光流 特征,这样的操作能够去掉大量的冗余视频帧。 光流特征提取过程如图 2 所示。 图 2 分区域光流幅度直方图特征提取框图 Fig.2 Grid⁃based amplitude histogram of optical flow feature extraction 首先,针对相邻两帧的运动区域所对应灰度图 像运用 Lucas⁃Kanade 算法提取动作视频帧的运动 区域水平和垂直方向的光流图。 其次,鉴于各帧运 动区域标准不同,需对提取出的运动区域光流图进 行标准化处理,对其利用双线性插值法,使其标准化 为 p × q 维标准大小光流图(文中 p = q = 120)。 通常 整体的光流图特征对外界环境的抗扰能力较差,所 以本文采用分区域的思想[16 ] 来进行表述。 对所提 取的动作视频帧光流图划分为 2 × 2 子块,且对各子 块内部,求取各子块内 18 维的光流幅度径向直方 图,即统计各子块内部 18 个扇形区域的光流幅度。 如此,每帧动作图像便可由 144 维( 2 × 2 × 2 × 18) 光流特征所表征。 1.3 混合特征提取 为了有效地提高识别算法对于复杂环境和视角 变化的适应性,本文将上述所得到的局部兴趣点视 频段词袋直方图与光流幅度直方图相结合,其结合 过程由式(1)给出,该混合特征既可以表述人体运 动过程整体的运动信息,又可以很好地提高对于遮 挡等问题适应性,同时实验证明该混合特征在一定 的视角变化范围内具有一定鲁棒性[15] ,最终获得 204 维(60+144)混合特征来表征各动作视频帧。 Ot = [OFx OFy OH] (1) 其中 OFx = [OFx1,1 OFx1,2 ... OFx1,18 ... OFx4,1 OFx4,2 ... OFx4,18 ] OFx 为水平方向光流特征; OFy = [OFy1,1 OFy1,2 ... OFy1,18 ... OFy4,1 OFy4,2 ... OFy4,18 ] OFy 为垂直方向光流特征; OH = [OH1 OH2 ... OH60 ] OH 为兴趣点视频段词袋特征。 2 动作识别 为了实现视角无关的动作识别,本文将运动人 体相对于摄像的旋转视角进行平均分割,即将其切 分为有限个 V 份子视角空间(文中 V = 8,即每个子 视角空间大小为 45 ° ),并在每个子视角空间下对各 类动作建立相应的子 HMM 模型,最终通过将多视 角空间相应的动作模型似然概率加权融合对未知视 角的动作进行识别。 2.1 子视角空间 HMM 建立 记: λ (1,v) ,λ (2,v) ,…,λ (H,v) 分别为当前给定子 视角空间 v 下的 1 号动作,2 号动作,…,H 号动作的 HMM 模型;这样当给定一个测试动作观察序列 O = {o test 1 ,o test 2 ,...,o test T } 时,利用前向算法计算这个测试 动作观察序列与当前子视角空间 v 中各个动作 HMM 模型的相似度,即: p(O test | λ (1,v) ),p(O test | λ (2,v) ),...,p(O test | λ (H,v) ) (2) 式中:v 为当前子视角空间,H 为 v 子视角空间下动 作模型类别数。 各子视角空间下的各 HMM 动作模型训练问题 其实质是对于给定 HMM 模型结构(文中选用 5 个 状态节点全连接结构 HMM 模型),调整模型参数对 于给定的观察序列使得其对应的模型相似度最大。 Baum⁃Welch 算法能够很好地解决模型的训练问题, 但由于 Baum⁃Welch 算法对于初值依赖较大,存在 易达到局部最优问题,所以本文利用 Kmeans 算法 为 Baum⁃Welch 算法进行初值选取。 同时为了描述 连续状态的发生概率,本文采用高斯概率密度函数 进行观察概率的计算,使得模型更加合理。 2.2 多视角空间 HMMs 概率融合识别 为有效利用各子视角空间下的动作模型信息, 通过给定的测试动作观察序列与各子视角空间下的 动作模型似然概率关系对各子视角空间动作模型进 行加权处理,利用各子视角空间下加权后的相应动 作模型似然概率和来表征测试观察序列与整个多视 角空间下的各个动作模型相似度,最终将测试动作 归类为与其相似度最高的动作模型所属类别,即 action_class = argmax 1≤h≤H (∑ v 1≤v≤V wv p(O test | λ (h,v) ) ∑ h 1≤h≤H p(O test | λ (h,v) ) ) 式中, wv 为子视角空间权值( 分别取为 inter_wv、 intra_wv、mean_wv );v 为当前子视角空间;h 为 v 子 第 5 期 王策,等:一种简便的视角无关动作识别方法研究 ·579·

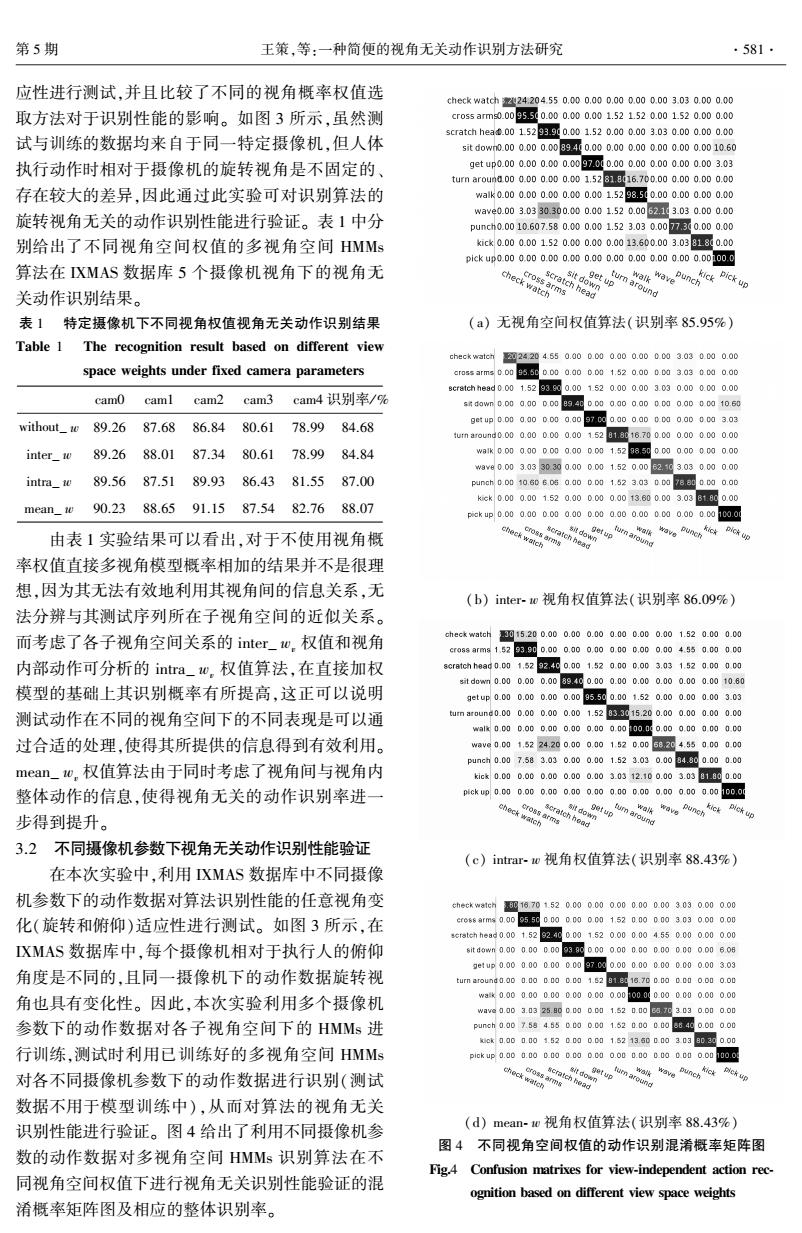

·580· 智能系统学报 第9卷 视角空间下当前动作模型类别。 n∈A= 本文主要根据两方面来对各子视角空间的概率 jlmax(p(())-p()th, 权重进行选取: 1)根据各子视角空间内部各动作模型之间的 1≤j≤Hj≠arax(p(01A): 可分性,若当前子视角空间下的动作模型可分性较 h为相似动作间的阈值。 好,即加重当前子视角空间下的权值。 (4)混合视角权值:为了更加有效的对未知视 2)根据各子视角空间与给定测试动作所在子 角的测试动作进行识别,结合2)、3)给出的视角空 视角空间的近似度关系,若当前子视角空间与给定 间概率权值求取思想,将视角之间权值与视角内部 测试动作所在子视角空间近似度较高则加重当前视 权值相结合,这样可使识别算法同时考虑了各子视 角空间的权值。本文正是基于以上思想来决定各子 角之间的相似关系以及视角内部动作模型的可分 视角空间权重大小,具体采用以下4种不同的权值 性,其具体实现由式(6)给出。 求取方式。 mean_w. (1)无视角权值:不考虑各子视角空间下的权 重关系,直接将各子视角空间下相应的动作模型似 ma (p(m)) 月-1gP(0m1A) 1 然概率相加,得到多视角空间下的待识别动作与各 ∑ie∑iP01A) 动作模型相似度,取其最大相似度与之对应的动作 (6) 模型类别作为待识别动作类别,即: 式中:j≠a婴8x(p(01A) action class p(O1入h.) 3实验与结果与分析 argmax( (3) 1完h≤H 点:∑1P(01A 本文所用实验数据均来自于Inria Xmas Motion (2)视角之间权值:利用各子视角空间与给定 Acquisition Sequences(IXMAS)数据库,其中包含了 测试动作所在子视角空间的近似度关系进行权值求 12个动作、5个摄像机视角,且在每个摄像机视角下 取,通常各子视角空间与给定的测试动作所在子视 每个动作分别由13个人执行3遍,在动作执行过程 角空间近似度越高,其视角空间下各动作模型似然 中,人体相对与摄像机的视角不受约束,该数据库被 概率和越大,所以,本文选取各子视角空间下的各动 广泛用于视角无关的人体动作识别。 作模型似然概率和作为当前子视角空间的概率权值 本文首先对数据库中的各摄像机下的动作数据 求取的准则函数。式(4)给出了一个子视角空间v 进行视角聚类,每个摄像机下的动作数据分别将其 下的权值求取具体过程。 聚类为3个子视角空间进行实验,在各实验中采用 ∑eP(0产1A) 留一法对不同执行人进行循环测试,最终得到实验 inter_w (4) ∑i,∑14少(0产1a) 结果。图3中的每一行展示出了各摄像机下聚类出 的子视角空间中的一类动作数据样例。 (3)视角内部权值:利用各子视角空间自身内 部各动作模型之间的可分性关系进行权值求取,通 cam0 caml cam2 cam3 cam4 常情况下,误识别动作往往发生于执行时相似度较 scratch head 高的两个或几个动作之间,如:wave、seratch head、 walk、turn around等,这样就应该着重分析各子视角 check 空间内部的相似动作,本文利用各子视角空间内部 watch 相似动作模型间似然概率差作为当前子视角空间的 wave 概率权值求取准则函数,其具体形式由式(5)给出。 ☏(0产1》-∑0广1A) 图3多视角XMAS数据库示例图 intra w. Fig.3 Exemplar frames from IXMAS multi-view dataset ☏0产1》+∑iee0产1A) 3.1特定摄像机下视角无关动作识别性能验证 (5) 在本次实验中,利用XMAS数据库中特定摄像 式中: 机下的动作数据对算法识别性能的旋转视角变化适

视角空间下当前动作模型类别。 本文主要根据两方面来对各子视角空间的概率 权重进行选取: 1)根据各子视角空间内部各动作模型之间的 可分性,若当前子视角空间下的动作模型可分性较 好,即加重当前子视角空间下的权值。 2)根据各子视角空间与给定测试动作所在子 视角空间的近似度关系,若当前子视角空间与给定 测试动作所在子视角空间近似度较高则加重当前视 角空间的权值。 本文正是基于以上思想来决定各子 视角空间权重大小,具体采用以下 4 种不同的权值 求取方式。 (1)无视角权值:不考虑各子视角空间下的权 重关系,直接将各子视角空间下相应的动作模型似 然概率相加,得到多视角空间下的待识别动作与各 动作模型相似度,取其最大相似度与之对应的动作 模型类别作为待识别动作类别,即: action_class = argmax 1≤h≤H ( ∑ v 1≤v≤V p(O test | λ (h,v) ) ∑ h 1≤h≤H p(O test | λ (h,v) ) ) (3) (2)视角之间权值:利用各子视角空间与给定 测试动作所在子视角空间的近似度关系进行权值求 取,通常各子视角空间与给定的测试动作所在子视 角空间近似度越高,其视角空间下各动作模型似然 概率和越大,所以,本文选取各子视角空间下的各动 作模型似然概率和作为当前子视角空间的概率权值 求取的准则函数。 式(4)给出了一个子视角空间 v 下的权值求取具体过程。 inter_wv = ∑ h 1≤h≤H p(O test | λ (h,v) ) ∑ v 1≤v≤V∑ h 1≤h≤H p(O test | λ (h,v) ) (4) (3)视角内部权值:利用各子视角空间自身内 部各动作模型之间的可分性关系进行权值求取,通 常情况下,误识别动作往往发生于执行时相似度较 高的两个或几个动作之间,如:wave、scratch head、 walk、turn around 等,这样就应该着重分析各子视角 空间内部的相似动作,本文利用各子视角空间内部 相似动作模型间似然概率差作为当前子视角空间的 概率权值求取准则函数,其具体形式由式(5)给出。 intra_wv = max 1≤i≤H (p(O test | λ i,v )) - 1 N∑ n 1≤n≤N p(O test | λ (n,v) ) max 1≤i≤H (p(O test | λ i,v )) + 1 N∑ n 1≤n≤N p(O test | λ (n,v) ) (5) 式中: n ∈ A = {j | max 1≤i≤H (p(O test | λ (i,v) )) - p(O test | λ (j,v) ) ≤ th, 1 ≤ j ≤ H,j ≠ argmax 1≤i≤H (p(O test | λ (i,v) ))}; th 为相似动作间的阈值。 (4)混合视角权值:为了更加有效的对未知视 角的测试动作进行识别,结合 2)、3)给出的视角空 间概率权值求取思想,将视角之间权值与视角内部 权值相结合,这样可使识别算法同时考虑了各子视 角之间的相似关系以及视角内部动作模型的可分 性,其具体实现由式(6)给出。 mean_wv = max 1≤i≤H (p(O test | λ (i,v) )) - 1 H - 1∑ j 1≤j≤H p(O test | λ (j,v) ) ∑ v 1≤v≤V∑ h 1≤h≤H p(O test | λ (h,v) ) (6) 式中: j ≠ argmax 1≤i≤H (p(O test | λ (i,v) )) 3 实验与结果与分析 本文所用实验数据均来自于 Inria Xmas Motion Acquisition Sequences (IXMAS)数据库,其中包含了 12 个动作、5 个摄像机视角,且在每个摄像机视角下 每个动作分别由 13 个人执行 3 遍,在动作执行过程 中,人体相对与摄像机的视角不受约束,该数据库被 广泛用于视角无关的人体动作识别。 本文首先对数据库中的各摄像机下的动作数据 进行视角聚类,每个摄像机下的动作数据分别将其 聚类为 3 个子视角空间进行实验,在各实验中采用 留一法对不同执行人进行循环测试,最终得到实验 结果。 图 3 中的每一行展示出了各摄像机下聚类出 的子视角空间中的一类动作数据样例。 图 3 多视角 IXMAS 数据库示例图 Fig.3 Exemplar frames from IXMAS multi⁃view dataset 3.1 特定摄像机下视角无关动作识别性能验证 在本次实验中,利用 IXMAS 数据库中特定摄像 机下的动作数据对算法识别性能的旋转视角变化适 ·580· 智 能 系 统 学 报 第 9 卷

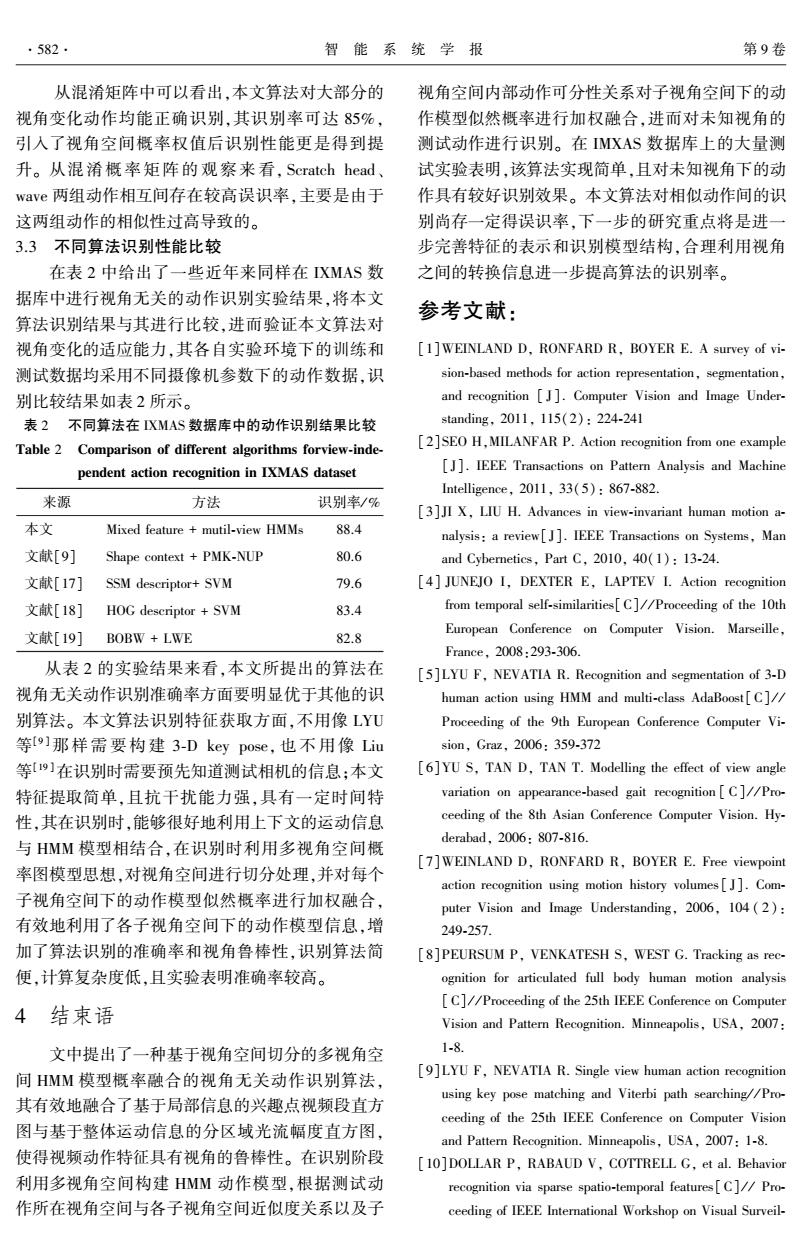

第5期 王策,等:一种简便的视角无关动作识别方法研究 ·581- 应性进行测试,并且比较了不同的视角概率权值选 check watch224204.550.000.000.000.000.003.030.000.00 取方法对于识别性能的影响。如图3所示,虽然测 cros5ams0.0095.500.000.000.001.521.520.001.520.000.00 scratch hea.0015293.90.001.520.000.003.030.000.000.00 试与训练的数据均来自于同一特定摄像机,但人体 sit down0.000.000.0089400.000.000.000.000.000.0010.60 执行动作时相对于摄像机的旋转视角是不固定的、 get up0.000.000.000.0097.0d0.000.000.000.000.003.03 turn around.000.000.000.001.5281.816.700.000.000.000.00 存在较大的差异,因此通过此实验可对识别算法的 walk0.000.000.000.000.001.5298.50.000.000.000.00 wave0.003.0330.300.000.001.520.0062,113.030.000.00 旋转视角无关的动作识别性能进行验证。表1中分 punch0.0010.607.580.000.001.523.030.0077.30.000.00 别给出了不同视角空间权值的多视角空间HMMs kick0.000.001.520.000.000.0013.600.003.0381800.00 p1ckup0.000.000.00,000.000.000.000.000.000.001o0.0 算法在XMAS数据库5个摄像机视角下的视角无 关动作识别结果。 round 表1特定摄像机下不同视角权值视角无关动作识别结果 (a)无视角空间权值算法(识别率85.95%) Table 1 The recognition result based on different view check watch224204.550.000.000.000.000.003.030.000.00 space weights under fixed camera parameters cross arm=0.0095.500.000.000.001.520.000.03.030.10.00 8cr8 tchhe8d0.001.52930.001520.000.003.030.000.00.00 cam0 caml cam2 cam3cam4识别率/9% s6dawn0,00a.a00.0089,4gDD00.a00.a00Da0.000010.60 without e89.2687.6886.8480.61 78.9984.68 get up0.00a.a0000a.a07da,a00,a0000,a00c03.03 turn around0.000.000.000.0015281.8516.700.00.000.00.00 inter_w 89.2688.0187.3480.61 78.9984.84 wak0.00a.00D000.000.001.5288,500a0.00000.00 w8vg0.003.0330.300.000001.520.0062,503.03000.00 intra w 89.5687.5189.93 86.4381.5587.00 punch0.0010.60606a.a0D.D01,523.030的78a00.的0.a0 mean_w90.2388.6591.1587.5482.7688.07 kck0.000.001.520.000.000.0013.600.003.03818m000 pick up0.000.000.000.000.000.000.000.C0.000.001c0.0 由表1实验结果可以看出,对于不使用视角概 率权值直接多视角模型概率相加的结果并不是很理 想,因为其无法有效地利用其视角间的信息关系,无 (b)inter-.o视角权值算法(识别率86.09%) 法分辨与其测试序列所在子视角空间的近似关系。 而考虑了各子视角空间关系的inter_t0,权值和视角 chec*watch015.200.000.000.000.000.000.001.520.000.C0 cr088armg15293900.000.,000,000.000.000,00450.00.0 内部动作可分析的intra_心,权值算法,在直接加权 8 cratch h88g0.001.5292,4g0.001.520000.003.031.520.000.0 std0wm0.000.000.0089.400.000.000.000.000.000.0010.60 模型的基础上其识别概率有所提高,这正可以说明 9etup0.000.000.000.0095500.001.520.000.000.003.03 测试动作在不同的视角空间下的不同表现是可以通 turn around0.000.000.000.001.5283.315.200.000.000.000.00 walW0000.000,000.000.00,000000.000.000000.00 过合适的处理,使得其所提供的信息得到有效利用。 wavg0.001.5224.200.000.001.520.0058204.550000.00 punch0.007.583.030.000.001.523.030.0084.800.000.00 mean0,权值算法由于同时考虑了视角间与视角内 kick0.000.000.000.000.003.0312.100.003.0381800.0 整体动作的信息,使得视角无关的动作识别率进一 pick up0.000.000,000.a00.000.000.000.000.000.0a100.0 步得到提升。 3.2不同摄像机参数下视角无关动作识别性能验证 (c)intrar-w视角权值算法(识别率88.43%) 在本次实验中,利用XMAS数据库中不同摄像 机参数下的动作数据对算法识别性能的任意视角变 checkw81ch016701520.000.000.000.000.003.03.0.000.00 化(旋转和俯仰)适应性进行测试。如图3所示,在 cr0s8arms0.009550000000001520.000003030.000.00 cratch head0.001.5292.400.001.520.000.004.550000.000.00 XMAS数据库中,每个摄像机相对于执行人的俯仰 sitd0wn0.a00.00000939g0000.000000000000.00606 gefup0.000.000000.0097.0.000.000.000.000.003.03 角度是不同的,且同一摄像机下的动作数据旋转视 turn around.000.00000.01.5281816.700.0a0.c10.000.00 角也具有变化性。因此,本次实验利用多个摄像机 wak0.000.000.000.000.000.00t00000000.000.000.00 wave0.003.0325.00.0011.520.0,7C3030.000.00 参数下的动作数据对各子视角空间下的HMMs进 punch.a07.584650.00.c01.520.000.0664g0.000.00 kek0.a000015200a01152135000303900.00 行训练,测试时利用已训练好的多视角空间HMMs p1ckup0.000.000.00.000.c00.000.000.000000.00100 对各不同摄像机参数下的动作数据进行识别(测试 数据不用于模型训练中),从而对算法的视角无关 识别性能进行验证。图4给出了利用不同摄像机参 (d)mean-1w视角权值算法(识别率88.43%) 图4不同视角空间权值的动作识别混淆概率矩阵图 数的动作数据对多视角空间HMMs识别算法在不 Fig4 Confusion matrixes for view-independent action rec- 同视角空间权值下进行视角无关识别性能验证的混 ognition based on different view space weights 淆概率矩阵图及相应的整体识别率

应性进行测试,并且比较了不同的视角概率权值选 取方法对于识别性能的影响。 如图 3 所示,虽然测 试与训练的数据均来自于同一特定摄像机,但人体 执行动作时相对于摄像机的旋转视角是不固定的、 存在较大的差异,因此通过此实验可对识别算法的 旋转视角无关的动作识别性能进行验证。 表 1 中分 别给出了不同视角空间权值的多视角空间 HMMs 算法在 IXMAS 数据库 5 个摄像机视角下的视角无 关动作识别结果。 表 1 特定摄像机下不同视角权值视角无关动作识别结果 Table 1 The recognition result based on different view space weights under fixed camera parameters cam0 cam1 cam2 cam3 cam4 识别率/ % without_ w 89.26 87.68 86.84 80.61 78.99 84.68 inter_ w 89.26 88.01 87.34 80.61 78.99 84.84 intra_ w 89.56 87.51 89.93 86.43 81.55 87.00 mean_ w 90.23 88.65 91.15 87.54 82.76 88.07 由表 1 实验结果可以看出,对于不使用视角概 率权值直接多视角模型概率相加的结果并不是很理 想,因为其无法有效地利用其视角间的信息关系,无 法分辨与其测试序列所在子视角空间的近似关系。 而考虑了各子视角空间关系的 inter_ wv 权值和视角 内部动作可分析的 intra_ wv 权值算法,在直接加权 模型的基础上其识别概率有所提高,这正可以说明 测试动作在不同的视角空间下的不同表现是可以通 过合适的处理,使得其所提供的信息得到有效利用。 mean_ wv 权值算法由于同时考虑了视角间与视角内 整体动作的信息,使得视角无关的动作识别率进一 步得到提升。 3.2 不同摄像机参数下视角无关动作识别性能验证 在本次实验中,利用 IXMAS 数据库中不同摄像 机参数下的动作数据对算法识别性能的任意视角变 化(旋转和俯仰)适应性进行测试。 如图 3 所示,在 IXMAS 数据库中,每个摄像机相对于执行人的俯仰 角度是不同的,且同一摄像机下的动作数据旋转视 角也具有变化性。 因此,本次实验利用多个摄像机 参数下的动作数据对各子视角空间下的 HMMs 进 行训练,测试时利用已训练好的多视角空间 HMMs 对各不同摄像机参数下的动作数据进行识别(测试 数据不用于模型训练中),从而对算法的视角无关 识别性能进行验证。 图 4 给出了利用不同摄像机参 数的动作数据对多视角空间 HMMs 识别算法在不 同视角空间权值下进行视角无关识别性能验证的混 淆概率矩阵图及相应的整体识别率。 (a) 无视角空间权值算法(识别率 85.95%) (b) inter⁃ w 视角权值算法(识别率 86.09%) (c) intrar⁃ w 视角权值算法(识别率 88.43%) (d) mean⁃ w 视角权值算法(识别率 88.43%) 图 4 不同视角空间权值的动作识别混淆概率矩阵图 Fig.4 Confusion matrixes for view⁃independent action rec⁃ ognition based on different view space weights 第 5 期 王策,等:一种简便的视角无关动作识别方法研究 ·581·

·582· 智能系统学报 第9卷 从混淆矩阵中可以看出,本文算法对大部分的 视角空间内部动作可分性关系对子视角空间下的动 视角变化动作均能正确识别,其识别率可达85%, 作模型似然概率进行加权融合,进而对未知视角的 引入了视角空间概率权值后识别性能更是得到提 测试动作进行识别。在IMXAS数据库上的大量测 升。从混淆概率矩阵的观察来看,Scratch head、 试实验表明,该算法实现简单,且对未知视角下的动 wave两组动作相互间存在较高误识率,主要是由于 作具有较好识别效果。本文算法对相似动作间的识 这两组动作的相似性过高导致的。 别尚存一定得误识率,下一步的研究重点将是进一 3.3不同算法识别性能比较 步完善特征的表示和识别模型结构,合理利用视角 在表2中给出了一些近年来同样在XMAS数 之间的转换信息进一步提高算法的识别率。 据库中进行视角无关的动作识别实验结果,将本文 参考文献: 算法识别结果与其进行比较,进而验证本文算法对 视角变化的适应能力,其各自实验环境下的训练和 [1WEINLAND D.RONFARD R,BOYER E.A survey of vi- 测试数据均采用不同摄像机参数下的动作数据,识 sion-based methods for action representation,segmentation, 别比较结果如表2所示。 and recognition [J].Computer Vision and Image Under- 表2不同算法在XMAS数据库中的动作识别结果比较 standing,2011,115(2):224-241 Table 2 Comparison of different algorithms forview-inde- [2]SEO H,MILANFAR P.Action recognition from one example pendent action recognition in IXMAS dataset [J].IEEE Transactions on Pattern Analysis and Machine ntelligence,2011,33(5):867-882. 来源 方法 识别率/% [3]JI X,LIU H.Advances in view-invariant human motion a- 本文 Mixed feature mutil-view HMMs 88.4 nalysis:a review[J].IEEE Transactions on Systems,Man 文献[9] Shape context PMK-NUP 80.6 and Cybernetics,Part C,2010,40(1):13-24. 文献[17]SSM descriptor+SVM 79.6 [4]JUNEJO I,DEXTER E,LAPTEV I.Action recognition 文献[l8]HOG descriptor+SVM 83.4 from temporal self-similarities[C]//Proceeding of the 10th 文献[19]BOBW+LWE European Conference on Computer Vision.Marseille, 82.8 France,2008:293-306. 从表2的实验结果来看,本文所提出的算法在 [5]LYU F,NEVATIA R.Recognition and segmentation of 3-D 视角无关动作识别准确率方面要明显优于其他的识 human action using HMM and multi-class AdaBoost[C]// 别算法。本文算法识别特征获取方面,不用像LYU Proceeding of the 9th European Conference Computer Vi- 等[]那样需要构建3-D key pose,也不用像Liu sion,Graz,2006:359-372 等[9]在识别时需要预先知道测试相机的信息;本文 [6]YU S,TAN D,TAN T.Modelling the effect of view angle 特征提取简单,且抗干扰能力强,具有一定时间特 variation on appearance-based gait recognition [C]//Pro- 性,其在识别时,能够很好地利用上下文的运动信息 ceeding of the 8th Asian Conference Computer Vision.Hy- derabad,2006:807-816. 与HMM模型相结合,在识别时利用多视角空间概 [7]WEINLAND D,RONFARD R,BOYER E.Free viewpoint 率图模型思想,对视角空间进行切分处理,并对每个 action recognition using motion history volumes[J].Com- 子视角空间下的动作模型似然概率进行加权融合, puter Vision and Image Understanding,2006,104(2): 有效地利用了各子视角空间下的动作模型信息,增 249-257. 加了算法识别的准确率和视角鲁棒性,识别算法简 8]PEURSUM P,VENKATESH S,WEST G.Tracking as ree- 便,计算复杂度低,且实验表明准确率较高。 ognition for articulated full body human motion analysis [C]//Proceeding of the 25th IEEE Conference on Computer 4结束语 Vision and Pattern Recognition.Minneapolis,USA,2007: 文中提出了一种基于视角空间切分的多视角空 1-8. 间HMM模型概率融合的视角无关动作识别算法, [9]LYU F,NEVATIA R.Single view human action recognition using key pose matching and Viterbi path searching//Pro- 其有效地融合了基于局部信息的兴趣点视频段直方 ceeding of the 25th IEEE Conference on Computer Vision 图与基于整体运动信息的分区域光流幅度直方图, and Pattern Recognition.Minneapolis,USA,2007:1-8. 使得视频动作特征具有视角的鲁棒性。在识别阶段 [10]DOLLAR P,RABAUD V,COTTRELL G,et al.Behavior 利用多视角空间构建HMM动作模型,根据测试动 recognition via sparse spatio-temporal features[C]//Pro- 作所在视角空间与各子视角空间近似度关系以及子 ceeding of IEEE International Workshop on Visual Surveil-

从混淆矩阵中可以看出,本文算法对大部分的 视角变化动作均能正确识别,其识别率可达 85%, 引入了视角空间概率权值后识别性能更是得到提 升。 从混淆概率矩阵的 观 察 来 看, Scratch head、 wave 两组动作相互间存在较高误识率,主要是由于 这两组动作的相似性过高导致的。 3.3 不同算法识别性能比较 在表 2 中给出了一些近年来同样在 IXMAS 数 据库中进行视角无关的动作识别实验结果,将本文 算法识别结果与其进行比较,进而验证本文算法对 视角变化的适应能力,其各自实验环境下的训练和 测试数据均采用不同摄像机参数下的动作数据,识 别比较结果如表 2 所示。 表 2 不同算法在 IXMAS 数据库中的动作识别结果比较 Table 2 Comparison of different algorithms forview⁃inde⁃ pendent action recognition in IXMAS dataset 来源 方法 识别率/ % 本文 Mixed feature + mutil⁃view HMMs 88.4 文献[9] Shape context + PMK⁃NUP 80.6 文献[17] SSM descriptor+ SVM 79.6 文献[18] HOG descriptor + SVM 83.4 文献[19] BOBW + LWE 82.8 从表 2 的实验结果来看,本文所提出的算法在 视角无关动作识别准确率方面要明显优于其他的识 别算法。 本文算法识别特征获取方面,不用像 LYU 等[9 ] 那样 需 要 构 建 3⁃D key pose, 也 不 用 像 Liu 等[19 ]在识别时需要预先知道测试相机的信息;本文 特征提取简单,且抗干扰能力强,具有一定时间特 性,其在识别时,能够很好地利用上下文的运动信息 与 HMM 模型相结合,在识别时利用多视角空间概 率图模型思想,对视角空间进行切分处理,并对每个 子视角空间下的动作模型似然概率进行加权融合, 有效地利用了各子视角空间下的动作模型信息,增 加了算法识别的准确率和视角鲁棒性,识别算法简 便,计算复杂度低,且实验表明准确率较高。 4 结束语 文中提出了一种基于视角空间切分的多视角空 间 HMM 模型概率融合的视角无关动作识别算法, 其有效地融合了基于局部信息的兴趣点视频段直方 图与基于整体运动信息的分区域光流幅度直方图, 使得视频动作特征具有视角的鲁棒性。 在识别阶段 利用多视角空间构建 HMM 动作模型,根据测试动 作所在视角空间与各子视角空间近似度关系以及子 视角空间内部动作可分性关系对子视角空间下的动 作模型似然概率进行加权融合,进而对未知视角的 测试动作进行识别。 在 IMXAS 数据库上的大量测 试实验表明,该算法实现简单,且对未知视角下的动 作具有较好识别效果。 本文算法对相似动作间的识 别尚存一定得误识率,下一步的研究重点将是进一 步完善特征的表示和识别模型结构,合理利用视角 之间的转换信息进一步提高算法的识别率。 参考文献: [1]WEINLAND D, RONFARD R, BOYER E. A survey of vi⁃ sion⁃based methods for action representation, segmentation, and recognition [ J]. Computer Vision and Image Under⁃ standing, 2011, 115(2): 224⁃241 [2]SEO H,MILANFAR P. Action recognition from one example [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(5): 867⁃882. [3]JI X, LIU H. Advances in view⁃invariant human motion a⁃ nalysis: a review[ J]. IEEE Transactions on Systems, Man and Cybernetics, Part C, 2010, 40(1): 13⁃24. [4] JUNEJO I, DEXTER E, LAPTEV I. Action recognition from temporal self⁃similarities[C] / / Proceeding of the 10th European Conference on Computer Vision. Marseille, France, 2008:293⁃306. [5]LYU F, NEVATIA R. Recognition and segmentation of 3⁃D human action using HMM and multi⁃class AdaBoost[C] / / Proceeding of the 9th European Conference Computer Vi⁃ sion, Graz, 2006: 359⁃372 [6]YU S, TAN D, TAN T. Modelling the effect of view angle variation on appearance⁃based gait recognition [ C] / / Pro⁃ ceeding of the 8th Asian Conference Computer Vision. Hy⁃ derabad, 2006: 807⁃816. [7]WEINLAND D, RONFARD R, BOYER E. Free viewpoint action recognition using motion history volumes [ J]. Com⁃ puter Vision and Image Understanding, 2006, 104 ( 2): 249⁃257. [8]PEURSUM P, VENKATESH S, WEST G. Tracking as rec⁃ ognition for articulated full body human motion analysis [C] / / Proceeding of the 25th IEEE Conference on Computer Vision and Pattern Recognition. Minneapolis, USA, 2007: 1⁃8. [9]LYU F, NEVATIA R. Single view human action recognition using key pose matching and Viterbi path searching / / Pro⁃ ceeding of the 25th IEEE Conference on Computer Vision and Pattern Recognition. Minneapolis, USA, 2007: 1⁃8. [10]DOLLAR P, RABAUD V, COTTRELL G, et al. Behavior recognition via sparse spatio⁃temporal features[C] / / Pro⁃ ceeding of IEEE International Workshop on Visual Surveil⁃ ·582· 智 能 系 统 学 报 第 9 卷

第5期 王策,等:一种简便的视角无关动作识别方法研究 ·583. lance and Performance Evaluation of Tracking and Surveil- Vision.Marseille,France,2008:293-306. lance.2005:65.72. [18]WEINLAND D,OZUYSAL M,FUA P.Making action rec- [11]SONG Y,TANG S.A distribution based video representa- ognition robust to occlusions and viewpoint changes[C]// tion for human action recognition[C]//Proceeding of the Proceeding of the 11th European Conference on Computer IEEE International Conference on Multimedia and Expo. Vision.Heraklion,Greece,2010:635-648. Suntec,Singapore,2010:772-777. [19]LIU J,SHAH M,KUIPERS B,et al.Cross-view action [12]REN H,THOMAS B.Action recognition using salient recognition via view knowledge transfer C//Proceeding of neighboring histograms [C]//Proceeding of the 20th the 29th IEEE Conference on Computer Vision and Pattern IEEE International Conference on Image Processing.Mel- Recognition.Colorado,USA,2011:3209-3216. bourne,Australia,2013:2807-2811. [20]JIANG Z,ZHE L,LARRY D.Recognizing human actions [13]BREGOMZIO M,GONG S,XIANG T.Recognizing action by learning and matching shape-motion prototype trees[]. as clouds of space-time interest points C//Proceeding of IEEE Transactions on Pattern Analysis and Machine Intel- the 27th IEEE Conference on Computer Vision and Pattern ligence,2012,34(3):533-547. Recognition.Miami,USA,2009:1948-1955. 作者简介: [14]SCOVANNER P,ALI S,SHAH M.A 3-dimensional sift 王策,男,1989年生,硕士研究生,主要 descriptor and its application to action recognition [C]/ 研究方向为基于视频的人体运动建模及其 Proceeding of the 15th International Conference on Multi- 分析。 media.Augsburg,Germany,2007:357-360. [15]姬晓飞,王策,李一波.一种基于视角鲁棒性特征的人 体动作识别方法研究[C]/第32届中国控制会议论文 姬晓飞,女,1978年生,副教授,博士, 集.西安,中国,2013:3877-3881. 主要研究方向为视频分析与处理、模式识 JI Xiaofei,WANG Ce,LI Yibo.An action recognition 别。承担国家自然科学基金项目、教育部留 method based on view-insensitive feature representation 学回国启动基金项目等多项基金研究工作。 [C]/Proceeding of the 32th Chinese Control Confer- 发表学术论文30余篇,其中被SCI、EI检索 ence.Xi'an,China,2013:3877-3881. 15篇。参与编著英文专著1部。 [16]TRAN D,SOROKIN A.Human activity recognition with 李一波,男,1963年生,教授,博士生导 metric learning [C]//Proceeding of the 10th European 师,博士,主要研究方向为生物特征识别、图 Conference on Computer Vision.Marseille,France,2008: 像处理与模式识别、飞行控制、复杂系统、人 548-561. 工智能等。曾获军队级科技进步3等奖1 [17]JUNEJO I,DEXTER E,LAPTEV I,et al.Cross-view ac- 项、省国防工业办公室科技进步2等奖1 tion recognition from temporal self-similarities[C]//Pro- 项。主持和参与近30项科研项目,发表学术论文100余 ceeding of the 10th European Conference on Computer 篇,其中被SCI及EI检索30余篇

lance and Performance Evaluation of Tracking and Surveil⁃ lance. 2005: 65⁃72. [11]SONG Y, TANG S. A distribution based video representa⁃ tion for human action recognition[C] / / Proceeding of the IEEE International Conference on Multimedia and Expo. Suntec, Singapore, 2010: 772⁃777. [12] REN H, THOMAS B. Action recognition using salient neighboring histograms [ C ] / / Proceeding of the 20th IEEE International Conference on Image Processing. Mel⁃ bourne, Australia, 2013: 2807⁃2811. [13]BREGOMZIO M, GONG S, XIANG T. Recognizing action as clouds of space⁃time interest points[C] / / Proceeding of the 27th IEEE Conference on Computer Vision and Pattern Recognition. Miami, USA, 2009: 1948⁃1955. [14]SCOVANNER P, ALI S, SHAH M. A 3⁃dimensional sift descriptor and its application to action recognition [ C] / / Proceeding of the 15th International Conference on Multi⁃ media. Augsburg, Germany, 2007: 357⁃360. [15]姬晓飞,王策,李一波. 一种基于视角鲁棒性特征的人 体动作识别方法研究[C] / / 第 32 届中国控制会议论文 集. 西安, 中国,2013:3877⁃3881. JI Xiaofei, WANG Ce, LI Yibo. An action recognition method based on view⁃insensitive feature representation [C] / / Proceeding of the 32th Chinese Control Confer⁃ ence. Xi’an, China, 2013: 3877⁃3881. [16] TRAN D, SOROKIN A. Human activity recognition with metric learning [ C] / / Proceeding of the 10th European Conference on Computer Vision. Marseille, France, 2008: 548⁃561. [17]JUNEJO I, DEXTER E, LAPTEV I, et al. Cross⁃view ac⁃ tion recognition from temporal self⁃similarities [ C] / / Pro⁃ ceeding of the 10th European Conference on Computer Vision. Marseille, France, 2008: 293⁃306. [18]WEINLAND D, OZUYSAL M, FUA P. Making action rec⁃ ognition robust to occlusions and viewpoint changes[C] / / Proceeding of the 11th European Conference on Computer Vision. Heraklion, Greece, 2010: 635⁃648. [19]LIU J, SHAH M, KUIPERS B, et al. Cross⁃view action recognition via view knowledge transfer[C] / / Proceeding of the 29th IEEE Conference on Computer Vision and Pattern Recognition. Colorado, USA, 2011: 3209⁃3216. [20]JIANG Z, ZHE L, LARRY D. Recognizing human actions by learning and matching shape⁃motion prototype trees[J]. IEEE Transactions on Pattern Analysis and Machine Intel⁃ ligence, 2012, 34(3): 533⁃547. 作者简介: 王策,男,1989 年生,硕士研究生,主要 研究方向为基于视频的人体运动建模及其 分析。 姬晓飞,女,1978 年生,副教授,博士, 主要研究方向为视频分析与处理、模式识 别。 承担国家自然科学基金项目、教育部留 学回国启动基金项目等多项基金研究工作。 发表学术论文 30 余篇,其中被 SCI、EI 检索 15 篇。 参与编著英文专著 1 部。 李一波,男,1963 年生,教授, 博士生导 师,博士,主要研究方向为生物特征识别、图 像处理与模式识别、飞行控制、复杂系统、人 工智能等。 曾获军队级科技进步 3 等奖 1 项、省国防工业办公室科技进步 2 等奖 1 项。 主持和参与近 30 项科研项目, 发表学术论文 100 余 篇, 其中被 SCI 及 EI 检索 30 余篇。 第 5 期 王策,等:一种简便的视角无关动作识别方法研究 ·583·