第3卷第2期 智能系统学报 Vol.3 Na 2 2008年4月 CAAI Transactions on Intelligent Systems Apr.2008 一种多层前馈神经网络的快速修剪算法 乔俊飞,张颖 (北京工业大学电子信息与控制工程学院,北京100022) 摘要:针对目前神经网络在应用中难于确定隐层神经元数的问题,提出了一种神经网络结构的快速修剪算法.该 算法在最优脑外科算法(OBS)的基础上通过直接剔除冗余的隐层神经元实现神经网络结构自组织设计,实验结果 表明,快速修剪算法与常规的最优脑外科算法相比,具有更简单的网络结构和更快的学习速度 关键词:最优脑外科算法:神经网络修剪算法:自组织设计算法 中图分类号:TP183文献标识码:A文章编号:1673-4785(2008)02-0173-04 Fast unit pruning algorithm for multilayer feedfor ward net work design QIAO Jum-fei,ZHANG Ying (College of Electronic and Control Engineering,Beijing University of Technology,Beijing 100022,China) Abstract:For it is difficult to determine the numbers of hidden neurons in the application of neural net- works,a fast unit pruning algorithm for the structure of neural network was presented in the paper.The algorithm which based on optimal brain surgeon(OBS)eliminated the unneeded hidden neurons directly,in which way carried out the self-organization design on the structure of neural networks.The results of com- parative studies with OBS showed that the fast unit pruning algorithm could reduce both neural network complexity and training time. Key words:optimal brain surgeon;neural network pruning;self-organization design 多层前馈神经网络(multilayer feedforward过训练和比较不同网络结构的途径来实现;备受推 neural network,MFNN)是目前应用最为广泛的神 崇的方法有交叉校验1:2)网络生长,由一个小规模 经网络模型之一,尽管其训练算法之一的BP算法 的网络结构开始,训练过程中,针对实际问题,根据 己成功应用于许多实际问题,但是BP算法仍需事 网络性能要求逐步增加结构复杂性,直至满足性能 先确定网络结构且易陷入局部极小,收敛速度极慢. 要求.著名的网络生长算法有Fahlman提出的瀑流 因此,神经网络结构设计己成为当前神经计算科学 关联4);3)与网络生长方法相反,在开始时构造一个 中人们共同关注的问题.众所周知,一个规模过大的 含有冗余节点的大规模网络结构,然后在训练过程 MFNN能很好地学习训练样本,输出误差小,但是 中逐步删除那些不必要的节点或权值,降低网络的 往往会出现网络的过度拟合现象,从而使泛化能力 复杂性,提高其泛化能力,最优脑外科算法(optimal 较差I山,另一方面,规模过小的MFNN虽具有较好 brain surgeon,OBS)就是其中一种代表性的算 的泛化能力,但完成对训练样本的学习较为困难.为 法;4)进化方法,其中,最具代表性的遗传算法是基 了使神经网络在保持良好性能的同时具有最小的网 于生物进化原理的搜索算法,具有很好的鲁棒性和 络规模,近年来,相继有一些神经网络结构优化方法 全局搜索能力,非常适用于神经网络结构的优化和 被提出:1)凑试法),由模型查找优化结构,主要通 调整) 收稿日期:2007-03-22. 凑试法简单易行,但是由于要凑试若干个候选 基金项目:国家自然科学基金资助项目(60304012,60674066);北京 市科技新星计划资助项目(H020821210120). 网络,所以凑试过程繁琐费时,并且需要一定的先前 通讯作者:张颖.2 hangying611@163.com 经验来确定网络结构.另一方面,由于网络对初始条 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.http://www.cnki.net

第 3 卷第 2 期 智 能 系 统 学 报 Vol. 3 №. 2 2008 年 4 月 CAA I Transactions on Intelligent Systems Apr. 2008 一种多层前馈神经网络的快速修剪算法 乔俊飞 ,张 颖 (北京工业大学 电子信息与控制工程学院 ,北京 100022) 摘 要 :针对目前神经网络在应用中难于确定隐层神经元数的问题 ,提出了一种神经网络结构的快速修剪算法. 该 算法在最优脑外科算法(OBS) 的基础上 ,通过直接剔除冗余的隐层神经元实现神经网络结构自组织设计. 实验结果 表明 ,快速修剪算法与常规的最优脑外科算法相比 ,具有更简单的网络结构和更快的学习速度. 关键词 :最优脑外科算法 ;神经网络修剪算法 ;自组织设计算法 中图分类号 : TP183 文献标识码 :A 文章编号 :167324785 (2008) 0220173204 Fast unit pruning algorithm for multilayer feedforward network design QIAO J un2fei , ZHAN G Ying (College of Electronic and Control Engineering , Beijing University of Technology , Beijing 100022 ,China) Abstract :For it is difficult to determine t he numbers of hidden neurons in the application of neural net2 works , a fast unit pruning algorit hm for the struct ure of neural network was presented in t he paper. The algorit hm which based on optimal brain surgeon (OBS) eliminated t he unneeded hidden neurons directly , in which way carried out the self2organization design on t he struct ure of neural networks. The results of com2 parative studies wit h OBS showed t hat the fast unit pruning algorit hm could reduce bot h neural network complexity and training time. Keywords :optimal brain surgeon ; neural network pruning ; self2organization design 收稿日期 :2007203222. 基金项目 :国家自然科学基金资助项目 (60304012 ,60674066) ;北京 市科技新星计划资助项目( H020821210120) . 通讯作者 :张 颖. zhangying611 @163. com. 多层前馈神经网络 ( multilayer feedforward neural network ,MFNN) 是目前应用最为广泛的神 经网络模型之一 ,尽管其训练算法之一的 BP 算法 已成功应用于许多实际问题 ,但是 BP 算法仍需事 先确定网络结构且易陷入局部极小 ,收敛速度极慢. 因此 ,神经网络结构设计已成为当前神经计算科学 中人们共同关注的问题. 众所周知 ,一个规模过大的 MFNN 能很好地学习训练样本 ,输出误差小 ,但是 往往会出现网络的过度拟合现象 ,从而使泛化能力 较差[ 1 ] ;另一方面 ,规模过小的 MFNN 虽具有较好 的泛化能力 ,但完成对训练样本的学习较为困难. 为 了使神经网络在保持良好性能的同时具有最小的网 络规模 ,近年来 ,相继有一些神经网络结构优化方法 被提出 :1) 凑试法[2 ] ,由模型查找优化结构 ,主要通 过训练和比较不同网络结构的途径来实现 ;备受推 崇的方法有交叉校验[3 ] ;2) 网络生长 ,由一个小规模 的网络结构开始 ,训练过程中 ,针对实际问题 ,根据 网络性能要求逐步增加结构复杂性 ,直至满足性能 要求. 著名的网络生长算法有 Fahlman 提出的瀑流 关联[4 ] ;3) 与网络生长方法相反 ,在开始时构造一个 含有冗余节点的大规模网络结构 ,然后在训练过程 中逐步删除那些不必要的节点或权值 ,降低网络的 复杂性 ,提高其泛化能力 ,最优脑外科算法 (optimal brain surgeon ,OBS) [526 ] 就是其中一种代表性的算 法 ;4) 进化方法 ,其中 ,最具代表性的遗传算法是基 于生物进化原理的搜索算法 ,具有很好的鲁棒性和 全局搜索能力 ,非常适用于神经网络结构的优化和 调整[7 ] . 凑试法简单易行 ,但是由于要凑试若干个候选 网络 ,所以凑试过程繁琐费时 ,并且需要一定的先前 经验来确定网络结构. 另一方面 ,由于网络对初始条

·174· 智能系统学报 第3卷 件、训练参数较敏感且存在局部极小,所以凑试方法 后关于下标1求最小化. 往往不易找到适宜的网络结构.网络生长方法在训 这里进行2个层次上的最小化.第1个最小化 练过程中逐渐增加隐层神经元的数量,直到满足性 是当第1个权值向量置零后对仍保留的突触权值向 能要求为止,这一过程无疑会耗费大量时间,并且随 量进行的:第2个最小化是对特定被修剪的向量进 着神经元数量的递增,其计算量也急剧增大.而遗传 行的. 算法最大的问题是昂贵的计算.相比之下,网络修剪 为了解决这个约束最优化问题,首先构建一个 方法具有以下优点:1)起始时的大规模网络保证能 Lagrange算子: 较快地完成训练:2)降低了对初始条件的敏感性;3) S=△wHAw.E△w+W,. (4) 通过修剪,网络将更适合实际函数并有更好的泛化 2 能力.在修剪技术中,由Hassibi和Stork提出的最 式中:入是Lagrange乘子.然后求Lagrange函数S 优脑外科算法最负盛名.然而,常规OBS算法是通 对△w的导数,应用式3)的约束条件,并且利用矩 过逐个删除具有最小特征值的权值来实现网络结构 阵的逆,求得权值向量w中的最佳变化: 修剪的,这大大增加了程序的计算量及运行时间,也 H 使得OBS算法在大规模神经网络中的应用受到限 Aw=H. (5 Lagrange算子S对元素w:的相应最优值是 制8).正是这样,本文提出了一种改进OBS算法,实 验结果表明,该算法能够获得简洁的网络结构,并且 s=2r] (6) 具有更快的收敛速度 式中:H'是Hessian矩阵H的逆,[H'.是这个 1 OBS算法 逆矩阵的第(1,)个元素.假设第1个突触权值w,被 删除,对△w进行优化而得到的Lagrange算子S:称 OBS算法是一种基于Hessian矩阵的网络修 为W:的显著性.事实上,显著性S:代表由于w,的 剪算法.首先,构造误差曲面的一个局部模型,分析 删除而导致的均方误差中的增长.在OBS过程中, 权值的扰动所造成的影响.构造这样一个模型结构 相应于最小特征值的权值将被删除,剩余权值将按 的出发点是在运行点附近使用Taylor级数给出代 式(⑤)进行校正 价函数5的局部逼近,并假设权值参数仅在训练过 2快速修剪算法 程收敛之后才被从网络中删除,且包含局部最小或 者全局最小的误差曲面是近似“二次的”,因此,可以 在上述的OBS算法中,Hessian矩阵的计算是 描述为 一个关键问题.OBS算法中对H的计算是针对网络 △5。=5w+△W.5W≈△wHaw,W 中的某一突触权值w:进行的,w:对应于H中的 第(i,)个元素,对于大规模的神经网络,必然导 H=正 致H的规模过大,此外,算法对于S,的计算以及对 Ow 最小显著性的搜索均是针对权值进行的,这些必然 dF(w x(n) F(w.x(n 2) 导致算法的计算量增大以及运行时间过长9?.针 对这些问题,提出了一种快速修剪算法,这种算法针 式中:H是Hessian矩阵,F是多层神经网络实现的 对网络中的隐层神经元i计算H.:,利用与第1个神 输入输出映射函数,w是权向量,△w是权向量增量, 经元相连的所有m个权值的均值w,计算S:,从而 x为网络的输入样本,N为训练样本总数,n为样本 达到减小计算量,缩短程序运行时间的效果.令 的序号 OBS的目标是置一个突触权值为零使得式(1) 中给出的的递增增量最小化.令w:(表示这个 7) m 特别的突触权值.这个权值的删除等价于条件: 相应地,式2)变为 1W△w+w:=0 3) H.= 子mpl≈ 成立,其中1,是除了第i个元素等于单位1之外其 Opu 他所有元素均为零的单位向量.因此,OB$的目标 六,ΣrpF'pwl 8 可理解为是对权值向量增长变化△w最小化二次型 △WHa使它满足约束条件aw+,为零.然 p.-x (9) 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved. http://www.cnki.net

件、训练参数较敏感且存在局部极小 ,所以凑试方法 往往不易找到适宜的网络结构. 网络生长方法在训 练过程中逐渐增加隐层神经元的数量 ,直到满足性 能要求为止 ,这一过程无疑会耗费大量时间 ,并且随 着神经元数量的递增 ,其计算量也急剧增大. 而遗传 算法最大的问题是昂贵的计算. 相比之下 ,网络修剪 方法具有以下优点 :1) 起始时的大规模网络保证能 较快地完成训练 ;2) 降低了对初始条件的敏感性 ;3) 通过修剪 ,网络将更适合实际函数并有更好的泛化 能力. 在修剪技术中 ,由 Hassibi 和 Stork 提出的最 优脑外科算法最负盛名. 然而 ,常规 OBS 算法是通 过逐个删除具有最小特征值的权值来实现网络结构 修剪的 ,这大大增加了程序的计算量及运行时间 ,也 使得 OBS 算法在大规模神经网络中的应用受到限 制[8 ] . 正是这样 ,本文提出了一种改进 OBS 算法 ,实 验结果表明 ,该算法能够获得简洁的网络结构 ,并且 具有更快的收敛速度. 1 OBS 算法 OBS 算法是一种基于 Hessian 矩阵的网络修 剪算法. 首先 ,构造误差曲面的一个局部模型 ,分析 权值的扰动所造成的影响. 构造这样一个模型结构 的出发点是在运行点附近使用 Taylor 级数给出代 价函数ξav的局部逼近 ,并假设权值参数仅在训练过 程收敛之后才被从网络中删除 ,且包含局部最小或 者全局最小的误差曲面是近似“二次的”,因此 ,可以 描述为 Δξav =ξ(w +Δw) - ξ(w) ≈ 1 2 Δw T HΔw, (1) H = 5 2ξav (w) 5w 2 ≈ 1 N ∑ N n = 1 5 F(w, x( n) ) 5w 5 F(w, x( n) ) 5w T . (2) 式中 : H 是 Hessian 矩阵 , F 是多层神经网络实现的 输入输出映射函数 ,w是权向量 ,Δw 是权向量增量 , x 为网络的输入样本 , N 为训练样本总数 , n 为样本 的序号. OBS 的目标是置一个突触权值为零使得式 (1) 中给出的ξav的递增增量最小化. 令 wi ( n) 表示这个 特别的突触权值. 这个权值的删除等价于条件 : l T iΔw + wi = 0 (3) 成立 ,其中 li 是除了第 i 个元素等于单位 1 之外其 他所有元素均为零的单位向量. 因此 , OBS 的目标 可理解为是对权值向量增长变化Δw 最小化二次型 1 2 Δw T HΔw,使它满足约束条件 l T iΔw + wi 为零 ,然 后关于下标 i 求最小化. 这里进行 2 个层次上的最小化. 第 1 个最小化 是当第 i 个权值向量置零后对仍保留的突触权值向 量进行的;第 2 个最小化是对特定被修剪的向量进 行的. 为了解决这个约束最优化问题 ,首先构建一个 Lagrange 算子 : S = 1 2 Δw T HΔw - λ( l T iΔw + wi) . (4) 式中 :λ是 Lagrange 乘子. 然后求 Lagrange 函数 S 对Δw的导数 ,应用式 (3) 的约束条件 ,并且利用矩 阵的逆 ,求得权值向量 w中的最佳变化 : Δw = - wi [ H - 1 ]i , i H - 1 li . (5) Lagrange 算子 S 对元素 w i 的相应最优值是 Si = w 2 i 2[ H - 1 ]i , i . (6) 式中 : H - 1是 Hessian 矩阵 H 的逆 , [ H - 1 ]i , i是这个 逆矩阵的第( i , i) 个元素. 假设第 i 个突触权值 w i 被 删除 ,对Δw进行优化而得到的 Lagrange 算子 Si 称 为 wi 的显著性. 事实上 ,显著性 Si 代表由于 w i 的 删除而导致的均方误差中的增长. 在 OBS 过程中 , 相应于最小特征值的权值将被删除 ,剩余权值将按 式(5) 进行校正. 2 快速修剪算法 在上述的 OBS 算法中 , Hessian 矩阵的计算是 一个关键问题. OBS 算法中对 H 的计算是针对网络 中的某一突触权值 w i 进行的 , wi 对应于 H 中的 第( i , i) 个元素 , 对于大规模的神经网络 , 必然导 致 H 的规模过大 ,此外 ,算法对于 Si 的计算以及对 最小显著性的搜索均是针对权值进行的 ,这些必然 导致算法的计算量增大以及运行时间过长[9210 ] . 针 对这些问题 ,提出了一种快速修剪算法 ,这种算法针 对网络中的隐层神经元 i 计算 Hi , i ,利用与第 i 个神 经元相连的所有 m 个权值的均值 wi 计算 S i ,从而 达到减小计算量 ,缩短程序运行时间的效果. 令 wi = ∑ m j = 1 wij m , (7) 相应地 ,式(2) 变为 Hi , i = 5 2ξav ( pij ) 5 p 2 ij ≈ 1 N ∑ N j =1 F′( pij ) F′( pij ) , (8) pij = ∑ m j = 1 wji ·x j . (9) ·174 · 智 能 系 统 学 报 第 3 卷

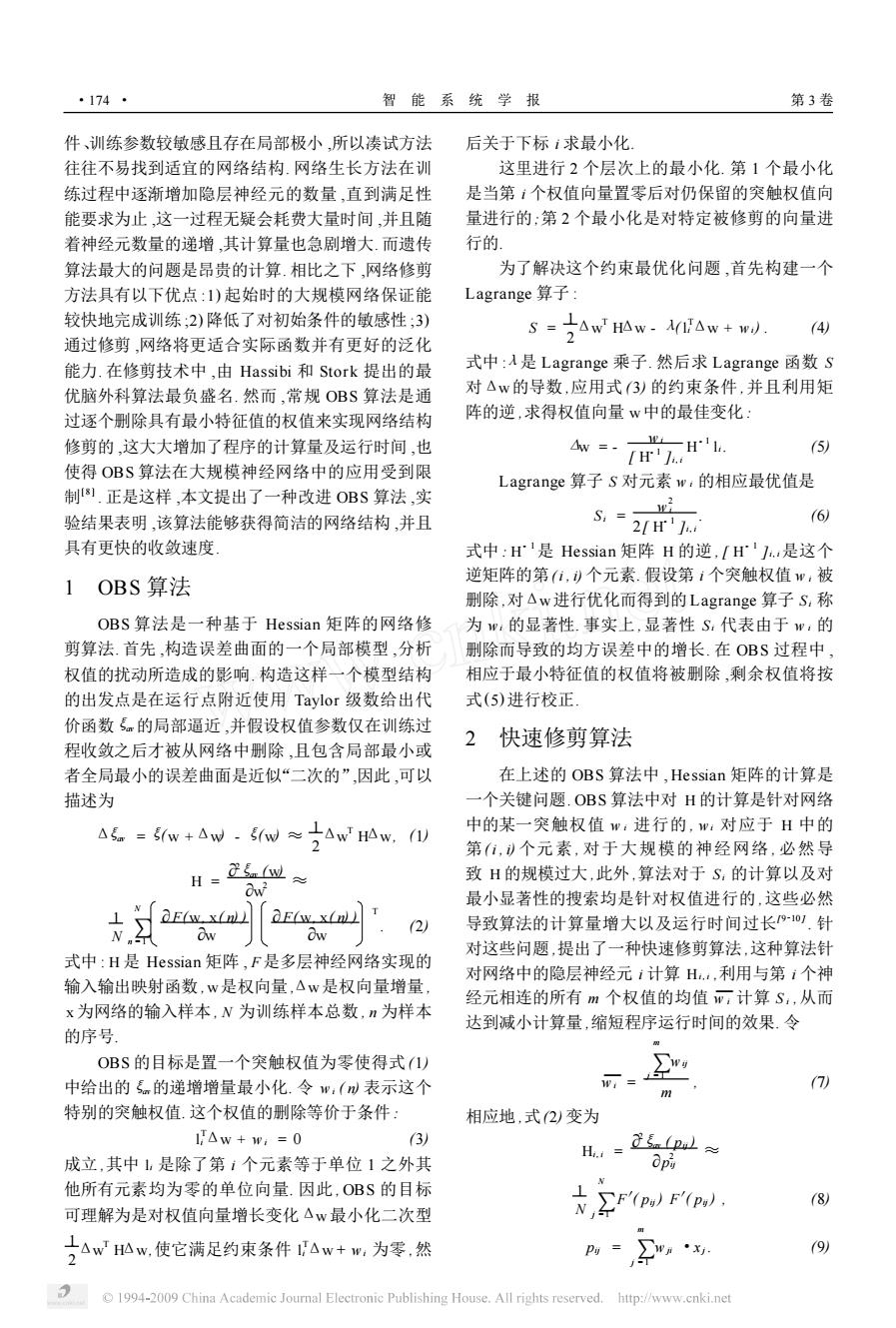

第2期 乔俊飞,等:一种多层前馈神经网络的快速修剪算法 ·175· 式中:P:为网络输入输出映射函数F的输入,这种 进水的油类污染物的含量,氨氮代表进水中油类污 针对某一隐层神经元i计算H.,的方法,在保留了 染物的含量.网络输出向量为通过活性污泥系统处 计算所需的必要信息的同时,减小了H矩阵的规 理后的出水COD值.实验所用数据来源于某小型 模.此外,第i个神经元的显著性为 污水处理厂水质化验日报表 8,= 在仿真实验中,网络采用512-1的连接方式 10) 2fH11. 训练样本和检测样本各100组,实验结果相关数据 这表明S:的值越大,网络中的第i个神经元对网络 如表1,其中运行时间指采用已收敛于最小均方误 的影响越大.因此,当S,的值小于某一设定值时,与 差的网络进行网络结构修剪及再次训练的时间 其对应的隐层神经元将被删除 表12种算法的性能比较 完整的多层神经网络快速修剪算法如下: Table 1 Performance of the two algorithms 1)训练给定多层感知器,使其收敛于最小均方 误差; 训练 优化的 检测 运行 2)利用递归公式计算Hessian矩阵的逆H': 算法 网络结构 误差 误差 时间 (权值数) 3)计算每个隐层神经元的显著性S,: OBS 4)如果显著性S:远小于均方误差,那么删除相 0.01 0.11 算法 60 12'30% 应的神经元i,否则,转第6)步: 快速修 54 5)通过应用如下调整,校正网络中所有的突触 0.01 0.07 剪算法 4'15m (9神经元) 权值: E △w=- -H. 11) 修剪前后的神经网络结构如图1所示,图中虚 [HlJ. 线表示经过快速修剪算法优化后剔除的冗余神经元 转第2)步: 及其连接权值 6)当不再有神经元被删除时停止计算,并在该 点重新训练网络 3 仿真实验 在解决实际问题时,网络的最优结构是一个未 知数,因此在应用中应该使网络在保持良好性能的 同时获得尽可能简单的结构.在仿真实验中,将 OBS算法及快速修剪算法应用于活性污泥法污水 处理过程建模,并将获得的相关实验数据进行比较, 由于活性污泥法污水处理过程具有高度的复杂 性和非线性,而神经网络能够根据对象输入/输出的 数据直接建立模型,不需要对象的先验知识及复杂 图1经过快速修剪算法优化后的网络结构 的数学公式推导,因此使得神经网络可以在建模过 Fig.I The network structure after pruning by 程中发挥作用.本实验选择网络的输入向量为污水 the fast unit pruning algorithm 调节池的几个重要的进水水质指标,分别为混合液 采用OBS算法及快速修剪算法修剪后的网络 悬浮固体(MLSS)、化学需氧量(COD)pH、油及氨 泛化能力分别如图2、图3所示,图中实线为网络的 氮.其中MLSS是指单位体积生化池混合液所含干 检测样本的样本输出值,虚线为网络对检测样本进 污泥的重量,单位为mgL,用来表征活性污泥浓 行在线学习后的实际输出值,由图可见,采用快速修 度.COD是指废水中能被氧化的物质在被化学氧 剪算法进行优化后网络的实际输出与样本输出拟合 化剂氧化时,所需要的氧量,以mgL为单位.由于 效果很好,保持了网络较好的泛化能力.实验结果表 它能够综合性地反映废水中所有有机物质的数量, 明,与OBS算法相比,快速修剪算法可以使网络获 且分析比较简单,因此被广泛地应用于废水分析和 得更简单的隐层结构,同时优化学习时间更短 环境工程上.pH值反映进水水质的酸碱程度,油是 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.http://www.cnki.net

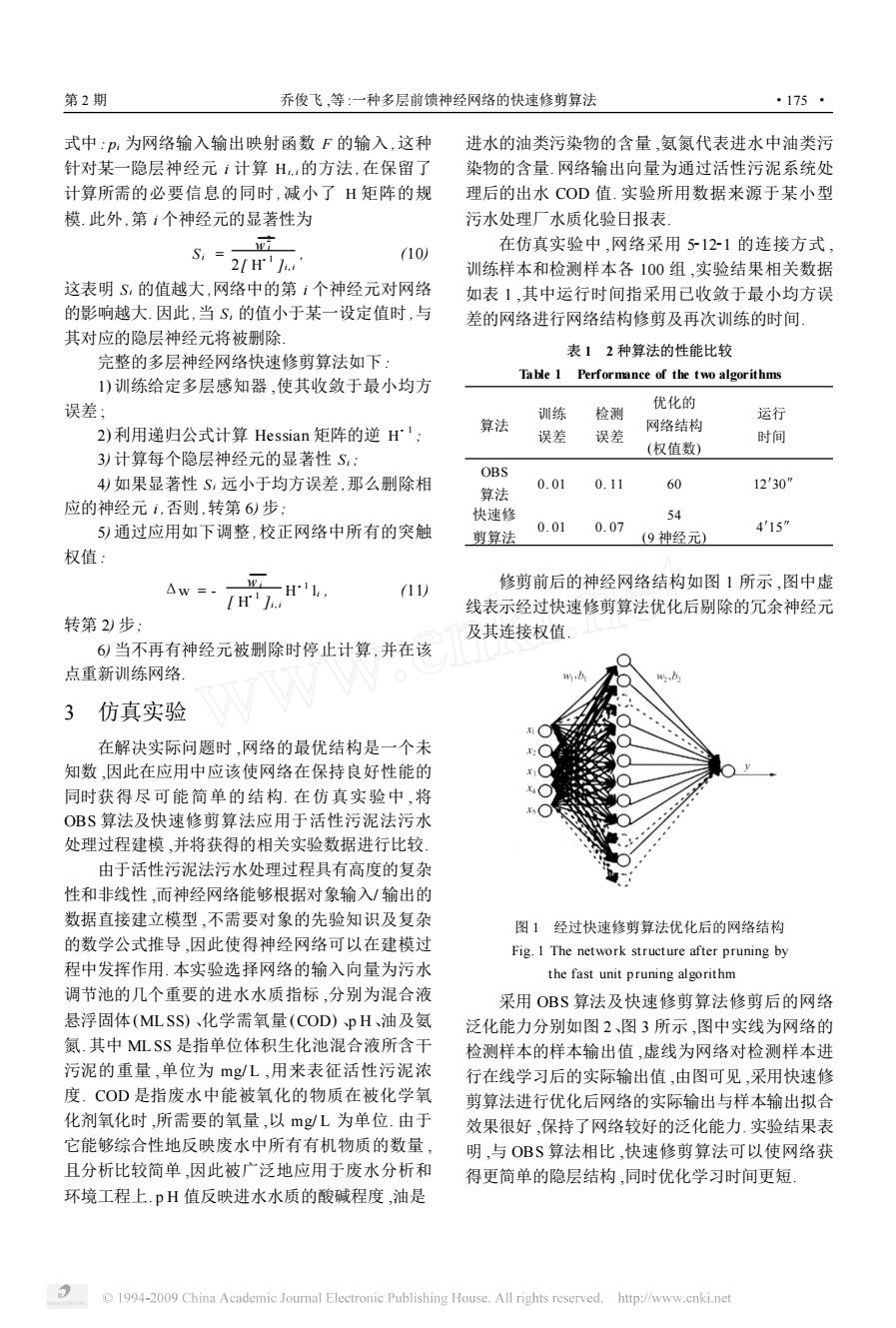

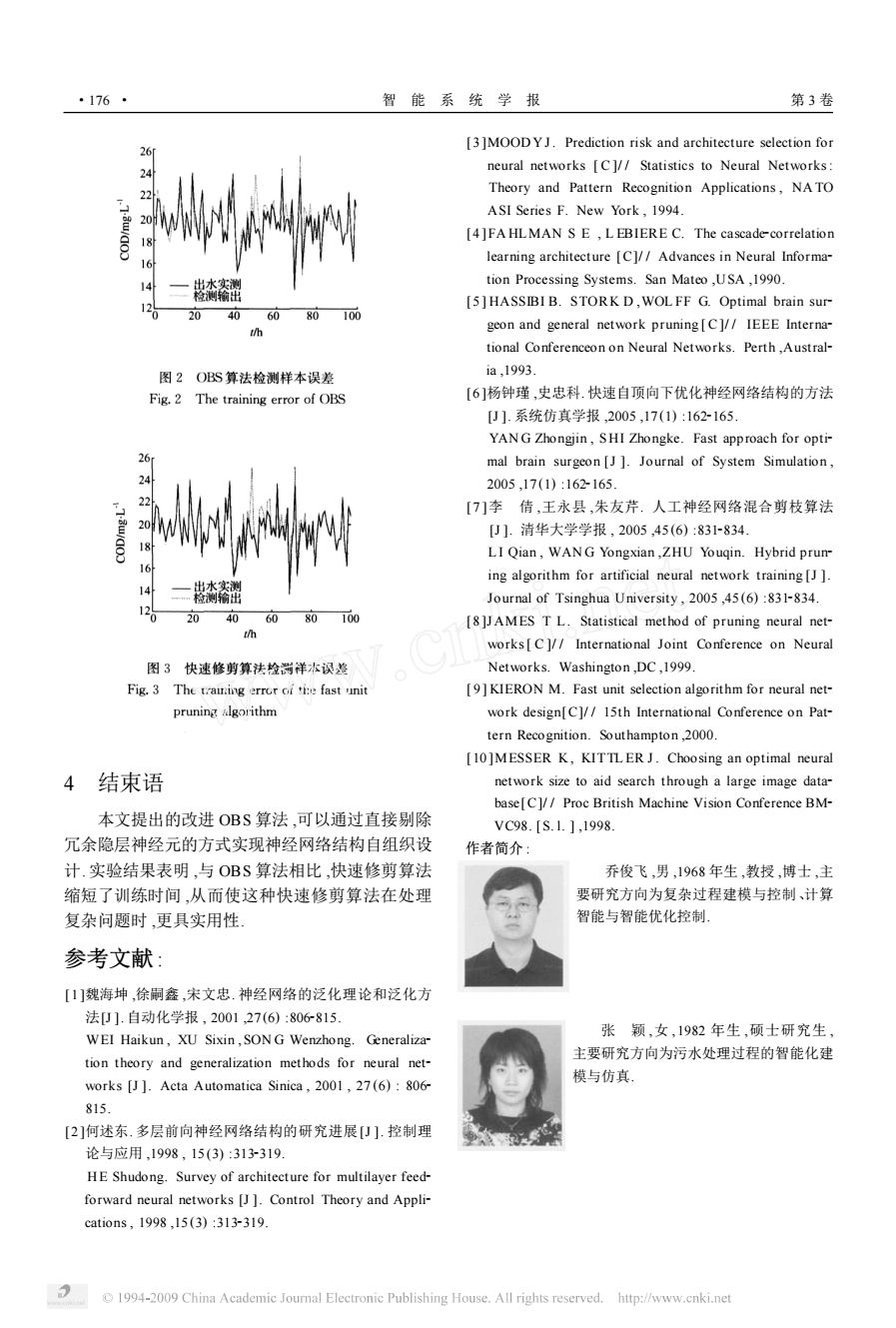

式中 : pi 为网络输入输出映射函数 F 的输入 ,这种 针对某一隐层神经元 i 计算 Hi , i的方法 ,在保留了 计算所需的必要信息的同时 , 减小了 H 矩阵的规 模. 此外 ,第 i 个神经元的显著性为 S i = w 2 i 2[ H - 1 ]i , i , (10) 这表明 Si 的值越大 ,网络中的第 i 个神经元对网络 的影响越大. 因此 ,当 Si 的值小于某一设定值时 ,与 其对应的隐层神经元将被删除. 完整的多层神经网络快速修剪算法如下 : 1) 训练给定多层感知器 ,使其收敛于最小均方 误差 ; 2) 利用递归公式计算 Hessian 矩阵的逆 H - 1 ; 3) 计算每个隐层神经元的显著性 Si ; 4) 如果显著性 Si 远小于均方误差 ,那么删除相 应的神经元 i ,否则 ,转第 6) 步; 5) 通过应用如下调整 ,校正网络中所有的突触 权值 : Δw = - wi [ H - 1 ]i , i H - 1 li , (11) 转第 2) 步; 6) 当不再有神经元被删除时停止计算 ,并在该 点重新训练网络. 3 仿真实验 在解决实际问题时 ,网络的最优结构是一个未 知数 ,因此在应用中应该使网络在保持良好性能的 同时获得尽可能简单的结构. 在仿真实验中 ,将 OBS 算法及快速修剪算法应用于活性污泥法污水 处理过程建模 ,并将获得的相关实验数据进行比较. 由于活性污泥法污水处理过程具有高度的复杂 性和非线性 ,而神经网络能够根据对象输入/ 输出的 数据直接建立模型 ,不需要对象的先验知识及复杂 的数学公式推导 ,因此使得神经网络可以在建模过 程中发挥作用. 本实验选择网络的输入向量为污水 调节池的几个重要的进水水质指标 ,分别为混合液 悬浮固体(MLSS) 、化学需氧量 (COD) 、p H、油及氨 氮. 其中 ML SS 是指单位体积生化池混合液所含干 污泥的重量 ,单位为 mg/ L ,用来表征活性污泥浓 度. COD 是指废水中能被氧化的物质在被化学氧 化剂氧化时 ,所需要的氧量 ,以 mg/ L 为单位. 由于 它能够综合性地反映废水中所有有机物质的数量 , 且分析比较简单 ,因此被广泛地应用于废水分析和 环境工程上. p H 值反映进水水质的酸碱程度 ,油是 进水的油类污染物的含量 ,氨氮代表进水中油类污 染物的含量. 网络输出向量为通过活性污泥系统处 理后的出水 COD 值. 实验所用数据来源于某小型 污水处理厂水质化验日报表. 在仿真实验中 ,网络采用 521221 的连接方式 , 训练样本和检测样本各 100 组 ,实验结果相关数据 如表 1 ,其中运行时间指采用已收敛于最小均方误 差的网络进行网络结构修剪及再次训练的时间. 表 1 2 种算法的性能比较 Table 1 Performance of the two algorithms 算法 训练 误差 检测 误差 优化的 网络结构 (权值数) 运行 时间 OBS 算法 0. 01 0. 11 60 12′30″ 快速修 剪算法 0. 01 0. 07 54 (9 神经元) 4′15″ 修剪前后的神经网络结构如图 1 所示 ,图中虚 线表示经过快速修剪算法优化后剔除的冗余神经元 及其连接权值. 图 1 经过快速修剪算法优化后的网络结构 Fig. 1 The network structure after pruning by the fast unit pruning algorithm 采用 OBS 算法及快速修剪算法修剪后的网络 泛化能力分别如图 2、图 3 所示 ,图中实线为网络的 检测样本的样本输出值 ,虚线为网络对检测样本进 行在线学习后的实际输出值 ,由图可见 ,采用快速修 剪算法进行优化后网络的实际输出与样本输出拟合 效果很好 ,保持了网络较好的泛化能力. 实验结果表 明 ,与 OBS 算法相比 ,快速修剪算法可以使网络获 得更简单的隐层结构 ,同时优化学习时间更短. 第 2 期 乔俊飞 ,等 :一种多层前馈神经网络的快速修剪算法 ·175 ·

·176· 智能系统学报 第3卷 [3]MOOD YJ.Prediction risk and architecture selection for 24 neural networks [C]//Statistics to Neural Networks: Theory and Pattern Recognition Applications,NATO 220 ASI Series F.New York,1994. 4]FA HLMAN S E,L EBIERE C.The cascade-correlation 18 16 learning architecture [C]//Advances in Neural Informa- 14 tion Processing Systems.San Mateo,USA,1990. 12 5]HASSIBI B.STORK D,WOL FF G.Optimal brain sur- 20 406080100 h geon and general network pruning[C]//IEEE Interna- tional Conferenceon on Neural Networks.Perth,Austral- 图2OBS算法检测样本误差 ia,1993. Fig.2 The training error of OBS [6]杨钟瑾,史忠科.快速自顶向下优化神经网络结构的方法 [J].系统仿真学报,2005,17(1):162-165. YANG Zhongjin,SHI Zhongke.Fast approach for opti- mal brain surgeon [J ]Journal of System Simulation. 2005,17(1):162165 22 [7]李倩,王永县,朱友芹.人工神经网络混合剪枝算法 [U1.清华大学学报,2005,45(6):831-834 18 LI Qian,WANG Yongxian,ZHU Youqin.Hybrid prun- 16 ing algorithm for artificial neural network training [J ] 14 态斋翻 Journal of Tsinghua University,2005,45(6):831-834. 20 40 60 80100 [8]JAMES TL.Statistical method of pruning neural net- works C]//International Joint Conference on Neural 图3快速修剪算法检测祥本误差 Networks.Washington,DC,1999. Fig.3 The training error oi tie fast unit [9]KIERON M.Fast unit selection algorithm for neural net- pruning agorithm work design[C]//15th International Conference on Pat- tern Recognition.Southampton,2000. [10]MESSER K,KITTL ER J.Choosing an optimal neural 4结束语 network size to aid search through a large image data- base[C]//Proc British Machine Vision Conference BM- 本文提出的改进OBS算法,可以通过直接剔除 VC98.[s.1.],1998 冗余隐层神经元的方式实现神经网络结构自组织设 作者简介 计.实验结果表明,与OBS算法相比,快速修剪算法 乔俊飞,男,1968年生,教授,博士,主 缩短了训练时间,从而使这种快速修剪算法在处理 要研究方向为复杂过程建模与控制、计算 复杂问题时,更具实用性 智能与智能优化控制. 参考文献: [1]魏海坤,徐嗣鑫,宋文忠.神经网络的泛化理论和泛化方 法U].自动化学报,2001,27(6):806815. 张颖,女,1982年生,硕士研究生 WEI Haikun,XU Sixin,SON G Wenzhong.Generaliza- 主要研究方向为污水处理过程的智能化建 tion theory and generalization methods for neural net- 模与仿真 works [J].Acta Automatica Sinica,2001,27(6):806 815. [2]何述东.多层前向神经网络结构的研究进展[卩].控制理 论与应用,1998,15(3):313319. HE Shudong.Survey of architecture for multilayer feed- forward neural networks [J].Control Theory and Appli- cations,1998,15(3):313319. 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.http://www.cnki.net

4 结束语 本文提出的改进 OBS 算法 ,可以通过直接剔除 冗余隐层神经元的方式实现神经网络结构自组织设 计. 实验结果表明 ,与 OBS 算法相比 ,快速修剪算法 缩短了训练时间 ,从而使这种快速修剪算法在处理 复杂问题时 ,更具实用性. 参考文献 : [1 ]魏海坤 ,徐嗣鑫 ,宋文忠. 神经网络的泛化理论和泛化方 法[J ]. 自动化学报 , 2001 ,27 (6) :8062815. WEI Haikun , XU Sixin , SON G Wenzhong. Generaliza2 tion theory and generalization methods for neural net2 works [J ]. Acta Automatica Sinica , 2001 , 27 (6) : 8062 815. [2 ]何述东. 多层前向神经网络结构的研究进展[J ]. 控制理 论与应用 ,1998 , 15 (3) :3132319. HE Shudong. Survey of architecture for multilayer feed2 forward neural networks [J ]. Control Theory and Appli2 cations , 1998 ,15 (3) :3132319. [3 ]MOOD Y J. Prediction risk and architecture selection for neural networks [ C ]/ / Statistics to Neural Networks: Theory and Pattern Recognition Applications , NA TO ASI Series F. New York , 1994. [4 ] FA HLMAN S E , L EBIERE C. The cascade2correlation learning architecture [C]/ / Advances in Neural Informa2 tion Processing Systems. San Mateo ,USA ,1990. [5 ] HASSIBI B. STORK D ,WOL FF G. Optimal brain sur2 geon and general network pruning [ C]/ / IEEE Interna2 tional Conferenceon on Neural Networks. Perth ,Austral2 ia ,1993. [6 ]杨钟瑾 ,史忠科. 快速自顶向下优化神经网络结构的方法 [J ]. 系统仿真学报 ,2005 ,17 (1) :1622165. YAN G Zhongjin , SHI Zhongke. Fast approach for opti2 mal brain surgeon [J ]. Journal of System Simulation , 2005 ,17 (1) :1622165. [ 7 ]李 倩 ,王永县 ,朱友芹. 人工神经网络混合剪枝算法 [J ]. 清华大学学报 , 2005 ,45 (6) :8312834. L I Qian , WAN G Yongxian ,ZHU Youqin. Hybrid prun2 ing algorithm for artificial neural network training [J ]. Journal of Tsinghua University , 2005 ,45 (6) :8312834. [8 ]J AMES T L. Statistical method of pruning neural net2 works[ C ]/ / International Joint Conference on Neural Networks. Washington ,DC ,1999. [ 9 ] KIERON M. Fast unit selection algorithm for neural net2 work design[C]/ / 15th International Conference on Pat2 tern Recognition. Southampton ,2000. [10 ]MESSER K , KITTL ER J. Choosing an optimal neural network size to aid search through a large image data2 base[C]/ / Proc British Machine Vision Conference BM2 VC98. [ S. l. ] ,1998. 作者简介 : 乔俊飞 ,男 ,1968 年生 ,教授 ,博士 ,主 要研究方向为复杂过程建模与控制、计算 智能与智能优化控制. 张 颖 ,女 ,1982 年生 ,硕士研究生 , 主要研究方向为污水处理过程的智能化建 模与仿真. ·176 · 智 能 系 统 学 报 第 3 卷